Итоги тестирования центральных процессоров по методике версии 2017 года: 101 конфигурация разного назначения

Процесс смены методик тестирования компьютерных систем сильно затянулся, однако все-таки дошел до логического завершения — почти на год позже, чем планировалось. В процессе доработки тестовых задач и адаптации их для новых версий программного обеспечения возникли определенные трудности. Затем некоторые программы обновились в очередной раз — и снова я на Дерибасовской ©… В общем, в конечном итоге было принято волюнтаристское решение остановиться на достигнутом на некоторое время — благо состояние, в котором «все работает» и пригодно для практических целей, было достигнуто.

Почему вообще приходится регулярно проделывать такую работу? Потому что, вообще говоря, освоение новых аппаратных возможностей программистами происходит с заметным лагом относительно их внедрения. Сначала у большинства пользователей «нового железа» нет вообще, потом оно начинает появляться, но на фоне общего количества используемых компьютеров погоды не делает. Даже серверы принято заменять лишь раз в пять лет, настольные же системы иногда работают и дольше. Но чем дальше, тем больше увеличивается превосходство «новейших» систем — поскольку все большее количество ПО «обучается» правильной работе с ними. А вот результаты «устаревших» компьютеров при смене программного обеспечения не улучшаются — бывает, даже и наоборот. Однако тестировать приходится и те, и другие: новые — потому что они новые, а старые — чтобы понимать, чем они хуже новых. Слишком «частить» со сменами тестовой методики тоже плохо, ведь целью-то являются не абстрактные результаты в вакууме, а сравнение разных компьютерных систем. Как минимум — их компонентов (в первую очередь — центральных процессоров). И чтобы не перетестировать их раз за разом, тестовую методику приходится фиксировать на продолжительный срок — как минимум, на год-два. Что мы и делаем.

В результате последняя версия «прожила» со второй половины 2017 года почти до окончания 2019-го — плюс с ее использованием были перетестированы некоторые более старые процессоры. Впрочем, и одних «новых» хватило бы, чтобы прийти к выводу, что такой бурной пары лет на рынке не было очень давно. По крайней мере, с момента появления Core 2 Duo в 2006 году — когда буквально за несколько месяцев ситуация на рынке изменилась радикально. AMD, боровшаяся за технологическое лидерство, «выгрызая» его пядь за пядью, мгновенно оказалась в отстающих — и надолго, поскольку лишь начиная с 2017-го события начали развиваться по противоположному сценарию, и теперь несладко пришлось уже Intel. Накопленных ею запасов пока еще достаточно, чтобы находиться в лучшем положении, чем в том же 2006-м, но… часики тикают :) Как обе компании распорядятся успехами и какие выводы сделают из неудач — будет видно в наступившем году.

Методика тестирования компьютерных систем образца 2017 года

Мы же пока просто подведем итоги, сведя на диаграммы 101 аппаратную конфигурацию. В принципе, все результаты доступны и в виде таблицы в формате Microsoft Excel. Более того, только в ней доступны конкретные цифры по отдельным приложениям. На диаграммах же мы используем исключительно нормированные относительно эталонной системы групповые результаты, т. е. за 100 баллов принята скорость процессора AMD FX-8350 в паре с 16 ГБ памяти и видеокартой на базе Nvidia GeForce GTX 1070. Результатов очень много, и диаграммы в этот раз стали практически необозримыми (не забывайте жать на кнопку увеличения, если не хотите открывать их в новой вкладке). Зато они дают возможность взглянуть на ситуацию в целом, что тоже очень интересно и полезно. А с самой тестовой методикой в последний раз можно познакомиться в соответствующем материале. Даже нужно — для улучшения восприятия результатов :)

Конфигурация тестовых стендов

Поскольку испытуемых много, расписывать подробно их характеристики не представляется возможным. Поразмыслив немного, мы решили и от обычной краткой таблицы отказаться: она тоже становится слишком уж необозримой. Ключевой же параметр сравниваемых процессоров — количество ядер (и потоков вычислений) — мы вынесли прямо на диаграммы. Заодно там же указаны использовавшиеся GPU, так удобнее сравнивать эффект (или его отсутствие) в конкретной группе программ.

Видеоконвертирование

Внедрение «тотальной многоядерности» в массовый сегмент благотворно сказалось на производительности его представителей —, но и на «разбросе» результатов в пределах одной современной платформы тоже. Впрочем, одно с другим связано — для AMD АМ4 «младшими» являются «модульные» процессоры, идеологически не слишком отличающиеся от решений компании начала десятилетия (впрочем, и современные Athlon не сказать, чтоб далеко от них ушли), а для Intel LGA1151 — Celeron. Которые менялись регулярно, но принципиально это все те же два однопоточных ядра невысокой (сравнительно с другими моделями аналогичных семейств) тактовой частоты. Максимальные же значения — выросли. В итоге, если для первой версии LGA1151 разброс не достигал и пяти раз, то для второй — превысил восемь раз. Для АМ4 у нас получилось около 10 раз и то — только потому, что мы не тестировали младшие одномодульные APU, ограничившись лишь более быстрыми моделями.

И, что характерно, за прошедшую пару-тройку лет сильно девальвировался уровень HEDT-систем. Некогда рекордсмен производительности в виде десятиядерного Core i7–6950Х, ценой более полутора тысяч долларов, практически идентичен современному (даже уже уходящему) Ryzen 7 2700X, который стоит в пять раз меньше (на практике, а не по рекомендованным ценам даже еще дешевле), а то и вовсе Ryzen 5 3600X. Современные же HEDT-платформы еще быстрее, но тут уже старшие модели процессоров не удается полностью «загрузить работой» при использовании бытового ПО. Из остальных же семейство Ryzen 9 уже сделало котлету. Так что интерес будут представлять, разве что, Ryzen Threadripper, новой линейки —, но она уже целиком «уехала» выше 1000 долларов.

Рендеринг

Принципиально картина не меняется, кроме одного момента: эти приложения всегда ориентировались в т. ч. и многопроцессорные системы, так что и NUMA им не помеха, и другие «особенности» HEDT-платформ, а ядра и потоки вычислений нужны еще больше, чем при транскодировании видео. В итоге до последнего времени идеальными процессорами оказывались AMD Ryzen Threadripper WX-серии, обходящие даже лучшие решения для массовых платформ более чем вдвое. Идеальными по производительности, разумеется — с точки зрения любителей философских абстракций, типа «цена / производительность» ловить им нечего: все традиционно для HEDT-платформ. Пусть и лучше, чем два-три года назад, опять же, поскольку тогда превосходство в скорости старших HEDT-процессоров было более низким. А что касается энергопотребления — этот вопрос мы рассмотрим позже. Сейчас же положение дел несколько изменилось — хоть оба Ryzen 9 все еще помедленнее, чем былые «топчики» для TR4 (местами несуразные —, но не в таких сценариях), но они и дешевле, и способны работать на более дешевых платах. Опять же — последняя модернизация LGA2066 с резким снижением цен эту платформу уже не спасает — такое бы год назад. А новые рекорды производительности по понятным причинам будут ставить новые Ryzen Threadripper — пусть и дорогие в абсолютных цифрах, но… не дороже, чем те же WX или Core i9 для LGA2066 всего-то год назад.

Видеоредактирование и создание видеоконтента

Еще одна группа программ, неплохо утилизирующая большое количество ядер — но, в отличие от предыдущих, сильно зависящая и от их «качества». Кроме того, здесь уже иногда прослеживается и влияние различных GPU — они начали иметь значение и три года назад. Впрочем, тогда еще не слишком большое — и (иногда) не слишком-то прямолинейное: «приличная» (с точки зрения блоков кодирования/декодирований видео в первую очередь, а не игровой производительности) интеграшка могла обогнать и дискретную видеокарту. Но, в общем и целом, расклад похож на предыдущие группы программ.

Обработка цифровых фотографий

Чего нельзя сказать об обработке фото — тут уже качество ядер важнее их количества. Пренебрегать последним, впрочем, не стоит. Равно как и поддержкой SMT — напомним, что низкие результаты процессоров с «однопоточными» ядрами здесь обусловлены странностями в работе одного из фильтров Adobe Photoshop. Причем, кстати, как было выяснено позже, в более новых версиях программы его работа не исправлена, так что пришлось поработать над тестовой задачей. И это хорошее напоминание о том, что возможность программных глюков никогда не стоит сбрасывать со счетов — какой бы идеальной ни была компьютерная система в теории, на практике все это легко испортить парой-тройкой ошибок программистов.

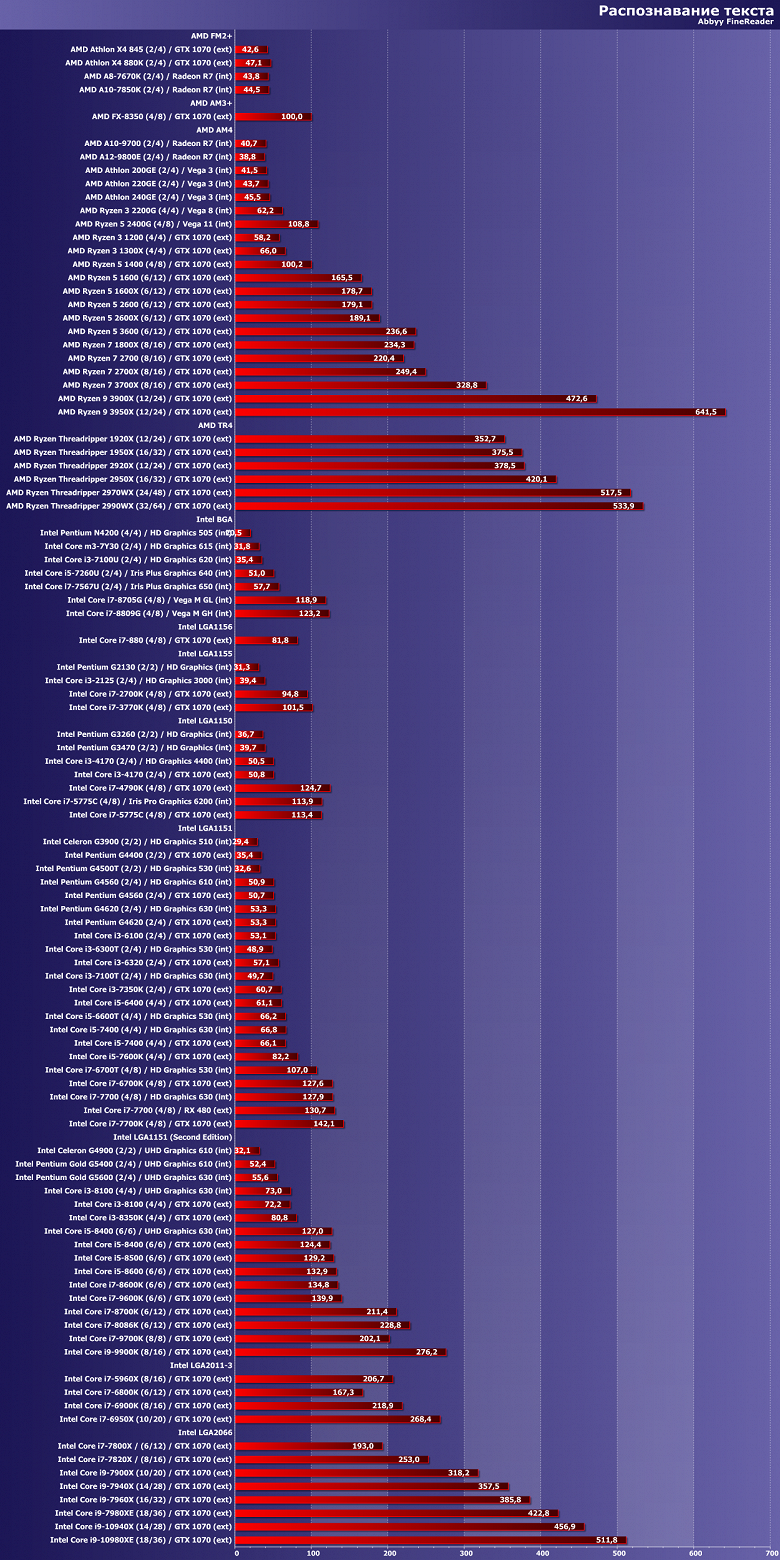

Распознавание текста

Можно долго рассуждать на тему актуальности распознавания многостраничных документов в современных условиях применительно к массовому рынку —, но вот для исследования процессоров эта задача все равно подходит очень хорошо. Действительно — казалось бы, простой целочисленный код, где мало что поддается оптимизации. Так что ядер побольше, частоту повыше — и вперед. На деле же, как видим, и здесь важно — какие ядра, а не только сколько их. Кроме того, программа очень восприимчива к системе памяти — и даже на смену накопителя хоть немного, да реагирует.

Архивирование

Впрочем, если говорить о кэшах и памяти, их влияние еще более показательно здесь. Особенно интересна реакция WinRar на организацию межъядерного взаимодействия: рекорд, установленный Core i7–6950X (напомним — десятиядерный HEDT-процессор еще с кольцевой шиной: подобно настольным моделям) до сих пор остается непревзойденным. Процессоры Intel для LGA2066 «упираются» в mesh-сеть, а Ryzen несмотря на все улучшения (и количественные, и качественные) лишь почти достигли нужной скорости. Или ненужной — все зависит от объемов обрабатываемых данных, так что с бытовой точки зрения, конечно, скорость работы архиваторов уже не так, чтоб критична. Но интересную информацию дает до сих пор.

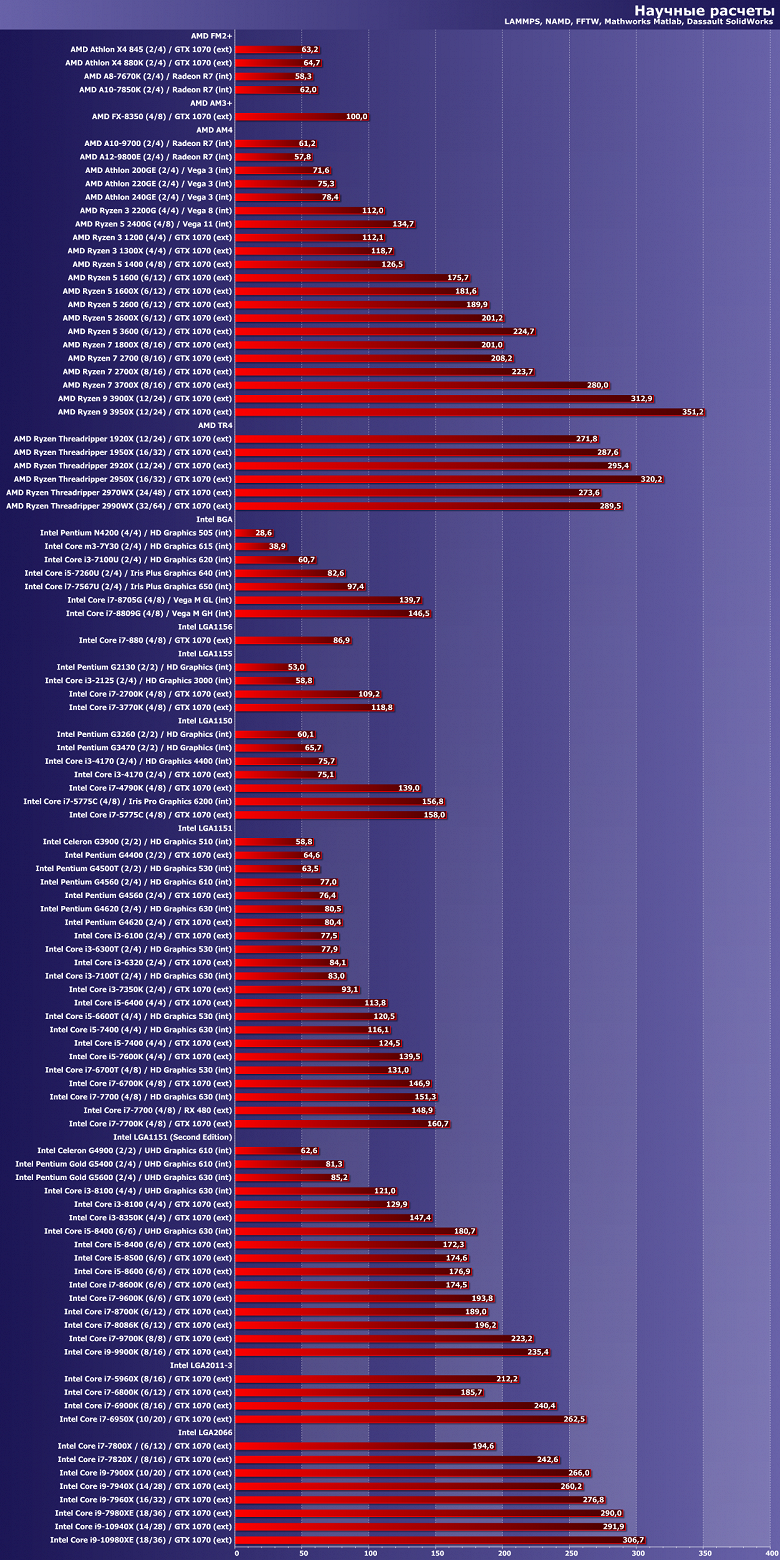

Научные расчеты

Поскольку «расчеты», количество ядер и вычислительная мощность каждого значение имеет. Однако и другие характеристики процессоров (да и не только их) на производительность программ данной группы тоже влияют. Впрочем, в целом — ничего нового мы тут тоже не видим: в конце концов все ПО давно уже пишется в одних и тех же средах, на одних языках — и компилируется одними и теми же компиляторами. Какие-то отступления от «среднего качества оптимизации» возможны (причем в обе стороны), но на рынке являются штучным товаром. А общие тенденции — на то и общие.

iXBT Application Benchmark 2017

И на этой диаграмме тоже в первую очередь видны они. В принципе, основные выводы по семействам процессоров нами делались непосредственно в их обзорах, так что в данной статье они не требуются — это в первую очередь обобщение всей полученной ранее информации, не более того. Сегодня же интереснее взглянуть на платформы в целом… И отметить, что понятие «производительности платформы» сильно изменилось. Действительно: пока на рынке за продажи в основном «приходилось отдуваться» Intel, а AMD занималась внутренними оптимизациями, мы наблюдали регулярную смену LGA115x без существенных изменений. Еще в прошлом десятилетии бюджетные процессоры стали двухъядерными, а топовые настольные — четырехъядерными восьмипоточными, причем наращивать скорость при прочих равных компании удавалось с трудом. В HEDT-сегменте вовсю использовались многоядерные решения, но для них приходилось разрабатывать «модифицированные» микроархитектуры, да и количество ядер за пять лет не смогло хотя бы удвоиться. Выход же Ryzen ощутимо перетряхнул рынок. И в первую очередь поражает собственно платформа АМ4, которая три года назад (еще до Ryzen) началась с одно-двухмодульных APU, а с этого года вмещает в себя и 16-ядерные процессоры. В итоге разница в производительности между старшими и младшими процессорами для АМ4 (самых младших, напомним, мы не тестировали) составляет порядка восьми раз. В рамках одной платформы. У «второй версии» LGA1151 — почти шесть раз. А некогда речь шла где-то о трех разах. Четырех — максимум.

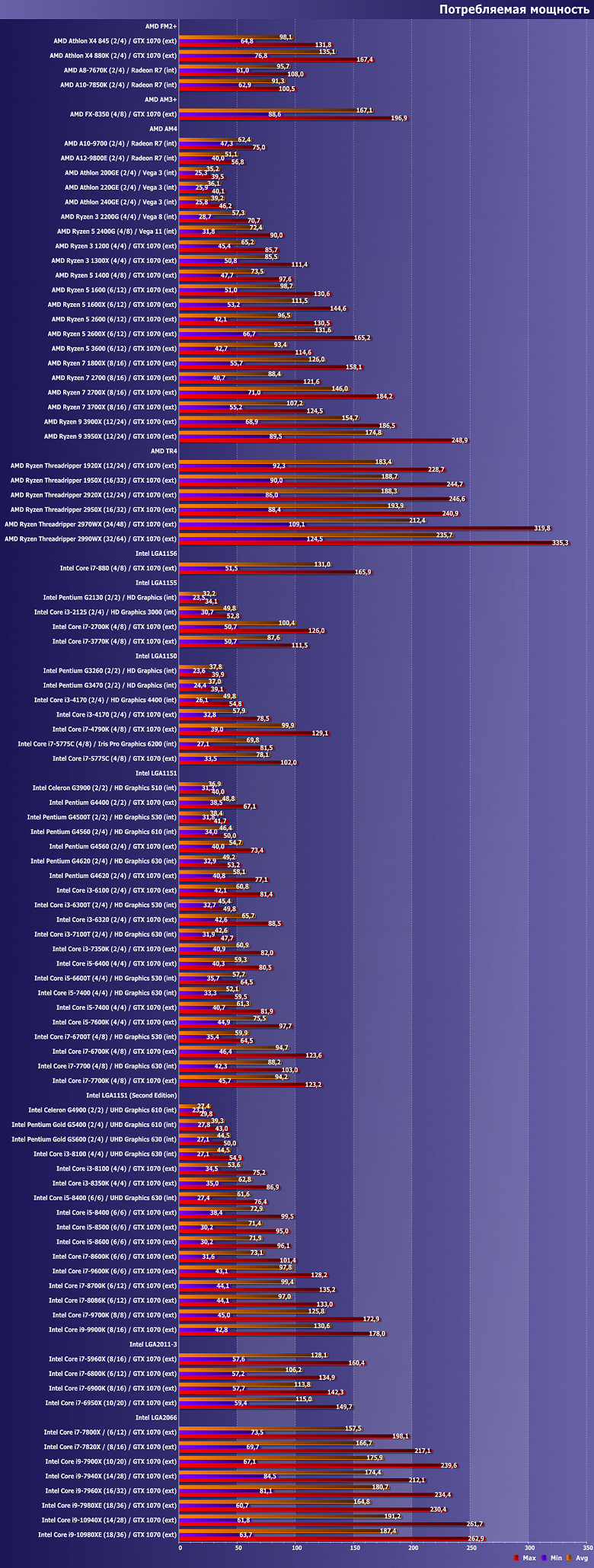

Энергопотребление и энергоэффективность

В данном случае испытуемых меньше — в микросистемах приходится использовать несколько иную методику тестирования, лишь с частичной совместимостью результатов. С другой стороны, главными для нас сегодня являются настольные системы — они в последнюю пару лет были интереснее, да и просто больше их.

Правда, с прискорбием вынуждены отметить, что кое о чем с «изменением направления» прогресса придется забыть. Ранее-то прогресс тоже наблюдался — только касался не увеличения количества ядер или абсолютного уровня производительности. Все улучшения микроархитектуры и техпроцесса были брошены на достижение одной цели: максимальной экономичности. Ведь настольные системы давно уже продаются хуже портативных, а если два процессора из трех производятся для ноутбуков, то есть смысл все три разрабатывать так, чтобы они годились для ноутбуков. И пусть десктопам это не было нужно, зато образовался солидный запас… И этот запас за прошедшие два года пришлось использовать. В итоге Core i9–9900K по уровню энергопотребления равен Core i7–880 — все ушло на увеличение количества ядер и тактовых частот.

Производительность при этом, конечно, увеличилась, так что в итоге современные массовые платформы и быстрее, и энергоэффективнее «исторических». Сегмент же HEDT всегда существовал несколько отдельно. Впрочем, после появления Ryzen 9 нужно еще три раза подумать о месте HEDT-процессоров даже в рабочей станции: массовые процессоры достигли не худшего уровня производительности. Разве что возможности по подключению высокоскоростной периферии у них победнее —, но тоже в большинстве случаев достаточные.

Итого

Понятно, что никакой принципиально новой информации подобные материалы не несут и нести не могут — это просто подведение итогов. Зато на какие-то из результатов можно взглянуть по-новому — особенно рассматривая не конкретные устройства, а платформы в целом. Повторимся: последняя пара лет на процессорном рынке была бурной как никогда. Причем не все изменения можно оценить положительно: по ряду направлений прошел своеобразный откатк тому, что было более привычным 10 лет назад, а не, например, 3–5. Конечно, история развивается по спирали, так что в количественном исчислении мы вышли на несколько иной уровень по производительности и энергоэффективности персональных компьютеров. А как события будут развиваться дальше и к чему это приведет — посмотрим в ближайшее время. AMD практически все новинки уже выпустила, но новые разработки не прекращает. Intel обещает вскоре предложить наконец для массового сегмента новую микроархитектуру (Skylake на рынке с 2015 года явно зажился) и новые техпроцессы. Но это будет уже другая история.

Полный текст статьи читайте на iXBT