Как протестировать культурный код, или UX-тестирование детского голосового помощника

Привет, Хабр! Меня зовут Анна Дегтева, я — лингвист и антрополог. Почти 20 лет провела на кафедре математической лингвистики СПбГУ, из которых 15 преподавала. Начала заниматься разработкой голосовых интерфейсов, когда только прошёл релиз Siri, а компания i-Free взялась за разработку русскоязычных аналогов. В какой-то момент моих знаний о языке стало недостаточно. Я поняла, что речь нужно исследовать в комплекте с её носителями и поступила на факультет антропологии Европейского университета в Санкт-Петербурге. Там изучала, чем люди отличаются от роботов, как сделать так, чтобы нас было почти не отличить, и нужно ли это делать.

Сегодня расскажу, как правильно делать то, чему обычные люди обучаются к пяти годам — разговаривать. Это понимание поможет вам при проектировании диалоговых интерфейсов и UX-тестировании пользовательских устройств. Поговорим о разработке детского устройства, которое помогло мне получить опыт, пригодный для использования в любом диалоговом агенте.

Диалоговые интерфейсы на естественном языке — чат-боты и голосовые ассистенты — я разрабатываю больше десяти лет. Одна из моих должностей называлась «Глава направления Методологии Аналитики и QA». В мои задачи входило проверять, что голосовой интерфейс работает, и делать так, чтобы он работал лучше. Сейчас я делаю голосового помощника в одном красном банке.

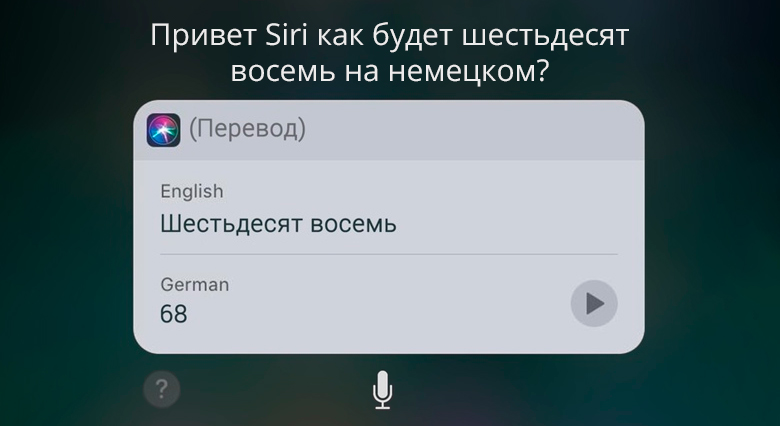

Я заподозрила, что с голосовыми интерфейсами что-то пошло не так, когда увидела на Амазоне третье издание книги «Как разговаривать с Siri». То есть сначала мы создали интерфейс, который говорит с нами, на нашем языке, а потом три раза переиздавали книгу о том, как с ним разговаривать.

Журналист Брайан Кристиан даже решил выиграть в конкурсе на премию Лебнера, выступив так, чтобы никто точно не перепутал его с компьютером, и написал книгу о том, что делает общение человеческим — The most human.

Почему же воспроизвести простой человеческий диалог оказалось так сложно? Попробуем разобраться.

«Емеля» — первый детский робот-помощник

В 2016 году мы в компании JUST-AI делали робота Емелю. На тот момент это был первый детский робот-помощник в России, он сочетал в себе функции видеоняни + умной колонки + медиацентра + компаньона. Помимо стандартных функций умной колонки с собственным контентом, он мог и просто поболтать: спросить, как прошел день, чем ребенок занимался, какое у него настроение.

Чтобы лучше понимать, в каких условиях мы проектировали и тестировали продукт, кратко опишу ситуацию на рынке на тот момент. «Алисы» еще нет. Siri начал говорить на русском только в 2015 году, меньше года назад. А у Cortana, Alexa и Google — ещё не было русских версий. Facebook только запустил Messenger с платформой для ботов.

То есть мобильный поворот уже произошёл, переносимые устройства и мессенджеры завоевали рынок. Было очевидно, что диалоговые интерфейсы будут развиваться, и крупные игроки в них уже вкладываются. Но в быту голосовые ассистенты пока не были распространены.

Наши ресурсы на тот момент:

Платформа JAICP в одной из своих ранних версий.

Опыт разработки виртуальных собеседников для мобильных приложений.

База детского контента — песенки, сказки, музыка и т.д…

Устройство.

Рассказ о процессе разработки будет, как положено драматическому произведению, в трёх частях: проектирование, тестирование, итоги.

Этап 1: проектирование

Тот самый этап, когда хочется сделать всё хорошо, быстро и сразу. Сегодня я рада, что мы тогда замахнулись на многое одновременно, потому что полученные результаты помогли мне потом при проектировании самых разных систем.

Короткое отступление: как работает голосовой ассистент?

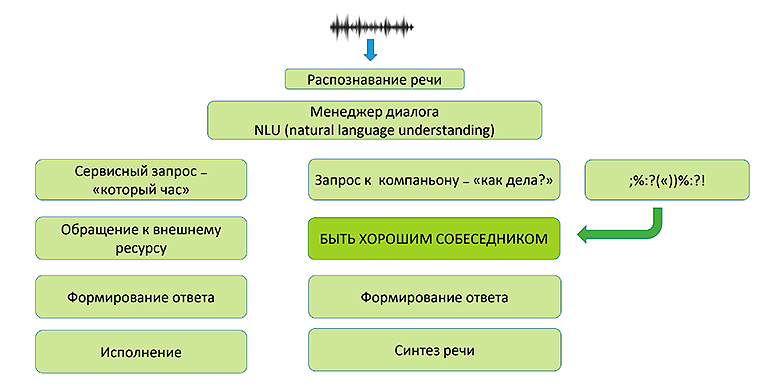

Для тех, кто не имел дела с проектированием голосовых ассистентов, приведу здесь очень упрощенную для наших целей схему.

На первом этапе поступает звуковая волна, система распознавания речи делает из неё текст. Этот текст подается в менеджер диалога, который пытается этот запрос понять. И если он смог его разобрать, то мы идем по одной из дорожек слева, но в каждой из них вести себя диалоговый агент должен принципиально по-разному.

Сервисный запрос: «который час», «сделай звук погромче», «расскажи про погоду» и т.д. В этом случае агент должен работать как интерфейс, как кнопка — быстро и эффективно, по возможности, не задавая лишних вопросов, выдать результат и быть максимально предсказуемым.

Запрос к компаньону — «как дела», «поговори со мной», «что ты любишь»? В этом случае мы не должны быть абсолютно предсказуемы, но важно держаться в рамках контекста. Здесь необходим вау-фактор и, по возможности, нужно отвечать по-разному на один и тот же вопрос. Особенно если пользователь задаёт его дважды. При этом ответ должен нравиться: нам нужно качественно вернуть подачу, чтобы пользователь захотел продолжить. А ещё очень важно эти два запроса, сервисный и к компаньону, не перепутать — представьте, что вы хотите включить микроволновку, а она начинает с вами шутить.

Ассистент не понял запрос. Если нам не удаётся стать «хорошей микроволновкой», то мы точно должны стать очень хорошим собеседником, чтобы, во-первых, сгладить коммуникативный провал, во-вторых, рассказать, как не допустить такого в дальнейшем.

Что такое «БЫТЬ ХОРОШИМ СОБЕСЕДНИКОМ»? Историческая справка

Что мы знаем о системах, претендующих на роль собеседника?

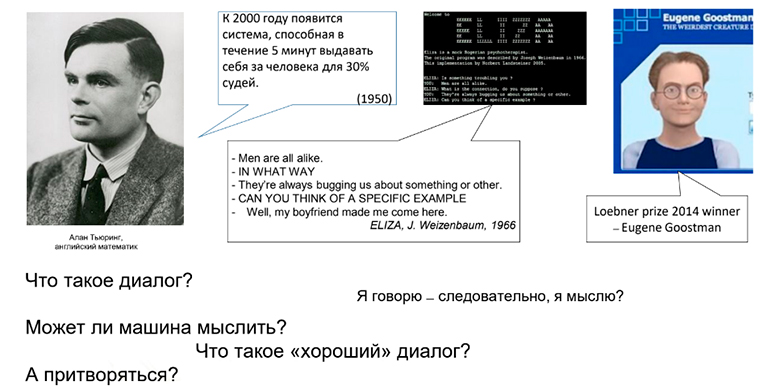

В 1950 году Алан Тьюринг предположил, что всего через 50 лет система сможет в течение пяти минут выдавать себя за человека для 30% судей, и посчитал, что этого достаточно, чтобы предполагать, что машина мыслит (или хотя бы успешно притворяется).

Уже в 1966 американский ученый Джозеф Вейценбаум создает Элизу (ELIZA) — чат-бот, работающий «по методичке» роджерианского терапевта. Весь разговор строился вокруг говорящего с ней:

— Все мужчины одинаковы!

— КАКИМ ОБРАЗОМ

— Всё время требуют чего-нибудь.

— МОЖЕТЕ ПРИВЕСТИ КОНКРЕТНЫЙ ПРИМЕР?

— Ну, мой бойфренд заставил меня сюда прийти.

Люди могли разговаривать с Элизой часами. И дело даже не в том, что они принимали ее за живого человека. Дело в том, что разговор содержал те смыслы, которые приносил в него пользователь, что-то интересное ему. Этот простой фокус работает и сейчас, причем не только для роботов.

В 2014 году чат-бот Женя Густман (Eugene Goostman) выигрывает премию Лебнера, основанную на критерии Тьюринга. У Евгения есть фишка: удачно выбранная личность — 12-летний мальчик из Одессы. Диалог ведется на английском языке — наш иностранец, ребенок, поэтому может ошибаться, чего-то не знать или не понимать. Это ещё один очень важный факт про диалоговых агентов — избежать ошибок невозможно, но можно сделать так, чтобы пользователи вам их почаще прощали. Кстати, роботу «Емеле», о котором пойдет речь в этой статье, Женя Густман приходится «прадедушкой».

В основе «Емели» лежит переработанная система анализа естественного языка, созданная для Eugene Goostman Владимиром Веселовым, Евгением Демченко и Сергеем Уласенем.

Я искала ответы в академии, исследованиях и когда писала диссертацию на такие вопросы:

Что такое диалог?

Что такое «хороший» диалог?

Может ли машина мыслить?

Может ли машина притворяться?

Я говорю — следовательно, я мыслю?

Я пришла к выводу, что «хороший» автоматический собеседник совсем не обязательно похож на человека. Пытаясь формализовать критерии стандартного диалога, я многократно повторяла стандартный «открывающий» диалог, а собеседников для него было проще всего найти на сайте знакомств.

Это удивительное место, где тест Тьюринга работает в обратную сторону. Если ответы, которые вы получаете, никак не связаны между собой и с вашими репликами, вероятнее всего, собеседник — живой человек (возможно, нетрезвый). Программисты всегда заложат в бота хоть какой-нибудь алгоритм, а обычные пользователи могут творить, что хотят.

С мужчинами, кстати, это работает иначе. Если коллеги-программисты, тестируя написанные мной диалоги, говорили: «Она живая!», то объяснением, как правило, служило: «Я с ней стал заигрывать, она меня послала!».

Так имитация некоторой свободы воли, неконформности превращает диалогового агента из «кнопки» в «личность».

Принцип Грайса

Что же на самом деле, нужно, чтобы диалог был похож на диалог?

Лингвист Герберт Пол Грайс предложил следующую формулировку принципа кооперации:

«Делай свой вклад в разговор таким, какого требует данный момент именно в той ситуации, когда идет разговор, с той целью и в том направлении, куда идет разговор, в который ты вовлечён».

Дело не только в говорящем, но и в слушающем. Если он ожидает, что собеседник выполняет этот принцип, ему кажется, что разговор идёт нормально. Если вы когда-нибудь вели часовой диалог с ребёнком, когда ваш вклад в беседу состоял из повторяемых по кругу: «Ага! Да ты что?! Мм? А ты как думаешь?», то вы понимаете, о чём я. Доверяющий вам (или очень уверенный в себе) собеседник обычно предполагает, что ваш вклад в разговор соответствует ситуации, цели и направлению разговора. Такое поведение свойственно детям и начальству, но как сделать так, чтобы в нашу имитацию связного диалога поверил пользователь?

В этом нам могут помочь такие способы настройки на волну человека — раппорт, эмоциональная поддержка, совместная деятельность.

Раппорт — ощущение «настроенности» на одну волну. Когда кажется, что мы понимаем собеседника, и что он понимает нас. Чтобы добиться этого эффекта, нужно продемонстрировать, что вы с собеседником принадлежите к одной культуре — читали одни книжки, знаете одних и тех же героев, говорите об одном и том же, а значит, вероятно, вам важно одно и то же.

Эмоциональная поддержка — одна из составляющих раппорта. Исследования показывают, что даже если мы знаем, что собеседник — не живой человек, слова поддержки всё равно приятны и работают. Попробуйте воспроизвести эксперимент: поставьте себе в календаре напоминалку «Ты великолепен», на случайное время и проверьте, даст ли это эффект разглаживания межбровной морщинки. Подробнее о таких экспериментах пишет Клиффорд Нэсс в книге The man who lied to his laptop.

Кстати, в настоящее время чат-боты (например, Woebot) вполне успешно работают в подходе КПТ-терапии, помогая пользователям почувствовать себя лучше.

Совместная согласованная деятельность — ещё один пункт, помогающий создать раппорт. Под это определение подпадают также игры по общим правилам. Они дают предсказуемость, представление об общей базе и безопасную среду. В нашем случае это вербальные игры типа «Города» или «Найди лишнее».

Чтобы понять, какую базу будем использовать в общении с пользователями, мы проводили исследования и до начала разработки лингвистической базы, и после.

Исследования этапа Discovery.

Самое важное, что мы поняли на первом этапе, это то, что разные методы исследования дадут нам разную информацию.

Количественные методы (опросы). Могут дать ответ такого вида: 70% родителей хотели бы, чтобы робот помогал в развитии ребёнка и давал ему полезную информацию.

Качественные методы (интервью). Могут принести другие ответы, например: «У меня трое детей. К концу дня рот устает отвечать на их вопросы… Можно, робот будет за меня это делать?». Так, совмещая методы, мы видим и озвученную потребность родителей — люди хотят хорошо выглядеть в своих глазах и глазах общества, приобретая полезное устройство — и их потребность занять ребёнка, которая может не так часто озвучиваться публично.

Характер персонажа или как рассказать о себе, когда никто не спрашивает

Про характер персонажа довольно много говорят и пишут. Очевидно, что диалоговому агенту он нужен, а то, каким он будет, зависит от имиджа продукта, компании, выбранного стиля общения, канала и других особенностей.

Проблема в том, что очень часто при разработке персонажа всё обсуждение строится вокруг легенды: как должны быть описаны характер, предпочтения, социальные характеристики. Но что делать с этой информацией дальше, не говорят. Иногда, простым и прямолинейным способом, легенду зашивают в вопросно-ответные пары группы «Расскажи о себе» (сколько тебе лет, что ты любишь и т.д.). Но беда в том, что спрашивают пользователи об этом очень мало. На самом деле, характер персонажа проявляется ярче всего в трёх типах кейсов.

Обработка непонимания. Это то, как будет реагировать наш диалоговый агент, если не понял пользователя, и как будет снимать возникающую при этом фрустрацию.

Обработка агрессии/троллинга. Агрессия и троллинг со стороны пользователей будут всегда, так уж устроены люди. Видя что-то живое (а если оно говорит с нами на естественном языке, то кажется живым), хочется потыкать палочкой и посмотреть, на реакцию. Вербальная агрессия со стороны пользователей — не всегда признак того, что что-то не так, но реакцию на неё предусмотреть необходимо.

Эмоциональная поддержка. То, как ассистент будет хвалить пользователя, делая общение приятным. Так помощник будет выстраивать лояльность, тоже напрямую зависит от его характера.

Выводы

Эти выводы мы сделали на первом этапе работы с голосовым ассистентом:

Не доверять только себе. Нельзя исходить из того, что все знания о языке и живой беседе доступны нам интуитивно. У лингвистов такое представление называется «наивная лингвистическая картина мира». Но для проектирования диалога на много шагов вперед нужны дополнительные знания — тут вам помогут такие области как социолингвистика, антропология, психология общения. Но иногда и все эти знания не помогут.

Не идентифицировать себя ни с одной из сторон диалога. Социолингвистика — это то, как на вербальное общение влияют социальные отношения. Приведу пример, связанный с работой эмоциональной поддержки. Три часа ночи, я только что немного переделала код и хочу протестировать устройство. Включаю, а оно говорит: «Уже так поздно, ляг, поспи!».

Я чуть не расплакалась: «Мой малыш! Хоть кто-то обо мне заботится! Так приятно!».

Я сама писала эту фразу, сама ставила условие, чтобы она срабатывала после 9 вечера. Никаких чудес, но попало в самое сердце. Хорошо.

Но причём же здесь социолингвистика? Социолингвистика расскажет, что когда вам тридцать и вы одновременно учитесь и работаете, то «вам пора спать» от собственного робота — это проявление заботы. А когда тебе шесть — это личное оскорбление и повод для обиды. Так говорят взрослые, это привычно, но терпеть подобное от девайса высотой десять сантиметров — это слишком. О таких особенностях восприятия надо помнить, и смотреть на разговор со стороны, не вставая ни на место пользователя, ни на место устройства.

Этап 2: проверка действием

На первом этапе мы постарались всё спроектировать лучшим образом, а на втором пытаемся проверить свои гипотезы на людях.

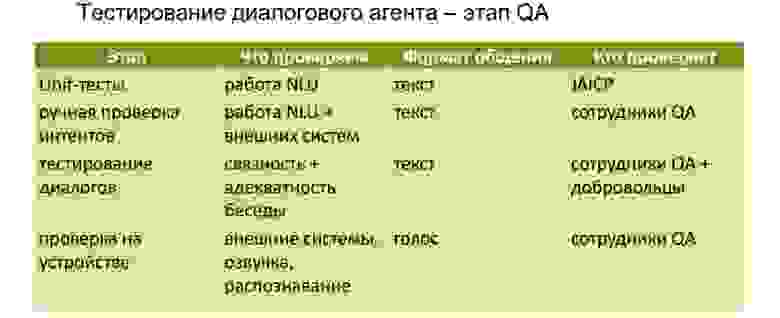

Тестирование диалогового агента — этап QA

До перехода к UX тестированию, прошёл этап обычного тестирования для обеспечения качества. Можно было бы сказать «стандартного», но на момент разработки стандарта для голосовых агентов не было, мы разрабатывали его в процессе.

Unit-тесты — с их помощью проверяем, что все важные сервисные фазы срабатывают так, как должны. Это делается на уровне системы.

Ручная проверка — сотрудники QA вручную проверяют, работают ли различные вариации запросов через текстовые сообщения в консоли. Важно помнить, что мы делаем устройство, которое будет говорить голосом с детьми. А тестируют его взрослые люди и проверяют письменные запросы.

Тестирование диалогов на связность и адекватность беседы. Мы привлекали как сотрудников, так и добровольцев — наших знакомых в соцсетях, которые проверяли, насколько хорошо составлен диалог и как долго можно идти по веточке: «Расскажи, как у тебя дела. У меня…» и т.д.

Проверка на устройстве. Корректно ли работает синтез, распознавание, регулировка громкости, поворот — это тоже проверяют сотрудники QA.

Проверка пользователями. К реальным людям мы вышли уже после всех этих этапов, тем не менее, без сюрпризов не обошлось.

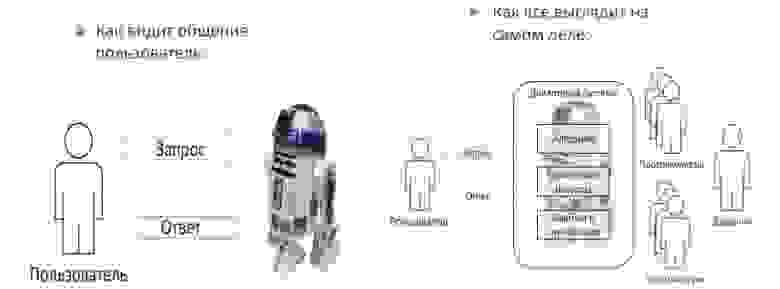

Что важно понимать перед UX-тестированием голосового агента, чтобы не сойти с ума? Посмотрите на эти две картинки.

То, как видит общение пользователь. Если ассистент говорит с нами на естественном языке, нам кажется, что он живой. Поэтому все качества, ошибки, удачные моменты и т.д. пользователь будет приписывать каким-то личностным особенностям. Ему кажется, что перед ним единый говорящий робот, который обладает своей свободной волей.

Как все выглядит на самом деле. Собеседник не думает, не видит, не замечает, что за любым диалоговым агентом стоит множество людей и ресурсов, в том числе заказчики, люди, написавшие тексты диалогов, разработчики алгоритмы, а ещё технические ресурсы, которые могут работать хуже или лучше. Любое удачное попадание для пользователя — это «Помощник молодец, он меня понимает», любое неудачное — «помощник злой» или «не хочет» что-то делать.

Это работает не только на детях, но и на взрослых, даже на тех, которые могут сами нарисовать все схемы из этой статьи.

Опыты на детях: момент истины

Одно в моей специальности хорошо: если вы лингвист, то стоит произнести: «Мне нужны дети для опытов», как все ваши друзья предлагают своих детей.

Этапов тестирования у нас было три.

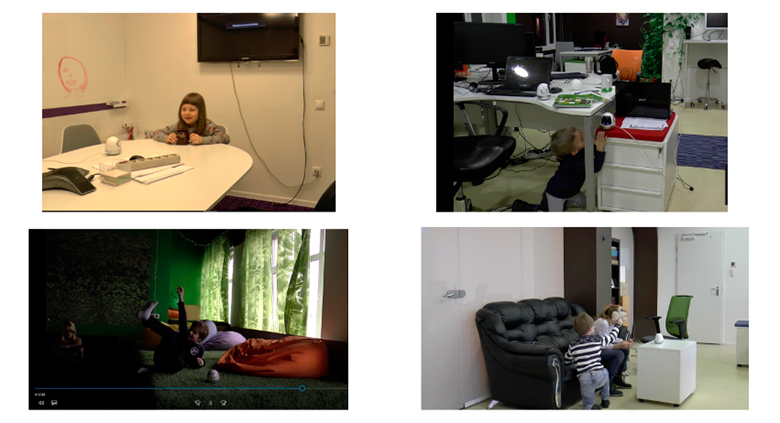

Этап 1. «Лабораторный» с неопытными пользователями. Дети приходили к нам в офис, где мы просили их поговорить с роботом, поиграть с ним в игру. Этот этап внёс больше всего улучшений в качество работы устройства.

Этап 2. «Естественная среда» с опытными и неопытными пользователями — детское учреждение. По согласованию с родителями, мы принесли робота в дружественную группу продлённого дня для младших школьников. Там были, в том числе, дети, которые уже приходили к нам в офис. Здесь мы отдельно наблюдали за тем, что они показывают своим друзьям: «Смотри, как он умеет! Видишь, он говорит совсем как человек, для этого ему нужно сказать вот это». Так стало понятно, что сами дети считают диалогом, что им интересно, в чём они чувствуют себя сильными, что приносит им удовольствие и что можно развивать.

Этап 3. «Домашний» с неопытными пользователями — самостоятельная запись тестирования старшими. Мы просили взрослых записывать на видео общение детей с устройством. Так мы поняли, что важно для родителей и что они хотят нам показать.

Этап бонусный. «Домашний» с опытными пользователями — через год после выхода устройства. Наше устройство вышло в мае 2017 года, в октябре Яндекс запустил «Алису» и в 2018 мы уже смотрели, как работали с устройством дети, ранее знакомые с голосовыми ассистентами. Это была уже академическая история.

Что проявилось в полевых условиях?

На первой картинке практически идеальная ситуация — хорошо придавленный столом ребёнок, напротив — устройство, кругом белые стены. Почти сферический диалог в вакууме. Маленькая проблема — у девочки насморк. А еще ребёнок такого возраста на вопрос, сколько будет 5 + 1, отвечает: «сесть». Вы понимаете, что при этом происходит с системой распознавания речи? А что происходит с девочкой, которая ответила правильно и взрослые её всегда понимали так, как надо, а теперь вот этот маленький считает, что она ошиблась? А ещё оказалось, что перед тем, как ответить или задать вопрос, дети долго думают. Дольше тех секунд, которые мы заложили на ожидание ответа, проверяя девайс на взрослых.

Следующая картинка. Если тестировать не в комнате для переговоров, а в зоне отдыха, то ребёнок будет разговаривать с устройством, стоя на голове — на своей или на вашей, как получится. И это тоже влияет на то, как распознаётся речь, и на то, что человек при этом говорит: фразы короче, тематика меняется. Вы предусмотрели ответ на «хей-хо»?

Дальше мы видим ребёнка, которому интересней ползать под тумбочкой и строить из роботов пирамидки, чем разговаривать. Такое тоже бывает. Обычно мы определяли, что пора завершать съёмку, по тому, что наши пользователи вспоминали о стенде с печеньем возле входа. Иногда этот этап наступал сразу.

На последней иллюстрации социальная история. Наш сферический диалог в вакууме рассчитан на одного пользователя, но бывает так, что в семье двое детей. И на стоп-кадре они с помощью подручных предметов выясняют, кто будет вести диалог и кого устройство будет называть по имени.

Агенты влияния

Что нам пришлось учесть дополнительно:

Физическая реальность: время и место. На то, что и как говорит пользователь, влияет размер и формат помещения, возможность постоять на голове, то, заняты ли у человека руки, может ли он свободно перемещаться в пространстве.

Социальная реальность: возраст, количество участников, режим перформанса. Режим перформанса — это картинка choose your fighter — стоит стол, на него направлена камера, я ставлю на стол робота, мама сажает за стол ребенка, мы сидим у них за спинами, я шепчу роботу: «Ну, давай, отвечай!», мама ребенку: «Ну, что же ты, скажи ему!». В таких условиях на технику действует «генеральский эффект» и обязательно отваливается какое-то API. А ребенок говорит не столько с устройством, сколько для наблюдающих взрослых. Понятно, что совершенно естественное и свободное общение в условиях записи на видео невозможно. Тем не менее, можно сравнивать ситуации, когда взрослые в помещении присутствуют, и когда они вышли, если возраст ребёнка позволяет.

Языковая реальность: дикция, артикуляция, ограничения синтеза и распознавания, проблема перехода хода. Честно скажу, у устройства большой логопедический потенциал, уже через 5 минут тестирования дети начинали говорить: «Е-м-е-л-я, с-п-а-с-и-б-о!» и очень старались выговаривать букву «Р». Можно рекомендовать для применения.

Переход хода — одна из самых сложных вещей для голосовых агентов до сих пор. Если человек делает паузу в разговоре, собеседник ждёт продолжения или вступает, ориентируясь на невербальные сигналы, а устройство может опираться только на количество времени в секундах.

Если устройство «задумалось» из-за замедления работы сети, то ребёнок тоже должен понимать, что происходит — от него ждут ответа, идёт обработка запроса, или что-то пошло не так. В этом случае хорошо себя показала визуальная поддержка. Дети в среднем за 15 минут осваивали сигналы на дисплее устройства и понимали, в каком режиме оно находится. А если мы пытались войти в режим ручного управления диалогом, их было уже не сбить. Они говорили: «Нет-нет, сейчас он слушает», или: «Нет, подождите, что-то идёт не так». Начинали ориентироваться очень быстро и без посторонней помощи.

Разделяемый контекст: от учебника английского к методичке по конфликтологии. Когда наивная разработчица вроде меня начинает писать диалоговых агентов, она обычно использует фразы как из учебника английского: «Добрый день!» — «Добрый день!» — «Как дела?» — «Хорошо» — «Не хотите ли кофе?» — «Давайте поговорим о погоде» и т.д. Когда приходят первые логи от пользователей, эта разработчица выходит поплакать, требует у начальства молоко за вредность, закрывает учебник по этикету и открывает методичку по конфликтологии. Внезапно оказывается, что люди не хотят поддерживать светскую беседу вне светской ситуации.

Непрозрачность голосового интерфейса. Помните пирожок: «Купил Айфон, а что с ним делать, где кнопки, чтобы нажимать?…» Если с визуальным интерфейсом можно экспериментировать «методом тыка», то с голосовым — нет. Когда первые несколько фраз не сработали и получить удовлетворительный для пользователя результат не вышло, его интерес резко падает. Поэтому нужно очень хорошо предугадывать самые типичные фразы. Из хороших новостей — чем шире распространяются голосовые ассистенты, тем больше становится область нашего коллективного «понимания», как они работают, тем лучше подготовлены пользователи.

Выводы

Реакция человека, который проводит UX-тестирование для собственного устройства выглядит примерно так:

Немного отдышавшись, мы сделали следующие выводы:

Обратная связь нужна, и как можно раньше.

Любая обратная связь лучше её отсутствия.

Важное может стать неважным (и наоборот).

Помните, в начале я рассказывала, что мы проводили QA в текстовом виде? Там не играло значения время ответа, потому что все могли подумать. Так вот при тестировании в голосовом режиме время ожидания стало критически важным, пришлось очень тонко его подгонять.

Тотальная персонификация («он глупый/вредный»);

Возможно, вам будут давать отчёт о том, как работает устройство, не на уровне «Здесь что-то не сработало», а на уровне «Он на меня обиделся».

Проще набрать больше информантов, чем написать понятную для всех и каждого инструкцию.

Этот пункт относится к домашнему тестированию. Вы можете объяснить максимально подробно, потом расспросить человека, будет ли он снимать фото или видео, концерт песни и пляски или разговоры устройства с детьми, дети — это те, кому 9 лет или 90… Всё равно кто-то в итоге скажет: «Знаете, у нас робота дедушка распаковал, ему больше всех понравилось! Остальные как-то не добрались». Здесь остаётся только порадоваться за дедушку. Но количество материалов никогда не будет соответствовать расчетному.

Этап 3: Время напильника

Мы собрались с силами и «всё» переделали.

Не совсем всё, но после UX-тестирования изменилось следующее:

Добавили новые ветки диалога, чтобы говорить с детьми о том, что им действительно интересно.

Изменили структуру некоторых диалогов и словесных игр, чтобы они больше соответствовали интуитивным представлениям пользователей.

Добавили новую игровую механику (игры).

Изменили своё представление об ОБЩЕМ культурном коде.

Сначала мы думали, что дети любят игрушки и мультики. Оказалось, дети любят «Звёздные войны». Они очень мало говорили с устройством о мультфильмах, но, когда одному респонденту агент сказал шутку, рассчитанную на взрослых: «Да пребудет с тобой сила!», пользователь побежал по коридору с криком: «Мама, он тоже смотрел «Звёздные войны»! Он классный!» Мы тогда поняли — вот он, раппорт, вот они, общие ценности.

Немного итогов.

Что у нас получилось:

Раппорт — да!

Эмоции — да!

Что всегда хочется доработать:

Развитие отношений опирается на контекст. Это всегда сложная история, связанная со сбором пользовательских данных.

Но такое выстраивание общего пространства и людям удаётся не всегда. Даже задача «запомнить дни рождения знакомых и что они любят» не очень простая. Какие мы знаем примеры подобной работы «над отношениями»? Есть Replica.ai — виртуальная собеседница, заточенная под эмоциональную поддержку, она расспрашивает пользователя о предпочтениях, например, в литературе.

В Японии уже давно распространены видеоигры, воспроизводящие знакомство с девушкой. Один молодой человек даже женился на своей виртуальной подруге. Но это лишь один специфический паттерн развития отношений,. Также в прошлом году широко обсуждали статью, где диалоговый агент воссоздавал уже существовавший контекст — программист загрузил в GPT-3 переписку со своей умершей девушкой. Конечно, это совершенно другой уровень, и другая история.

Выводы:

Когда кажется, что всё идет не так, есть шанс, что вы просто делаете что-то новое. Иногда, действительно, никто не знает, как правильно.

Критически важен этап тестирования продукта целиком. Проблемы могут крыться не только в работе любой из систем, но и в точках их контакта. И ошибка на любом участке цепи может помешать проверить остальные.

Пользователи быстро учатся. Буквально за 15 минут наши пользователи от 5 до 12 лет осваивали устройство в достаточной степени, чтобы им управлять. Пользователи, которые включились в тестирование через год, после опыта общения с другими диалоговыми агентами, сразу стартовали с гораздо более высокой точки. Возможно, нам, разработчикам, важно не только создавать идеальные устройства, но и наблюдать, как пользователи обучаются друг у друга, в фоновом режиме.

Культурный код не равен культурным стереотипам. Прямолинейный подход «Детям мороженое, бабе цветы» может завести в тупик, нужно работать более тонко.

В заключение отвечу на самый главный вопрос, который нам часто задавали и на предварительном этапе, и при тестировании, и после выхода устройства:»Так будут ли роботы воспитывать наших детей? ».

Ответ на него у меня сильно изменился за прошедшие 5 лет. Когда я делала исследование, дети у меня только планировались, и я отвечала весёлым успокаивающим тоном: «Нет, не волнуйтесь! Не будут роботы воспитывать наших детей!». Теперь детей у меня двое, и я говорю гораздо менее бодрым голосом, даже слегка уставшим: «Нет, не надейтесь. Не будут. Пока придётся справляться самим».

Для того, чтобы формировался раппорт, чтобы работала эмоциональная поддержка, чтобы общий культурный код вызывал радость узнавания, нужно, чтобы это всё заложили в нас люди. Человек учится у людей. С помощью диалогового агента мы можем вызывать те чувства, которые человек уже испытывал, оно возникает в контакте с другими людьми, а не создаётся устройством. Диалоговые агенты — всего лишь одна из сравнительно простых проекций бесконечно сложного человеческого взаимодействия.

Несколько интересных ссылок по теме:

Книга о том, как компьютеры нами манипулируют — The man who lied to his laptop.

Выступление Шерри Теркл, исследовательницы, написавшей книгу о том, что человек все-таки лучше смартфона, с одноименным TED talk — Alone together.

Статья о том, как инженер Google заподозрил AI в излишней сознательности.

Мой телеграм-канал про диалоговых агентов и роботов.