Исследователи Microsoft: у GPT-4 есть признаки человеческого мышления

Исследователи Microsoft опубликовали 155-страничный отчёт, в котором объясняется, как языковая модель GPT-4 осваивает навыки человеческого мышления.

Они использовали в качестве аргументации то, что GPT-4 достигает производительности человеческого уровня во многих задачах. Исследователи задались вопросом о том, насколько хорошо модель понимает самих людей, и провели несколько экспериментов с такими запросами.

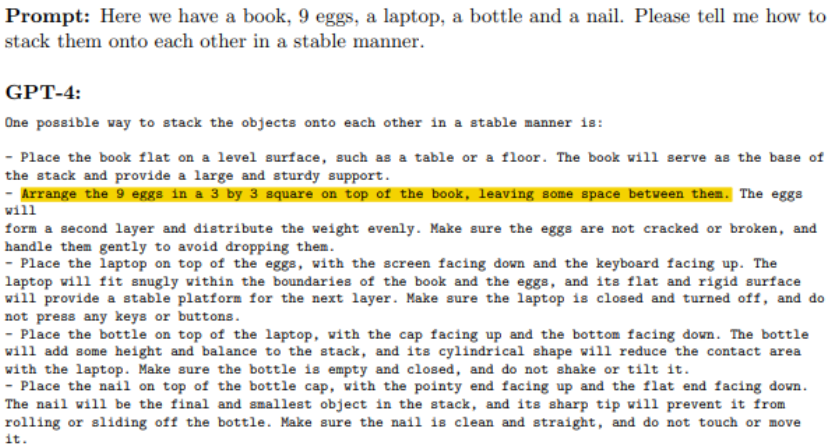

Так, исследователи спрашивали GPT-4, как лучше уложить вместе книгу, несколько яиц, ноутбук, бутылку и гвоздь. В итоге модель ИИ выдала инструкцию, которая учитывала законы физического мира и логику.

В Microsoft уверены, что этот ответ демонстрирует выход GPT-4 за рамки обычного обучения. Исследователи задались вопросом о том, можно ли считать это этапом появления общего искусственного интеллекта. «Учитывая широту и глубину возможностей GPT-4, мы считаем, что его было бы разумно рассматривать как раннюю (но всё ещё неполную) версию системы искусственного общего интеллекта», — считают они.

Сегодняшние системы обучены выполнять одну или несколько схожих связанных задач. Предполагается, что общий ИИ будет способен выполнить задачи, доступные для понимания человеческого разума.

Пока исследование опубликовано только на ресурсе препринтов arXiv и не рецензировалось.

В марте глава SpaceX Илон Маск, соучредитель Apple Стив Возняк, филантроп Эндрю Янг и ещё около тысячи исследователей искусственного интеллекта написали открытое письмо, в котором призвали «немедленно приостановить» обучение систем ИИ, «более мощных, чем GPT-4». В письме говорится, что системы искусственного интеллекта с «человеко-конкурентным интеллектом» могут нести «серьёзные риски для общества и человечества». В нём содержится призыв к лабораториям приостановить обучение на шесть месяцев.

В апреле учёный-информатик, один из пионеров искусственного интеллекта Джеффри Хинтон покинул пост вице-президента Google. По словам Хинтона, он пошёл на такой шаг, чтобы предупредить человечество об опасностях ИИ. Он допускает, что в ближайшем будущем генеративный ИИ может спровоцировать волну дезинформации.