Взгляд изнутри на OpenBMC применительно к системам OpenPOWER

Для полноты истории придётся начать немного издалека и рассказать о назначении сервисных процессоров и роли BMC в работе сервера, затронуть протокол IPMI и программную часть. После этого кратко опишу, как BMC участвует в загрузке систем на POWER8. Закончу обзором проекта OpenBMC и нашим отношением к вопросу. Опытные в теме сервисных процессоров читатели могут сразу отмотать на нижние разделы.

Сервисный процессор — это отдельный специализированный контроллер, встраиваемый в сервер. Его чип может быть напаян на материнскую плату, расположен на отдельной карте или, к примеру, размещён в блейд-шасси для управления ресурсами всей системы в целом (и тогда это может называться уже SMC — System Management Controller). BMC — частный случай сервисного процессора для управления отдельным хостом, и дальше по тексту будем говорить только о них и использовать термин «сервисный процессор» только в значении «BMC». При этом, говоря «BMC», в целом имеем в виду как собственно чип, так и управляющую прошивку. В некоторых случаях отдельно будем указывать, что речь идёт о аппаратной либо программной части.

BMC запитан отдельно от основной системы, включается автоматически при подаче дежурного (standby) питания на сервер и работает, пока питание не отключится. Почти все сервисные процессоры умеют управлять питанием хоста, предоставлять доступ к консоли главной операционной системы через Serial Over LAN (SoL), считывать показания системных датчиков (скорость вентиляторов, напряжение на блоках питания и VRM, температура компонентов), следить за исправностью компонентов, хранить аппаратный лог ошибок (SEL). Многие предоставляют возможности удаленного KVM, виртуальных медиа (DVD, ISO), поддерживают различные протоколы out-of-band подключения (IPMI/RMCP, SSH, RedFish, RESTful, SMASH) и прочее.

Сейчас удалённоe управление повсеместно распространилось. Оно облегчает управление большим парком серверов, повышает доступность из-за сокращения времени простоя, и улучшает операционную эффективность датацентров. Как следствие, наличие широких возможностей удалённого менеджмента учитывается заказчиками при выборе поставщика аппаратной платформы.

Пользователями BMC в основном являются сисадмины для удалённого управления, восстановления после сбоев, сбора логов, установки ОС и т.д. Данными из сервисного процессора пользуется техподдержка. Для нее BMC часто является единственным источником информации при устранении сбоев и выявлении неисправных компонентов для замены.

В современной инфраструктуре BMC является не просто приятной дополнительной опцией удалённого управления сервера (хотя не ходить в серверную, где холодно, шумно, негде присесть и плохо ловит мобильный — это приятно). Во многих ситуациях это критический компонент инфраструктуры. Когда операционная система или приложение не отвечает или находится в непонятном состоянии, сервисный процессор является единственным источником информации и способом быстро восстановить работу.

Для подключения к сервисному процессору используют выделенный сетевой порт (out-of-band), или же BMC делит сетевой порт с основной системой (sideband). То есть один физический Ethernet-коннектор, но два независимых MAC и два IP-адреса. Для первоначальной настройки часто используют консольное RS-232 подключение.

IPMI

Краткая справка

Исторически, программная часть BMC разрабатывалась вместе с аппаратной платформой сервера и теми же разработчиками. Как следствие, для каждой платформы ПО сервисного процессора было уникальным. У одного и того же вендора могло быть несколько вариантов прошивок BMC для разных линеек продуктов. Несмотря на распространение open source, прошивки BMC оставались долгое время исключительно проприетарными.

Обычно сервисный процессор основан на специализированных системах на кристалле (System-on-Chip, SoC), и стандартом де-факто описания требований к архитектуре аппаратной части является спецификация IPMI (Intelligent Platform Management Interface). Это достаточно старый стандарт, ещё в 1998 году группа компаний разработала первую спецификацию IPMI для стандартизации управления сервером.

IPMI предусматривает общий интерфейс сообщений для доступа ко всем управляемым компонентам в системе и описывает большой набор интерфейсов для разных типов операций — например, мониторинга температуры, напряжения, скорости вентиляторов, или получения доступа к консоли ОС. Также предусмотрены методы для управления питанием всего комплекса, получения аппаратных логов SEL (System Event Log), считывания данных сенсоров (SDR), реализации аппаратных watchdog«ов. IPMI предоставляет замену или абстракцию для отдельных методов доступа к сенсорам, таких как System Management Bus (SMBus) или Inter Integrated Circuit (I2C). В большинстве BMC используют проприетарный IPMI стек от небольшого числа вендоров.

Претензии к IPMI

К протоколу накопилось много претензий, в том числе в части безопасности при доступе по сети (IPMI over LAN). Периодически сеть сотрясают истории, подобные этой. Дело вот в чем — получив доступ к сервисному процессору, мы получаем полный контроль над сервером. Ничто не мешает перезагрузиться в recovery mode и поменять пароль для «root»-учётки. Единственным надёжным средством от подобной уязвимости является правило, что IPMI траффик (UDP порт 623) не должен выходить за пределы специально выделенной сети или VLAN. За активностью в управляющей сети должен быть строгий контроль.

Кроме проблем c безопасностью, аппаратный ландшафт датацентров сильно изменился за минувшие годы. Распространились виртуализация, дезагрегация компонентов, облака. В протокол IPMI сложно добавлять что-то новое. Чем больше серверов надо администрировать, тем выше значение автоматизации процедур. Появляются спецификации API, призванные заменить IPMI over LAN. Многие возлагают надежды на RedFish.

Этот API использует современные JSON и HTTPS протоколы и RESTful интерфейс для доступа к данным «out-of-band». Цель разработки нового API — предложить отрасли единый стандарт, который подходил бы для гетерогенных датацентров. Причем и для одиночных сложных enterprise серверов и для облачных датацентров из множества commodity серверов. И этот API должен отвечать актуальным требованиям безопасности.

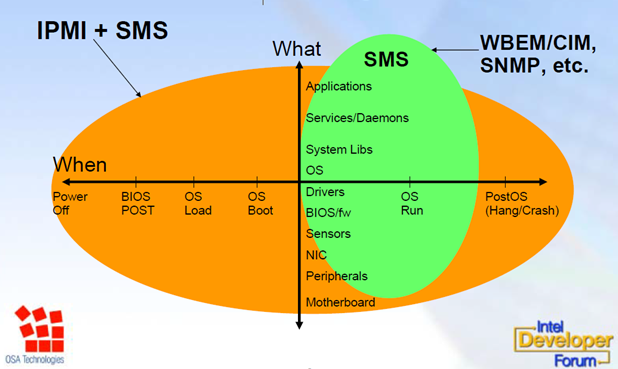

При этом на аппаратном уровне стандартом является поддержка IPMI, который участвует во всем рабочем цикле сервера, начиная от включения питания, загрузки операционной системы и заканчивая восстановлением после сбоя (зависания, паники, и т.д.).

Роль BMC в жизни сервера. На этой картинке SMS означает «System Management Software». Картинка взята отсюда.Роль BMC в загрузке системы OpenPOWER

В сердце аппаратной части протокола IPMI находится чип BMC. Он задействован в работе сервера, начиная с момента подачи питания и участвует в процессе начальной загрузки сервера на OpenPOWER. То есть BMC необходим для включения системы. В то же время перезагрузка/падение BMC не влияет на уже работающую операционную систему.

BMC и процессор POWER8 соединены шиной LPC (Low Pin Count). Эта шина предназначена для связи процессора с периферийными, относительно медленными устройствами. Она работает на частоте до 33 МГц. Через LPC центральный процессор (то есть микрокод Hostboot/OPAL) общается с IPMI-стеком BMC по BT (стр. 104) интерфейсу. По этой же шине POWER8 получает загрузочный микрокод из PNOR (Processor NOR chip) через LPC → SPI (Serial Peripheral Interface) соединение.

Роль BMC в этапе загрузке Power off → Standby

Первый этап загрузки начинается, как только блоки питания включены в сеть и заканчивается на стадии, когда BMC полностью включился и готов начать загрузку всего хоста. Забегая вперёд, отмечу, что отсюда и далее описываю работу ПО BMC на OpenPOWER-системах вообще, но конкретно в нашем сервере эти функции выполняет OpenBMC. При подаче питания BMC начинает выполнять код из SPI флэш, загружает u-boot и затем ядро Linux. На данном этапе на BMC работает IPMI, шина LPC подготовлена для доступа хоста к PNOR памяти (монтируется через mtdblock). Cам чип POWER8 на данном этапе выключен. В этом состоянии можно подключиться к сетевому интерфейсу BMC и что-то поделать.

Standby → OS boot

Когда система в режиме «standby», и нажата кнопка включения питания, BMC инициирует продолжение загрузки и запускает на мастер-процессоре «маленький» контроллер SBE (Self Boot Engine) внутри POWER8 чипа на загрузку Hostboot микрокода из PNOR-флэша в L3 кэш мастер-процессора.

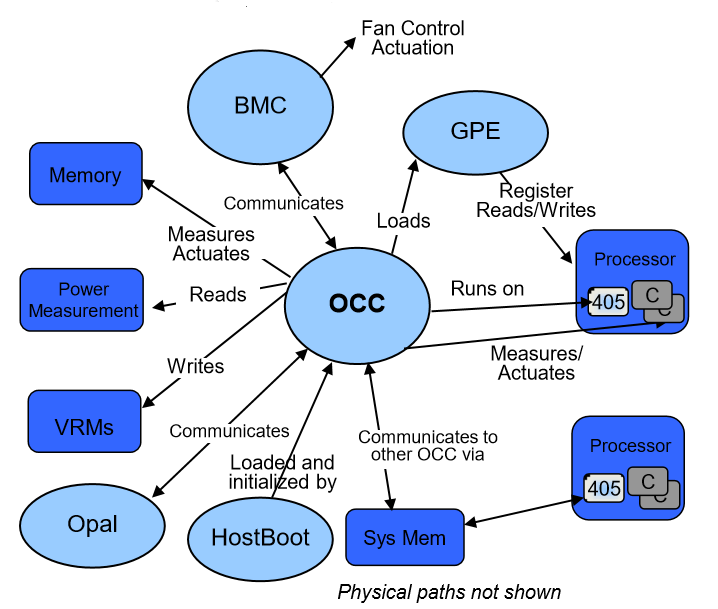

Микрокод Hostboot отвечает за инициализацию шин процессора, SDRAM памяти, остальных процессоров POWER8, OPAL (Open Power Abstraction Layer) и еще одного микроконтроллера встроенного в POWER8, называемого OCC (On Chip Controller).

Об этом контроллере расскажем чуть подробнее, так как для BMC он имеет особое значение. Когда Hostboot заканчивает свою работу, из PNOR флэша запускается следующий компонент микрокода Skiboot. Этот уровень синхронизирует процессоры, инициализирует шины PCIe, а также взаимодействует с BMC через IPMI (например, обновляет значение сенсора «FW Boot progress»). Skiboot также отвечает за запуск следующего уровня загрузки Petitboot, который выбирает, откуда будет загружена основная операционная система, и запускает ее через вызов kexec.

Но сделаем шаг назад, и вернёмся к OCC. Чип OCC представляет собой ядро PPC 405, встроенное в процессор IBM POWER8 вместе с основными ядрами POWER8 (один ОСС на чип). У него есть собственные 512 КБ SRAM, доступ к основной памяти. Это система реального времени, ответственная за температурный контроль (мониторинг температур памяти и процессорного ядра), управление производительностью памяти, отслеживание напряжения и частоты процессора. OCC предоставляет доступ ко всей этой информации для BMC по шине I2C.

Что именно делает OCC?

- Отслеживает состояние электропитания компонентов сервера.

- Отслеживает и контролирует температуру компонентов; в случае перегрева снижает производительность памяти (memory throttling).

- Если необходимо, OCC снижает частоту/энергопотребление процессора за счет снижения максимального P-state (performance state, см. ACPI). При этом OCC не задаёт P-state напрямую. Он задает лимиты, в рамках которых операционная система может менять P-state.

- Предоставляет BMC информацию о питании и температуре для эффективного управления вентиляторами.

Таким образом, OCC является поставщиком информации для BMC, к которому подключен по шине I2C. Исходный код большей части микрокода для POWER8 (и в частности для OCC) был открыт IBM.

Кроме взаимодействия с OCC и центральным процессором по шине LPC, у BMC есть и другие интерфейсы. Например, для управления блоками питания и LED используется GPIO на чипе BMC, для чтения сенсоров может использоваться I2C.

Взаимосвязь всего вышеупомянутого не так уж сложна

На данный момент большая часть микрокода OpenPOWER является открытой. При этом программная часть сервисного процессора и стек IPMI до недавнего времени оставались проприетарными. Первым open source проектом для сервисного процессора стал OpenBMC. Сообщество встретило его с воодушевлением и стало активно развивать. Про OpenBMC и поговорим дальше.

OpenBMC, его история и особенностиНаконец, мы подходим к истории появления OpenBMC и том, как мы его используем.

Рождение OpenBMC в Facebook

Появился OpenBMC в компании Facebook при разработке свитча Wedge в рамках сообщества OCP в 2015 году. Изначально программную часть BMC разрабатывал поставщик железа. В первые месяцы работы возникло много новых требований к BMC, координация которых с разработчиками была сложной и вызывала задержки. Под влиянием этого, на одном из хакатонов четыре инженера Facebook реализовали некоторые из базовых функций BMC за 24 часа. До продуктива было очень далеко, но стало ясно, что задача реализации софтверной части BMC может быть решена отдельно от аппаратной.

Через несколько месяцев OpenBMC официально был выпущен вместе с коммутатором Wedge, а еще через некоторое время исходный код OpenBMC был открыт в рамках партнерства OCP.

Далее Facebook адаптировал OpenBMC для NVMe флэш-полки Lightning, а следом и для шасси микросерверов Yosemite. В последнем изменении Facebook отказался от RMCP/RMCP+ (доступ IPMI over LAN), но появился REST API через HTTP (S) и консольный доступ по SSH. Таким образом, у Facebook получился единый API для управления разными типами оборудования и большая гибкость реализации новых фич. С проприетарным подходом к BMC такое было бы невозможно.

В концепции Facebook, BMC — обычный сервер, но работает на SoС c ограниченными ресурсами (медленный процессор, мало памяти, небольшой флэш). С учетом этого, OpenBMC был задуман как специализированный дистрибутив Linux, все пакеты которого собираются из исходников с помощью проекта Yocto. Описание всех пакетов в Yocto объединяются в «предписания» (recipes), которые в свою очередь объединяются в 'слои» (layers).

OpenBMC имеет три слоя:

- общий уровень, user space приложения (не зависят от железа).

- SoC уровень (ядро Linux, bootloader, C library).

- уровень платформы/продукта (пакеты специфичные именно для конкретного продукта, настройки ядра, библиотеки для сенсоров).

Facebook не первый, кто стал использовать Yocto в BMC. На этой же системе сборки построен проприетарный Dell iDRAC.

OpenBMC легко портируется с одной платформы на другую с помощью пересборки несколькими командами bitbake. Это позволяет использовать один и тот же BMC и как следствие один API на разных аппаратных платформах. Этим можно сломать сложившуюся традицию зависимости программного стека от аппаратной части.

Fork проекта в IBM

Сообщество OCP быстро прониклось идеей OpenBMC, и в разработку активно включился другой участник OCP — IBM. Их стараниями возник форк проекта под OpenPOWER, и к августу 2015 была выпущена первая версия OpenBMC для сервера Rackspace Barreleye под SoC AST2400. Инженеры IBM решительно взялись за дело и не просто адаптировали OpenBMC под новую платформу, а значительно его переработали. При этом из-за сжатых сроков и для простоты разработки активно использовали Python.

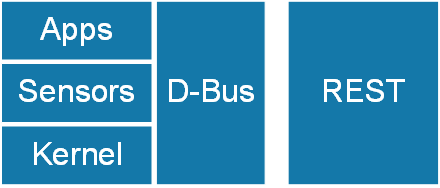

Изменения коснулись всех слоев проекта, в том числе переработано ядро Linux под SoC (устанавливаемые драйвера, добавлен device tree), на пользовательском уровне появился D-Bus для межпроцессорного взаимодействия (у facebook D-Bus не было). Именно через D-Bus реализованы все функции OpenBMC. Основным способом работы с OpenBMC является REST интерфейс для доступа к интерфейсам шины. Кроме того, есть Dropbear SSH.

Предусмотрен web-доступ к REST API (для отладки, к примеру) через фреймворк Python Bottle.

Благодаря легкой портируемости OpenBMC с одной платформы на другую, для разработки могут использоваться отладочные платы, вплоть до RaspberryPI. Для упрощения разработки предусмотрена сборка под эмулятор QEMU.

Сейчас OpenBMC имеет достаточно аскетичный консольный интерфейс через SSH. IPMI поддерживается со стороны хоста в минимальном объеме. REST-интерфейс может использоваться приложениями для удаленного управления и мониторинга. Часть наиболее популярных функций реализована через команду obmcutil.

Наверное, 90% операций, выполняемых через BMC, — это включение/выключение сервера. В OpenBMC это делается командами obmcutil poweron и obmcutil poweroff.

Также, к примеру, через obmcutil можно посмотреть значение сенсоров и подробную информацию про аппаратную часть сервера (FRU), если это поддерживается на конкретной платформе:

obmcutil getinventory

obmcutil getsensorsСейчас, в проекте OpenBMC активно участвует не только IBM, но и много других вендоров, заинтересованных в уходе от закрытого стека BMC. Сам IBM сосредоточен в основном на адаптации под платформу P9.

Большая часть разработки OpenBMC ведется под лицензией Apache-2.0, но в состав OpenBMC входит множество компонентов с разными лицензиями (например, ядро Linux и u-boot под GPLv2). В результате получается микс из разных open source лицензий. Кроме того, разработчики могут добавлять в конечную сборку собственные проприетарные компоненты, которые работают параллельно с Open Source.

Наш взгляд на OpenBMCКак понятно из текста выше, программную часть своего сервисного процессора мы проектируем на основе OpenBMC. Продукт еще сырой, но самый минимум функций для администрирования сервера в нем уже реализован, частично реализован IPMI (для самых базовых потребностей). Сервисные процессоры в серверах с таким набором возможностей были на рынке несколько лет назад.

OpenBMC постоянно изменяется и совершенствуется, почти каждый день на gerrit сервере можно увидеть новые коммиты. Поэтому сильно концентрироваться на функциональности в данный момент — дело не очень благодарное. Непрерывно выполняется рефакторинг, код на Python заменяется на C/C++, больше функций переносятся в systemd.

Отношение к сервисному процессору, как к обычному серверу нетипично для BMC из-за его важной роли в жизни сервера. Использование systemd и D-Bus не было распространено в этой области раньше. Новое время — новые веяния.

Первая задача для нас — адаптация текущего состояния OpenBMC под нашу платформу. Далее мы планируем доработать ее опциями и интерфейсами, в которых заинтересованы наши заказчики. С учетом ограниченной функциональности на текущий момент, направлений для разработки есть великое множество. По мере реализации новых возможностей обязательно будем коммитить изменения в проект OpenBMC, чтобы сообщество могло пользоваться.

Комментарии (3)

8 декабря 2016 в 15:52

0↑

↓

Intel уже придумали AMT с удалённым управлением. Опустим OpenPOWER, я про x86, в чём преимущества BMC/IPMI перед этой технологией? AMT мне ещё не удалось потыкать, только собираюсь, поэтому я е в курсе её возможностей, однако, выглядит похоже, есть даже запуск с ISO.

8 декабря 2016 в 16:35

0↑

↓

AMT предназначен для PC/ноутбуков, в то время как BMC/IPMI для серверов. Так что имхо нельзя сравнивать, хотя функциональность пересекается.8 декабря 2016 в 16:53

0↑

↓

А можно конкретные примеры различий в функциональности, хотя бы пару штук? К примеру, я знаю, что в IPMI от SuperMicro есть SNMP и почтовые уведомления, подозреваю, что этого в AMT нет, что-то ещё?