[Перевод] Воссоздаем старую компьютерную графику с помощью генеративных моделей

Могут ли современные алгоритмы создавать улучшенные версии старой графики видеоигр с более высоким разрешением?

Последние несколько дней я использовал ИИ-генерацию изображений для воспроизведения одного из кошмаров моего детства. Я использовал Stable Diffusion, Dall-E и Midjourney, чтобы посмотреть, как эти инструменты генерации изображений могут помочь улучшить старую визуальную историю — вступительный фильм к старой видеоигре (Nemesis 2 на MSX). В этом посте описывается процесс и мой опыт использования этих моделей для улучшения графики.

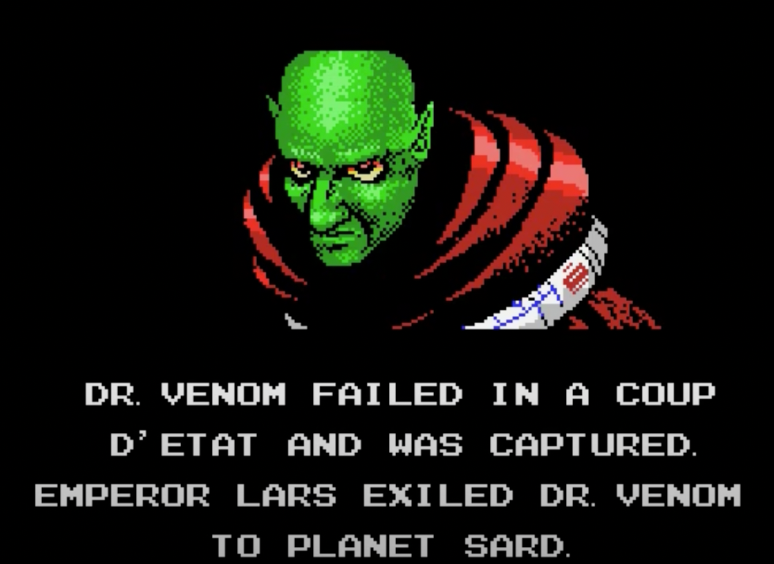

Встречайте, доктор Веном

Этот симпатичный джентльмен — злодей в видеоигре. Доктор Веном появляется во вступительном ролике видеоигры Nemesis 2, вышедшей в 1987 году. Это изображение, в частности, появляется в драматическом моменте фильма.

Давайте обновим картинки из игры с помощью инструментов визуального генеративного ИИ и посмотрим, кто же будет лучше?

Создаем компьютерную графику заново с помощью AI

Вот вид сбоку на карточках из оригинального кинофильма (левая колонка) и финальные карточки, созданные инструментами ИИ (правая колонка):

На этом рисунке не показана финальная графика Доктора Венома, потому что я хочу, чтобы вы увидели ее, как это сделал я, в соответствующем контексте и под соответствующую музыку. Вы можете посмотреть это здесь:

Карточка 1

Оригинал

А это сгенерировано Stable Diffusion с помощью Dream Studio:

Однако путь к этому образу проходит через создание более 30 изображений и настройку входных подсказок. Первая подсказка, которую я использовал, выглядит следующим образом:

fighter jets flying over a red planet in space with stars in the black sky

На что DALL-E генерирует следующие изображения:

Если вставить аналогичный запрос в Dream Studio, то появятся такие картинки:

Ищем подходящие входные фразы в Lexica

Текущее решение состоит в том, чтобы либо изучить руководство по подсказкам и выучить стили, которые люди находили успешными в прошлом, либо искать в галерее типа Lexica, которая содержит миллионы примеров и соответствующие им подсказки. Я выбираю последний вариант, поскольку изучение заумных ключевых слов, которые будут работать на конкретных версиях конкретных моделей, не является выигрышной стратегией в долгосрочной перспективе.

В итоге я нахожу изображение, которое мне нравится, и редактирую его в соответствии со стилистической частью входной подсказки, чтобы в итоге оно выглядело так:

fighter jets flying over a red planet in space flaming jets behind them, stars on a black sky, lava, ussr, soviet, as a realistic scifi spaceship!!!, floating in space, wide angle shot art, vintage retro scifi, realistic space, digital art, trending on artstation, symmetry!!! dramatic lighting.

MidJourney

Результаты Midjourney всегда отличались особой красотой. Я попробовал использовать оригинальную входную подсказку, содержащую только тему. Результаты были потрясающими.

Хотя они выглядят невероятно, они не передают суть оригинального изображения так хорошо, как это делает Stable Diffusion. Но это убедило меня попробовать сначала Midjourney для продолжения истории. У меня было большое количество изображений для создания и ограниченное время, чтобы получить хороший результат для каждого.

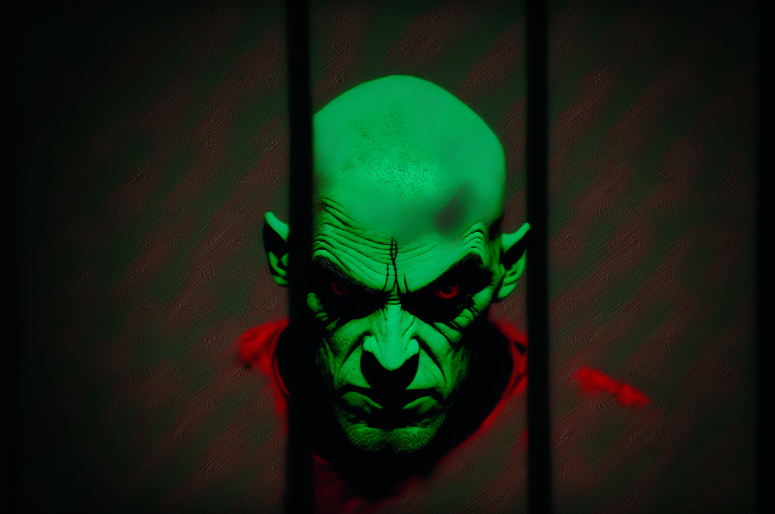

Карточка 2

Оригинал:

Мой результат

Midjourney prompt: realistic portrait of a single scary green skinned bald man with red eyes wearing a red coat with shoulder spikes, looking from behind the bars of a prison cell, black background, dramatic green lighting --ar 3:2

Midjourney prompt: realistic portrait of a single scary green skinned bald man with red eyes wearing a red coat with shoulder spikes, looking from behind the bars of a prison cell, black background, dramatic green lighting --ar 3:2

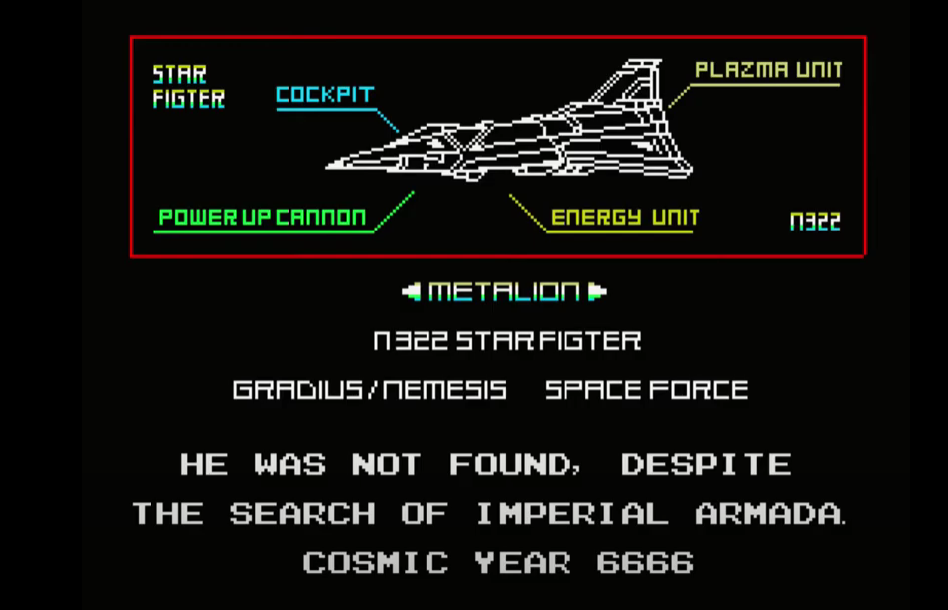

Карточка 3

Оригинал

Мой результат

Midjourney prompt: massive advanced space fighter jet schematic blueprint on a black background, different cross-sections and perspectives, blue streaks and red missles, star fighter, vic viper gradius --ar 3:2

Midjourney prompt: massive advanced space fighter jet schematic blueprint on a black background, different cross-sections and perspectives, blue streaks and red missles, star fighter, vic viper gradius --ar 3:2

Midjourney действительно передает крутость многих схем истребителей. Текст не будет иметь смысла, но это может сработать в вашу пользу, если вы хотите создать что-то инопланетное.

При такой работе будет трудно воспроизвести тот же самолет в последующих рисунках.

Карточка 4

Оригинал

Результат

Midjourney prompt: front close-up of the black eyes of a space pilot Mr. James Burton peering through the visor of a white helmet, blue lighting, the stars reflected on the glass --ar 3:2

Midjourney prompt: front close-up of the black eyes of a space pilot Mr. James Burton peering through the visor of a white helmet, blue lighting, the stars reflected on the glass --ar 3:2

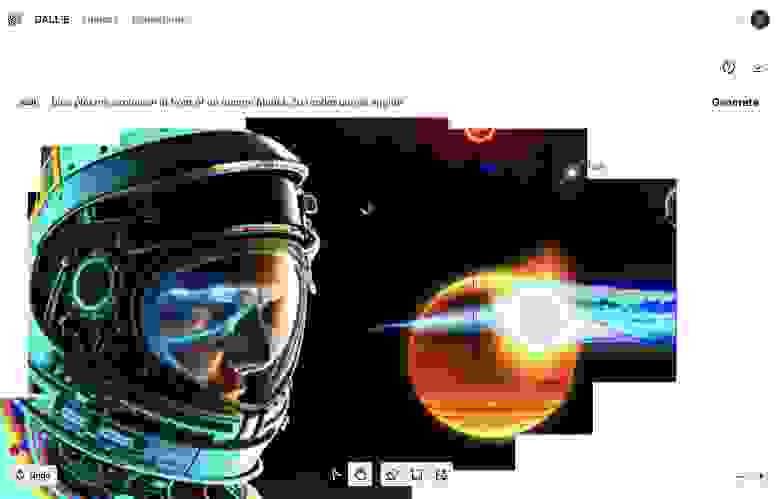

Это изображение предоставило отличную возможность опробовать инструмент DALL-E outpainting для расширения холста и заполнения окружающего пространства контентом.

Увеличиваем холст с Dalle

Допустим мы остановились на следующем изображении

Мы можем загрузить его в редактор DALL-E и расширять холст вокруг основного изображения (принимая во внимание часть изображения, чтобы сохранить некоторую преемственность).

Процесс outpainting отличается от text2image тем, что подсказка должна быть изменена для описания описываемой части в каждой части изображения.

Мои впечатления от текущих моделей генерации изображений

Прошло несколько месяцев с тех пор, как подавляющее большинство людей получили широкий доступ к инструментам генерации изображений с помощью ИИ. Основной вехой здесь является выпуск Stable Diffusion с открытым исходным кодом (хотя некоторые люди имели доступ к DALL-E и раньше, а такие модели, как OpenAI GLIDE, были общедоступными, но более медленными и менее способными). За это время я успел воспользоваться тремя из этих сервисов генерации изображений.

Dream Studio

Stable Diffusion v2.1 prompt: Two astronauts exploring the dark, cavernous interior of a huge derelict spacecraft, digital art, neon blue glow, yellow crystal artifacts

Stable Diffusion v2.1 prompt: Two astronauts exploring the dark, cavernous interior of a huge derelict spacecraft, digital art, neon blue glow, yellow crystal artifacts

Это то, что я использовала больше всего за последние несколько месяцев.

Плюсы

Есть API, поэтому легко получить доступ к моделям. Ключевой момент для расширения возможностей и создания более продвинутых систем, использующих компонент генерации изображений.

Тот факт, что Stable Diffusion имеет открытый исходный код, является еще одним весомым аргументом. Оригинальная модель может быть использована в качестве прототипа, но при этом вы знаете, что если ваши изображения требуют тонкой настройки вашей собственной модели, вы можете вернуться к версиям с открытым исходным кодом.

На данный момент лучший пользовательский интерфейс с наибольшим количеством опций

Минусы

Dream Studio по-прежнему не хранит историю всех изображений, созданных пользователем.

Старые версии Stable Diffusion (например, 1.4 и 1.5) по-прежнему дабт лучшие результаты (в этом помогают галереи вроде Lexica). Более новые модели, похоже, все еще осваиваются сообществом.

MidJourney

Midjourney v4 prompt: Two astronauts exploring the dark, cavernous interior of a huge derelict spacecraft, digital art, neon blue glow, yellow crystal artifacts --ar 3:2

Midjourney v4 prompt: Two astronauts exploring the dark, cavernous interior of a huge derelict spacecraft, digital art, neon blue glow, yellow crystal artifacts --ar 3:2

Плюсы

Безусловно, лучшее качество генерации при наименьшем количестве настроек

Сохраняется история всех генераций

Есть витрина генераций всего сообщества

Минусы

DALL-E

One generation plus two outpainting generations to expand the sides. DALL-E prompt: Two astronauts exploring the dark, cavernous interior of a huge derelict spacecraft, digital art, neon blue glow, yellow crystal artifacts

One generation plus two outpainting generations to expand the sides. DALL-E prompt: Two astronauts exploring the dark, cavernous interior of a huge derelict spacecraft, digital art, neon blue glow, yellow crystal artifacts

Плюсы

DALL-E первый алгоритм который показал миру возможности генеративного ИИ

Поддержка inpainting и outpainting технологий

Сохраняется история генерации изображений

Есть API

Минусы

Медленнее, чем Stable Diffusion

Поскольку он отстает от Midjourney по качеству изображений, и от Stable Diffusion по принятию сообществом и инструментарию (по моему мнению), я не нашел причин тратить много времени на изучение DALL-E

Нет API

Тем не менее, не стоит сбрасывать со счетов DALL-E. OpenAI — настоящие пионеры, и я ожидаю, что следующие версии модели значительно улучшат качество генерации.

Еще больше примеров использования ML в современных сервисах можно посмотреть в моем телеграм канале. Я пишу про ML, стартапы и релокацию в UK для IT специалистов.