Продвижение сайта в Google.com

У вас есть бизнес и вы захотели расширить свою аудиторию трафиком из com-версии Google. И это логично, аудитория у Google.com огромна: если посмотреть на статистику Stat Counter, по всему миру Google на первом месте, доля рынка — 92,86%. На втором — Bing с 2,41%, следом — Yahoo (1,82%), четвертое место занимает Baidu (привет из Китая), на пятом — наш родной Яндекс. У Duckduckgo примерно такая же доля, как и у Яндекса, разница в нескольких сотых.

И это очень интересные цифры. Вроде бы, вот он трафик, только руку протяни, но не все так просто, как кажется на первый взгляд.

В Рунете балом правит Яндекс (опять же по данным Stat Counter), и по многим сайтам проводят поисковую оптимизацию только по его требованиям. Наполняют сайт огромными тоннами текстов (привет фб.ру), начинают крутить контекст в Яндексе (а как иначе поведенческих нагнать, не обращаясь к черным методам оптимизации?), наращивают ссылочную массу с помощью крауда и подключают ещё множество различных манипуляций, которые действительно могут повысить позиции сайта в Яндексе.

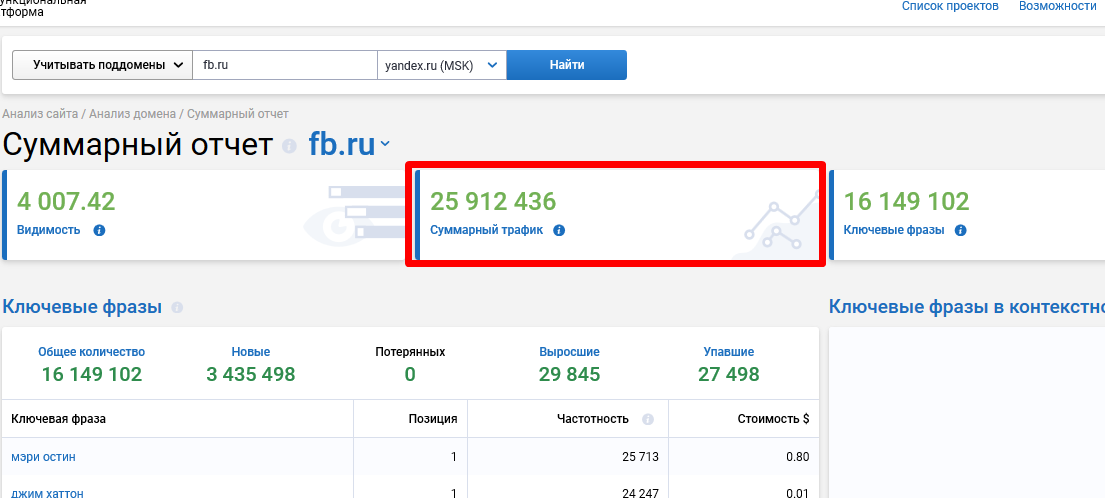

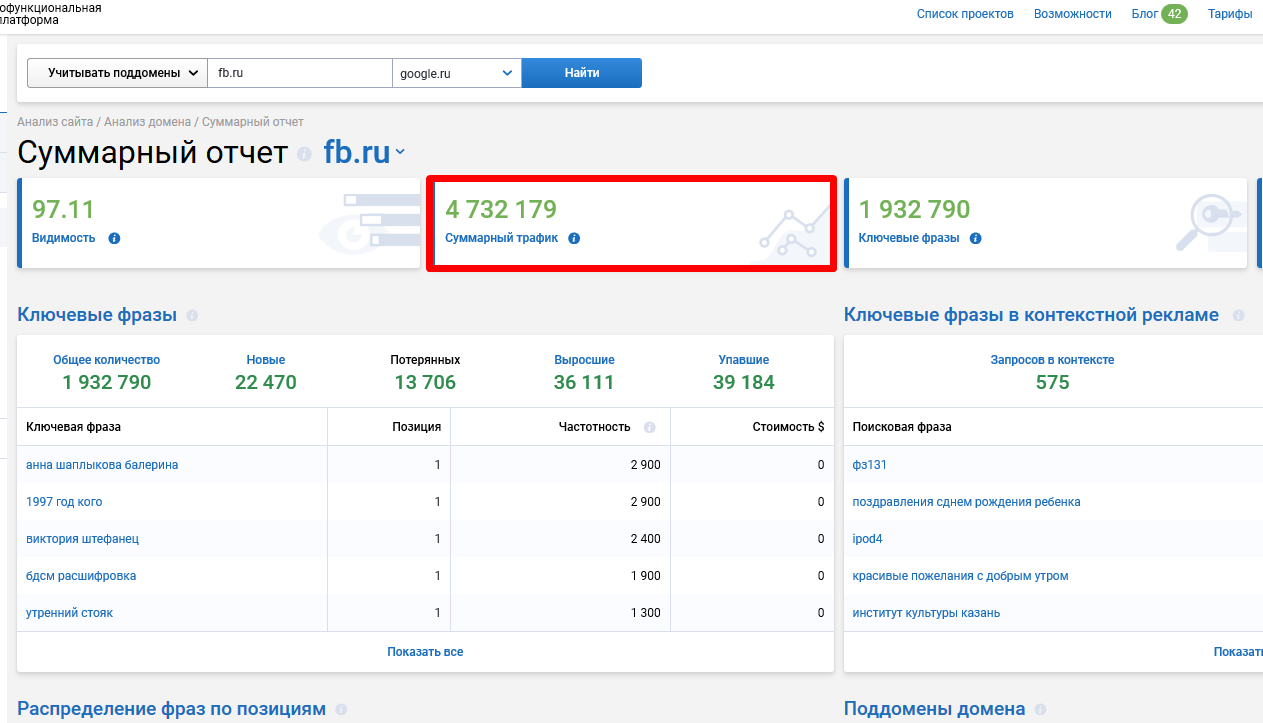

Только вот Google плевать хотел на большинство этих стараний. И это я говорю сейчас только о ru-версии. В подтверждение — суммарный трафик того же фб.ру из Яндекса и Google.ru:

Суммарный трафик сайта фб.ру из Яндекса

Суммарный трафик сайта фб.ру из Google.ru

Разница — почти в 5,5 раз. Из Яндекса трафика на сайт больше на 81%!

Значит, Google ранжирует сайты определенно иначе.

Google и Яндекс: чем разница?

Напомню о самых очевидных факторах, которые влияют на ранжирование сайта в поисковых системах.

Разница в подходах к ранжированию сайтов

Точнее, сами подходы практически одни и те же, только приоритеты разные.

Например, в Яндексе не составляет большого труда вывести в топ сайт по целевым запросам, используя внутренние ресурсы сайта, а в Google фокус смещён на внешние факторы.

Также на своем опыте я не раз сталкивался с ситуациями, когда в Яндексе страница понижалась из-за переоптимизации, а в Google — наоборот: либо держалась в топ-10, либо шла в рост.

У Google и у Яндекса есть свои собственные факторы ранжирования. Об одних говорится открыто, а другие подтверждаются экспериментальным путём.

Несомненно, качество контента — это один из важнейших факторов ранжирования. Однако нельзя просто так взять и одними текстами заставить Google полюбить ваш сайт.

Google любит качественные сайты с историей, поэтому, получив ссылку с такого ресурса, можно увеличить вероятность вывести сайт в топ поисковика. Особенно, если эти ссылки — с ресурсов в доменных зонах .gov, .edu и .mil. Но и тут не без условий: это должен быть незаспамленный сайт. Раньше такие ресурсы пользовались бо? льшим авторитетом у Google, но сейчас они могут быть менее эффективными. Джон Мюллер в своём Twitter-аккаунте говорит, что такие обратные ссылки не учитываются, однако практика показывает: если ссылка не «очевидно спамная», а органично встроена в контент сайта, то вес от такой ссылки будет больше, чем с аналогичной ссылки с обычного сайта.

Для Google важна «свежесть» контента. Необязательно быстро реагировать на тренды и новинки на своём сайте: в некоторых случаях достаточно написать большую экспертную статью, в заголовке которой будет упоминаться актуальный год. Если это прогноз на несколько лет вперед — совсем прекрасно. Также Google следит за датой обновления контента на странице, поэтому позаботьтесь о том, чтобы эта информация также отображалась на страницах вашего сайта (конечно, саму информацию нужно обновлять по мере необходимости, а не просто так).

Разница фильтров поисковых систем

Несмотря на то, что Яндекс старается отслеживать манипулирование выдачей, его мощности всё-таки не сопоставимы с Google.

На западе боятся продавать ссылки, так как это выдаёт сайт перед Google, ну, а затем следует закономерный бан «Пингвином».

«Пингвин» — фильтр Google, запущенный в 2012 году как средство для борьбы с сайтами, которые злоупотребляют закупкой ссылок. Из-за большого количество банов и сложности работы с этим фильтром, к 2017 году вымерли практически все ссылочные биржи.

Скорее всего, если сейчас вы сможете найти такую биржу, то либо она не будет функционировать, либо это будут мошенники. Ситуацию усугубляет второй фильтр Google — «Панда», который был разработан для того, чтобы бороться с сайтами-сателлитами (аналог АГС).

У Яндекса есть похожий фильтр — «Минусинск», он также наказывает сайты за использование серых методов получения ссылок, однако в Рунете всё-таки получить ссылку с другого ресурса за адекватные деньги намного легче.

Разница в геолокации и динамике

Что мы видим в Яндексе: под каждый город есть отдельная выдача со своими любимчиками и лидерами. В любой момент пользователь может изменить свой город и посмотреть, как выглядит выдача в другом регионе (примерно, естественно). Привязать свой сайт к какому-либо региону или отвязать его можно с помощью панели вебмастеров Яндекса.

А в Google? Там нет возможности изменять регион, запрос пользователя привязывается по IP из той точки, где находится устройство, с которого осуществляется поиск. Несмотря на это, пользователи Google, которые находятся в разных точках одной и той же страны, будут получать примерно одинаковую выдачу. Да, она может изменяться из-за персонализации, но в общем и целом выдачи будут похожи. Чтобы посмотреть выдачу Google глазами другого региона или города, нужно прибегать к отдельным неофициальным сервисам.

Получается, что выдача в Яндексе из-за геолокации более динамична от региона к региону одной и той же страны, чем в Google.

И это далеко не все различия между Google и Яндекс, как не сложно догадаться. Из этих различий и складывается определённый подход к самому продвижению. Где-то он может быть сложнее, где-то легче, но в целом далеко не всё, что работает в Яндексе будет работать и на Google.com.

Что нужно делать, чтобы попасть в топ Google.com

Я не планирую открывать Америку, а лишь рассказываю о тех подходах, которые реально работают в 2019 году в англоязычном SEO.

Что делать с семантикой?

Собирать, но не загонять себя в жесткие рамки определенного количества запросов: старайтесь раскрыть тему своего сайта максимально полно. Продвижение по запросам имеет смысл тогда, когда семантика сайта ограничена — это относится к нишевым сайтам и непопулярным тематикам. Без проработки максимально возможной семантики выйти в топ будет проблематично. Во всех остальных случаях ориентируйтесь на трафик.

В любом случае нужно собирать максимально полную семантику по своему сайту, дополнять её близкими по теме ключами и сформировать маски запросов (например, для интернет-магазина многие запросы, как правило, содержат такие слова, как buy, review, online, for sale, best, near me и подобные).

Небольшой чек-лист по семантике:

-

Собирайте маски запросов в тематике. В зависимости от типа сайта маски могут быть свои.

-

Смотрите семантику конкурентов в тематике (Ahrefs, SEMRush).

-

Подбирайте LSI-фразы (LSIGraph). Они помогут охватить большее количество ключей и привлечь на сайт дополнительный трафик.

-

Используйте подсказки Google (Keyword Tool). Подсказки смотрите через VPN того региона, по которому идёт продвижение. Если продвижение по всем штатам, то выбирайте несколько приоритетных и смотрим подсказки по ним.

-

Добавляйте в семантику вопросы и запросы, содержащие такие конструкции, как «What is», «How to», «Where to» и т.д. По подобным запросам страницы крайне успешно попадают в голосовую выдачу Google. С поиском вопросов по теме может помочь сервис Answer The Public.

-

Помните, что частотность в Google отображается в диапазоне. Поэтому даже запросы с частотностью 0 по Ahrefs могут без проблем приносить трафик на сайт.

-

Расширяйте семантику постоянно и фиксируйте это. Когда создаётся новый контент, заносите новые ключи в общий документ с семантикой — так будет легче отследить, под какие ключи уже есть контент на сайте, а под какие ещё не написан.

Как анализировать?

Отслеживайте динамику роста органического трафика. Грамотно настроенный счётчик Google Analytics — это морока и своего рода искусство, однако такой инструмент в работе даст вам намного больше, чем вы можете себе представить. Также для дополнительных отчётов подключайте Яндекс.Метрику (да-да) — в таком случае будет всегда доступ к картам ссылок, кликов, скроллинга и Вебвизору.

Чек-лист по аналитике:

-

Настраивайте счётчики Google Analytics и Яндекс.Метрики. Правильно указывайте главное зеркало (http, https) и включайте фильтр ботов (он далеко не гений, но с ним лучше, чем без).

-

Настраивайте свои собственные сегменты. Стандартные сегменты в средствах аналитики грешат неполнотой данных. Вам виднее, кого лучше отслеживать, поэтому не ленитесь создавать свои собственные сегменты (органика, контекст, социальные сети и т.д.). Добавляйте в сегмент минус-слова, регион, исключайте UTM-метки и брендовый трафик. Благодаря такой настройке информация будет более релевантной и объективной.

-

Смотрите отчёты еженедельно, а не ежемесячно, а ещё лучше ежедневно. Банально, но многие не задумываются над тем, что отслеживание статистики на постоянной основе может предупредить различные проседания в ПС. Смотрим и делаем выводы по общим объёмам трафика, по органическому трафику, по запросам, по конверсиям и по поведенческим (время, количество страниц, показатель отказов).

-

Смотрите во внешние сервисы тоже. Такие комплексные сервисы, как SEMRush или Ahrefs выдают полезную информацию о сайте — пусть с небольшой задержкой, однако по их качественным характеристикам можно отследить динамику роста сайта.

-

Грамотно настраивайте цели. Без целей будет сложно определить, на каком этапе пользователь покидает сайт, поэтому настраивайте составные цели. Если же все формы завязаны на Java-скрипте, то каждому этапу в форме приписывайте свой уникальный идентификатор.

-

Четко определите, какая сезонность у сайта, и отслеживайте её.

Что делать с внутренней оптимизацией сайта?

Внутренняя оптимизация сайта — это то, что Google и Яндекс оценивают примерно одинаково. Сайт без ошибок с технической стороны, как правило, будет лучше ранжироваться в Google, однако есть действительно ключевые моменты, которые будут качественно отличать ваш сайт от сайта конкурента. Обойдёмся без прописных истин типа «уникальные метатеги», «адаптивность», «скорость загрузки» и «HTTPS» — про это писалось тысячу раз, и если вы читаете эту статью, то уже наверняка и видели это тысячу раз. Копнём поглубже.

Чек-лист по внутренней оптимизации сайта под Google.com:

-

Микроразметка JSON-LD. Несмотря на то, что schema.org более универсальная и «съедается» практически всеми поисковиками, Google в своей справке рекомендует использовать именно JSON-LD при разметке контента на сайте. И, если честно, с данным видом микроразметки банально удобнее работать.

-

Наличие на страницах подзаголовков H2 и H3. До сих пор ко мне в работу приходят сайты, на которых есть только заголовки H1. Это приводит к тому, что такие сайты могут хуже ранжироваться своих конкурентов — да, банально из-за отсутствия подзаголовков нижних уровней. В некоторых случаях Google формирует выдачу на основе контента из этих подзаголовков, также он может использовать контент в этих блоках для определения релевантности документа. Поэтому добавление ключей в H2 и H3 может улучшить релевантность страницы по ключевым запросам, а, следовательно, улучшить позиции сайта.

-

Оптимизация Java-script контента. Google сканирует Java-script. Не заносит в кэш инфу в этих блоках, но отлично распознаёт контент в них и переходит по ссылкам. Поэтому приведите в порядок информацию в этих блоках и оптимизируйте их так же, как и все остальные участки своей страницы.

-

Плотность ключей и их количество может быть больше, чем в Яндексе. По моим наблюдениям, те страницы, которые могут быть под фильтром переспама в Яндексе, для Google могут отлично ранжироваться и держаться в топе.

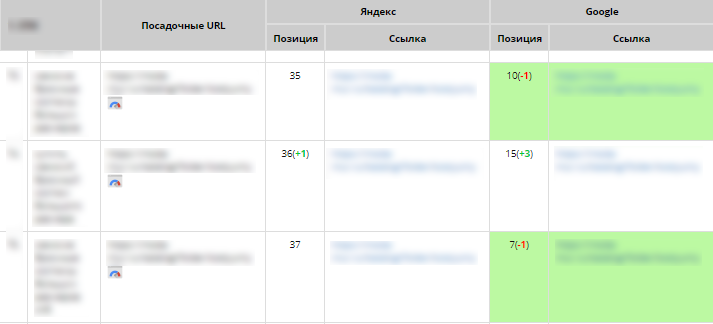

За переспам в Яндексе на сайт прилетел «Баден-Баден», а в Google сайт спокойно сидит по этим же запросам в топ-10 и топ-20

-

Внутренний PR страниц важен. Если на вашем сайте есть две страницы и на одну внутри сайта стоит 1 ссылка, а на другую 100, то для Google это будет сигналом, что вторая страница более важна, чем первая. Поэтому старайтесь грамотно настраивать перелинковку между контентом на своём сайте и смещать фокус на те страницы, на которые вы хотите, чтобы пользователь перешёл из поисковой выдачи.

-

Корректная генерация файла sitemap.xml. XML-карта сайта позволяет Google эффективно индексировать ваш сайт, не растрачивая краулинговый бюджет. Позаботьтесь о том, чтобы он корректно работал и не отсылал в Google ошибки и отличные от 200 коды ответа сервера (404, 503 и т.д.). Также использование XML-карты может помочь в переобходе страниц. Для этого создаётся отдельный документ со старыми адресами и добавляется в корневую папку сайта. У страниц в документе должен быть настроен 301 редирект. Затем всё это «скармливается» Google через панель вебмастеров. После того, как робот обойдёт все страницы и склеит старые URL-адреса с новыми, документ можно удалять с сайта.

-

Сделать всё для того, чтобы сайт соответствовал регламенту GDPR. В 2018 году ужесточились законы обработки персональных данных в Европейском союзе. Для Google наличие политики конфиденциальности веб-сайта и информация об использовании персональных данных может быть сигналом для повышения траста.

-

Создание отдельных страниц с конкретным городом или штатом, если сайт оказывает услуги по всей стране. Это лучше реализовать в виде подпапок, так как если сделать поддомены, то Google может признать их аффилиатами и вообще не включать в ранжирование.

А что с внешней оптимизацией?

Здесь всё намного интереснее. Google очень жестко карает сайты, которые манипулируют поисковой выдачей с помощью накруток внешних ссылок. Поэтому со временем выработалось несколько ссылочных стратегий, которых обычно придерживаются все веб-мастера, которые хотят повысить свой сайт в поисковой выдаче Google.com.

Какие есть ссылочные стратегии в Google.com:

-

PBN (Private Blog Network). Самый трудоёмкий, дорогой и один из самых эффективных способов прокачать свой ссылочный профиль.

-

Ссылки из профилей. Такие ссылки, как правило, проставляются в открытых профилях на различных сайтах, например, vimeo.com.

-

Ссылки WEB 2.0. Такие ссылки выглядят как полноценная статья с органично встроенной ссылкой в теле на сайт-акцептор.

-

Спам на сайтах с движками WordPress с Dofollow комментариями. Такие ссылки относятся к чёрному SEO и проставляются, как правило, с помощью инструмента Scrapebox и подобных аналогов.

-

Продвижение с помощью дропов. Отбор и выкуп доменных имён с уже имеющимся ссылочным профилем, с последующей настройкой 301 редиректа на сайт акцептор.

-

Гостевые посты. Такие ссылки добываются посредством личного общения вебмастеров сайтов (читай аутрич). Это может быть как платное размещение, так и бесплатное, но с условием обмена ссылками в статьях. При таком подходе с нуля создаётся уникальный и экспертный контент с последующей простановкой ссылки на сайт-акцептор.

-

Крауд на форумах и в социальных сетях. Отбираются форумы, соцсети и площадки, где можно завести обсуждение с последующим встраиванием ссылки в сообщениях. Главный критерий — органичность.

-

Local SEO-ссылки. Это ссылки со справочников, карт и каталогов, где есть название, адрес, телефон (NAP — Name Address Phone).

Из всех этих подходов самым оптимальным по трудозатратам, стоимости и результату я считаю гостевые посты. Такие ссылки вкупе с качественным контентом не только улучшают позиции сайта, но и формируют положительный имидж организации. Стоимость одной такой ссылки может составлять от 20$ до 300$ в зависимости от сайта донора и объёма статьи. Основной минус — создавать контент для такого рода ссылок долго.

По эффективности лидируют PBN и дропы. Однако создание своей качественной сетки стоит дорого (10 сайтов от 500$), к тому же нужно поддерживать и наполнять все эти сателлиты. Выкуп освободившихся доменов (дропы) выглядит более привлекательным, на мой взгляд (купить приличный домен можно от 10$), а если приобрести дроп с хорошей историей и бэклинками, то эффект будет примерно таким же, как от сетки сайтов. А возможно, даже лучше и быстрее.

Для онлайн-коммерции и организаций Local SEO-ссылки жизненно необходимо, так как по многим запросам в Google, Bing и Yahoo формируется выдача с картами. Такие ссылки, как правило, бесплатные, однако есть специальные сервисы, в которых можно пакетно занести информацию о своём бизнесе сразу в десятки каталогов. Стоимость таких сервисов — от 200$.

Ссылки из профилей, Web 2.0 и крауд — это бесплатные способы получения внешних ссылок на свой сайт. Такие ссылки имеют не такой большой вес, как те, о которых я писал выше, однако на некоторых ресурсах такие ссылки dofollow. Также такие ссылки — это отличная возможность разбавить ссылочный профиль сайта.

Спам через комментарии для блогов WordPress я не поддерживаю и не рекомендую вообще никому, разве что для прокачки сайтов-сателлитов или ссылок Web 2.0, но в адекватных количествах, так как чревато баном от Google.

Чек-лист по внешней оптимизации сайта:

-

Выбрать оптимальную для своего сайта стратегию наращивания ссылочной массы.

-

Выделить отдельную статью расходов на ссылки, так как тратиться придётся и немало.

-

Разбавлять ссылочную массу разными ссылками (крауд, Web 2.0, профили).

-

Следить за репутацией своей компании на площадках где можно оставлять отзывы (Yelp, Google Map и т.д.)

-

Стараться получать ссылки с доменов .gov, .edu и .mil, но следить за тем, чтобы эти сайты были не заспамлены.

-

Прокачивать ссылками не только продвигаемый сайт, но и посты web 2.0, в которых он упоминается.

-

Ориентироваться на показатели Ahrefs или SEMRush по ссылкам.

-

Автоматизировать, то, что можно автоматизировать, потому что вручную делать придётся очень многое. Это в большей части относится к созданию PBN, аутрич и дропам.

Как поступить с контентом?

Качественный контент — это секрет успеха в поисковике. Но сделать по-настоящему уникальный контент с каждым годом становится все трудозатратнее. Раньше при составлении ТЗ на текст указывалось количество ключей и их вид в тексте. Сейчас уже давно отошли от этого, и ТЗ для редактора больше похоже на скелет самой статьи, чем на сухое перечисление ключевых слов. «Пишите тексты для людей», — как попугаи твердят представители Google. И на самом деле это работает.

Чек-лист по созданию хорошего контента для Google.com:

-

Анализ выдачи — основа хорошего текста. Посмотрите, что пишут конкуренты и напишите лучше.

-

Экспертность. Последнее время Google стал уделять большое внимание достоверности информации, поэтому сейчас очень важно иметь в документе уникальный текст эксперта в области.

-

Пишите большие и насыщенные статьи. Чем подробнее и шире будет раскрыта тема в статье, тем лучше. Научитесь создавать качественные лонгриды.

-

Разбивайте контент на логические блоки. Многие такие куски текста Google помещает в блок быстрых ответов.

-

Разнообразие медиаконтента не повредит. Каждое изображение в статье — это дополнительный ключ, который можно вписать в ALT-атрибут, а каждое видео — это увеличение времени нахождения пользователя на странице.

-

Дата публикации контента и его обновление имеют важную роль в ранжировании документа. Поэтому важно не только создать качественную статью, но и периодически её обновлять.

-

Есть возможность комментирования и оценки. После публикации контента не забрасывайте его, старайтесь отвечать на вопросы и комментарии пользователей — это дополнительная возможность поставить ссылку на внутреннюю страницу или ключевик.

-

Учитесь понимать интент пользователя по ключу, под который вы оптимизируете страницу. Когда пользователь запрашивает locksmith prices, он вряд ли хочет увидеть водное рассуждение сомнительной ценности о том, какие цены могут быть на услуги: ему нужны конкретные цифры и услуги.

-

Имя автора в своих статьях. К ресурсу повышается доверие, если у него есть список своих авторов и от их лица публикуются тексты.

-

Ссылки на авторитетные источники, которые могут дать дополнительный вес документам в поисковой выдаче.

-

Хороших редакторов на бирже мало. Скорее всего, если вы выйдете на исполнителя, то это будет не носитель языка, а качество статей от таких авторов не самое высокое. Ищите добросовестных редакторов на textbroker.com, там есть множество фильтров, по которым можно отобрать исполнителей.

-

Найдите пруфридера, который будет перечитывать ваш материал на предмет фактических, стилистических и других ошибок. Если вы сами идеально знаете английский язык, то можете быть пруфридером текстов для своего сайта и проводить такой анализ самостоятельно.

Как работать с поведенческими факторами?

Некоторые моменты, связанные с поведенческими факторами, были перечислены в списках выше, однако эту тему нужно раскрыть так же, как и все остальные. Поведение пользователя на страницах сайта имеет серьёзное значение. Для того чтобы пользователь оставался на вашем сайте как можно дольше, нужно следовать некоторым правилам.

Чек-лист по поведенческим факторам в Google.com:

-

С ресурсом удобно взаимодействовать. Если показатель отказов на вашем сайте увеличился, возможно есть проблемы с интерфейсом, которые нужно срочно решить.

-

Формы обратной связи не перегружены. Старайтесь избегать большого количества пунктов для заполнения в формах обратной связи.

-

Добавлены полезные для пользователей сервисы. Если вы можете облегчить пользователям жизнь, то смело делайте это (например, добавьте калькулятор расчёта стоимости).

-

Вся информация доступна, понятна и наглядна. Пользователь должен сразу понять, куда он попал, независимо от того, перешёл он по сниппету из выдачи или кликнув по анкору на другом сайте.

-

Сайт вызывает доверие пользователей. Это можно сделать с помощью лидеров мнений в вашей тематике — найдите их и попросите прокомментировать ваш продукт или услугу.

-

Для коммерческих сайтов созданы УТП (уникальные торговые предложения). Предложите пользователю причину остаться на вашем сайте (скидка, бонус, купон), но не перебарщивайте с различными всплывающими виджетами и окнами.

Заключение

Я выделил 3 основных отличия продвижения под Google.com от русскоязычного продвижения: приоритеты ранжирования, фильтры и геопривязка. Из-за этого разница в некоторых моментах оптимизации колоссальна. То, что полезно для Яндекса, может стать фатальным для Google и наоборот.

Эффект от SEO в Google приходится ждать дольше, чем в Яндексе, из-за отсутствия быстрого и дешевого способа получения внешних ссылок. Google скрывает от вебмастеров много информации, и поэтому приходится обращаться к внешним ресурсам, которые выдают хоть и качественные, но опосредованные данные.

Многие перечисленные в этой статье подходы могут одинаково хорошо отразиться на позициях сайта в других поисковых системах, таких как Yahoo, Bing, DuckDuckGo и других поисковиках, которыми пользуются англоговорящие пользователи.

Полный текст статьи читайте на CMS Magazine