NetApp: Мы даем потребителям возможность пользоваться единым набором сервисов в любом облаке

Новое в СХД

31.07.2019, Ср, 13:34, Мск , Текст: Шатунова Евгения

Следуя за сменой поколений и парадигм построения ИТ-инфраструктуры, трансформируются и классические технологии хранения данных. В интервью CNews технический директор NetApp в России и странах СНГ Роман Ройфман рассказал, как NetApp помогает пользователям освоиться с жизнью в облаках, используя гибридные архитектуры.

CNews: Эффективное управление ресурсами хранения и защита данных в гибридных облаках — в фокусе внимания компании NetApp в течение ряда лет. Какие основные тенденции изменения корпоративной ИТ-среды вы можете отметить?

Роман Ройфман: Лет пять назад компания NetApp стояла на перепутье — тогда проявилось несколько внешних угроз: появились облака, набирала силу виртуализация, да и гиперконвергентные системы выглядели как потенциальная угроза — вдруг потребители полностью откажутся от on-premises систем? Было очевидно, что мир меняется, и места для традиционных систем хранения может вообще не остаться. Как на это реагировать? Были различные варианты. Например, сдаться. Или бороться, отрицая угрожающие изменения. И, наконец, третий вариант — принять происходящее и сотрудничать с ним. Нам показалось, что попытаться самим поменяться и найти собственное место среди тех вызовов, которые на тот момент казались угрозами, — это интересная возможность.

Мы тогда приняли решение не воевать с ветряными мельницами, а стараться получать из них электричество — создали три больших направления. Первое — традиционные СХД. Второе — работа с новыми заказчиками, которые строят собственные ЦОДы нового поколения и являются, в частности, потребителями гиперконвергентных решений NetApp. Третье направление — это те заказчики, которые совсем ушли в облака и вообще не хотят иметь ничего общего с «железом», то есть намерены всю обработку данных потреблять как услугу и использовать ИТ-решения этого класса. Соответственно, сформировали три группы продуктов, ориентированных на нужды каждого типа заказчиков. Но вот что мы обнаружили недавно: выяснилось, что мир — не плоский, и эти направления, хотя мы движемся по каждому из них, все-таки имеют много точек пересечения между собой, порой неожиданных для нас.

CNews: Эти точки пересечения стали поводом для создания новых продуктов?

Роман Ройфман: Именно так. Поскольку мир поменялся, наши продукты с базовыми решениями тоже поменялись. В том числе, изменения коснулись базового понятия NetApp Data Fabric, которое характеризует возможности управления данными. Изначально речь шла о том, что мы можем передавать данные из on-premises решений в облако, фактически о репликации между традиционными All-Flash системами хранения AFF (NetApp All Flash FAS) и гиперконвергентной платформой HCI (Hyper Converged Infrastructure).

Сегодня мы размещаем на площадке on-prem часть облачной инфраструктуры, а часть ресурсов — внутри частного или публичного облака. Это означает, что владелец ИТ-инфраструктуры должен иметь в своем распоряжении сервисы мониторинга данных, как для on-prem систем, так и для систем, построенных из «кирпичиков» HCI-систем, а также для ресурсов, которые находятся в облаке. Иными словами, сегодня речь идет о возможности использовать единое управление данными, которые могут находиться в разных реализациях гибридной облачной инфраструктуры. И мы в NetApp хотим, чтобы у наших пользователей был единый пользовательский опыт, вне зависимости от того, выбрал он Google Cloud, Amazon Web Services (AWS) или построил собственное облако, чтобы возможность пользоваться сервисом была практически одинаковой.

Единый пользовательский опыт для гибридной среды

И вот что мы обнаружили: эти вопросы управления можно решать не по каждому направлению отдельно, а использовать одновременно продукты из разных «корзинок». Эти связи продуктов в структуре Data Fabric мы называем «нитями» — по сути, они описывают возможности совместного использования тех или иных решений. Так вот оказалось, что «нити» Data Fabric, связывающие различные решения между собой, стали более плотными, и в целом их стало больше. По сути, они образовали новую структуру: элементы из трех разных архитектурных направлений в той или иной степени проявляются в каждом из наших сегодняшних продуктов, обогащая их новым содержанием. Мы отчетливо видим синергический эффект от того, что мы разрабатываем разные продуктовые направления, но вместе они дают сумму, которая гораздо больше, чем простое объединение трех направлений. И вот это характеризует новый уровень наших собственных ожиданий от продуктов и ожиданий наших потребителей, которые используют эти продукты в своих ИТ.

Еще один интересный момент: когда приблизительно пару лет назад мы начали говорить о NetApp Data Fabric как некоторой концепции, охватывающей определенный набор продуктов, в этом словосочетании очень значимым было слово «NetApp». А сегодня мы пришли в такое состояние, что слово «NetApp» оказалось менее важным. Самым значимым оказалось словосочетание «Data Fabric»: мы сегодня говорим про Data Fabric заказчика, помогаем ему построить собственную Data Fabric, устраняя привязку к конкретному вендору. С моей точки зрения, происходящее напоминает эволюцию интернета: в начале 90-х это было соединение между собой считанного числа университетов. Но с ростом количества точек взаимодействия, точек обмена информацией изначальная сетевая структура трансформировалась в абсолютно новую сущность.

CNews: Известно, что отношение компаний к публичным облакам существенно различается в разных странах. Например, трудно представить, чтобы компания в США не пользовалась облачными сервисами Amazon Web Services или Microsoft Azure, а в РФ отношение к публичным облакам достаточно настороженное. Каким вы видите сегмент потенциальных потребителей таких решений в РФ?

Роман Ройфман: Опишу этот сегмент как «многообещающий». Сказать, что я ожидаю большие масштабы бизнеса в этом направлении прямо сейчас, будет лукавством с нашей стороны. Однако мы видим различные движения в сторону облаков. Конечно, отличия США, Европы и, например, рынка РФ, велики. Так, в Америке достаточно часто работает принцип Cloud first mandate, то есть обязательство в первую очередь использовать облачное решение. Особенно это касается государственных контрактов — там приходится объяснять, почему в конкретном случае ресурсы размещаются не в облаке, почему выбрано приобретение физической «железки»? Это другая реальность.

В России есть множество ограничений, которые не позволяют ожидать обширного пользования решениями глобальных облачных провайдеров, так называемых, гиперскейлеров: AWS, Google Cloud, Microsoft Azure. Конечно, мы не ожидаем в ближайшее время получить от российских крупных компаний или государственных заказчиков «облачный мандат» американского типа. Но что мы видели, например, на Западе?

Мы называем это «партизанским движением». Дело в том, что очень часто там ресурсы перемещались в облака не по указке сверху, а неким партизанским движением снизу, то есть в обход ИТ-служб. Кстати, тогда появился термин «shadow IT», описывающий феномен «теневого ИТ», когда ИТ-департамент не знает, какие информационные ресурсы уже сейчас в компании потребляются от гиперскейлеров, когда точка принятия решения о покупке ресурса находится не в руках ИТ, а в бизнес-подразделениях, потому что бизнес-пользователи зачастую сами занимаются приобретением прикладных систем. Подобное «партизанское движение» подразумевает, что работа с облачными ресурсами реализуется «внизу» и теневым маршрутом обходит требования ИТ-департамента.

Такое движение мы видим и в России. Достаточно посмотреть на любое мероприятие, посвященное облачным ресурсам Azure или AWS, — там вы встретите много людей, которые пришли туда не в первый раз и точно понимают, с какой целью они используют услуги гиперскейлера. В социальных сетях мы также видим большой интерес к этим ресурсам от весьма консервативных российских заказчиков. Но этот интерес стимулируется не мандатом сверху, а бизнес-запросом снизу. Думаю, что с течением времени «партизанский» характер этих процессов трансформируется в более открытые взаимодействия, но сейчас это так.

Европа, с этой точки зрения, находится посередине между США и Россией. Там тоже был период отрицания публичных облаков по причине того, что сами ресурсы находятся в США. Но сегодня большое количество ресурсов разных гиперскейлеров стали доступны в европейских странах. Правда, все еще первая реакция на облако — негативная. Мы с этим встречались в странах Восточной Европы — почти в каждой стране первым делом нам сообщали: «Облако — это не для нас». Однако это вовсе не означает, что проектов гибридных облаков там не появляется. Просто это зависит от желания той или иной компании что-то сделать в облачном направлении, и они начинают работать.

CNews: В описаниях решений NetApp для гибридных облаков фигурирует глобальная «Большая тройка» гиперскейлеров. Как компания относится к российским облачным компаниям?

Роман Ройфман: Да, сегодня облачные продукты NetApp ориентированы на трех основных провайдеров, которые совместно занимают не менее 90% облачных ресурсов во всем мире. Поэтому первая задача — обеспечить поддержку основных глобальных поставщиков. Все остальные сервис-провайдеры являются региональными или локальными, и с ними мы тоже работаем. Примером является сотрудничество на китайском рынке — там мы работаем совместно с Alibaba Cloud. Будем ли мы предоставлять такие сервисы в России? Отвечу так: нам хотелось бы получить продукт с поддержкой российских сервис-провайдеров, доступных из их облаков, но в настоящий момент таких продуктов в наших руках нет. Это ведь дорога с двусторонним движением, здесь необходимо стремление навстречу друг другу.

CNews: Поговорим детальнее о том, что дает заказчикам реализация гибридной архитектуры хранения данных. Например, насколько, на ваш взгляд, важна для заказчика легкость миграции данных между различными частями гибридной инфраструктуры?

Роман Ройфман: Когда мы заговорили о Data Fabric, эта тема, действительно, касалась возможности взаимодействия между разными облаками с целью переноса данных, и фактически сводилась к реализации репликации. Думаю, что это сугубо технический вопрос, который может решаться тем или иным способом. Намного более интересно, что происходит с приложениями и пользователями — миграция этих субъектов коммуникаций между облаками гораздо интереснее. Сегодня мы видим во всем мире мощный тренд миграции приложений из публичных облаков на on-prem инфраструктуру.

Причин для этого несколько. Первая — это, безусловно, цена, потому что жить в публичных облаках достаточно дорого. Живя в собственной инфраструктуре, при больших объемах данных и долгосрочном использовании можно сэкономить весьма существенные деньги. Вторая — безопасность данных. Чтобы нам ни гарантировал поставщик облачных услуг, часть чувствительных данных должна храниться в корпоративном ЦОДе, и это понятное требование бизнеса.

Роман Ройфман: Сегодня мы видим во всем мире мощный тренд миграции приложений из публичных облаков на on-prem инфраструктуру

Третья причина — более интересная — миграция пользовательского опыта с публичных облаков в частные. Речь идет о том, что когда наши разработчики научились разрабатывать приложения внутри Azure или AWS, они стали переносить ту же самую методологию, тот же самый стиль производства приложений в on-prem решения. По сути, сегодня они хотят, чтобы те приложения, которые они разработали в облаках, теперь запускались на корпоративной инфраструктуре локально. И это достаточно заметный глобальный тренд.

Актуальные тренды разработки приложений ставят перед нами задачу обеспечить пользователям возможность использовать тот же пользовательский опыт, который они обрели в публичных облаках, в инфраструктуре частного облака. Поэтому все наши последние анонсы — о том, что обеспечен единый пользовательский опыт в любом облаке, публичном или частном. Поэтому мы говорим о том, что, например, сервисы развертывания кластеров Kubernetes могут быть сделаны в любом облаке или локально на on-prem инфраструктуре внутри NetApp HCI. Точно так же сервис Cloud Volumes Service (по сути, «файловый ресурс как сервис») можно развернуть на любом облаке или внутри локальной инфраструктуры.

CNews: Когда-то компания NetApp ввела в обиход новый термин — Gravity, характеризующий некие «гравитационные» свойства корпоративных данных, которые «имеют массу» и «давят» на ИТ-инфраструктуру. Как, на ваш взгляд, меняются «гравитационные» характеристики данных в корпоративных ИТ-системах в последнее время?

Роман Ройфман: Безусловно, «гравитация» данных остается важным их свойством. Как и следствие из этого положения вещей, — то, что данные должны потребляться максимально локально. Мы не можем ожидать, что данные мгновенно переместятся из одной локации в другую, это не реалистично. У нас есть физические законы, которые нас ограничивают в нашем физическом мире. И есть аналогичные законы, ограничивающие наши возможности внутри каждой инфраструктуры, что «физически» не дает возможности потребить данных больше, чем способна обеспечить конкретная инфраструктура.

Аксиома о том, что данные должны быть максимально локальны, сегодня получила развитие в новом направлении. Речь идет, скорее, не о том, чтобы обеспечить просто передачу данных — это ведь и есть, по сути, старая добрая репликация, а о том, чтобы обеспечить возможность развертывания новых сервисов максимально быстро с использованием этих же данных. Надо постараться по максимуму избежать ненужного переноса данных. Для этого нужно придумать умный подход, чтобы не копировать данные между системами. Приведу понятный пример. В облаке мы можем размещать большие файловые ресурсы, которые у нас используются для работы некоторого приложения, и для хранения этих данных. И эти же ресурсы с этими же данными мы можем использовать, например, для запуска аналитических систем или машинного обучения.

При традиционном подходе подготовка данных для таких задач подразумевала необходимость скопировать данные на еще одну специально созданную для этих целей Hadoop-систему или специальный кластер для Machine Learning. Очевидно, что это очень дорого, поскольку требуется еще одна копия больших данных. Альтернативный подход подразумевает, что вы можете создать виртуальные копии — клоны данных, которые хранятся на основной системе. Именно к этой копии, которая создается мгновенно, вы подключаете систему аналитики — она использует эти клонированные данные как исходные для работы своих моделей.

CNews: Какие еще есть возможности снизить операционную стоимость обработки больших данных в гибридных средах?

Роман Ройфман: К числу тех привычных для on-prem возможностей, которые мы переносим в облака, относятся методы, повышающие эффективность хранения данных, в первую очередь, компрессия и дедупликация. Например, если данные на on-prem сжаты, и они передаются (осуществляется репликация) в программно-определяемую систему хранения в облаке Cloud Volumes ONTAP внутри любого гиперскейлера, то данные передаются тоже в эффективном виде, без дублирования. Здесь мы также экономим и время, и затраты. Одна из наиболее ярких историй — это, пожалуй, возможность эффективного использования мгновенных снимков (snapshot) и клонирования, чего обычно нет в инфраструктуре гиперскейлеров. По сути, мы с помощью наших продуктов заполняем пустующие функциональные ниши облачных систем.

CNews: В каком направлении развиваются средства управления данными в гибридных средах?

Роман Ройфман: В части управления данными следует отметить несколько аспектов. Так, потребителю нужно иметь четкое понимание, какими ресурсами он, собственно, располагает. Проконтролировать это on-prem очень просто — достаточно физически пройтись по ЦОДу и обнаружить несколько стоек нового оборудования. А вот о том, что у вас появилось несколько дополнительных «виртуальных стоек» в облаке, зачастую вы можете узнать лишь спустя некоторое время, изучая счета, выставленные для оплаты услуг. Нередко информация о таком событии в прошлом оказывается большим «сюрпризом» для компании. Поэтому очень важно понимать, какие ресурсы находятся в разных частях гибридной инфраструктуры: on-prem, в частном облаке, инфраструктуре публичного облака. Вторая важная вещь — понимание уровня защиты данных. Наши продукты, например, Cloud Insights, обеспечивают понимание, какие есть риски в отношении определенных ресурсов, и осуществляют аналитику использования данных, предлагают рекомендации по улучшению состояния. Единая точка мониторинга и контроля за всеми ресурсами, включая публичные облака, — весьма нетривиальная вещь, в том числе, потому, что каждый гиперскейлер строит инфраструктуру своего облака по-своему. Так что вопрос мониторинга того, что происходит с данными в облаке, — это, по сути, вопрос максимально эффективного использования облачных данных для управления сервисами.

Поэтому очевидно, что если мы хотим предоставлять сервисы внутри гиперскейлера, мы каждый раз должны учиться «говорить на их языке», чтобы потребители, которые привыкли пользоваться API AWS или API Google Cloud, понимали, что сервисы NetApp — точно такие же. Иными словами, пользователь не ощущает разницы, потребляя «родные» сервисы, созданные производителем облака, или компанией NetApp, обеспечивающей единый пользовательский опыт.

CNews: Создание продукта, поддерживающего сервисы того или иного российского облачного провайдера, потребует глубокого взаимодействия с ним на техническом уровне?

Роман Ройфман: Безусловно. Это означает, что с ним нужно будет работать, прикладывая точно такие же усилия по интеграции, как это было с «Большой тройкой» гиперскейлеров. Это непростая работа, предполагающая серьезные инвестиции с обеих сторон. Поскольку речь идет об инвестициях, то движение по этой «дороге» — это всегда вопрос целесообразности, разумного выбора.

CNews: Непрерывный рост объемов обрабатываемых данных предъявляет особые требования к производительности ИТ-систем. Некоторые вендоры, например, NVidia, даже сравнивают современный ЦОД с суперкомпьютером, легко «перемалывающим» петабайты данных. За счет чего NetApp достигает высокой производительности своих систем?

Роман Ройфман: NetApp как производитель систем хранения с большим уважением относится к скоростным показателям. NVidia — отличный пример во многих аспектах. В первую очередь, в части скорости обработки данных. У нас есть отличная референсная архитектура, разработанная вместе с NVidia, которая позволяет получить выдающиеся параметры производительности на вычислительных системах NVidia DGX и системах хранения NetApp All-Flash.

Главным достижением наших систем All-Flash являются уникальные скоростные характеристики: мы можем «напитывать» данными системы «суперкомпьютерного ЦОДа» DGX так, чтобы они были максимально утилизированы, то есть простаивали минимальное количество времени в ожидании данных, чтобы они постоянно работали. Это наша ключевая заслуга и, похоже, у нас сегодня наилучшие показатели в отрасли по этому параметру. При этом важно, что это не какое-то изолированное решение, решающее одну задачу — на максимальном уровне «кормить» одну «железку» с данными локально на площадке заказчика. Это полное end-to-end решение начинается со сбора данных на границе сети (Edge), где работает программно-определяемая СХД ONTAP Select, оптимизированная для управления данными на недорогих серверах. Затем данные передаются в корпоративный ЦОД, где интегрированные решения NVidia и NetApp позволяют их обработать с максимальной скоростью и эффективностью, используя все те преимущества, которые дают технологии NetApp. Дальнейшая обработка может быть передана в облако, где можно использовать подключение внешних ресурсов, как от NVidia, так и облачных сервисов хранения NetApp (ONTAP Cloud, Cloud Volume ONTAP, Cloud Volumes Service), которые могут работать совместно с решениями NVidia. Ну, и в качестве «вишенки на торте» — NVidia является партнером NetApp в работе с Kubernetes и использует сервисы NetApp для поддержки собственных аналитических решений уровня Machine Learning в облаке. Как мы видим, скорость обработки данных является очень важной частью сотрудничества NetApp c NVidia на разных участках инфраструктурных решений.

Еще один интересный пример — возможность обеспечить такие скоростные показатели в облачной гиперскейл–инфраструктуре, которые превышают характеристики «родных» сервисов от поставщиков облачных сервисов зачастую на порядок. У нас есть примеры, когда использование NetApp Cloud Volumes Service позволяет получить показатели производительности в 10 раз большие, чем производительность «родных» облачных файловых сервисов Amzon или Azure. За счет чего это достигается? Используется, во–первых, максимально быстрое «железо» с All-Flash массивами хранения, как и в on-prem архитектурах. Во-вторых, используются выделяемые уровни обслуживания (SLA), что в сумме позволяет получить существенный прирост производительности, по сравнению с инфраструктурой гиперскейлера.

CNews: Для стимулирования интереса корпоративных клиентов к облакам важны три ключевых характеристики: безопасность данных, легкость интеграции с прикладными ИТ-решениями и экономическая выгода. Компания NetApp утверждает, что умеет решать все три указанных задачи одновременно. Это правда?

Роман Ройфман: Похоже на шутку насчет того, что каждому человеку хочется быть одновременно умным, здоровым, красивым и счастливым, но такого в жизни не бывает? Однако шутки в сторону — NetApp, действительно, работает по всем трем направлениям и достигает успехов. Так, безопасность данных — это один из основополагающих факторов, вопрос безопасности данных в своих продуктах мы никогда не можем ставить под сомнение.

Экономическая выгода относится к числу тех факторов, которые мы также не можем игнорировать. Потому что никто из клиентов не скажет, что готов приобрести нужное решение за любые деньги. Об этом мы постоянно думаем, и в числе последних июньских анонсов была, например, объявлена доступность freemium-модели расчетов за услуги, предполагающая возможность бесплатного знакомства с сервисами NetApp.

Интеграция в облачную инфраструктуру гиперскейлеров — это тоже, безусловно, необходимая вещь, без нее в современных реалиях существовать просто невозможно. Если вы решите предложить решение для гиперскейлеров в виде отдельно стоящей коробочки, с отдельными методами управления, которые ориентированы на профессиональных storage-администраторов, то целевая аудитория потребителей –, а они являются cloud-native, которые вообще не представляют, зачем им может понадобиться физическая «железка», — вас просто не поймет. Сколько ей ни объясняй, что эта коробочка на 100% безопасна и предельно экономична, она все равно будет находиться вне зоны их интересов. С людьми нового поколения cloud-native нужно разговаривать на их языке, нужно интегрироваться с их «образом жизни», а значит, самим меняться.

CNews: Как эти специалисты называются в современном штатном расписании?

Роман Ройфман: Проще всего с персоналом on-prem ЦОД — это администраторы систем хранения, системные архитекторы и т.д., которые понимают, что такое серверное оборудование, система хранения данных и зачем нужны системы резервного копирования.

Cloud native миллениалы, которые ушли в облака, не думают в терминах систем хранения. Зачастую они даже не подозревают, что у них должен быть бэкап. Мысль об этом приходит им в голову подчас через несколько лет эксплуатации их сервисов. Это люди с новыми специальностями — cloud-архитекторы или инженеры по надежности систем, то есть специалисты по инженерному направлению Site Reliability Engineering (SRE), возникшему не так давно с легкой руки Google.

А между этими двумя мирами есть прослойка — специалисты, которые строят инфраструктуру частного облака. Они с интересом смотрят на конвергентные и гиперконвергентные решения для построения своих ИТ-инфраструктур, и им будут интересны наши решения HCI. Таких сотрудников сегодня частенько называют ИТ-дженералистами, потому что они обладают широким системным взглядом на вопросы построения ИТ-инфраструктуры, а для конкретных работ привлекают узких специалистов. Так же среди них администраторы виртуальных систем, администраторы технологий open stack. Их язык несколько отличается от того, на котором говорят классические on-prem администраторы.

CNews: В такой «лингвистической» ситуации остро встает вопрос принципиальной возможности создания единого управляемого пространства данных в гибридном облаке.

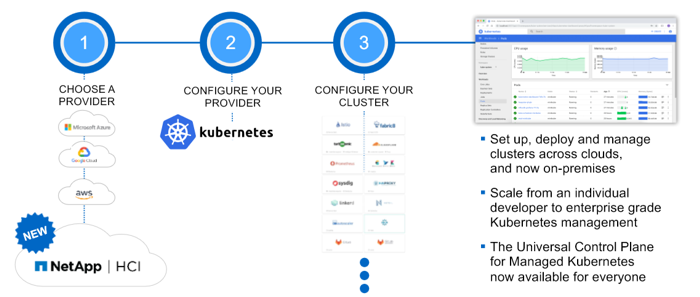

Роман Ройфман: Конечно, достичь этого очень непросто, но мы прилагаем максимум усилий, чтобы сделать это реальностью. И в некоторых случаях, надо сказать, существенно приблизились к этой цели. В качестве примера можно привести несколько новых сервисов, анонсированных в июне. В частности, сервис NetApp Kubernetes Service, который может разворачиваться через наш портал на любом из трех больших гиперскейлеров либо on-prem на оборудовании NetApp HCI. То есть для потребителя процесс развертывания сервисов Kubernetes протекает абсолютно одинаково, хоть в публичном облаке, хоть на корпоративной инфраструктуре on-prem.

Такая же ситуация — с возможностью развертывания NetApp Cloud Volumes Service, когда у нас появляется возможность получить Cloud Volumes Service on-prem, но в режиме потребляемой услуги с помесячной оплатой — точно так же, как в случае гиперскейлера. Точно так же заказчик платит за потребляемый сервис, а не за физическую «железку». И они точно так же управляются те ми же самыми специалистами, которые управляют системами хранения и сервисами для Azure, AWS или Google Cloud. Такие возможности есть, и мы движемся в этом направлении.

Развертывание кластера Kubernetes с помощью NetApp Kubernetes Service — всего три шага

CNews: На ваш взгляд, насколько полезны технологии виртуализации и контейнеров для технологической унификации облаков и классических ЦОДов?

Роман Ройфман: Что касается виртуализации, то зачастую вы привязаны к тому, какой гипервизор используете в данный момент. С контейнерами ситуация интереснее. Потому что де-факто вы, как правило, будете иметь дело с Kubernetes, а кластеры Kubernetes могут быть развернуты, как на on-prem инфраструктуре, так и на инфраструктуре вашего частного облака либо публичного облака. И в этом случае контейнеризация предполагает, что у вас появляется больше свободы в размещении и потреблении ресурсов, и это серьезно облегчает миграцию данных и приложений: они запускаются то в частном облаке, то в публичном облаке, то легко могут возвращаться в основной ЦОД и запускаться там. В этом случае, безусловно, легче делать балансировку нагрузки, потому что гораздо меньше привязка к облачному вендору, и можно меньше думать о границах, легче переходить с системы в систему.

По сути, это некоторая новая функциональность, хотя на первый взгляд таковой не выглядит: мы обнаруживаем здесь спектр новых возможностей для гораздо более легкой переносимости приложений.

CNews: По большому счету, когда мы говорим об обработке данных в гибридных средах, мы говорим об управлении в условиях растущей сложности систем? Как взять под контроль рост этой сложности?

Роман Ройфман: Да, сложность решений постоянно растет. Лет пять назад главной историей была виртуализация, и вопрос интеграции с технологиями виртуализации сводился к особенностям конкретного используемого гипервизора (Hyper-V, KVM или ESXi) и конкретной гостевой операционной системы, где также вариантов было не очень много. При переходе к гибридно-облачному окружению в это «уравнение» с несколькими переменными добавляется несколько новых слоев. Во-первых, сами облачные среды: AWS, Azure, Google Cloud, локальные решения, возможно, Mail.ru, Яндекс-Облако и т.д. Во-вторых, системы гиперскейлеров не обязательно используют традиционные гипервизоры, в частности, Nutanix применяет свой собственный гипервизор, и другие новые гипервизоры вполне могут появиться. Иными словами, точек смены управления становится больше, это факт. Что мы можем поделать с этой тенденцией?

Во-первых, можем создать такое средство, которое позволяет управлять и собирать информацию из разных источников, как мы делаем в случае с Cloud Insights, причем, не только со своего оборудования, но и оборудования других вендоров. Он, кстати, с июня доступен в freemium-режиме с бесплатной версией Basic для систем NetApp. И, во-вторых, можем уменьшить количество точек с особенными требованиями, предъявляемыми нашим оборудованием. Например, в последних версиях операционной системы ONTAP мы активно переходим к REST API управлению. Мы отказываемся от специальных API для управления нашими «железками» и стараемся везде переходить на REST API, чтобы у заказчиков оставалось минимальное число вариантов управления оборудованием.

CNews: В этой связи насколько глубоко компания NetApp намерена углубляться в технологии контейнеризации, в частности для использования облачных системах и сервисах по модели PaaS?

Роман Ройфман: Готовы ли мы помогать Kubernetes–сервисам и PaaS–сервисам? Ответ: безусловно, да. Это может показаться удивительным, все-таки наш главный конек — это управление данными. Но мы допускаем иногда шаг в сторону, и в этом плане интересен наш опыт с NetApp Kubernetes Service — речь идет о возможности разворачивать кластеры Kubernetes на облачных инфраструктурах, гиперскейлерах, и на on-prem инфраструктуре. При этом мы не пытаемся построить свой собственный дистрибутив Kubernetes, работаем с популярным «ванильным Kubernetes», и главной задачей считаем — упростить процедуры разворачивания кластеров. То есть мы не предлагаем собственный полноценный сервис PaaS, как и не предлагаем рынку свою платформу контейнеров, но мы позволяем упростить процесс развертывания Kubernetes для тех пользователей, кто выбрал такое решение.

У нас есть OEM-партнеры, крупные вендоры, в том числе, в европейских странах, которые под своим брендом продают NetApp Kubernetes Service. Это реально очень полезная штука — она, действительно, позволяет снизить сложность, с которой сталкиваются потребители, потому что развертывание сервисов достаточно большого кластера сводится к трем достаточно простым шагам. Вначале мы определяем, где это будет развернуто: в гиперскейлере? В частном облаке? Будет зона с NetApp HCI? Затем определяем, что будет развернуто. И на третьем шаге выбираем сервисы, настраиваем и запускаем. Происходит это очень быстро, буквально за минуты вы можете подготовить ваш кластер Kubernetes к развертыванию.

Еще раз подчеркну: мы не хотим продвигать «самое правильное решение», «самую правильную платформу», заставлять потребителей делать «самый правильный выбор». Мы хотим дать нашим потребителям возможность пользоваться единым набором сервисов в любом облаке, которое они выберут или которое они построят сами, и использовать один и тот же пользовательский опыт.

CNews: Как выглядит эта задача на фоне конкуренции с традиционными производителями систем хранения данных?

Роман Ройфман: Что касается конкуренции на классическом рынке СХД, то мы не видим более-менее серьезной конкуренции в части облачной инфраструктуры со стороны традиционных игроков. Мы абсолютно уникальны со своими возможностями в новых сегментах рынка. Например, мы очень полезны гиперскейлерам, потому что NetApp — единственный вендор, обладающий таким большим опытом работы с системами хранения данных и управлением данных, что он способен принести в облачную инфраструктуру то, до чего еще не доросли их «родные» технологические разработки.

Пожалуй, NetApp — единственный из крупных производителей, кто не пытается подключить свою «железку» к облаку, чтобы потом продать ее подороже. Мы стараемся интегрироваться в те сервисы, которые предоставляют гиперскейлеры, вплоть до того, что зачастую передаем им возможность самим предоставлять такие интегрированные услуги, используя наше оборудование. В этом мы, действительно, уникальны и отличаемся от всех.

CNews: Такая бизнес–модель оправдывается?

Роман Ройфман: Да, вполне. Как только мы начали двигаться в этом направлении, это нашло отражение в динамике роста акций, регулярно поступают положительные оценки со стороны финансистов. Так, недавно — в конце мая — инвестиционный аналитик «Тинькофф Journal» рассказал в журнале о компании NetApp как привлекательном объекте для инвестиций: «NetApp — сильный игрок на растущем рынке облачных вычислений».

У NetApp — сильные стратегические партнеры. Это, безусловно, компания NVidia, о которой я уже упоминал, а также компании Veem, Commvault. Давнее очень тесное сотрудничество связывает NetApp с компанией Cisco: текущий уровень продаж достиг миллиардного уровня. Ключевому продукту по этому направлению партнерства — FlexPod — более пяти лет, но он по-прежнему отлично продается по всему миру. Дело в том, что технология All-Flash продолжает играть ключевую роль в переходе наших заказчиков на цифровые технологии, а FlexPod — это удачная конвергентная инфраструктура, которая дает возможность воспользоваться гарантированной производительностью, высочайшей гибкостью, способностью к масштабированию и автоматизации, а также интеграцией с Data Fabric. Поэтому многие крупнейшие предприятия по всему миру продолжают делать свой выбор в пользу FlexPod.

Существенный сегмент клиентов NetApp — локальные сервис-провайд

Полный текст статьи читайте на CNews