Память с калькулятором. Вычисления внутри DRAM становятся мейнстримом

Всеобщий переход к параллельной обработке данных и кардинальное увеличение размера нейросетей привели к тому, что некоторые типы вычислений сейчас требуют очень быстрого доступа к памяти. В то же время разрыв в скорости доступа между микросхемой CPU и оперативной памятью чрезвычайно велик. Процессоры становятся всё быстрее, а скорость доступа к DRAM практически не растёт.

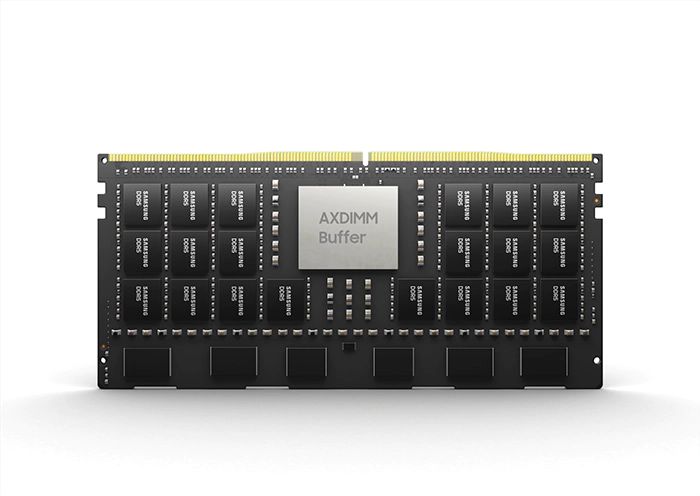

Оригинальная компьютерная архитектура фон Неймана не предусматривала разделение логики и памяти. Но прогресс не стоит на месте — и вот уже несколько производителей разработали интегрированные модули типа processing-in-memory (PIM). Это Samsung, SK hynix и израильский стартап NeuroBlade.

Благодаря переносу части логики в микросхемы памяти сокращается трафик между CPU и DRAM, то есть меньше данных перемещается между чипами. По некоторым оценкам, с точки зрения энергозатрат перемещение данных из памяти обходится примерно в 650 раз дороже, чем операция умножения в CPU.

Конечно, вычисления в памяти — это не новая идея. Но возможно, что сейчас её время наконец-то пришло, пишет IEEE Spectrum. В прошлом году такую технологию начала внедрять Samsung. В феврале 2021 года она интегрировала вычислительные ядра в память с высокой пропускной способностью Aquabolt-XL. Это высокопроизводительная память, которую устанавливают в специализированные ускорители AI.

Новая память HBM-PIM призвана заменить обычные чипы HBM.

Например, с AI-ускорителем Xilinx Alveo технология PIM обеспечивает почти 2,5-кратный прирост производительности и снижение энергопотребления на 62% в нейросети распознавания речи.

Samsung планирует разработать PIM также для следующего поколения DRAM с низким энергопотреблением в мобильных устройствах. Этот стандарт будет принят JEDEC ориентировочно в I пол. 2022 года.

Существует множество способов добавить вычислительные возможности в чипы памяти. Samsung выбрала простую и эффективную конструкцию: стопка микросхем DRAM вертикально прошита «каналами сквозь кремний» (through-silicon vias, TSV). На нижнем слое лежит логическая микросхема, которая служит интерфейсом к процессору.

Кроме Samsung, технологию PIM внедряют и другие компании. Второй по величине производитель памяти SK hynix совместно с университетом Пердью ещё в 2020 году представил архитектуру специализированного AI-ускорителя Newton с ядрами вычислителей в памяти типа HBM-PIM, но компания решила не выпускать его в продажу и вместо этого заняться разработкой PIM для стандартных модулей DRAM.

Третий по величине производитель Micron утверждает, что у него нет таких продуктов, но в 2019 году купил стартап Fwdnxt с целью разработки «инноваций, которые сближают память и вычисления».