Мир. Труд. Майпу. Или как мы тестировали китайскую СХД

Чем заменить на санкционном безрыбье системы хранения данных Dell, HPE, Huawei и других покинувших нас вендоров? Мы уже долго изучаем этот вопрос и протестировали большинство доступных альтернатив enterprise-уровня.

И что думаете? Кажется, нашли приемлемое решение — СХД китайского вендора Maipu с привычными функциями, перспективными возможностями и не только. Мы привезли его в лабораторию и первыми на российском рынке протестировали — срочно делимся впечатлениями и результатами.

Мы регулярно проводим эксперименты: тесты серверов, систем хранения данных и разнообразного инфраструктурного софта — это обычная практика. У нас накопленная база знаний и приличный опыт. Большую часть железа покупаем сами, что-то получаем от вендоров, тестируем и формируем демо-фонд, который предлагаем заказчикам.

Купили Maipu посмотреть что к чему

С этими китайцами мы уже знакомы и довольно тесно работали в 2022 году в части телекоммуникационного оборудования. Реализовали несколько проектов — вендор неплохо себя проявил, заказчикам и коллегам зашло. В результате в этом году число наших совместных проектов кратно выросло.

И вот мы решили попробовать СХД Maipu, которые в Китае используют многие госструктуры и банки, местный аналог РЖД и всякие крупные предприятия.

Особенно вдохновляло, что функциональное описание модели обещало все привычные возможности: поддержку репликации: как в режиме active-active метрокластера, так и просто синхронную/асинхронную, снепшоты, клоны, QoS и т. д. Вот она — полноценная mid-range СХД, похоже, единственная на рынке с официальной поставкой и прямой гарантией от производителя.

Гибридное хранилище MPS5520G2 Storage

Мы приобрели в лабу пару Maipu MPS5520G2 в исполнении all-flash. Они относятся к самым ходовым системам хранения, которые закрывают потребности большинства компаний. Эта модель СХД предлагает хорошую производительность и функциональность и подходит для решения распространенных бизнес-задач.

Смотрим, что представляет собой MPS5520G2 на бумаге:

Шасси высотой 4U, в которое установлены два контроллера (SPs), 2 блока питания, 2 FAN-модуля, 2 батарейных модуля, 24 слота под диски 3.5/2.5, 6 IO-модулей (по 3 на контроллер);

У каждого контроллера встроены 3 интерфейса Ethernet 1 Гбит/с и 4 интерфейса Ethernet 10 Гбит/с. Дополнительные порты добавляются IO-модулями 10/25/40/100 Gb/s Ethernet, 8/16/32gb/s FC, 10Gb/s FCoE и др.;

Вертикально расширяется дисковыми полками SAS до 3200 дисков на пару контроллеров;

Горизонтально расширяется до 32 контроллеров;

Поддерживает метрокластер (symmetric dual-active), репликацию, зеркалирование, снэпшоты;

Поддерживает кэш объемом до 1,5 ТБ, что повышает производительность хранилища;

Использует открытое программное обеспечение для управления хранением данных и открытый API-интерфейс.

Вообще у Maipu большая линейка хранилищ — гибридные/флеш модели от простого начального уровня до производительных и хорошо масштабируемых, а также отдельная линейка all-NVMe систем с окончанием «MACH» в названии моделей — полный список привели в таблицах ниже. Мы заказали не самую базовую, а более продвинутую модель, которую сочли самой универсальной, подходящей под потребности большинства клиентов и стали потирая руки ждать заказанное железо.

Модели Hybrid/Flash

Model | MPS2500G2 | MPS3000G2–24D | MPS5520G2 | MPS5580G2 | MPS7000G2 |

Product forms | dual-control, disk-control integrated | dual-control, disk-control integrated | dual-control, disk-control integrated | dual-control, disk-control separated | dual-control, disk-control separated |

Max. controllers | 16 | 24 | 32 | 32 | 48 |

Dual-control Max. cache | 128GB | 256GB | 1.5TB | 1.5TB | 3TB |

Max. disks | 1200/dual-control | 1600/dual-control | 3200/dual-control | 3200/dual-control | 3200/dual-control |

Hard disk drive | SSD, SAS, NL-SAS, SATA | NVMe, SSD, SAS, NL-SAS, SATA | |||

Dual-control IO module | 2 | 4 | 6 | 22 | 16 |

Dual-control max. host interfaces | 34 | 42 | 54 | 80 | 72 |

Front-end supporting | FC, iSCSI | FC, iSCSI, NVMe over FC, NVMe over RoCE | |||

Front-end port type | 1/10/25/40/100G Ethernet module, 8/16/32G FC module, 10G FCoE module | ||||

Expansion cabinet type | 4U24 2U25 | 4U24 2U25 2U25(NVMe) |

Модели All-NVMe

Model | MPS5500G2 -Mach | MPS7000G2 -Mach |

Product forms | dual-control, disk-control integrated | dual-control, disk-control integrated |

Max. controllers | 32 | 48 |

Dual-control Max. cache | 1.5TB | 3TB |

Max. disks | 25/dual-control (expansible) | 50/dual-control |

Hard disk drive | NVMe | |

Dual-control IO module | 4 | 4 |

Dual-control max. host interfaces | 32 | 36 |

Front-end supporting | FC, iSCSI, NVMe over FC, NVMe over RoCE | |

Front-end port type | 1/10/25/40/100G Ethernet module, 8/16/32G FC module, 10G FCoE module | |

Expansion cabinet type | 2U25(NVMe) no |

Ну как же без сюрприза

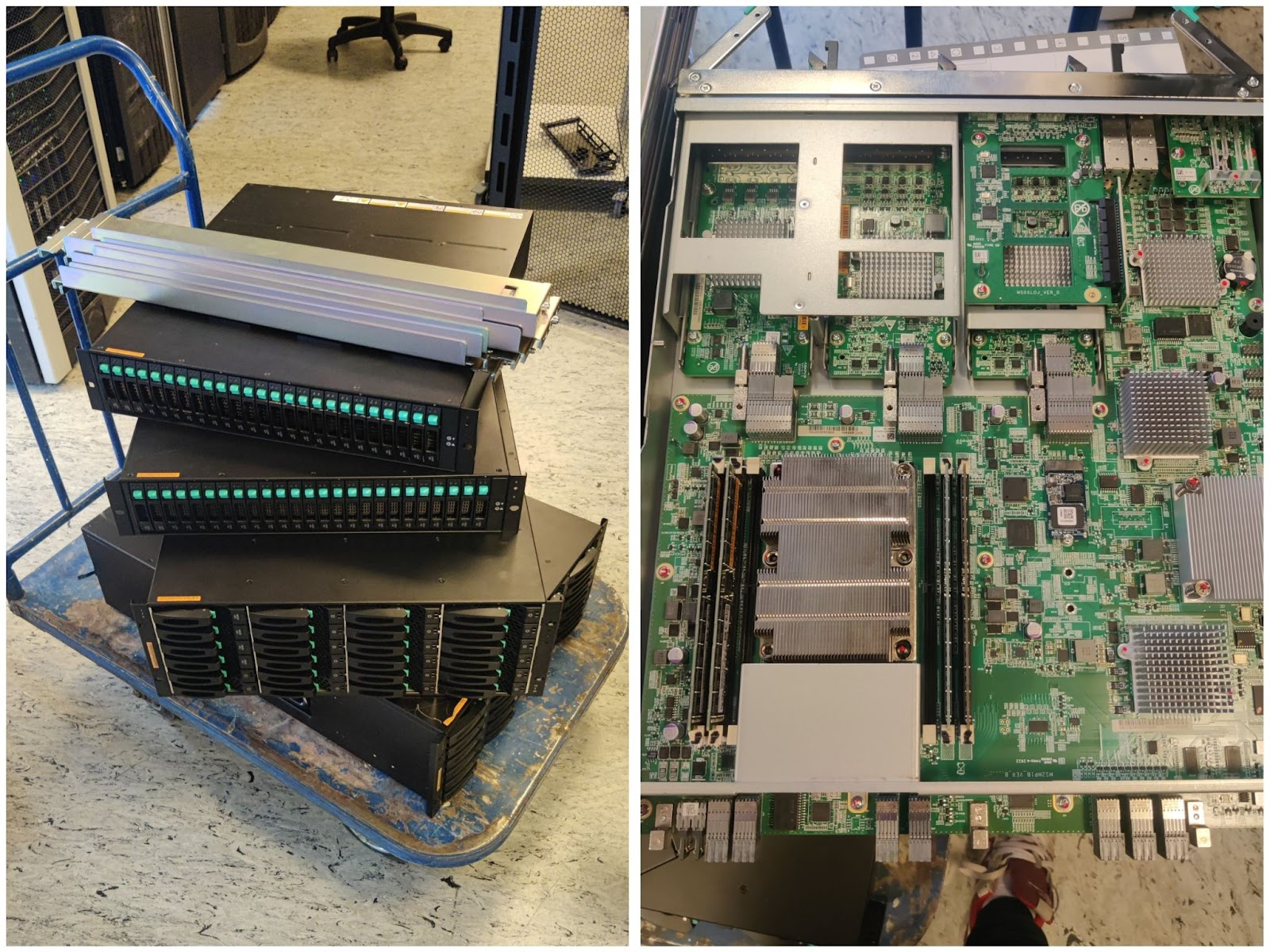

Ура, приехало! Инсталляция довольно простая, без особенностей — поставили в стойку, подключили и запустили. Опытный инженер, который видел эту СХД впервые, справился с монтажом и базовой настройкой примерно за два часа.

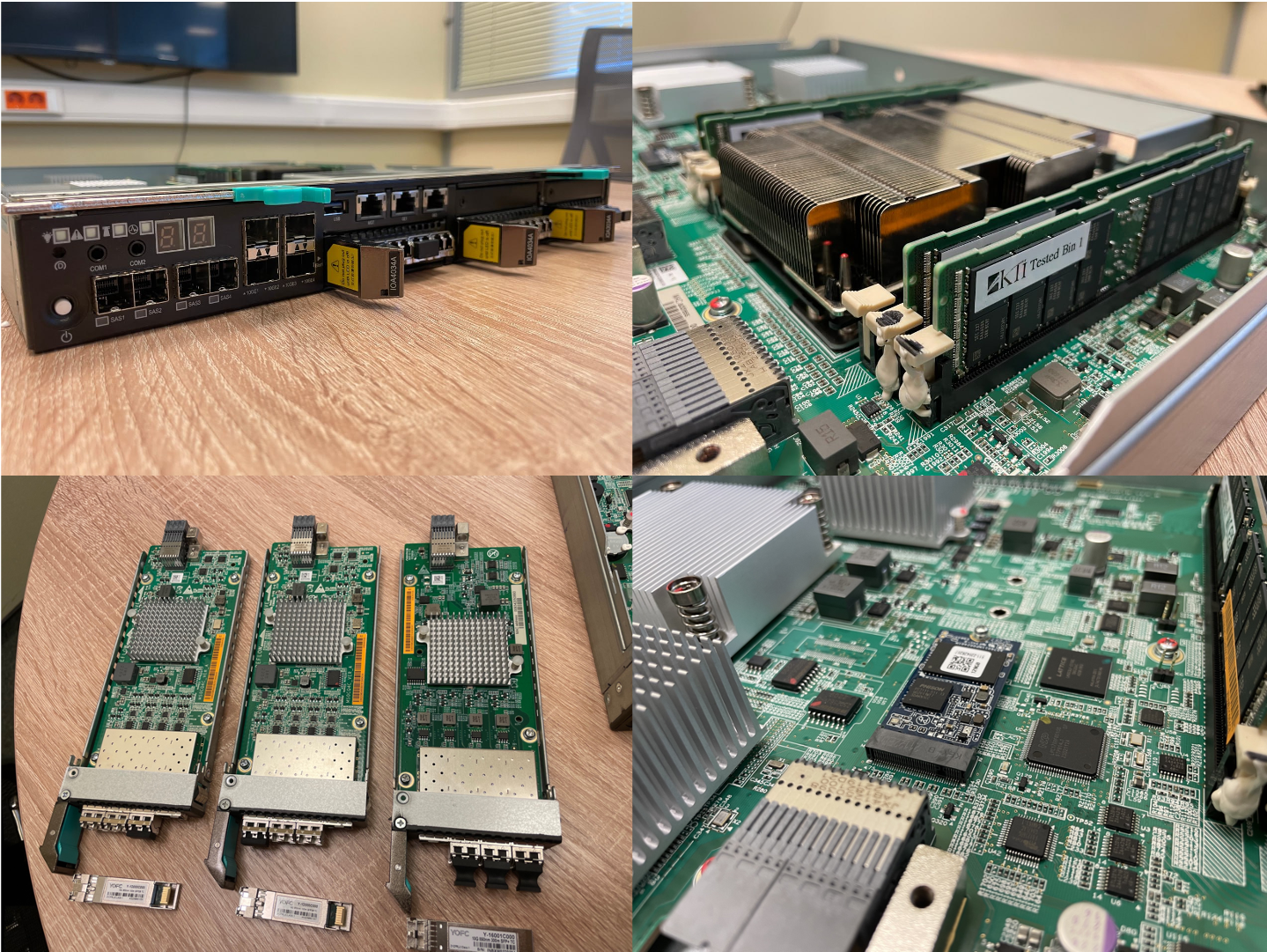

1. Контроллер. 2. Планки кэш-памяти контроллеров с радиатором процессора. 3. IO-модули 10 и 16 Гбит. 4. М.2 модуль для загрузки системы.

Выглядит вполне себе как enterprise-решение снаружи и внутри. Первое впечатление подпортила лишь нерабочая батарея — непонятно, то ли заводской брак, то ли пострадала при транспортировке, но осадочек остался.

Та самая батарея (сверху) — устанавливается внутрь единого батарейного и FAN-модуля

Вид батарейного и FAN-модуля спереди. Он же отвечает за охлаждение прилегающего к нему контроллера

Зато сразу проверили, как работает сервис производителя. Нет худа без добра, как говорится.

Спойлер

Поддержка самая что ни на есть официальная и реально работает— еще расскажем об этом отдельно. Это важный момент: бывает, привезешь железо, и хорошо, если все работает и не приходится сталкиваться с гарантийной заменой. И можно сильно приуныть от того, как все долго и трудно. Нам же сразу подтвердили, что батарея неисправна — посмотрели по логам, проанализировали телеметрию и отправили новую запчасть.

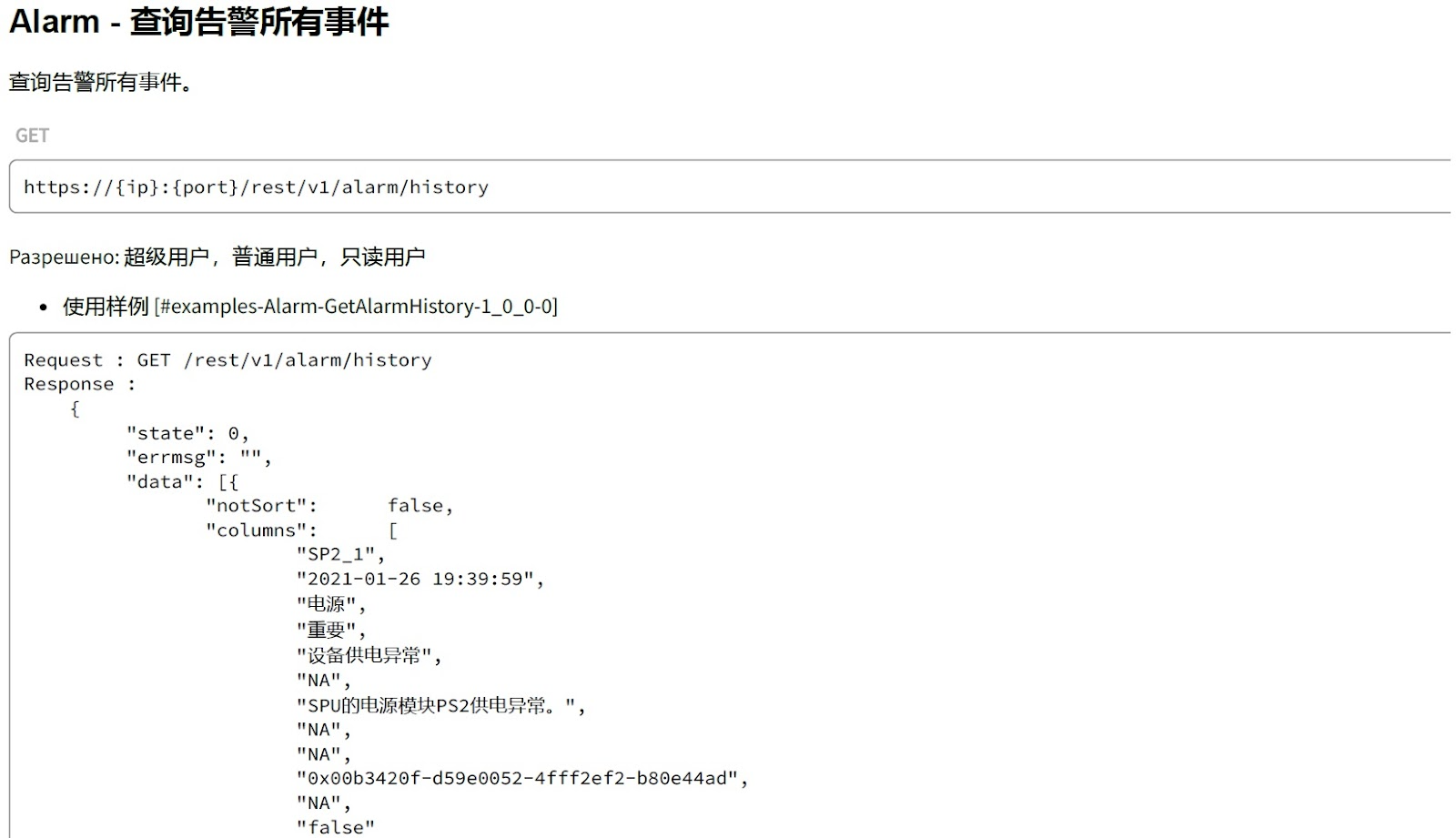

Первоначальная настройка СХД тоже не вызвала особых проблем. User guide на английском — это типовое. Однако, в нем есть только базовые вещи. Что-то посложней, например Rest API, описано только на китайском, но нам не привыкать.

Ну, а что? Понятная инструкция!

В ней вполне реально разобраться, если прогнать через онлайн-переводчик. С более глубокими вопросами мы уже обращаемся к вендору, а он дает развернутый ответ. По крайней мере, старается.

Что там приехало такое интересное

У Maipu в линейке есть модели all flash, которые полностью построены на NVMe, а к нам на тесты попал hybrid flash storage, система хранения данных, которая поддерживает NVMe, SSD, SAS, NL-SAS, SATA. Аппаратно это — центральный контроллер, в него можно установить 24 диска на 3,5 и 2,5 дюйма, плюс дополнительные дисковые полки.

Конфигурация СХД:

MPS5520G2-AF storage controller dual controllers;

16Gb-FC-IO modules, 4 штуки (I/O Модуль 16GB FC 4 портовый);

10GE-iSCSI-IO module, 2 штуки (I/O Модуль 10GB ethernet 4 портовый);

Полка расширения 25 дисков SFF 2.5» , 1 штука;

Диски SAS SSD 3.84TB, 25 штук;

Кэш 512 гб на массив (256 на контроллер);

1GbE Base-T встроенные порты, 4 штуки;

1GbE Base-T management port встроенные порты, 2 штуки;

10 GbE SFP+ , 8 штук .

Мы установили в лаборатории сразу пару таких систем (кодовые имена Biba и Boba), чтобы проверить их функциональность вместе и по отдельности.

Biba в левом верхнем углу, Boba — в нижнем (да, мы их различаем), справа вверху SSD из полки, справа внизу — 1 из 4 дисков на которых живет операционная система массива

Тестовый стенд выглядел так:

Получилась так называемая симметричная Dual-Active схема. Ее смысл в том, чтобы взять пару СХД, установить в разных ЦОД и резервировать данные. Получается катастрофоустойчивая инфраструктура — даже если целый дата-центр выйдет из строя, то сохранность информации обеспечит вторая СХД. Все живет и растянуто на двух ЦОД и переключается автоматически. При этом инфраструктура, приложения и пользователи даже не заметят сбоя. В общем, классический метрокластер.

А что система может в реальности?

Мы уже сталкивались с тем, что у продукции некоторых производителей в реальности работают не все заявленные функции, либо они работают, но не совсем так, как ожидаешь. Поэтому хотели лично проверить, что с Maipu MPS5520G2 все в порядке. Только это позволяет убедиться нам в том, что решение можно использовать в проектах и предлагать заказчикам.

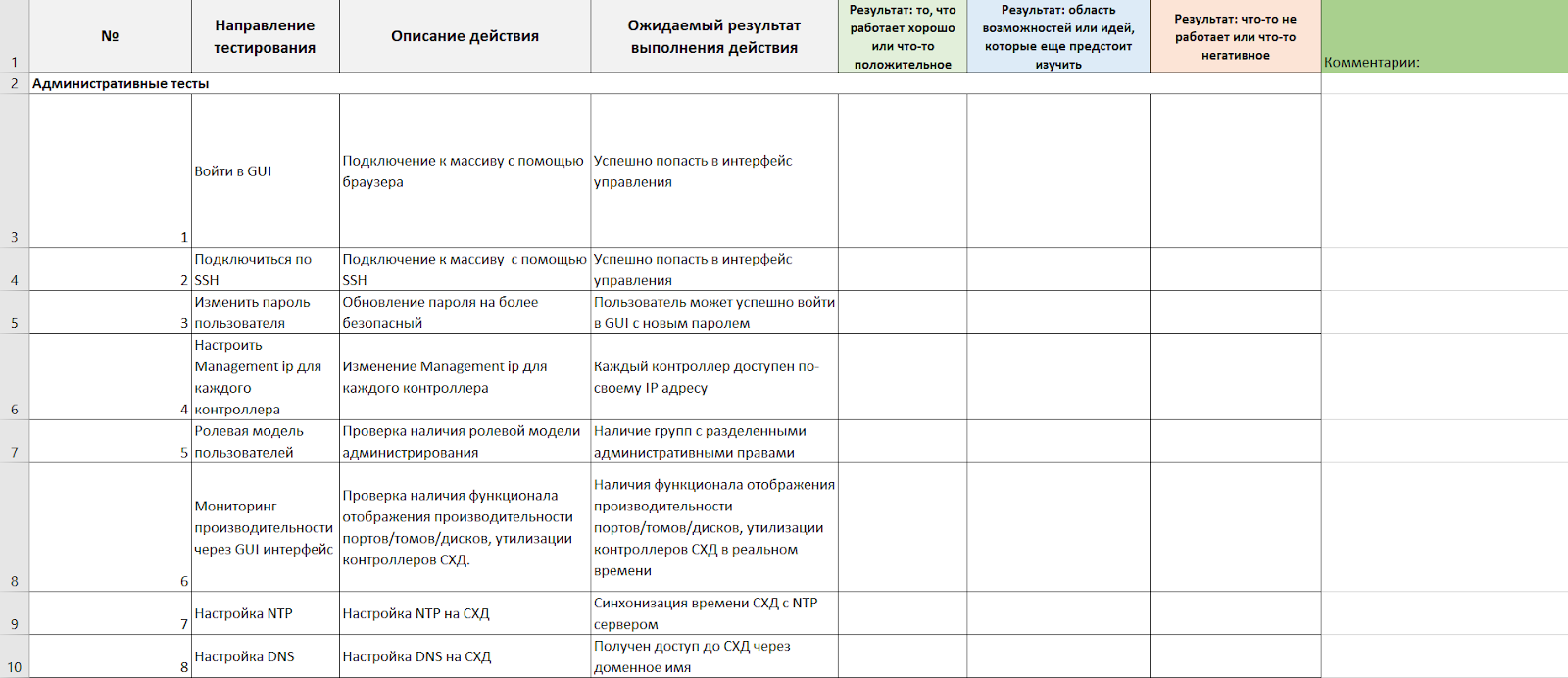

У нас своя многократно обкатанная методика тестирования, которая состоит из последовательных блоков:

Административные тесты.

Тесты конфигурации дисковой подсистемы.

Тестирование интеграции с VMware.

Проверка работы в SSH.

Тестирование работы Rest API.

Проверка работы при одиночном сбое аппаратных компонентов.

Тестирование производительности.

В каждом блоке — множество шагов, которые нужно пройти и зафиксировать результаты.

Например, функциональные тесты административного теста выглядят примерно так: войти в GUI → подключиться к массиву с помощью браузера → попасть в интерфейс управления → зафиксировать 3 варианта результата: что хорошего/возможности и идеи доработки/что плохого, нерабочего.

Ну что, погнали? Посмотрим, на что способна эта малышка.

Проверили производительность синтетическими тестами

Синтетические тестирования мы сначала проводили на платформе виртуализации VMware 6.7 с помощью HCIBench на стенде, о котором я рассказывал выше.

Во всех случаях тестирования мы использовали следующие параметры пула:

24 диска SAS SSD 3.84 TB;

размер Cell 1 GB;

в основу пула легли популярные рейды, которые используются у заказчиков;

политика spare равна двум дискам или пространству равному двум дискам.

Выбирая профили нагрузки, ориентировались на типовые кейсы, с которыми сталкиваемся чаще всего. Также решили сравнить будет ли разница в производительности между CRAID-P и CRAID-V. Посмотрев на тесты, можно сделать вывод, что в данном случае результаты CRAID-P и CRAID-V идентичные.

Проверили отказоустойчивость

На этом этапе мы по полной нарушаем инструкцию по эксплуатации. Прямо во время работы вырубаем питание, выдергиваем жесткие диски и всячески издеваемся над СХД. В результате одновременное извлечение блоков питания контроллеров и полок, самих контроллеров, I/O модулей, SAS и FC-кабелей ожидаемо не повлияло на доступность данных. Отметили только небольшую просадку на время перестроения путей.

Метрокластер тоже не вызвал никаких вопросов и отработал ожидаемо.

Все хорошо, но есть нюансы

В целом тесты дали положительные результаты — вся заявленная функциональность отрабатывает корректно. Массив прост и понятен в администрировании: очевидно, куда нужно нажать, если хочешь, например, сделать снапшот, или еще что-то. Все очень наглядно.

Но есть и некоторые странности. Например, веб-интерфейс, похоже, позиционируется, как основное средство управление СХД. Подключение через командную строку как бы есть, но используется только специалистами техподдержки. Документации по ней как таковой нет и команды при помощи tab-ов не подбираются.

Что из технических особенностей:

У контролеров нет централизованного управления. Чтобы изменить настройки, нужно ходить непосредственно на каждый узел.

Еще заявлена мультитенантность, но по факту она пока не реализована.

Очень широкая политика настройки прав пользователей: прямо 33 параметра, которыми можно разграничить права на разных уровнях.

Есть проблема с заведением массива в Zabbix. Сейчас обсуждаем с вендором эту тему. Пока нам предоставили шаблон, но он довольно сырой, в нем нет триггеров и графиков, чтобы все заработало, придется сделать их самостоятельно.

Контакты с вендором как отдельный повод для позитива

Взаимодействие с техподдержкой вендора у нас пока складывается исключительно положительное. Помимо гарантийной замены батареи на старте, уже в процессе тестирования мы вместе решали вопросы по конфигурации СХД. И вот у нас есть чатик в Telegram, куда мы кидаем вопросы. А вендор сразу отвечает или идет уточнять эту информацию у разработчиков.

Была выявлена проблема с настройкой репликационных линков, которые связывают два массива. Как мы сработали: отправляли конфигурацию вендору, он говорил да-да, нет-нет. Однажды даже они подключались удаленно, чтобы что-то проверить, и после проверки дали итоговую конфигурацию, сказали, как подключить — и все работает.

Для нас это необычный кейс. Ведь обычно как: получил систему и все вопросы задаешь через службу сервисной поддержки, которым присваивается низкий уровень критичности и жди ответа в течение недели. А здесь фактически живое общение с сотрудниками компании, которые быстро и спокойно решают вопросы, даже каверзные.

Что в сухом остатке

После всех тестов и впечатлений резюме по Maipu MPS5520G2 Storage у нас такое:

Это СХД, которую можно привезти легально (с точки зрения вендора) и получить полную поддержку производителя. Совсем как в старые добрые времена.

Все тесты система выдержала достойно — мы планируем активно использовать ее в клиентских проектах.

Пока это самое функциональное решение среди официально доступных, что мы нашли на рынке. С привычными техническими характеристиками, позволяющими закрывать основные задачи бизнеса.

Решение подойдет enterprise-компаниям, которым нужна система хранения данных, и они планируют модернизировать или расширить существующую инфраструктуру.

И в конце вишенка на торте — мы собрали в удобную табличку сравнительный анализ функционала Maipu c решениями российских и ушедших иностранных вендоров.

А дополнительным бонусом вы можете запросить полную сравнительную таблицу по имеющимся решениям у меня — AlZotov@k2.tech