Microsoft выпустила новую версию DeepSpeed+ZeRO для тренировки нейросетей

Компания Microsoft выпустила в свет новую версию библиотеки для тренировки нейросетей DeepSpeed+ZeRO, о чем свидетельствуют обновления соответствующего репозитория на GitHub. Теперь библиотека способна работать по 1 трлн параметров против 100 млрд, заявленных в первой версии DeepSpeed+ZeRO.

Ранняя версия библиотеки была представлена публике еще в феврале этого года и позиционировалась как инструмент, который значительно расширяет возможности по тренировке нейросетей по большому спектру параметров.

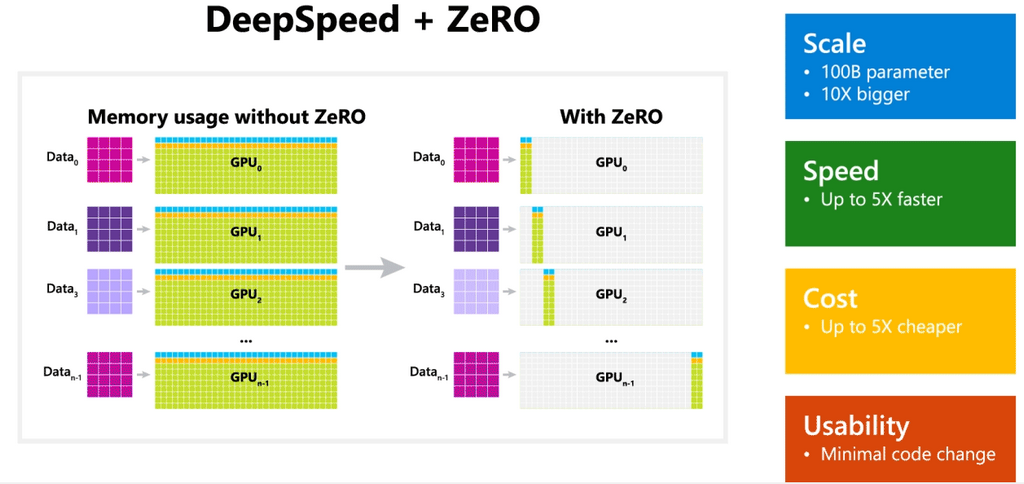

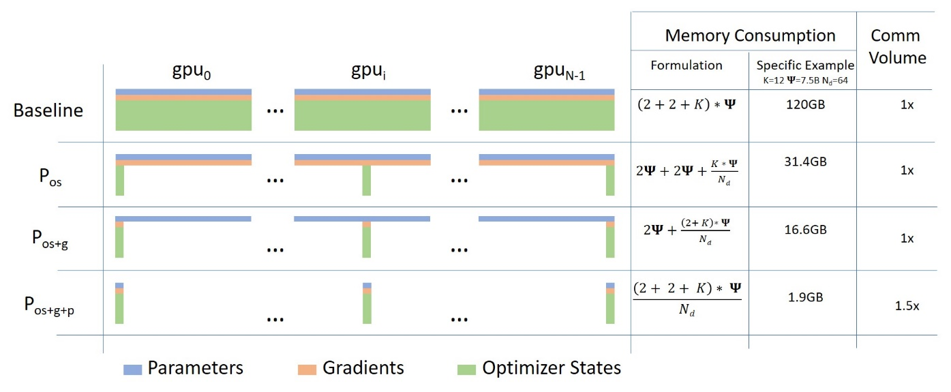

Высокая производительность библиотеки достигается за счет модуля ZeRO — технологии оптимизации потребления памяти во время крупномасштабного глубинного обучения. Именно ZeRO высвобождает необходимые для эффективных расчетов мощности, без привлечения дополнительного оборудования.

В плане количества параметров DeepSpeed превосходит в десятки раз OpenAI GPT-2, NVIDIA Megatron-LM и Google T5, которые используют 1,5, 8,3 и 11 миллиардов параметров соответственно.

Важно то, что ZeRO совместима с другими библиотеками, например, с Megatron-LM от NVIDIA и может ускорить, согласно заявлению в официальном блоге Microsoft, ее работу до четырех раз за счет оптимизации потребления ресурсов.

Основную область применения DeepSpeed Microsoft видит в сфере обучения языковых моделей, которые содержат миллиарды параметров. Так, по заверениям представителей компании, кластер из сотни видеокарт Nvidia архитектуры TensorCore модели Tesla V100 способен обучить языковую модель с 13 млрд параметров за 100 дней.

Для сравнения, на тот же период обучения с помощью более новых карт Nvidia модели А100, потребуется 4000 устройств. То есть, Microsoft заявляет о софтверном ускорении обучения языковых моделей в 40 раз. Также представители компании заявляют, что, технически, обучить нейросеть можно будет даже на одном ускорителе V100, просто это займет неприемлемо больше времени.

Подобная софтверная оптимизация ресурсов на миллиардных моделях открывает в сегмент дверь для энтузиастов и малых компаний, которые не могут позволить себе выкупить целый дата-центр для экспериментов. Так, одна Nvidia Tesla V100 сейчас стоит в рознице около $6700, а доступная пока только на закрытых тестах Nvidia A100, по разным оценкам, будет стоить в диапазоне от $10 до $14 тысяч. Мини-кластер высокой производительности и стоимостью от $10–15 тысяч — вполне подъемная цена для малого и среднего бизнеса. А это говорит о том, что в ближайшие годы мы можем столкнуться с качественным рывком продуктов на базе обучаемых нейросетей, в первую очередь, в области голосовых помощников, переводчиков и прочих продуктов, связанных с лингвистикой.