Кровеносная система мирового интернета

Инфографика TeleGeography

Google запускает рой воздушных шариков в стратосферу, а Facebook — армию беспилотников на солнечных батареях. Но это лишь маленькие игрушки гиков, которые мечтают покрыть связью всю планету. Их амбициозные сервисы станут крохотным дополнением к мощной базовой инфраструктуре Всемирной сети — разветвлённой сети наземных и подводных магистральных каналов. Вот где настоящая кровеносная система современной цивилизации. Именно здесь бьётся её пульс.

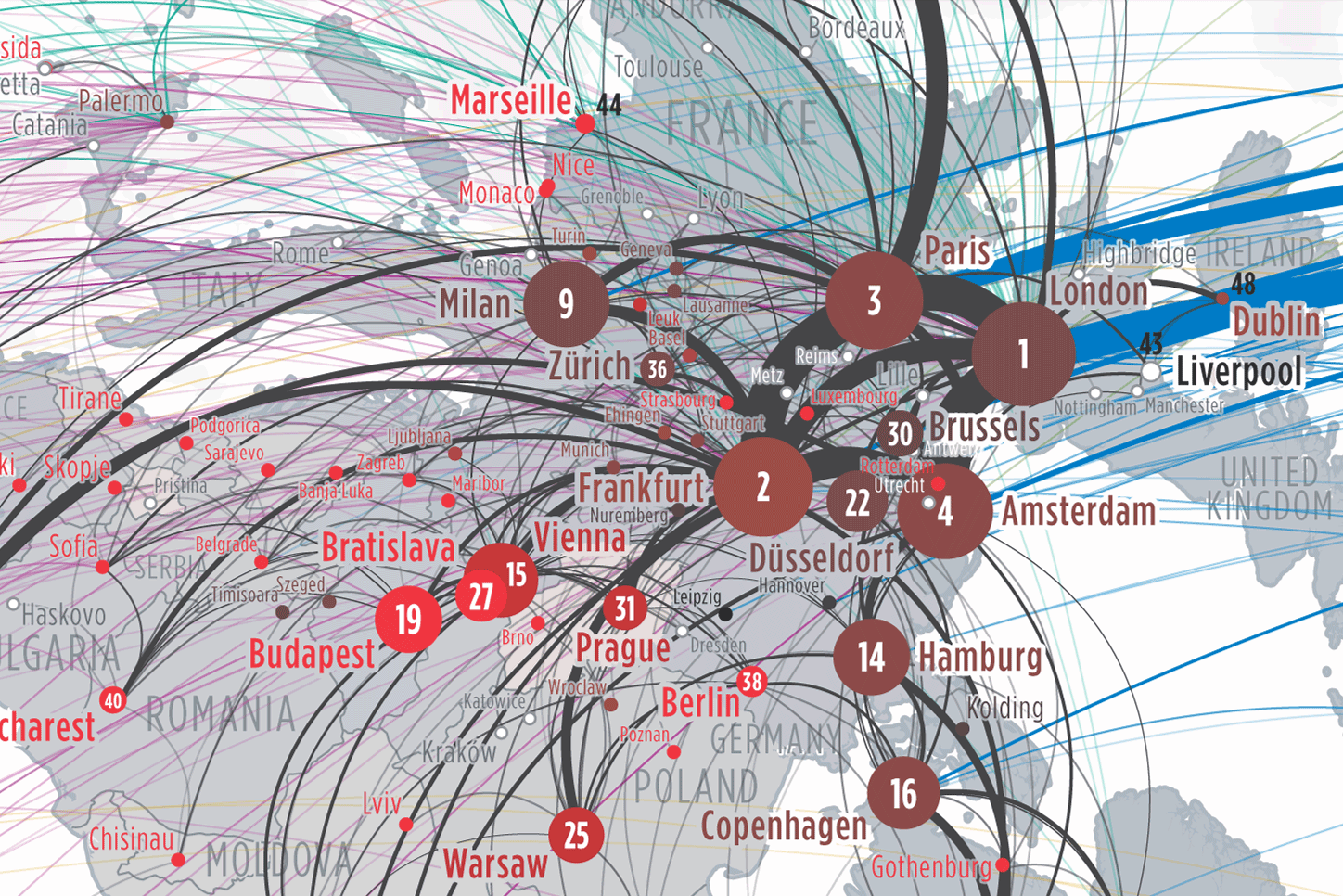

Крупнейшие хабы

На физическом уровне интернет представляет сеть хабов (точек обмена трафиком), связанных магистральными каналами. В точках обмена трафиком концентрируется не только трафик, но и сетевая инфраструктура (дата-центры, хостинг и т.д). Крупнейшие точки обмена находятся во Франкфурте, Амстердаме, Лондоне и Париже. В каком-то смысле эти города можно считать столицами мирового интернета. По крайней мере, точно крупнейшими сетевыми узлами, вместе с Нью-Йорком, который тоже входит в пятёрку основных хабов.

В списке крупнейших точек обмена трафиком в мире лидируют DE-CIX (пиковая пропускная способность 5178 Гбит/с), AMS-IX (4270 Гбит/с). Российская MSK-IX находится на 5-м месте (2135 Гбит/с).

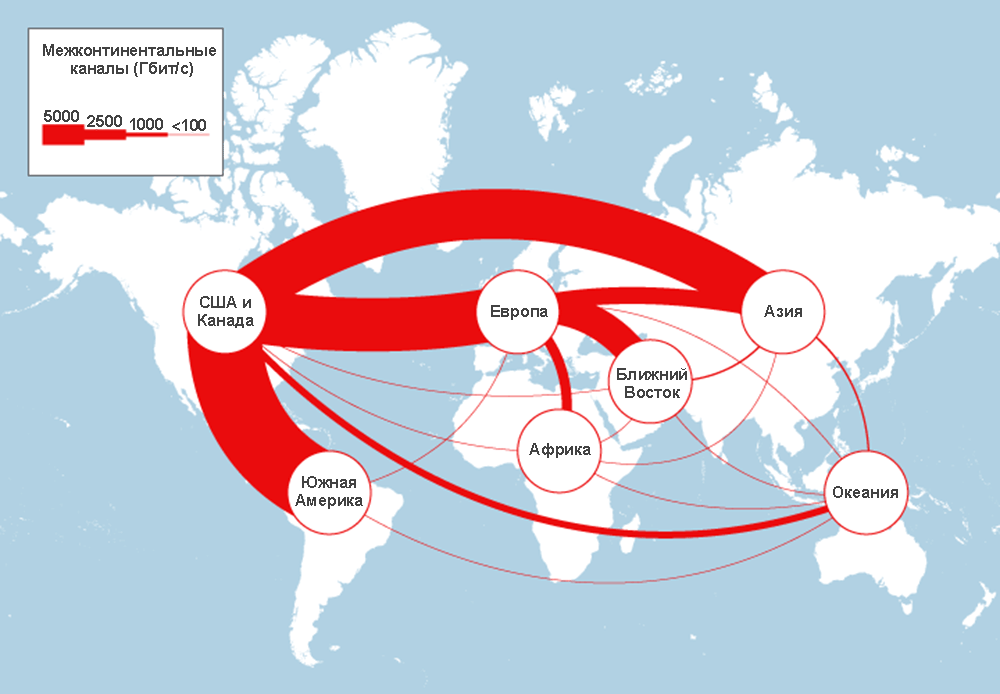

Совокупная пропускная всех международных каналов связи составляет 180 Тбит/с (на 2015 год).

По количеству международных каналов Европа долгое время была абсолютным лидером, превосходя любой другой континент. Но сейчас примерно столько же у Северной Америки (читай — у США), далее Азия, Южная Америка и Африка. Ещё десятилетие назад более половины международных каналов связи на планете приземлялись в Европе. Сейчас уже меньше половины, но Европа всё равно остаётся ключевым узлом в глобальной Сети.

Европейский узел отличается от остальных континентов ещё одной деталью: около 70% международного трафика перемещается между городами внутри континента. Для сравнения, у Южной Америки и Африки прямо противоположная картина: 80% каналов уходят к другим континентам, Кстати, 60% внешних каналов Южной Америки подключены к одному зарубежному городу: Майами. Так что если в Майами случится блэкаут, из интернета частично выпадет Южная Америка.

Почти все каналы связи между континентами прокладываются по дну океана.

Подводные бэкбоны

Подводный интернет — наверное, самая интересная (и секретная) часть мировой сетевой инфраструктуры. Секретная, потому что просто так вы не найдёте точную карту прокладки конкретного кабеля. Россия и некоторые другие страны держат эту информацию держится в секрете, и на то есть веские причины (см. статьи на Хабре «Подводная лодка USS Jimmy Carter, её специальные задачи», «Скрытное подсоединие к оптоволокну: методы и предосторожности»). От постороннего подключения не защищён ни один кабель, где бы он не находился.

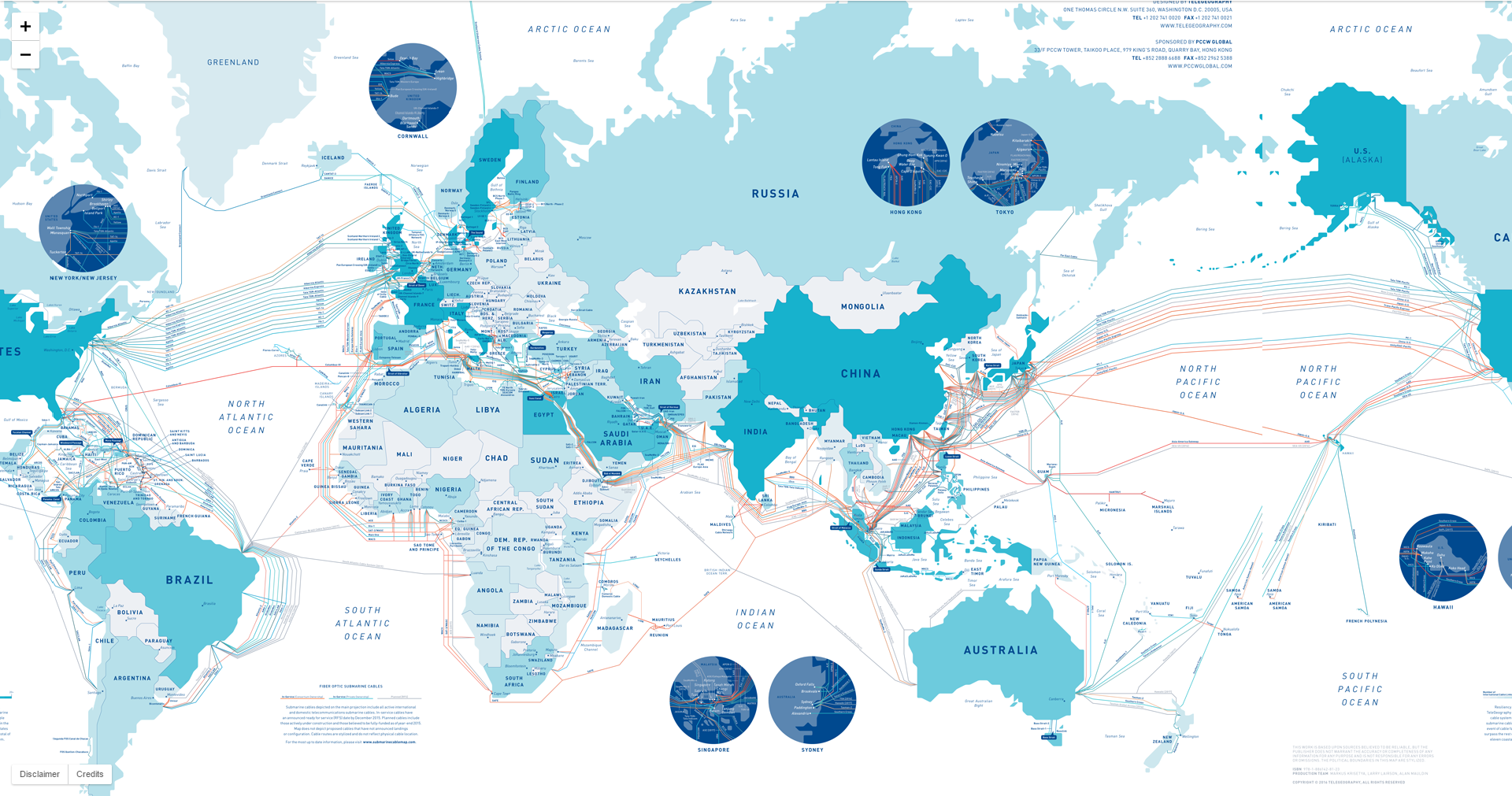

Карта подводных кабелей 2016 года

По данным на 2014 год, по дну океана проложено 285 кабелей связи, из них 22 не использовались, это так называемые «тёмные кабели» («тёмное оптоловокно») — такие неиспользуемые кабели в большом количестве есть и на суше. Например, та же компания Google скупает тёмное оптоволокно для связи между дата-центрами. Когда по тёмному оптоволокну пускают сигнал, говорят, что его «зажгли», как лампу.

Расчётный срок службы оптоволокна составляет 25 лет — это чисто теоретическая величина. Предполагается, что в течение такого времени коммерческая эксплуатация канала будет иметь смысл. Соответственно, исходя из такого срока экономисты рассчитывают окупаемость инвестиций. Например, для компании Google выгоднее проложить собственный кабель через Тихий океан, чем 25 лет арендовать чужой.

По мере роста трафика в интернете (он растёт примерно на 37% в год) операторы производят апгрейд оптоволокна — «уплотняют» его, чтобы передавать данные одновременно в нескольких спектральных каналах за счёт спектрального уплотнения. Кроме того, внедряются более эффективные техники фазовой модуляции и устанавливается более современное оконечное оборудование. Соответственно, пропускная способность магистрального канала увеличивается пропорционально полосе частот, на которых передаются данные.

Хорошей иллюстрацией является трансатлантическая информационная магистраль. В 2003–2014 годы здесь не было проложено ни одного (!) нового кабеля, зато пропускная способность действующих каналов увеличилась в 2,4 раза исключительно за счёт уплотнения каналов и апгрейда оборудования. И у этих кабелей ещё остался большой запас на будущее.

Увеличение пропускной способности трансатлантических каналов связи в 2003–2014 годы

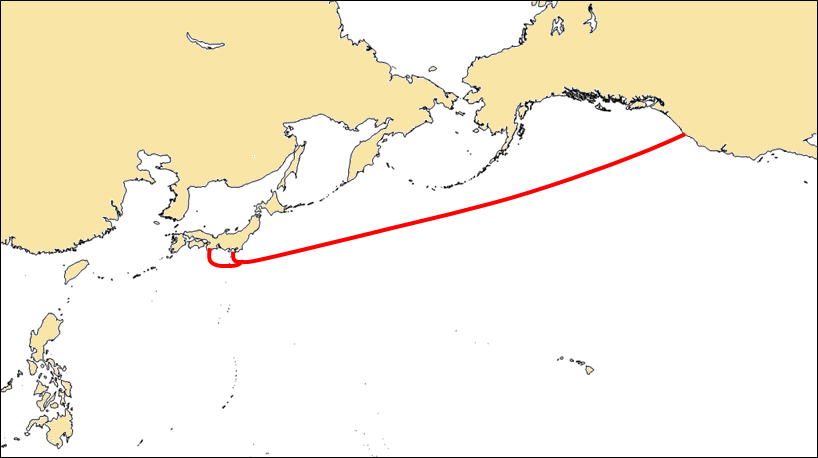

Прокладка нового кабеля и ввод его в эксплуатацию — длительная процедура, которая продолжается несколько лет, и довольно дорогостоящая, поэтому несколько корпораций обычно сообща финансируют такие проекты, а потом делят между собой оптоволоконные пары в кабеле. Например, 29 июня 2016 года компания Google с партнёрами (China Mobile International, China Telecom Global, Global Transit, KDDI, Singtel) объявили о вводе в эксплуатацию крупнейшего подводного кабеля в мире — транстихоокеанского кабеля FASTER на 60 Тбит/с. Кабель длиной 9000 км связал Японию и США (здесь Япония выполняет роль хаба между США и Китаем).

FASTER

Этот конкретный кабель состоит из 6 оптоволоконных пар. Каждая пара способна передавать сигнал в 100 диапазонах длины волны по 100 Гбит/с на каждую длину (10 Тбит/с на каждую оптоволоконную пару). Это соответствует 60 Тбит/с максимальной пропускной способности для каждого кабеля — это не теоретическая, а реальная максимальная пропускная способность, продемонстрированная в тестах.

Но в первое время пропускная способность даже близко не приблизится к этому пределу. На первом этапе будут задействованы всего лишь от 2 до 10 каналов, то есть 2–10% максимальной пропускной способности кабеля. В течение 25-летнего срока эксплуатации Google с партнёрами будут постепенно увеличивать его пропускную способность, по мере необходимости.

Google принадлежит один или два из шести оптоволоконных пар в кабеле, точная информация держится в секрете. Хотя стоимость прокладки трансатлантической магистрали FASTER составила $300 млн, для интернет-компании это действительно дешевле, чем арендовать такие же каналы у других. Кроме того, так Google получает больший контроль над линиями связи, которые связывают её дата-центры.

Кстати, Microsoft и Facebook по примеру Google сейчас тоже формируют консорциум для прокладки своего трансатлантического кабеля.

Сети в Европе

Если магистральные каналы связи сравнить с кровеносной системой современной цивилизации, то Европа — её сердце.

Карта магистральных каналов в Европе с каждым годом немного изменяется. Между крупнейшими узлами сети иногда прокладываются новые каналы с большей пропускной способностью и/или меньшей задержкой (то есть по более оптимальному маршруту). В некоторых случаях каналы могут вообще «пропадать», то есть их перестают использовать, если оператор по какой-то причине решит перенаправить линк от одного города к другому. В начале 2000-х крупнейшим международным каналом связи в мире был трансатлантический маршрут Нью-Йорк–Лондон, но в 2009 году проложили более толстый канал Амстердам–Лондон, а затем и этот рекорд был побит новым «чемпионом» — трассой Франкфурт–Париж.

Примерно в это время сформировалась окончательная структура сетевых магистралей в Европе с четырьмя крупнейшими в мире точками обмена трафиком.

- Франкфурт

- Лондон

- Париж

- Амстердам

По мировой статистике, всего лишь около 25% самых популярных сайтов каждой страны размещаются у себя на родине (в среднем). Доля национального хостинга заметно выше в Китае, Иране, Турции и России, по понятным причинам.

Физическое местоположение серверов 100 самых популярных сайтов в некоторых странах, апрель 2015 год. Источник: TeleGeography

Связь с Россией

С точки зрения надёжности оптимально размещение сервера возле крупнейшей точки обмена трафиком, которая связывает Россию с мировым интернетом.

России в каком-то смысле повезло. Рядом с российским сегментом интернета располагаются крупнейшие в мире сетевые хабы. Самая близкая географически и, по стечению обстоятельствам, самая крупная в мире из точек обмена трафиком — DE-CIX во Франкфурте. Сюда подключены три крупнейших российских оператора обмена трафиком MSK-IX (2 Тбита/с), Data-IX (2 Тбита/с), W-IX (1 Тбит/с), со средней нагрузкой 3,2 Гбита/с.

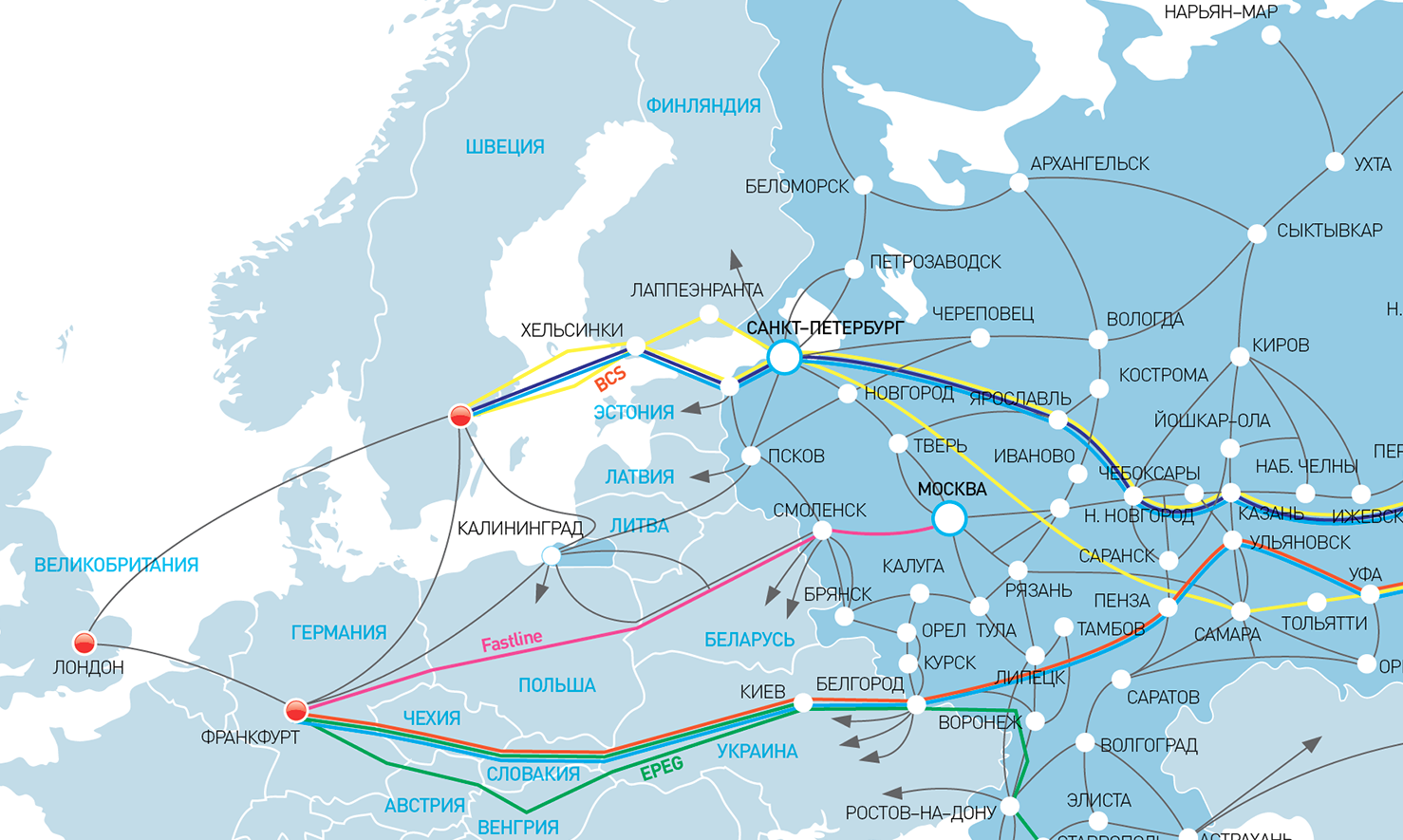

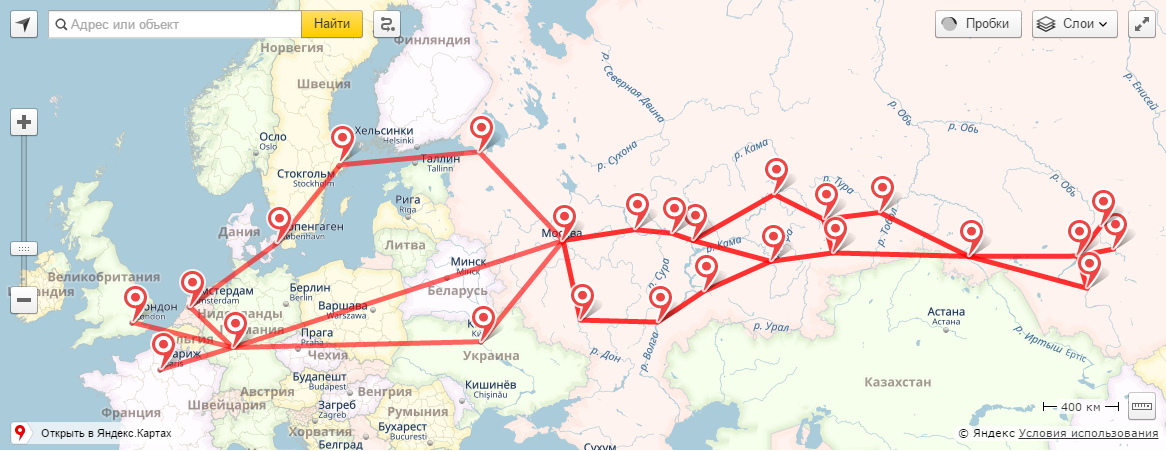

На карте магистральных сетей «Ростелекома» и карте международного магистрального оператора RETN показано, по каким каналам российский сегмент подключается к крупнейшим мировым точкам обмена. Обозначена и новая быстрая линия «Ростелекома» из Москвы во Франкфурт.

Карта магистральных сетей «Ростелекома»

Карта магистральных сетей RETN

Для обмена трафиком операторы могут заключать соглашения друг с другом или выбрать более продвинутый пиринг вроде W-IX. Эта система работает внутри одного города на втором уровне, и связь между участниками осуществляется, как и в любом другом пиринге, напрямую. В то же время, через роут-сервер осуществляется связь со всеми другими точками обмена трафиком, в которых W-IX является участником.

W-IX

W-IX имеет свои международные каналы между крупнейшими точками обмена трафиком.

W-IX

W-IX

Эксперты отмечают, что в последние годы наметилась некоторая тенденция к локализации трафика, когда серверы размещают внутри национальных границ той страны, где находится основная аудитория. В пользу локализации играет распространение CDN-сервисов и меры информационной безопасности, связанные с угрозой утечек конфиденциальной информации. Сейчас не только Россия, но и другие страны рассматривают законы, обязывающие хранить конфиденциальную информацию (в том числе финансового и медицинского характера) только внутри страны.

К счастью, требования локализации затрагивают только ограниченное количество веб-сайтов, так что интернет-компании по-прежнему могут выбрать место хостинга исходя из собственных потребностей. Размещение серверов рядом с глобальными сетевыми хабами не делает серверы доступнее для глобальной аудитории и выходит гораздо дешевле, потому что вокруг хабов концентрируется вся соответствующая сетевая инфраструктура, в том числе дата-центры и хостинг-провайдеры.

Комментарии (2)

14 июля 2016 в 09:06

+1↑

↓

Почему трансатлантический кабель проложен по дну Тихого океана?14 июля 2016 в 09:14

+1↑

↓

И вправду, вероятно из соображений секретности)) Спасибо за ремарку, исправил.