Кроме Мура — кто еще формулировал законы масштабирования вычислительных систем

Говорим о двух правилах, которые также начинают терять актуальность.

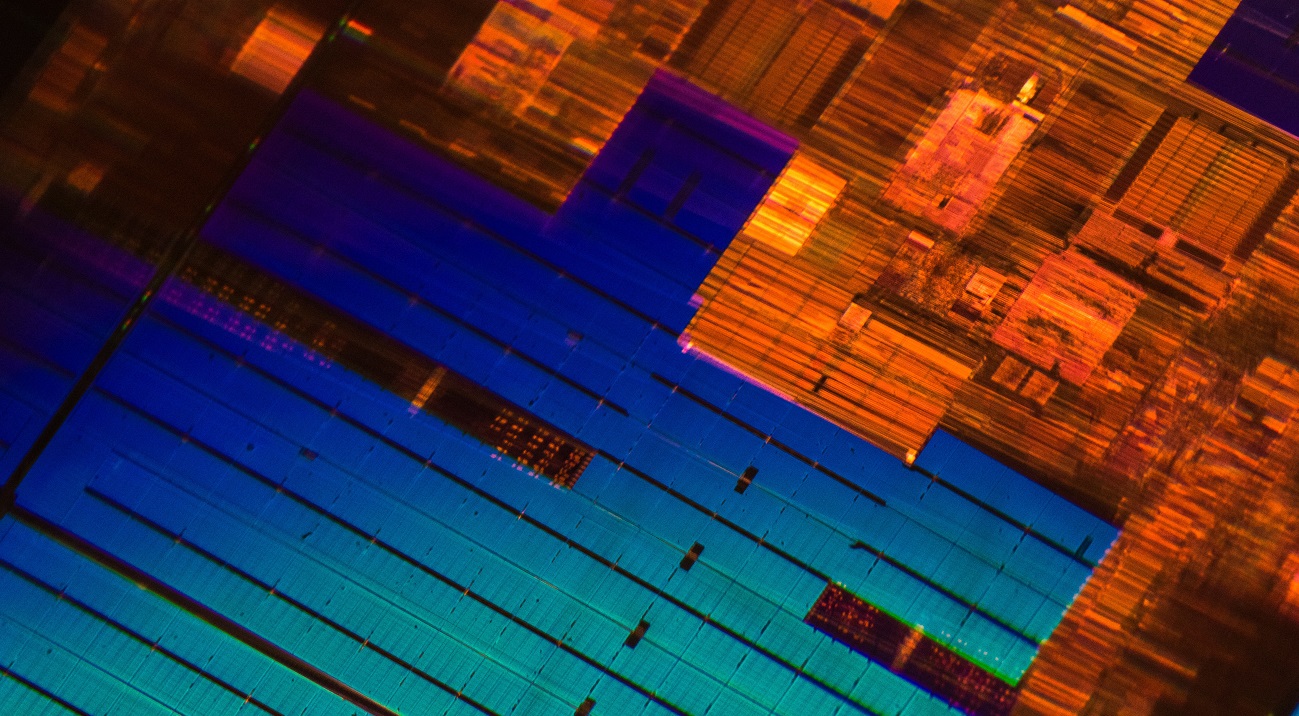

/ фото Laura Ockel Unsplash

Закон Мура был сформулирован более пятидесяти лет назад. На протяжении всего этого времени он по большей части оставался справедливым. Даже сегодня при переходе от одного техпроцесса к другому плотность транзисторов на кристалле увеличивается примерно в два раза. Но есть проблема — скорость разработки новых техпроцессов замедляется.

Например, в Intel долгое время откладывали массовое производство своих 10-нанометровых процессоров Ice Lake. Хотя ИТ-гигант начнет поставлять устройства в следующем месяце, анонс архитектуры состоялся около двух с половиной лет назад. Также в августе прошлого года производитель интегральных схем GlobalFoundries, который работал с AMD, прекратил разработку 7-нм техпроцессов (подробнее о причинах этого решения мы рассказывали в нашем блоге на Хабре).

Журналисты и руководители крупных ИТ-компаний уже не первый год пророчат смерть закону Мура. Даже сам Гордон как-то заявлял, что сформулированное им правило перестанет действовать. Однако закон Мура — не единственная закономерность, которая теряет актуальность и на которую равняются производители процессоров.

Закон масштабирования Деннарда

Его сформулировал в 1974 году инженер и разработчик динамической памяти DRAM Роберт Деннард (Robert Dennard) вместе с коллегами из IBM. Правило звучит следующим образом:

«Уменьшая размеры транзистора и повышая тактовую частоту процессора, мы можем легко повышать его производительность».

Правило Деннарда закрепило уменьшение ширины проводника (техпроцесса) в качестве главного показателя прогресса в индустрии микропроцессорной техники. Но закон масштабирования Деннарда перестал действовать примерно в 2006 году. Количество транзисторов в чипах продолжает увеличиваться, но этот факт не дает значительного прироста к производительности устройств.

Например, представители TSMC (производитель полупроводников) говорят, что переход с 7-нм техпроцесса на 5-нм увеличит тактовую частоту процессора всего на 15%.

Причиной замедления роста частоты, являются утечки токов, которые Деннард не учитывал в конце 70-х. При уменьшении размеров транзистора и повышении частоты ток начинает сильнее нагревать микросхему, что может вывести ее из строя. Поэтому производителям приходится балансировать выделяемую процессором мощность. В результате с 2006 года частота массовых чипов установилась на отметке в 4–5 ГГц.

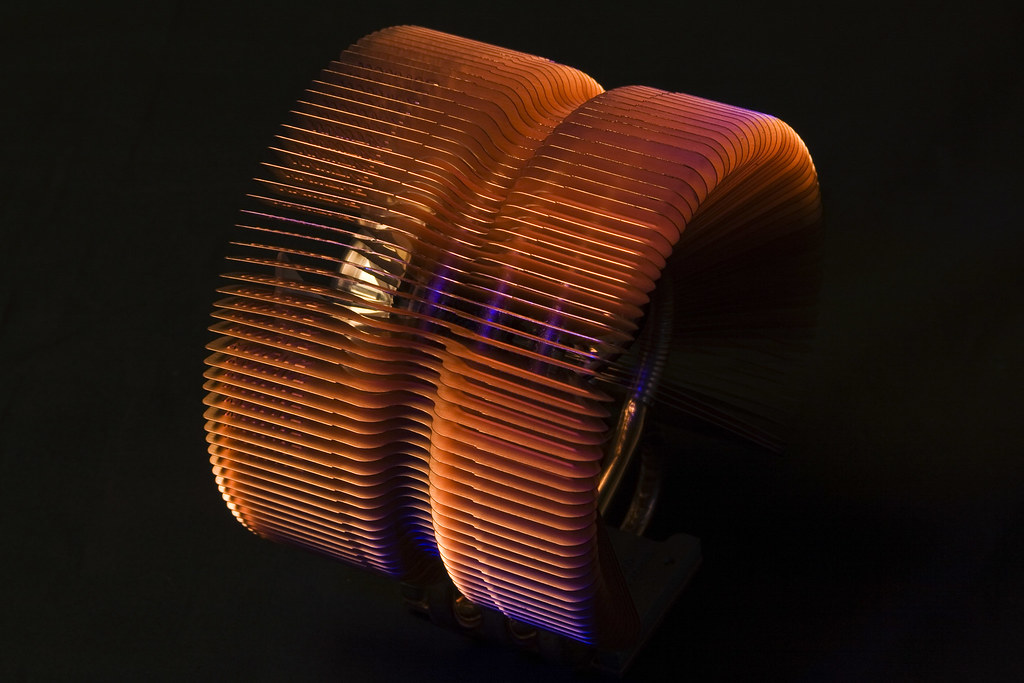

/ фото Jason Leung Unsplash

Сегодня инженеры работают над новыми технологиями, которые позволят решить проблему и увеличить производительность микросхем. Например, специалисты из Австралии разрабатывают металл-воздушный транзистор, который имеет частоту в несколько сотен гигагерц. Транзистор состоит из двух металлических электродов, выполняющих роли стока и истока и расположенных на расстоянии в 35 нм. Они обмениваются электронами друг с другом благодаря явлению автоэлектронной эмиссии.

По словам разработчиков, их устройство позволит перестать «гоняться» за уменьшением техпроцессов и сконцентрироваться на построении высокопроизводительных 3D-структур с большим числом транзисторов на кристалле.

Правило Куми

Его сформулировал в 2011 году профессор Стэнфорда Джонатан Куми (Jonathan Koomey). Совместно с коллегами из Microsoft, Intel и университета Карнеги-Меллона он проанализировал информацию об энергопотреблении вычислительных систем начиная с ЭВМ ENIAC, построенной в 1946 году. В итоге Куми сделал следующее заключение:

«Объем вычислений на киловатт энергии при статической нагрузке удваивается каждые полтора года».

При этом он отметил, что энергопотребление компьютеров за прошедшие годы также выросло.

В 2015 году Куми вернулся к своей работе и дополнил исследование новыми данными. Он установил, что описанная им тенденция замедлилась. Средняя производительность чипа на киловатт энергии начала удваиваться примерно каждые три года. Тренд сменился из-за трудностей, связанных с охлаждением чипов (стр. 4), так как с уменьшением размеров транзисторов становится сложнее отводить тепло.

/ фото Derek Thomas CC BY-ND

Сейчас разрабатываются новые технологии охлаждения чипов, но об их массовом внедрении пока говорить не приходится. Например, разработчики из университета в Нью-Йорке предложили использовать лазерную 3D-печать для нанесения тонкого теплопроводящего слоя из титана, олова и серебра на кристалл. Теплопроводность такого материала в 7 раз лучше, чем у других термоинтерфейсов (термопасты и полимеров).

Несмотря на все факторы, по словам Куми, до теоретического энергетического предела еще далеко. Он ссылается на исследование физика Ричарда Фейнмана (Richard Feynman), который еще в 1985 году отметил, что показатель энергоэффективности процессоров вырастет в 100 млрд раз. На момент 2011 года этот показатель увеличился всего лишь в 40 тыс. раз.

ИТ-индустрия привыкла к высоким темпам роста вычислительных мощностей, поэтому инженеры ищут способы продлить действие закона Мура и преодолеть трудности, продиктованные правилами Куми и Деннарда. В частности, компании и исследовательские институты ищут замену традиционным транзисторным технологиям и кремнию. О некоторых из возможных альтернатив мы расскажем в следующий раз.

О чем мы пишем в корпоративном блоге:

Наши отчеты с VMware EMPOWER 2019 на Хабре: