Искусство парсинга 2 или транслитерация собственной разметки

+БОНУС: как включать классы друг в друга в C++

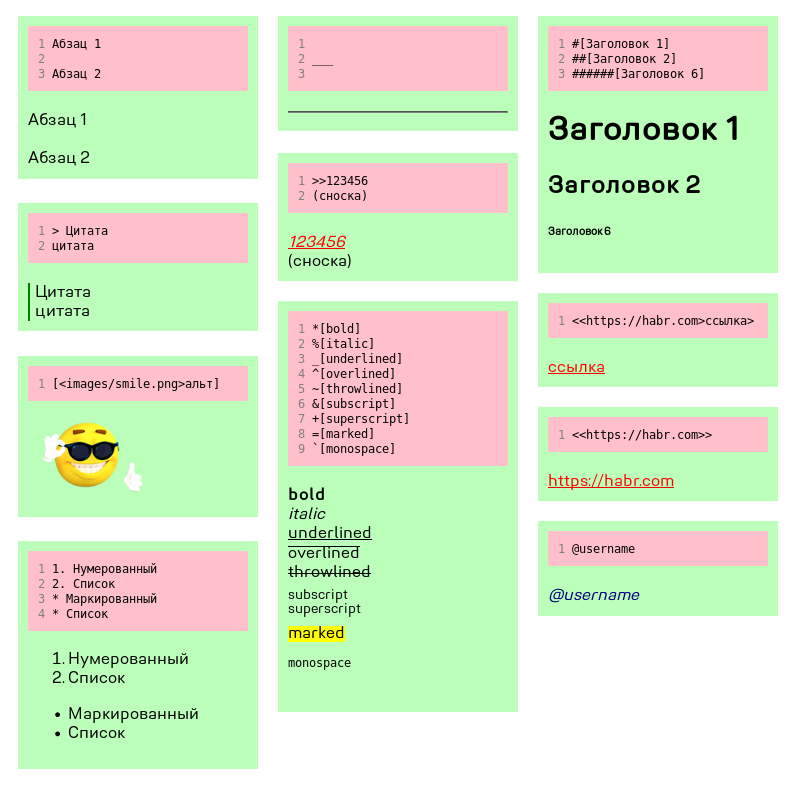

Привет, Хабр! Эта статья — прямое продолжение статьи Искусство парсинга или DOM собственными руками, где мы разобрали HTML-документ и построили на его основе абстрактное синтаксическое дерево (AST) с доступом к любому элементу через индексацию при помощи лишь стандартной библиотеки C++, проще говоря, научились самостоятельно парсить XML-подобные штуки. Напомню, что процесс парсинга, или синтаксического анализа/разбора состоит из двух этапов: лексического разбора (разбора текста на токены) и построения AST. Если первый мы рассмотрели очень подробно, с примерами и исходниками, то описание второго похоже на пустую куколку бабочки, у которой есть только оболочка, а прекрасное содержимое автор извлёк перед публикацией. На то была причина, для HTML построить дерево действительно просто, нужно всего 4 класса: пустой тег, блок, текстовый узел и корень документа, наследуемый от блока. Сегодня мы оставим такую простоту позади и построим дерево, где свойства элементов, и пустых, и блочных, будут содержаться не в атрибутах тегов, а непосредственно в классах, а для этого классов придётся создать много. Действительно много. Строить будем не из простых известных языков разметки, а создадим свой, с правилами, показанными на изображении под катом. Плюс в конце ещё переведём, или, говоря правильнее, транслитируем документ с предыдущей статьёй, размеченной нашим языком, в HTML, а в качестве бонуса я отвечу начинающим программистам C++ на тривиальный, но труднонаходимый вопрос: как включать классы «друг в друга»?

Примечания в грамматике

Прежде чем мы перейдём непосредственно к построению дерева, давайте освежим память и уясним некоторые детали предварительной работы. Вы ещё помните, что весь синтаксис языка нужно прописать в форме одной из контекстно-свободных формальных грамматик, например, БНФ? Вот только начинающим программистам трудно сразу их освоить, да и к тому же, не все возможные правила этими грамматиками можно описать. В таких случаях, если вы зашли в тупик и никак не сформулируете определённое правила в правильной форме, можно записать его как замечания на естественном человеческом языке, например, так:

...

=

= "." { "."} " "

= {}

!! link ending ">" and image/span ending "]" can't follow "\n" or document start

Перевод: окончания ссылки »>» и изображения/встроенного элемента »]» не могут следовать сразу за началом строки или документа.

То есть, если в начале строки лексер встретит »]» или »>», мы должны дать ему установку проигнорировать особое значение этих символов и работать с ними как с обычным текстом. Такой способ добавления замечаний в грамматику не единственный, вы можете делать это по своему. В конце концов, файл с описанием синтаксиса — не курсовая работа, никто не заставляет соблюдать все правила и важно только, чтобы именно вам было удобно с ним работать. Главное, не забывать о сделанных замечаниях и отразить их в нужных участках кода.

Давайте рассмотрим полное описание данного языка:

= {}

= |

(* ARTICLE ITEMS *)

= "___" {"_"} "\n"

= {}

= | | <quote> | <cite> | <unordered_list> | <ordered_list>

(* SECTION ITEMS *)

<paragraphs> = <paragraph> {"\n" <paragraph>}

<paragraph> = <span> {<span>} ("\n" | <END>)

<span> = <bold> | <italic> | <underlined> | <overlined> | <throwlined> | <subscript> | <superscript> | <marked> | <monospace> | <text> | <image> | <link> | <notification>

<title> = <number signs> <left_angle_bracket> {<span>} <right_angle_bracket> ("\n" | <END>)

<number signs> "######" | "#####" | "####" | "###" | "##" | "#"

<quote> = "> " {<span>} ("\n" | <END>)

<cite> = ">>" <number> ("\n" | <END>)

<number> = <digit> {<digit>}

(* PARAGRAPH ITEMS *)

<bold> = "*[" {<span>} "]"

<italic> = "%[" {<span>} "]"

<underlined> = "_[" {<span>} "]"

<overlined> = "^[" {<span>} "]"

<throwlined> = "~[" {<span>} "]"

<subscript> = "&[" {<span>} "]"

<superscript> = "+[" {<span>} "]"

<marked> = "=[" {<span>} "]"

<monospace> = "`[" {<span>} "]"

<text> = <textline> "\n" {<textline> "\n"}

<textline> = <symbol> {<symbol>}

<symbol> = /^[\n]/

<link> = "<<" <text> ">" {<span>} ">"

<image> = "[<" <text> ">" [<text>] "]"

<notification> = (" " | "\n") "@" <word> (" " | "\n" | <END>)

<word> = (<letter> | <digit>) {<letter> | <digit>}

<letter> = "a" | "b" | "c" | "d" | ... | "_" | "-"

<digit> = "0" | "1" | "2" | "3" | "4" | "5" | "6" | "7" | "8" | "9"

(* LISTS *)

<unordered_list> = <unordered_list_item> {<unordered_list_item>}

<ordered_list> = <ordered_list_item> {<ordered_list_item>}

<unordered_list_item> = <marker> <div>

<marker> = ("*" {"*"}) | ("+" {"+"}) " "

<ordered_list_item> = <number_marker> <div>

<number_marker> = <number> "." {<number> "."} " "

<number> = <digit> {<digit>}

!! link ending ">" and image/span ending "]" can't follow "\n" or document start

</code>

</pre><p>

<br />В прошлый раз нужно было выписать терминалы и проверять каждый входящий символ на соответствие одному из них. Но тогда терминалы были односимвольные! Теперь необходимо кроме выделения терминалов разделить их самих на <em>ключи</em> — то есть, символы. Почему «ключи»? Они имеют ключевое значение для лексера. В результате всех действий у нас в файле с грамматикой появятся строчки: </p>

<pre>

<code class="html">(* TERMINALS *)

"___...", "\n", "\n\n", "> ", ">>...", "###...[", "*[", "%[", "_[", "^[", "~[", "&[", "+[", "=[", "`[", "]", "<<", "[<", ">", " @... ", "\n@...\n", " @...\n", "\n@... ", "***... ", "+++... ", "123.56. "

(* KEYS *)

"_", "\n" ">", "#", "*", "%", "^", "~", "&", "+", "=", "`", "<", "[", "]", " ", "@", "1..9", ".", <END>

</code>

</pre><p>

<br /></p>

<h2>Стек ожидаемых типов токенов</h2><p>

<br />В прошлый раз, опять же, всё было проще, у нас было всего 10 типов токенов, не считая конца, и было меньше шансов запутаться в этом зоопарке лексем. Теперь типов, очевидно, больше. Напомню, что задача лексера — оставить парсеру как можно меньше работы, в идеале, лишь построение дерева. Поэтому набор типов токенов должен как можно точнее отражать их сущность. В первой статье я привёл пример хорошего набора, в этой приведу его вместе с «антипримером». Видите терминалы, начинающие встроенные текстовые элементы (полужирный — bold, курсив — italic и т.д.)? Мы могли бы разобрать их на пару токенов: ведущий (»*»,»%» и др.) и ведомый (»[») и в такой форме передать парсеру. Легко догадаться, что лучше сделать точное определение текстового элемента на уровне лексера, т.е. определить »*[» как «bold_start»,»%[» как «italic_start» и и.д. Чем больше типов и чем точнее они отражают самих себя — тем лучше. При этом второе важнее первого. Например, мы могли бы разобрать нотификацию на символ »@» и имя пользователя, но, очевидно, лучше оставить их совмещёнными в одной лексеме.<br />Ну вот мы определились с типами. С чего начать процедуру разбора текста на токены? Как и тогда, начните с начала. Что может следовать сразу за началом разбираемого документа? Не спешите загибать пальцы. В отличие от HTML, все 22 типа здесь могут дать старт. Ничего страшного, вооружившись битовой унификацией, так и пишем: </p>

<pre>

<code class="cpp">curr_token_type = TEXT | UNDERLINE | TITLE_START | QUOTE_START | CITE | BOLD_START | ...</code>

</pre><p>

<br />а в функции обработки символа: </p>

<pre>

<code class="cpp">case TEXT | UNDERLINE | TITLE_START | QUOTE_START | CITE | ...</code>

</pre><p>

<br />Если не понимаете, о чём идёт речь, прочитайте первую статью.</p>

<p>Не бойтесь длинного обобщённого типа ожидаемого токена. Первый символ строки сразу сократит его длину до 2–4 типов. Так как наши терминалы многосимвольны, определение идёт по ключам.</p>

<p>Всё просто, посмотрите сами: </p>

<pre>

<code class="cpp">

if (c == '_') {

buffer.push_back('_');

curr_token_type = TEXT | UNDERLINE | UNDERLINED_START;

</code>

</pre><p>

<br />Нижнее подчёркивание сразу определило строящийся токен к одному из трёх типов: простого текста, горизонтальной черте или начало подчёркнутого текста (»_[»).</p>

<p>Возвращаясь к проблеме, как уследить за всеми обобщёнными типами и не забыть обработать их все? Заведите стек… в блокноте! Именно так, записывайте все обобщённые типы, появляющиеся после «curr_token_type = …» в список, и после обработки одного берите из этого списка другой с конца. Можно организовать работу со списком и как с очередью, это большого значения не имеет. Главное, что так вы не забудете, какие типы уже обработаны, а какие ещё предстоит обработать.</p>

<h2>Дерево классов</h2><p>

<br />Наконец, мы добрались до синтаксического разбора. Здесь нужно определиться с классами нод (узлов) будущего дерева точно так же, как мы определялись с типами токенов. Для этого снова откройте блокнот и напишите следущее: </p>

<pre>

<code class="cpp">

Node { Node * parent, Node_type type } #-

Root { Root_item[] children, ulong children_count }

</code>

</pre><p>

<br />Так мы определили будущий базовый класс всех нод и его производный — корень дерева, то есть, сам документ. Документ (см. БНФ выше) состоит из двух типов нод: раздела (section) и горизонтальной линии (underline). Определим для них базовый класс Root_item и опишем каждый так же, как мы описали корень. Кроме того, здесь же, в блокноте, сразу указываем все другие поля классов, если они есть. Для корня это число «детей» — т.е. внутренних разделов и горизонтальных линий. Раздел состоит из элементов, для которых мы определим базовый класс Div и так далее, двигаясь рекурсивно по грамматике, определим все нужные классы. Перед тем, как писать код, определим здесь же все включения заголовков. Это просто: все прямые наследники базовых обобщённых классов должны включаться в содержащие их классы.</p>

<p>Обозначим эти зависимости в виде списков после решётки, и у нас получится такой документ: </p>

<pre>

<code class="css">Node { Node * parent, Node_type type } #-

Root { Root_item[] children, ulong children_count } #Underline, #Section

Root_item {} #-

Underline {}

Section { Div[] children, ulong children_count } #Paragraph, #Title, #Quote, #Cite, #Unordered_list, #Ordered_list

Div {} #-

Paragraph { Span[] children, ulong children_count } #Bold, #Italic, #Underlined, #Overlined, #Throwlined, #Subscript, #Superscript, #Marked, #Monospace, #Text, #Image, #Link, #Notification

Title { char level, Span[] children, ulong children_count } #Bold, #Italic, #Underlined, #Overlined, #Throwlined, #Subscript, #Superscript, #Marked, #Monospace, #Text, #Image, #Link, #Notification

Quote { Span[] children, ulong children_count } #Bold, #Italic, #Underlined, #Overlined, #Throwlined, #Subscript, #Superscript, #Marked, #Monospace, #Text, #Image, #Link, #Notification

Cite { ulong number } #-

Unordered_list { Div } #Paragraph, #Title, #Quote, #Cite, #Ordered_list

Ordered_list { Div } #Paragraph, #Title, #Quote, #Cite, Unordered list

Span {} #-

Bold { Span[] children, ulong children_count } #Italic, #Underlined, #Overlined, #Throwlined, #Subscript, #Superscript, #Marked, #Monospace, #Text, #Image, #Link, #Notification

Italic { Span[] children, ulong children_count } #Bold, #Underlined, #Overlined, #Throwlined, #Subscript, #Superscript, #Marked, #Monospace, #Text, #Image, #Link, #Notification

Underlined { Span[] children, ulong children_count } #Bold, #Italic, #Overlined, #Throwlined, #Subscript, #Superscript, #Marked, #Monospace, #Text, #Image, #Link, #Notification

Overlined { Span[] children, ulong children_count } #Bold, #Italic, #Underlined, #Throwlined, #Subscript, #Superscript, #Marked, #Monospace, #Text, #Image, #Link, #Notification

Throwlined { Span[] children, ulong children_count } #Bold, #Italic, #Underlined, #Overlined, #Subscript, #Superscript, #Marked, #Monospace, #Text, #Image, #Link, #Notification

Subscript { Span[] children, ulong children_count } #Bold, #Italic, #Underlined, #Overlined, #Throwlined, #Superscript, #Marked, #Monospace, #Text, #Image, #Link, #Notification

Superscript { Span[] children, ulong children_count } #Bold, #Italic, #Underlined, #Overlined, #Throwlined, #Subscript, #Marked, #Monospace, #Text, #Image, #Link, #Notification

Marked { Span[] children, ulong children_count } #Bold, #Italic, #Underlined, #Overlined, #Throwlined, #Subscript, #Superscript, #Monospace, #Text, #Image, #Link, #Notification

Monospace { Span[] children, ulong children_count } #Bold, #Italic, #Underlined, #Overlined, #Throwlined, #Subscript, #Superscript, #Marked, #Text, #Image, #Link, #Notification

Text { string text } #-

Image { string src, string alt } #-

Link { string URL, Span[] children, ulong children_count } #Bold, #Italic, #Underlined, #Overlined, #Throwlined, #Subscript, #Superscript, #Marked, #Monospace, #Text, #Image, #Notification

Notification { string user } #-

</code>

</pre><p>

<br />Здесь я пометил »#-» отсутствие зависимостей и убрал включения классов в самих себя.<br />Замечаем, что все классы встроенного форматирования (Bold, Italic, …) зависимы друг от друга и, кроме того, от класса Link, который так же зависим от них! В похожем положении находятся Unordered_list и Ordered_list. Включение заголовков друг в друга не просто приведёт к игнорированию одного из них, как ожидалось бы, но и не пройдёт валидацию препроцессором, а одностороннее включение не позволит нам объявить внутри включаемого класса функцию открытия элемента класса включающего и возвращения ссылки на оный. Как быть? Есть два способа.</p>

<h2>Включение классов друг в друга</h2><p>

<br />Сначала посмотрим на классы Bold, Italic и так до Monospace. Они похожи. Настолько, что могут быть объединены в один класс «Inline». Возможно, такое решение вызовет сомнения. У меня тоже вызывало, но на практике различие между ними влияло лишь на форму представления в виде дерева в терминале и на теги в HTML. Если вы видите, что некоторые классы содержат одинаковые поля, имеют одинаковые зависимости и вообще схожее описание в формальной грамматике, смело объединяйте их. Так вы облегчите работу себе и процессору.</p>

<p>Но такой трюк не пройдёт с классом Link, ведь он содержит дополнительное поле — строку URL. Воспользуемся вторым способом.</p>

<p>Все знают, что хорошим тоном в программировании на C++ является разделение классов на объявление и определение? В заголовке с расширением .h или .hpp — объявление, в исходнике с расширением .cpp — определение, так? А теперь обращаюсь к новичкам в программировании: сядьте и пристегните ремни безопасности, потому что будет неприятно. Ведь то, что мы прописываем в файле с расширением .h — не что иное, как <strong>определение</strong> класса. А в файле .cpp — уже <strong>реализация методов</strong> этого класса. Не понятно? В школе нас обманывали. Класс объявляется так же, как функция, одной строкой, если не содержит шаблонов.</p>

<p>Даже проще функции, ведь у него нет аргументов. Вот типичное <em>объявление</em> класса: </p>

<pre>

<code class="cpp">class MyClass;</code>

</pre><p>

<br />И всё! А объявления полей и методов — уже его <em>определение</em>.</p>

<p>Этим мы и воспользуемся. Включим заголовок класса Inline в заголовок класса Link, а в нём самом объявим класс Link перед <em>определением</em> класса Inline. Выглядеть файл inline.h должен так: </p>

<pre>

<code class="cpp">

#ifndef INLINE_H

#define INLINE_H

#include "AST/span.h"

#include "AST/text.h"

#include "AST/image.h"

#include "AST/notification.h"

class Link;

class Inline : public Span {

public:

static const unsigned long MAX_CHILDREN_COUNT = 0xFFFFFF;

private:

Span ** children;

unsigned long children_count;

unsigned long extended;

void extend();

public:

Inline(const Node * parent, const Node_type &type);

Inline(const Span * span);

~Inline();

Inline * add_text(const string &text);

Inline * add_image(const string &src, const string &alt);

Inline * add_notification(const string &user);

Link * open_link(const string &URL);

...

</code>

</pre><p>

<br />Класс Inline ещё ничего не знает о классе Link, о его полях и методах, но точно знает о его существовании. Поэтому мы можем объявлять методы, возвращающие указатель на объект класса Link, либо принимающие его в качестве аргумента. Слово <em>указатель</em> выделено не случайно, класс Inline ещё не умеет строить объекты типа Link, так как не имеет доступа к его конструктору, зато может работать со всеми указателями, т.к. у них у всех одинаковый интерфейс. Но нам здесь объекты и не нужны. А вот в реализации метода open_link создаётся объект типа Link и возвращается указатель на него, а значит, к моменту вхождения препроцессора в этот метод конструктор и остальные методы Link, которые могут понадобиться методу open_link, должны быть объявлены. Здесь воспользуемся преимуществом разделения исходного кода на отдельные файлы с заголовками и реализацией. В файл inline.cpp включён («подинклюден») файл inline.h, но файл link.h не включён в inline.h. Значит, включение его в inline.cpp будет первым включением для препроцессора. Тогда файл inline.cpp будет начинаться так: </p>

<pre>

<code class="cpp">

#include "inline.h"

#include "link.h"

...

</code>

</pre><p>

<br />Повторю всё вышесказанное. Заголовок класса A.h включаем в заголовок класса B.h как обычно, а класс B объявляем перед классом A и включаем его заголовок в исходник A.cpp. Данный способ не единственный, но самый простой, по моему мнению.</p>

<p>Замечу, что такое взаимное включение классов не мешает наследовать класс B от класса A, если именно его <em>объявление</em> мы записали перед <em>определением</em> класса A. Именно так я и сделал, унаследовав Ordered_list от Unordered_list.</p>

<h2>Построение дерева</h2><p>

<br />Итак, мы добрались до построения абстрактного синтаксического дерева. В прошлой статье функция уместилась в 50 строк. Спойлер: на этот раз она выросла почти до 1400. Принцип работы тот же: проверяем тип каждого токена и в зависимости от него выполняем определённый участок кода, храня в памяти открытый узел дерева. Вот только если для разбора HTML почти все участки содержали одну и только одну из трёх команд: добавить пустой узел внутрь открытого, открыть новый узел в открытом и закрыть открытый узел, вернув его родителя, то здесь нужное действие ещё зависит от типа открытого узла. Например, если на обработку поступил токен «горизонтальная линия», а открытый узел — корень документа, то всё, что нужно, — добавить в этот открытый узел с помощью кастования и функции с условным названием add_line () линию, примерно так: </p>

<pre>

<code class="cpp">

if (type == Node::ROOT)

static_case<Root*>(open_node)->add_line();

</code>

</pre><p>

<br />Но если открытый узел — абзац (Paragraph), то сначала нужно закрыть его и всех возможных предков (маркированные и нумерованные списки), пока открытый узел не станет иметь тип «раздел», а затем закрыть и его: </p>

<pre>

<code class="cpp">

else if (type == Node::PARAGRAPH) {

open_node = static_cast<Paragraph*>(open_node)->close();

while (open_node->get_type() != Node::SECTION) {

if (open_node->get_type() == Node::UNORDERED_LIST)

open_node = static_cast<Unordered_list*>(open_node)->close();

else if (open_node->get_type() == Node::UNORDERED_LIST)

open_node = static_cast<Unordered_list*>(open_node)->close();

else if (open_node->get_type() == Node::PARAGRAPH)

open_node = static_cast<Paragraph*>(open_node)->close();

}

open_node = static_cast<Section*>(open_node)->close();

open_node = tree->add_line();

}

</code>

</pre><p>

<br />Если открытый узел — подпись к изображению, то горизонтальная линия вообще нарушает грамматику, и необходимо выбросить исключение, а если открытый узел — не ссылка, а входящий токен »>» имеет тип «LINK_FINISH», его следует обработать не как конец ссылки, а как текст и т.д.</p>

<p>Таким образом, дерево switch/case, проверяющее тип входящего токена, должно содержать ещё одно дерево switch/case, проверяющее тип открытого узла. Вначале за такую конструкцию сложно взяться, но не обязательно начинать с начала, с первого условия. Можно создать типовый документ, размеченный вашим языком / содержащий сценарий на вашем языке и реализовывать условия по ходу документа, проверяя результат выводом псевдографического дерева в терминал. Я в качестве такого документа взял предыдущую статью, самый первый поступивший токен — начало заголовка. Значит, обрабатываем токен с типом TITLE_START. Следом идут текст заголовка и закрывающая квадратная скобка, обрабатываем токены типов TEXT и SPAN_OR_IMAGE_FINISH.</p>

<p>После этого у нас уже получится такое мини-деревце: </p>

<pre>

<code class="plaintext"><article>

|

+-<section>

|

+-<h1>

|

+-"Искусство парсинга или DOM своими руками"

</code>

</pre><p>

<br />По ходу дела вы заметите, что некоторые классы включают в себя одинаковые методы с одинаковыми алгоритмами. Например, классы абзаца Paragraph и цитаты Quote одинаково открывают ссылки и добавляют в себя текст. В таких случаях лучшим решением будет при рефакторинге создать один класс с данными методами и унаследовать от него нужные ноды. Я попытался такое реализовать, но моих навыков не хватило, и я запутался в неоднозначности при кастовании, поэтому просто привожу результаты работы лексера и парсера: </p>

<div><strong>Сама статья</strong>

<div>

<pre>

<code class="plaintext">@2che

>>442964

#[Искусство парсинга или DOM своими руками]

Привет, Хабр! Недавно я задался идеей создать простой язык разметки наподобие markdown, который отлично подходил бы для моих задач, а именно — быстрого написания лекций с форматированием и возможностью вставки математических формул «на лету», с применением одной лишь клавиатуры. Чтобы перевести текст, написанный в таком формате, в более понятную форму, например, документ LibreOffice Writer, нужен %[синтаксический анализатор], проще говоря — %[парсер]. Поскольку я привык делать велосипеды, то направился в поисковые системы с запросами «parser example», «html to DOM», «how to parse html» и др. К моему разочарованию, на всех найденных ресурсах либо приводились элементарные примеры типа калькулятора Страуструпа с рекурсивным спуском, либо использовались готовые решения, такие как flex, bison, llvm и yacc. Библиотек, предназначенных для парсинга строго определённых языков, нашлось ещё больше (gumbo, jsoup, rapidjson, инструменты Qt и др.) Ни то, ни другое не входило в мои планы по написанию парсера своей разметки на C++ с использованием лишь стандартной библиотеки, поэтому моим источником знаний об искусстве парсинга вместо электронных ресурсов стали методички технических институтов. О том, как взять текст и построить из него AST (абстрактное синтаксическое дерево), о некоторых подводных камнях, на которые я натыкался в процессе, о возможных ошибках я сегодня и расскажу.

Сразу оговорюсь, — если ваша цель — свой скриптовый язык или что ещё сложнее, этой статьи будет недостаточно для его реализации. В идеале нужно на отлично знать теорию автоматов и дискретные структуры. Но в качестве отправной точки можно пока ограничиться и моим опытом, которым я щедро поделюсь под катом. Это не совсем то, что я задумывал изначально, зато идеально подходит для примера. Парсить мы будем HTML, как простой и всем знакомый язык.

Прежде всего, парсинг, или %[синтаксический разбор] — не синоним полного процесса превращения текста в объектную модель. Сам процесс состоит из двух этапов:

1. *[Лексический разбор] текста на токены — небольшие куски этого текста, имеющие определённое синтаксическое значение.

2. *[Синтаксический разбор] — построение из токенов на основе их значений %[абстрактного синтаксического дерева] (AST — abstract syntax tree), или %[объектной модели документа] (DOM — document object model).

Но давайте по порядку. Перед тем, как открывать свою любимую IDE и писать код, нужно разработать грамматику будущего языка. Из формальных контекстно-свободных грамматик самые известные — %[форма Бэкуса-Наура (БНФ)] и %[расширенная форма Бэкуса-Наура]. Я использовал их симбиоз, взяв лучшее от обеих форм. Любое выражение можно определить через другие выражения так:

> `[<сумма> = <выражение_1> <знак_плюс> <выражение_2>]

Здесь одно выражение определено через три других, следующих одно за другим. Их, в свою очередь, тоже необходимо представить через «третьи» выражения и т.д.

Когда же остановиться?

Описание синтаксиса любого языка в формальных грамматиках состоит из двух типов лексем: %[терминалов] и %[нетерминалов]. *[Нетерминалы] — выражения, требующие определения:

> `[<выражение_1> = <число> (<знак_умножения> | <знак_деления>) <число>]

*[Терминалы] самодостаточны, их не нужно определять. Выше приведённые примеры можно записать так:

> `[<сумма> = <выражение_1> "+" <выражение_2>

<выражение_1> = <число> ("*" | "/") <число>]

где "+", "*", "/" — терминалы.

Выделить из грамматики терминалы нужно сразу, можно даже выписать их в отдельный список внизу основных определений, — они пригодятся позже.

Полное описание БНФ доступно в Википедии <<https://ru.wikipedia.org/wiki/%D0%A4%D0%BE%D1%80%D0%BC%D0%B0_%D0%91%D1%8D%D0%BA%D1%83%D1%81%D0%B0_%E2%80%94_%D0%9D%D0%B0%D1%83%D1%80%D0%B0>здесь> и <<https://ru.wikipedia.org/wiki/%D0%A0%D0%B0%D1%81%D1%88%D0%B8%D1%80%D0%B5%D0%BD%D0%BD%D0%B0%D1%8F_%D1%84%D0%BE%D1%80%D0%BC%D0%B0_%D0%91%D1%8D%D0%BA%D1%83%D1%81%D0%B0_%E2%80%94_%D0%9D%D0%B0%D1%83%D1%80%D0%B0>здесь>. Составление грамматики языка — важная стадия создания языка, не терпящая легкомыслия. Одна ошибка в ней может привести к полностью нерабочему коду, который придётся переписывать с нуля. Поэтому, прежде чем делать следующий шаг, убедитесь, что в составленной грамматике не осталось спорных моментов. Если у вас два монитора, будет удобно на всё оставшееся время работы занять документом с грамматикой один монитор, чтобы иметь возможность быстро перемещаться глазами на него, когда будете кодить. Поверьте, так придётся делать постоянно. Вот составленная мной грамматика HTML5 в форме БНФ:

> `[stub]

Когда грамматика готова, можно приступать к лексическому анализатору (другое название лексического разборщика, т.к. помимо разбора, он выявляет в документе лексические ошибки). На первый взгляд всё просто: поглощать символы, записывать в буфер и при обнаружении ключевого терминала определять полученную лексему как токен с определённым типом, так? Да, только тип токена здесь имеет большее значение, чем символ. Сейчас поясню. Само собой, процедура disassemble(ifsteam &file) должна содержать цикл, читающий по одному символу из входного потока и отправляющий его в процедуру process(const char &c), где этот символ обрабатывается. Кажется, что процедуре process нужно содержать switch, где на каждый ключевой символ определены свои функции в зависимости от текущего типа токена. На самом деле всё наоборот: лучше с помощью switch проверять именно тип токена, а функции определять для символов. Более того, текущий токен чаще всего имеет неопределённый тип, один из многих. Например, после открытия угловой скобки может идти: открывающий, закрывающий, пустой теги, а также комментарий в стиле HTML или макро тег (сценарий PHP, заключённый в "<?… ?>". И для всех таких объединений нужен свой case. Как такое реализовать? С помощью битовых флагов. Пусть задано конечное число типов токена (чем больше — тем лучше, так как задача лексического анализатора — оставить как можно меньше работы синтаксическому). Для каждого типа задано уникальное число степени двойки (1, 2, 4, 8 и т.д). Тогда в двоичном формате они будут выглядеть так: 0001, 0010, 0100 и т.д., и при побитовом сложении любого числа любых типов получится уникальное число. Если текстовое описание сложно для понимания, приведу код. Вот определение типов:

> `[enum Token_type {

END = 1, TEXT = 2,

OPENING_BLOCK_TAG_NAME = 4, CLOSING_BLOCK_TAG_NAME = 8, EMPTY_TAG_NAME = 16, COMMENT = 32, MACRO_TAG = 64,

ATTRIBUTE_NAME = 128, UNQUOTED_ATTRIBUTE_VALUE = 256, SINGLE_QUOTED_ATTRIBUTE_VALUE = 512, DOUBLE_QUOTED_ATTRIBUTE_VALUE = 1024

};]

Урезанная процедура process:

> `[stub]

Проверяем с помощью switch тип ожидаемого токена (или токенов), а внутри каждого case определяем процедуры для каждого из ключевых терминалов. Функций не так много, все выполняют простые действия: либо добавление символа к буферу, либо слив буфера в очередной токен, либо смену ожидаемого типа токена (токенов), либо выброс исключения. Определить нужную процедуру легко по написанной выше грамматике при помощи текстового редактора с возможностью поиска. Просто ищем все включения ожидаемого токена (токенов) в определения других выражений, затем включения этих выражений в «третьи» и т.д. Вот пример для открывающего тега в текстовом редакторе gedit:

[<https://hsto.org/webt/72/fw/tw/72fwtwt_waeie4ulzftkxua356w.png>]

Вначале ориентироваться в грамматике сложно, но со временем и опытом она становится не сложнее деления столбиком. А вот и процедура disassemble:

> `[stub]

Первому ожидаемому токену очевидно необходимо задать тип TEXT, а в конце добавить токен типа END с любым текстом (или пустой, как здесь).

Для примера я взял один из своих шаблонов HTML-документа с комментарием, добавил к нему псевдо-скрипт PHP, обработал лексером и вывел список токенов в формате "[ "<текст_токена>": <тип_токена> ]". Вот что получилось:

> =[Сам документ`[stub]]

=[Список токенов`[stub]]

Теперь мы готовы приступить ко второй части — построению синтаксического дерева. Поскольку наши теги имеют аттрибуты, то узлы дерева кроме связи с другими узлами будут содержать массивы пар ключ-значение. Получившаяся конструкция сможет полноправно называться объектной моделью документа DOM, упомянутой в заголовке статьи.

Сколько нужно классов для реализации всех свойств HTML-элементов?

В идеале — по одному классу для каждого элемента, чтобы можно было определять для них каскадные таблицы стилей, но мы ограничимся тремя — пустым тегом «Node», унаследованным от него блоком «Block» (контент, заключённый между двумя парными тегами) и унаследованным от него корнем дерева «Root». Также определим в парсере массив тегов, которые могут содержать текст, такие, как <p>, <li>, <strong> и др, чтобы отсеять токены с неразмеченным текстом. Теперь дело за малым. Если вы хорошо проработали лексический анализатор, то задача синтаксического — просто поглощать токены и выполнять в открытом узле одну из трёх операций: добавить в него пустой узел, открыть новый или закрыть самого, вернув указатель на родителя. Для последней потребуется, чтобы все классы, начиная с базового Node, содержали такой указатель, получаемый при создании элемента. Этот процесс называется %[нисходящим синтаксическим разбором].

Процедура парсинга:

> `[stub]

Вот и всё! Если вы всё сделали правильно, полученное дерево можно вывести на экран:

`[|

+--<ROOT>

|

+--<!DOCTYPE>

|

+--<html>

|

+--<head>

| |

| +--<meta>

| |

| +--<meta>

| |

| +--<meta>

| |

| +--<meta>

| |

| +--<meta>

| |

| +--<meta>

| |

| +--<meta>

| |

| +--<meta>

| |

| +--<meta>

| |

| +--<title>

| |

| +--<link>

| |

| +--<link>

| |

| +--<COMMENT>

|

+--<body>

|

+--<header>

| |

| +--<div>

|

+--<nav>

| |

| +--<ul>

| |

| +--<li>

| | |

| | +--<a>

| |

| +--<li>

| | |

| | +--<a>

| |

| +--<li>

| |

| +--<a>

|

+--<main>

| |

| +--<MACRO>

|

+--<footer>

|

+--<hr>

|

+--<small>]

Однако, хотя полученное дерево действительно можно назвать DOM, до полноценных jQuery, Jsoup, beautifulsoup или Gumbo нашему парсеру далеко, в частности потому, что он не может правильно обрабатывать текст, расположенный между парными тегами <style> и <script>, а потому исходников пока не привожу. Но обязательно добавлю, если хабровчане изъявят такое желание. Успехов.

P.S. Залил в публичный доступ <<https://gitlab.com/2che/nyHTML>исходники>. Имхо, сыроватые, поэтому буду обстругивать до полноценной библиотеки.

</code>

</pre></div>

</div><p>

<br /></p>

<div><strong>Токены от лексера</strong>

<div>

<pre>

0: [ "2che" : NOTIFICATION ]

1: [ "

" : NEWLINE ]

2: [ "442964" : CITE ]

3: [ "#[" : TITLE_START ]

4: [ "Искусство парсинга или DOM своими руками" : TEXT ]

5: [ "]" : SPAN_OR_IMAGE_FINISH ]

6: [ "

" : DOUBLE_NEWLINE ]

7: [ "Привет, Хабр! Недавно я задался идеей создать простой язык разметки наподобие markdown, который отлично подходил бы для моих задач, а именно — быстрого написания лекций с форматированием и возможностью вставки математических формул «на лету», с применением одной лишь клавиатуры. Чтобы перевести текст, написанный в таком формате, в более понятную форму, например, документ LibreOffice Writer, нужен " : TEXT ]

8: [ "%[" : ITALIC_START ]

9: [ "синтаксический анализатор" : TEXT ]

10: [ "]" : SPAN_OR_IMAGE_FINISH ]

11: [ ", проще говоря — " : TEXT ]

12: [ "%[" : ITALIC_START ]

13: [ "парсер" : TEXT ]

14: [ "]" : SPAN_OR_IMAGE_FINISH ]

15: [ ". Поскольку я привык делать велосипеды, то направился в поисковые системы с запросами «parser example», «html to DOM», «how to parse html» и др. К моему разочарованию, на всех найденных ресурсах либо приводились элементарные примеры типа калькулятора Страуструпа с рекурсивным спуском, либо использовались готовые решения, такие как flex, bison, llvm и yacc. Библиотек, предназначенных для парсинга строго определённых языков, нашлось ещё больше (gumbo, jsoup, rapidjson, инструменты Qt и др.) Ни то, ни другое не входило в мои планы по написанию парсера своей разметки на C++ с использованием лишь стандартной библиотеки, поэтому моим источником знаний об искусстве парсинга вместо электронных ресурсов стали методички технических институтов. О том, как взять текст и построить из него AST (абстрактное синтаксическое дерево), о некоторых подводных камнях, на которые я натыкался в процессе, о возможных ошибках я сегодня и расскажу." : TEXT ]

16: [ "

" : DOUBLE_NEWLINE ]

17: [ "Сразу оговорюсь, — если ваша цель — свой скриптовый язык или что ещё сложнее, этой статьи будет недостаточно для его реализации. В идеале нужно на отлично знать теорию автоматов и дискретные структуры. Но в качестве отправной точки можно пока ограничиться и моим опытом, которым я щедро поделюсь под катом. Это не совсем то, что я задумывал изначально, зато идеально подходит для примера. Парсить мы будем HTML, как простой и всем знакомый язык." : TEXT ]

18: [ "

" : DOUBLE_NEWLINE ]

19: [ "Прежде всего, парсинг, или " : TEXT ]

20: [ "%[" : ITALIC_START ]

21: [ "синтаксический разбор" : TEXT ]

22: [ "]" : SPAN_OR_IMAGE_FINISH ]

23: [ " — не синоним полного процесса превращения текста в объектную модель. Сам процесс состоит из двух этапов:" : TEXT ]

24: [ "

" : NEWLINE ]

25: [ "1. " : ORDERED_LIST_ITEM_MARKER ]

26: [ "*[" : BOLD_START ]

27: [ "Лексический разбор" : TEXT ]

28: [ "]" : SPAN_OR_IMAGE_FINISH ]

29: [ " текста на токены — небольшие куски этого текста, имеющие определённое синтаксическое значение." : TEXT ]

30: [ "

" : NEWLINE ]

31: [ "2. " : ORDERED_LIST_ITEM_MARKER ]

32: [ "*[" : BOLD_START ]

33: [ "Синтаксический разбор" : TEXT ]

34: [ "]" : SPAN_OR_IMAGE_FINISH ]

35: [ " — построение из токенов на основе их значений " : TEXT ]

36: [ "%[" : ITALIC_START ]

37: [ "абстрактного синтаксического дерева" : TEXT ]

38: [ "]" : SPAN_OR_IMAGE_FINISH ]

39: [ " (AST — abstract syntax tree), или " : TEXT ]

40: [ "%[" : ITALIC_START ]

41: [ "объектной модели документа" : TEXT ]

42: [ "]" : SPAN_OR_IMAGE_FINISH ]

43: [ " (DOM — document object model)." : TEXT ]

44: [ "

" : DOUBLE_NEWLINE ]

45: [ "Но давайте по порядку. Перед тем, как открывать свою любимую IDE и писать код, нужно разработать грамматику будущего языка. Из формальных контекстно-свободных грамматик самые известные — " : TEXT ]

46: [ "%[" : ITALIC_START ]

47: [ "форма Бэкуса-Наура (БНФ)" : TEXT ]

48: [ "]" : SPAN_OR_IMAGE_FINISH ]

49: [ " и " : TEXT ]

50: [ "%[" : ITALIC_START ]

51: [ "расширенная форма Бэкуса-Наура" : TEXT ]

52: [ "]" : SPAN_OR_IMAGE_FINISH ]

53: [ ". Я использовал их симбиоз, взяв лучшее от обеих форм. Любое выражение можно определить через другие выражения так:" : TEXT ]

54: [ "

" : NEWLINE ]

55: [ "> " : QUOTE_START ]

56: [ "`[" : MONOSPACE_START ]

57: [ "<сумма" : TEXT ]

58: [ ">" : LINK_FINISH ]

59: [ " = <выражение_1" : TEXT ]

60: [ ">" : LINK_FINISH ]

61: [ " <знак_плюс" : TEXT ]

62: [ ">" : LINK_FINISH ]

63: [ " <выражение_2" : TEXT ]

64: [ ">" : LINK_FINISH ]

65: [ "]" : SPAN_OR_IMAGE_FINISH ]

66: [ "

" : DOUBLE_NEWLINE ]

67: [ "Здесь одно выражение определено через три других, следующих одно за другим. Их, в свою очередь, тоже необходимо представить через «третьи» выражения и т.д." : TEXT ]

68: [ "

" : DOUBLE_NEWLINE ]

69: [ "Когда же остановиться?" : TEXT ]

70: [ "

" : DOUBLE_NEWLINE ]

71: [ "Описание синтаксиса любого языка в формальных грамматиках состоит из двух типов лексем: " : TEXT ]

72: [ "%[" : ITALIC_START ]

73: [ "терминалов" : TEXT ]

74: [ "]" : SPAN_OR_IMAGE_FINISH ]

75: [ " и " : TEXT ]

76: [ "%[" : ITALIC_START ]

77: [ "нетерминалов" : TEXT ]

78: [ "]" : SPAN_OR_IMAGE_FINISH ]

79: [ ". " : TEXT ]

80: [ "*[" : BOLD_START ]

81: [ "Нетерминалы" : TEXT ]

82: [ "]" : SPAN_OR_IMAGE_FINISH ]

83: [ " — выражения, требующие определения:" : TEXT ]

84: [ "

" : NEWLINE ]

85: [ "> " : QUOTE_START ]

86: [ "`[" : MONOSPACE_START ]

87: [ "<выражение_1" : TEXT ]

88: [ ">" : LINK_FINISH ]

89: [ " = <число" : TEXT ]

90: [ ">" : LINK_FINISH ]

91: [ " (<знак_умножения" : TEXT ]

92: [ ">" : LINK_FINISH ]

93: [ " | <знак_деления" : TEXT ]

94: [ ">" : LINK_FINISH ]

95: [ ") <число" : TEXT ]

96: [ ">" : LINK_FINISH ]

97: [ "]" : SPAN_OR_IMAGE_FINISH ]

98: [ "

" : DOUBLE_NEWLINE ]

99: [ "*[" : BOLD_START ]

100: [ "Терминалы" : TEXT ]

101: [ "]" : SPAN_OR_IMAGE_FINISH ]

102: [ " самодостаточны, их не нужно определять. Выше приведённые примеры можно записать так:" : TEXT ]

103: [ "

" : NEWLINE ]

104: [ "> " : QUOTE_START ]

105: [ "`[" : MONOSPACE_START ]

106: [ "<сумма" : TEXT ]

107: [ ">" : LINK_FINISH ]

108: [ " = <выражение_1" : TEXT ]

109: [ ">" : LINK_FINISH ]

110: [ " "+" <выражение_2" : TEXT ]

111: [ ">" : LINK_FINISH ]

112: [ "

" : NEWLINE ]

113: [ "<выражение_1" : TEXT ]

114: [ ">" : LINK_FINISH ]

115: [ " = <число" : TEXT ]

116: [ ">" : LINK_FINISH ]

117: [ " ("*" | "/") <число" : TEXT ]

118: [ ">" : LINK_FINISH ]

119: [ "]" : SPAN_OR_IMAGE_FINISH ]

120: [ "

" : DOUBLE_NEWLINE ]

121: [ "где "+", "*", "/" — терминалы." : TEXT ]

122: [ "

" : NEWLINE ]

123: [ "Выделить из грамматики терминалы нужно сразу, можно даже выписать их в отдельный список внизу основных определений, — они пригодятся позже." : TEXT ]

124: [ "

" : DOUBLE_NEWLINE ]

125: [ "Полное описание БНФ доступно в Википедии " : TEXT ]

126: [ "<<" : LINK_START ]

127: [ "https://ru.wikipedia.org/wiki/%D0%A4%D0%BE%D1%80%D0%BC%D0%B0_%D0%91%D1%8D%D0%BA%D1%83%D1%81%D0%B0_%E2%80%94_%D0%9D%D0%B0%D1%83%D1%80%D0%B0" : TEXT ]

128: [ ">" : LINK_FINISH ]

129: [ "здесь" : TEXT ]

130: [ ">" : LINK_FINISH ]

131: [ " и " : TEXT ]

132: [ "<<" : LINK_START ]

133: [ "https://ru.wikipedia.org/wiki/%D0%A0%D0%B0%D1%81%D1%88%D0%B8%D1%80%D0%B5%D0%BD%D0%BD%D0%B0%D1%8F_%D1%84%D0%BE%D1%80%D0%BC%D0%B0_%D0%91%D1%8D%D0%BA%D1%83%D1%81%D0%B0_%E2%80%94_%D0%9D%D0%B0%D1%83%D1%80%D0%B0" : TEXT ]

134: [ ">" : LINK_FINISH ]

135: [ "здесь" : TEXT ]

136: [ ">" : LINK_FINISH ]

137: [ ". Составление грамматики языка — важная стадия создания языка, не терпящая легкомыслия. Одна ошибка в ней может привести к полностью нерабочему коду, который придётся переписывать с нуля. Поэтому, прежде чем делать следующий шаг, убедитесь, что в составленной грамматике не осталось спорных моментов. Если у вас два монитора, будет удобно на всё оставшееся время работы занять документом с грамматикой один монитор, чтобы иметь возможность быстро перемещаться глазами на него, когда будете кодить. Поверьте, так придётся делать постоянно. Вот составленная мной грамматика HTML5 в форме БНФ:" : TEXT ]

138: [ "

" : NEWLINE ]

139: [ "> " : QUOTE_START ]

140: [ "`[" : MONOSPACE_START ]

141: [ "stub" : TEXT ]

142: [ "]" : SPAN_OR_IMAGE_FINISH ]

143: [ "

" : DOUBLE_NEWLINE ]

144: [ "Когда грамматика готова, можно приступать к лексическому анализатору (другое название лексического разборщика, т.к. помимо разбора, он выявляет в документе лексические ошибки). На первый взгляд всё просто: поглощать символы, записывать в буфер и при обнаружении ключевого терминала определять полученную лексему как токен с определённым типом, так? Да, только тип токена здесь имеет большее значение, чем символ. Сейчас поясню. Само собой, процедура disassemble(ifsteam &file) должна содержать цикл, читающий по одному символу из входного потока и отправляющий его в процедуру process(const char &c), где этот символ обрабатывается. Кажется, что процедуре process нужно содержать switch, где на каждый ключевой символ определены свои функции в зависимости от текущего типа токена. На самом деле всё наоборот: лучше с помощью switch проверять именно тип токена, а функции определять для символов. Более того, текущий токен чаще всего имеет неопределённый тип, один из многих. Например, после открытия угловой скобки может и

<p class="copyrights"><span class="source">© <a target="_blank" rel="nofollow" href="https://habr.com/ru/post/444876/?utm_campaign=444876">Habrahabr.ru</a></span></p>

</div>

<br>

<!--<div align="left">

<script type="text/topadvert">

load_event: page_load

feed_id: 12105

pattern_id: 8187

tech_model:

</script><script type="text/javascript" charset="utf-8" defer="defer" async="async" src="//loader.topadvert.ru/load.js"></script>

</div>

<br>-->

<div style="padding-left: 20px;">

<!-- PCNews 336x280 -->

</div>

<!-- comments -->

</div>

<br class="clearer"/>

</div>

<br class="clearer"/>

<div id="footer-2nd"></div>

<div id="footer">

<br/><br/>

<ul class="horz-menu">

<li class="about"><a href="/info/about.html" title="О проекте">О

проекте</a></li>

<li class="additional-menu"><a href="/archive.html" title="Архив материалов">Архив</a>

</li>

<li class="additional-menu"><a href="/info/reklama.html"

title="Реклама" class="menu-item"><strong>Реклама</strong></a>

<a href="/info/partners.html" title="Партнёры"

class="menu-item">Партнёры</a>

<a href="/info/legal.html" title="Правовая информация"

class="menu-item">Правовая информация</a>

<a href="/info/contacts.html" title="Контакты"

class="menu-item">Контакты</a>

<a href="/feedback.html" title="Обратная связь" class="menu-item">Обратная

связь</a></li>

<li class="email"><a href="mailto:pcnews@pcnews.ru" title="Пишите нам на pcnews@pcnews.ru"><img

src="/media/i/email.gif" alt="e-mail"/></a></li>

<li style="visibility: hidden">

<noindex>

<!-- Rating@Mail.ru counter -->

<script type="text/javascript">

var _tmr = window._tmr || (window._tmr = []);

_tmr.push({id: "93125", type: "pageView", start: (new Date()).getTime()});

(function (d, w, id) {

if (d.getElementById(id)) return;

var ts = d.createElement("script");

ts.type = "text/javascript";

ts.async = true;

ts.id = id;

ts.src = (d.location.protocol == "https:" ? "https:" : "http:") + "//top-fwz1.mail.ru/js/code.js";

var f = function () {

var s = d.getElementsByTagName("script")[0];

s.parentNode.insertBefore(ts, s);

};

if (w.opera == "[object Opera]") {

d.addEventListener("DOMContentLoaded", f, false);

} else {

f();

}

})(document, window, "topmailru-code");

</script>

<noscript>

<div style="position:absolute;left:-10000px;">

<img src="//top-fwz1.mail.ru/counter?id=93125;js=na" style="border:0;" height="1"

width="1" alt="Рейтинг@Mail.ru"/>

</div>

</noscript>

<!-- //Rating@Mail.ru counter -->

</noindex>

</li>

</ul>

</div>

<!--[if lte IE 7]>

<iframe id="popup-iframe" frameborder="0" scrolling="no"></iframe>

<![endif]-->

<!--<div id="robot-image"><img class="rbimg" src="i/robot-img.png" alt="" width="182" height="305" /></div>-->

<!--[if IE 6]>

<script>DD_belatedPNG.fix('#robot-image, .rbimg');</script><![endif]-->

</div>

<!--[if lte IE 7]>

<iframe id="ie-popup-iframe" frameborder="0" scrolling="no"></iframe>

<![endif]-->

<div id="footer-adlinks"></div>

<noindex>

<!--LiveInternet counter--><script type="text/javascript">

document.write("<a rel='nofollow' href='//www.liveinternet.ru/click' "+

"target=_blank><img src='//counter.yadro.ru/hit?t45.6;r"+

escape(document.referrer)+((typeof(screen)=="undefined")?"":

";s"+screen.width+"*"+screen.height+"*"+(screen.colorDepth?

screen.colorDepth:screen.pixelDepth))+";u"+escape(document.URL)+

";"+Math.random()+

"' alt='' title='LiveInternet' "+

"border='0' width='1' height='1'><\/a>")

</script><!--/LiveInternet-->

<!-- Rating@Mail.ru counter -->

<script type="text/javascript">

var _tmr = window._tmr || (window._tmr = []);

_tmr.push({id: "93125", type: "pageView", start: (new Date()).getTime()});

(function (d, w, id) {

if (d.getElementById(id)) return;

var ts = d.createElement("script"); ts.type = "text/javascript"; ts.async = true; ts.id = id;

ts.src = "https://top-fwz1.mail.ru/js/code.js";

var f = function () {var s = d.getElementsByTagName("script")[0]; s.parentNode.insertBefore(ts, s);};

if (w.opera == "[object Opera]") { d.addEventListener("DOMContentLoaded", f, false); } else { f(); }

})(document, window, "topmailru-code");

</script><noscript><div>

<img src="https://top-fwz1.mail.ru/counter?id=93125;js=na" style="border:0;position:absolute;left:-9999px;" alt="Top.Mail.Ru" />

</div></noscript>

<!-- //Rating@Mail.ru counter -->

<!-- Yandex.Metrika counter -->

<script type="text/javascript">

(function (d, w, c) {

(w[c] = w[c] || []).push(function () {

try {

w.yaCounter23235610 = new Ya.Metrika({

id: 23235610,

clickmap: true,

trackLinks: true,

accurateTrackBounce: true,

webvisor: true,

trackHash: true

});

} catch (e) {

}

});

var n = d.getElementsByTagName("script")[0],

s = d.createElement("script"),

f = function () {

n.parentNode.insertBefore(s, n);

};

s.type = "text/javascript";

s.async = true;

s.src = "https://mc.yandex.ru/metrika/watch.js";

if (w.opera == "[object Opera]") {

d.addEventListener("DOMContentLoaded", f, false);

} else {

f();

}

})(document, window, "yandex_metrika_callbacks");

</script>

<noscript>

<div><img src="https://mc.yandex.ru/watch/23235610" style="position:absolute; left:-9999px;" alt=""/>

</div>

</noscript>

<!-- /Yandex.Metrika counter -->

<!-- Default Statcounter code for PCNews.ru https://pcnews.ru-->

<script type="text/javascript">

var sc_project=9446204;

var sc_invisible=1;

var sc_security="14d6509a";

</script>

<script type="text/javascript"

src="https://www.statcounter.com/counter/counter.js"

async></script>

<!-- End of Statcounter Code -->

<script>

(function (i, s, o, g, r, a, m) {

i['GoogleAnalyticsObject'] = r;

i[r] = i[r] || function () {

(i[r].q = i[r].q || []).push(arguments)

}, i[r].l = 1 * new Date();

a = s.createElement(o),

m = s.getElementsByTagName(o)[0];

a.async = 1;

a.src = g;

m.parentNode.insertBefore(a, m)

})(window, document, 'script', '//www.google-analytics.com/analytics.js', 'ga');

ga('create', 'UA-46280051-1', 'pcnews.ru');

ga('send', 'pageview');

</script>

<script async="async" src="/assets/uptolike.js?pid=49295"></script>

</noindex>

<!--<div id="AdwolfBanner40x200_842695" ></div>-->

<!--AdWolf Asynchronous Code Start -->

<script type="text/javascript" src="https://pcnews.ru/js/blockAdblock.js"></script>

<script type="text/javascript" src="/assets/jquery.min.js"></script>

<script type="text/javascript" src="/assets/a70a9c7f/jquery/jquery.json.js"></script>

<script type="text/javascript" src="/assets/a70a9c7f/jquery/jquery.form.js"></script>

<script type="text/javascript" src="/assets/a70a9c7f/jquery/jquery.easing.1.2.js"></script>

<script type="text/javascript" src="/assets/a70a9c7f/jquery/effects.core.js"></script>

<script type="text/javascript" src="/assets/a70a9c7f/js/browser-sniff.js"></script>

<script type="text/javascript" src="/assets/a70a9c7f/js/scripts.js"></script>

<script type="text/javascript" src="/assets/a70a9c7f/js/pcnews-utils.js"></script>

<script type="text/javascript" src="/assets/a70a9c7f/js/pcnews-auth.js"></script>

<script type="text/javascript" src="/assets/a70a9c7f/js/pcnews-fiximg.js"></script>

<script type="text/javascript" src="/assets/a70a9c7f/js/pcnews-infobox.js"></script>

</body>

</html>