ИИ соцсети Facebook принял людей на видео за приматов, компании пришлось извиниться

По информации New York Times, система искусственного интеллекта соцсети Facebook приняла за приматов людей на видеоролике в публикации издания Daily Mail. Через некоторое время после того, как многочисленные пользователи заметили этот факт и распространили скриншоты с роликом и уведомлением от ИИ на других платформах, администрация Facebook принесла извинения за ошибку в работе системы и отключила ее для всех пользователей на время расследования.

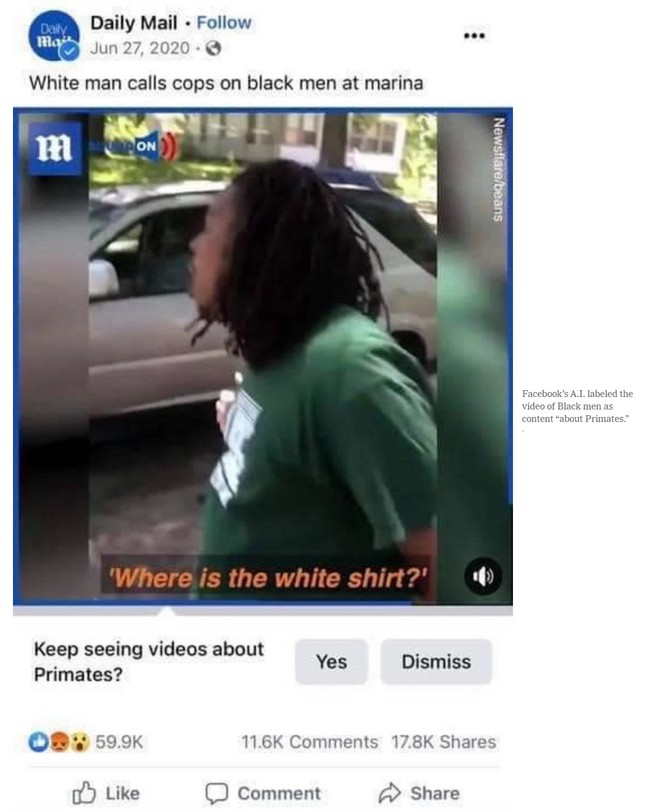

27 августа в публикации британской газеты Daily Mail в социальной сети Facebook появилось видео, содержащее отрывки двух отдельных инцидентов, произошедших ранее в США. На нем было показано, как чернокожий мужчина спорил с другим человеком и с полицейскими перед задержанием.

ИИ соцсети выдал к ролику автоматическое текстовое уведомление, на котором пользователям предлагалось «продолжить смотреть еще видео о приматах». На это обратила внимание Дарси Гроувс, бывший менеджер по контентному дизайну Facebook. Именно она запросила своих бывших коллег оперативно принять меры и удалить некорректные выражения из публикации.

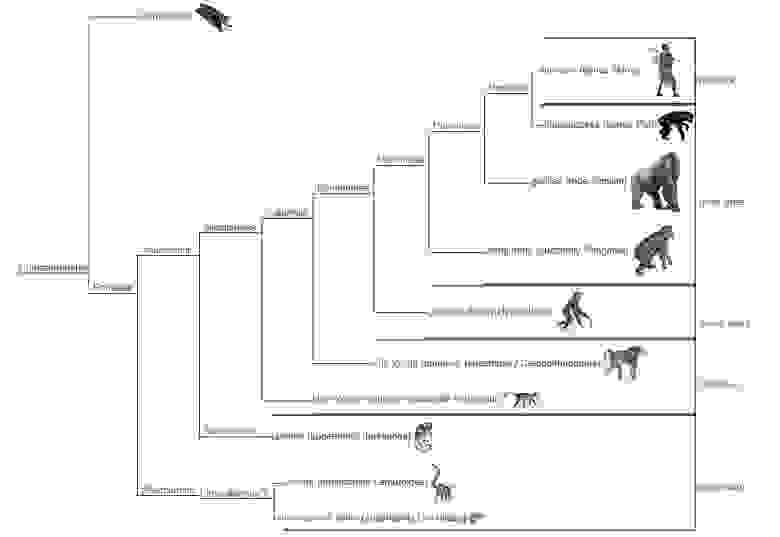

Некоторые пользователи Twitter пояснили, что технически ИИ не ошибся, так как люди относятся к отряду приматов. Другие предположили, что система не фиксировала цвет кожи, а оценивала поведение человека, так что это мог быть и белый.

Представитель Facebook заявил, что ИИ соцсети не идеален и постоянно дорабатывается. В компании пояснили, что не хотели никого обидеть «неприемлемыми» автоматическими рекомендациями. Разработчики системы назвали это «недопустимой ошибкой» и пообещали предпринять меры по исправлению работы алгоритма анализа видео и выдаче уведомлений, чтобы «предотвратить повторение этого снова».

В конце прошлого года Twitter пообещал изменить работу функции автоматической обрезки изображений после того, как пользователи пожаловались на ее предвзятость. По их сообщениям, при попытке обрезать снимки алгоритм выделял людей с более светлой кожей вне зависимости от того, где располагался фокус исходного изображения.

В мае 2021 года Twitter признал свой алгоритм обрезки изображений расистским. В компании считают, что людям стоит кадрировать изображения для предварительного просмотра самостоятельно.