Графические войны #2: красно-зеленая эпоха

Часть 2

Часть 1

2000–2006. Падение 3Dfx. Начало двухстороннего противостояния

2000 год — Эпоха слияний и поглощений в индустрии.

Начало нового тысячелетия ознаменовало большие перемены на рынке видеокарт. Многие компании профессионального сегмента готовились покидать отрасль — после ухода ixMicro свои последние продукты представили NEC (TE5) и Hewlett-Packard (VISUALIZE FX10). А Evans & Sutherland продала своё графическое подразделение RealVision, переключившись на создание купольных систем для планетариев.

На мейнстрим-рынке в феврале 2000 года ATi приобрела ArtX Inc за $400 млн в акциях. Компания разрабатывала новый графический чип для будущей Nintendo GameCube (известный как Project Dolphin, а позже — Flipper). Такая покупка позволила ATi значительно расширить своё портфолио, заявив о себе на новом рынке.

3Dfx, сократив штат на 20%, приобрела компанию Gigapixel за $186 млн, получив в свое распоряжение проприетарную технологию мозаичного рендеринга, тогда как S3 и NVidia завершили судебные разбирательства заключением нового партнерского соглашения на ближайшие семь лет.

Наиболее важным новым игроком на рынке в тот период стала VIA — компания, купившая в недавнем прошлом Number Nine и многострадальную S3. Реструктурировав бизнес, VIA объединила S3 с AIB-производителем Diamond Multimedia — сумма сделки составила $165 млн в эквиваленте ценных бумаг. Независимым осталось лишь профессиональное подразделение DM FireGL — выйдя из состава компании и реорганизовавшись как SONICBlue, компания в итоге стала частью ATi в марте 2001 за скромные $10 млн. Активной была и 3DLabs, выкупившая Intense3D у Intergraph в апреле 2000 года. В результате рынок увидел первую серьезную консолидацию, прямо намекнувшую на возможное будущее рынка в лице противостояния нескольких ключевых игроков. И 3Dfx стремительно приближалась к числу тех, кто уже стал частью минувшей эпохи.

3Dfx — Последние попытки и уход в закат

Череда неудач на графическом рынке, импульсивное руководство и непонимание критической важности создания новой архитектуры привели 3Dfx к печальному итогу — несмотря на неплохие продажи, компания несла убытки уже несколько лет, и отчаянно нуждалась в продукте, способном перевернуть рынок также, как это сделала оригинальная Voodoo. Долгожданная Voodoo 5500, вышедшая в июле 2000 года, показала себя неплохо, выступая на уровне с GeForce 256 DDR и вырываясь вперед при игре в высоких разрешениях, но революции не произошло.

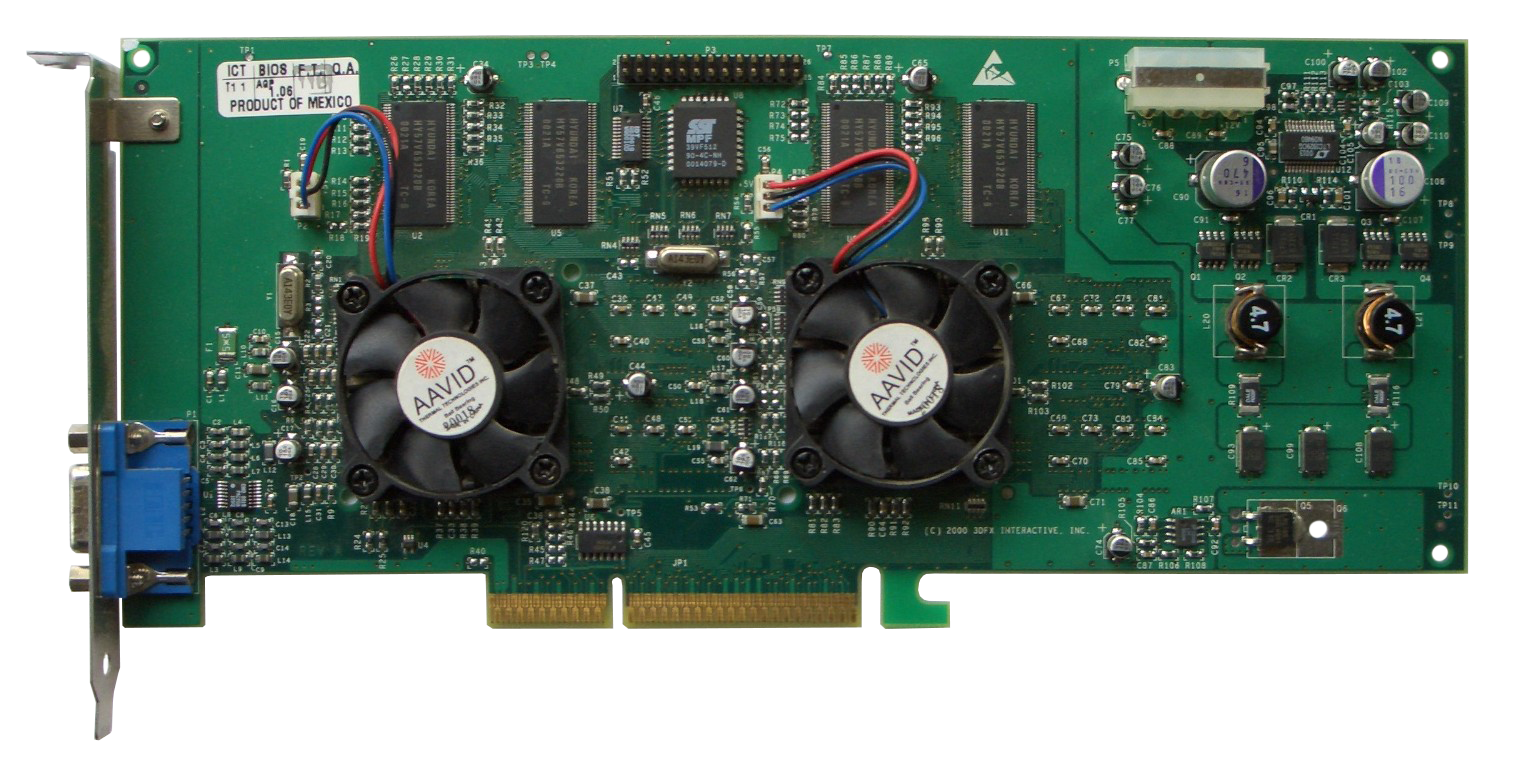

3Dfx Voodoo 5 5500

3Dfx Voodoo 5 5500Архитектурные преимущества, обеспечившие успех Voodoo, во многом крылись в высокой «сырой» производительности — вычислительной мощности, способной перекрыть многие возможные недостатки. С Voodoo 5500 на смену этих особенностей пришли другие, менее очевидные преимущества — например, полноэкранное сглаживание. 3Dfx использовала технологию Т-буфера вместо уже классической трансформации и освещения (T&L), объединяя несколько промежуточных фреймов в единый кадр. Такая технология обеспечивала мягкий эффект размытия и лучшую плавность анимации на высоких кадровых частотах.

Именно эта технология легла в основу множества графических особенностей, получивших повсеместное использование. Мягкие тени, motion blur, глубина поля, отражения — всё это было построено на базе того, что в последний год создавала 3Dfx, значительно опередив своё время.

Последним релизом легендарной компании стала Voodoo 4500, вышедшая на рынок в октябре 2000 года.

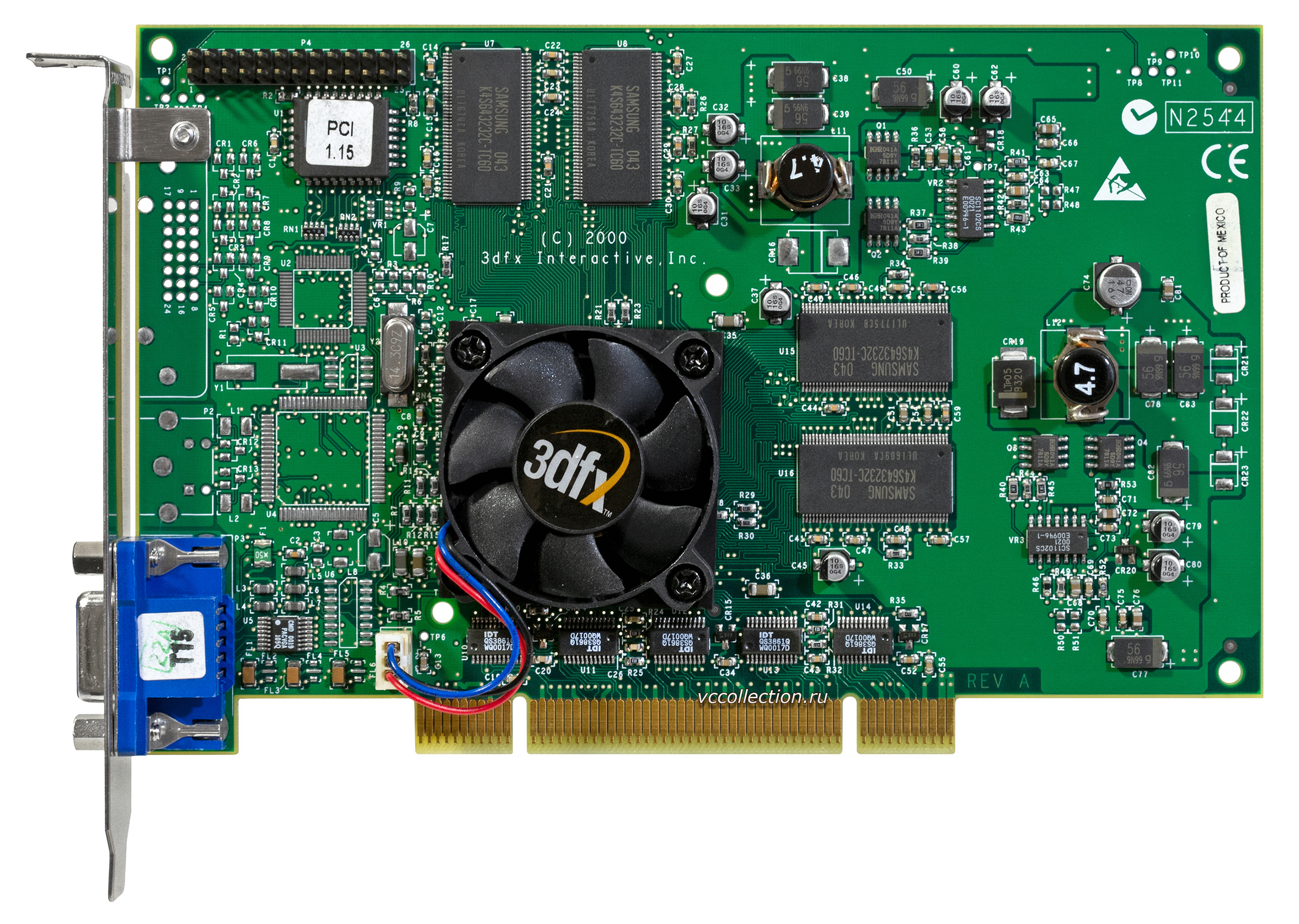

3Dfx Voodoo4 4500

3Dfx Voodoo4 4500Из-за задержек (карта ожидалась еще летом в качестве конкурента для NVidia TNT 2) новинке от 3Dfx пришлось конкурировать уже с могучей GeForce 256 DDR, а также будущими GeForce 2 GTS и ATi Radeon DDR. Из-за финансовых трудностей другие линейки 3Dfx (Voodoo 4200 и 4800) так и не увидели свет, сохранившись лишь в виде прототипов.

14 ноября 2000 года 3Dfx объявила о прекращении выпуска своих брендовых видеокарт.

Последним гвоздем в крышку гроба стали новости о том, что отсутствие обратного сигнала по линии 3.3V на новейшей платформе Pentium IV сделает невозможной работу адаптеров Voodoo на новом поколении систем Intel.

Паническая покупка SGI и отчаянное желание наладить производство чипов собственными силами привели 3Dfx к банкротству, в результате которого NVidia приобрела всё портфолио конкурента за смехотворные $70 млн, а также миллиона долларов в формате своих акций. Все проприетарные разработки и технологии 3Dfx стали частью портфолио NVidia, и в будущем повсеместно применялись в видеокартах новых поколений. Легенда гласит, что озлобленные инженеры 3Dfx после перехода в NVidia решили отомстить компании, и выпустили печально известные FX 5700 и FX 5800 — худшие видеокарты в истории компании Дженсена Хуанга. Впрочем, это могла быть просто старая байка.

Начало эпохи ATi vs NVidia

Когда многие геймеры все еще ожидали выхода Voodoo 5, ATi анонсировала Radeon DDR — «самый мощный видеочип, который когда-либо выпускался для ПК-рынка».

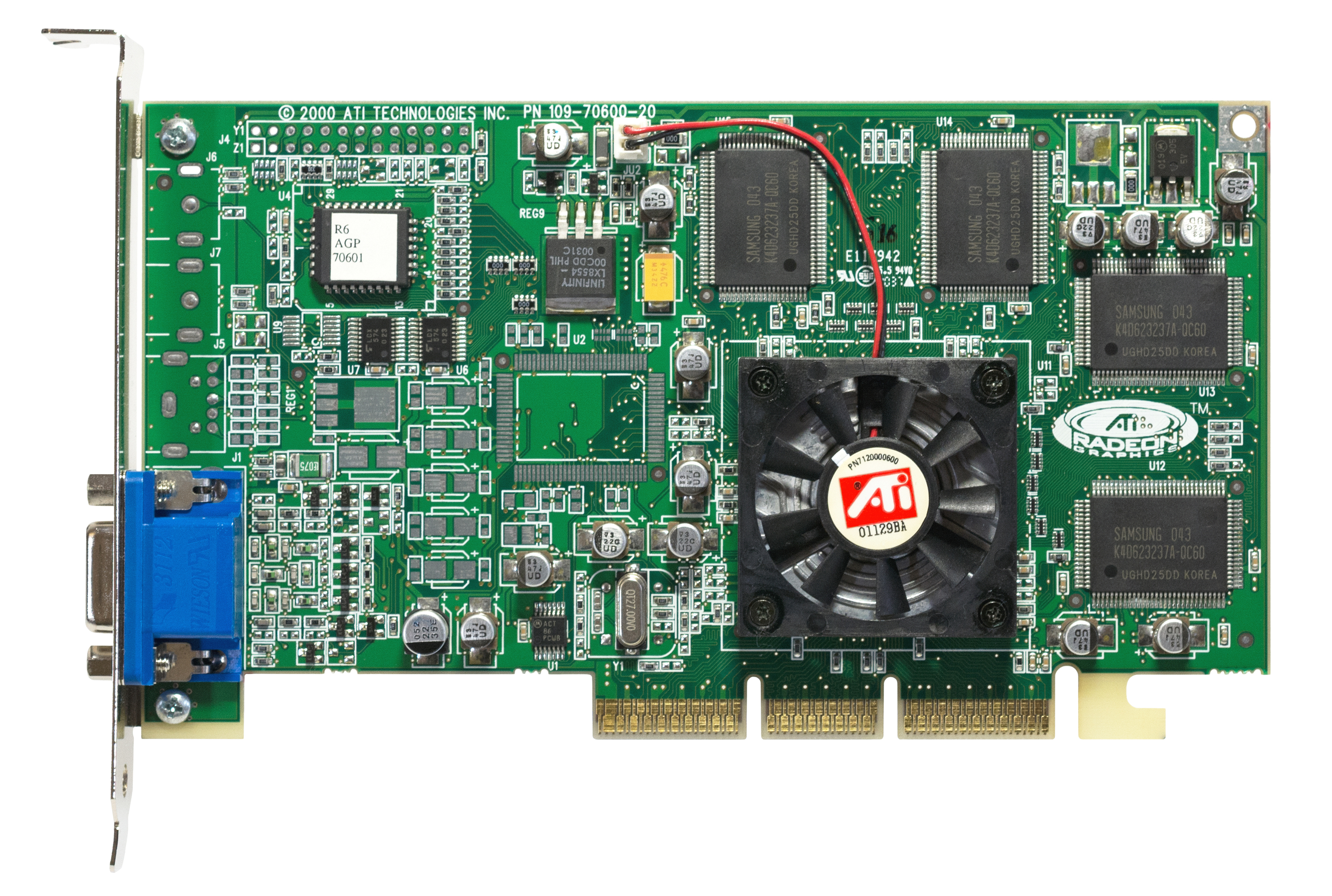

ATi Radeon 7200 DDR

ATi Radeon 7200 DDRПредварительные обзоры видеокарты уже появились в прессе 25 апреля, но менее чем через сутки после анонса свой ответ на «самый передовой чип» дала NVidia, анонсировав GeForce 2 GTS (GigaTexel Shader). Новинка включала собственную версию архитектуры Pixel Tapestry в виде NVidia Shading Rasterizer, включающей множество аппаратных технологий, таких как зеркальное выделение, объемные взрывы, рефракцию, симуляцию волн, вертексное смешение, объемные тени, бамп-маппинг и elevation-маппинг, применяемый к каждому пикселю на экране с помощью аппаратных инструкций.

NVidia GeForce 2 GTS

NVidia GeForce 2 GTSОбширный список новшеств NVidia задумывала реализовать еще в GeForce 256, но из-за аппаратных проблем они были отключены на этапе производства. Вместе с вышесказанным, NVidia реализовала собственную версию Charisma Engine от ATi, — движка для выполнения цикла операций трансформации, освещения и отсечения ресурсами GPU. Тем не менее, в этом отношении ATi пошла дальше c технологией vertex skinning, позволяющей обеспечить более плавное движение полигонов, а также интерполяции ключевого кадра, в котором разработчики могли задать начальную и конечную точку формирования полигональной сетки, доверяя Charisma Engine достраивать комбинацию из промежуточных шагов.

ATI Radeon DDR вышла на рынок в августе 2000 года. Видеокарта обеспечивала невероятную производительность T&L-алгоритмов, а также поддерживала некоторые возможности новейшего API DirectX 8.0, наряду с GeForce 2 GTS начав эру DVI, интегрировав контроллер непосредственно в видеочип. Тем не менее, DVI еще не был так популярен среди простых геймеров, и поэтому карты с новейшим разъемом чаще уходили на ОЕМ-рынок, тогда как в ретейле куда чаще попадались платы с коннекторами VIVO.

У Radeon DDR были и недостатки — частоты чипа и памяти оказались ниже ожидаемых, а в 16-битном цвете возникали артефакты на экране. Драйвера на старте продаж были далеки от оптимальных, но даже они не помешали Radeon DDR выйти в лидеры в разрешениях выше 1024–768 при 32-битном цвете. Карта с 64 Мб на борту продавалась за $399, и отлично конкурировала с GeForce 2 GTS по схожей цене — отрыв в производительности в среднем составлял 15% в пользу ATi, что позволило канадской компании выйти в лидеры, завоевав бОльшую долю мейнстрим-рынка.

Однако это не значит, что дела у NVidia шли плохо — компания показывала стабильный рост, и расширяла своё присутствие в различных сегментах рынка. В июне была выпущена упрощенная версия видеокарты GeForce 2 с припиской MX, а в августе свет увидела заряженная Ultra-версия, вернувшая NVidia первое место по производительности в играх — правда, и стоила такая карта уже $499.

NVidia GeForce 2 Ultra

NVidia GeForce 2 UltraMX-версия чипа получила и профессиональный вариант в виде Quadro 2, а GeForce2 Go удовлетворила спрос на передовую графику в мобильном сегменте рынка.

PowerVR KYRO и KYRO II — Конкуренция в кавычках

В ноябре 2000 года, когда 3Dfx уже готовилась к процедуре банкротства, компания Imagination Tech (бывшая VideoLogic) совместно с STMicro решила попытать счастья на объемном рынке бюджетных видеокарт с PowerVR KYRO.

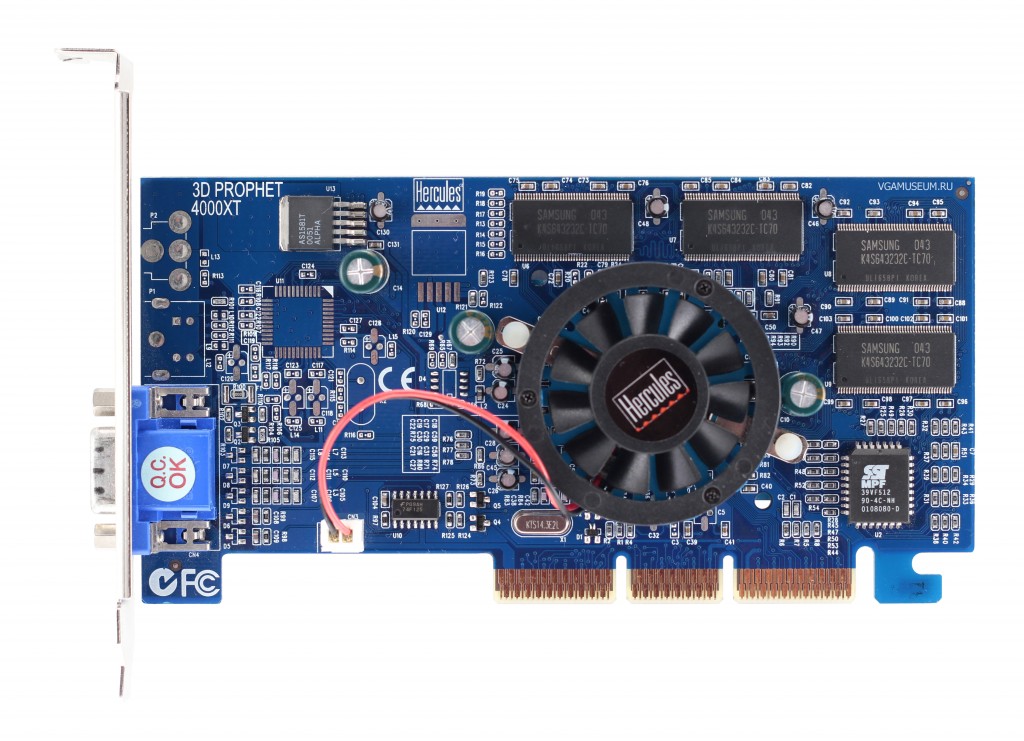

PowerVR KYRO

PowerVR KYROНовинка стоила в промежутке от $80 до $110, и предлагала неплохую производительность в играх при разрешении 1024×768 (32 бита) и ниже. К сожалению, победному шествию адаптера по рынку помешала NVidia, выпустившая GeForce 2 MX за те же самые $110.

Но Imagination Tech не сдалась, и выпустила KYRO II в апреле 2001 года. Передовой 180-нм техпроцесс STMicro вкупе с подросшими частотами ядра и памяти мог был обеспечить безоговорочную победу, но NVidia ответила снижением цены MX на 40% (переименовав карту в MX200), а на её прежнее место по той же цене вышла MX400 с серьезно «заряженными» частотами.

Карты PowerVR не имели аппаратной поддержки мозаичного рендеринга, из-за чего сильно буксовали на фоне конкурентов в новых проектах. STMicro закрыла своё графическое подразделение в 2002 году, тогда как Imagination Tech перешла в мобильный бизнес, выпуская SoC-решения на основе ARM-процессоров для смартфонов и первых планшетных компьютеров.

Такие компании, как Matrox и VIA/S3 более не горели желанием включаться в гонку за производительностью на ПК, сосредоточив усилия на ОЕМ-рынках.

NVidia GeForce 3 — нарастающее преимущество

На волне успехов GeForce 2 NVidia в феврале 2001 года анонсировала GeForce 3 по цене от $339 до $449. Главным преимуществом новинки была доселе невиданная производительность в разрешении 1600×1200 с использованием полноэкранного сглаживания.

NVidia GeForce 3

NVidia GeForce 3Как это часто бывает, первые версии драйверов не отличались стабильностью — особенно пострадали игры, использующие OpenGL. В числе программных новинок NVidia реализовала поддержку DirectX 8, мультисэмплинг, кенконксное сглаживание (которое, по сути, работало как MSAA 2х с добавлением блюра на этапе постпроцессинга), восьмикратную анизотропную фильтрацию, а также первую аппаратную возможность её совмещения с трилинейной в едином механизме рендера. Программируемые вертексные шейдеры позволили GeForce 3 лучше контролировать движение полигональных сеток и в итоге обеспечили повышение плавности анимации.

Была реализована и LMA (Lightspeed Memory Architechture) — аналог HyperZ, фильтрующий обработку пикселей, не попадающих в поле зрения (отсечение Z-окклюции), а также обеспечивающий компрессию и декомпрессию данных для оптимизации пропускной способности шины (Z- компрессия).

Последней особенностью GeForce 3 стала реализация алгоритмов балансировщика загрузки, ставших частью Crossbar Memory Controller — сложной системы из четырех независимых контроллеров памяти, внедренных для более эффективного управления буфером.

Позже портфолио NVidia пополнил тот самый чип NV2A, разработанный на основе GeForce 2 (с рядом особенностей GeForce 4) для консоли XBox. Контролируя 31% рынка видеокарт в 2001 году, NVidia стала законодателем мод, а уже следом шли Intel (26%) и ATi (17%).

Radeon 8500 — Пафос, шок, легкое разочарование

Когда линейка NVidia уже включала целое семейство продуктов на базе GeForce 3, ATi в срочном порядке организовала вывод на рынок Radeon 8500 — достойного ответа лидеру рынка, произведенного по тем же 150 нм TSMC (как и чип NV20 GeForce 3). После официального анонса геймеры со всего мира с нетерпением ждали выхода канадской новинки — тогда сам Джон Кармак уверенно заявлял, что в Doom 3 8500 окажется вдвое быстрее GeForce 3.

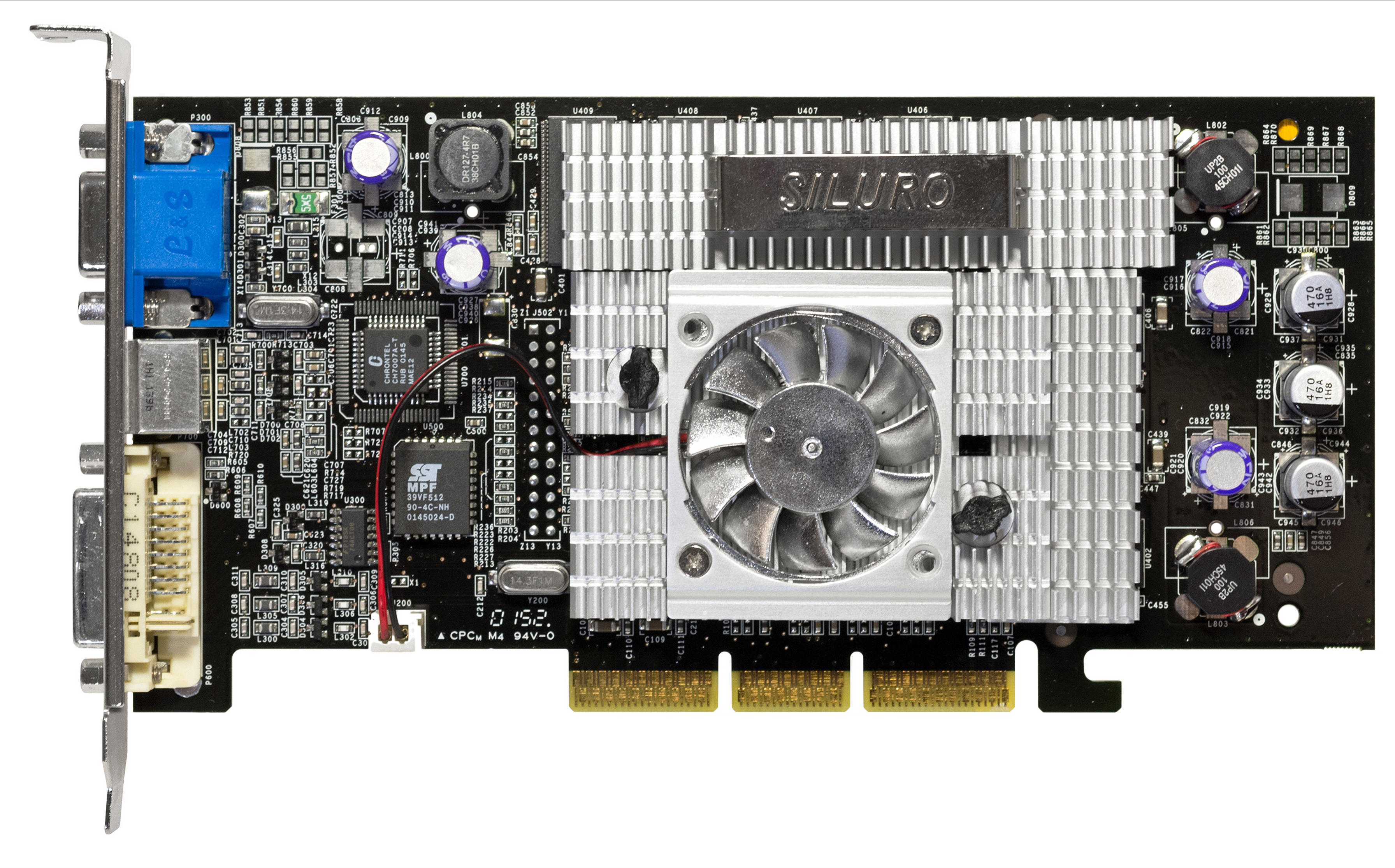

ATi Radeon 8500

ATi Radeon 8500Рекламная кампания была громкой, и во многом напоминала дерзкий маркетинг 3Dfx — «самая производительная видеокарта в мире» ворвалась на прилавки в октябре 2001, и сразу же сорвала розовые очки поклонников: производительность «самой производительной карты» оказалась на уровне GeForce 3 Ti 200 — далеко не передовой модели NVidia. Драйвера оставляли желать лучшего, а технология сглаживания Smoothvision и вовсе не работала — первая волна обзоров была разгромной, но уже к зимним каникулам большинство изданий выпустили новые материалы, признав, что проблемы с драйверами были решены, а итоговая производительность Radeon 8500 расположилась между Ti 200 и стандартной GF3.

На несмотря на то, что первые строчки бенчмарков остались за NVidia, Radeon 8500 обладала рядом бесспорных преимуществ. Более высокое качество изображения в 2D-режиме, плавное воспроизведение видео и высокая производительность со сглаживанием предлагались поклонникам по демократичной цене, составляя достойную конкуренцию одноклассникам NVidia.

Закончив год с убытками в $54 миллиона, ATi сосредоточила силы на разработке новой архитектуры и начала продавать лицензии на производство партнерских видеокарт.

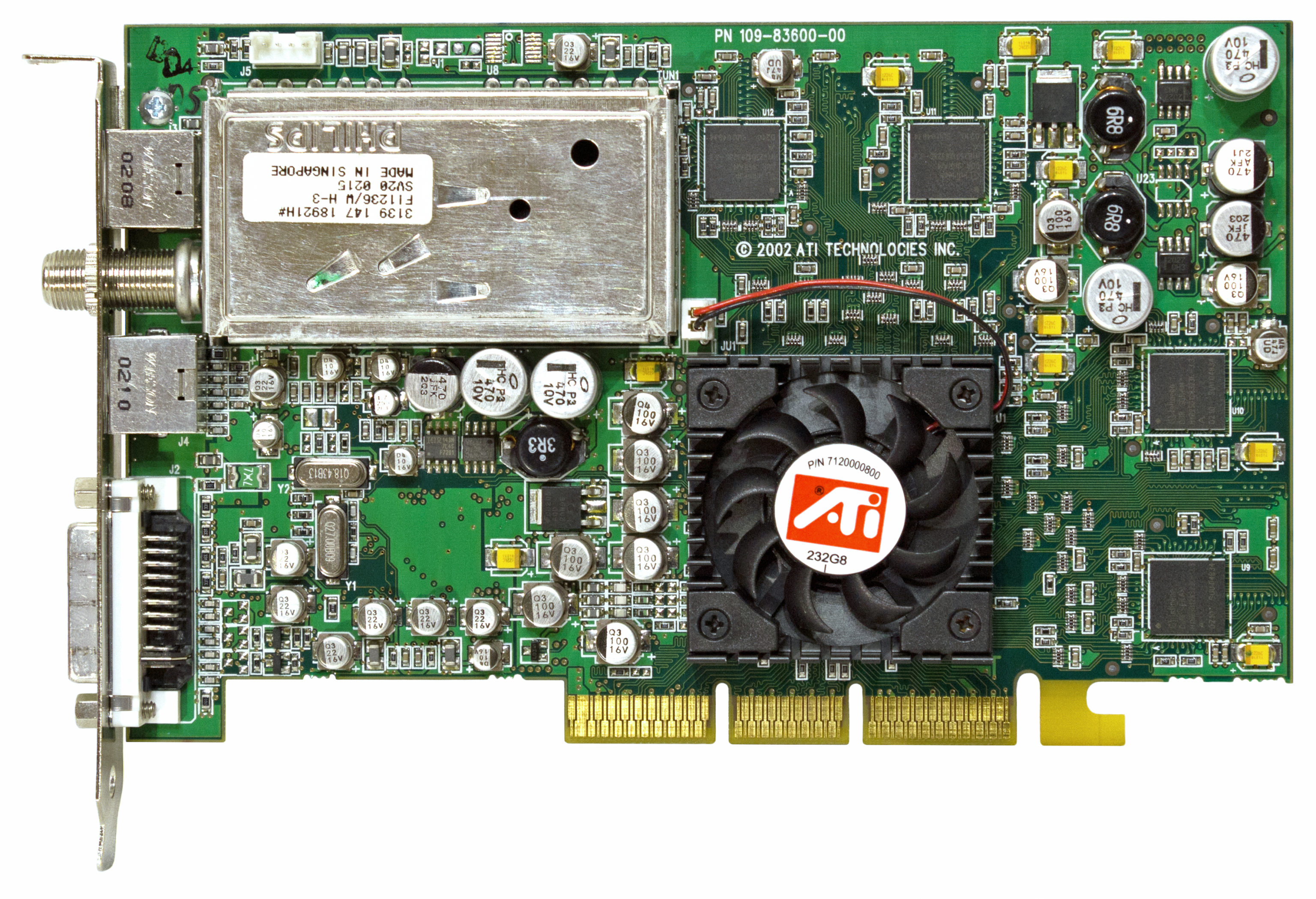

Одним из самых необычных продуктов в портфолио ATi того времени стала Set-Top-Wonder Xilleon — инженерная платформа, включающая полноформатную плату с интегрированным процессором, видео и аудио-чипами и системой ввода-вывода, снабженной нужными разъемами для использования в первых цифровых ресиверах для домашнего ТВ.

Set-Top-Wonder Xilleon

Set-Top-Wonder XilleonДля разработки платформы ATi летом 2002 года приобрела компанию NxtWave Communications за $20 млн., занимавшуюся технологиями обработки цифрового видеосигнала, а также разработкой ПО для ресиверов и спутниковых тарелок.

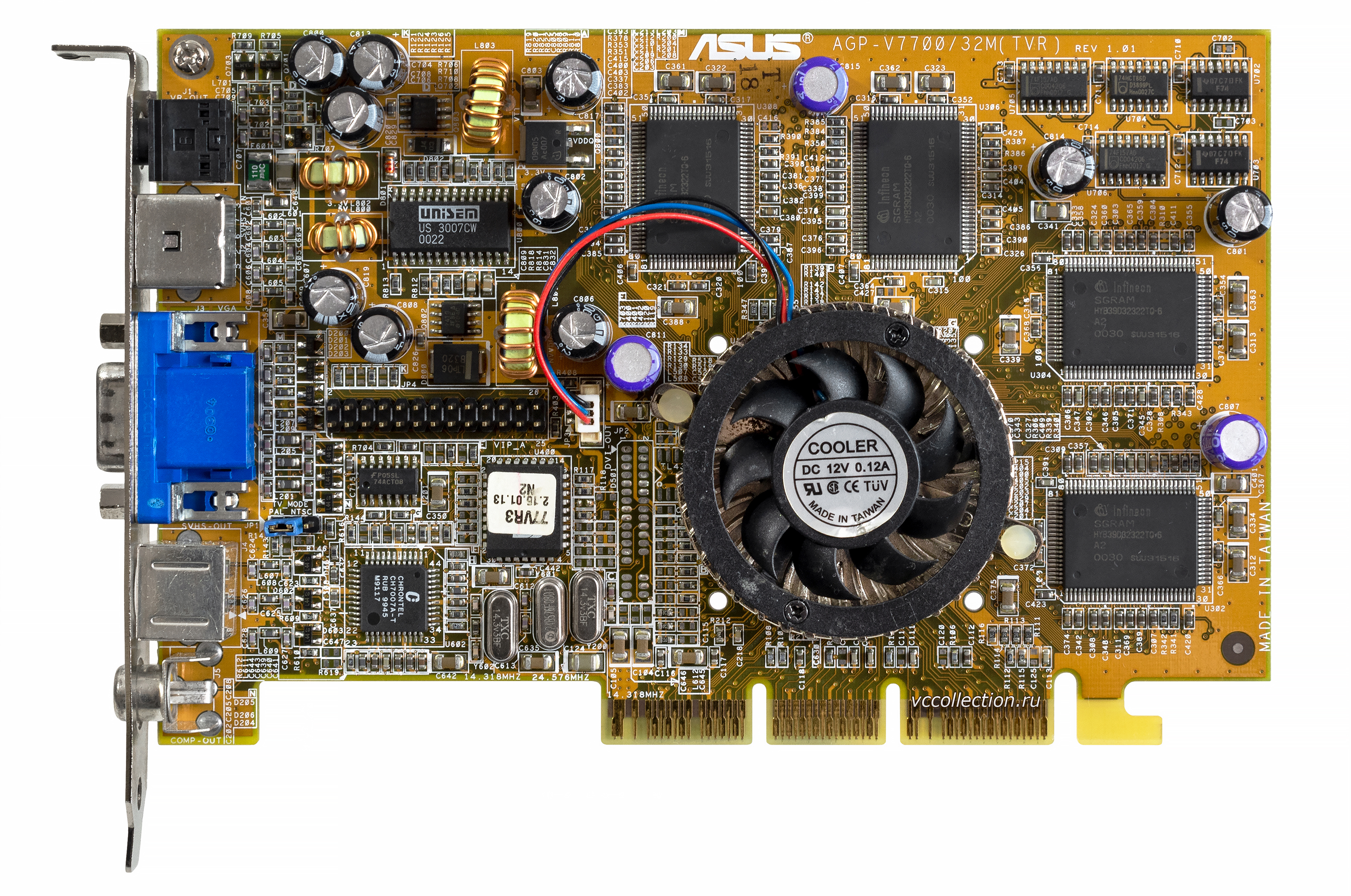

GeForce 4 — Фальшивые бюджетники и настоящие Титаны

Уже выработав определенный календарный цикл для своих релизов, NVidia представила линейку GeForce 4 в феврале 2002 года.

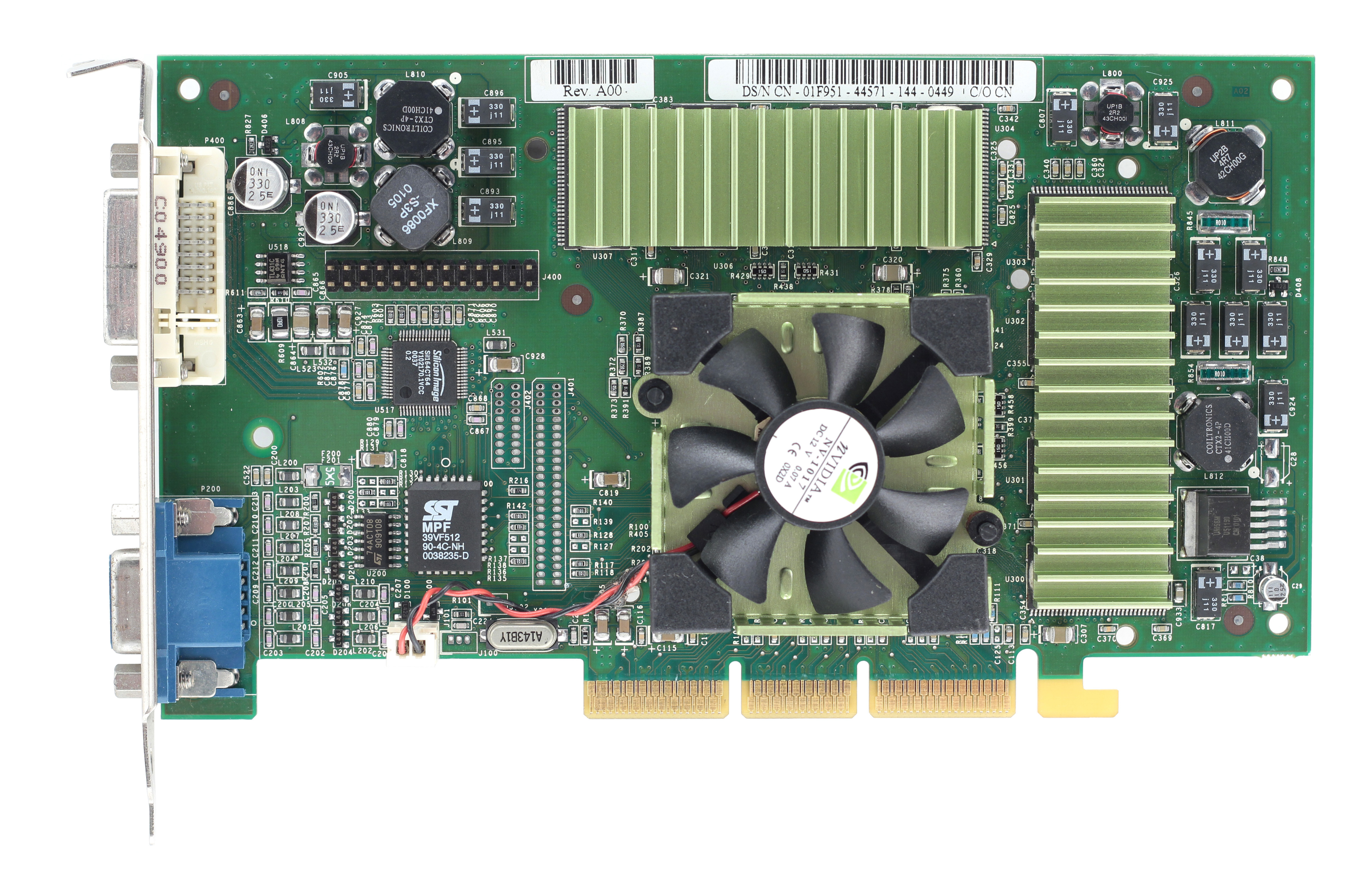

NVidia GeForce 4 Ti 4600

NVidia GeForce 4 Ti 4600Она получилась достаточно объемной, и включала три карты MX-серии, три мобильных варианта, построенных на MX-чипах, а также два премиальных адаптера серии Titanium (Ti 4400 и Ti 4600). Хотя новая серия NVidia была готова к выходу в продажу еще в ноябре, в компании не хотели подрывать рекордные продажи предыдущей линейки во время Черной Пятницы и новогодних каникул. Представьте себе лицо геймера, купившего GeForce 3 за неделю до выхода нового поколения — вместо недели Дженсен Хуанг дал целых три месяца счастья тем, кто решил хорошенько потратиться в праздники.

Именно в линейке GeForce 4 NVidia сознательно пошла на ребрендинг для сокращения затрат — под удар попал бюджетный сегмент, где видеокарты серии MX по факту не были новинками, а принадлежали всё той же линейке GeForce 2. Вместо новейших технологий счастливчики, заплатившие за новинку $179, получали поддержку DirectX 7.0/7.1 и обновленный кодек MPEG2.

Зато любители покупать самое лучшее сорвали джекпот — карты серии Titanium (или сокращено Ti) серьезно подняли планку производительности, обеспечив более чем 50% рост в сравнение с GF3 Ti 500. Ti 4600 мгновенно стала самой желанной видеокартой на рынке, возглавив всевозможные бенчмарки популярных «железных» новинок, а Ti 4400 за $199 получила лестный титул «лучшая видеокарта по соотношению цена-производительность». Radeon 8500 оказалась на обочине праздника NVidia, безнадежно отставшая по всем фронтам.

А потом ATi перестала играть в бирюльки и выдала Radeon 9700 Pro, напомнив NVidia, что такое настоящий прогресс.

Radeon 9700 Pro — Графический переворот

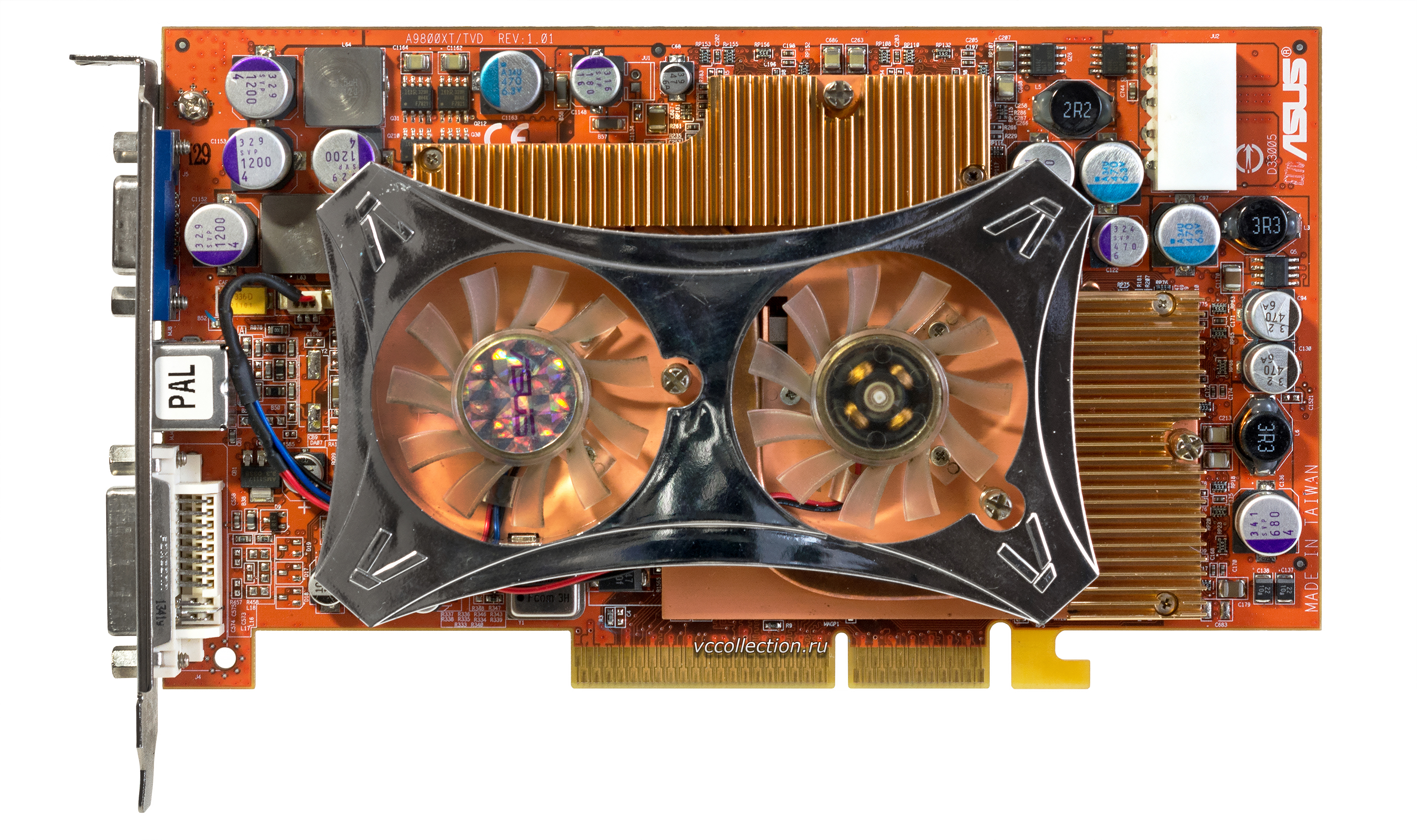

Разработанный командой, некогда составлявшей костяк ArtX, чип R300 оказался громом среди ясного неба. Он первым на рынке получил полную поддержку DirectX 9.0, первым обеспечил шейдеры версии 2.0, как пиксельные, так и вертексные. Уступая лишь картам серии S3 Xabre 80/200/400, R300 вторым на рынке перешел на восьмиканальную шину AGP и первым изготавливался по 150 нм технологии с применением производственного метода flip-chip, когда контактные площадки кристалла GPU располагаются непосредственно на нем, обеспечивая соединение с контактами платы напрямую, без использования внешних проволочных проводников.

Как и NVidia, ATi готовила целую линейку карт — в октябре свет увидела обычная версия 9700 за $299 (для тех, кто не был готов расстаться с $399), а экономные геймеры получали на выбор 9500 Pro ($199) или обычную 9500 ($179) для игр и других задач. Не забыли в ATi и о профессиональном рынке — эти нужды удовлетворяли модели FireGL Z1/X1 за $550 и $950. Последней в изначальной линейке стала All-In-Wonder 9700 Pro за $449, представленная уже в декабре.

ATi Radeon 9700 Pro

ATi Radeon 9700 ProКарты вышли прорывными, но продажи ATi всё равно пострадали — уже по вине энтузиастов, открывших возможности модификации доступных моделей в более дорогостоящие. Так референсную модель 9500 можно было превратить в 9700, а 9800 Pro волшебным образом могла стать «заряженной» 9800 XT. Такие перевоплощения становились возможным благодаря любительскому патчу драйвера видеокарты для распознавания модификации. Само же превращение осуществлялось или через работу с резистором, либо с помощью обычного карандаша, немного пошаманив с контроллером напряжений GPU и видеопамяти.

Особо увлеченные энтузиасты превращали 9800 в профессиональную FireGL X2, а бюджетную 9800 SE с помощью модификации драйвера можно было превратить во флагманскую 9800 Pro, стоившую почти вдвое больше.

Как и всегда, одной лишь графикой для ПК-рынка дело не ограничилось, и ATi представила множество решений в сегменте встроенной графики и чипсетов, как для AMD, так и для Intel. A3/IGP 320 предназначалась для платформ первых, RS200/IGP 330 & 340 — для вторых. Мобильный сегмент тоже не был оставлен в стороне — для решений AMD была выпущена U1/IGP 320M, а Intel получила чип RS200M для своих Pentium4-M. Все чипы интегрированной графики работали в связке с южными мостами производства ATi — чаще всего это были IXP200 или 250.

SiS Xabre — Когда пора на выход

В разгар противостояния GeForce 4 и R300 компания SiS выпустила на рынок линейку видеокарт Xabre. Новинки оказались нелепыми — высокие цены и отсутствие аппаратной поддержки вертексных шейдеров ставили под вопрос смысл такого релиза. Разработчикам игр ничего не оставалось, кроме включения в драйвера программной эмуляции сложного алгоритма, чтобы хотя бы как-то удерживать на плаву слабые решения от SiS.

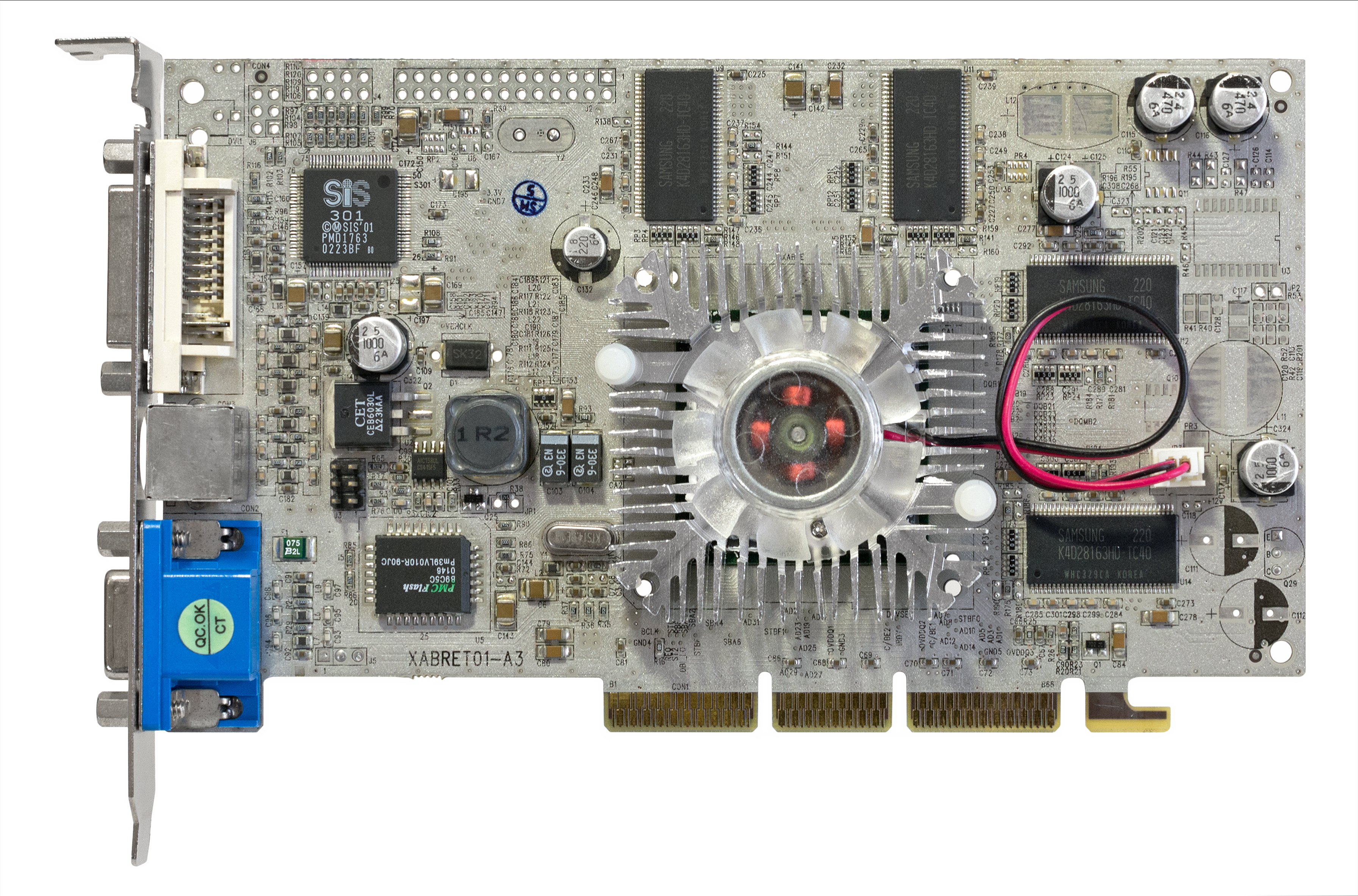

Xabre 400

Xabre 400Фирменной разработкой SiS в серии Xabre стала технология Turbo Texturing. Резко снижая качество текстур, игрок мог увеличить производительность в игре, но из-за отсутствия возможности сглаживая замыленной картинки преимущества новой технологии никто не увидел.

Нетрудно догадаться, что Xabre стала последней линейкой под брендом SiS — графической подразделение компании отделилось под брендом XGI, а сама SiS стала частью Trident Graphics в июне 2002 года.

NVidia FX — Зеленый Фуфыкс на потеху 3Dfx

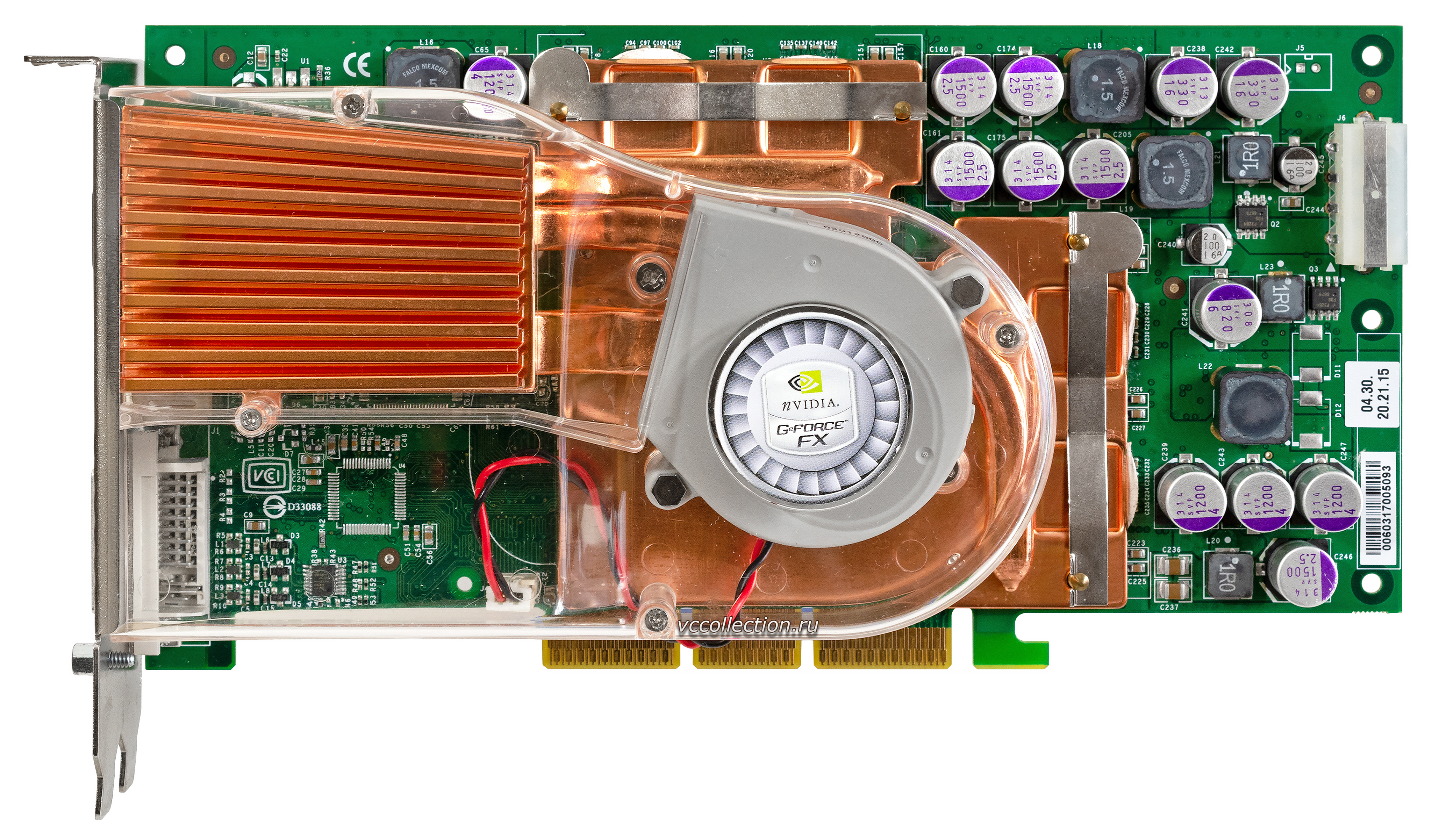

Новый виток развития графики NVidia пришелся на серию FX, представленную 27 января 2003 года с печально известной FX 5800 по прозвищу Dustbuster и её «заряженной» версии FX 5800 Ultra.

NVidia GeForce FX 5800 Ultra

NVidia GeForce FX 5800 UltraНа фоне нового чемпиона в лице Radeon 9700 Pro (и его младшего брата 9700) новинки не внушали энтузиазма — карты серии FX были очень громкими, хуже справлялись с полноэкранным сглаживанием и анизотропной фильтрацией, и уступали флагманам ATi в общем зачете. Прошлогодняя линейка канадцев настолько превосходила конкурентов, что даже обычная 9700, вышедшая за 5 месяцев до премьеры линейки FX, оказалась быстрее хвалебной Ultra (хотя стоила при этом на $100 дешевле — $299 против $399).

Новый графический чип NV30 должен был выйти в августе 2003-го и исправить положение, но высокий процент брака в кремниевых пластинах 130 нм техпроцесса non-K TSMC заставили NVidia отложить релиз, сосредоточив усилия на разработке NV2A для консоли Xbox (известному как SandStorm), а также ряде новых чипсетов для материнских плат.

Понимая, что дальнейшие задержки — непозволительная роскошь, NVidia в срочном порядке перевела производство на фабрики IBM, использовав 130 нм техпроцесс на основе флюросиликатного стекла.

Через 3.5 месяца после премьеры разочарования в лице FX5800, NVidia представила работу над ошибками — карты FX 5900 и FX5900 Ultra на базе доработанного чипа NV35.

NVidia GeForce FX 5900 Ultra

NVidia GeForce FX 5900 UltraНовый набор драйверов Detonator FX (сразу чувствуется пафос 3Dfx!) значительно улучшил работу со сглаживанием и анизотропной фильтрацией, почти догнав ATi в этом отношении, но что куда важнее, 5900 удалось сместить 9800 Pro с пьедестала самой производительной видеокарты — правда, по цене в $499. Злить канадцев подобной провокацией было ошибкой.

Radeon 9800 XT — Твоё место под номером 2

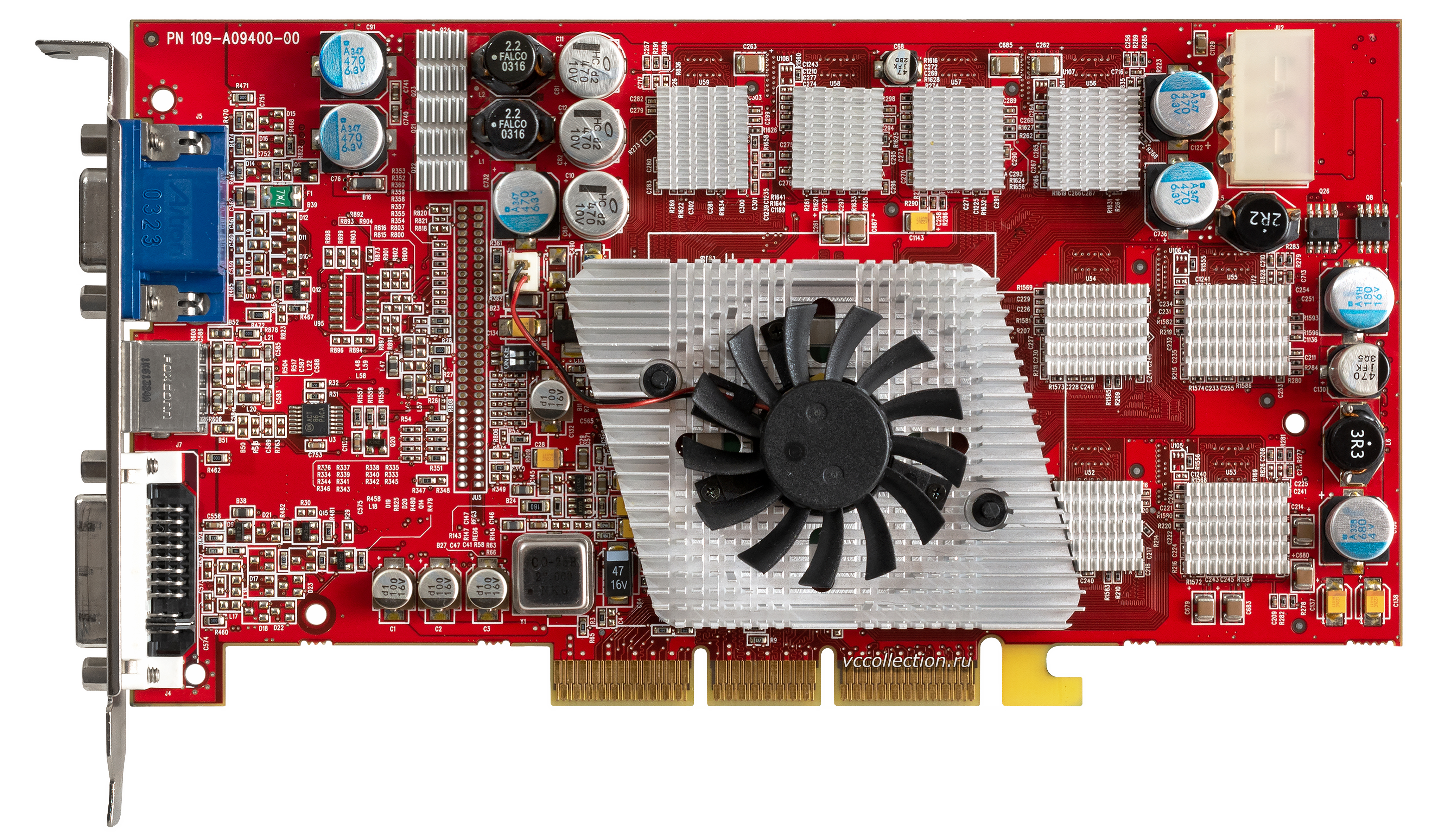

Несмотря на то, что 9800 Pro недолго пробыла в качестве лидера, именно с неё началось обновление линейки ATi — доработанный чип R350 получил поддержку Hyper-Z-кэширования и технологии сжатия инструкций.

ATi Radeon 9800 Pro

ATi Radeon 9800 ProПодготовила ATi и другие версии своего чипа для бюджетных категорий видеокарт — RV350 и RV280. Первый из них лег в основу Radeon 9600, и использовал передовой техпроцесс TSMC non-K 130 нм, тогда как второй был обновленной версией RV250 с поддержкой восьмиканальной шины AGP, и лег в основу Radeon 9200.

Важным вкладом в общие успехи ATi стали два контракта на разработку видеочипов — один из них предназначался для Nintendo Wii, другой лег в основу XBox 360. Партнерство с японской компанией было особенно важным стратегически, так как позволило заявить о себе на других, ранее недоступных рынках.

В стремлении вернуть утраченное лидерство ATI в сентябре 2002 года представила 9800 XT.

ATi Radeon 9800 XT

ATi Radeon 9800 XTДрайвера впервые за долгое время работали безупречно, а игровые новинки с поддержкой DirectX 9.0 демонстрировали прекрасную производительность — канадцы снова заняли первую строчку во многих бенчмарках, закончив год максимально удачным образом. 9700 Pro получила признание мейнстрим-рынка, тогда как NVidia досталось лишь место «лучшего продукта в категории цена-производительность» — его получила FX 5200.

2002 год закончился для ATi прибылью в $35.2 миллиона — во многом благодаря большой марже с продаж 9800 и 9600. NVidia покорила бюджетный сегмент, заняв 75% рынка благодаря популярности FX 5200.

XGI Volari и S3 DeltaChrome — Последние из могикан

Бывшее подразделение SiS, XGI, вывело на рынок своих кандидатов на народную любовь — линейку карт Volari, в которой были и самый бюджетные V3 за $49, и внушительные двухчиповые Duo V8 Ultra.

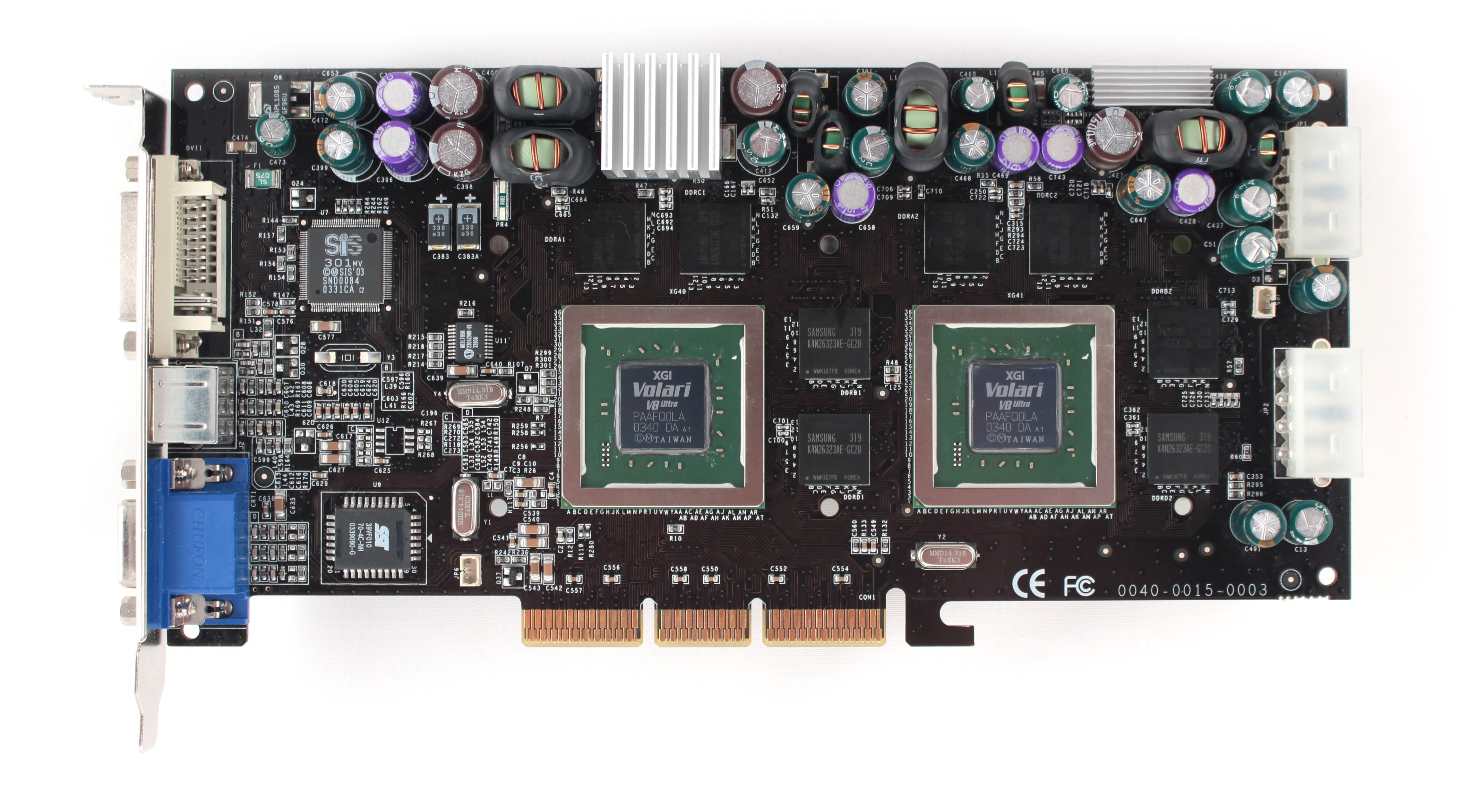

Volari V8 Duo Ultra

Volari V8 Duo UltraБюджетная V3 была ремаркированной Trident«s Blade XP4, и поддерживала только DirectX 8.1, а карты сегментом выше (включая V5 и V8) строились на базе SiS Xabre, и уже обеспечивали поддержку новейшего API.

Но подобная расстановка сил не слишком помогла XGI — среди всей линейки внимания заслуживала только младшая V3, способная потягаться с FX 5200 Ultra и Radeon 9200, тогда как остальные модели безнадежно отстали от конкурентов в своих ценовых сегментах. Например, флагманская Duo V8 Ultra стоила на 20% дороже Radeon 9800 XT, при этом демонстрируя производительность целым классом ниже — как у 9600 XT.

Линейка Volari еще возвращалась в поле зрения индустрии в 2005, а в 2010 году XGI снова стала частью SiS.

Другой компанией, внезапно решившей вернуться на рынок, стала S3. Будучи поглощенной VIA за $208 миллионов, компания занималась выпуском чипсетов и других интегрированных решений, но желание попытать счастья на прежнем поприще не пропало.

Карты серии DeltaChrome были анонсированы уже в январе, однако на полки магазинов добрались только к концу года.

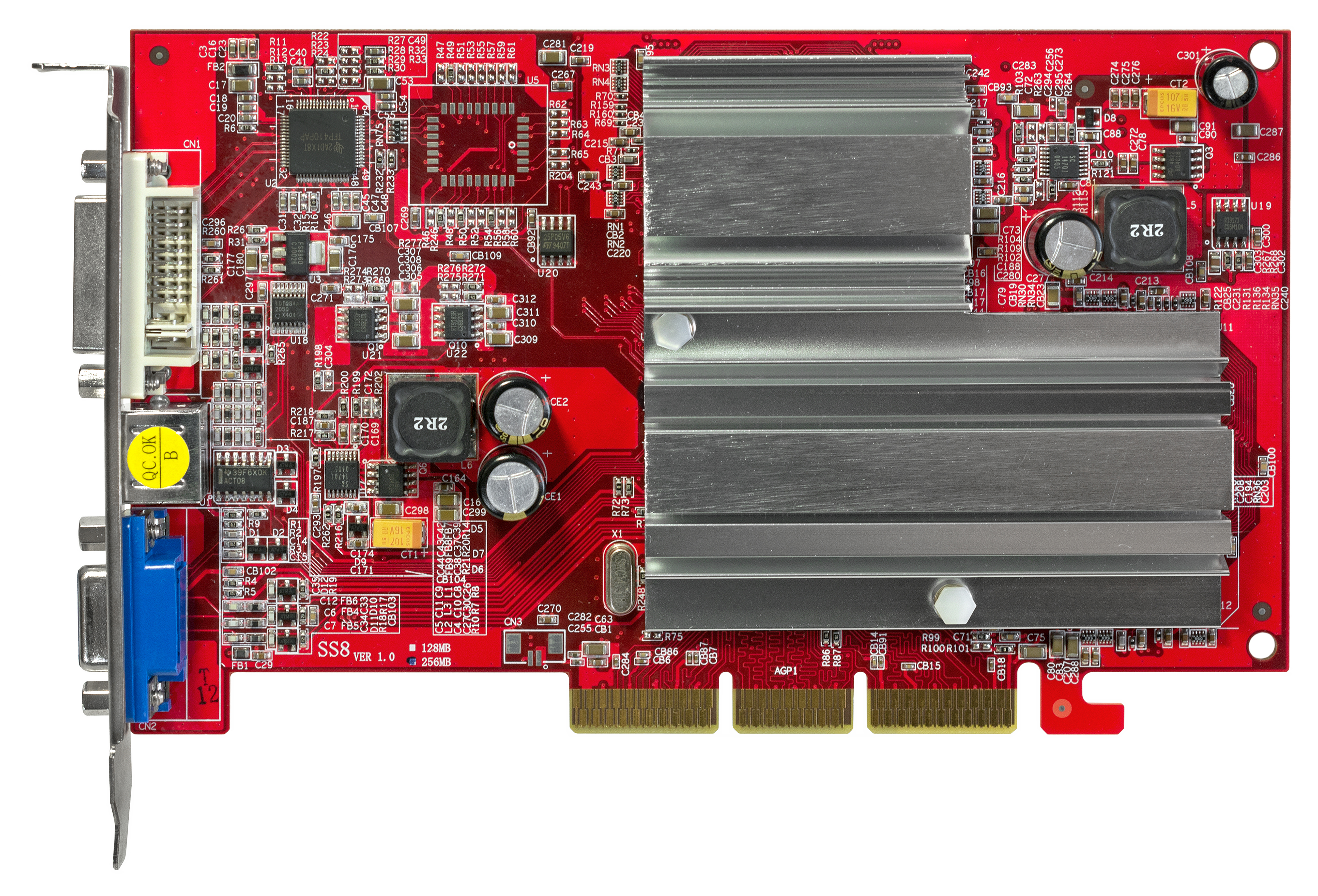

S3 DeltaChrome S8

S3 DeltaChrome S8На бумаге новинки выглядели готовыми к противостоянию с двумя титанами — поддержка DirectX 9, шестнадцатикратной анизотропной фильтрации, работа в разрешении 1080p и с портретным форматом дисплея подкрепляли намерение вернуться в игру.

К сожалению для S3, карты не получили должного внимания из-за специфики рынка — люди привыкли видеть графический фронт как поле боя двух титанов, и места для третьего игрока в этом противостоянии просто не было.

История бренда не закончилась сразу же — на смену DeltaChrome приходили карты GammaChrome, выпущенные в 2005. Но об этом позже.

NVidia 6800 — Сегментация для ценителей, «изобретение» SLI

Стремительный прогресс шел всё быстрее, и уже в марте 2005 года NVidia представила первую карту с памятью формата GDDR3 — FX 5700, следом за которой вышло поколение GeForce 6, сулящее геймерам покорение новых горизонтов производительности. Серия 6800, нацеленная на high-end сегмент, включала широкую линейку во всех ценовых сегментах, включая базовую версию карты за $299, GT за $399, Ultra за $499 и наиболее заряженную Ultra Extreme, выпуск которых NVidia доверила избранным AIB-партнерам. Рыночная цена эксклюзивной карты ограниченной серии составляла целых $549.

NVidia GeForce 6800 Ultra Extreme

NVidia GeForce 6800 Ultra ExtremeНо, как выяснилось позже, NVidia лишь прощупывала почву. 14 марта 2005 года линейку пополнила 6800 Ultra с 512 Мб видеопамяти на борту за сумасшедшие $899, а следом за ней появилась BFG-версия, стоившая целую тысячу долларов! С этой линейкой лидер рынка впервые проверял на прочность кошельки фанатов, готовых на всё ради передовых графических решений. А для всех остальных, с недоверием глядящих на цены линейки 6800, в сентябре 2005 года NVidia представила более доступную линейку 6600.

В техническом плане 6000 серия видеокарт NVidia была впечатляющей — она предлагала поклонникам и полную поддержку DirectX 9.0c, и частичную реализацию шейдеров 3.0, и новый движок декодирования и воспроизведения видео NVidia PureVideo, а также (барабанная дробь) поддержку технологии SLI — аппаратной синхронизации видеокарт, некогда разработанной 3Dfx.

Но если 3Dfx видела суть SLI в разделении рабочей нагрузки через разделение рендеринга фреймов (когда каждая видеокарта обрабатывала по половине кадра), то NVidia подошла к работе связок из двух видеокарт немного иначе. Режим split frame rendering (SFR) во многом соответствовал видению 3Dfx, разделяя рендер кадра на верхнюю и нижнюю половину, тогда как alternate frame rendering (AFR) выстраивал кадровый рендеринг в порядке очереди (один кадр рендерила одна видеокарта, следующий за ним — другая). Впрочем, управление технологией во многом зависело от конфигурации драйвера, а множество игр попросту не поддерживало технологию SLI, из-за чего вторая видеокарта не использовалась, и полезность SLI-связок часто становилась объектом споров среди геймеров — к тому же разработчики игр очень неохотно внедряли поддержку новинки в свои проекты.

Несмотря на июньский анонс SLI, первые материнские платы с поддержкой технологии на основе чипсета nForce 4 не появлялись в продаже вплоть до ноября. Спорные драйвера и вовсе приводили в порядок до начала 2006 года, только усилив неприятие новой технологии.

Но обзорщики не теряли возможности протестировать SLI там, где она была интересна более сего — в бюджетном сегменте. Например, некоторые тесты показывали очевидные преимущества связки из двух 6600 GT (общей стоимостью менее $400) над флагманскими картами в низком разрешении и на низких настройках качества графики. Но как только речь заходила об актуальных разрешениях и пресетах выше «среднего», преимущества SLI переставали быть очевидными. Различные технологические недостатки так и не позволили ни SLI, ни CrossFire продемонстрировать идеальное двукратное скалирование производительности, оставшись уделом энтузиастов и профессионалов. Сегодня в игровом компьютере никто не будет рекомендовать использовать две видеокарты — выгоднее выбрать одну, но мощную.

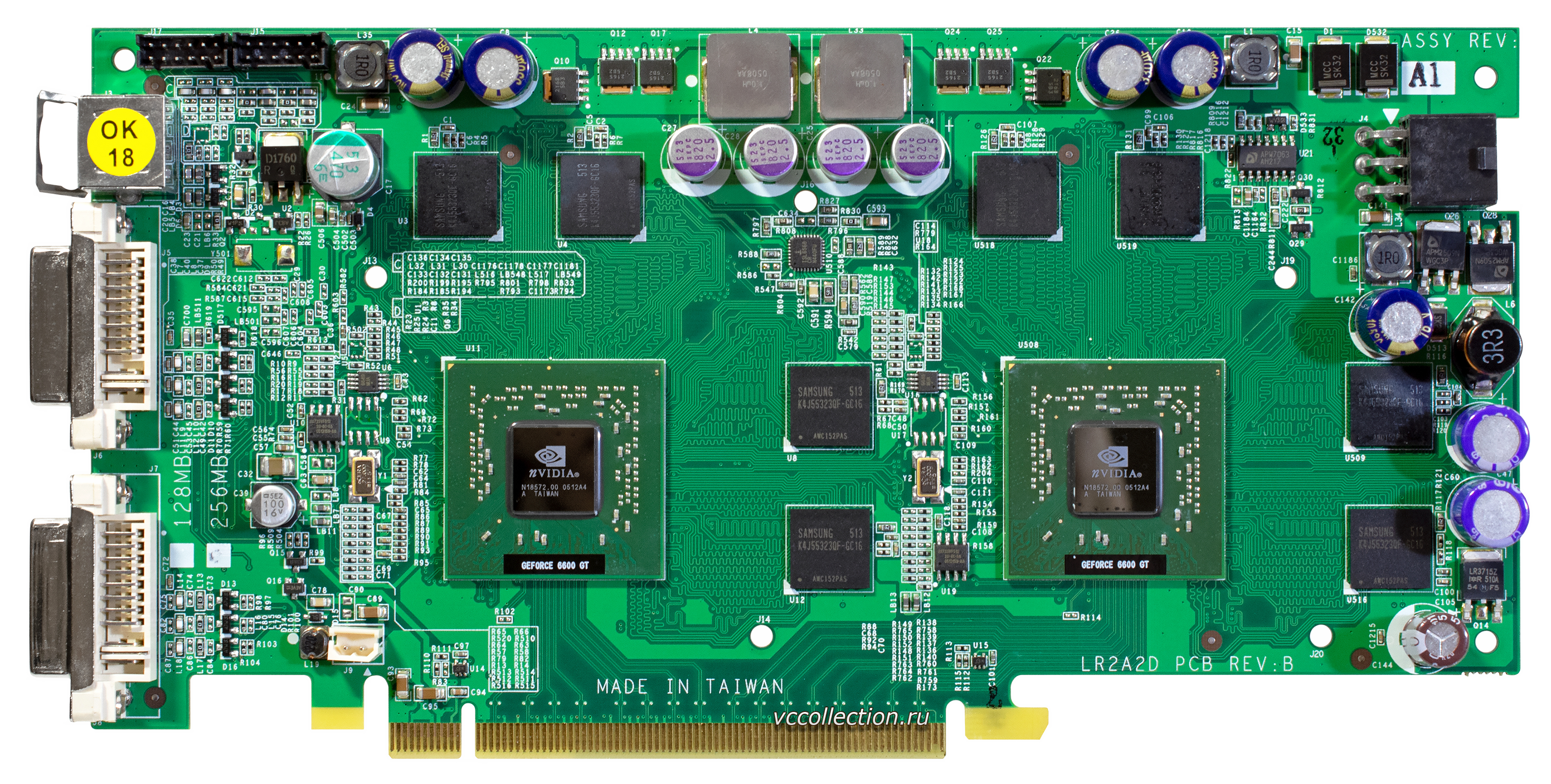

Но партнеры-производители увидели в возвращении технологии немалый маркетинговый потенциал, и компания Gigabyte выпустила не только двухчиповые 6600 и 6600 GT, но и 6800 GT.

NVidia GeForce 6600 GT x2

NVidia GeForce 6600 GT x2Такие чудеса инженерной мысли требовали не только новейшего чипсета nForce 4, но и моделей материнских плат исключительно производства Gigabyte.

Там же, где одночиповые карты всё еще правили балом, на вершине бенчмарков и тестов сражались 6800 Ultra и Radeon X800 XT/XT PE от ATi. Обе карты шли ноздря в ноздрю в тестах, и даже страдали от тех же проблем — так флагман ATi вышел в мае 2005 года и присутствовал на прилавках лишь ограниченными тиражами до конца жизненного цикла, а 6800 Ultra и вовсе вышла в продажу только в августе, оставшись больше коллекционной картой — даже партнерских версий флагмана NVidia было всего несколько.

Зато этажом ниже NVidia вышла в лидеры — 6800 GT с комфортом обходила X800 Pro в ценовом сегменте в $399, тогда как 6600 GT доминировала в категории видеокарт до $200.

Иронично, но серьезная конкуренция со стороны NVidia практически не сказалась на рекордных прибылях ATi в $204.8 миллиона при общем обороте практически в $2 млрд.

6600 GT, несмотря на свой культовый статус и бешеную популярность, пала жертвой явной технологической спешки. Дело в том, что карта использовала новейшую шину PCI-e, которая в 2005 году была доступна только зажиточным владельцам новой платформы Intel Pentium 4. При этом материнские платы AMD, которая была технологическим лидером с передовыми двухъядерными процессорами AMD 64, всё еще использовали AGP-шину, и решение NVidia оставить за бортом массу фанатов новых видеокарт осталось непонятным.

NVidia 7000 vs Radeon X1000 — Ожесточенная схватка за лидерство

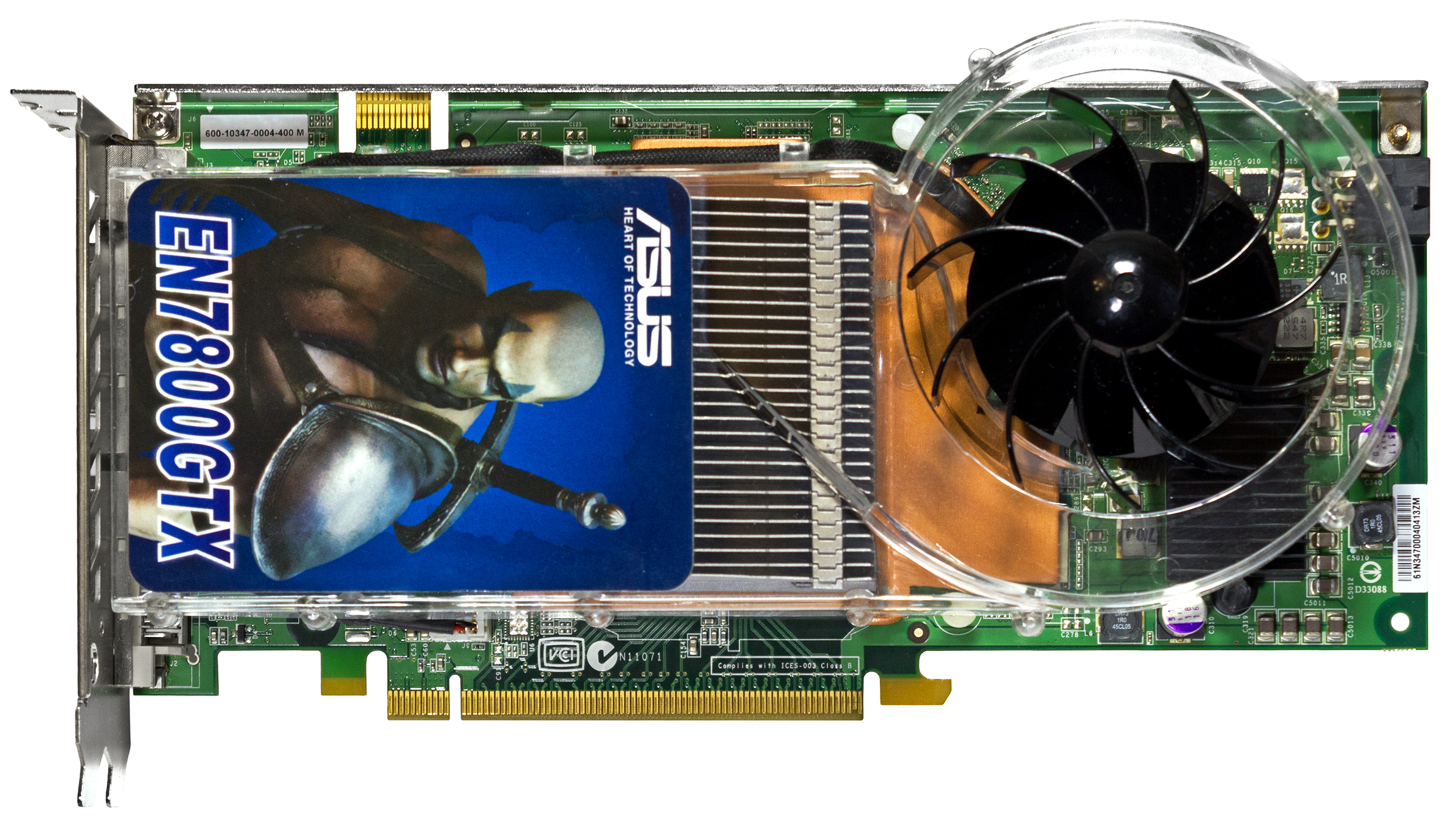

Опасаясь потерпеть поражение от нового поколения ATi, NVidia начала выпускать модели 7000 серии еще выхода в продажу полной линейки предыдущего поколения. Новая 7800 GTX появилась на прилавках за 5 месяцев до того, как была представлена урезанная 6800 с префиксом GS.

NVidia GeForce 7800 GTX

NVidia GeForce 7800 GTXСпешка с выпуском новинок была так велика, что в процессе NVidia успела сменить техпроцесс — если первые карты изготавливались на 110 нм техпроцессе от TSMC (7800, чип G70), то последующие использовали более совершенный 90 нм техпроцесс (7900, чип G71).

И хотя обозначение чипов сменилось с привычного NV на G, новая архитектура во многом напоминала чип NV40, лежащую в основе 6000 серии. При минимальной разнице в размерах новый чип имел на 8 миллионов транзисторов больше, число пиксельных конвейеров выросло в 1.5 раза, а вертексных стало больше на треть. NVidia заменила всю линейку моделями на базе G70 уже через девять месяцев после премьеры 6000 серии, а карты классов GS и GTX (на 512 Мб) и вовсе сменили предшественников всего через 3 и 4 месяца соответственно. Так Дженсен Хуанг еще никогда не торопился.

Интересные технологические решения были реализованы даже в бюджетных моделях. Например, в 7200 GS была реализована технология TurboCache, позволявшая видеокарте использовать системную память компьютера после исчерпания бортового буфера — впервые NVidia испытала её в GeForce 6200 TC, но технология показала себя более чем жизнеспособной — она активно используется до сих пор.

Что же до флагманских карт, 7800 GTX с 256 Мб на борту появилась в продаже 22 июня по не самой демократичной цене в $599.

NVidia GeForce 7800 GTX

NVidia GeForce 7800 GTXАжиотаж вокруг новинки был настолько велик, что цены зачастую оказывались куда выше рекомендованных. ATi ответила выпуском X1800XT, отняв титул самой производительной карты, но уже пять дней спустя NVidia выпустила 7800 GTX с 512 Мб памяти, вернув себе звание «самой-самой».

ATi Radeon x1800 XT

ATi Radeon x1800 XTДва месяца спустя ATi продолжила с X1800XTX, которая навязала конкуренцию флагману NVidia, и стартовала новый этап гонки за производительностью — обе карты стоили в районе $650, а одно из партнерских решений канадского флагмана даже предлагало геймерам разъем dual-link DVI, через который можно было играть в разрешении 2560×1600 (!) при высоких настройках графики.

ATi CrossFire и новинки X1000 — Исторические рекорды и новые горизонты

В мае 2005 года ATI представила собственную технологию работы с несколькими видеокартами — CrossFire. Премьера новинки состоялась в сентябре одновременно с выпуском специального чипсета Xpress 200 Crossfire Edition и материнской платы X850 XT Crossfire Master. Первоначально из-за одноканального видеоконтроллера разрешение экрана с использованием парных карт ограничивалось 1600×1200 при 60 Гц, но уже в скором времени появление двухканального DVI решило проблему и довело его до 2560×1600.

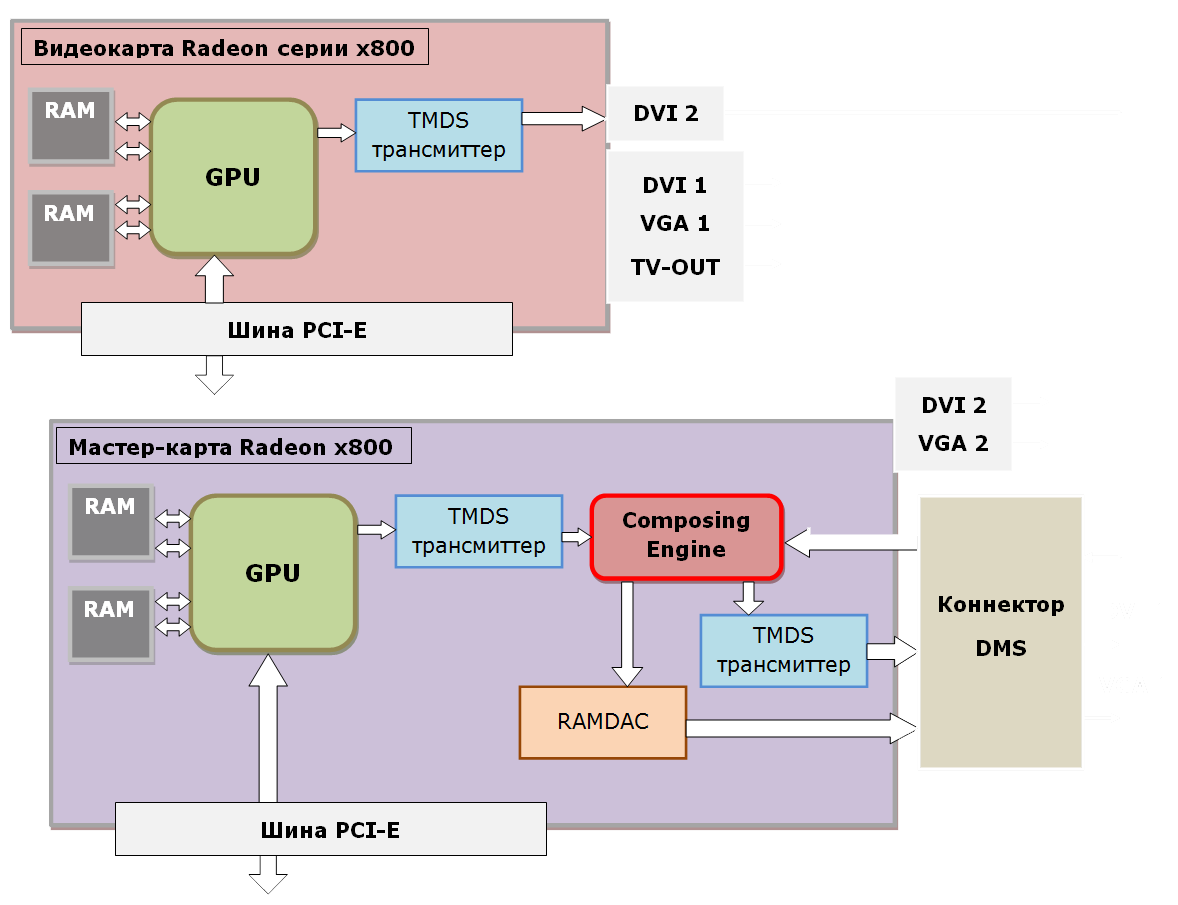

В отличие от NVidia, объединяющей два одинаковых адаптера через мостик, ATI использовала мастер-карту с TDMS-ресивером, подключая второй адаптер через внешний Y-кабель и используя чип Xilinx.

CrossFire предлагал идентичные SLI технологии работы рендеринга, но при этом имел и собственную разработку SuperTiling. Технология позволяла заметно увеличить производительность в некоторых играх и приложениях, однако не работала с OpenGL, и не поддерживала ускоренной обработки геометрии. О проблемах с драйверами и играми, как и в случае с SLI, можно даже не упоминать.

Несмотря на план ATi выпустить первые видеокарты с поддержкой шейдеров 3.0 еще в июле (на новом чипе RV520), обнаруженный в архитектуре критический баг затянул подготовку новинки на целых 4 месяца.

Начальная линейка включала модели X1800 XL/XT на базе ядра RV520, бюджетную линейку карт X1300 на урезанном R515 (имевшим 25% конвейеров флагмана), а также X1600 Pro/XT на основе RV530, ставшую золотой серединой по общей производительности.

© Habrahabr.ru