Google создала нейросеть, которая поможет изучать тенденции в моде

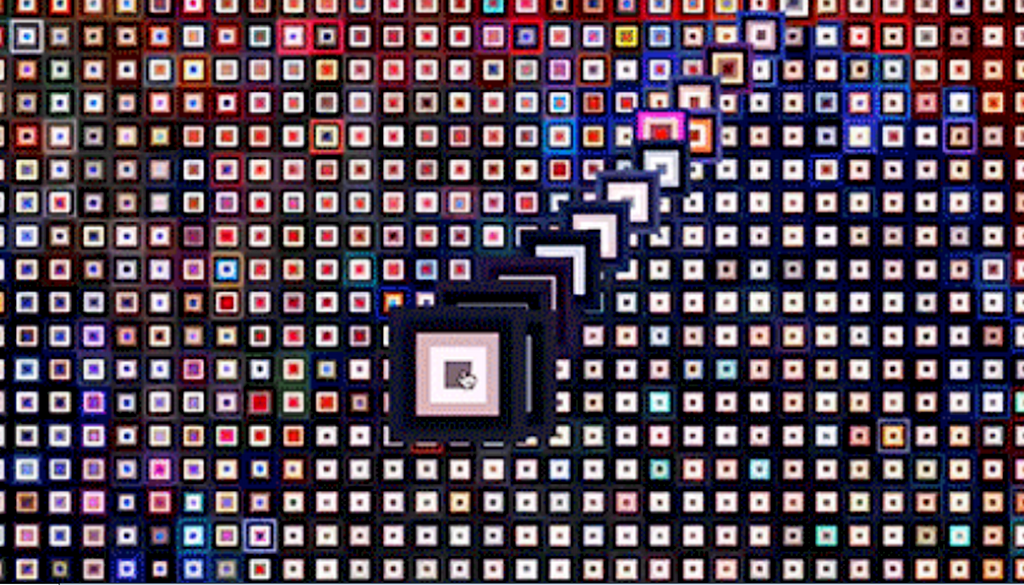

Разработчики Google представили нейросеть, которая изучает тенденции модных показов по цвету. Было проанализировано 140 тысяч фотографий с подиума. Затем ИИ выделил из них основные цвета и составил интерактивную карту.

Издание The Business of Fashion предоставило компании фотографии с 4000 показов. В рамках эксперимента Runway Palette была составлена интерактивная визуализация четырехлетней моды от почти 1000 дизайнеров.

В Google отметили, что, если бы человек в день посещал по одному представленному в проекте показу, то у него бы ушло на это более десяти лет. Однако теперь есть общедоступная визуализация. Она поможет в изучении трендов на цвета и сравнении работ дизайнеров.

Кроме того, нейросеть научилась подбирать наряд по фото. Если загрузить на сайт фотографию осенних листьев, то ИИ выделит их основной цвет и подберет образы, составленные в аналогичных тонах.

См. также: «Google представила «объяснимый» ИИ (Explainable AI)»

Google предложила пользователям поучаствовать в еще одном эксперименте, Living Archive. В рамках него машинное обучение используется для прогнозирования и генерации движений в стиле танцоров Уэйна МакГрегора. ИИ можно использовать, чтобы установить связь между позами, а также чтобы записать свое собственное движение и создать хореографическое произведение.

Ранее компания открыла общий доступ для всех пользователей на экспериментальный онлайн-сервис с использованием искусственного интеллекта — FreddieMeter. Он создан совместно с YouTube и в сотрудничестве с группой Queen и студиями звукозаписи Universal Music Group и Hollywood Records. На недавно запущенном онлайн-портале предлагается всем пользователям сравнить свои вокальные данные с голосом легендарного Фредди Меркьюри.

См. также: «Квантовая ставка Google на ИИ — и что она означает для всего человечества»

Кроме того, Google упростила машинное обучение для тех, кто не имел дела с разработкой. В новой Teachable Machine 2.0 нейронные сети можно обучить одним нажатием кнопки. Компания утверждает, что инструмент доступен даже школьникам. Если первая версия Teachable Machine позволяла с использованием веб-камеры наблюдать, как компьютер учится распознавать шаблоны и закономерности в изображениях, то вторая способна распознавать звуки и позы. Пользователь же может с помощью веб-камеры и микрофона на своем ПК без написания кода обучать нейронные сети и экспортировать их в сторонние приложения, носители или на веб-сайты.