Гигантские ИИ-модели и самые производительные чипы: Nvidia выпустила мощный GPU B200 со скромным потреблением энергии

Корпорация Nvidia продолжает развивать направление производства чипов для ИИ-отрасли. Сейчас руководитель американской компании заявил о выпуске самого мощного ИИ-чипа в мире. Кроме того, готовы и некоторые модульные системы, базирующиеся на основе GPU B200, так называется новинка.

Что это за чип и зачем он нужен?

Поскольку отрасль искусственного интеллекта сейчас активнейшим образом развивается, производители чипов и модулей на их базе тоже не стоят на месте. Один из самых крупных представителей этого рынка — корпорация Nvidia.

В марте 2024 года она показала новые ускорители вычислений, которые базируются на архитектуре Blackwell. Последняя — «потомок» Hopper, предтечи, представленной два года назад.

Корпорация заявила, что новый чип предназначен для создания систем, позволяющих обучать поистине гигантские модели — уже не с миллиардами, а триллионами параметров. Это нужно для решения таких задач, как обработка естественного языка, создание мультимодальных приложений, кодогенерация и т. п. В нейминге архитектуры нет ничего удивительного, она названа в честь американского математика.

Стоит отметить, что чипы H100/H200 крайне востребованы на рынке, несмотря на свою цену. Новый чип, насколько можно судить, будет ещё дороже, но, скорее всего, его тоже станут массово покупать. Здесь стоит подробнее рассказать о характеристиках чипа.

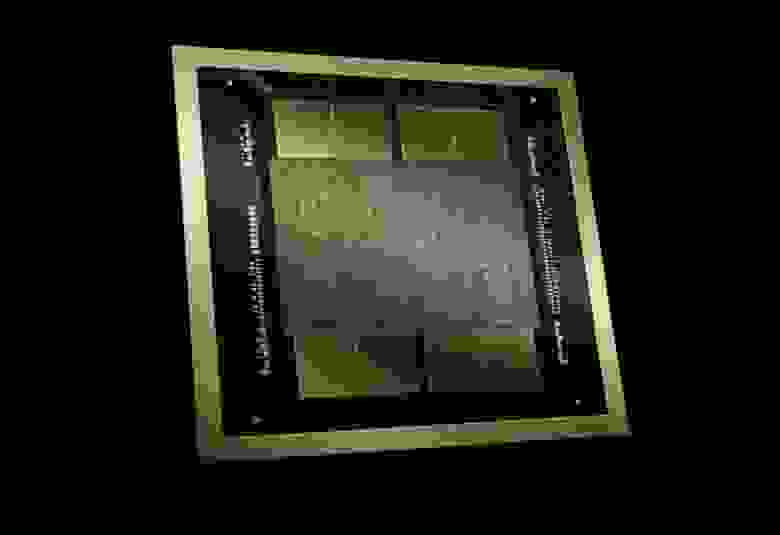

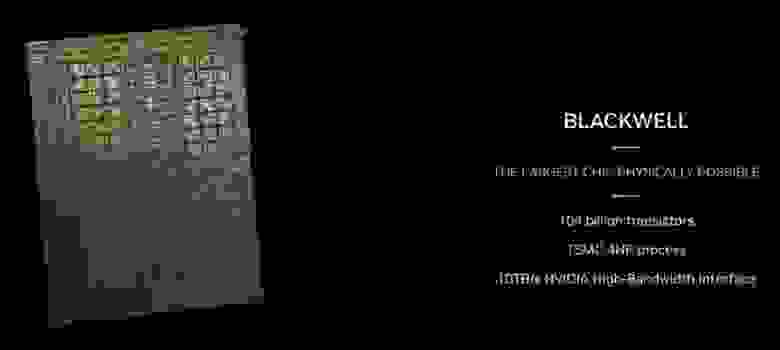

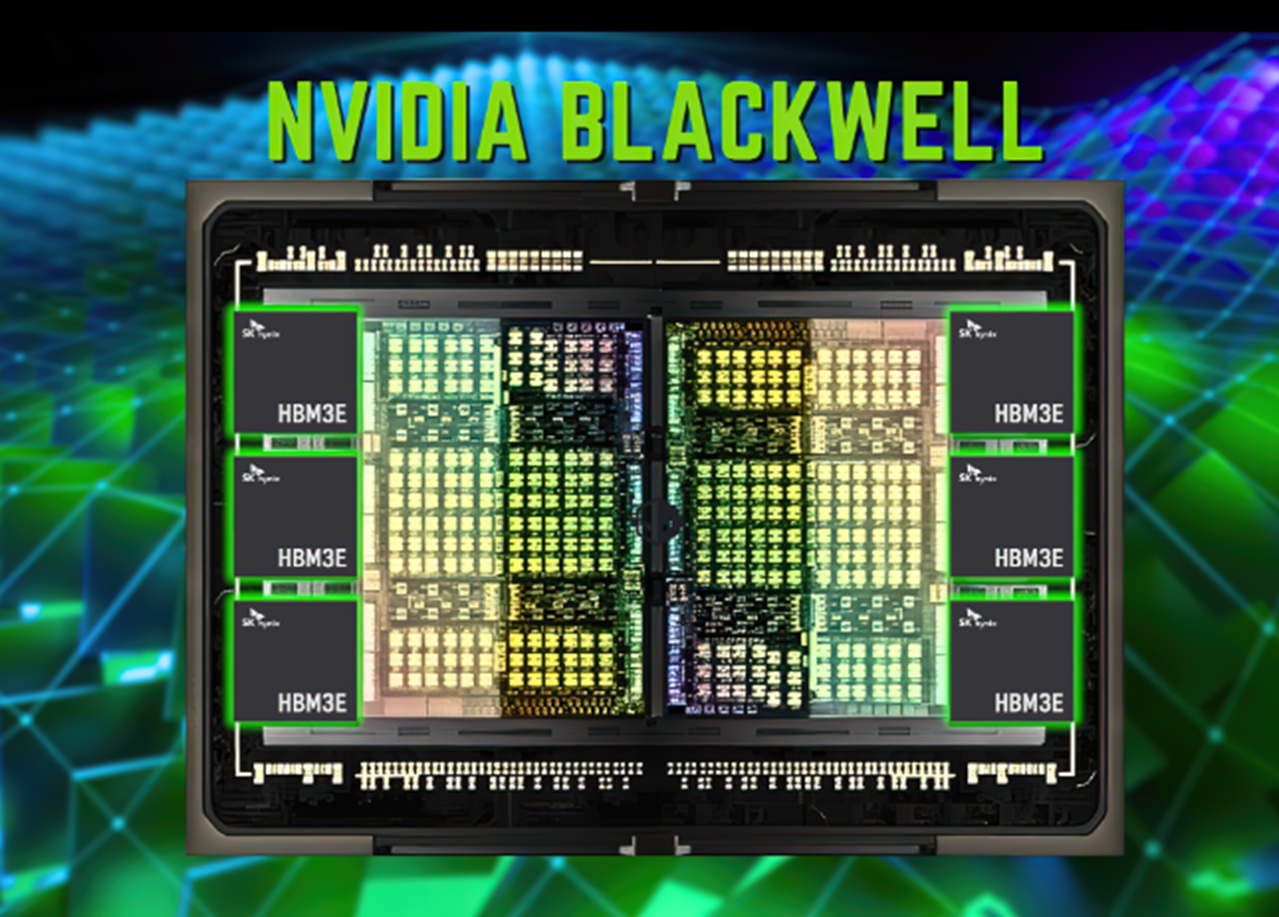

Так, новый GPU состоит из двух кристаллов, которые произведены по специальной версии 4-нм техпроцесса TSMC 4NP (само собой, на мощностях TSMC) и объединены 2,5D-упаковкой CoWoS-L. Интересно, что это первый GPU компании Nvidia с чиплетной компоновкой. Чипы соединены шиной NV-HBI с пропускной способностью 10 Тбайт/с и работают как единый GPU. Всего новинка насчитывает 208 млрд транзисторов. Свой продукт компания называет двигателем для новой промышленной революции.

Собственно, имеет право, поскольку его возможности действительно отличные. Например, в вычислениях FP4 и FP8 этот GPU показывает производительность до 20 и 10 Пфлопс соответственно. Не в последнюю очередь функции чипа обусловлены новыми тензорными ядрами и вторым поколением механизма Transformer Engine. Он позволяет выполнять тонкую настройку вычислений для разных задач, что, конечно, влияет на скорость обучения моделей. Blackwell поддерживает работу с самыми различными форматами, включая FP4, FP6, FP8, INT8, BF16, FP16, TF32 и FP64.

Ну хорошо, чип — это отлично, а что насчёт ускорителей?

Главным продуктом здесь станет Nvidia Grace Blackwell Superchip. В нём два графических процессора B200 и центральный Arm-чип Nvidia Grace с 72 ядрами Neoverse V2. В общем, не зря к названию чипа добавили приставку Super, результат действительно удивляет. Производительность в операциях FP4 достигает 40 Пфлопс, тогда как в операциях FP8/FP6/INT8 новый GB200 способен обеспечить 10 Пфлопс.

По сравнению с H100 новинка показывает 30-кратный прирост производительности. Но при этом она ещё и потребляет меньше энергии — сообщается, что ускоритель в 25 раз более энергоэффективный, чем предыдущие модели.

А ещё компания будет поставлять системы GB200 NVL72. Это собственная разработка — серверная стойка, в которую входят 36 Grace Blackwell Superchip и пара коммутаторов NVSwitch 7.2T. Получается, что в системе сразу 72 графических процессора B200 и 36 чипов Grace, которые объединены NVLink пятого поколения.

И всё это работает как единый GPU с ИИ-производительностью 1,4 эксафлопс (FP4) и 720 Пфлопс (FP8). Эта система станет строительным блоком для новейшего суперкомпьютера Nvidia DGX SuperPOD.

Но и это ещё не всё, ведь американская компания представила также и серверные системы. Это в первую очередь HGX B100, HGX B200 и DGX B200. В каждой по восемь ускорителей нового типа.

Nvidia заявляет, что существует возможность создания очень крупных ИИ-систем, которые включают от 10 тыс. до 100 тыс. ускорителей GB200. Формировать их можно посредством сетевых интерфейсов Nvidia Quantum-X800 InfiniBand и Spectrum-X800 Ethernet. Они также были анонсированы сегодня и обеспечат передовые сетевые возможности со скоростью до 800 Гбит/с.

При этом всего одна система GB200 NVL72 способна выполнить инференс модели с 27 трлн параметров. В той же GPT-4, модели, с которой знакомы многие читатели Хабра, 1,7 трлн параметров. Соответственно, в скором будущем можно ожидать появления ещё более крупных и совершенных моделей, способных удивлять нас разными технологическими новшествами и возможностями.

Кроме новинок, показанных Nvidia, в скором времени представят свои системы на базе Nvidia B200 и другие корпорации, включая Aivres, ASRock Rack, ASUS, Eviden, Foxconn, GIGABYTE, Inventec, Pegatron, QCT, Wistron, Wiwynn и ZT Systems.

Естественно, новинки Nvidia уже заинтересовали крупные и средние компании. В числе первых — те корпорации, которые оказывают услуги облачных вычислений, например Amazon, Google, Microsoft и Oracle.