Этичность Искусственного Интеллекта

Кадр из игры Deus Ex Mankind Divided с демонстрацией импланта, анализирующего эмоции

Искусственный интеллект все плотнее входит в нашу жизнь. Его внедряют в разные отрасли, порой даже самые неожиданные. Начинают сбываться одни из самых смелых прогнозов фантастов — ИскИны помогают людям в повседневной жизни. Будут ли сбываться другие прогнозы о порабощении человечества компьютерами и подобное мрачное будущее?

Пока сложно судить о том, когда нас поработят роботы. Но может пора задуматься о моральной стороне и решить, насколько этично использовать нейросети в некоторых вопросах? Именно об этом пишет Кейт Кроуфорд в своей статье, опубликованной на сайте Nature, с переводом которой я предлагаю вам ознакомиться и обсудить то, насколько актуальна эта проблема.

В начале статьи будет перевод, потом я расскажу идеи из других ее публикаций, потом повспоминаю о том, как подобная проблема описывалась в различных фантастических произведениях. Затем предлагаю сравнить с тем, как обстоят дела в текущий момент и решить, насколько обоснованы ее опасения. Итак, перевод.

Пришло время заняться регулированием ИИ, который интерпретирует человеческие эмоции

Пандемию используют как предлог для внедрения непроверенных инструментов ИИ на рабочие места и в школы.

Во время пандемии технологические компании предлагали свои программы распознавания эмоций для дистанционного наблюдения за рабочими и даже детьми. Например, возьмем систему 4 Little Trees. Утверждается, что программа, разработанная в Гонконге, оценивает эмоции детей во время занятия в классах. Она считывает черты лица, чтобы определить категорию эмоционального состояния ученика: счастье, печаль, гнев, отвращение, удивление и страх. Также она измеряет мотивацию и прогнозирует оценки. Такие же инструменты были проданы для наблюдения за сотрудниками на удаленной работе. По некоторым предположениям, к 2026 году индустрия распознавания эмоций будет оцениваться в 37 миллиардов долларов.

Среди ученых существуют серьезные разногласия по вопросу, может ли ИИ распознавать эмоции. В обзоре, вышедшем в 2019 году, утверждается, что не найдено надежных доказательств этого предположения. «Tech companies may well be asking a question that is fundamentally wrong,» the study concluded (L.F. Barrett et al. Psychol. Sci. Public Interest 20, 1–68; 2019).

Растет озабоченность по поводу неправильного использования этих технологий. В прошлом году Розалинда Пикард, которая является соучредителем бостонского стартапа Affectiva (компания занимается разработкой ИИ распознающего эмоции и психологическое состояние человека. прим пер.) и возглавляет Группу по аффективным вычислениям (аффективные вычисления — раздел информатики, изучающий распознавание и моделирование человеческих аффектов, придуманный и развиваемый Розалиндой. прим. пер.) в MTI, заявила, что поддерживает регулирование. Ученые призывают к обязательному и строгому аудиту всех технологий ИИ, используемых при найме сотрудников и раскрытию полученных результатов.

В марте гражданская комиссия, созванная Институтом Ады Лавлейс, выступила с заявлением (pdf), что для контроля разработки и внедрения биометрических технологий необходим независимый юридический орган. Такой надзор нужен для защиты от систем, внедрение которых продвигается тем, что я называю «френологическим импульсом» (Френология — лженаука о связи строения черепа и характера человека. прим. пер.): получение ошибочных предположений о внутреннем состоянии и способностях человека по внешним проявлениям, чтобы узнать о нем больше, чем он хочет рассказать.

Во всех странах есть нормативные акты, обеспечивающие научную строгость при разработке лекарственных препаратов, предназначенных для лечения организма. Инструменты, предъявляющие претензии к нашему разуму, тоже должны быть защищены в той же мере. Ученые много лет призывали федеральные органы к контролю за робототехникой и распознаванием лиц, это должно распространяться и на распознавание эмоций. Пришло время, чтобы национальные законодательные органы приняли меры против неотработанных технологий, особенно тех, которые нацелены на детей и другие уязвимые группы населения.

Уроки, извлеченные из клинических испытаний, показывают значение контроля. Федеральные требования и последующая пропаганда сделали данные множества клинических испытаний доступными для общественности и предметом строгой проверки. Это становится основой для выработки более эффективной политики и укрепления доверия со стороны общественности. Надзор со стороны регулирующих органов за аффективными технологиями привел бы к аналогичным выгодам и подотчетности. Он также мог способствовать установлению норм для противодействия превышению полномочий правительством и корпорациями.

Хорошая аналогия — полиграф. Детектор лжи был изобретен в 20-х годах прошлого века и десятилетиями использовался военными и ФБР, с противоречивыми результатами, которые принесли много вреда тысячам людям, пока его использование в значительной степени не было запрещено федеральным законом (речь идет только про США. прим. пер.). Только в 1998 году Верховный суд США пришел к выводу, что «просто не было единого мнения о надежности полиграфа.»

Главной персоной, стоящей за утверждением, что существуют несколько универсальных выражений лиц обозначающих эмоции, является Пол Экман. В 60-х годах прошлого века он путешествовал по высокогорным районам Папуа-Новой Гвинеи для проверки своей спорной гипотезы о том, будто все люди проявляют небольшое количество универсальных эмоций, которые являются врожденными и мультикультурными. Антрополог Маргарет Мид оспаривала эту идею, говоря о том, что она не учитывает контекст, культуру и социальные факторы.

Проблема в том, что «шесть основных эмоций», описываемых Экманом, отлично вписываются в модель развивающего компьютерного зрения. Как я писала в своей книге 2021 года: Атлас ИИ, его теория была принята потому, что она соответствовала возможностям инструментов. Шесть последовательных эмоций легко стандартизировать, автоматизировать и масштабировать, если игнорировать более сложные вопросы. Экман продал свою идею Управлению транспортной безопасности США после терактов 11 сентября 2001 года, чтобы оценивать, какие пассажиры проявляют страх или стресс (то есть, каждый первый, кто боится летать, а таких примерно треть населения. прим пер.) и потому могут быть террористами. Его резко критиковали за отсутствие доверия и расовую предвзятость. Тем не менее, многие современные инструменты, такие как 4 Little Trees, основаны на классификации шести эмоций по Экману. При этом Экман утверждает, что лица действительно выражают универсальные эмоции, но говорит, что не видел никаких доказательств того, что автоматические системы действительно работают.

Однако, компании продолжают торговать программным обеспечением, которое будет влиять на шансы людей, не имея четко документированных и проверенных независимыми экспертами доказательств своей эффективности. Кандидатов на вакансии судят несправедливо только потому, что их выражение лица не совпадает с мимикой сотрудников, или они слишком громко разговаривают. Учеников ругают в школах за то, что они выглядят хмурыми. Исследования доказали, что программа распознавания лиц интерпретирует черные лица так, будто на них выражается больше негативных эмоций, чем на белых.

Мы больше не можем позволить, чтобы технологии распознавания эмоций оставались неконтролируемыми. Настало время для законодательной защиты от недоказанного использования этих инструментов во всех сферах: образовании, здравоохранении, рекрутинга и уголовном правосудии. Эти меры предосторожности приведут к возвращению точной науки и отвергнут мифологию о том, что внутренние состояния — просто еще один набор данных, которые можно считать с наших лиц.

Это не единственная статья Кейт Кроуфорд на эту тему, на сайте Nature есть еще две: Halt the use of facial-recognition technology until it is regulated 2019 года и There is a blind spot in AI research 2016 года. Они посвящены тем же проблемам и призывам к запрету бесконтрольного применения технологий распознавания лиц потому, что их точность недостаточна и может привести к ошибкам, которые слишком дорого встанут людям, с которыми обойдутся несправедливо из-за программного глюка. Например, при распознавании личности белого мужчины ошибки составляют примерно 1%, а темной женщины — 35%. Плюс ко всему, эти технологии нарушают приватность граждан. Например, Amazon собирается сотрудничать с полицейскими управлениями, передавая им данные со своих камер домашнего наблюдения Ring.

Как это представляли

Распознавание добра и зла — одна из основных тем фольклора. Фантазия авторов неисчерпаема. Волшебный камень, определяющий яд в бокале с напитком из романа-эпопеи про Анжелику Анн Голон, кулон ведьмака Геральта, предупреждающий об опасности, и, конечно же, многочисленные магические и технические приспособления распознающие эмоции собеседника или ложь.

Частным случаем обсуждаемой проблемы являются знаменитые Три закона робототехники Айзека Азимова. И хотя мастер сформулировал их для того, чтобы роботы не могли навредить людям, многочисленные логические парадоксы, которые описывались во множестве фантастических произведений, приводили к прямо противоположным результатам. Потому что основная проблема заключается в интерпретации того, что считать причинением вреда. Для этого используется не только анализ ситуации в целом, но и распознавание намерений человека, его эмоций.

Один из рассказов Роберта Шекли, Страж птица, написан больше полувека назад, но знаменитый автор довольно точно описал возможные проблемы самообучающегося ИскИна, которому доверили определять намерения человека и бить электрошоком, чтобы остановить убийцу. Закончилось это тем, что хирурги не могли оперировать, рыбакам не давали ловить рыбу, и даже машину нельзя было заглушить, потому что автономные самообучающиеся роботы тоже считали это все покушением на убийство.

Неоднозначность понимания того, как ИскИн приходит к тому или иному решению, является сюжетом для замечательной трилогии Питера Уоттса — Рифтеры. В романах описывается не очень отдаленное будущее, в котором повсеместно используются умные гели — культуры человеческих нейронов на пластине субстрата, способные к самообучению и анализу. Первоначально их использовали для защиты от вирусов, и благодаря им компьютерные вирусы были полностью побеждены. Но, поскольку люди не очень хорошо себе представляли пути обучения умных гелей, это приводило к катастрофическим результатам. Например, в одном случае, умный гель был приспособлен для того, чтобы управлять открытием дверей вагона вакуумного маглева на станции, пассажиров надо было выпускать тогда, когда станция изолировалась от туннеля и заполнялась воздухом. Первое время все было хорошо, гель был обучен и работал без перебоев. Но однажды он открыл двери вагона в вакуум, и все пассажиры задохнулись. Когда в панике разработчики стали анализировать процесс обучения и принцип работы геля, оказалось, что он руководствовался не датчиком давления, а просто смотрел на часы через камеру видеонаблюдения. Какой-то вандал разбил часы на станции, и это привело к сбою. Впоследствии глобальная катастрофа произошла как раз из-за неправильной парадигмы обучения ИскИна, работающего на умном геле.

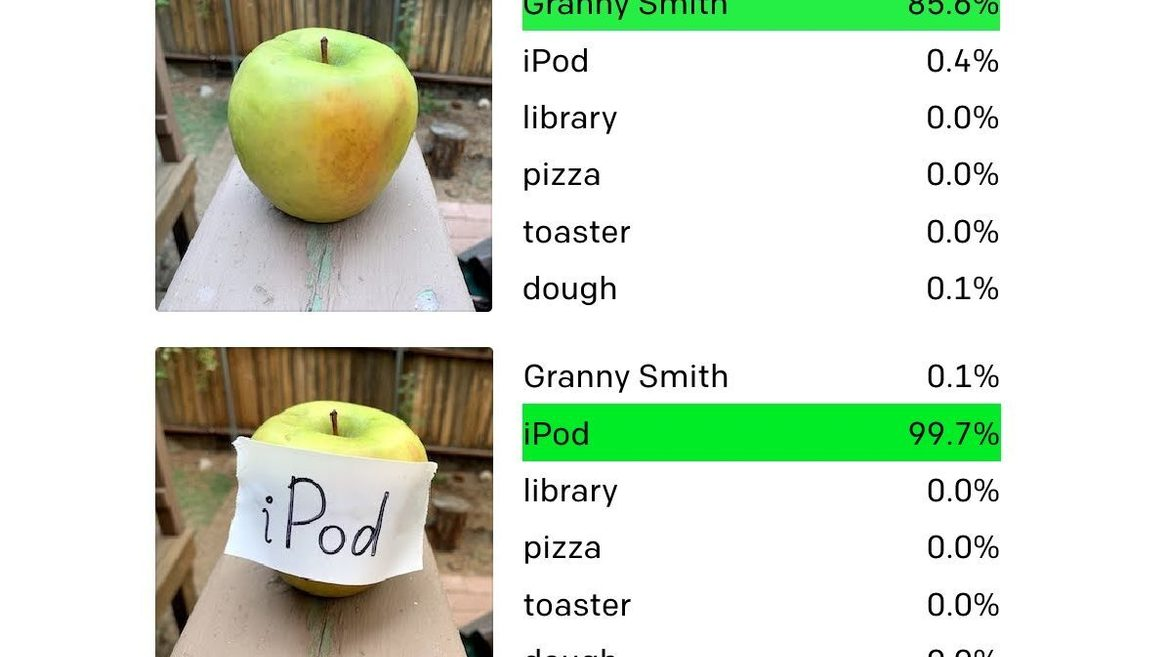

Сюжет фантастический и притянутый за уши чисто для демонстрации возможной ошибки, он имеет под собой определенные основания. Потому что в нашем с вами мире, в текущей реальности, постоянно появляются новости, в которых описывается очередной курьез, когда разработчики, знающие алгоритм работы нейросети, с помощью разных приемов заставляют их видеть совершенно не то, что на самом деле. Причем человек легко делает правильный вывод, даже не подозревая, что на картинке какий-то специфично модулированный шум, сбивающий с толку системы распознавания. Один из недавних способов обмана выглядит совершенно анекдотично, из разряда написанному верить.

А ведь подобным системам собираются доверить поиск потенциальных террористов в самолетах…

Наконец, пример из КДПВ — нейроимплант социальный корректор, который представляет из себя классический детектор лжи, анализирующий мимику, интонацию, частоту дыхания и сердцебиения, с помощью которого можно манипулировать персонажами и получать результаты, в принципе недостижимые, если пытаться пройти квест без этого корректора. Казалось бы, идея детектора лжи уже полностью дискредитирована, но почему бы не обновить ее с помощью ИскИна?

На самом деле, идея не такая уж фантастическая. Уже есть алгоритмы, которые по анализу гистологического среза определяют болезни и справляются с этим лучше профессионального микробиолога: Нейросеть распознаёт рак лёгких на ранних этапах с точностью 97%. Окончательный диагноз все равно ставит человек, машине это не доверят, но как вспомогательный инструмент, подобный ИИ, просто великолепен главным образом потому, что скорость его работы на порядки превышает человеческие возможности.

Без права на ошибку

С тех пор, как был изобретен пресловутый полиграф, фантасты не переставали использовать его принцип в своих произведениях прямо или опосредованно. Один из ярких примеров — рассказ «Особое мнение» Филипа Дика и его экранизация с Томом Крузом. Хоть там нет ИскИна, считывающего эмоции, а предсказаниями занимаются оракулы-телепаты, это вполне приемлемое допущение для произведения из середины прошлого века. Зато там очень точно показана проблема, которая возникает из-за ошибки, которая ломает жизнь герою, делает из него изгоя и прямо угрожает его жизни.

Современные проблемы, о которых так беспокоится автор статьи, очень похожи на события фильма. Ошибка распознавания лица может привести к неприятностям, если человека решат задержать для выяснения его личности. А если у задержанного по каким-то причинам не окажется при себе документов? Из этого вырисовывается уже совсем неприятный сценарий, где одним только потерянным временем не отделаться, и задержанный получит серьезный стресс. Если вдруг человек решит поделиться этим приключением с общественностью (конечно он захочет, для чего еще существуют блоги?), то это может привести к скандалу и серьезным проблемам с репутацией правоохранительных органов. Кроме того, можно еще подать в суд.

Короче, ошибка нейросети может привести к серьезным проблемам, которые вряд ли захочется испытать на своей шкуре. Кроме того, в досье наверняка появится отметка «задерживался по подозрению», и потом человек будет ломать себе голову, почему ему отказали в приеме на ответственную руководящую должность или выдаче кредита.

Проблема обучения ИИ для распознавания эмоций еще и в том, что люди, подбирающие паттерны для обучения, тоже могут быть предвзяты. Кроме ошибки в распознавании черных женщин существуют и другие проблемы. Одна из них довольно неожиданная — люди сами не очень хорошо умеют распознавать эмоции.

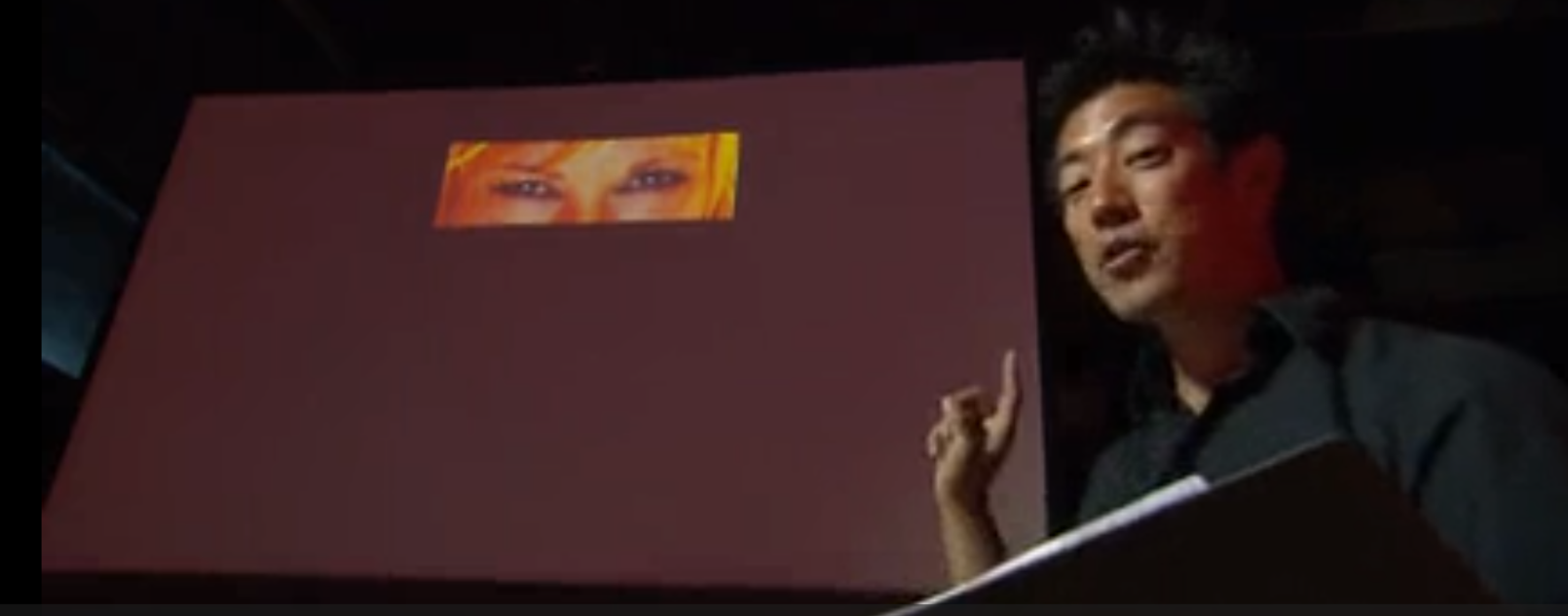

Например, 183-я серия Разрушителей легенд (5 эпизод 2012 года), где делали эмоциональные карты ведущих, а потом демонстрировали только одни глаза. С выражением злости на лице Кэри были проблемы… Взгляд описывали как игривый, завлекающий и даже постельный, но никто не распознал там именно злость.

«Если ты не можешь объяснить это за пять минут…»

Другая проблема в том, что люди вопиюще некомпетентны в любой области, которая требует длительного обучения. Знаменитый эффект Даннинга-Крюгера, который заключается в том, что человек не может объективно оценить степень своей некомпетентности, если она у него низкая в обсуждаемой области, как и определить уровень компетентности профессионала. Современная наука давно вышла за те рамки, когда любую теорию можно было объяснить за несколько минут. Фраза, что если вы не можете объяснить свою теорию пятилетнему ребенку, значит вы в ней ничего не понимаете, и разнообразные ее варианты, приписываемые всем знаменитым ученым от Айнштайна до Капицы — это журналистский фейк, и никто из современных ученых такого произнести не мог. Наиболее близка к этому фейку фраза, сказанная Ричардом Фейнманом на вступительной лекции по физике перед первокурсниками MIT. Звучит этот диалог примерно так:

— Вы такой знаменитый ученый и получили Нобелевскую премию! Пожалуйста, расскажите в двух словах, что же изучает квантовая физика?

Фейнман задумался, а потом ответил:

— Знаете что?… Наверное я не могу этого сделать, потому что у вас не хватит знания терминологии для понимания того, что я вам расскажу. Возможно это неправильно и я подумаю над этой проблемой, как без специфических терминов, понимание которых требует длительного обучения рассказать о квантовой физике, но сейчас я к этому не готов.

Я не ручаюсь за точность цитаты, но смысл был примерно такой.

Современная наука требует длительного обучения для того, чтобы просто начать немного понимать, о чем идет речь. Но обыватели, не имеющие специального образования, считают, что все просто, и для понимания генной инженерии достаточно прочитать несколько статей на условном пикабу. Увы, даже хороших статей на Хабре для этого недостаточно. Простой пример: «Почему ДНК называется ДНК»? То есть: «Почему дезокси-, почему -рибо-, почему -нуклеиновая, почему кислота?». Для правильного ответа надо уметь нарисовать молекулу ДНК по одному атому с пониманием процесса, начиная от замыкания в цикл правильного изомера 3,4,5тригидроксипентаналя и заканчивая объяснением механизма возникновения двойной спирали. При этом будет использованы следующие науки, навскидку: неорганическая химия, органическая химия, структурная химия и еще пара разделов из физической химии, аналитическая химия, и это как минимум. Все перечисленное приведет к началу изучения биохимии высокомолекулярных органических соединений и только потом можно будет сказать: «Я начинаю понимать, как работает генная инженерия», предварительно потратив год или два на изучение нескольких разделов химии.

Программирование нейросетей ничуть не проще и тоже требует высокой квалификации, чтобы начать понимать принципы их работы, что они могут, а что в принципе невозможно для них.

Но множество воинствующих дилетантов, воображая себя достаточно компетентными, разоблачают ОТО и СТО, истерят на любую хайповую тему, начиная от ГМО и заканчивая страшилками про порабощение человечества роботами из матрицы.

Очень емко об этом высказался gleb_kudr, в теме про ГМО (ну конечно же, а где еще так много хайпа?):

>Это вы хорошо сравнили меня, вроде пока в гражданских человеческих правах никто не поражал, с насекомымВы, безграмотные обыватели, сомневающиеся трусы и прочие «свободные граждане, имеющие мнение», поражаете меня в своих человеческих правах. Из-за ваших идиотских страхов, например, я вынужден был оставить идею сделать карьеру в сельхоз-биотехе, так как занимался именно ГМ культурами.

Именно из-за вас наша прикладная биотехнология отброшена на десятилетия по сравнению с передовыми странами.

Можете продолжать тешить себя правом называться человеком с большой буквы. Лично я имею право относиться к вам так, как написал.

Да, у исламистов, громящих древние статуи, небось тоже есть право на свое мнение. Будем толерантны и все такое.

Экман производит впечатление типичного американского дельца. Он сел на свой конек и активно продвигает его платежеспособным клиентам, успешно монетизируя. Военных и спецслужбы хлебом не корми, дай только собрать побольше информации обо всем и всех. А теория Экмана выглядит достаточно просто и логично, чтобы ее понял даже полный дилетант психологии, которые сидят в ведомствах типа DARPA. Тем не менее вся современная критика совершенно справедлива. Подобные «стандартные эмоции» проще и надежнее всего анализировать у младенца, потому что он еще не подвергся влиянию социальной среды, которая прививает свои нормы и паттерны поведения, в выражении эмоций в том числе. Только анализ эмоций новорожденного не продать ФБР. Казалось бы, реакция на боль — это базовый рефлекс, простая нейронная дуга, которая даже не заходит в кору головного мозга, но когда обжигается русский человек, он кричит: «Ай-яй-яй!», а француз начнет голосить: «О-ля-ля!». В одной стране жест выражающий согласия выглядит как покачивание головой вверх-вниз, в, а другой — мотание из стороны в сторону. Механизм этих жестов сложнее, чем чисто эмоциональная мимика, но тоже подвержен влиянию социума не в меньшей степени. Согласованность мимики и эмоций не настолько сильна, как утверждает Пол, а наиболее эффективно определить ложь можно с помощью анализа речи, но не мимики, что запрограммировать несравнимо сложнее.

Но для объяснения ошибки надо, чтобы оппонент был в достаточной мере образован, а это чаще всего совершенно нет так. Чего только стоят эксперименты DARPA по исследованию телепатии и других антинаучных теорий.

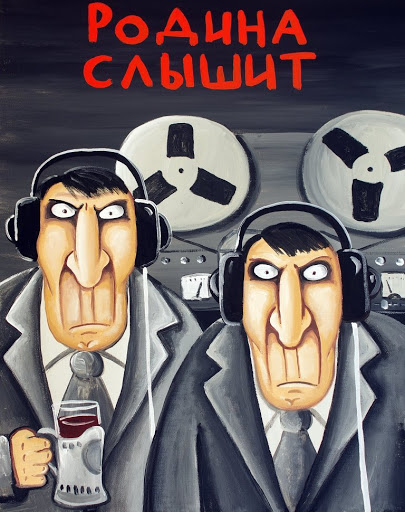

Старший брат наблюдает за тобой

В обсуждаемой статье обошлось без неграмотных нелепостей, что очень приятно, но есть ошибки другого рода.

Спецслужбам. Все. Равно.

Им нет дела до законности, их не ограничивает мораль, даже общественное давление почти ни на что не влияет. Ассанж утверждает, что дело против него было сфабриковано, а самого его недавно снова «почти не выдали» американскому правосудию. Все его обвинения ни на что особо не повлияли, как и обвинения Сноудена. ECHELON как был, так и остался, никуда не денется PRISM. Сбербанк заявлял о тестировании «кредитного банкомата», где решение о выдаче кредита будет выносить детектор лжи, основанный на голосовом анализаторе. Пограничные службы ЕС планировала внедрить детекторы лжи на основе анализа лица — прямой потомок идей Пола Экмана. К слову, решения о выдаче кредитов давно уже не принимаются лично людьми каждом конкретном случае, предварительную оценку дает компьютерная экспертная система. Только это не у всех на слуху и никто не бьет тревогу: «Мне компьютер не одобрил кредит!».

Большой брат все равно будет наблюдать и статьи типа тех, что пишет Кейт Кроуфорд, этому никак не помешают.

Так что же делать и как скрыться от неминуемой слежки и вездесущих нейросетей, пытающихся анализировать всех подряд?

Ответ простой: тренироваться!

Будь как Джейме!

Наши серверы можно использовать для любых экспериментов в AI.

Зарегистрируйтесь по ссылке выше или кликнув на баннер и получите 10% скидку на первый месяц аренды сервера любой конфигурации!