Домашний сервер, или приключение длиной в 6 лет. Часть вторая

Здравствуй Хабр!

Прежде всего я хотел бы сказать спасибо всем читателям, присоединившимся в комментариях к первой части. Честно сказать, я не ожидал, что моя статья получит подобный отклик! Я вообще в целом не был уверен, стоит ли рассказывать о своем франкенштейне, ожидал скорее даже критики в стиле: «Вот тебе делать нечего!», «Купил бы готовый NAS и не занимался бы ерундой!» и т.п.

Осторожно в статье много фото!

Кстати, если кто то собирается пойти подобным путем — почитайте комментарии к первой части статьи, там множество дельных советов!

Учитывая интерес публики, я постараюсь в этой части углубиться в детали, но прежде:

Дисклеймер: некоторая часть ПО, о котором ведется речь в статье, может быть использована на бесплатной основе только в ознакомительных целях или с ограничениями по функциональности, пожалуйста, перед использованием изучите сайт разработчика на предмет лицензирования и возможности использования ПО для вашего дома.

В первой части мы закончили на том, что ко мне приехала дисковая полка Dell PowerVault MD1000 — расскажу кратко о данном устройстве:

Dell PowerVault MD1000 — это так называемое устройство DAS или Direct Attach Storage, как понятно из названия полку нужно подключать напрямую к чему-то, к чему-то с мозгами, например к устройству, которое умеет работать с логикой систем хранения данных. Сама по себе полка не умеет ни создавать RAID-массивы, ни предоставлять диски по сети. У нее очень скудный функционал, а именно: подать питание к дискам, предоставить их внешней системе по кабелю SFF8470 (на другой стороне коннектор может варьироваться в зависимости от вашего RAID-контроллера, пропускная способность до 12 Gbit/s), охладить работающие диски посредством 4-х вытяжных вентиляторов, расположенных в 2-х блоках питания в задней части устройства, ну и подсветить красной лампочкой вылетевший диск, а зеленой работающий в данный момент. Самое умное, что есть в данной полке — это возможность подключать каскадом еще 2 такие же полки за ней. Для этого предусмотрено 2 контроллера, которые также обеспечивают дополнительную надежность работы самой дисковой полки, и в случае выхода из строя одного из них полка без перерыва продолжит работать на оставшемся.

Из минусов: данное устройство довольно старое и max скорость интерфейсов подключения самих дисков — это SAS 3Gbit/s, поддерживаются как SAS, так и SATA-диски.

Собственно, так как полка приехала ко мне поздно вечером, то первый запуск я решил сделать на следующий день. С улыбкой до ушей я кое-как уместил ее в тумбочке под телевизором, выселив оттуда детские игрушки, подключил 2 кабеля питания — по одному в каждый БП, и перевел выключатели в положение ON.

Да, кстати, у данной полки нет отдельной кнопки питания и как только вы переводите выключатель на БП в положение ON — полка сразу же начинает работать, а работа ее начинается с цикла диагностики и продувки.Что же такое эта самая «продувка»: продувка — это 30–40 секунд работы всех 4×60 мм вентиляторов на скорости в 12 000 RPM, зачем она нужна меня в принципе не волновало, так как появившуюся в дверях комнаты супругу я не слышал совсем, а она у меня довольно громкая, чтобы не услышать ее возмущение надо стоять по другую сторону от двигателя Boeing-777, с которым она в итоге и сравнила мою «новую хреновину». Тут конечно же стало понятно, что нужно срочно что-то делать — улыбки на лице у меня уже не было, да и вообще я в очередной раз начал проклинать себя за эту затею, но смирится с требованием супруги отправить дисковую полку на балкон я согласился не сразу.

Boeing 777 — 4 двигателя прям как 4 вентилятора у полки.

Стоит сразу отметить, что из-за начавшегося периода борьбы с уровнем шума издаваемым дисковой полкой я отложил идею перехода с Windows Server 2012 до лучших времен и принялся изучать документацию к полке на предмет включения тихого режима работы вентиляторов. Такового не оказалось, зато я нашел в интернете патч, позволяющий полке работать с дисками до 3-х терабайт, от этого радости было не много, но все же лучше чем ничего. Не найдя ничего дельного в официальной документации, я начал копаться в форумах и чатах. Оказалось, такой ерундой конечно же никто не озадачивался, потому что нормальные люди используют подобное оборудование в серверных/ЦОДах, ну или на крайний случай — в подвале частного дома, где шум им совершенно не мешает.

Не найдя какого-либо однозначного рецепта для дрессировки дисковой полки, я достал 2 реобаса Zalman, которые шли с каким-то из кулеров для CPU (мне кажется они были в комплекте с моими Zalman CNPS9700 LED, купленных давным-давно для прошлого ПК на базе Core2Duo E6320), кусачки, паяльник и термоусадочные трубки и принял волевое решение интегрировать их в блок питания полки, получилось следующее:

Подобные поделки мы с коллегами называли «нездоровыми экспериментами». Привет всем, если читаете!

И сам процесс:

Результат не оправдал ожидания: во-первых особо тише не стало, а во-вторых, на минимальных оборотах полка видимо догадывалась, что что-то тут не чисто, и начинала пищать на всю квартиру спикером (по моим субъективным ощущениям спикер у полки был как минимум раз в десять громче стандартного десктопного). Мне еще раз напомнили, что либо выключи ее, либо давай на балкон. Конечно же мои слабые попытки объяснить, что на балконе жарко/холодно и влажно — что плохо для техники, никакого действия не возымели, ну не вышло, так попробуем иначе!

Тут мне пришла в голову мысль, что полка видимо получает от куллера информацию о его максимальных оборотах по 4-pin коннектору, и видя, что не может его разогнать до требуемых — включает тревогу. Как мне показалось — логичным было поставить вентилятор с изначально не высокими максимальными оборотами, и раз на то пошло, то сразу один из лучших — Noctua. Оказалось, что выбор десктопных тихих 4-pin 60 мм вентиляторов мало того, что очень ограничен, так еще и цены кусались, но так как мне очень уж хотелось побыстрее начать пользоваться полкой, то я купил сразу 4 шт. Noctua 60×60x25 NF-A6×25 PWM 3000rpm за 3440 рублей (дело было 19 января 2017 года, то есть через 10 дней после получения полки).

Кстати в этом же месяце я нанял фрилансера для создания сайта для моей супруги — площадка, на которой она общалась с другими девчонками на кулинарную тематику закрывалась и она захотела взять дело в свои руки (интересно, что заметил я это лишь потому, что искал в Google Spreadsheets когда и за сколько я купил вентиляторы Noctua, тем кто занимается личными финансами/семейным бюджетом однозначно рекомендую Spreadsheets для этой цели, возможно когда-нибудь я допилю своего телеграмм-бота, через которого можно заполнять и формировать таблицы до публичного релиза).

Long story short…

С вентиляторами тоже не вышло — требуемые обороты в зависимости от температурного режима полка явно берет из своей памяти, то бишь хард-кодед параметры. Фото с установленными вентиляторами Noctua я не нашел, но есть фото процесса (резать провода на новых не дешевых вентиляторах было жалко):

В общем в оби за материалами для тумбочки я поехал уже 3 февраля 2017 года, отдав 2059 рублей за всё. Вернувшись домой, у меня ушел целый день на то, чтобы собрать из напиленного материала тумбу (про то, как мне «подсобили» в ОБИ с распилом я уже писал в первой части статьи, если бы размеры были как изначально и планировалось, то думаю потребовалось бы не более 2-х часов на сборку), собирал я ее на мебельных саморезах, предварительно просверливая отверстия обычным сверлом.

Что в прошлый раз я опустил — так это то, как я провел электричество и витую пару на балкон. Делать все красиво у меня уже не было ни сил, ни желания, поэтому я просто взял толстый 3-х жильный кабель, розетку уличного типа и вилку, просверлил балконную дверь толстым сверлом и провел оба провода.

Из отверстия зимой не дует, ничем не уплотнял, не засиликонивал, оставил всё как есть.

По коннективити стоит упомянуть мой древний свитч D-link DGS1024D, глупая железка, но со своей задачей справляется, по крайней мере в рамках домашней сети.

Провода когда то были аккуратно уложены косой и закреплены на стяжках к стене, но после каких-то перемещений оборудования что то пошло не так.

После чего сервер с полкой были перенесены из комнаты на балкон. Следующая неделя была потрачена на тесты разных конфигураций RAID, перенос данных и т.п. (по RAID я кстати остановился на конфиге RAID-10 из 14×1TB HDD и 1 диск в HotSpare). После этого и у меня наступил период охлаждения — мне не хотелось что-либо трогать довольно длительное время: на работе приехала первая в РФ AFA-СХД от Pure Storage, пришли новые сервера под резервные копии, потом отпуск, лето и т.д. В итоге о полке я вспомнил только в июле-августе, когда в очередной раз она начала истерично пищать спикером из-за жары, видимо я таки превысил критическую температуру.

Следующие полгода я периодически пытался что-то придумать на этот счет — то снова возвращался к мысли о покупке сервера 3U-4U SuperMicro, то пытался как-то улучшить охлаждение на балконе (хотел даже сделать технологические отверстия в обшивке балкона и установить туда вентиляторы для принудительной вытяжки, благо до дела не дошло), но то, что делать что-то надо — было очевидно.

Вопрос решился когда на работе списывали старое железо и мне перепал старый серверный корпус 3U то ли Procase, то ли Negorack — точно я так и не определил, а также кучка дисков по 3–6TB (кстати за время работы 1TB дисков в полке ни один диск не вылетел, даже в жару, в отличии от 3ТB, которые правда довольно долго использовались в офисе под видеозапись и были замученные до ужаса).

Тем временем дело близилось к очередному моему дню рождения и я конечно же был недоволен штатными корзинами в корпусе, поэтому приступил к изучению вариантов HotSwap корзин на рынке. В итоге выбор пал на Procase

Старая корзина крупным планом на фото справа, которая также видна на первом фото слева внизу — уже демонтирована, а новая лежит на сервере и ждет установки.

В этот момент я снова пошуршал на полках и для нового сервера уже нашлись: материнская плата Gigabyte GA-Z77X-UD3H, Intel Core i5–3470 3.2Ghz на 4 ядра, 32GB RAM. Для подключения дисков в HotSwap корзинах я взял RAID-карту LSI 9260–16i — этого было достаточно для всех 15 отсеков в HS корзинах. В качестве операционной системы наконец-то был установлен ESXi 6.5!

Хватит с меня винды, по крайней мере в виде основной ОС сервера.

Некоторое время полка жила в тумбочке с новой «головой», пока я не отмигрировал данные, старый же сервер был отправлен на шкаф.

Выглядело это так:

Как происходила миграция:

Операционная система Windows Server 2012, которая кстати жила на 120GB SSD-диске OCZ Vertex 3 доставшемуся серверу от моего ПК (после апгрейда на 240GB SSD), была перенесена со старого сервера на ESXi в виртуальную машину на RAID, собранный уже из «новых» дисков, расположенных в HS-корзинах, далее полка была так же подключена к RAID карте LSI 8888ELP, которая в свою очередь была проброшена в виртуальную машину как PCI passthrough устройство. Таким образом, я получил доступ к данным на RAID«ах собранных на дисковой полке в виртуальной машине.

После завершения всех миграций дисковая полка Dell MD1000 с дисками и старый сервер были проданы на Авито за 25 тысяч рублей вместе (покупал я ее всего год назад без дисков, с кабелем SSF за почти 27 тысяч рублей — не дешевый эксперимент получился).

Далее последовал постепенный процесс распиливания на виртуальные машины и перенос данных уже между ними, но параллельно с этим появилась другая проблема, связанная с питанием.

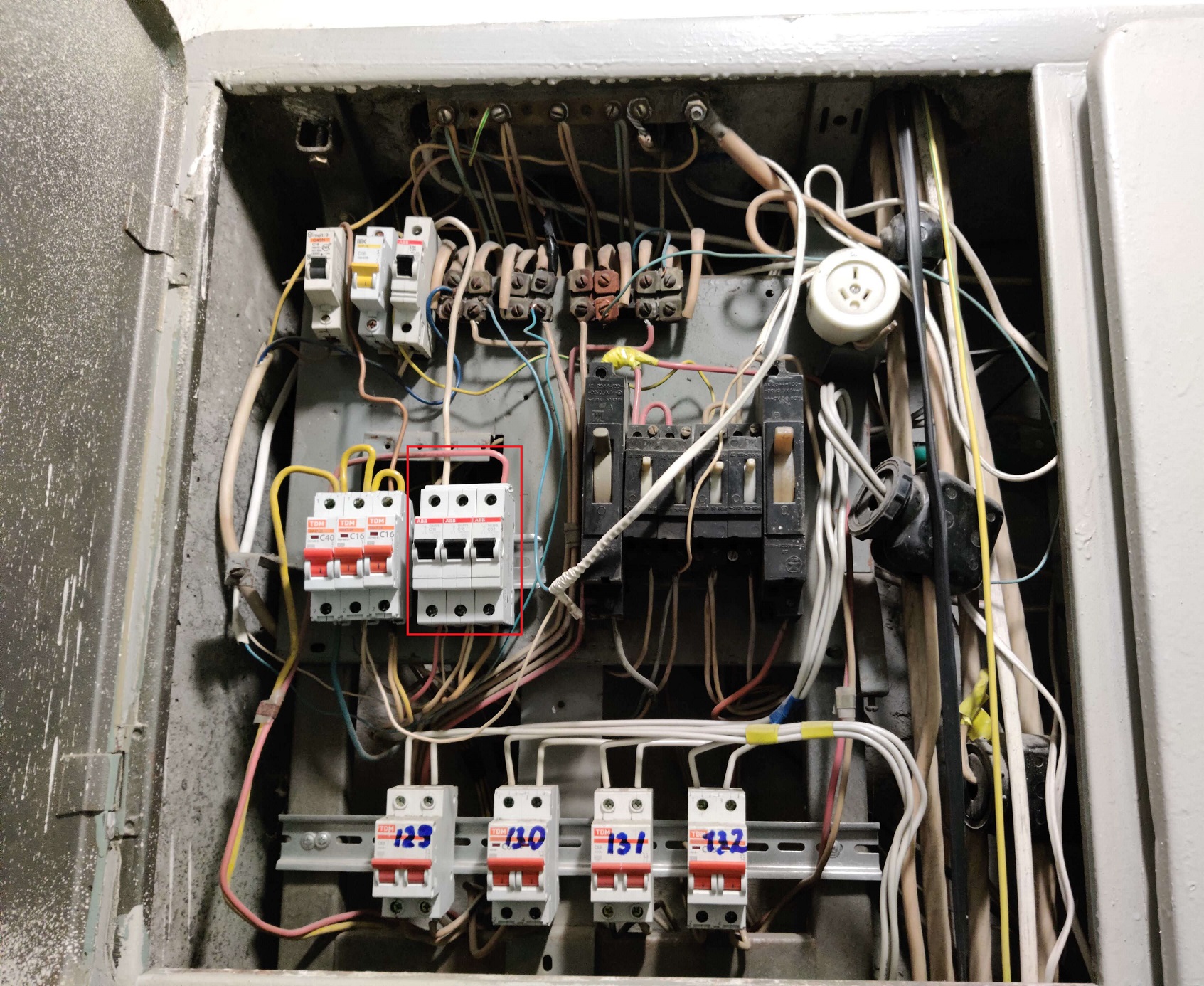

Если в двух словах — то не берите ИБП 3Cott, ожидать предсказуемого результата от них нельзя. Проблема с электропитанием была обусловлена тем, что я проживаю в относительно старом многоэтажном доме и автомат, установленный в щитке, был датирован 1987 годом выпуска, причем выбивало его крайне рандомно (позже я нашел закономерность между температурой окружающей среды и его срабатыванием).

Моя группа УЗО датированная 1987 годом.

Классический простой УЗО — устройство защитного отключения (в народе автомат), срабатывает при разности токов в нулевом проводе и фазе, соответственно при изменении температуры окружающей среды порог срабатывания меняется (физика она такая) и в жару он становится намного ниже.

В общем летом чайник+микроволновка+2 ПК+сервер+всякая мелочь равнялось бац. Пару раз воскресив то одну то другую виртуалку, то потратив пол дня для восстановления MongoDB, я начал ругаться с жэком (или как они там сейчас называются). Приходило 2 электрика из жэка, с умным видом осматривали щиток и говорили, что нужно меньше электроприборов включать, но меня это не устраивало и вскоре я приобрел ИБП 3Cott 2200-HML 2200VA за 5740 рублей (+299 руб. доставка). Это было 2 июня 2019 года и у меня уже было 2 ИБП 3cott меньшей мощности, к которым были подключены 2 домашних ПК, и особых нареканий на них не было, по крайней мере на тот момент (чуть позже в одном из ИБП просто лопнула батарея, а второй начал чудить — то ему мерещился перегруз, то просто начинал попискивать ни с того ни с сего).

Буквально через пару дней свеже приобретенный ИБП должен был спасти сервер от очередного выключения из-за сработки УЗО. ИБП как водится начал истерично пищать при переходе на питание от батареи, я переключил автомат в рабочее положение, но вернувшись к ПК обнаружил, что сервер не работает. Далее последовало 3 недели тестов ИБП, то он все-таки срабатывал ожидаемо, то опять оборудование за ним выключалось и в итоге я пришел к выводу, что время переключения на питание от батареи в нём не стабильное (исходя из технических характеристик модели ИБП запас по мощности был почти 10-кратным). Пошарив по форумам я нашел подобные проблемы от ИБП 3cott, Crown и прочих бюджетных брендов — еще 6 тысяч рублей на ветер.

Не берите эту пародию на ИБП.

Промучавшись с этим ИБП довольно длительное время, в моей голове окрепла мысль, что ремонт сервера будет точно дороже чем решение вопроса с УЗО и я не придумал ничего лучше, чем заказать замену УЗО в МосЭнерго (сюда пожалуй хорошо зайдет такой капитальный фейспалм). По телефону стоимость они как водится не проговаривают и звучат фразы в стиле «мастер на месте будет решать в зависимости от сложности замены» и т.п., а на месте уже начинаются пляски и цирковое шоу, ну да ладно — замена 3-х автоматов «под ключ» от сотрудников МосЭнерго (точнее очередного партнера как водится), обошлась мне аж в 6500 рублей — да аппетиты у наших крепких хозяйственников не знают границ.

Как видите изменилось не много, но жить стало намного лучше.

После замены автоматов действительно стало несравнимо лучше — теперь можно включить половину электроприборов в квартире и только после откровенного перебора (а-ля 3 кондиционера, микроволновка, посудомоечная машина и чайник + мелочь в виде 2х ПК, сервера, телевизора) автомат срабатывает, но так как супруга несколько раз все же добилась подобного, то был докуплен еще один ИБП, но в этот раз Ippon Smart Power Pro II Euro 2200, кстати совсем недавно — 26 октября 2020 года, за 13 589 рублей, и вот это уже совсем другое дело в плане надежности.

Работает нормально, по крайней мере пока что.

Интерфейс конечно из 2000х, но лучше чем никакого.

ПО вроде как даже умеет отправлять сигнал на выключение для VMWare Esxi, но в бесплатной версии ESXi закрыт доступ к API, да и я как-то не проверял данную возможность, пока что не было необходимости/времени.

ИБП установлен под столом у супруги, подключен к ее ПК по USB где и работает ПО для мониторинга ИБП. По замерам ваттметра текущая конфигурация потребляет всего лишь 260 ватт с учетом ИБП, что в день равняется примерно 29 рублям по текущим тарифам в Москве, в месяц получается не более 1000 рублей со всеми погрешностями. Когда я делал замеры с дисками меньшего объема и без ИБП среднее значение было ~170 ватт.

Пока я разбирался с питанием и периодически воскрешал виртуальные машины или спасал из них данные, в сервер приехало несколько дисков по 6TB и парочка на 8TB. Все просто 6-ки и 8-ки заменили на работе на 12TB — там такие объемы данных, что брали максимально доступные диски, кстати есть красивое фото:

HGST 12TB каждый.

Это офисное добро — для дома было бы слишком не бюджетно, у меня автомобиль дешевле стоит.

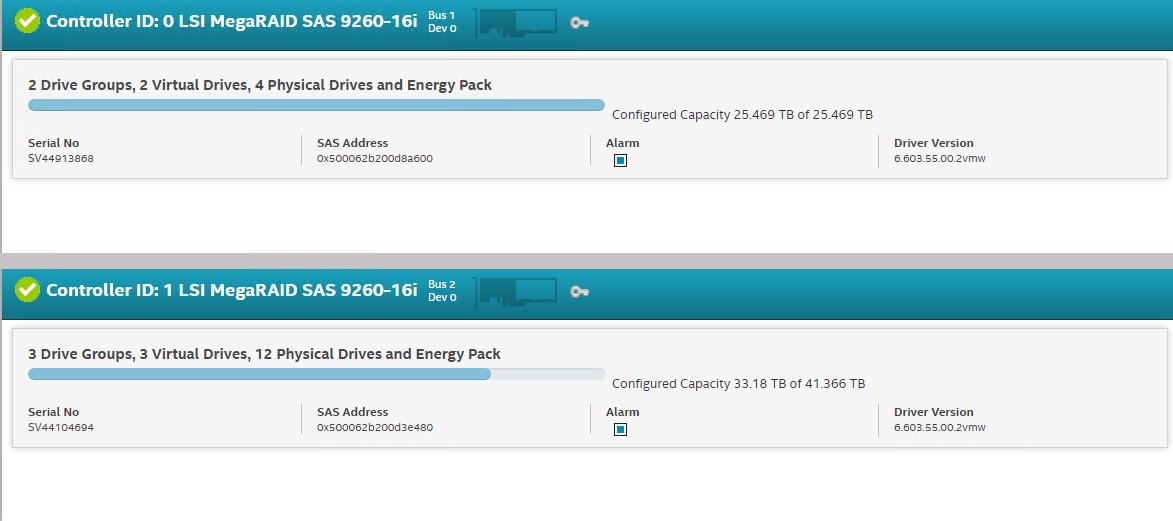

Плюс мне привалил еще один RAID-контроллер LSI 9260–16i — он был списан и заменен на HBA карту LSI 94… уже не помню, но я был крайне рад! Опять же у меня в руках теперь был резервный контроллер, можно было при необходимости провернуть такой же фокус, как в прошлую миграцию — с пробросом внутрь виртуалки, да и вообще добро не пропадет. Бонусом к нему шло 2 батарейки LSI (а это значит Write-Back Always режим доступен всегда!) и пару замученных SSD Intel 240GB для CacheCade. Кратко о технологии CacheCade — это использование ssd дисков в качестве кэширующего уровня для рейд контроллера, получается некий tier 1 для горячих данных перед рейд массивом из HDD, естественно назначать для кэширования можно определенные пулы дисков что бы например не кешировать CCTV которое и так неплохо пишется на RAID из HDD и при этом не забивает SSD кэш.

Плюс я установил два 80 мм вентилятора в корпус на выдув и добавил на стяжках дополнительный вентилятор на процессорный кулер, нормальный башенный в данный корпус к сожалению не влезает.

В общем железом я обложился как мог.

Что же вышло в итоге по железу:

Intel Core i5–3470

32 GB RAM DDR3

2x RAID Card LSI SAS 9260–16i

1x SSD 240GB под быстрые данные (без RAID)

Raid card №1:

2x HDD 8TB RAID1

2x HDD 6TB RAID1

Raid card №2:

2x SSD 240GB RAID1 CacheCade pool

4х HDD 6TB RAID 10 + 1 HDD 6TB HotSpare

4х HDD 3TB RAID 10 + 1 HDD 3TB HotSpare

В итоге полезного места: ~29,31 TB

Софт у LSI редкое фу фу фу, особенно при работе в gui с винды на контроллер установленный в ESXi.

По софту:

ESXi 6.7 (update 3)

10 Виртуальных машин.

Из которых 5 это «продакш», остальные лаба.

В «Проде»:

CentOS7-Pi-hole

CPU x1

RAM 1GB

Виртуальная машина на операционной системе CentOS7 с докером, в котором поднят блокировщик рекламы на программном обеспечении Pi-Hole, основная цель: уменьшить количество рекламы на планшете у дочери и на телевизоре. Справляется со своей задачей довольно средне — сколько бы я не пробовал списков блокировки на youtube и в андройд-приложениях полностью удалить рекламу не получается, но при этом страдают все возможные реферальные ссылки, промокоды, и прочие, иногда нужные элементы. Так же в соседнем контейнере до недавнего времени жил DNScrypt, но после обновления прошивки роутера (Xiaomi R3G) этот функционал я перенес на него. Про adblock для планшета на андройде я знаю, он так же установлен, но хотелось централизованного контроля над рекламой.

UBNT-NVR-Debian9

CPU x2

RAM 6GB

За последние 2 года я полностью отказался от камер D-link и постепенно купил 7 камер Ubiquiti — 5 штук UniFi UVC G3 Dome и 2 UniFi UVC G3 Bullet (они конечно ппц не дешевые, но для чего еще нужны дни рождения =))). Камеры D-link меня не устраивали ни качеством звука, ни картинки, да и постоянные отваливания надоели — раз в 2–3 недели одна камера рандомно отваливалась, лечилось это только перезагрузкой, так, в какой-то момент, я чуть было не выкинул свой гигабитный свитч D-link т.к. грешил сначала на него. Но, как позже выяснил, одна из камер D-link примерно раз в месяц вешала всю сеть — переставало работать всё, а на ПК в консоли управления адаптерами на интерфейсе отображалась неопознанная сеть, лечилось это перезагрузкой проблемной камеры и свитча. Собственно на данной VM установлен только Unifi controller — я пробовал запускать его в Docker, но ничего хорошего не вышло. На записи у меня отведено 2,5TB — этого объема хватает для архива примерно на 5 месяцев записи в режиме «запись при движении» с 7 камер в full HD.

Я многократно был рад тому, что есть запись за длительный период — всегда можно найти нужные события или восстановить последовательность своих же действий, дабы найти куда же я положил этот проклятый %нужный предмет%.

WS-2016-FS

CPU x1

RAM 2GB

Storage ~5TB

По сути сервер-помойка, остался от процесса промежуточной миграции части сервисов на Linux. Когда-нибудь у меня до него дойдут руки и я его разберу на части. Сейчас он используется под хранение фото, раздачу старых закачек на deluge (да да, я тот человек, который остается на раздаче даже очень древних торрентов).

Особенность хранения фотографий в моем случае заключается в размере папки с семейным архивом (фото+видео) ~2,2TB, папки фото постоянно синхронизируются в двунаправленном режиме:

Сервер ← → ПК супруги

Сервер ← → Мой ПК

Помогает мне в этом програмка syncthing, я использую вариант с GUI SyncTrayzor, как только софтинка видит изменения в файловой системе она тут же начинает процесс синхронизации. На стороне обоих ПК стоят так же SyncTrayzor«ы в которых настроено какие папки кому отдавать и принимать.

Так же как оказалось удобно настроить аналогичную синхронизацию со смартфонами, фото моментально оказываются на домашнем сервере, а если надо удалить со смартфона фотографии старше скажем 3-х месяцев, то мы просто вырезаем из папки в которую настроена двунаправленная синхронизация старые фото (конечно же это так же можно заскриптовать) и переносим их в архив в другой папке, откуда они уже синхронизируются между ПК.

Если упрощенно то структура примерно такая:

|

|-- Фотографии

|------ Архив с телефона

|---------- Мой смартфон

|---------- Смартфон супруги

|

|-- Мой смартфон

|-- Смартфон супруги

На всякий случай я так же сохраняю резервную копию важных папок с рабочего ноутбука, естественно то, что не попадает под NDA, но то что необходимо для работы и в случае выхода из строя ноута нужно будет быстро восстановить на новом.

Опять же некоторые кейсы оказалось проще решить синхронизацией, чем договориться с пользователем, поэтому на всякий случай синхронизируются рабочие области упрямого юзера, такие как рабочий стол и корень диска.

По итогу набралось почти 5TB данных.

WS-2016-FF-bak

CPU x1

RAM 2GB

Storage ~240GB

Данная машинка у меня выделена полностью под резервные копии веб-сайта, созданного для хобби супруги (кулинарная тематика).

Резервное копирование происходит по схеме:

WebHosting→ Dropbox → VM

Не самый лучший вариант, знаю, но настроил давным давно и работает без особых проблем.

Самый большой вопрос к данному серверу возникает у меня когда речь заходит о размере данных. Так как я сохраняю практически одинаковые архивы, то для эффективности использования дискового пространства я пользуюсь технологией дедупликации данных на уровне блоков файловой системы!

Скрин для лучшего понимания эффективности данной технологии.

Обратите внимание на коэффициент сжатия:

Диски V и W полностью дублируют друг друга для лучшей надежности (полетит файловая система на одном диске, есть второй), данные на них копируются из первичного местоположения, что исключает возможность получить битые архивы при синхронизации дисков из-за повреждения системы дедупликации.

В данный момент я искренне прошу подсказать мне аналогичное решение на Linux, т.к. все мои тесты и попытки собрать что-то аналогичное на zfs или btrfs не увенчались успехом, я уверен что на Linux можно найти вариант.

CentOS7-Plex

CPU x2

RAM 2GB

Storage ~4TB

Собственно Plex Media Server о котором мы ранее уже говорили — в комментариях к первой части статьи есть многочисленные рекомендации альтернативных вариантов, кому интересна идея организации собственного медиа-сервера обязательно загляните в комменты.

За исключением некоторых неудобств, связанных с требованиями к наименованию файлов, данное решение меня полностью устраивает. Дочь сама уже умеет переключать пультом от телевизора плейлисты с сериалами, полнометражные мультфильмы и т.п. А — автоматизация =))

Остальные виртуальные машины у меня имеют временный статус — там есть и дженкинс, как в контейнерах так и standalone, и NodeRed (штук 5–6 контейнеров) — ПО для автоматизации и визуализации IoT, API, и т.п. Я кстати очень активно его использовал для эмуляции всевозможных датчиков, счетчиков электричества, воды, света, станций детекции утечек и концентрации газов, датчиков Холла, созданием GUI для отображения графиков с IoT-устройств. Со всем этим мне посчастливилось поработать в рамках моего трудоустройства в Nokia corporation, ага, они не только мобилки делают, и ответ на самый часто задаваемый вопрос «А они что еще живы?» — да, очень даже живы! Смартфоны, как вы знаете, сейчас они не производят, зато IoT и 5G у компании сейчас в приоритете. В общем в лабе творится всякая вакханалия доступная в рамках оставшейся оперативной памяти и CPU.

Температурный режим.

В сентябре с алиэкспресса ко мне приехали Xiaomi Mijia Bluetooth Thermometer 2, один из которых я пристроил рядом с сервером.

Xiaomi Mijia Bluetooth Thermometer 2 в серверной тумбочке.

Статистика пока что довольно скудная, но общее представление об окружающей сервер температуре на балконе составить можно. Посмотрим конечно, что будет летом, но сейчас там все хорошо.

Планы на когда-нибудь….

Отмигрировать WS-2016-FS полностью на Linux.

Найти надежное решение с дедупликацией на уровне блоков файловой системы на Linux и отправить туда резервные копии сайта, и как следствие — избавиться от WS-2016-FF-bak.

Также в планах собрать что-то для управления умным домом — в данный момент у меня есть несколько устройств от Xiaomi с хабом gateway v3, который, насколько я знаю, не имеет режима разработчика и как следствие обращаться из внешней системы без танцев с бубном не получится, в общем есть планы на изучение этого вопроса. А с учетом некоторого опыта работы с NodeRed хочется создать дашборд с кнопками для наиболее востребованных сцен/скриптов для IoT.

Доразобраться-таки с блокировщиком рекламы на всю сеть Pihole или аналогичным (я еще пробовал Adguard Home — практически тоже самое что и PiHole), либо отказаться от него совсем.

Вероятно таки купить настоящую серверную платформу, а-ля supermicro с KVM over IP, с интегрированными корзинами, 2-мя CPU, кучей RAM, блэкджеком и всеми подробностями. (Но на этот ДР пролетаем — я уже купил себе стол с изменяемой высотой на 2-х электродвигателях, классно, но не дешево).

Материал получился гигантским, но делить его пополам, как мне показалось будет не честно, так как в комментариях к первой части я обещал раскрыть все подробности во второй, да и провести условную черту где-то посередине не нарушая повествования у меня не получилось.

Большое спасибо всем дочитавшим до конца!

На самом деле получив такой активный отклик к первой части у меня снова появилось желание заняться своей домашней поделкой и довести ее до следующей итерации, на целую интересную статью скорее всего я отважусь не скоро, но вероятно продолжение следует…

До следующей встречи Хабр!

Ну и напоследок несколько фото текущего состояния железяки:

P.S. Так же видя количество вопросов и советов к первой части, предлагаю всем желающим энтузиастам объединиться в свеже созданной Телеграмм группе @HomeServerAdvices, где можно будет накидать ссылок на полезные ресурсы по тематике и обмениваться советами в реальном времени и задавать глупые вопросы.