DellEMC Unity 400F: небольшое тестирование

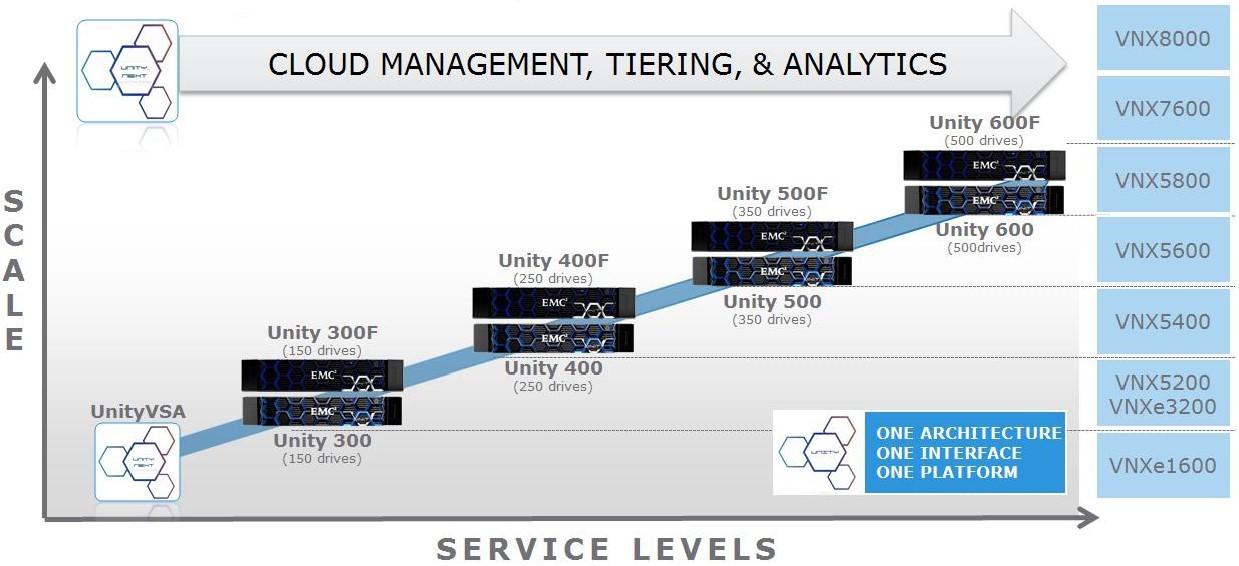

А DellEMC утверждает, что новое поколение по крайней мере в 3 раза производительнее, чем VNX2.

Если интересно, что из всего этого вышло, то…

Описание стенда и теста

На массиве Unity 400F был создан пул в конфигурации Raid5 (8+1). На пуле разместились два тестовых LUN, которые были подключены к серверам. На LUN-ах были созданы файловые системы NTFS и тестовые файлы размером 400GB, что бы исключить влияние кэш контроллеров на результат.

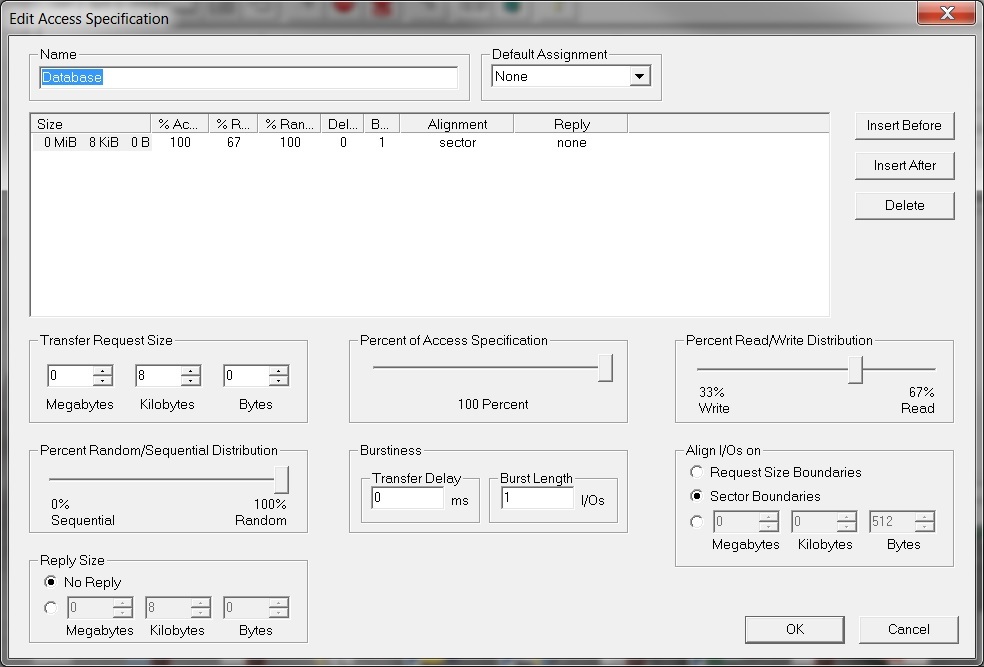

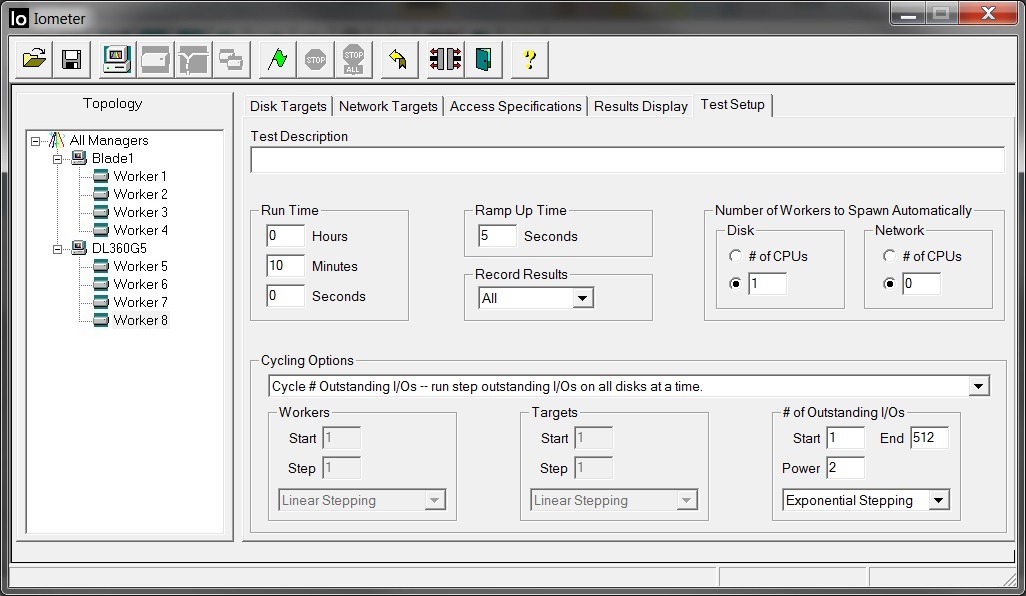

Настройки в IOMETER при этом выглядят следующим образом:

Т.е. на каждом сервере работало по 4 worker-а (всего 8), на которых на каждом последующем этапе тестирования двухкратно увеличивалось количество потоков ввода\вывода. Таким образом на каждый worker последовательно 1, 2, 4, 16, 32, 64, 128, 256, 512 потоков. А всего на массив приходилось на каждом этапе по 4, 8, 16, 32, 64, 128, 256, 512, 1024, 2048, 4096 потоков.

По традиции немного расчетов

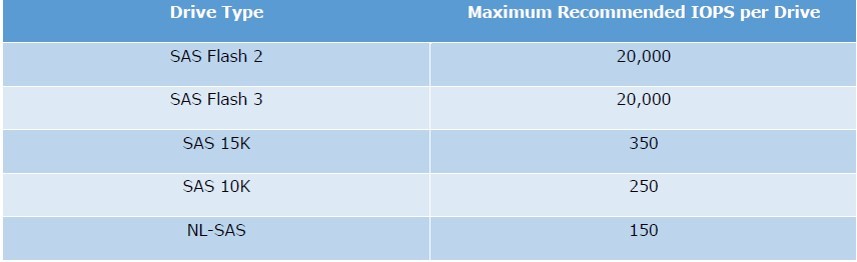

DellEMC при расчетах производительности рекомендует для SSD дисков использовать максимальное значение в 20000 IOPS.

То есть максимально в теории наши 9 дисков могут выдать 20000×9=180000 IOPS. Нам необходимо посчитать сколько IOPS получат с этих дисков сервера, с учетом нашего профиля нагрузки. Где соотношение чтения/записи в процентном отношении составляет 67%/33%. И еще нужно учесть накладные расходы на запись в RAID5. Получаем следующее уравнение с одной неизвестной 180000=X*0.33*4+X*0.67. Где X это у нас те IOPS, которые получат сервера с наших дисков, а 4 — это размер «пенальти» на запись для Raid5. В итоге получаем в среднем X=180000/1.99= ~90452 IOPS.

Тест и Результаты

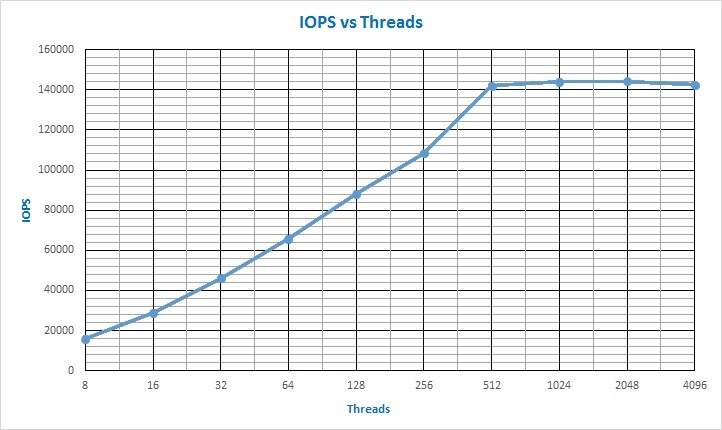

В результате теста у нас получилась следующая зависимость IOPS от количества потоков I/O:

По графику хорошо видно, что насыщение наступило при 512 потоках I/O на тестируемые LUN-ы и при этом было достигнуто значение примерно в 142000 IOPS. Если посмотреть на тестирование VNX5400, то видно, что даже при тестировании кэша контроллеров, максимальные значения по IOPS не превышали порога в 32000 IOPS. А насыщение массива VNX5400 по вводу/выводу наступало примерно на 48 потоках. Тут еще нужно отметить, что один сервер HP DL360 G5, в описанной выше конфигурации, выдавал в максимуме около 72000 IOPS. После чего упирался в 100% загрузки CPU. Почему собственно и пришлось искать второй «вычислитель».

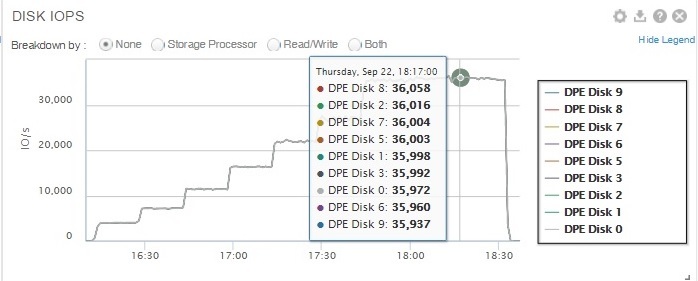

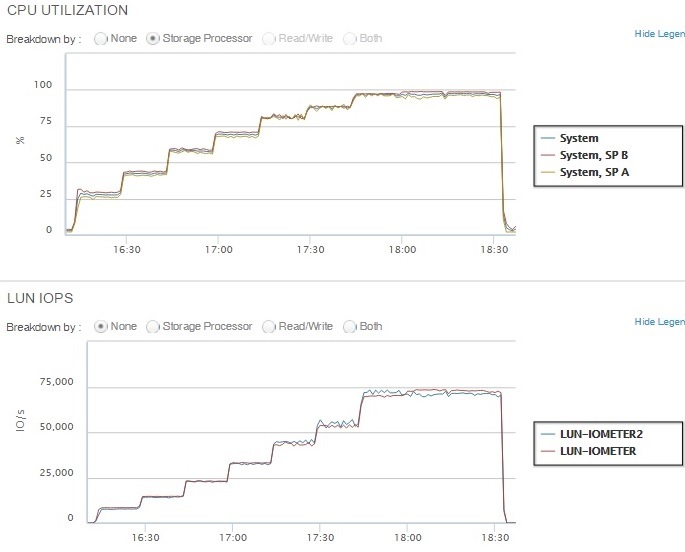

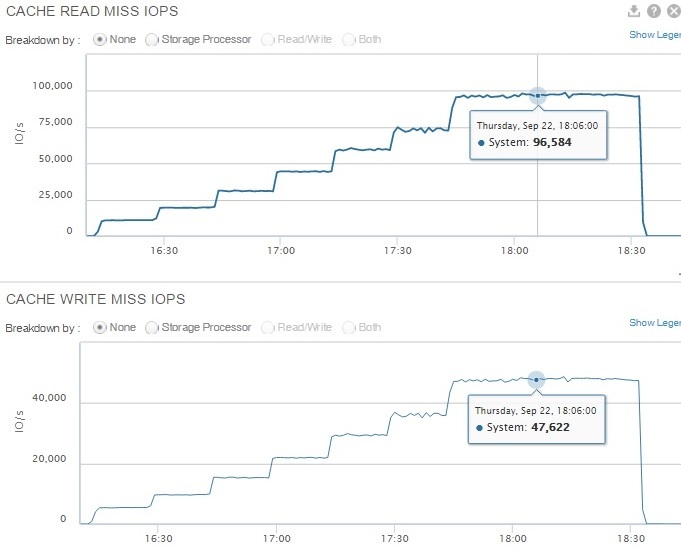

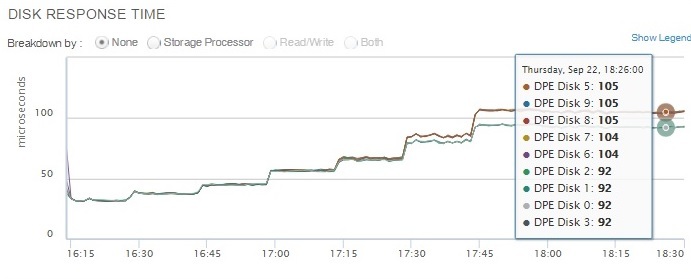

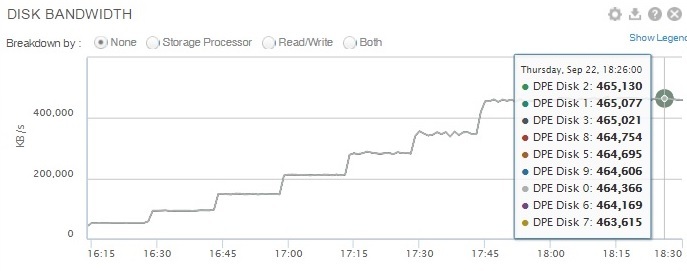

У Unity есть не плохой функционал сбора статистики производительности по различным компонентам массива. Так например можно посмотреть графики нагрузки по IOPS по дискам массива (по каждому в отдельности или сразу по всем).

Из графика видно, что в максимуме диски выдают «несколько» больше, чем значение, которое рекомендует брать вендор при расчете производительности.

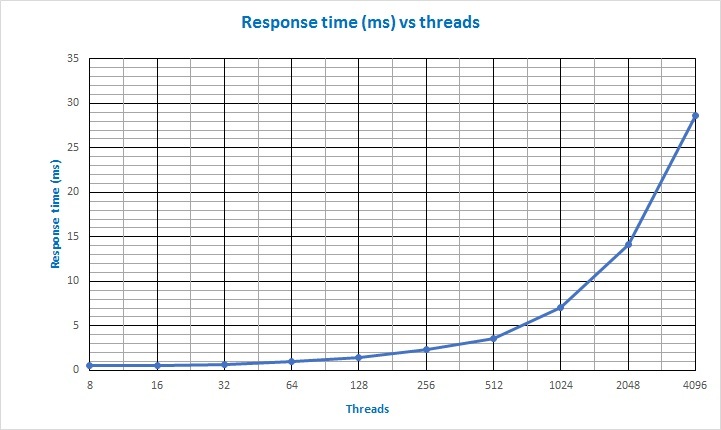

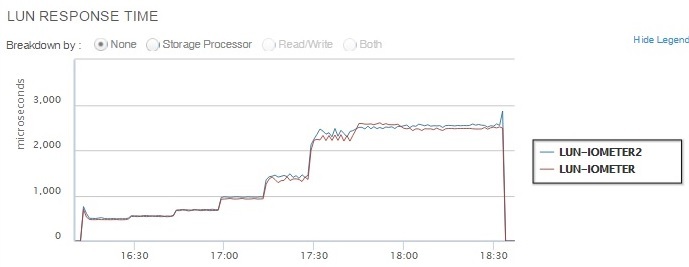

Время отклика на тестируемой конфигурации Unity росло следующим образом:

Т.е. даже в «точке насыщения», когда при увеличении количества потоков IOPS-ы перестают расти (512 потоков), время отклика не превысило 5ms.

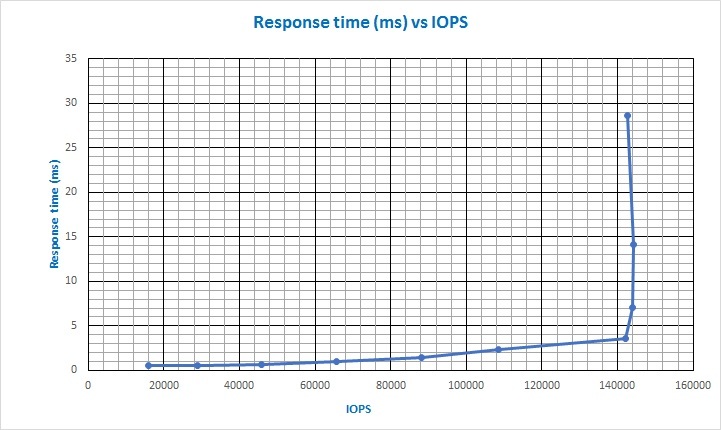

Зависимость времени отклика от количества IOPS.

Опять же если сравнивать с временем отклика при тестирования кэша контроллеров на VNX5400, то можно увидеть, что на VNX5400 время отклика в 1ms достигалось уже примерно при 31000 IOPS и около 30 потоках ввода/вывода (и это фактически на ОЗУ). На Unity же на SSD дисках это происходит только при ~64000 IOPS. И если в нашу Unity добавить еще SSD дисков, то эта точка пересечения с значением в 1ms на графике сдвинется намного дальше по шкале IOPS.

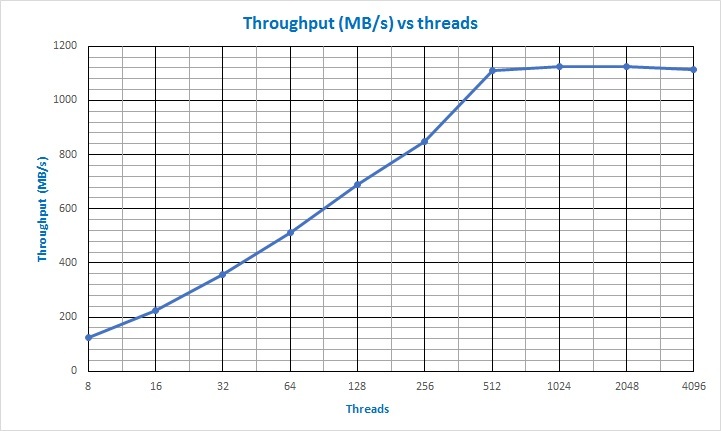

Зависимость пропускной способности от количества потоков ввода/вывода:

Получается, что массив принимал и отдавал потоки пакетов размером по 8KB на скорости около 1TB/s (терабайта в секунду).

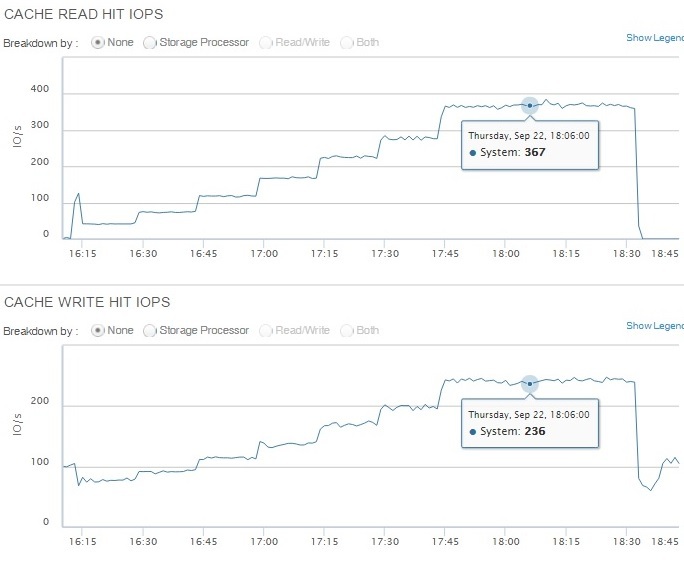

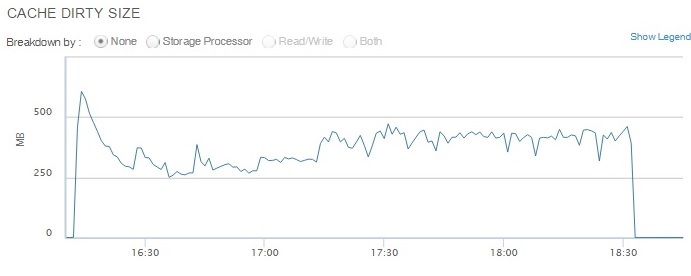

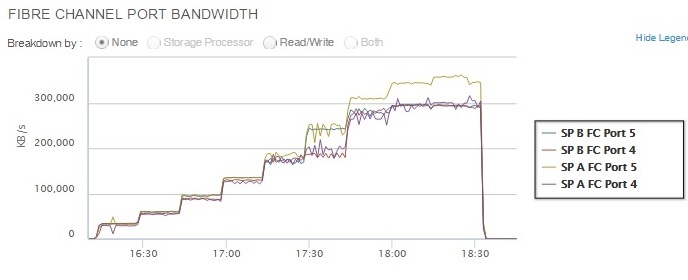

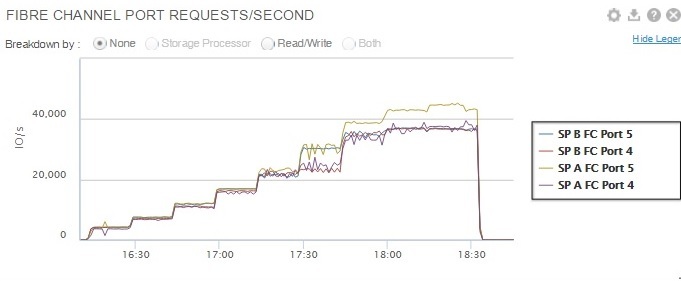

Да бы не утомлять читателя, ряд графиков производительности различных компонентов массива Unity 400F упрятано для любопытных…

Ссылка на файл с исходными данными IOMETR-a.

Выводы

Выводы я думаю каждый сделает для себя сам.

Как по мне, так на рынке появилась новая интересная система хранения, которая даже при небольшом количестве SSD дисков показывает высокую производительность. А если учесть доступные сейчас размеры SSD (а у DellEMC для Unity уже доступны SSD диски объемом 7.68 TB и в ближайшее время должна появиться поддержка 15.36TB SSD), то думаю, что в ближайшие несколько лет гибридные массивы со смесью SSD и шпиндильных дисков станут историей.

P.S. Для любителей задавать вопросы «сколько это стоит?». В своих презентациях вендор указывает, что ценник на Unity F (All Flash) начинается от 18k$, а для Hybrid конфигурации от менее чем 10k$. Но так как презентации все «буржуйские», то в наших российских реалиях ценник может отличаться. В любом случае лучше уточнять в каждой конкретной ситуации у местного вендора или его партнеров.

Комментарии (2)

14 октября 2016 в 09:53

0↑

↓

Unty 400F в конфигурации с 10 SSD дисками на 1.6TB каждый.

ценник на Unity F (All Flash) начинается от 18k$

То есть это цена за шасси, без дисков?14 октября 2016 в 09:58

0↑

↓

Нет, я думаю вендор имеет в виду цену за шасси с минимальным набором дисков. Для Unity F это как раз 10 дисков, насколько я знаю. Исходя из рекомендованной конфигурации для SSD Raid5 (8+1) и плюс 1 SSD как HS. Без дисков массивы у EMC никогда не продавались, не считая уже не существующей линейки NAS-систем Iomega.