Big data, deus ex machina

Источник

«Данные — это новая нефть». Эту фразу на выступлении для PopTech произнёс несколько лет назад Джер Торп (Jer Thorp), художник и эксперт в вопросах анализа и визуализации данных, один из основателей «Бюро креативных исследований». Сегодня мы хотим поговорить не просто о данных, а о больших данных. Разбираемся, какие данные big, а какие нет, как они работают и как на этом зарабатывает бизнес.

Эта статья вдохновлена нулевым выпуском подкаста «Завтра облачно». Слушать на iTunes, ВКонтакте, на Soundcloud.

От data к big data

Давайте разберёмся, какие бывают данные. У компаний есть IT-инфраструктура, они используют разные приложения: CRM, корпоративную почту, файловые хранилища и так далее. Иногда предоставляют какие-то сервисы для внешних клиентов. Данные постоянно перемещаются из одного хранилища в другое, попадают к разным пользователям, копируются, видоизменяются, фильтруются. Так вот: даже если всего этого много — это ещё не big data, это просто данные.

А вот если про каждый фрагмент этих данных известно, кто и когда их создал, отправил, переслал, изменил, как часто открывал, сколько времени просматривал, если можно автоматически делать срезы этих данных по пользователям, по времени, по каким-то самым фантастическим параметрам — вот это уже большие данные. Как вы понимаете, они возникают только в такой IT-системе, которая вообще способна сохранять все эти «данные о данных» в привязке к самим данным.

Итак, big data — это данные о данных. То есть, данные + их метаинформация, логи. Big data знает, как вело себя каждое звено в цепи событий, которые происходили с каждым файлом, видео, картинкой.

И сразу скажем, если большие данные кому и по зубам, то только алгоритмам машинного обучения, нейросетям. То есть big data — это хлеб машинных алгоритмов.

Big data — данные о данных

«Атомы», из которых состоят большие данные, можно увидеть на уровне простых граждан, «b2c-пользователей». Вот смотришь ты видео на Youtube, а под ним отображаются метаданные: создатель, дата создания, реакции пользователей. Если сложить вместе все видео и их метаданные (что сам Youtube, конечно, легко может сделать), то получится big data, из которой можно узнать много интересного. К слову, в разделах аналитики видеосервиса сами «ютуберы» могут посмотреть небольшие срезы из этих данных про свои видео.

Лилу говорит: «Не данные, Большие данные! «Источник

Но вернёмся к бизнесу. Мы обещали рассказать, как big data позволяет зарабатывать деньги. Вот конкретные примеры.

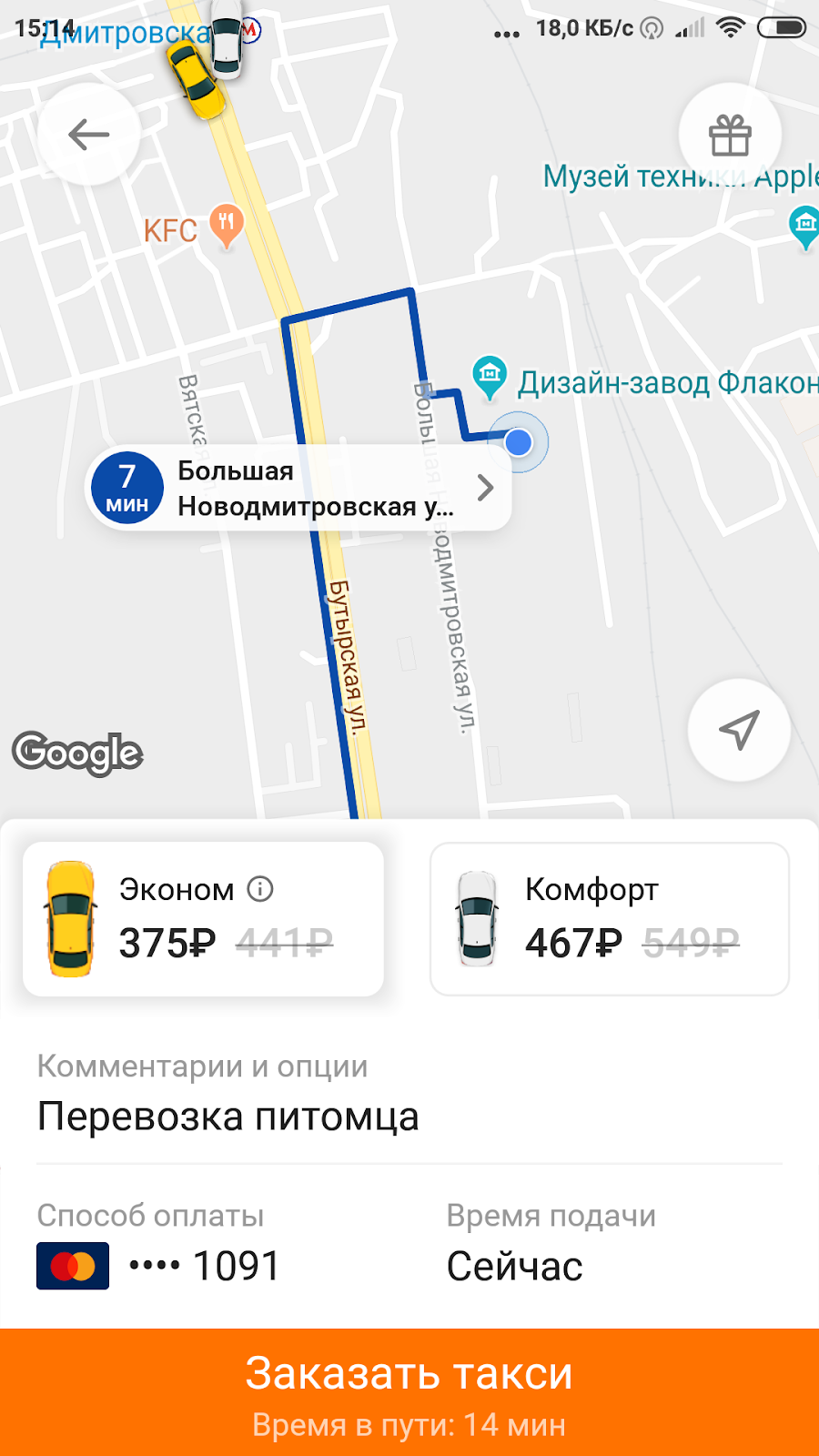

«Ситимобил» — как подать машину вовремя, чтобы все остались довольны

Такси-сервисом «Ситимобил» может воспользоваться любой, у кого в смартфоне установлено одноимённое приложение. Водители и потенциальные пассажиры взаимодействуют друг с другом через онлайн-диспетчерскую. Информация, которую она получает и анализирует, это и есть big data.

У диспетчерской есть конкретная задача: сделать счастливыми всех на свете — пассажирам предложить цену меньше, чем у конкурентов и у себя же вчера; водителям — предложить оплату больше;, а себе заплатить за всю эту систему, её эксплуатацию и рост. Задача по определению противоречивая и требующая оптимизации на основе моря данных.

А данные такие. Мы знаем местоположение водителя и пассажира, их удалённость друг от друга, количество отказов и успешно завершённых поездок. Знаем погоду здесь и сейчас, прогноз погоды на ближайшее время и ещё много других факторов. Всё это помогает предложить цену для пассажира в виде тарифа «Ситимобил» и оплату водителю, которая его устроит. Если копнуть глубже, то окажется, что рассчитывается несколько вариантов, например, с учётом погоды или местоположения, на основе которых будет вычислено какое-то среднее значение, самый выгодный для пассажира и водителя коэффициент.

Попутно нужно решить ещё одну задачу: правильно распределить водителей между потенциальными клиентами. Ведь не всегда водитель, который находится ближе всего, будет оптимальным выбором с точки зрения сервиса.

«Ситимобил» делает хорошо.

В случае «Ситимобил» big data — это большая выборка данных о поездках. В ней есть информация о том, где находятся клиенты и водители, какой у них опыт поездок, как стоимость раньше зависела от погодных условий и какими были результаты предыдущих расчётов стоимости. Получается, что основная роль больших данных в этом случае — помочь оказать услугу максимальному количеству клиентов и задействовать при этом все доступные автомобили.

Как связать пользователей «Ситимобил» и Delivery Club

В Mail.ru Group данные хранятся и обрабатываются на единой платформе, к которой привязаны все бизнес-юниты. Соответственно, данными, которые получил один сервис, может воспользоваться другой, тоже подключённый к платформе. Вот как это работает на примере такси «Ситимобил» и доставки еды Delivery Club, которые входят в Mail.ru Group.

У Delivery Club есть база клиентов, среди которых можно найти самых активных: они часто заказывают доставку еды и тратят на это крупные суммы. Легко сделать вывод, что это люди платежеспособные, но занятые. Значит, им может подойти такси «Ситимобил», им можно предложить купон на бесплатную поездку, которым они с высокой вероятностью воспользуются, а там — как знать — может быть, станут постоянными клиентами. Именно big data помогает «угадать», кому лучше показать предложение бесплатно протестировать новую услугу.

Другим пользователям подобные предложения рассылать нерационально: они им интересны с меньшей вероятностью, а мы все знаем, как раздражает реклама, которая «не попадает». И чем лучше работает big data, тем точнее таргетирование.

Big data в рекламе: вы видите то, что точно захотите купить

Собственно, это продолжение предыдущего примера. В задачах таргетирования рекламы — то есть, показывания её кому нужно — машинные алгоритмы и big data начали применяться едва ли не в первых рядах. Когда мы смотрели рекламу только по телевизору, рекламодатели плохо могли оценить её эффективность, разве что устраивать холодные обзвоны. С появлением интернета всё изменилось, и скрыться от онлайн-рекламы стало невозможно: она «смотрит» на нас из любого приложения и сайта в компьютере или смартфоне.

Насколько точно она попадает в цель? Иногда не очень. Замужним предлагают услуги брачных агентств, купившим мультиварку — ещё мультиварку. Серьёзно, кому нужна вторая мультиварка? А кто целый год принимает решение о покупке книги, дрели или развивающей игрушки для трёхлетки?

Да, машинам ещё нужно учиться, но получается у них всё лучше. Вспомните хотя бы историю про девочку-подростка, беременность которой супермаркет вычислил быстрее, чем она сама и её родители. Да, вначале был скандал, но в итоге супермаркет оказался прав! В общем, 60% американских маркетологов-руководителей верят в ИИ и делают на него ставку в персонализации коммуникаций с покупателями.

Итак, цель таргетирования — показывать рекламные объявления так, чтобы тот, кому их показали, обратил на них внимание. С помощью big data специальные платформы накапливают информацию о том, как вы раньше взаимодействовали с рекламными объявлениями: как долго изучали, когда делали клик, на каком этапе закрывали рекламу. Зная это, система выбирает, кому показать рекламу, чтобы та «выстрелила» с высокой вероятностью. Более того, система показывает разным людям разную цену или предлагает скидки и купоны. О да, big data помогает вас «хакнуть», чтобы вы совершили компульсивную покупку!

Как обрабатывают большие данные, чтобы извлечь максимум пользы

Собрать данные — полдела, важно ещё правильно их обработать. Отличие больших данных от обычных в том, что человек никак не участвует в их обработке, все операции выполняет алгоритм машинного обучения. Он не просто находит закономерности, а постоянно учится. Постепенно результаты его работы улучшаются. В той же контекстной рекламе про каждого пользователя собирается информация о кликах, «куках», глубине и продолжительности просмотра. После обработки алгоритму становится понятно, какую рекламу этому пользователю предложить в следующий раз.

Big data можно анализировать только с помощью машинного обучения

Представляете себе объем вычислений, которые необходимо сделать для каждого (!) пользователя? Это очень сложно реализовать без мощных автоматизированных инструментов, которые собирают статистику. А ещё это огромные объёмы информации, которая обрабатывается параллельно и очень быстро. Десятки и сотни суперкомпьютеров «ворочают» сотнями петабайт данных, чтобы за несколько миллисекунд найти правильное решение. В контекстной рекламе таким решением будет показ объявления, которое «выстрелит», в поисковой системе — выдача релевантных ссылок в ответ на ваш запрос.

С объёмами данных получается интересная ситуация: нет четкой границы, по которой проходит разделение между big data и не big data. Понятно, что речь идет о «нетранспортабельных» данных, которые нельзя загрузить на один накопитель и передать в другой дата-центр. Но важен не столько объём, сколько способ обработки: с обычными данными справится один человек, с большими — только нейронные сети.

Неструктурированные данные

Итак, никто не справится с анализом данных лучше алгоритмов машинного обучения. На то есть веская причина: большие данные не структурированы, они не хранятся стройными столбцами в таблицах, а выглядят как текстовые фрагменты, сканы, аудио- и видеофайлы, последовательности цифр. Чтобы вникнуть и сделать правильные выводы из этой информации, потребуются сотни, тысячи человеко-часов.

Big data — это данные в естественном виде, «как есть».

Аналогично обстоит дело со стандартными (не машинными) алгоритмами анализа данных. Им нужна структурированная информация. Любой хаос в данных, не предусмотренный при создании алгоритма, помешает ему извлечь полезную информацию. Машинные алгоритмы обработки big data снова оказываются на порядок умнее.

Почему бы не приводить big data к структурированному виду? Например, преобразовать их в нужный формат и заполнять ими SQL-таблицы, чтобы проще было их обрабатывать?

Дело в том, что подход к обращению с данными в духе big data исходит из того, что мы никогда не знаем, какие данные мы захотим использовать завтра. А преобразование для структурированного хранения приводит к упрощению, отказу от части данных. Big data подразумевает хранение всей исходной информации в таком виде, чтобы в любой момент можно было делать нужные срезы, агрегировать, преобразовывать так, как это нужно именно сейчас. И если завтра понадобится извлечь другие признаки данных, мы опять вернёмся к исходным данным и сделаем новую выборку, новые преобразования.

Пытливый читатель скажет — почему же вы, Mail.Ru Cloud Solutions, не рекламируете здесь свои сервисы? Ну почему же не рекламируем? Вот же: наш облачный сервис для работы с большими данными (Hadoop, Spark) и машинное обучение в облаке для быстрой разработки приложений и бла-бла-бла.

Как менялось отношение к «большим данным»?

Первая эйфория сменилась пессимизмом, как это было со многими хайповыми технологиями. В какой-то момент вопросов было больше, чем ответов. Как собрать big data? Как объединить данные из разных источников? Как обработать их быстро и с минимальными потерями? Прошло время, и бизнес понял: невозможно просто извлечь big data из имеющейся инфраструктуры, необходимо использовать специальные платформы, которые умеют их правильно собирать и анализировать. Затем мы пережили «схватку» платформ, которые боролись за кошельки корпоративных клиентов, и наконец-то в этой сфере наступило условное затишье. Сейчас на рынке работают несколько хороших платформ — Hadoop, Clickhouse, некоторые облачные решения. Есть бизнес, который готов вкладывать в это деньги.

Мы не зря назвали затишье условным. В IT всегда есть место для появления революционных продуктов, и не исключено, что скоро появятся новые инструменты для big data. Добавьте к этому постоянно растущие объемы данных, и вы поймёте, что и разработчикам, и бизнесу не приходится скучать.

Какое будущее ждёт большие данные

Большие данные уже контролируют нашу повседневную жизнь, но мы почти не замечаем этого. По несколько часов в день мы работаем с компьютерами, смартфонами, гаджетами, которые непрерывно собирают о нас информацию. Big data будет ещё глубже проникать в нашу жизнь, но сможет проникнуть не во все её сферы. В некоторых отраслях данные очень трудно спрогнозировать. Два хороших примера — прогнозы погоды и событий на рынке: погода зависит от слишком большого числа хаотичных факторов, а рынок всё время развивается, плюс на него могут умышленно влиять люди. Для обеих областей есть решения на основе ИИ, но прорыва пока не видно.

Где big data находит применение уже сегодня:

- создание антивирусных программ;

- анализ геномов, молекулярная биология и биомоделирование;

- поиск нарушителей на дорогах, преступников (камеры видеонаблюдения снимают, а система распознаёт лица, действия, номера транспортных средств);

(Вы уже напряглись? Давайте пугаться дальше!)

На фоне стран, которые внедряют технологии big data, здорово выделяется Китай. В нём хорошо развита система видеонаблюдения и анализа лиц, чем активно пользуется бизнес и государственные службы.

Роман-антиутопия »1984» Джорджа Оруэлла — это тоже про big data. Источник

Сегодня люди, которые раньше не интересовались высокими технологиями и big data, начали понимать, насколько это мощные инструменты для бизнеса. Одновременно сами данные постепенно перестают быть анонимными: по фотографии человека уже можно понять, кто он, чем занимается и где живёт. То, что происходит сейчас и будет происходить в будущем, можно назвать настоящей тотальной слежкой. Это хорошо или плохо?

Всё зависит от конечных целей. Изменить ход выборов? Найти преступника? Выследить инакомыслящего? Вернёмся в 2019 год: предложить вам рекламу того, что вы, вероятно, купите? Подобрать такси, которое быстро и за разумные деньги доставит вас из точки А в точку Б? В общем — страшное дело.

Биг дата — за вами следят. Источник

Пока по факту у пользователей довольно мало прав выбора в том, разрешать или запрещать собирать информацию о себе. И каким бы драконовским ни выглядел GDPR с точки зрения провайдеров услуг и вообще IT-компаний, это неплохая попытка защитить право граждан «не попадать под микроскоп». Например, 17-й пункт даёт «право на забвение» — позволяет гражданам Евросоюза требовать удаления связанных с ними результатов поисковой выдачи без весомых причин. Впрочем, это была далеко не первая попытка отрегулировать обработку и хранение персональных данных.

Интересно, что будет дальше. Может быть, в будущем за анонимность придётся платить большие деньги? Или смириться с тем, что полная конфиденциальность недостижима, расслабиться и жить в обществе, где все всё и обо всех знают? Помните «Мы» Замятина — дома с прозрачными стенами? Если в «слежке» будет использована технология блокчейн, она позволит хранить данные так, что их невозможно удалить из цепочки незаметно, не повредив структуру.

А теперь передадим микрофон некоему обобщённому big-data-оптимисту и выделим ему ровно один абзац. Итак: чем более открытое и честное общество, тем лучше оно развивается. Эта открытость — заслуга big data. Ведь чем больше информации, тем больше открытости и прозрачности в обществе. Обычным людям это даже полезно. Например, перед очередными выборами они смогут узнать правду о кандидатах, словно это персонажи RPG-игры: какие скиллы у них прокачаны и до какого уровня, что делали в прошлом, какие у них наклонности и в каких щекотливых ситуациях побывали. Это отличный способ исключить воров, взяточников и просто некомпетентных личностей, которые хотят прийти к власти. Всё, конец оптимизма.

Итак, те, кто владеют данными и извлекают из них полезные выводы, будут такими же могущественными, какими раньше были нефтяные и индустриальные магнаты. И у нас к вам два вопроса:

- Вы уже осознали, насколько наша жизнь зависит от больших данных?

- В плане big data вы оптимист или пессимист?