[Перевод] Ноам Хомский: где искусственный интеллект пошел не туда?

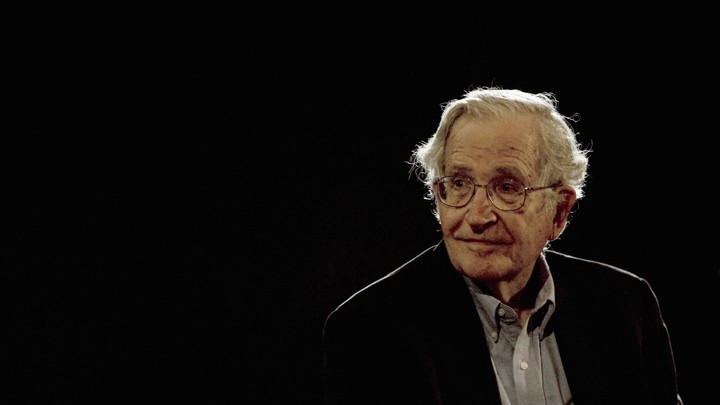

Подробное интервью с легендарным лингвистом, вышедшее 6 лет назад, но ничуть не утратившее своей актуальности. Ноам Хомский — «современный Эйнштейн», как его называют, делится своими соображениями об устройстве человеческого мышления и языка, искусственном интеллекте, состоянии современных наук. На днях ему исполнилось 90 лет, и это кажется достаточным поводом для публикации статьи. Интервью ведет молодой учёный-когнитивист Ярден Кац, он сам прекрасно разбирается в предмете, поэтому беседа очень содержательна, а вопросы столь же интересны, как и ответы.

Если задаться целью составить список величайших и самых недостижимых интеллектуальных задач, то задача «декодирования» самих себя — понимания внутреннего устройства наших умов и мозгов, и того, как архитектура этих элементов закодирована в нашем геноме — точно была бы на вершине. Однако различные области знаний, которые брались за эту задачу, от философии и психологии до информатики и нейронаук, охвачены разногласиями о том, какой подход — правильный.

В 1956 году ученый-информатик Джон МакКарти ввел в обиход выражение «искусственный интеллект» (ИИ) для описания науки изучения разума путем воссоздания его ключевых признаков на компьютере. Создание разумной системы, используя рукотворное оборудование, вместо нашего собственного «оборудования» в виде клеток и тканей, должно было стать иллюстрацией полного понимания, и повлечь за собой практические применения в виде умных устройств или даже роботов.

Однако, некоторые из коллег МакКарти, из смежных дисциплин, были больше заинтересованы в том, как разум устроен у людей и у других животных. Ноам Хомский и его коллеги работали над тем, что впоследствии стало называться когнитивной наукой — открытие ментальных представлений и правил, которые лежат в основе наших познавательных и умственных способностей. Хомский и его коллеги опрокинули доминирующую в тот момент парадигму бихевиоризма, возглавляемую гарвардским психологом Б.Ф. Скиннером, в которой поведение животных было сведено к простому набору ассоциаций между действием и его следствием в виде поощрения или наказания. Недостатки работ Скиннера в психологии стали известны из критического отзыва Хомского 1959 года на его книгу «Вербальное поведение», в котором Скиннер попытался объяснить языковые способности, используя бихевиористские принципы.

Подход Скиннера делал упор на ассоциации между стимулом и реакцией животного — подход, легко представимый как эмпирический статистический анализ, предсказывающий будущее как следствие прошлого. В концепции языка Хомского, с другой стороны, был акцент на сложности внутренних представлений, закодированных в геноме, и их развитии в ходе получения данных в сложную вычислительную систему, которую нельзя просто разложить на набор ассоциаций. Бихевиористский принцип ассоциаций не мог объяснить богатство языкового знания, наше бесконечно творческое его использование, или почему дети быстро осваивают его из минимальных и зашумленных данных, которые им предоставляет окружающая среда. «Языковая компетенция», как Хомский её называл, была частью генетического фонда организма, как и зрительная система, иммунная система, сердечно-сосудистая система, и нам следует изучать её точно так же, как мы изучаем остальные, более приземленные биологические системы.

Дэвид Марр, специалист в области нейронаук — коллега Хомского по MIT — определил общий подход изучения сложных биологических систем (таких, как мозг) в своей нашумевшей книге «Зрение», и анализ языковой компетенции по Хомскому более-менее в этот подход укладывается. Согласно Марру, сложную биологическую систему можно понимать на трех различных уровнях. Первый уровень («вычислительный уровень») описывает ввод и вывод системы, которые определяют задачу, выполняемую системой. В случае зрительной системы, вводом может быть изображение, проецируемое на нашу сетчатку, а выводом может быть идентификация объектов на изображении нашим мозгом. Второй уровень («алгоритмический уровень») описывает процедуру, при помощи которых ввод превращается в вывод, то есть: как изображение на нашей сетчатке может быть обработано, чтобы достичь задачи, описанной на вычислительном уровне. Наконец, третий уровень («уровень реализации») описывает, как наше биологическое оборудование из клеток выполняет процедуру, описанную на алгоритмическом уровне.

Подход Хомского и Марра в понимании того, как действует наш разум, настолько далек от бихевиоризма, насколько это возможно. Здесь упор на внутреннюю структуру системы, которая позволяет ей выполнить задачу, нежели на внешнюю ассоциацию между прошлым поведением системы и окружающей средой. Цель — проникнуть в «чёрный ящик», который управляет системой, и описать его внутреннее устройство, примерно как программист может объяснить вам принцип работы хорошо проработанного программного продукта, а также проинструктировать, как запустить его на домашнем компьютере.

Как сейчас принято считать, история когнитивной науки — это история очевидной победы подхода Хомского над бихевиористской парадигмой Скиннера — событие, о котором часто говорят как о «когнитивной революции», хотя сам Хомский отрицает такое название. Это достаточно точно отражает ситуацию в когнитивной науке и психологии, но в других смежных науках бихевиористское мышление и не собирается умирать. Бихевиористские экспериментальные парадигмы и ассоцианистские объяснения поведения животных используются специалистами в области нейронаук, чья цель — изучение нейробиологии поведения лабораторных животных, таких как грызуны, где системный трехуровневый подход, предложенный Марром, неприменим.

В мае 2011 года, в честь 150-летней годовщины Массачусетского технологического института, состоялся симпозиум «Brains, Minds and Machines» («Мозги, умы и машины»), на котором ведущие ученые-информатики, психологи и специалисты в области нейронаук собрались для обсуждения прошлого и будущего искусственного интеллекта и его связь с нейронауками.

Подразумевалось, что собрание вдохновит всех междисциплинарным энтузиазмом по поводу возрождения того научного вопроса, из которого и выросла вся сфера искусственного интеллекта: Как работает разум? Как наш мозг создал наши когнитивные способности, и можно ли это когда-либо воплотить в машине?

Ноам Хомский, выступая на симпозиуме, не был преисполнен энтузиазма. Хомский раскритиковал сферу ИИ за принятие подхода, похожего на бихевиоризм, только в более современной, вычислительно сложной форме. Хомский заявил, что опора на статистические техники для поиска закономерностей в больших объемах данные маловероятно даст нам объяснительные догадки, которых мы ждем от науки. Для Хомского новый ИИ — сфокусированный на использовании техник статистического обучения для лучшей обработки данных и выработки предсказаний на их основе — вряд ли даст нам общие выводы о природе разумных существ или о том, как устроено мышление.

Эта критика вызвала подробный ответ Хомскому со стороны директора по исследованиям корпорации Google и известного исследователя в области ИИ, Питера Норвига, который защищал использование статистических моделей и спорил о том, что новые методы ИИ и само определение прогресса не так уж далеки от того, что происходит и в других науках.

Хомский ответил, что статистический подход может иметь практическую ценность, например, для полезной поисковой системы, и он возможен при наличии быстрых компьютеров, способных обрабатывать большие объемы данных. Но с научной точки зрения, считает Хомский, данный подход неадекватный, или, говоря более жестко, поверхностный. Мы не научили компьютер понимать, что означает фраза «физик сэр Исаак Ньютон», даже если мы можем построить поисковую систему, которая возвращает правдоподобные результаты пользователям, вводящим туда эту фразу.

Оказывается, похожие споры есть и у биологов, которые пытаются понять более традиционные биологические системы. Как компьютерная революция открыла путь анализу больших объемов данных, на котором и держится весь «новый ИИ», так и революция секвенирования в современной биологии породила цветущие поля геномики и системной биологии. Высокопроизводительное секвенирование — техника, благодаря которой миллионы молекул ДНК могут быть быстро и дешево прочитаны — превратило секвенирование генома из дорогостоящего предприятия длиной 10 лет в доступную обычным людям лабораторную процедуру. Вместо мучительного изучения отдельных изолированных генов, мы теперь можем наблюдать поведение системы генов, действующих в клетках как единое целое, в сотнях, тысячах разных условий.

Революция секвенирования только началась, и гигантский объем данных уже получен, принося с собой ажиотаж и новые многообещающие перспективы для новой терапии и диагностики человеческих болезней. К примеру, когда обычное лекарство не помогает определенной группе людей, ответ может быть в геноме пациентов, и там может быть некая особенность, не дающая лекарству сработать. Когда собрано достаточно данных, дающих сравнить релевантные особенности генома у таких пациентов, и правильно подобраны контрольные группы, могут появляться новые кастомизированные лекарства, ведущие нас к чему-то вроде «персонализированной медицины». Подразумевается, что при наличии достаточно развитых статистических инструментов и достаточно большого набора данных, интересные сигналы можно будет вытянуть из шума, который создается большими и малоизученными биологическими системами.

Успех таких явлений, как персонализированная медицина, и других следствий революции секвенирования и системно-биологического подхода, основывается на нашей способности работать с тем, что Хомский называет «масса необработанных данных» — и это помещает биологию в центр дискуссии, подобно той, которая была в психологии и искусственном интеллекте с 1960-х.

Системная биология тоже встречала скептицизм. Великий генетик и нобелевский лауреат Сидней Бреннер однажды так её определил: «low input, high throughput, no output science» (в вольном переводе: «много шума из ничего, и никакой науки по итогам»). Бреннер, ровесник Хомского, который тоже участвовал в том симпозиуме по ИИ, был точно так же настроен скептически насчет новых системных подходов к пониманию мозга. Описывая популярный системный подход к картографированию мозговых схем, называемый Коннектомика, который пытается описать связи всех нейронов в мозге (то есть составляет диаграмму того, как одни нервные клетки соединены с другими), Бреннер назвал его «формой безумия».

Остроумные нападки Бреннера на системную биологию и связанные подходы в нейронауке недалеки от критики Хомского в сторону ИИ. Непохожие внешне, системная биология и искусственный интеллект сталкиваются с тем же самым фундаментальным заданием обратного инжиниринга в высшей степени сложной системы, чье внутреннее устройство, по большей части, загадка. Да, развивающиеся технологии предоставляют большой массив данных, связанных с системой, из которых только часть может быть релевантна. Нам следует опираться на мощные вычислительные возможности и статистические подходы, чтобы выделить сигнал из шума, или нам нужно искать более базовые принципы, лежащие в основе системы и объясняющие ее суть? Желание собрать больше данных неостановимо, хотя и не всегда понятно, в какую теорию эти данные могут уложиться. Эти дискуссии поднимают извечный вопрос философии науки: Что делает научную теорию или объяснение удовлетворительными? Как определяется успех в науке?

Мы сидели с Ноамом Хомским апрельским днем в довольно беспорядочной переговорке, спрятавшись в тайном уголке головокружительного здания Стата-центра MIT архитектуры Фрэнка Гери. Я хотел лучше понять критику Хомского в адрес искусственного интеллекта, и почему, как он считает, он двигается в неверном направлении. Я также хотел изучить применение этой критики к другим научным областям, таким как нейронауки и системная биология, которые все работают с задачей обратного инжиниринга сложных систем — и где учёные часто обнаруживают себя посреди бесконечно расширяющегося моря данных. Отчасти мотивацией интервью было то, что Хомского сейчас редко спрашивают о науке. Журналистов слишком интересует его мнение о внешней политике США, Ближнем Востоке, администрации Обамы и других обычных темах. Другой причиной было то, что Хомский принадлежит к тому редкому и особенному виду интеллектуалов, который быстро вымирает. С момента публикации знаменитого эссе Исайи Берлина, любимым развлечением в академической среде стало помещать различных мыслителей и ученых в континуум «Лисы-Ежа»: Ёж — дотошный и специализированный, нацеленный на последовательный прогресс в четко очерченных рамках, против Лисы, более быстрого, движимого идеями мыслителя, который скачет от вопроса к вопросу, игнорируя рамки предметной области и применяя свои навыки там, где они применимы. Хомский — особенный, поскольку он превращает это различие в старое и ненужное клише. У Хомского глубина не идет взамен гибкости или широты охвата, хотя, по большей части, он посвятил всю свою раннюю научную карьеру изучению определенных тем в лингвистике и когнитивных науках. Работа Хомского оказала огромное влияние на несколько сфер помимо его собственной, включая информатику и философию, и он не уходит от обсуждения и критики влияния этих идей, что делает его особенно интересным для интервьюирования человеком.

Я хочу начать с очень простого вопроса. На заре искусственного интеллекта люди с оптимизмом смотрели на прогресс в этой области, но всё оказалось иначе. Почему задача так сложна? Если спросить специалистов в области нейронаук, почему понять мозг так сложно, они дадут вам совершенно не удовлетворяющие интеллектуально ответы: в мозге миллиарды клеток, и мы не можем считывать их все, и так далее.

Хомский: В этом что-то есть. Если вы посмотрите на развитие науки, все науки как континуум, но они разделяются на отдельные области. Величайшего прогресса достигают науки, которые изучают самые простые системы. Возьмите, например, физику — в ней огромный прогресс. Но одна из причин в том, что у физиков есть преимущество, которого нет ни в одной другой науке. Если что-то становится слишком сложным, они передают это кому-то другому.

Например, химикам?

Хомский: Если молекула слишком большая, вы отдаёте её химикам. Химики, если для них молекула слишком большая или система становится слишком большой, отдают её биологам. А если для них слишком большая, они отдают психологам, и в конце концов она оказывается в руках литературных критиков, и так далее. Так что не всё, что говорят в нейронауках, полностью неверно.

Но может быть, — и с моей точки зрения это очень вероятно, хотя специалистам в области нейронаук это не нравится — что нейронаука последние пару сотен лет идёт по ложному пути. Есть довольно новая книга очень хорошего нейроучёного-когнитивиста Рэнди Галлистела совместно с Адамом Кингом («Memory and the Computational Brain: Why Cognitive Science will Transform Neuroscience» — прим. перев.), в которой он спорит — на мой взгляд, правдоподобно — с тем, что нейронаука развивалась, будучи увлечённой ассоцианизмом и связанными с ним представлениям о том, как устроены люди и животные. В результате, они искали явления, обладающие свойствами ассоциативной психологии.

Как с хеббовой пластичностью? [Теория, приписываемая Дональду Хеббу: ассоциации между стимулом окружающей среды и реакцией на стимул могут быть закодированы через усиление синаптических связей между нейронами — прим. ред.]

Хомский: Да, как усиление синаптических связей. Галлистел годы потратил на то, чтобы объяснить: если вы хотите как следует изучить мозг, вам нужно, подобно Марру, вначале спросить, какие задачи он выполняет. Поэтому он в основном интересуется насекомыми. Так вот, если вы хотите изучить, скажем, неврологию муравья, вы спрашиваете, что делает муравей? Оказывается, муравьи делают довольно сложные вещи, например, построение пути. Посмотрите на пчёл: их навигация требует довольно сложных вычислений, включающих положение солнца, и так далее. Но в целом, с чем он спорит: если вы возьмете когнитивные способности животного или человека, это вычислительные системы. Таким образом, вам нужно посмотреть на вычислительные атомарные единицы. Возьмем машину Тьюринга, это самая простая форма вычисления, вам нужно найти атомы, которые имеют свойства «читать», «писать» и «адрес». Это минимальные вычислительные единицы, так что вам нужно поискать их в мозгу. Вам никогда их не найти, если вы будете искать усиление синаптических связей или свойства полей, и так далее. Вам нужно начать вот с чего: посмотреть, что там уже есть и что работает, и вы это можете увидеть с наивысшего уровня в иерархии Марра.

Правильно, но большинство нейроучёных не сидят и не описывают вводы и выводы феномена, который они изучают. Вместо этого, они помещают мышь в лабораторную задачу обучения, и записывают как можно больше нейронов, или узнают, нужен ли ген Х для обучения задаче, и так далее. Такого рода утверждения вытекают из их экспериментов.

Хомский: Это так…

Есть ли в этом концептуальная ошибка?

Хомский: Ну, вы можете получить полезную информацию. Но если там действительно происходит какой-то род вычислений, задействующий атомарные единицы, вы их не найдёте таким способом. Это примерно как искать потерянные ключи под другим фонарем, только потому, что там светлее (отсылка к известному анекдоту — прим. перев.). Это дискуссионный вопрос… Я не думаю, что позиция Галлистела широко воспринята нейробиологами, но это правдоподобная позиция, и она сделана в духе анализа Марра. Так что когда вы изучаете зрение, говорит он, вы вначале спрашиваете, какие вычислительные задачи решает система. Затем вы ищете алгоритм, который мог бы осуществлять эти вычисления, и в конце концов вы ищете механизмы, которые позволяют произвести работу такого алгоритма. Иначе, вы можете никогда ничего не найти. Есть много примеров этого, даже в точных науках, и совершенно точно в гуманитарных. Люди стараются изучать то, что знают, как изучать — я имею в виду, это выглядит разумно. У вас есть определенные техники экспериментов, у вас есть определенный уровень понимания, вы пытаетесь раздвигать границы возможного — и это хорошо, я не критикую, люди делают, что могут. С другой стороны, хорошо бы знать, в правильном ли направлении двигаешься. И может так случиться, что если взять за основу точку зрения Марра-Галлистела, которой я лично симпатизирую, то вы будете работать по-другому, искать эксперименты другого рода.

Итак, я думаю, ключевая идея Марра в том, чтобы, как вы сказали, найти подходящие атомарные единицы для описания проблемы, иначе говоря, подходящий «уровень абстракции», если так можно сказать. А если мы возьмем конкретный пример новой области нейронаук под названием Коннектомика, где цель — найти диаграмму связей очень сложных организмов, найти соединения всех нейронов коры мозга человека или мыши. Этот подход был раскритикован Сиднеем Бреннером, который в большой степени [исторически] один из его авторов. Защитники этой области не останавливаются и не спрашивают, является ли диаграмма связей подходящим уровнем абстракции — может, и не является. А каково ваше мнение об этом?

Хомский: Есть гораздо более простые вопросы. Например, здесь, в MIT, была междисциплинарная программа по изучению нематоды (круглого червя — прим. перев.) C. elegans на протяжении нескольких десятилетий, и, как я понимаю, даже с этим крошечным существом, у которого вы знаете всю диаграмму связей, там 800 нейронов или около того …

Я думаю, 300…

Хомский: … Всё равно, вы не можете предсказать, что оно [нематода C. elegans] собирается делать. Может быть, вы просто ищете не там.

Я бы хотел перейти на тему различных методологий в ИИ. Итак, «Старый добрый искусственный интеллект» (GOFAI), как его называют теперь, основывался на строгих формализмах в традиции Готлоба Фреге и Бертрана Рассела, на математической логике, к примеру, или её ответвлениях, как немонотонные рассуждения, и так далее. С точки зрения истории науки, интересно, что эти подходы были практически полностью исключены из мейнстрима и были заменены — в сфере, которая теперь называет себя ИИ — вероятностными и статистическими моделями. Мой вопрос: как можно объяснить этот сдвиг, и является ли это шагом в нужном направлении?

Хомский: Я слушал доклад Пэта Уинстона об этом год назад. Один из тезисов у него был: ИИ и робототехника дошли до стадии, где вы можете делать действительно полезные вещи, таким образом внимание переключилось на практическое применение, и поэтому были отложены в стороны более фундаментальные научные вопросы, просто потому, что все захвачены успехом технологии и достижением определенных целей.

То есть всё ушло в инженерию….

Хомский: Да, так и есть… И это вполне можно понять, но, конечно, это уводит людей в сторону от изначальных вопросов. Я должен сам признать, что я был очень скептично настроен по поводу этих оригинальных работ (в новой парадигме вероятностного ИИ — прим. перев.). Мне казалось, что всё было чересчур оптимистично, предполагалось, что вы сможете достичь результатов, которые требуют реального понимания едва изученных систем, и что вы не можете прийти к их пониманию, просто вбросив туда сложную машину. Если вы это попробуете делать, вы приходите к концепции самоподкрепляющегося успеха, потому что вы получаете результат, но это очень сильно отличается от того, как это делается в науках.

Например, возьмем предельный случай, предположим, что кто-то хочет упразднить факультет физики, и сделать это правильно. А «правильно» — это взять множество видеозаписей о том, что происходит во внешнем мире, и скормить их самому большому и быстрому компьютеру, гигабайты данных, и сделать комплексный статистический анализ — ну, вы понимаете, байесовские методы, туда-сюда. (современный подход к анализу данных, основанный на теории вероятности — прим. ред) — и вы получите что-то вроде предсказания о том, что случится у вас за окном в следующую секунду. Фактически, вы получите гораздо лучшего качества предсказание, чем физический факультет мог бы вам дать. Ну, если успех определяется в том, чтобы получить наиболее близкую аппроксимацию на массе хаотических необработанных данных, тогда, конечно, это гораздо более лучший способ, чем как обычно работают физики — ну, знаете, никаких больше мысленных экспериментов об идеально ровной поверхности и так далее. Но вы не получите тот уровень понимания, который всегда был целью науки — вы лишь получите аппроксимацию к тому, что происходит.

И так делается везде. Предположим, вы хотите предсказать погоду на завтра. Один способ: ОК, у меня есть статистические априорные вероятности, например: высокая вероятность, что завтра погода будет такая же, как была вчера в Кливленде, и я использую её, и ещё некоторое влияние окажет положение солнца, и это я тоже использую, итак, вы сделали несколько таких предположений, вы проводите эксперимент, вы смотрите на результаты снова и снова, вы корректируете байесовскими методами, вы получаете лучшие априорные вероятности. Вы получаете довольно хорошую аппроксимацию того, какая будет завтра погода. Но это не то, что делают метеорологи — они-то хотят понять, как это работает. И это просто две разных концепции того, что такое успех, что такое достижение. В моей науке, науке о языке, это сплошь и рядом. В вычислительной когнитивной науке, примененной к языку, концепт успеха именно такой. То есть вы получаете всё больше данных, лучше статистику, получаете всё более точную аппроксимацию к какому-то гигантскому корпусу текста, например, все архивы Wall Street Journal —, но вы не узнаёте ничего о языке.

Совершенно другой подход, который я считаю правильным — попробовать посмотреть, можете ли вы понять, в чем фундаментальные принципы и их связь с ключевыми свойствами, и увидеть, что в реальной жизни, вам будут мешать тысячи разных переменных — вроде того, что происходит сейчас за окном — и вы разберетесь с ними позже, если захотите более точной аппроксимации. Это просто две разных концепции науки. Вторая — это то, чем наука была со времен Галилея, это современная наука. Аппроксимация необработанных данных — это вроде бы новый подход, но вообще-то, подобные вещи существовали и в прошлом. Это новый подход, который ускорен существованием больших объёмов памяти, очень быстрой обработки, которые позволяют вам делать вещи, которых вы раньше не могли сделать вручную. Но я думаю, что это ведет области наподобие вычислительной когнитивной науки в направлении, может быть, практической применимости…

… в инженерии?

Хомский: … Но уводит от понимания. Да, может быть, даже эффективной инженерии. И это, кстати, интересно, что произошло с инженерией. Когда я попал в MIT в 1950-е, это был инженерный вуз. Там был очень хороший факультет математики, физики, но они были обслуживающими факультетами. Они обучали инженеров всяким трюкам, которые они могли бы использовать. На факультете электронной инженерии вы учились, как собрать схему. Но начиная с 1960-х и по сей день, всё совсем по-другому. Неважно, какая ваша инженерная специальность — вы изучаете всё те же самые базовые науки и математику. И потом, возможно, вы изучаете немного о том, как её применять. Но это совсем другой подход. Он стал возможным, благодаря тому факту, что первый раз в истории человечества базовые науки, как физика, действительно могли помочь инженерам. Кроме того, технологии начали очень быстро изменяться, поэтому мало смысла изучать технологии сегодняшнего дня, если через 10 лет они всё равно изменятся. Поэтому вы изучаете фундаментальную науку, которая будет применима, независимо от того, что будет дальше. И примерно то же самое случилось и в медицине. Итак, в последнем столетии, опять же, в первый раз, биологии было что сказать практической медицине, и поэтому вам необходимо было знать биологию, если вы хотели стать врачом, плюс технологии менялись. Я думаю, что это переход от чего-то наподобие искусства, которое вы учитесь применять — аналогией будет сопоставление непонятных вам данных, каким-то особым способом, и может быть даже построение чего-то работающего — переход к науке, которая появилась в Новое время, грубо говоря, наука Галилея.

Понятно. Возвращаясь к теме байесовской статистики в моделях языка и познания. Был известный спор с вашим участием, вы утверждали, что говорить о вероятности предложения неразумно само по себе…

Хомский: … Ну, вы можете получить число, если захотите, но оно ничего не значит.

Оно ничего не значит. Но кажется, что есть почти тривиальный способ унифицировать вероятностный метод, если предположить, что есть очень богатые внутренние ментальные представления, состоящие из правил и других символических структур, и цель теории вероятности просто в том, чтобы связать зашумлённые, фрагментарные данные нашего мира с этими внутренними символическими структурами. И от вас не требуется говорить что-то о том, как эти структуры появились — они могли существовать изначально, или там подстраиваются некоторые параметры — зависит от вашей концепции. Но теория вероятности работает как клей между зашумлёнными данными и очень богатыми ментальными представлениями.

Хомский: Нет ничего плохого в теории вероятности, статистике.

Но есть ли у неё роль?

Хомский: Если вы её можете использовать, прекрасно. Но вопрос, для чего вы её используете? Прежде всего, самый первый вопрос, есть ли какой-то смысл в понимании зашумлённых данных? Есть ли смысл понимать, что происходит снаружи, за окном?

Но нас ведь бомбардируют этими данными. Это один из примеров Марра: мы встречаем зашумлённые данные постоянно, начиная с нашей сетчатки и до…

Хомский: Это так. Но вот, что он говорит: Давайте спросим себя, как биологическая система выбирает из шума важное. Сетчатка не пытается дублировать входящий шум. Она говорит: я сейчас буду искать на изображении вот это, вот это и это. Это примерно как с обучением языку. Новорожденный ребенок окружен разнообразным шумом, как говорил Уильям Джеймс, «цветущий и жужжащий беспорядок». Если обезьяна, котенок, птица, кто угодно, слышит этот шум, на этом всё и заканчивается. Однако ребенок каким-то образом, немедленно, рефлекторно, выбирает из шума отдельную часть, которая связана с языком. Это первый шаг. Как он это делает? Не при помощи статистического анализа, потому что обезьяна тоже может в грубой форме проводить тот же самый вероятностный анализ. Он ищет конкретную вещь. Итак, психолингвисты, нейролингвисты и прочие пытаются открыть конкретные детали вычислительной системы и нейропсихологии, которые каким-то образом связаны с конкретными аспектами окружающей среды. Так вот, выходит, что действительно есть нейронные схемы, которые реагируют на определенные виды ритма, который и проявляется в языке — как длина слогов и так далее. И есть некоторые свидетельства того, что одна из первых вещей, которые ищет мозг ребенка — это ритмические структуры. И возвращаясь к Галлистелу и Марру, у мозга есть внутри некая вычислительная система, которая говорит: «Окей, вот что я буду делать с этими штуками», и примерно через девять месяцев типичный ребенок уже исключил — убрал из своего запаса — те фонетические различия, которых нет в его собственном языке. То есть, получается, с самого начала любой ребенок настроен на любой язык. Но, скажем, японский ребенок в возрасте девяти месяцев не будет реагировать на различие «Р» и «Л», оно как бы отсеялось. Так что система рассматривает множество возможностей и ограничивает их только до тех, которые являются частью языка, а это уже вполне узкое множество. Вы можете придумать анти-язык, в котором ребенок никогда не сможет это сделать, и еще много чего интересного. Например, если говорить о более абстрактной стороне языка, на настоящий момент есть твердое свидетельство того, что такая простая вещь, как линейный порядок слов — что идёт за чем — не входит в синтаксическую и семантическую вычислительную системы, их устройство просто таково, что они не ищут линейный порядок. Видно, что преимущественно используются более абстрактные понятия расстояния и это не линейное расстояние, и этому можно найти нейрофизиологическое подтверждение. Можно привести пример: если придумать искусственный язык, в котором используется линейный порядок слов, как, к примеру, вы делаете из утвердительного предложения отрицательное, делая что-то с третьим по счету словом. Люди смогут разгадать эту головоломку, но по-видимому, стандартные языковые участки мозга не активируются — активируются другие зоны, то есть люди воспринимают это как головоломку, а не как языковую задачу. И чтобы её разгадать, людям приходиться напрягаться больше…

Вы считаете это убедительным свидетельством того, что активация или отсутствие активации участка мозга…

Хомский: … Это свидетельство, и конечно, вам хочется большего. Но это свидетельство такое, что вы смотрите со стороны лингвистики, как работают языки — в них нет таких вещей, как третье слово в предложении. Возьмем простое предложение: «Инстинктивно летающие орлы плавают», здесь «инстинктивно» связано со словом «плавают», а не со словом «летающие», даже хотя всё предложение и не имеет смысла. И вот действие рефлекса. «Инстинктивно», наречие, не ищет ближайший глагол, оно ищет структурно более подходящий глагол. Это гораздо более сложное вычисление. Но это единственное вычисление, которое вообще используется. Линейный порядок — это очень простое вычисление, но оно никогда не используется. Есть множество свидетельств наподобие этого, и очень мало нейролингвистических свидетельств, но они указывают в одном и том же направлении. И когда вы смотрите на более сложные структуры, вы находите всё больше и больше подобного.

Это, по моему мнению, способ понять, как система работает на самом деле, как это произошло с системой зрения в лаборатории Марра: люди наподобие Шимона Ульмана открыли довольно примечательные вещи вроде принципа ригидности. Вы не сможете этого найти при помощи статистического анализа данных. Он нашёл это при помощи тщательно спланированных экспериментов. Потом вы ищете в нейрофизиологии и смотрите, можете ли что-то найти, что выполняет эти вычисления. Я думаю, что то же самое в языке, то же самое в изучении наших арифметических способностей, планирования, почти везде. Просто работать с сырыми данными — вы никуда с этим не придете, и Галилей бы не пришёл. Фактически, если к этому вернуться, в 17 веке людям, таким как Галилей и другие великие ученые, было непросто убедить Национальный научный фонд тех времен —, а именно, аристократов — в том, что в их работах был смысл. Я имею в виду: зачем изучать, как шар катится по идеально ровной плоскости без трения, ведь их не существует. Почему не изучать, как растут цветы? Если бы вы попробовали изучать рост цветов в те времена, вы бы, возможно, получили статистический анализ того, как всё устроено.

Важ