[Перевод] Когда дефицита GPU ещё не было

Большую часть времени GPU были не важны

Как, наверно, понимает большинство людей, компьютеры считают числа. Обычно «интуитивным» способом работы с компьютерами является взаимодействие с какой-нибудь графикой. Или, что более важно, с более красивым отображением чисел.

Реклама Tektronix Interactive Graphics, предполагаемого предшественника технологий GPU. Но так ли это на самом деле?

Пока Windows и Apple приучали публику к своим заточенным под мышь интерфейсам, хардкорным пользователям компьютеров, то есть геймерам, нужно было, чтобы действия мыши регистрировались намного быстрее. А ещё они хотели, чтобы графика была более реалистичной. Затем они стали просить такие функции, как онлайн-мультиплеер, мгновенный обмен сообщениями и множество других возможностей, которые сегодня воспринимаются как должное, но в первой половине 90-х казались чем-то значительным.

Можно было бы заявить, что технически сложному геймплею мы обязаны классическому Doom 1993 года, а также его потомку Quake, вызвавшему интерес пользователей к специализированным графическим картам. Однако пообщавшись со специалистом, наблюдавшим за развитием этой отрасли с самого начала, можно прийти к выводу, что история GPU не была такой уж простой.

Доктор Джон Педди впервые занялся компьютерной графикой в 1960-х. Он находился в составе команды, создававшей топографические 3D-карты по снимкам аэрофотографии, что в дальнейшем привело к созданию его собственной компании Data Graphics. К началу 1980-х он задумался об уходе на пенсию и карьере писателя научной фантастики, но заметил в этой отрасли бум, который сложно было игнорировать. Практическое применение высокопроизводительной графики изначально развивали компании, занимавшиеся CAD и GIS, однако взрывной рост популярности видеоигр в 80-х изменил эту ситуацию.

«Игры были (и остаются) локомотивом отрасли благодаря количеству потребителей», — сообщил мне Педди в электронном письме. «Среди пользователей 3D и GPU были инженерные компании (CAD и молекулярное моделирование), а также киноиндустрия. Но в 80-х и 90-х на этом рынке было примерно 100 тысяч покупателей. А рынок потребительского 3D исчислялся миллионами пользователей. Однако рынок профессионалов платил больше — тысячи или десятки тысяч долларов, в то время как потребители платили всего несколько сотен. То есть задача заключалась в том, чтобы встроить достаточную мощь в чип, который в готовом продукте продавался бы за сотни долларов».

На этом этапе истории компьютеров в техническом лексиконе появилась аббревиатура GPU. В статье в журнале Computerworld за 1983 год подробно описывается линейка графических терминалов Tektronix. Но если приглядеться, GPU пока расшифровывается не как «graphic processing unit», а как «graphic processor unit». Есть ли какая-то разница? На самом деле, GPU не существовало до 1997 года, пусть даже и использовалась похожая аббревиатура. Оказывается, для настоящего GPU обязателен движок трансформации и освещения (transform and lighting, T&L).

«Почему термином GPU нельзя называть графический чип или плату, разработанную до 1997 года? Он отрисовывает графику (хоть и только в 2D-пространстве). Обрабатывает ли он графику? Да, в каком-то смысле. Он отрисовывает отрезки и окружности — это и есть обработка (processing). Важное отличие заключается в том, что GPU должен быть способен на истинное 3D (а для этого требуется T&L)».

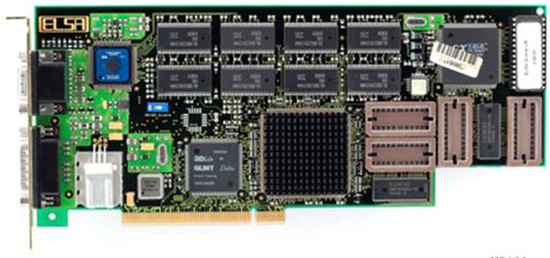

Графический 3D-чип Glint компании 3Dlabs, по мнению некоторых, первой создавшей истинный GPU. Он был выпущен в ноябре 1994 года и активно применялся в «мощных 3D-приложениях CAD» (по-прежнему не первый «настоящий» GPU, но всё равно интересный графический чип). Несмотря на то, что 3Dlabs первой появилась на рынке, она не смогла воспользоваться экономическими масштабами, доступными для её конкурентов, например, Nvidia.

Право первопроходца забирают себе победители

Давайте для начала разберём распространённую ошибку. Оборудование первой PlayStation не было первым GPU на массовом рынке. Такое мнение возникло благодаря мощному маркетингу Sony и Toshiba. Как говорит Педди, «У первой PlayStation был движок трансформации геометрии (geometry transformation engine, GTE), являвшийся сопроцессором 2D-чипа, и ошибочно названый (маркетологами) GPU».

Маркетинг был важным элементом той эпохи, то есть незадолго до того, как GPU впервые начали появляться. Создание истинного GPU для 3D было далёким горизонтом, и многие компании хотели добраться до него первыми. Однако эту честь первой получила небольшая контора из Великобритании под названием 3Dlabs. Инновацией, давшей продукту 3Dlabs титул первого настоящего GPU, стала разработка графического процессора из двух чипов, содержавшего обработчик геометрии, называемый движком трансформации и освещения (T&L). В отличие от своих конкурентов, 3Dlabs делала упор на рынок CAD, хоть и пыталась вторгнуться на крупный потребительский рынок, заключив партнёрское соглашение с Creative Labs.

Технологическое демо с показом возможностей чипсета 3Dlabs Glint.

Малый размер 3Dlabs и её специализация на профессиональном рынке означали, что на рынке потребительских GPU появится множество «первопроходцев».

Сектор графических карт в тот период был невероятно активен, за благосклонность игроков в Quake сражались такие крупные компании, как Matrox, S3 и 3Dfx.

Но историю пишут победители, и в этот период возник лидер рынка. К концу 1999 года Nvidia была готова выпустить свой первый массовый потребительский GPU с интегрированным T&L, называвшийся GeForce 256.

«Так, по мифологии Nvidia, появился GPU, и компания утверждает, что именно она изобрела его», — говорит Педди. «То есть историю можно перекраивать, как тебе угодно. Nvidia стоит 10 миллиардов долларов и на пути к 50 миллиардам, а о 3Dlabs никто не помнит».

Примечание: название Nvidia всегда было и является существительным, а не сокращением, несмотря на распространённое заблуждение.

Довольно скоро рынок заполнился конкурирующими GPU, каждый из которых стремился занять собственную рыночную нишу. Канадский производитель ATI Technologies, которого позже приобрёл крупнейший конкурент Nvidia — компания AMD, попытался обособить свою продукцию на рынке, назвав свои GPU аббревиатурой VPU (video processor unit), хотя на практике они ничем не различались. Но это название не прижилось.

«ATI сдалась, она не могла противостоять превосходящим маркетинговым навыкам, масштабам, привлекательности и безжалостному напору Nvidia», — рассказывает Педди.

К началу 2000-х на потребительском рынке начали доминировать крупные игроки наподобие Nvidia, быстро ставшие злодеями в глазах геймеров всего мира. Любопытно, что именно эта консолидация рынка позволяет объяснить, почему сегодня так трудно найти и купить мощные графические карты.

Узрите! Один из самых желанных продуктов в мире. И это ведь даже не самая мощная карта в линейке.

Так кого же винить в этом дефиците GPU?

Если вы так далеко углубились в статью об истории и названиях GPU, то вам наверняка интересно, когда я доберусь до Великого дефицита GPU 2020 года (который, вероятно, будет длиться и дальше).

Вкратце для тех, кто не понимает, о чём я говорю: за последние месяцы цена мощных GPU взлетела до небес и их даже невозможно найти в продаже.

Например, у Nvidia есть три модели графических карт, которые обычно стремятся приобрести геймеры:

- RTX 3090: рекомендуемая производителем розничная цена — 1499 долларов

- RTX 3080: рекомендуемая цена — 699 долларов

- RTX 3070: рекомендуемая цена — 499 долларов

Можно спорить о соотношении цены и производительности этих моделей. Однако дефицит вызвал рост стоимости этих GPU на рынке перепродажи. На данный момент цена средней по мощности из трёх карт RTX 3080 равна 1499 долларов, в то время как 3090 и 3070 практически невозможно найти. Один из лотов 3090 продаётся на eBay за более чем 3000 долларов.

Здесь также стоит упомянуть линейку графических карт AMD. Несмотря на не столь высокий спрос, поскольку традиционно они были не такими мощными, на карты AMD тоже повлияли ограничения цепочки поставок производства GPU. Как и в случае с линейкой Nvidia, модели AMD RX 6700, 6800 и 6900 тоже выросли в цене на вторичном рынке в два с лишним раза.

Немного забавного контекста — в моём старом Xeon установлена refurbished-версия AMD RX 570, за которую я в середине 2019 года заплатил чуть больше 100 долларов. Та же самая карта, которая, по сути, является бюджетной моделью и уже слегка устарела на момент моей покупки, сейчас продаётся за 599 долларов.

Очевидно, что существует огромный спрос, и капитализм обычно неплохо справляется с устранением таких пробелов. Как и за многие другие проблемы 2020 года, большую часть вины можно возложить на COVID-19. Производственные хабы в Китае и Тайване, как и почти весь остальной мир, были вынужденно закрыты. Хотя многие операции в производстве оборудования можно автоматизировать, тонкая природа GPU требует определённой степени вмешательства человека.

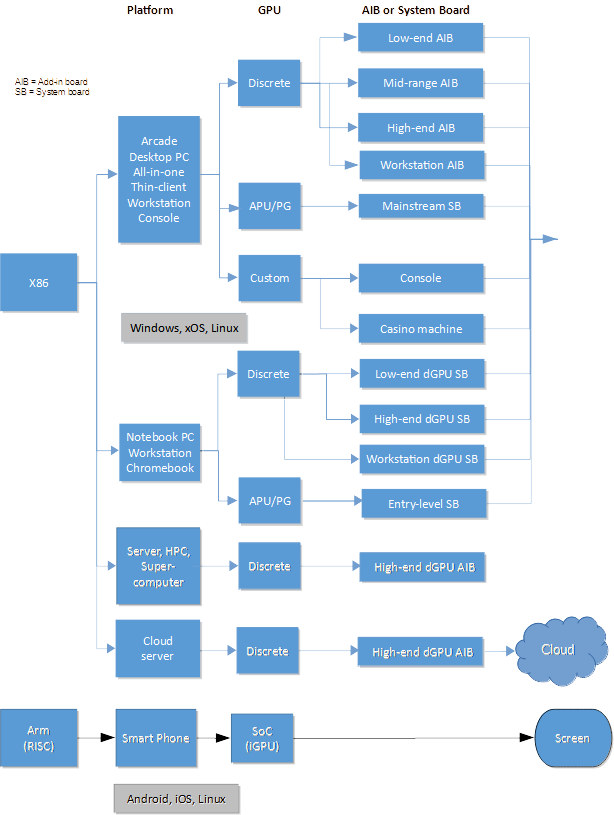

График, описывающий текущее состояние отрасли GPU. (Автор — Джон Педди)

Тем не менее, такое объяснение слишком упрощает тенденции процессов, начавшихся в отрасли графических карт ещё задолго до COVID-19. Послушаем доктора Педди:

Примерно пятнадцать лет назад сложился конвейер производства GPU: разрезание кремниевых пластин, тестирование, упаковка в корпуса, повторное тестирование и доставка заказчику. Все компании в этом конвейере, а также ниже по потоку (OEM-клиенты, имевшие похожий конвейер), искали способы более быстрого реагирования и в то же время минимизации своих материально-технических ресурсов. Так была разработана модель производства JIT (just in time, «точно в срок»). Она предполагала, что все в цепочке поставок дают точные прогнозы, а значит, и делают точные заказы. Если сломается одно звено цепи, то пострадают и все последующие… Когда правительства объявили карантин в своих странах, всё производство остановилось, перестали поставляться детали, конвейер был сломан. И когда (если) производство восстановится, то для полной синхронизации потребуется ещё несколько месяцев.В то же время людей отправили работать из дома, а у них не оказалось необходимых для этого инструментов. Так возник спрос на PC, и в особенности на ноутбуки. В 30–40% PC установлено два GPU, то есть спрос на GPU увеличился ещё сильнее.

А затем начался рост стоимости криптовалют… Теперь майнеры (люди, использующие GPU для зарабатывания крипто) стремились скупить каждый доступный им GPU. Это вызвало спекуляции — люди покупали все графические карты и продавали их по как можно более высокой цене.

То есть по цепочке поставок ударил спрос, а предложение не увеличивалось.

И такова краткая история. Изготавливающие GPU компании работали с очень малым допуском на погрешность, не имея возможности предсказывать будущее. Это относится и к рынку GPU в целом, но частично касается крупных заказчиков.

Ещё одним фактором разочарования стало время появления в 2020 году нового поколения видеоигровых консолей, а значит, и нового поколения видеоигр. Долгожданная PlayStation 5 вместе с Cyberpunk 2077 встретились в момент выпуска со множеством технических проблем и проблем с поставками. Игроки в Cyberpunk жаловались на то, что производительность игры сильно зависела от оборудования, на котором она была запущена. О различиях игрового процесса на PS4 и на PS5 один ютубер сказал так: «По крайней мере, на PS5 она играбельна».

Хотя доктор Педди ожидает, что проблема дефицита разрешится к первому кварталу 2022 года (ура…), он не особо оптимистичен относительно того, будет ли отрасль избегать подобных накладок в будущем.

«Ещё одной проблемой будет происходящее сейчас удвоение заказов, которое в перспективе приведёт к огромному падению спроса на рынке полупроводников из-за избыточного предложения», — заключает он.

Многому научиться можно даже у относительно новой истории. Хотя можно обвинить в неудовлетворении спроса ошибки рынка, очевидно, в целом ситуация намного сложнее. Несмотря на то, что GPU внезапно стали необходимы миллиардам людей для повседневной работы, высокопроизводительные устройства нужны только малой их доле, обладающей нишевыми интересами.

Тем не менее, рынок в целом должен уделить внимание разочарованным геймерам. Именно их потребности толкают отрасль к инновациям, которые становятся стандартом в более широко распространённых устройствах. С каждой итерацией устройства получают всё больше расширенных графических возможностей, которые постепенно достигают людей, не знавших о них, а теперь считающих их обязательными.

В конце концов, сегодня устройство, не обладающее реалистичной 3D-графикой, и телефоном-то мало кто назовёт.

На правах рекламы

VDSina предлагает эпичные серверы — это виртуальные серверы с новейшими CPU AMD EPYC. Огромный выбор операционных систем для автоматической установки, есть возможность установить любую ОС с собственного образа. Обязательно попробуйте!