Ретроклокинг: Три «Молнии» красно-зеленых оттенков

Оглавление

Вступление

Лаборатория продолжает цикл статей о ретроклокинге. И хотя данную статью можно лишь условно отнести к тематике ретро, но после процессоров мне захотелось уделить время видеокартам, относящимся к серии Lightning производства Micro-Star International (MSI). Серия Lightning более десяти лет у всех на слуху, и так или иначе посетители этого ресурса знакомы с ней.

Видеокарты MSI Lightning ассоциируются в первую очередь с надежностью, инновациями, широким спектром технологий, которые призваны обеспечить максимальный результат разгона без какого-либо внутреннего вмешательства в схемотехнику устройства и не требуют от обладателя наличия специальных навыков разгона. Весь комплекс программно-аппаратных решений уже реализован командой инженеров MSI.

Немного истории

Чтобы понять, откуда же эти видеокарты появились, следует погрузиться в оверклокерское движение середины 2000-х годов.

Разгоном занимались еще в прошлом веке, но это было скорее попытка получить недостающую производительность при отсутствии достаточного количества денежных средств. Так что это было больше необходимостью, а не увлекательным соревновательным мероприятием, которое потом переросло в категорию спортивных соревнований, где необходимость не была насущной, а был важен сам процесс и полученный результат любой ценой, даже с применением незаурядных средства, таких как жидкий азот, который в домашних условиях для повседневного использования попросту годится.

С развитием интернета оверклокинг стал массовым, опыт передавался проще, создавались группы, форумы и целые национальные команды, объединенные одним интересом — разогнать быстрее и результативнее остальных.

Первопроходцем в области организации публичных соревнований лучших оверклокеров из различных стран и континентов стала компания ASUS, которая в 2007 году организовала на просторах азиатского континента турнир под названием ASUS Advanced Overclocking Championship или AAOC 2007.

Первый чемпионат такого рода состоялся в Сингапуре с 7 по 8 июля 2007 года, с подачи ведущего онлайн-издания о технологиях азиатского региона — VR-Zone.com, где помимо новостей и обзоров на форумах собирались сингапурские оверклокеры и делились своими достижениями. В ASUS поняли, что это направлением можно коммерциализировать, а заодно и расширить свою фанатскую базу, увеличив тем самым рынок сбыта.

Энтузиасты-оверклокеры из Азии и Океании собрались на двухдневное мероприятие, организованное ASUS при поддержке Intel, Kingston, AC-Ryan, и FSP, чтобы побороться за ценные призы и мировую славу. Турнир проходил в торговом центре «Funan Digitalife Mall», куда съехались команды энтузиастов из Китая, Австралии, Индии, Индонезии, Таиланда, Малайзии, Тайваня и Сингапура.

Само мероприятие прошло успешно и в последующим оно стало проходить регулярно в различных уголках нашей планеты. Так, например в 2014 году в московском Cyber Stadium прошел финал ASUS Open Overclocking Cup (AOOC), полистать фото и видео можно по ссылке.

Вслед за ASUS свой личный чемпионат организовала и Gigabyte. С 16 по 17 ноября 2007 года в Джакарте, Индонезия прошел Gigabyte Open Overclocking Competition, куда прилетели зарубежные команды из Индии, Сингапура, Таиланда, Китая, Кореи, Малайзии и Австралии.

По современным меркам все проходило очень скромно, необходимо самому было добраться до места проведения либо найти себе спонсора, организаторы предоставляли 2-дневное просиживание в гостинице и 100 долларов США на расходы для каждого участника из-за рубежа.

Тестовый стенд состоял из комплектующих производства Gigabyte: материнская плата Gigabyte GA-X38-DQ6, видеокарта Gigabyte 8600GTS, блок питания Gigabyte ODIN Pro 800 Вт, и от участников нужно было максимально разогнать эти комплектующие. Первым трем победителям доставался такой же новенький комплект и призовые деньги: 1-е место 430 долларов США, 2-е — $270 и 3-е — $170.

Сейчас в подобных мероприятиях, например G.SKILL OC World Cup, победитель получает $10 000, как говорится, есть с чем сравнить.

И вот мы добрались до компании MSI, которая тоже поняла, что подобного рода мероприятия это хороший информационный повод завить о себе и своей продукции, ведь если его выбирают оверклокеры, которые устанавливают на своих материнских платах и видеокартах рекорды, то платы классом попроще, тоже должны быть хороши.

В 2008 году MSI организует свой первый чемпионат — Master Overclocking Arena, финал которого состоялся 8–11 ноября в Тайбее, Тайвань.

Чтобы предоставить возможность попасть в финал чемпионата, MSI организовала отборочные соревнования более чем в 30 странах, по результатам которых лучшие команды встретились в полуфинале, а затем победители отправились на Тайвань. В Тайбэе помимо организатора, в спонсорский состав входили такие именитые компании как Intel, NVIDIA, OCZ Technology, Western Digital, Enermax и Geinus.

Как несложно догадаться, тестовые стенды финалистов состояли из компонентов этих компаний, а в качестве основы использовалась материнская плата организатора — MSI P45D3 Platinum и видеокарты MSI R4850-T2D512 Quad Pipe на базе Radeon HD 4850 и MSI N9800GTX PLUS-T2D512-OC на базе 55 нм GeForce 9800 GTX.

Эти две модели видеокарт выделялись на фоне остальных видеокарт своих серий в линейке MSI. Благодаря наличию хорошей системы охлаждения с тепловыми трубками, усиленной компонентой базой, повышенным частотам они все еще имели потенциал для дальнейшего разгона.

Один из участников MOA 2008 предложил MSI сделать специальную видеокарту для оверклокеров, которая бы еще лучше подходила для разгона и была бы визитной карточкой на будущих мероприятиях.

В компании MSI подошли серьезно к этому предложению и уже через полгода, весной в марте 2009 в рамках выставки CeBIT 2009 публике был представлен прототип будущей «Молнии». Вид прототипа был очень далек от того строгого и узнаваемого черно-желтого дизайна, которым обладают все видеокарты серии Lightning.

Вентиляторы видеокарты были оснащены LED-индикаторами, которые отображали количество оборотов и температуру графического процессора, сам кожух системы охлаждения и общий вид видеокарты выглядели несуразно.

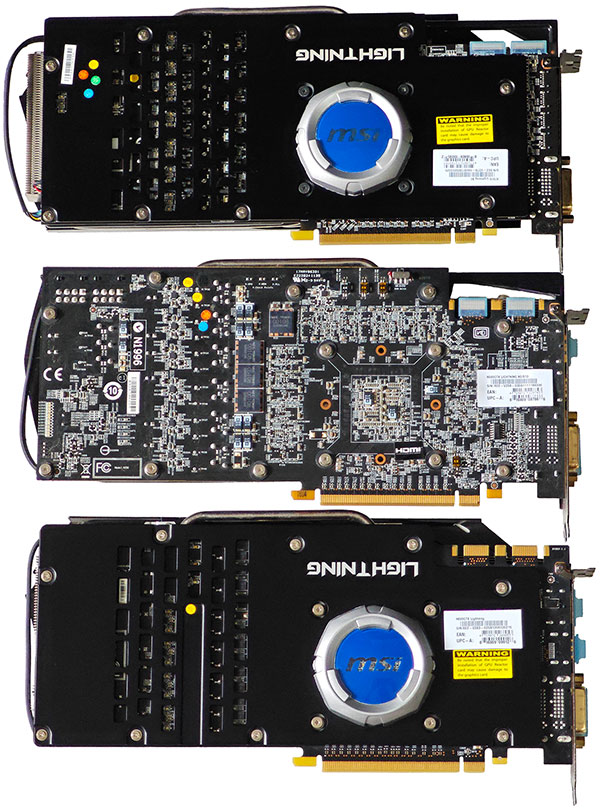

К счастью, в компании отказались от такого странного дизайна, и финальная версия «Молнии» получила фирменную систему охлаждения Twin Frozr первого поколения с никелированным радиатором и чёрно-серым металлическим кожухом. В результате самой первой молнией стала видеокарта MSI N260GTX Lightning 1792 MB.

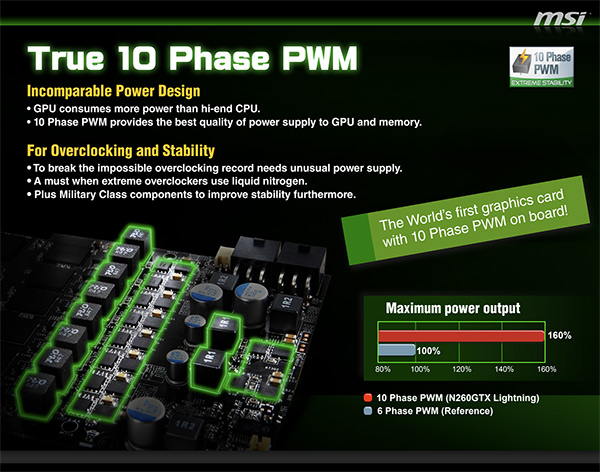

Видеокарта была изготовлена на базе 55-нанометрового графического процессора GT200, содержащего 216 потоковых процессоров, и 1792 Мб памяти стандарта GDDR3 с шиной доступа 448 бит.

Первая волна моделей видеокарт NVIDIA GeForce GTX 260 имела в основе 65 нм графический процессор GT200 со 192 потоковыми процессорами и 896 Мб памяти. Частота GPU равнялась 576 МГц, видеопамять функционировала на эффективной частоте 2000 МГц. «Молния» сразу выделялась удвоенным объемом видеопамяти с частотой 2100 МГц, и GPU работящим на частоте 680 МГц.

Помимо этого, конструкция видеокарты отличалась наличием 10-слойной печатной платы, 10-ти фазной системы питания с твердотельными конденсаторами, ресурс которых в 2,5 раза выше обычных, точки замеров напряжений ядра и памяти, и оригинальной системы охлаждения Twin Frozr, которая состояла из пяти тепловых трубок и двух вентиляторов.

В дополнительной расширенной комплекции «Black Edition» с видеокартой поставлялась специальная панель AirForce Panel в форм-факторе 5,25-дюймового устройства, которая могла устанавливаться как в корпус ПК, так и стоять на столе возле монитора. Сенсорные кнопки и светодиодные индикаторы позволяли отслеживать и изменять частоту GPU и памяти видеокарты, а также переключать различные режимы её работы.

Также MSI выпустили специальную утилиту для управления аналогичными параметрами в среде операционной системы, но первые версии были далеки от совершенства, но сам подход к разгону и мониторингу основных показателей видеокарты заложил ту основу, которую мы привыкли использовать сейчас в виде MSI afterburner и других аналогичных утилит других производителей видеокарт.

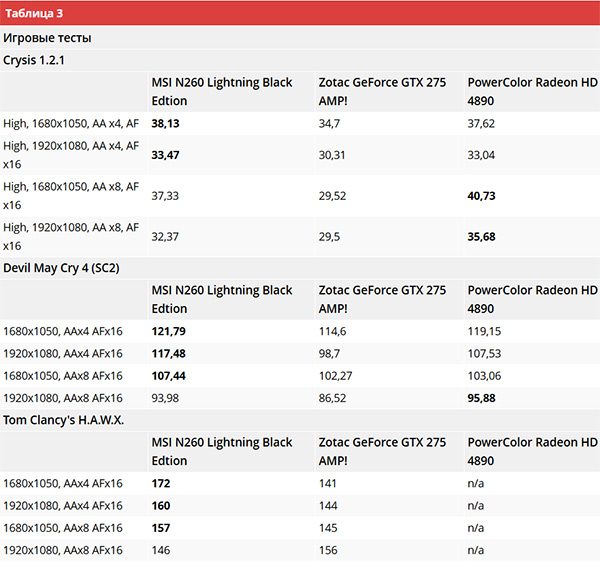

За такие инновации конечному потребителю приходись голосовать рублем. Так вариант с панелью AirForce оценивался производителем примерно в $300, в тоже время за $250 можно приобрести более быструю модель видеокарты на базе GPU GeForce GTX 275. Но благодаря своим характеристикам, в разгоне первая молния оставляла позади даже форсированные GeForce GTX 275. Вот пример выводов из одного обзора:

MSI удалось вывести GeForce GTX 260 на совершенно новый уровень, оставив позади даже разогнанную GTX 275. Да и эксперимент с внешней панелью для разгона — та еще новинка. Такое мы видели только у компании Zotac в виде отдельного девайса под названием Nitro. Тут же панель идет в комплекте с видеокартой. Интересно, что просят за карту не так уж и много — 10500 рублей. К примеру, за отстающую Zotac GeForce GTX 275 AMP! требуют столько же. Если брать N260 GTX Lightning без внешней панели, то можно сэкономить тысячу рублей. В общем, хорошее предложение, тем более что при особом желании видеопроцессор можно разогнать до 1 ГГц.

Хотя если взглянуть на графики тестов, то видно, что авторы делали упор на потребление видеопамяти, устанавливая максимальные значения сглаживания, чтобы у всех, у кого было меньше 1 Гбайт видеопамяти, теряли часть производительности. О времена, о нравы, совсем как сейчас, когда нам в 2025-м году маркетологи говорят, что 8 Гбайт видеопамяти хватит. Но, тем не менее, у первой «Молнии» был хотя бы удвоенный запас, а не нехватка места под объёмные текстуры как сейчас.

Далее компания MSI продолжила хорошую традицию, и новые модели «Молний» выходили практически для всех флагманских GPU, как зеленого, так и красного лагеря. Были даже специальные модели, которые раздавались оверклокерам на МОА и которые не выходили в официальную продажу (например, MSI GeForce GTX 780 Ti Lightning), но это уже отдельная история.

А моя история и сама идея сегодняшней статьи начинается прямиком с этого абзаца. Думаю, многие помнят тот период, когда тактовые частоты GPU прописывались «жестко» в BIOS видеокарты.

Никаких умных технологий, которые измеряют массу параметров видеокарты и автоматически подстраивают тактовую частоту GPU в реальном времени в зависимости от изменившихся условий окружающей среды, потребления энергии, преодоление различных лимитов — не существовало. Разгон был простым: повышай напряжение, подымай тактовую частоту и следи за температурой. Никаких лимитов мощности и температурных ограничений.

А затем одна за одной появились технологии, которые были призваны оградить пользователя от ошибок разгона или сделать разгон более «интеллектуальным». Вот этот временной рубеж как раз и заинтересовал меня.

Участники тестирования

Я нашел три «Молнии». Одна относится к последнему поколению видеокарт с классическим подходом к разгону, вторая основана на следующем поколении GPU, который содержит интеллектуальные разгонные технологии первого поколения (или, наоборот, тормозящие, тут кому как больше нравится). И третья — представитель противоположного (красного) лагеря, которая вышла в этот же временной промежуток времени.

Энтузиасты, скорее всего, уже поняли, что это за модели видеокарт, а для остальных я кратко перечислю их основные характеристики. Тем более это не простые «Молнии», а «Молнии» второй ревизии или улучшенные по дизайну версии видеокарт, выпущенные на одном и том же GPU, но компания MSI сделала их еще быстрее, относительно первых ревизий своих «Молниеносных» видеокарт.

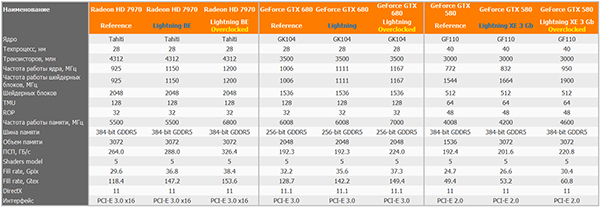

Стоит задача сравнить три видеокарты между собой, в трех различных состояниях:

- На референсных частотах тех GPU, на которых выпускалось подавляющее большинство видеокарт, путем понижения тактовых частот у Молний.

- На тактовых частотах, которые были зашиты в BIOS видеокарт Lightning самим производителем.

- Вручную разогнанные Молнии, работающие на полностью стабильных частотах при использовании штатных СО.

Таким образом можно будет сравнить производительность референсных видеокарт с видеокартами MSI Lightning, а также вручную разогнанные модели Молний по отношению к референсным моделям видеокарт, основанным на следующем поколении GPU. Посмотреть, насколько отличается производительность между поколениями и что дает разгон таких заряженных видеокарт.

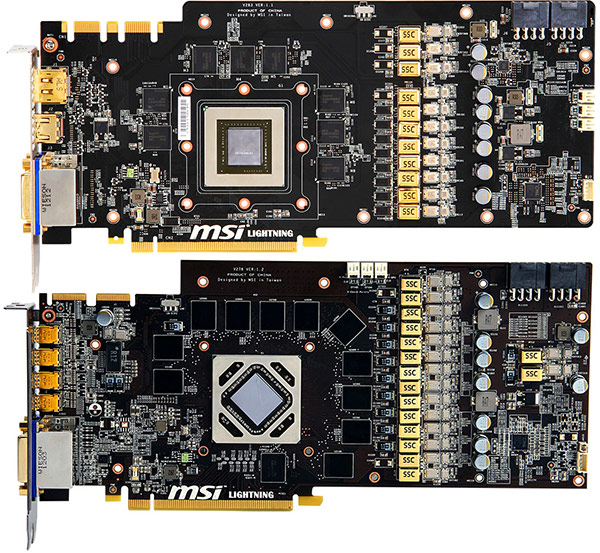

Первый участник — MSI GeForce GTX 580 Lightning Xtreme Edition 3Gb с удвоенным количеством видеопамяти по отношению к референсу. Видеокарта была представлена публике на международной выставке Computex в 2011 году.

В основе видеокарты лежит GPU GF110, выпускавшийся с применением техпроцесса 40 нм, в основе которого лежит микроархитектура Fermi. Сам GPU насчитывал 512 CUDA ядер, 64 текстурных блока, и 48 блоков растеризации.

Видеокарта оснащалась 3 Гб памяти типа GDDR5 и работала на частотах 832/1664/4200 МГц. Компонентная база состояла из самых передовых на тот момент элементов, которые MSI относила к Military Class II, 16-фазная подсистема питания и количество примененных технологических решений облегчающих разгон (уменьшение пульсаций, снятие ограничение по току, площадки для подключения кабелей и измерения напряжений, специальная версия BIOS) делали эту видеокарту одной из самых быстрых в Мире. MSI заявляла что модель экстремальной молнии в умелых руках может работать на частоте 1 ГГц.

Следующий участник это MSI GeForce GTX 680 Lightning, который дебютировал в 2012 году. В основе видеокарты лежало графическое ядро GK104, произведенное по нормам 28нм (предыдущая Молния имела тех процесс 40 нм). Компонентная база видеокарты все также была представлена самыми передовыми компонентами с увеличенным сроком службы. Cистема охлаждения перешла на следующую 4-ю версию Twin Frozr. Два восьмиконтактных разъема питания, как и у предыдущей молнии остались на своих местах, а вот количество фаз сократилось с 16 до 12.

Количество видеопамяти у видеокарт GTX 680 равняется 2 Гб, что на фоне предыдущей Молнии кажется даунгрейдом. Сама видеопамять работает на частоте 6008 МГц, что заметно больше 4200 МГц, чем у предшественницы, при все том же стандарте видеопамяти GDDR5.

Сердцем видеокарты является GPU — GK104 на новой микроархитектуре Kepler, которая несколько видоизменила подход к графическим вычислениям и обзавелась технологией автоматического разгона — GPU Boost, с которой мы живем по сей день.

GK104 содержит 1536 ядер CUDA, что втрое больше, чем у GF110, 128 текстурных блоков (больше в два раза) и 32 ROP (у GF110 их 48). Общий кеш L2 уменьшился с 768 до 512 Кбайт, однако пропускная способность кеша увеличилась на 73%. Базовая тактовая частота составляет 1006 МГц, а реальная будет зависеть уже от внешних факторов, таких как предел используемой мощности, напряжение GPU, которое напрямую влияет на потребляемую мощность, температура и всяческие программные алгоритмы, зашитые в BIOS видеокарты. Одним словом — прощай классический разгон.

На фоне MSI GeForce GTX 580 Lightning Xtreme Edition 3Gb новая Молния выглядит неоднозначно, с одной стороны уменьшение количественных характеристик компенсируется качественными, во главу угла поставлена энергоэффективность, как главный критерий нового поколения видеокарт, с другой стороны пользователи получили GPU работающий на 1 ГГц из коробки и всего 2 Гб видеопамяти. Позже Nvidiа выпустит GeForce GTX 680 с четырьмя гигабайтами видеопамяти, которые получались путем удвоения количества чипов памяти, располагавшихся на обратной стороне платы, но MSI так и не выпустила обновлённую версию Молнии, как в случае с MSI GeForce GTX 580 Lightning.

Финальные тактовые частоты 680-й Молнии выглядят следующими 1111/1176/6008 МГц, то есть базовая частота относительно референса повышена с 1006 до 1111 МГц, или на 10,4%, а реальная частота видеокарты целиком и полностью полагается на работу технологии GPU Boost.

Вот и посмотрим, как все эти компромиссы скажутся на итоговом быстродействии в играх, учитывая еще один нюанс GTX 580, у которой частота шейдерного домена работает на удвоенной частоте ядра. Поэтому если итоговый разгон MSI GeForce GTX 580 Lightning Xtreme Edition 3Gb составил 1 ГГц по GPU, то CUDA ядра будут работать на частоте 2 ГГц.

Третьим представителем Молний является MSI R7970 Lightning Boost Edition. В осное видеокарты лежит 2-я ревизия GPU Tahiti XT, производившаяся по технологии 28 нм (как и GTX 680).

Сама история появления на рынке второй версии Молнии в рамках одного поколения GPU интересна сама по себе. Если у MSI GeForce GTX 580 Lightning Xtreme Edition 3Gb основной причиной появления стало использование удвоенного объема видеопамяти с увеличением её тактовой частоты, то у MSI R7970 Lightning Boost Edition причины совсем другие.

Тут нам нужно вернуться к референсным характеристикам классического Radeon HD 7970, который был анонсирован 9 января 2012 года с референсными частотами: 925 МГц для GPU и 5500 МГц для видеопамяти. На основе этого GPU MSI сделала первую версию своей молнии с частотной формулой: 1070 МГц для GPU и 5600 МГц для видеопамяти. Radeon HD 7970 до апрельского релиза GeForce GTX 680 не имел полноценных конкурентов со стороны NVIDIA, и все верхние строчки в рейтинге HWBOT заняли представители «красного» лагеря.

Но переработанный представитель на обновленной архитектуры Kepler оказался быстрее и существенно энергоэффективнее. На такой зленый выпад AMD ответила второй ревизией GPU Tahiti XT, которое носила индекс GPU Tahiti XT2, куда была добавлена технология энергосбережения PowerTune Boost и повышена частота графического ядра до с 925 МГц до 1 ГГц. Референсные частоты новых Radeon с суффиксом «GHz Edition» составляли 1000/6000 МГц, частота видеопамяти была повышена на 500 МГц по отношению к первой ревизии. А благодаря Power Tune Boost частота GPU в 99% составляла 1050 МГц даже в плохо проветриваемых корпусах.

Вот на таком обновленном GPU и была спроектирована MSI R7970 Lightning Boost Edition. Частота в бусте составляла 1150 МГц, видеопамять работала на 6 ГГц ровно. Внешне разницы между MSI R7970 Lightning и MSI GeForce GTX 680 Lightning практически не наблюдалось.

Когда участники определены, сведем все характеристики трех состояний видеокарт в одну таблицу.

Остановлюсь на итоговых результатах разгона видеокарт. MSI GeForce GTX 580 Lightning Xtreme Edition 3Gb покорились стабильные 950 МГц по GPU и 4600 МГц для видеопамяти. Отдельные тесты и игры видеокарта способна проходить на 1 ГГц, но видимо компонентная база немного подустала за прошедшие 15 лет.

Для MSI GeForce GTX 680 Lightning стабильной базовой частотой стала 1167 МГц, что в бусте давало 1200+ МГц, видеопамять показала хороший разгонный потенциал и с 6008 МГц успешно разогналась до 7 ГГц ровно.

Для MSI R7970 Lightning Boost Edition итоговые рабочие частоты составили 1200 МГц для GPU и 6800 МГц для видеопамяти.

Тестовый стенд

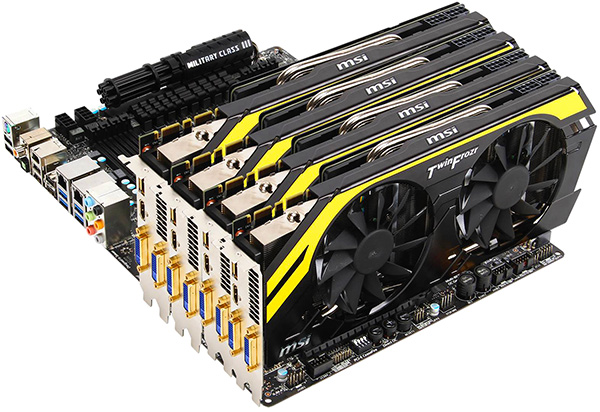

Конфигурация тестового стенда

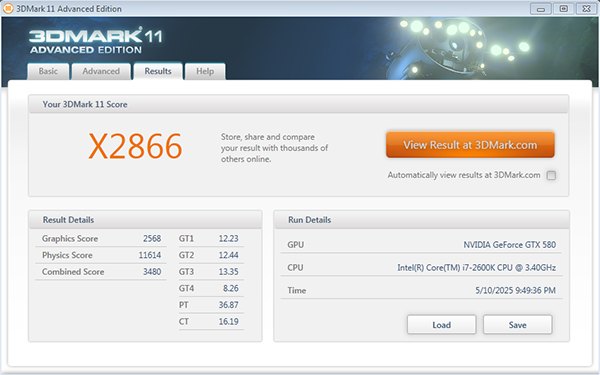

- Процессор: Intel Core i7–2600K (Sandy Bridge), разогнанный до 4700 МГц;

- Материнская плата: ASUS Maximus V Extreme, чипсет Intel Z77;

- Оперативная память: Kingston HyperX (4×2 Гбайт) DDR3 (Epida IC«s), 1866 МГц, CL=7;

- Видеокарты:

- MSI GeForce GTX 580 Lightning Xtreme Edition 3Gb (ForceWare 381.65);

- MSI GeForce GTX 680 Lightning 2Gb (ForceWare 381.65);

- MSI R7970 Lightning Boost Edition 3Gb (Catalyst 12.3).

Программное обеспечение

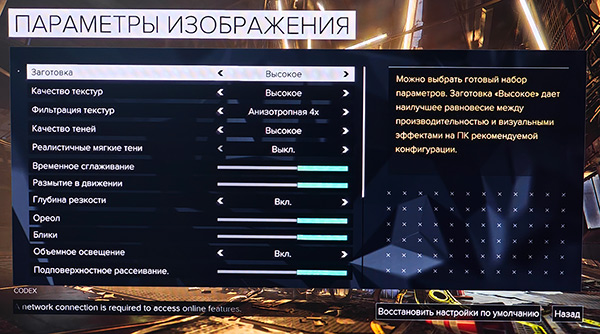

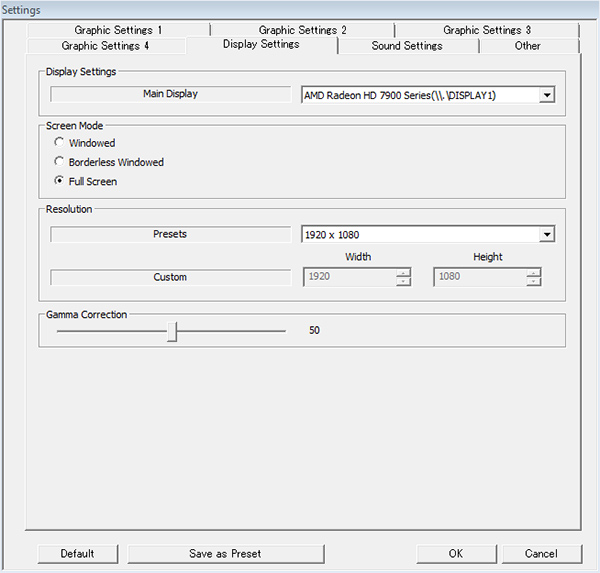

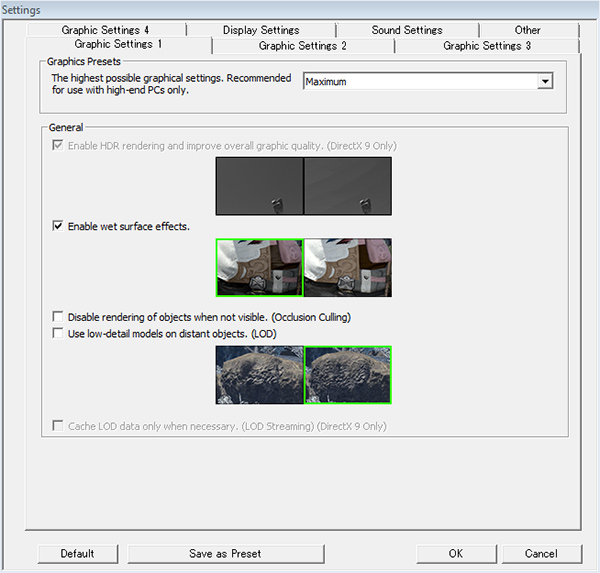

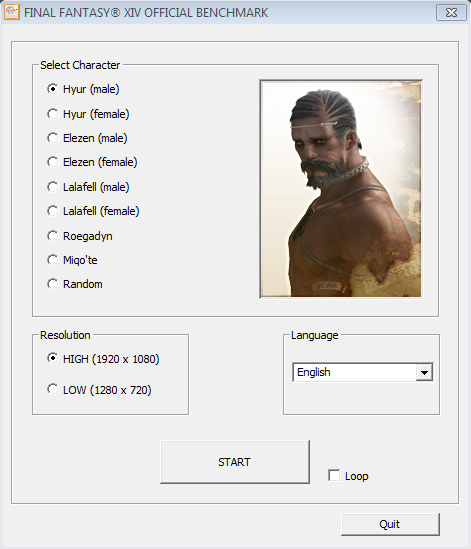

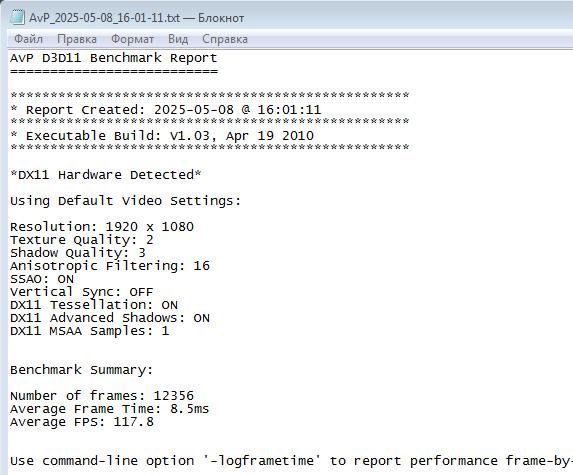

- Операционная система Windows 7×64 Sp1;

- 3DMark 2011 Advanced edition;

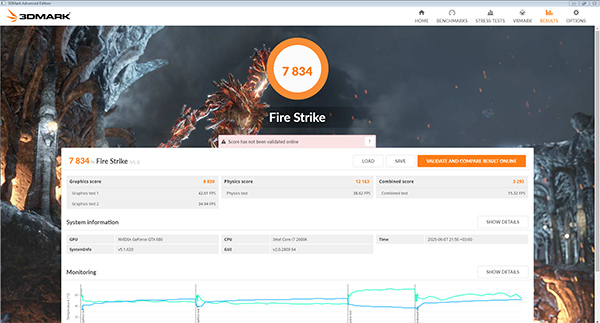

- 3DMark (2013) Firestrike benchmark;

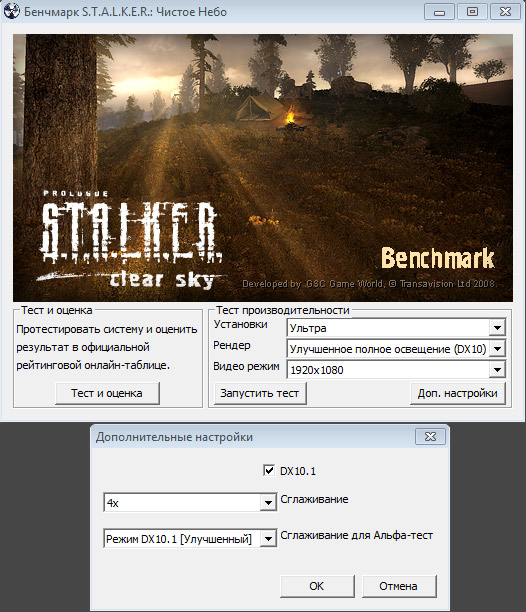

- S.T. A.L.K. E.R.: Clear Sky, DX10;

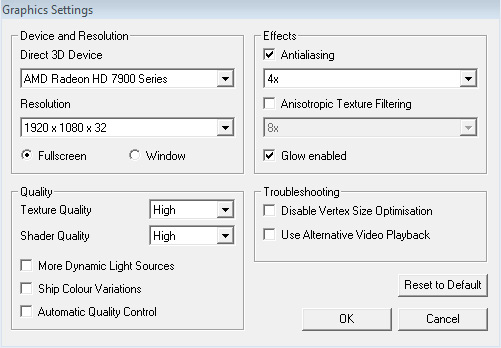

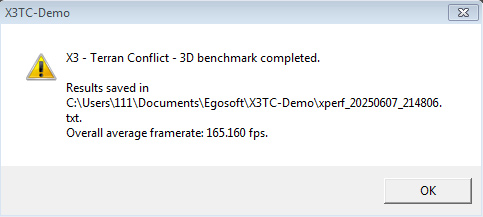

- X3 Terran Conflict Benchmark, DX10;

- Deus Ex: Mankind Divided — Benchmark, DX11;

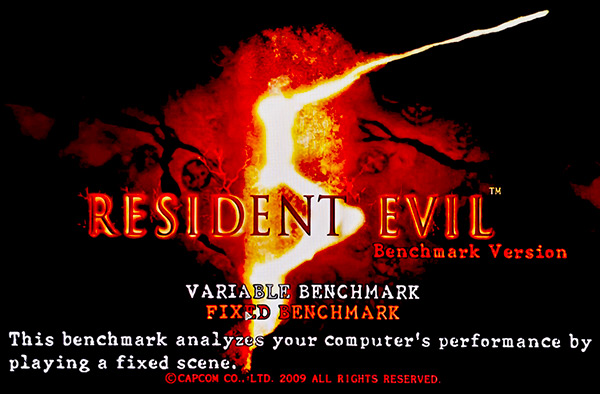

- Resident Evil 5 Benchmark, DX9с;

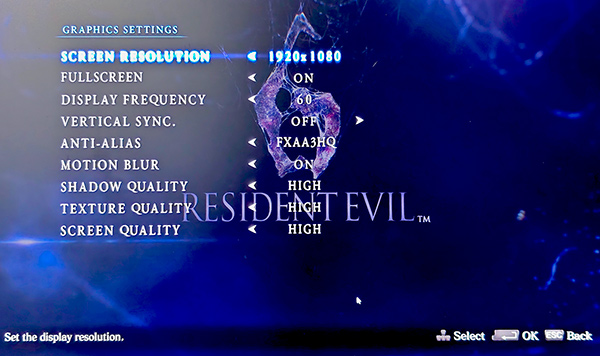

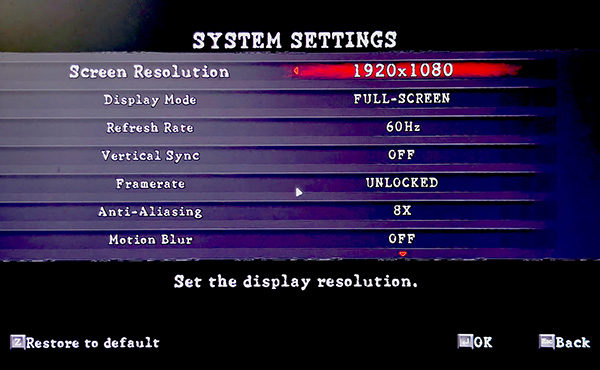

- Resident Evil 6 Benchmark, DX9с;

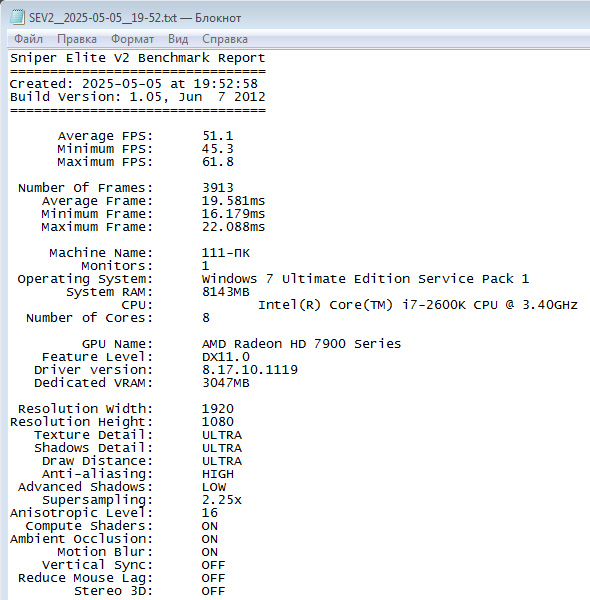

- Sniper Elite V2 Benchmark, DX11;

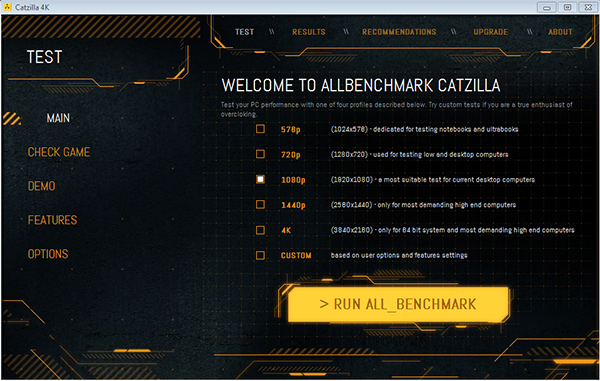

- Catzilla Benchmark, DX11;

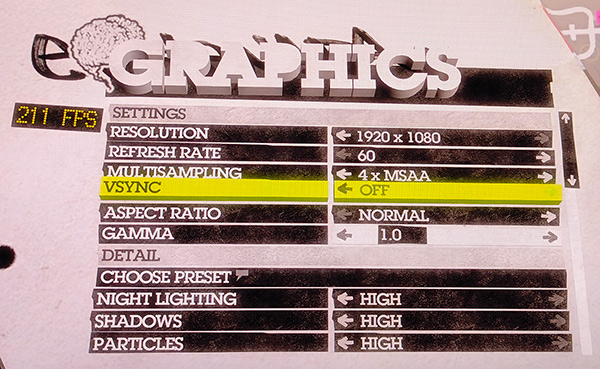

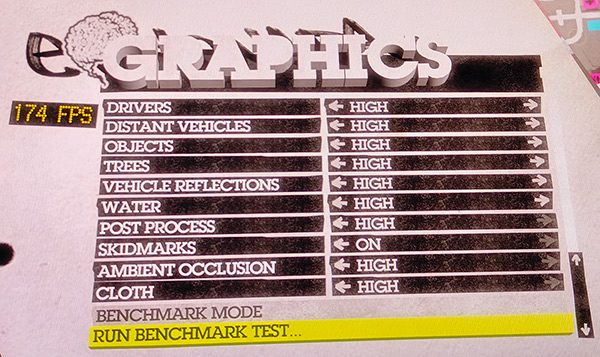

- DiRT 2 Benchmark, DX11;

- PLA Unreal 3 Engine DirectX 11 Benchmark;

- Final Fantasy XIV: Heavensward Official Benchmark, DX11;

- Final Fantasy XIV: Official Benchmark, DX11;

- AVP Aliens vs. Predator DirectX 11 Benchmark;

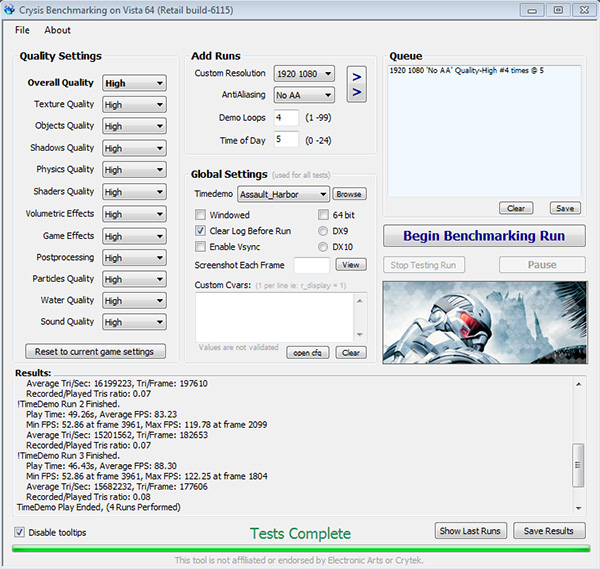

- Crysis 1, Assault_Harbor Benchmark, DX10;

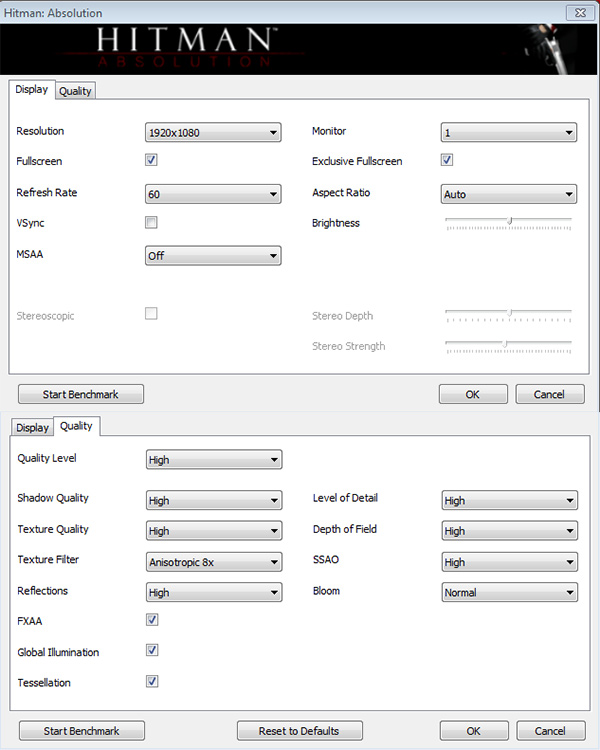

- Hitman Absolution Benchmark, DX11;

- Batman Arkham Origins, in game Benchmark, DX11;

- Lost Planet 2 Benchmark, DX9c;

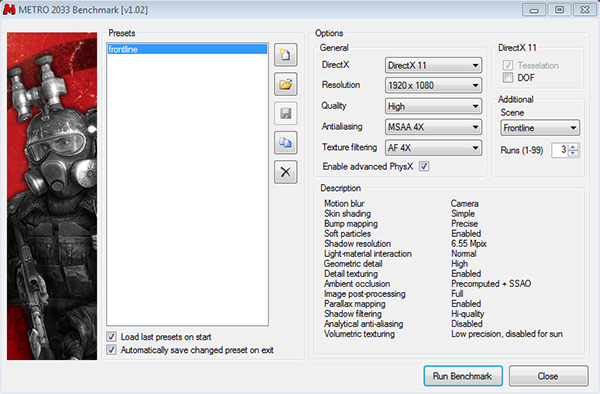

- Metro 2033 Benchmark, DX11.

Результаты тестирования

Итоговый результат

Больше — лучше

Включите JavaScript, чтобы видеть графики

В бенчмарке 2011 года в лидерах представитель зеленого лагеря — MSI GeForce GTX 680 Lightning. MSI R7970 Lightning Boost Edition не помогает даже разгон и лишний 1 Гб видеопамяти. Молния, основанная на GeForce GTX 580 благодаря разгону, опережает референсный Radeon HD7970.

Итоговый результат

Больше — лучше

Включите JavaScript, чтобы видеть графики

В более современном бенчмарке ситуация не меняется, посмотрим, как дела будут обстоять в реальных играх. Я попытался собрать как можно больше игр со встроенными подсчётом производительности, в комментариях можно этот список дополнить. Приоритет Демо-игра со встроенным бенчамарком.

AVG FPS

Больше — лучше

Включите JavaScript, чтобы видеть графики

Вот тут разгорелась настоящая борьба, GTX 580 не помог разгон, из двух оставшихся молнии из противоположных лагерей быстрее оказалась «красная», но при предельном разгоне обеих получится паритет FPS.

AVG FPS, «DAY»

Больше — лучше

Включите JavaScript, чтобы видеть графики

AVG FPS

Больше — лучше

Включите JavaScript, чтобы видеть графики

AVG FPS

Больше — лучше

Включите JavaScript, чтобы видеть графики

AVG FPS

Больше — лучше

Включите JavaScript, чтобы видеть графики

AVG FPS

Больше — лучше

Включите JavaScript, чтобы видеть графики

AVG FPS

Больше — лучше

Включите JavaScript, чтобы видеть графики

Итоговый результат

Больше — лучше

Включите JavaScript, чтобы видеть графики

AVG FPS

Больше — лучше

Включите JavaScript, чтобы видеть графики

AVG FPS

Больше — лучше

Включите JavaScript, чтобы видеть графики

Итоговый результат

Больше — лучше

Включите JavaScript, чтобы видеть графики

Итоговый результат

Больше — лучше

Включите JavaScript, чтобы видеть графики

AVG FPS

Больше — лучше

Включите JavaScript, чтобы видеть графики

AVG FPS

Больше — лучше

Включите JavaScript, чтобы видеть графики

AVG FPS

Больше — лучше

Включите JavaScript, чтобы видеть графики

AVG FPS

Больше — лучше

Включите JavaScript, чтобы видеть графики

AVG FPS

Больше — лучше

Включите JavaScript, чтобы видеть графики

AVG FPS

Больше — лучше

Включите JavaScript, чтобы видеть графики

Заключение

Результаты получились достаточно интересными и где-то предсказуемыми. Так, «Молния» на базе GeForce GTX 580 ни разу не опередила последующую, несмотря на предельный разгон и дополнительный гигабайт видеопамяти. Исключения: космосим X3 Terran Conflict Benchmark, на который разгон видеокарт практически не действовал, и неожиданно Metro 2033, где благодаря предельному разгону удалось вклиниться в середину результатов. В остальном же игры, которые отдают явное предпочтение какой-либо из двух GPU архитектур, демонстрируют преимущество конкретной архитектуры, и конкуренту в очень редких случаях удается что-либо изменить за счет разгона.

Я бы поставил паритет между обеими «Молниями» MSI R7970 Lightning Boost Edition и MSI GTX 680 Lightning, но у последней немного повеселее в плане запаса дальнейшего разгона, хотя это также зависит и от экземпляра конкретного GPU. Но больше всего мне понравилось иметь дело с MSI GeForce GTX 580 Lightning Xtreme Edition 3Gb, классический и понятный во всех отношениях разгон… как дым отечества нам сладок и приятен!

Мне бы хотелось попробовать в деле самую первую «Молнию», но пока, к сожалению, она отсутствует в моем распоряжении. Будем искать, а заодно и другие «Молнии» и не только, чтобы еще сравнить и не раз незаурядные видеокарты былых эпох. Если у кого-то без дела лежат подобные экспонаты — вы можете приблизить этот момент. И будем надеяться, что серия Lightning когда-нибудь вернется.

Полный текст статьи читайте на overclockers.ru