Rutube 2009-2015: история нашего железа

Прошло 7 лет с тех пор, как Rutube стал частью Газпром-Медиа Холдинга и начался новый этап развития проекта. В данной статье расскажем о том, каким мы получили проект в конце 2008 года, и как он изменялся в течение 7 лет по аппаратной части. Под катом вас ждёт увлекательный рассказ и много много картинок (осторожно, трафик!), поэтому тыкайте на Фичу (наша офисная кошка) и вперёд!

Начало

В конце 2008 года Газпром-Медиа Холдинга приобрёл Rutube — код и инфраструктуру. Техническая команда, состоявшая на тот момент из технического директора, системного администратора и технического специалиста («Компьютер просит нажать «Эникей», где она?), получила в своё распоряжение несколько стоек с оборудованием в центрах обработки данных «М10», «КОМСТАР-Директ» и «Курчатнике».

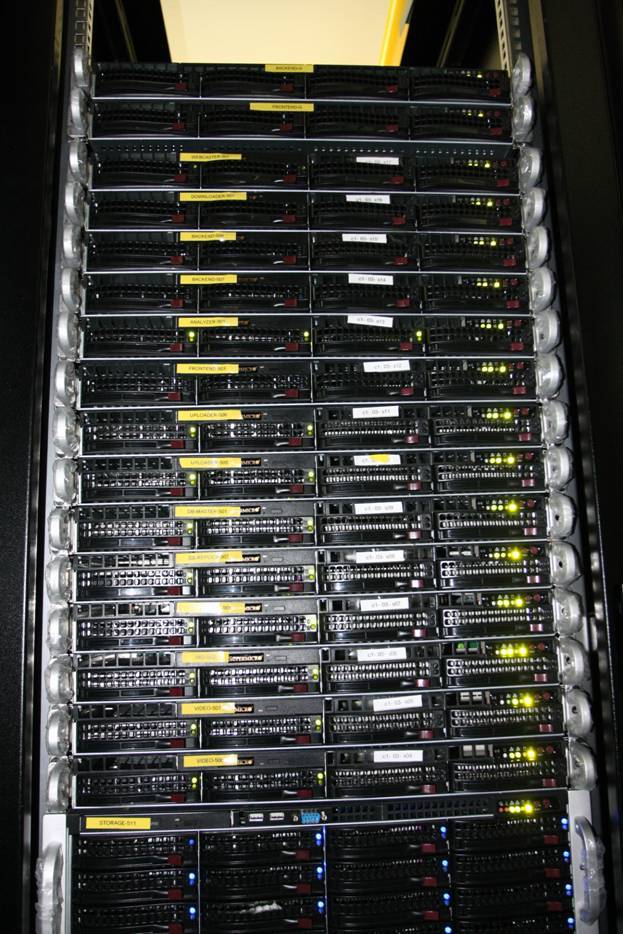

Стойки выглядели примерно следующим образом:

С тоской вспоминаем ЦОД «М10», в котором быстросъёмные салазки можно было установить только с помощью плоскогубцев и лёгкого постукивания молотком. Зато салазки Supermicro, крепящиеся на болты, прекрасно фиксировались в стойках, а сами стойки были готовы выдержать полное наполнение устройствами ИБП.

Чего только стоило расположение стоек в ЦОД «КОМСТАР-Директ», когда задняя дверца не могла до конца открыться, упираясь в стену, и приходилось снимать дверцу, чтобы подлезть к салазкам со стороны петель стойки. Даже какая-то ностальгия осталась по этому ценному опыту!

Оборудование состояло из серверов HP ProLiant DL140 G3 и HP ProLiant DL320 G5, а также серверов Supermicro на базе материнских плат PDSMU, X7SBi. Роль коммутаторов исполняли Allied Telesis и D-Link.

К слову, часть этого оборудования мы уже вывели из эксплуатации и продали, а часть ещё в продаже — обращайтесь!

Развитие

Практически сразу стало ясно, что текущих мощностей недостаточно для развития проекта, и было принято решение закупить несколько десятков серверов Supermicro на базе материнской платы X7DWU. В качестве сетевой составляющей использовали коммутаторы Cisco Catalyst 3750. Это оборудование с начала 2009 года мы устанановили в новый ЦОД «Синтерра» и в «М10».

Хранение контента начали переводить на промышленную систему хранения данных. Выбор пал на NetApp: контроллеры FAS3140 с дисковыми полками DS14. В последствие СХД расширялась контроллерами серий FAS3170 и FAS3270 с использованием более современных полок DS4243.

К лету 2009 года образовалась «неожиданная» проблема — так как никто конкретно не отвечал за обслуживание центров обработки данных, то каждый, кто ставил туда железо или проводил коммутацию, чувствовал себя не хозяином, а гостем. Отсюда нарисовались джунгли проводов и беспорядочным образом разбросанные серверы.

Было принято решение закрепить ответственность за данное направление (сотня серверов, десяток стоек и коммутаторов) за выделенным сотрудником. С тех пор инфраструктура доросла до пяти сотен серверов, несколько десятков коммутаторов и стоек, сотрудник превратился в отдел из трёх человек.

Параллельно прошла закупка нового сетевого оборудования — выбор остановился на Juniper (коммутаторы Juniper EX8208, EX4200, EX3200, EX2200 и маршрутизатор MX480). И осенью 2009 года, когда получили новое оборудование, то провели масштабные работы по наведению порядка (в ЦОД «Синтерра») и ввода в эксплуатацию нового оборудования с минимальным перерывом сервиса.

Смонтировали новое сетевое оборудование, подвели элементы новой СКС (на тот момент мы ещё расшивали патч-панели).

Украсили гирлянду временными патч-кордами, чтобы свести к минимуму перерывы сервиса при работе.

В итоге пришли к такому порядку. Схема End-of-Row — рабочая, но имеет свои понятные минусы. Через несколько лет, расширив парк сетевого оборудования, перешли к схеме Top-of-Rack.

Окончательный перевод на новое оборудование состоялся 4 ноября — в День народного единства.

В конце 2009 года мы запустили свой узел в ЦОД «М9». Основной целью было получение доступа к тем сотням операторов, которые присутствуют на «Девятке» (даже сейчас в Москве нет реальной альтернативы данному учреждению). Здесь мы установили маршрутизатор Juniper MX480, коммутаторы Juniper EX4200, EX2200 и новенькие серверы Dell PowerEdge R410.

Juniper MX480

Juniper EX2200, EX4200

Тогда ещё казалось, что стойки 52U на «M9» безразмерные, а теперь едва в них умещаемся.

Раньше серверы мы принимали не сразу в ЦОД, а в офисе, где проходила проверка и первоначальная настройка серверов перед отправкой в ЦОД.

Уютное просторное серверное помещение без окон и системы кондиционирования, в котором в качестве бонуса располагался некий завхоз, постоянно предлагающий отобедать «клюковкой» за компанию.

С 2010 года мы активно росли: новые проекты, новое оборудование, новые стойки в ЦОД. В середине 2011 года коллеги обратили внимание, что сотрудник, отвечающий за железо и ЦОД, не появляется в офисе даже в день аванса и зарплаты (благо они приходят на карточку). Мы скучали!

Минута славы (понял, что пишу больше для себя, чем для хабра)!

Но темпа никто сбавлять не собирался. В новом ЦОД «M77» мы запустили новый проект (NTVPLUS.TV) и начали строить второе ядро RUTUBE.RU, чтобы при падении основного ЦОД РУТЬЮБ продолжал работать.

Небольшая партия серверов Sun Fire X4170×64.

Коммутаторы Juniper EX8216, EX4200, EX2200 и немного NetApp.

Очередное соревнование «успей обжать 100500 патч-кордов до запуска проекта».

С СКС завершили и ЦОД запустили.

Вот и NetApp FAS3170 с полочками DS4243 постепенно наполняется контентом.

Тем временем наши системные администраторы завершают настройку Sun Fire X4170×64.

А «главный по проводочкам» завершает наводить красоту (AKA порядок).

2011 год начали с продолжения расширения второго ядра в ЦОД «M77», когда получили новую партию серверов Dell PowerEdge R410 и в рамках нового проекта (от технологического партнёра), серверы на платформе Quanta.

В сетевой инфраструктуре всё больше появлялось 10G-коммутаторов — первой ласточкой стал Extreme Summit X650–24x. Потом были и более интересные Extreme Summit X670–48x.

Вот, чего не хватало в детстве, чтобы построить свой картонный домик.

Не успев выдохнуть после окончания работ в ЦОД «М77» перебазировались в ЦОД «Синтерра», где необходимо было ввести в эксплуатацию Juniper EX8216 вместо EX8208 (нужно было ставить ещё платы для подключения операторов и серверов).

В это же время мы начали монтаж нашего первого комплекса DWDM (активный вариант), связывающего три основных ЦОД «М9», «Синтерра» и «М77» поверх тёмной оптики. Тут нам помог отечественный производитель — Т8.

Juniper EX8216 и DWDM

В 2012 году у нас появился отдел, отвечающий, за ЦОД и железо (то есть, вместо одного сотрудника стало два). До этого, конечно, все работы выполнял не один человек — ему активно помогали коллеги сетевые и системные администраторы. С тех пор отдел старается балансировать между порядком, унификацией, красотой и оперативной работой в рамках задач по развитию проектов.

Проект в наши дни

Новый этап развития начался в 2014 году, когда стали менять СХД, оптимизировать серверную инфраструктуру, запуская новые кэширующие серверы, а также (уже в 2015) провели замену всего основного сетевого оборудования, так как старое уже не удовлетворяло текущим потребностям.

СХД NetApp верой и правдой нам прослужила 5 лет. За это время мы поняли, что на содержание и расширение СХД требует трат, которые не соразмерны остальным подсистемам. Начали поиск более рационального решения, который закончился поэтапным внедрением СХД собственной разработки (переход начался в начале 2014, а закончился осенью 2015). Теперь СХД состоит из 12-дисковых серверов (Supermicro, Quanta) и софта, написанного нашими разработчиками. Для нас это стало отличным решением, и в данный момент NetApp сняли с поддержки и часть его используем в качестве СХД под разные технологические нужды.

В начале 2014 года приняли решение модернизировать систему кеширования, которая на тот момент представляла сотню серверов с 4 гигабитными интерфейсами и гибридной дисковой подсистемой (SAS + SSD).

Мы решили выделить серверы, которые будут отдавать «горячий» (активно просматриваемый) контент, в отдельный кластер. Этими серверами стали Supermicro на материнской плате X9DRD-EF с двумя процессорами Intel Xeon E5–2660 v2, 128 Гб ОЗУ, 480 Гб SSD и 4 сетевыми картами Intel X520-DA2. Опытным путём установили, что такой сервер без особых проблем отдаёт 65–70 Гбит/с (максимум было 77 Гбит/c).

В середине 2014 года мы заменили активный DWDM на пассивный. Это позволило нам сильно нарастить его ресурсы и начать «разводить» операторов, подключённых в одном ЦОД, на другие площадки, снижая зависимость от выхода из строя конкретного пограничного оборудования.

К концу 2014 года запустили и новый кластер для «холодного» контента, которые пришли на смену оставшимся серверам с агрегатом на 4 Гбит/с. И снова наш выбор пал Supermicro на материнской плате X9DRD-EF, на этот раз с двумя процессорами Intel Xeon E5–2620 v2, 128 Гб ОЗУ, 12×960 Гб SSD и 2 сетевыми картами Intel X520-DA2. Каждый узел этого кластера способен держать нагрузку до 35 Гбит/с.

Естественно, дело не только в грамотно подобранном железе, но и в замечательных самописных модулях для сегментации, написанных нашим системным чудо-архитектором и замечательном видеобалансировщике, созданном командой разработки. Работы по выяснению предельных возможностей данной платформы продолжаются — остались слоты под SSD и сетевые карты.

2015 год ознаменовался заменой всего основного сетевого оборудования, включая переход с аппаратных балансировщиков нагрузки на программные (Linux + x86). Вместо коммутаторов Juniper EX8216, большей части EX4200, Extreme Summit X650–24x и X670–48x заступили на службу маршрутизаторы Cisco ASR 9912 и коммутаторы Cisco Nexus 9508, Cisco Nexus 3172PQ и Cisco Nexus 3048. Конечно, развитие нашей сетевой подсистемы повод для отдельной большой статьи.

После работ по замене старого серверного оборудования и сети стойки выглядят вновь не так хорошо, как хотелось бы. В обозримом будущем закончим наведения порядка и опубликуем красочную статью с фотографиями, как мы вступаем в 2016 год.