Llama 4 разочаровала экспертов: в чем дело

Meta* (признана в России экстремистской организацией и запрещена на территории РФ) представила две новые модели искусственного интеллекта, Llama 4 Scout и Llama 4 Maverick, в минувшие выходные. Компания заявила о прорывных возможностях своих разработок, но первые тесты и отзывы экспертов говорят об обратном, сообщает Ars Technica.

Главное обещание, контекстное окно в 10 миллионов токенов для модели Scout, оказалось практически недостижимым. Контекстное окно определяет объем информации, который ИИ может обработать за один раз. Чем оно больше, тем с более длинными текстами и сложными задачами справится система.

На практике сторонние сервисы, предоставляющие доступ к Llama 4, вынуждены существенно ограничивать этот параметр. Groq и Fireworks позволяют использовать лишь 128 тысяч токенов, а Together AI — 328 тысяч. Это значительно меньше заявленных 10 миллионов. «Чтобы запустить модель с контекстом всего в 1,4 миллиона токенов, нужно восемь высокопроизводительных GPU Nvidia H100», — отмечает независимый исследователь ИИ Саймон Уиллисон. Такие требования к оборудованию делают использование полного потенциала модели недоступным для большинства пользователей.

Уиллисон также протестировал Scout на задаче обобщения длинной дискуссии объемом около 20 тысяч токенов. Результат он охарактеризовал как «полный мусор», который превратился в бессмысленные повторы.

Архитектура «смеси экспертов» (MoE), на которой построены новые модели, тоже вызвала критику. Эта технология позволяет активировать только нужные части нейросети для конкретной задачи. В теории это должно экономить вычислительные ресурсы без потери качества.

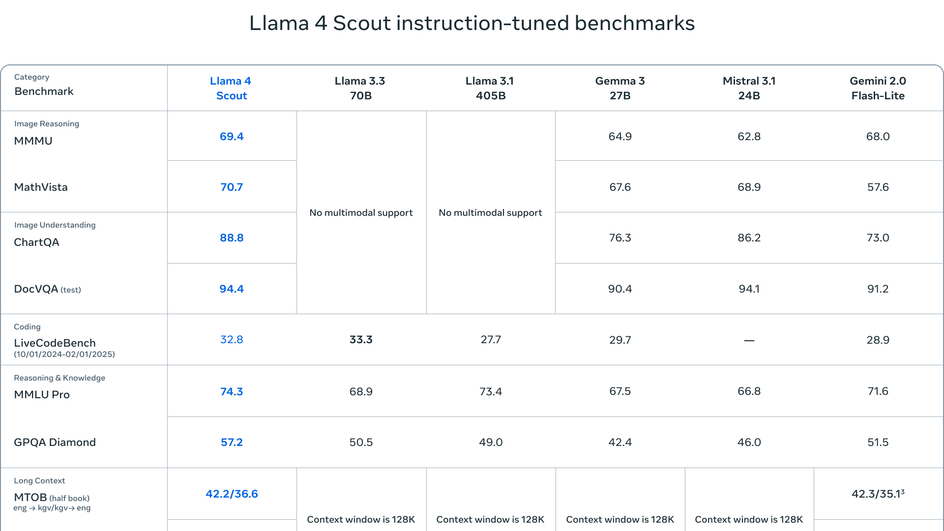

Llama 4 Maverick имеет впечатляющие 400 миллиардов параметров, но в любой момент активны только 17 миллиардов из них. Scout содержит 109 миллиардов параметров с теми же 17 миллиардами активных. Эксперты считают, что 17 миллиардов активных параметров — слишком мало для заявленного уровня производительности.

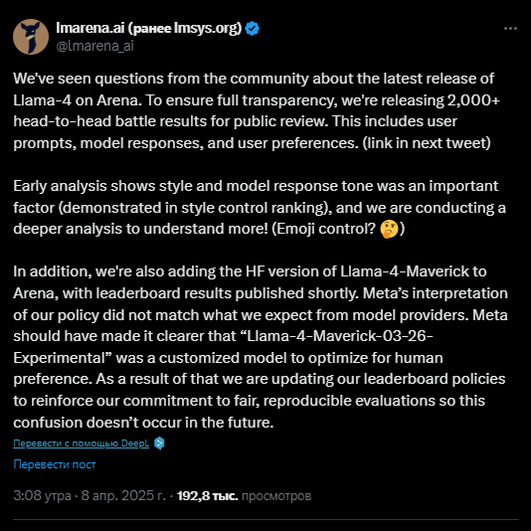

Пользователи выяснили, компания использовала модифицированную версию Llama 4 Maverick для тестирования на платформе LMArena, которая отличается от публично доступной версии. Компания применила «экспериментальную чат-версию», специально «оптимизированную для разговорности», что привело к высоким результатам в рейтинге. Это вызвало обвинения в нечестной практике и ввело в заблуждение разработчиков относительно реальных возможностей модели

Также в Reddit отмечают слабые результаты Llama 4 в задачах программирования по сравнению с конкурентами DeepSeek и Qwen. Многие указывают на посредственные мультимодальные функции, хотя разработчики позиционируют свои модели как «изначально мультимодальные», способные одинаково хорошо работать с текстом и изображениями.

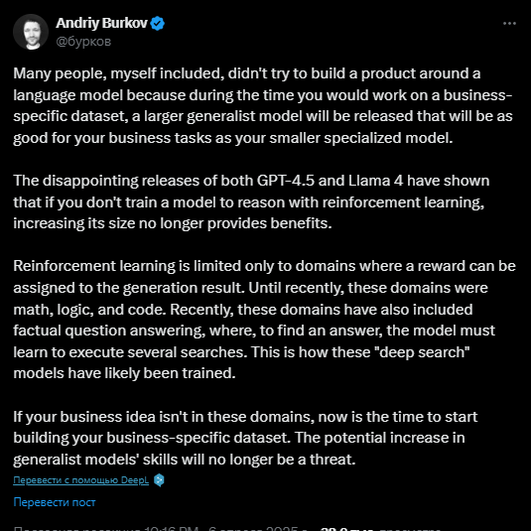

Исследователь Андрей Бурков видит в этом признак более глобальной проблемы: «Разочаровывающие релизы GPT-4.5 и Llama 4 показали, что простое увеличение размера модели больше не дает преимуществ без обучения рассуждать с помощью подкрепления».

Несмотря на критику, Уиллисон сохраняет оптимизм: «Я надеюсь, что мы увидим целое семейство моделей Llama 4 различных размеров. Особенно интересно, смогут ли они создать улучшенную компактную модель, которая будет работать на смартфоне».

Релиз Llama 4 показывает, что даже технологические гиганты сталкиваются с фундаментальными ограничениями в развитии искусственного интеллекта. Простое наращивание вычислительной мощности и количества параметров уже не гарантирует качественного скачка в возможностях ИИ-систем. Индустрии требуются новые подходы к обучению моделей и архитектурные инновации.

А пока компания разбирается с критикой пользователей, Microsoft показывает хорошие результаты. Она воссоздала Quake 2 с помощью ИИ, рассказали об этом в статье.

*Meta признана в России экстремистской организацией и запрещена на территории РФ

HI-TECH@Mail.Ru прочитано 7229 раз