Продвинутый генератор видео Kling AI получил обновление: что изменилось

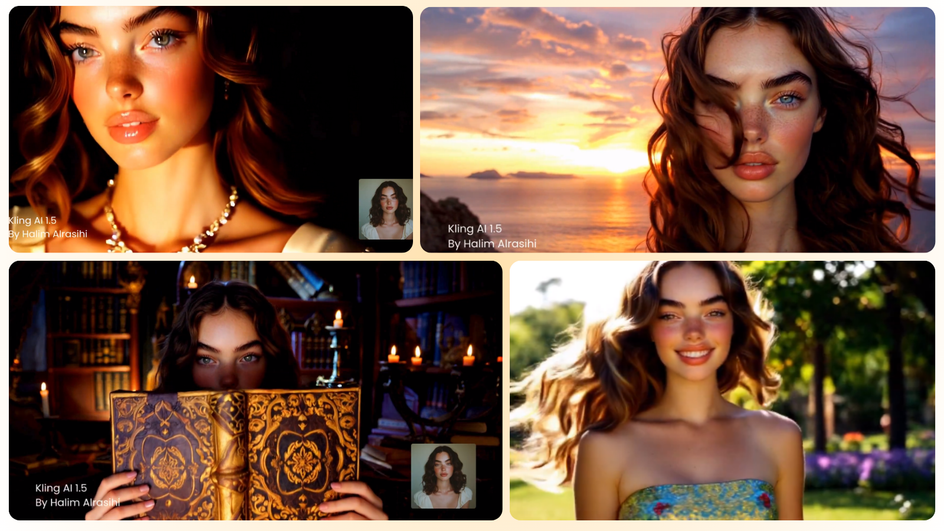

Нейросеть для создания видео на основе текстовых запросов Kling выпустила масштабное обновление, которое открывает пользователям новые возможности. Теперь любой желающий может создать уникального персонажа для видео и сделать его более «живым» благодаря поддержке пользовательских моделей. Это нововведение обещает повысить реалистичность и разнообразие контента, позволяя кастомизировать каждого героя под индивидуальные задачи.

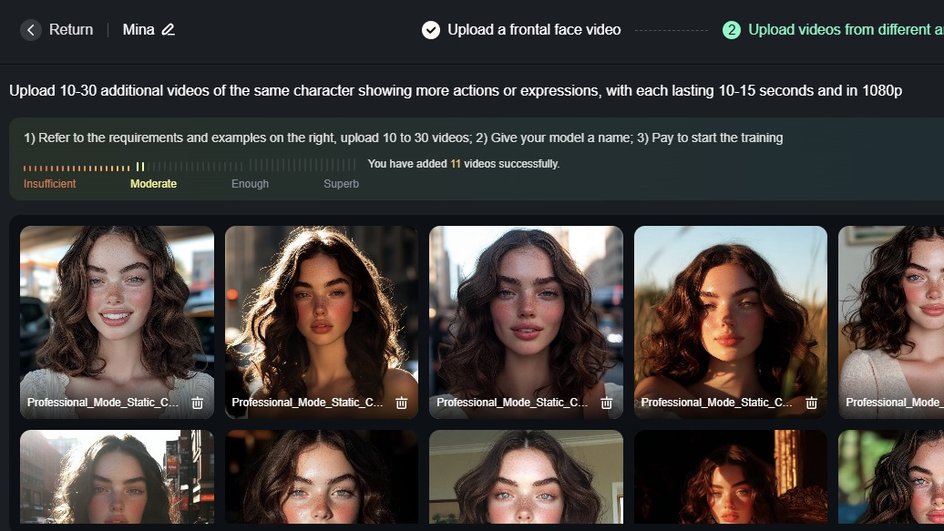

В обновлении появилась возможность тренировать модели для видео, что позволяет создавать устойчивый и последовательный образ персонажа в движении. В отличие от классического подхода, где для обучения модели используются только изображения, Kling предлагает загружать короткие видеоролики, чтобы запечатлеть персонажа во всей его выразительности. По словам разработчиков, достаточно 10−30 коротких видео продолжительностью от 10 секунд, чтобы нейросеть смогла создать запоминающийся и устойчивый образ.

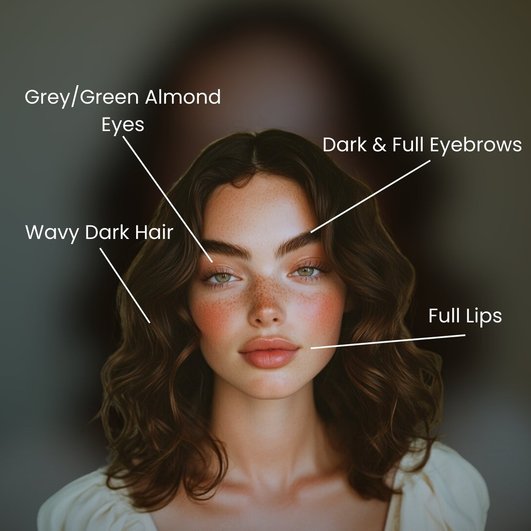

Для начала нужно загрузить на платформу фотографии или создать их с помощью других генеративных нейросетей. Затем пользователь делает несколько генераций с персонажем в разных локациях, позах и с разными выражениями лица. Главное, чтобы в каждом кадре акцент был на лице героя — это позволит нейросети захватить все особенности мимики и движений. Как только видео загружены, начинается процесс тренировки модели, что позволяет персонажу «оживать» и взаимодействовать с различными фонами и объектами.

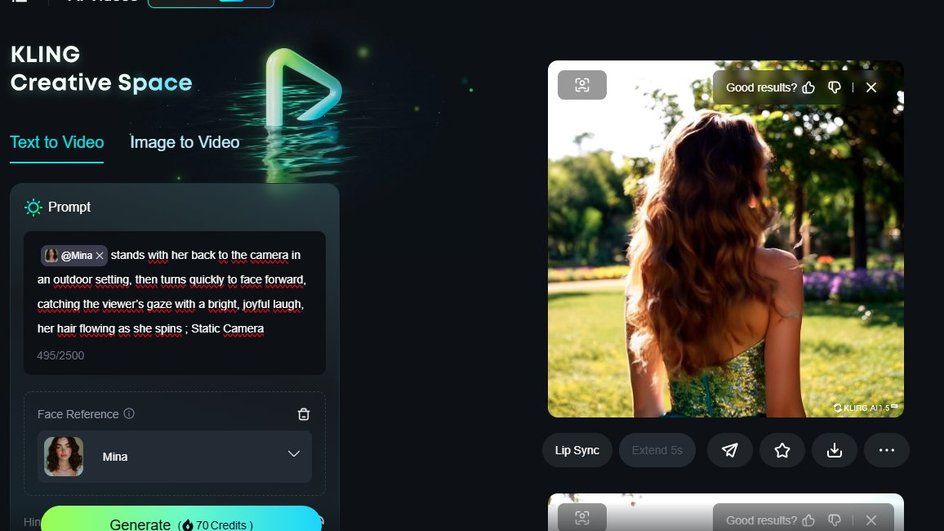

С помощью Kling AI пользователи могут управлять действиями и мимикой персонажей за счет текстовых команд. Например, можно повернуть все лицо в нужном направлении или только взгляд. Такие возможности открывают новые горизонты, позволяя создавать контент с глубокой эмоциональной и визуальной составляющей.

Благодаря обновлению пользовательская модель Kling также поддерживает настройку ракурсов камеры и освещения, что помогает создавать сложные сцены, где лицо персонажа постепенно появляется в кадре. Есть возможность задать сценарий, в котором камера сначала фокусируется на руке персонажа, а затем плавно поднимается к лицу. Это добавляет ролику кинематографический эффект и позволяет зрителю ощутить более глубокое погружение в атмосферу.

Также в прошлом месяце Adobe представила новую ИИ-функцию в Premiere Pro. Чтобы добавить кадры между двумя нарезками, достаточно нажать одну кнопку и нейросеть сама дорисует недостающие фрагменты.