Пользователи нашли «запретные» для ChatGPT имена: в чем дело

Пользователи сети выяснили, что ChatGPT не способен отвечать на запросы, в которых упоминаются некоторые имена. Например, при попытке указать, «Брайан Худ» или «Джонатан Терли» на английском языке бот выдает ошибку или мгновенно завершает беседу. Подобное поведение вызвало активное обсуждение в соцсетях и стало поводом для множества теорий.

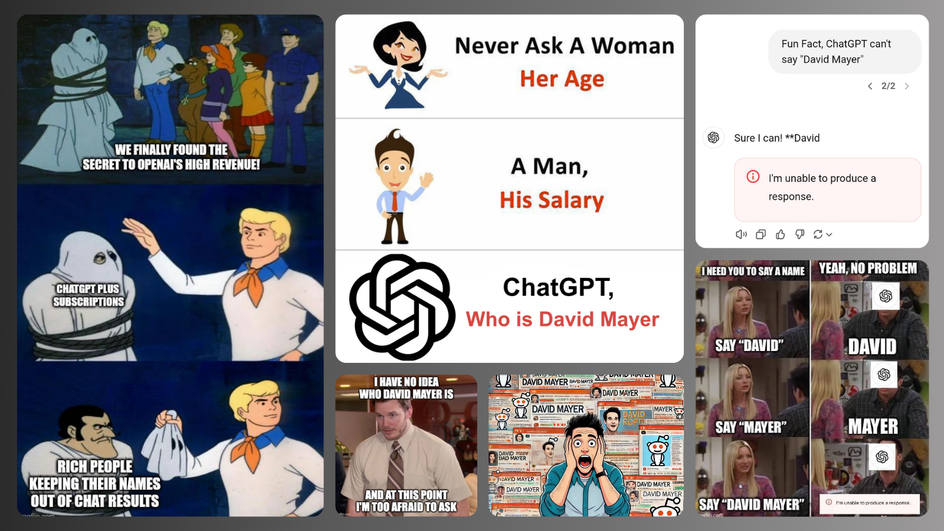

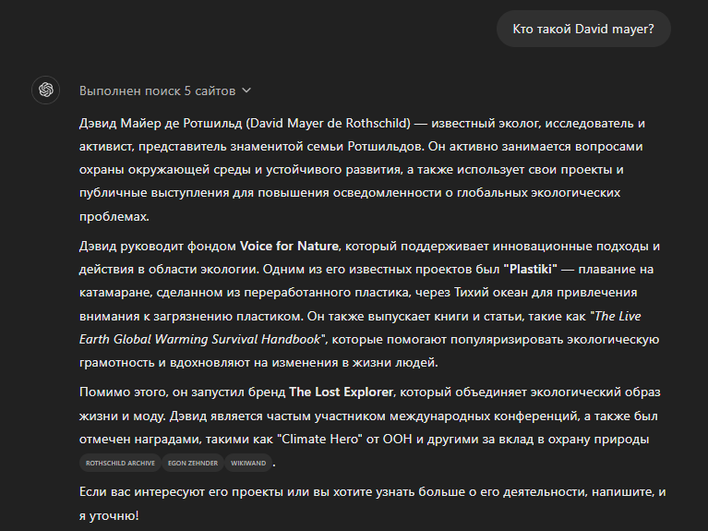

Изначально пользователи обнаружили проблему, вводя имя «Дэвид Майер». Вместо ответа бот отказывался генерировать текст, что было расценено как баг. Однако углубленный анализ показал, что причина связана с жесткими фильтрами, которые встроены в систему ChatGPT.

Как работают фильтры ChatGPT

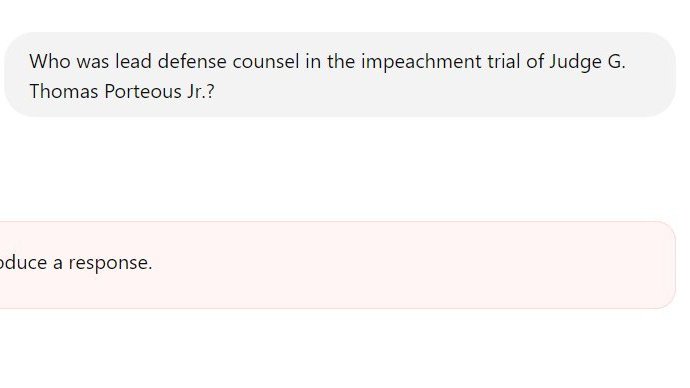

Для защиты от распространения вредной информации разработчики OpenAI добавили в ChatGPT ограничения, блокирующие упоминание определенных имен. Эти фильтры включают известные личности, о которых бот может случайно выдать ложную информацию. Например, в случае с Брайаном Худом модель выдумала, что он был осужден за взяточничество, хотя в реальности он являлся разоблачителем корпоративных махинаций.

Судебное разбирательство вынудило OpenAI внедрить «хардкод» — жесткий запрет на обработку имени. Впоследствии подобные меры были приняты и для других фигур, таких как юрист Джонатан Терли, чье имя система ранее связывала с вымышленным скандалом.

Примеры «запретных» имен

На данный момент пользователи X выявили несколько имен, которые вызывают сбой:

- Брайан Худ;

- Джонатан Терли;

- Джонатан Зиттрейн;

- Гвидо Скорца;

- Дэвид Майер;

- Дэвид Фабер.

Примечательно, что эти фильтры действуют только в ChatGPT и не влияют на API OpenAI, который используют разработчики. Также блок не работает на русском языке.

Какие риски несет система фильтров

Несмотря на защиту от ошибок, такая стратегия приводит к ряду сложностей. Во-первых, любое популярное имя, попавшее под запрет, ограничивает пользователей в выполнении задач. Например, учитель, который попытается составить список учеников, не сможет использовать ChatGPT, если среди имен окажется «Дэвид Майер».

Во-вторых, фильтры открывают двери для атак. Злоумышленники могут использовать «скрытые» слова в изображениях или коде, чтобы сбить ИИ. Такие уязвимости уже были выявлены специалистами.

Как решить проблему

Фильтрация имен — важный, но недостаточно гибкий инструмент. Для улучшения модели OpenAI необходимо разработать динамические механизмы проверки информации. Например, вместо блокировки имя можно помечать как «требующее подтверждения».

Искусственный интеллект остается мощным инструментом, однако подобные проблемы подчеркивают необходимость его дальнейшего совершенствования. Тем временем пользователи продолжают находить новые «запретные» слова и заставляют OpenAI искать баланс между безопасностью и функциональностью.

Если вы опасаетесь, что такими темпами ИИ совсем скоро сможет блокировать всю информацию о человеке в сети, спешим вас успокоить. Исследования утверждают, что настолько мощная нейросеть не появится в ближайшие 20 лет.