Бояться не надо? Разбираем, как Apple будет сканировать ваши фото на айфоне, искать запрещёнку и даже докладывать в органы

Вчера Apple анонсировала пакет мер по защите детей и их родителей, пользующихся iPhone и iPad. Больше всего внимания привлекла одна специфическая функция — анализ фотографий на iPhone ради поиска незаконных и запрещённых изображений.

Звучит это пугающе, но реальность, как обычно, не чёрная или белая. Поэтому я постарался разобраться в вопросе и представить его вам в максимально понятном виде.

Очень советую нашим читателям внимательно ознакомиться с этим несложным, но достаточно подробным объяснением работы технологии. Она совсем не такая страшная и, тем более, опасная, как может показаться по заголовкам новостей и первым категоричным мыслям, возникающим под давлением современного инфополя.

Потому что очень важно кричать «волк» только тогда, когда волк и вправду есть. Иначе между вами и поджигателями 5G-вышек не будет никакой разницы в степени невежества. А это — плохо.

Как на самом деле работает эта система

Если боитесь сложных слов, вот перевод всего текста далее на очень простой русский язык:

Ваши фотографии вначале хитро конвертируются в циферки, а эти циферки сверяются с циферками, присвоенными гарантированно нехорошим фотографиям. Если циферки совпали, то это нехорошо, но не критично. А если таких совпадений становится ну очень, ОЧЕНЬ много, то тогда сверкой циферок займётся специальный человечек.

Если человечек заметит очевидное совпадение циферок всех подозрительных фотографий с циферками очевидно нехороших картинок, то тогда данные про вас передадут дальше, к дядям и тётям в уполномоченных организациях.

Данные далее взяты из технического документа Apple, размещённого на официальном сайте 5 августа 2021 года. В статье будет неоднократно упомянута фраза CSAM. Термин расшифровывается как Child Sexual Abuse Material, и не думаю, что тут кому-то нужен перевод.

Поехали!

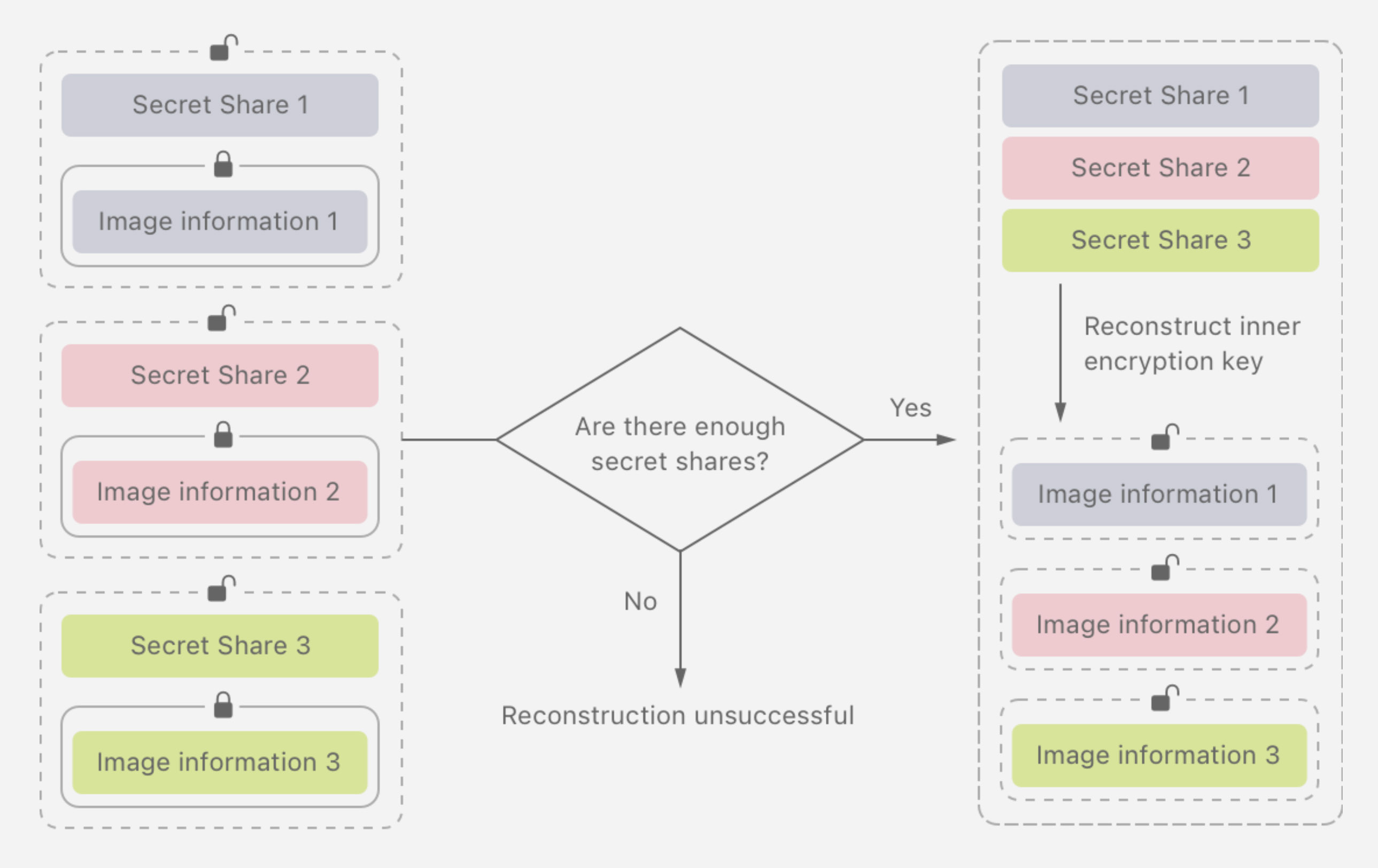

Это алгоритм раскрытия данных изображений при превышении порога сработок CSAM. Источник: Apple

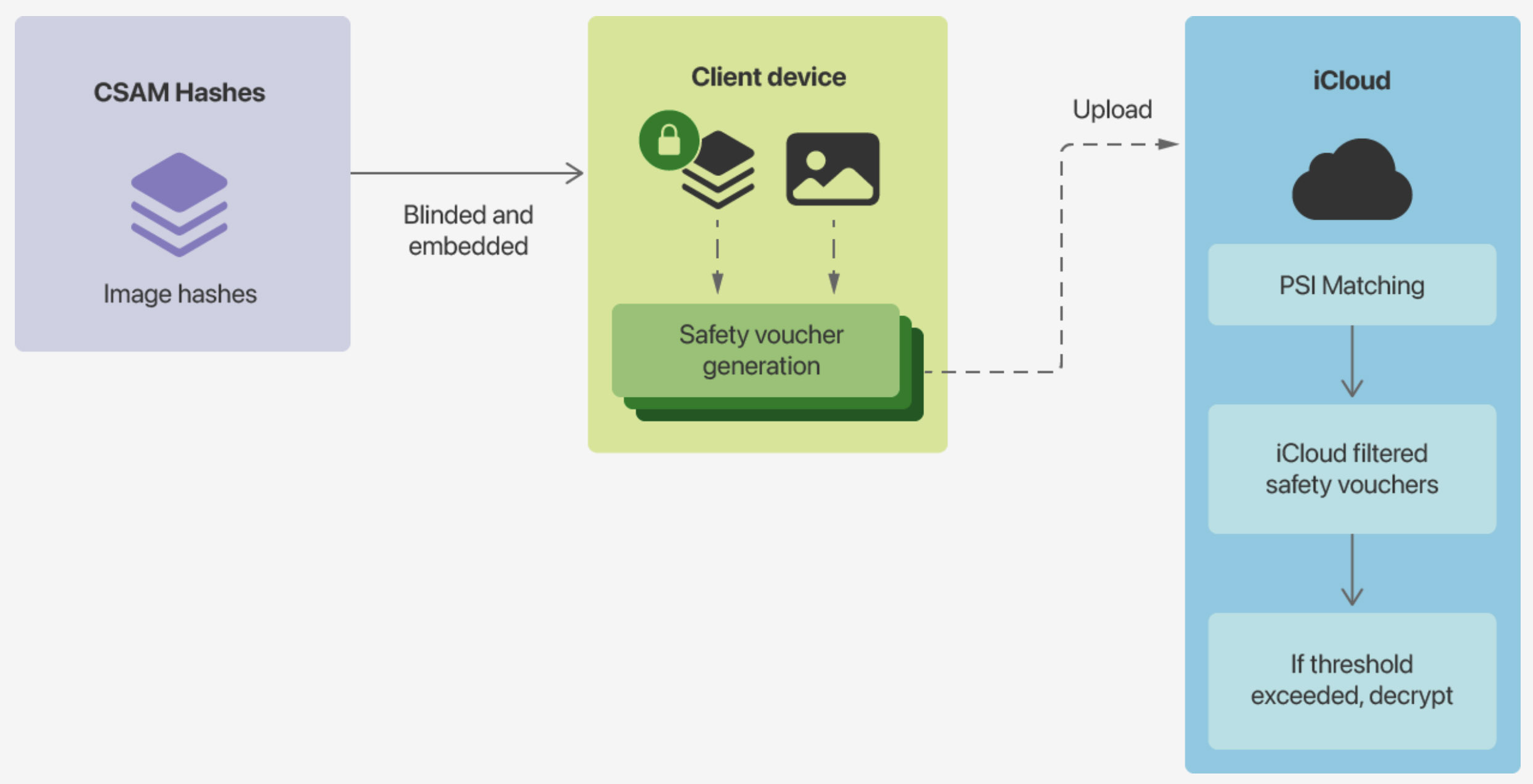

Итак, метод Apple для поиска CSAM заточен под максимальную защиту пользователей. Компания не будет сканировать изображения в облаке iCloud. Вместо этого система будет сверять изображения на самих устройствах (то есть на iPhone) с базой данных хэшированных изображений, предоставленной NCMEC и другими организациями по защите детей.

Поэтапно представить весь метод в простой форме можно так:

фото → шифровка → поиск совпадения шифровок → выгрузка в iCloud → последующий контроль количества совпадений → проверка в случае большого количества совпадений

Немного пояснений. NCMEC, который предоставил базу данных, это Национальный центр по проблемам пропавших без вести и подвергающихся эксплуатации детей, американская частная некоммерческая организация.

База данных, полученная от NCMEC и других организаций, превращена Apple в «нечитаемый», дополнительно зашифрованный набор хэш-сумм, который начнёт храниться на iPhone всех пользователей вместе с выходом iOS 15 и iPadOS 15. А хэш-сумма — это кодированная строка данных, информацию из которой можно извлечь, лишь зная первоначальный алгоритм шифрования. То есть тут, как говорится, шифр на шифре шифром погоняет.

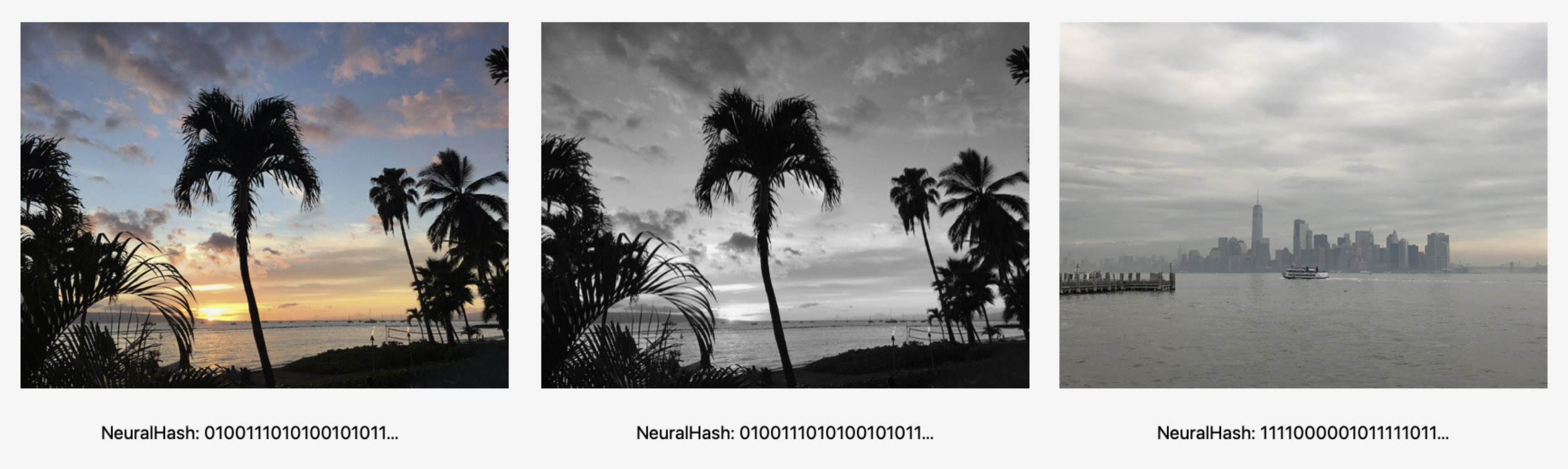

По методу Neuralhash, фактически одинаковые фотографии слева и в центре обозначаются одним общим кодом. У той, что справа, код будет другим.

Метод, по которому изображения превращаются в хэш-сумму, называется NeuralHash. Он анализирует изображения и присваивает им уникальный номер. Только изображения, которые выглядят максимально идентично, получают один общий номер.

При этом, обрезанное, отражённое, сжатое и прочим образом отредактированное изображение всё равно получит номер, как у оригинала.

Переходим к главному, что нужно знать: момент идентификации, то есть точка, в которой Apple будет осуществлять проверку ваших изображений.

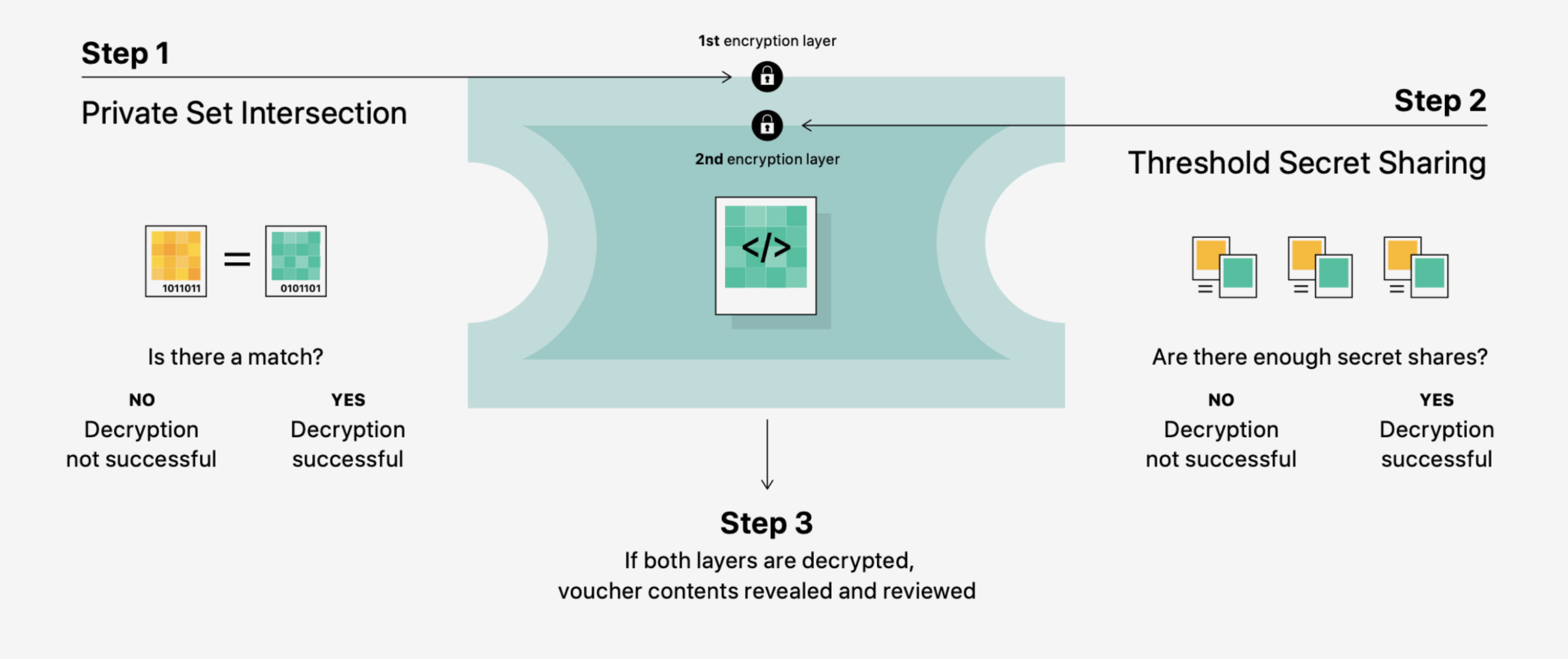

Сверка фото происходит перед тем, как изображение выгружается из iPhone на сервера iCloud. Процесс происходит через метод «private set intersection» — грубо говоря, система не раскрывает наличие или отсутствие совпадений с базой, а просто создаёт результат сверки. Затем iPhone создает криптографический «сертификат безопасности» (safety voucher), в который вшит зашифрованный результат сверки. В «сертификат безопасности» также вшивается хэш-сумма NeuralHash и визуальная репрезентация фото.

Всё это происходит за доли секунды, после чего фотография успешно выгружается в iCloud вместе с пришитым «ваучером безопасности».

Так выглядят условия, при которых разрешается расшифровка «сертификата безопасности». Источник: Apple

Получается, что каждой выгруженной в iCloud фотографии ваш iPhone присваивает конверт с билетиком со статусом вакцинации — это если хотите аналогию к понятным современным реалиям.

Но в «конверт» просто так не заглянуть. Отдельная технология «threshold secret sharing» в автоматическом режиме, без участия человека, гарантирует, что Apple не сможет посмотреть «ваучер безопасности» вплоть до момента, пока количество совпадений CSAM-контента у отдельно взятого пользователя не превысит «порог внимания».

Алгоритм формирования и хранения в iCloud фотографии с iPhone и её «сертификата безопасности». Источник: Apple

Apple не узнает ничего про изображения, которые не совпадут с базой данных CSAM. Подобные данные просто не будут отправлены на сервер. Apple также не сможет узнать метаданные и прочую информацию про фотографии пользователя, пока количество срабатываний CSAM на устройстве не превысит так называемый «порог внимания».

Порог внимания неизвестен, но он выставлен таким образом, чтобы исключить спорные ситуации. Можно смело предполагать, что если у вас нет множества критически схожих изображений из базы CSAM, статистически гарантирующего наличие противоправного контента на устройстве, то вы никогда не удостоитесь внимания специалиста по мониторингу.

Сама Apple гарантирует, что риск некорректной пометки аккаунта пользователя как требующего внимания специалиста «экстремально низок». А прежде, чем довести информацию до государственных и международных служб безопасности, компания сама вручную проверит пользователя, чтобы окончательно исключить ложные срабатывания на банально схожие фото личного характера.

База CSAM засекречена, доступ извне к ней невозможен, и простым пользователям невозможно внести туда изменения. В то же время пользователь iPhone не узнает, какие именно из его изображений были помечены как потенциально подозрительные через систему идентификации CSAM.

У пользователя также остаётся путь решения проблем: если аккаунт после всех проверок будет признан нарушающим правила iCloud и заблокирован, то он может подать апелляцию, которую вручную рассмотрят специалисты Apple.

Важно: система CSAM на данный момент будет работать ТОЛЬКО в США. Активация в других странах — в планах, но когда это произойдёт, неизвестно. Про Россию в анонсе не было ни слова.

Если вы не выгружаете фотографии в iCloud, то система вообще ничего не будет анализировать. Также эта система анализирует только файлы изображений, а не видео. Наконец, ваши личные фото никто не увидит в «чистом виде» в любом случае.

Вышеупомянутые факты актуальны на сегодняшний день и базируются на информации, которую пока предоставила Apple. До выхода iOS 15 и момента формальной (фактической) активации системы всё может частично или полностью измениться.

Главный сюрприз: эта система уже существует почти ВЕЗДЕ

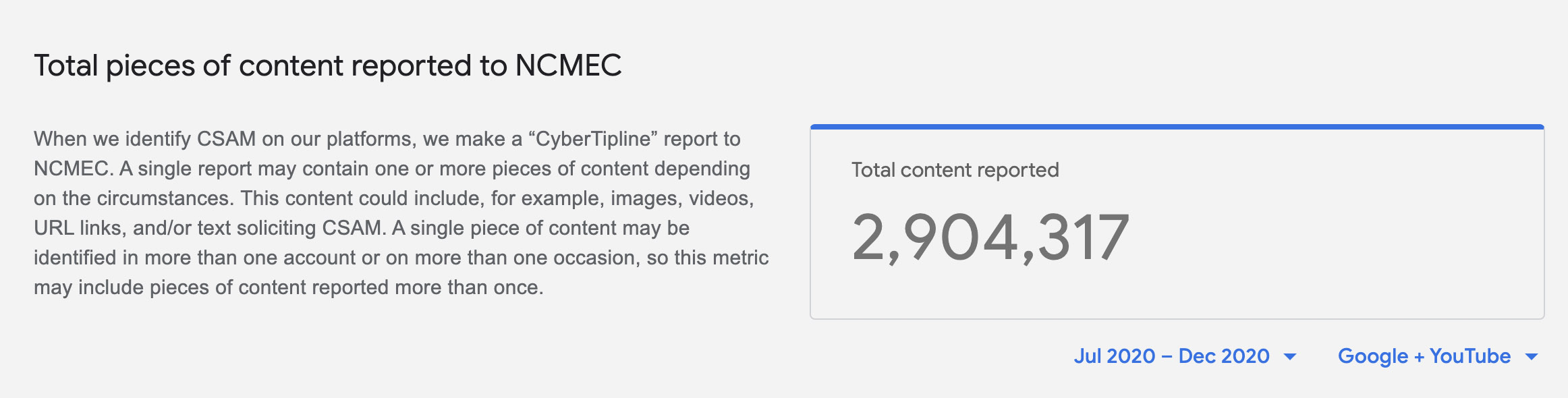

С июня 2020 года по декабрь 2020 Google идентифицировала 2904317 случаев совпадений CSAM-контента в Поиске Google и YouTube. Источник: Google

Да, похожие системы сканирования хэшированного контента уже есть во всех мало-мальски популярных рабочих средах.

Microsoft, Google, Twitter, Facebook и крупные облачные сервисы (например, Dropbox) уже давно используют CSAM-сканирование в своих ПО и продуктах. Оно точно так же встроено в Microsoft Office, Gmail и Поиск Google: ищет совпадения с международными и локальными базами запрещённых изображений. И абсолютно так же оно сообщает на сервера каждое совпадение — вплоть до превышения некоего «порога», после которого на пользователя обращает внимание специалист.

Многие из справочных материалов не переведены на русский язык, но ознакомиться с ними как минимум полезно для понимания принципа работы таких систем в крупнейших интернет-платформах и сервисах:

► Microsoft: Protecting children online, PhotoDNA

► Google: efforts to combat online child sexual abuse material

► Facebook: online child protection (на русском)

Единственная причина, почему инфополе так взволновано аналогичным шагом Apple — высочайший медийный вес любого анонса компании. Когда то же самое делали другие, это «почему-то» никого не напрягало.

В данном случае Apple просто отвечает на современные вызовы и требования регуляторов крупных государств. Борьба с международно запрещённым контентом усиляется ежегодно, а CSAM-сканирование уже давно используется повсеместно.

Раз так, то почему столько негатива?

Apple анонсировала немало инициатив по защите детей в iOS 15, и даже жалко, что они утонули в обсуждении теории лишь одной из них. Источник: Apple

Как пользователи, так и эксперты по безопасности не видят проблемы в инициативе Apple в том виде, как она представлена. Идея контроля содержимого фото по хэш-сумме не нова. Её уже много где используют, вплоть до популярных браузеров. Людей ещё не обвиняли на основе ложноположительных совпадений личных фотографий и универсально незаконного контента.

Проблема, которую подчёркивают исследователи в сфере безопасности, кроется в другом. Сканирование производится на устройстве, а не в интернете, что в масштабах сотен миллионов смартфонов происходит впервые. Появление подобных механизмов в iOS ставит Apple на хрупкую дорожку.

Осенью 2021 года эта система начнёт искать очевидную «запрещёнку» на основе хэш-сумм. Опасаются вот чего: что объективно остановит спецслужбы США и авторитарные государства от добавления в базы «запрещёнки» каких-то специфических фотографий? Например, активиста или политика, спецагента под прикрытием, идеологически нежелательных изображений и тому подобного?

Смартфон — это не интернет-браузер, и на нём хранится самая личная информация человека, зачастую даже «личнее», чем на его же компьютере. Падение этого бастиона в случае нарушения принципов CSAM будет означать окончательное разрушение иллюзии конфиденциальности, и дороги назад не построишь.

This sort of tool can be a boon for finding child pornography in people«s phones. But imagine what it could do in the hands of an authoritarian government? https://t.co/nB8S6hmLE3

— Matthew Green (@matthew_d_green) August 5, 2021

Исследователи обращают внимание на то, что Apple уже демонстрировала хоть и ограниченную, но категорически возможную сговорчивость в скользких вопросах. Например, по данным Reuters, компания не стала шифровать копии iPhone на серверах iCloud по требованию ФБР. А в Китае ключи к резервным копиям данных с iPhone и iPad хранятся у государства, а сами копии лежат на местных серверах, что не позволяет Apple полностью гарантировать защиту личных данных китайских пользователей.

Грубо говоря, вопрошают эксперты, где гарантии, что завтра эта система не будет использована для преследования конкретных людей или, хуже, поиска и слежки за целым пластом «неблагонадёжных» на основе тайных или публичных интересов отдельных государств или спецслужб?

С другой стороны, какими бы объективными не казались опасения, без доказательств они не могут считаться истиной. Возмущаться тем, чего не происходило, как минимум преждевременно. Стоимость репутации, которую, очевидно, потеряет Apple в такой ситуации, фактически равна стоимости всей компании — слишком уж долго в Купертино приравнивали к бренду тему безопасности и конфиденциальности.

Всё тайное всегда становится явным, и первый же случай злоупотребления этой системой в пользу отдельных государств и спецслужб приведёт к необратимому разрушению не только репутации, но и коммерческих перспектив продуктов компании в любых странах. Ведь устройства, в которые с завода вшито де-факто шпионское ПО с подтверждённой функциональностью и неизвестными бенефициарами, не захочет впускать на рынок ни одно государство.

Apple слишком долго строила свой закрытый сад, чтобы позволить его полностью разрушить одной инициативой. В этом смысле у компании достаточно противовеса, чтобы отбиваться от давления заинтересованных сторон.

Теперь время и тысячи экспертов по всему миру, желающих первыми вскрыть факты злоупотребления и прославиться, покажут, стоит ли опасаться этой новой системы законопослушным людям.

В одном можно не сомневаться: если однажды Apple поймают за руку, об этом моментально и бесповоротно узнает весь мир. А бояться впустую точно не надо.

Дополнительное чтение:

▪ официальный анонс Apple по мерам безопасности детей в iOS 15

▪ подробное объяснение анонса Apple в официальном PDF-файле

▪ принцип работы поиска CSAM в iOS 15, PDF

▪ принцип работы системы PSI (private set intersection), PDF

▪ технический анализ системы PSI экспертом по безопасности, PDF

▪ еще одна оценка методов Apple от эксперта, PDF

▪…и ещё одна оценка эксперта, PDF