3 года снимаю на iPhone для работы, а он всё лажает в базовых вещах. Apple, исправь, пожалуйста

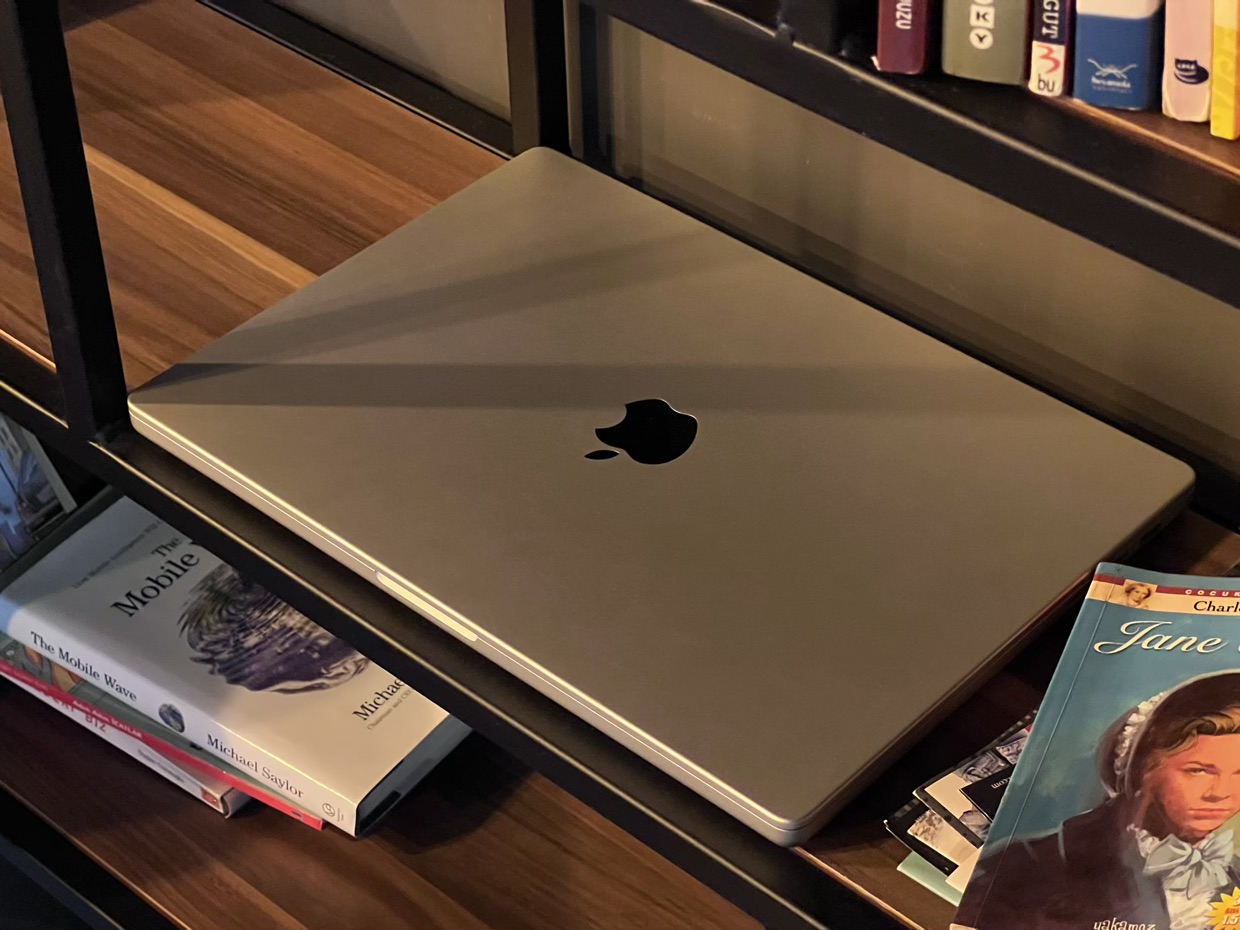

Недавно я сделал фотопост со своими впечатлениями от жёлтого iPhone 14, который полностью снял на iPhone 13 Pro.

Это ужасно, но на обработку в фотошопе того, что выдал смартфон, убил чуть ли не весь день. И не потому что руки у меня кривые. Выровнять все кадры к одной цветовой гамме оказалось слишком сложно.

В каждом новом кадре iPhone красил дерево, руки и предметы на полном рандоме. И это половина проблем.

Ниже на реальных примерах покажу, где iPhone жёстко проседает, и как Apple всего парой новых настроек должна вывести фотографию на новый уровень удобства и натуральности.

В Камере до сих пор нет ручной фиксации цвета

А сторонние приложения не дают того же удобства

С 2019 года топовые модели iPhone выходят под брендом Pro. И рассказы на презентации теперь соответствующие: добавляют профессиональные функции, которые нужны трём процентам покупателей от силы, но вызывают желание купить у всех.

При этом настройки внутри приложения камеры остаются хилыми пятый год подряд. Apple, конечно, пытается сделать их по-своему, а не бездумно копировать из профессиональных камер. Но из-за того, что тут до сих пор нет настройки баланса белого, хочется забить на мобильную съёмку в принципе.

Градация баланса белого. Чем меньше показатель, тем желтее

Баланс белого отвечает за то, чтобы белый цвет выглядел белым и цветовая температура изображения соответствовала действительности. Чтобы фото или видео не уходило в оранжевый и синий.

Измеряется в Кельвинах. Градация такая:

Теплый белый (2700–3200К) Дневной белый (3500–4500К) Белый (5000–6000К) Холодный белый (6000–8000К).На обычных камерах корректный белый значит, что и все остальные оттенки тоже начнут выглядеть естественно.

В теории iPhone тоже так должен работать, но в нём вскрываются сразу две проблемы: нельзя зафиксировать значение вручную и даже при одинаковом показателе этого параметра цвет будет разным.

Проблема с ручным значением лучше всего заметна, когда вы пытаетесь снять пурпурный закат, а iPhone красит его в оранжевый.

Две фотографии без обработки, ни одна их которых не показала реальный оттенок неба

На фотографии выше правда была где-то посередине. Более красное, но точно не электрическо-синее.

Иногда, если мне важно сохранить реальный оттенок неба, лезу в редактор и прямо на месте обрабатываю фотографию, сверяясь с живым примером.

А было бы гораздо проще открыть настройку в приложении Камеры и с помощью слайдера привести значение к нужному.

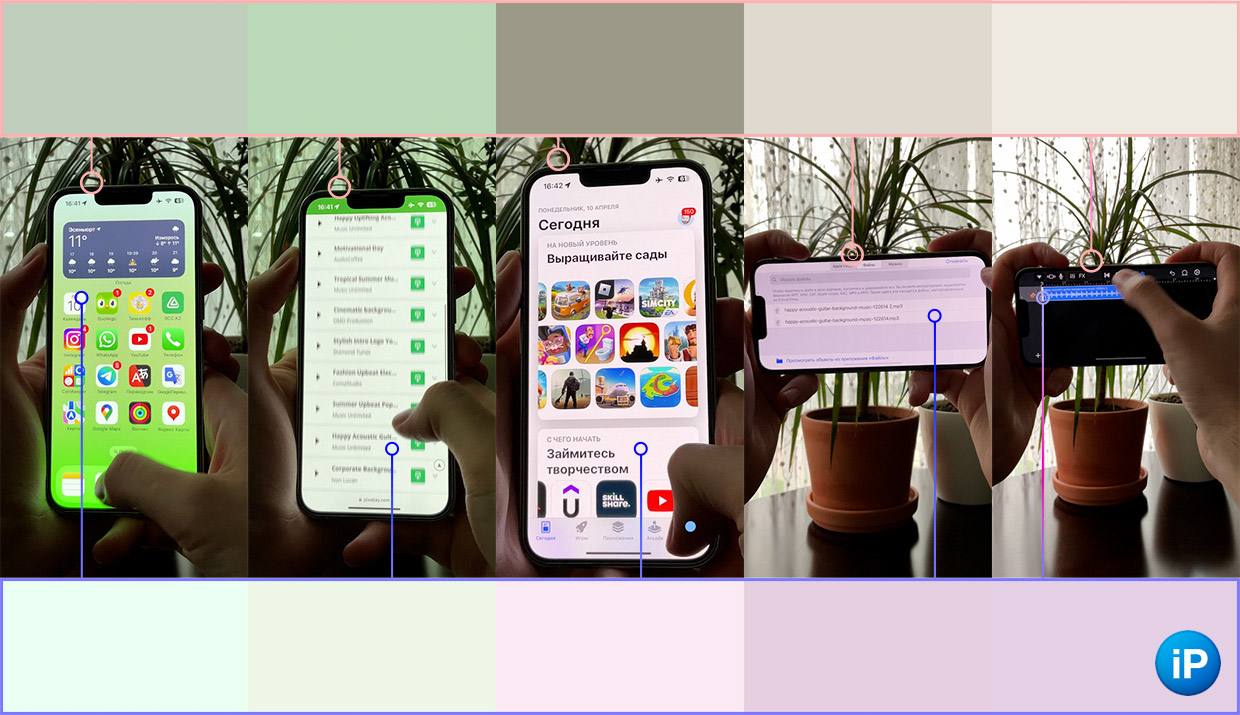

Возвращаясь к жёлтому iPhone 14. Ниже две галереи: конечный результат после обработки сверху и их оригиналы ниже.

То, что я решил добавить в пост, выдержано плюс-минус в одной цветовой гамме.

В авторежиме фон, девайс и чехлы всё время получались разными. При этом, к сожалению, простым подтягиванием баланса белого не обошлось.

Например, когда в двух разных фотографиях жёлтый цвет смартфона становился одинаковым, дерево почему-то имело совершенной разный оттенок. Его приходилось выравнивать с помощью масок, выборочной коррекции цвета и так далее.

Одно статичное видео, а у нас 50 оттенков белого. Делал для вебинара

Эта проблема становится ещё хуже в видео, когда до появления рук в кадре фон будет одного цвета, а после — другого. Или когда доминантный цвет в кадре меняется, алгоритмы пытаются моментально подкрутить и все остальные элементы.

Единственным выходом становится зажать палец на объекте, но вместе с цветом фиксируется также фокус и экспозиция, что моментально ограничивает гибкость съёмки.

Почему настройку до сих пор не добавили? За последние 10 лет Apple слишком сильно автоматизировала обработку цвета и яркости в фото и видео. Половины всей работы сейчас делает не железо камеры, а алгоритм SmartHDR, который склеивает десятки изображений в один кадр.

Вероятно, взять и перепрограммировать его на то, чтобы он учитывал вручную настроенный баланс белого, дорого и сложно.

На этом проблемы не кончаются.

Искусственная резкость раздражает уже всех

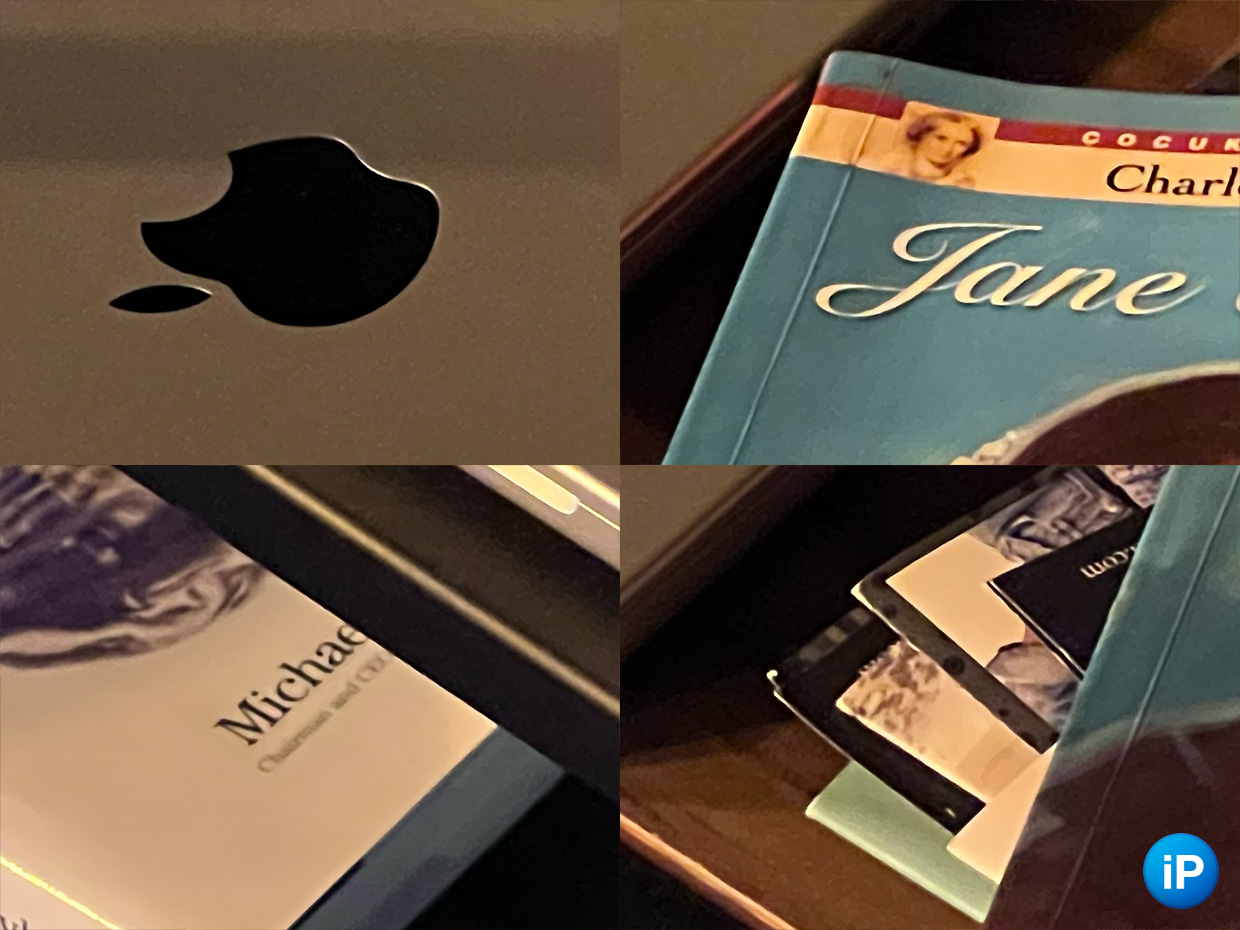

Выше примеры того, как при искусственном освещении алгоритмы превращают фотографию в рисунок красками.

Когда я в помещении фотографию на »троечку» (или телефото), а свет недостаточно сильный, происходит одна из двух вещей: вместо оптического приближения iPhone решает выдавать обрезок с основной камеры или модуль приближения включает агрессивное шумоподавление и работу Deep Fusion, тем самым выдавая сильно размытую картинку с жирными белыми полосами на контрастных участках.

Ещё не самый страшный пример того, как сильно iPhone белыми полосами задирает контрастность

Я не могу принудительно снимать на оптическое 3х приближение, не могу отключить шумоподавление, не могу запретить алгоритму жёстко усиливать контраст.

Ничего из этих варварских методов отключить нельзя, каким бы «профессиональным» смартфон не называли.

Не вижу нужды в том, чтобы портить фотографию ради иллюзии лучшего качества, которая рассыпается при первом увеличении кадра. Текст, например, и без белых ореолов остаётся разборчивым, а всему остальному это ужасно вредит с моей точки зрения эстетики.

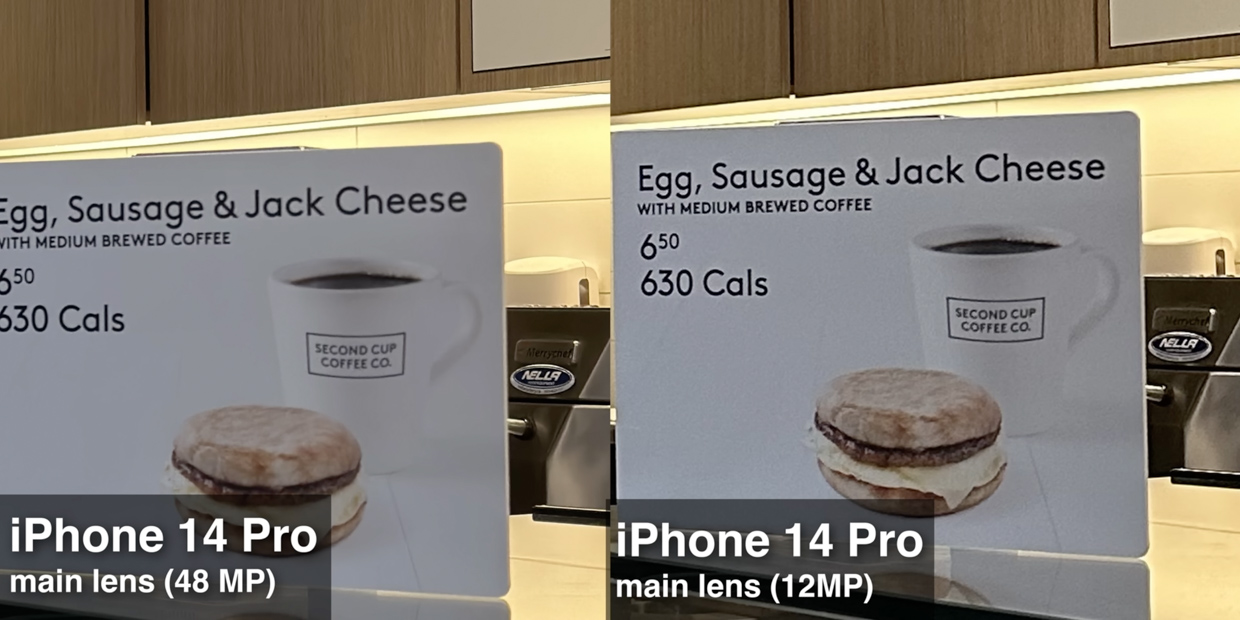

Слева фото до шумоподавления, справа итоговый снимок

Смотрите на примере выше. Иногда после съёмки iPhone не успевает обработать фотографию в реальном времени, поэтому, когда открываешь Галерею, можно увидеть зерно на свежей фотографии.

Дело вкуса, конечно, но такой вариант кадра нравится мне гораздо больше, чем акварель, которая остаётся через секунду после обработки алгоритмами.

Понятно, что не каждый кадр должен оставаться таким. Но добавить быструю настройку, где можно до или после съёмки это поправить, не помешало бы. Иногда лучше красивый шум, чем месиво из пикселей.

Надежда рядом

В начале 2023 года видел на разных каналах и сайтах мнение, что iPhone 14 плохо фотографирует. По-крайней мере, хуже, чем конкуренты того же класса.

Так что проблему вижу не я один, и в обзорах камеры многие писали, что при съёмке в режиме ProRAW 48 МП на iPhone 14 Pro лишний контраст уходит. Текст и другие линии с резким переходом цвета начинают выглядеть естественно, белый ореол не появляется.

Вопрос с балансом белого сложнее.

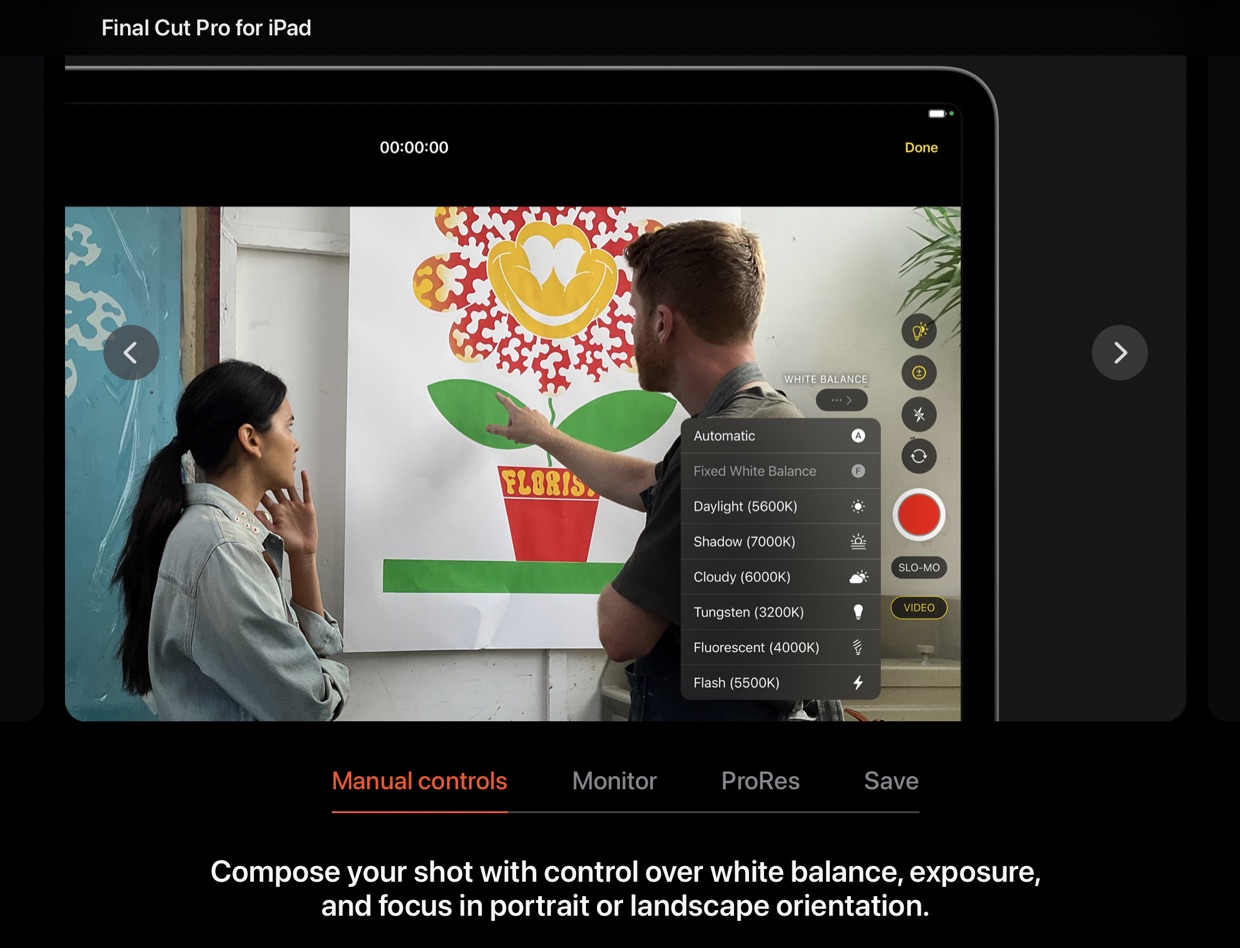

На странице, посвященной выходу Final Cut Pro на iPad, упоминают о возможности «профессионально» использовать встроенную камеру планшета.

Кроме всех привычных настроек впервые официально от Apple появится возможность регулировать баланс белого.

И хотя, судя по этому превью, там не будет ручного замера, это уже шаг вперёд. Apple за все 15 лет развития своих камер ни разу не давала менять цветовой баланс видео перед съёмкой.

Сейчас «брака» от iPhone много

За последние три года для работы я использовал три камеры разного калибра, одной из которых был iPhone.

Приблизительно половина всех фотографий в моих статьях сделана на него, и, на мой взгляд, лучше всего возможности мобильной камеры заметны в обзоре iPhone 13 Pro год спустя.

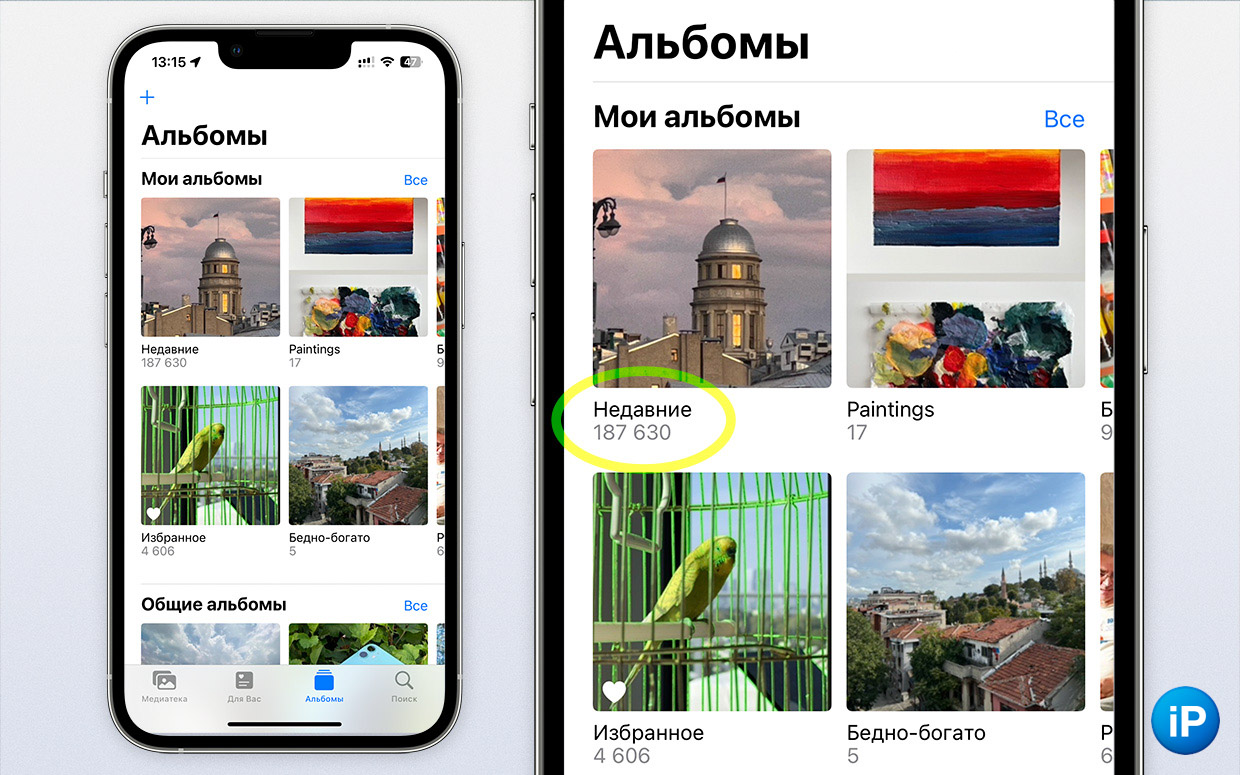

Вот только за кадрами, которые меня устроили, стоят десятки тысяч (!!!) фотографий, которые я бы никогда не смог вытянуть до того качества, чтобы их хотелось у нас публиковать.

Как же раздражают это нейросеточные белые ореолы вокруг линий

Плохим «танцором» называть себя не хочется, потому стараюсь выжимать максимум другими способами: маски, правка отдельных оттенков, уменьшение текстуры, суперсэмплинг, добавление зерна и так далее.

Но такие базовые вещи как непредсказуемый баланс белого и непрошеное усиление резкости от ИИ добавляют непомерно много работы в видео и значительно портят результат в вечерней фотографии. Нам срочно нужны кнопки для их контроля.

Apple сделала мелкие шаги навстречу в обеих проблемах, когда отключила перешарп в режиме ProRAW 48 МП и дала возможность регулировать баланс белого при съёмке видео на iPad через Final Cut Pro.

Чуть адаптировать всё это под обычную съёмку на iPhone, и вопрос закрыт.

Ждём в iPhone 15 Pro. Иначе уже проще будет взять хорошую камеру за плюс-минус те же деньги и оставаться на iPhone 13 Pro, который во всём остальном почти так же хорош, как и грядущие новинки.