Intel возглавила программу DARPA по защите ИИ от атак мошенников и обмана

Современные модели машинного обучения (ML) ограничены в возможностях распознавать мошенничество. Атакующему всегда легче придумать новую уловку, которую разработчики не смогли предусмотреть. Объять необъятное, как известно, невозможно, даже если очень хочется. Но мошеннические атаки на модели машинного обучения и ИИ можно смягчить, если разработать фундаментальные принципы защиты от такого вида атак. Эти работы возглавит компания Intel.

Как сообщается в пресс-релизе компании, агентство DARPA выбрало компанию Intel как главного исполнителя проектов по программе «Гарантированная устойчивость ИИ к обману» (Guaranteeing AI Robustness against Deception, GARD). Также Intel возглавила этот проект, но не единолично. Вместе с ней программой GARD будет плотно заниматься коллектив Технологического института Джорджии (Georgia Tech). Программа GARD продлится четыре года и обойдётся налогоплательщикам США во много миллионов долларов.

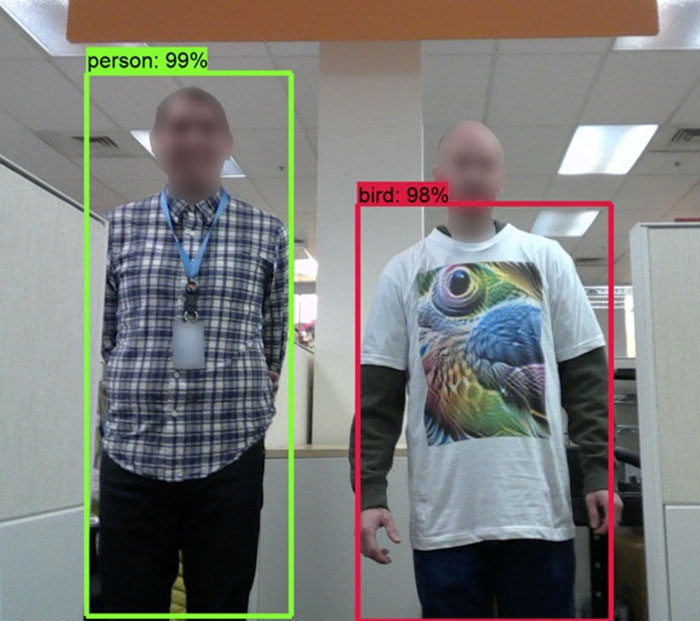

Одним из видов атак на модели машинного обучения являются так называемые состязательные атаки (adversarial attacks). Это вариант обмануть нейросеть, чтобы она выдала некорректный результат. Сделать это, например, можно с помощью тех или иных помех на анализируемом изображении. Ниже на фото сотрудники Intel приводят пример, когда картинка на футболке заставляет нейросеть идентифицировать человека как плицу. Но даже если искажения вносятся на уровне довольно небольшого числа пикселей, этого уже достаточно, чтобы ИИ и ML не смогли правильно определить объект.

Если модели машинного обучения не научить распознавать мошенничества на изображениях и видео, то нет смысла вообще говорить о массовом применении таких технологий на уровне систем национальной безопасности и в военном деле. Поэтому, собственно, проблематикой защиты ML от состязательных атак и других видов обмана ИИ занялось агентство Министерства обороны США по перспективным исследованиям.

Главной целью программы GARD заявлено создание теоретических основ системы ML, которые не только идентифицируют уязвимости системы и дают рекомендации по повышению их надёжности, но также способствуют созданию эффективных средств защиты. Это должно привести к тому, что со временем появятся устойчивые к обману системы ИИ с жесткими критериями оценки их эффективности.

Источник:

© 3DNews