Возможно ли сделать ЦОД эффективнее и экономичнее одновременно?

Бельгийский дата-центр Google полностью запитан от собственной солнечной электростанции, а оборудование охлаждается водой из ближайшего канала — экономичность и энергоэффективность на высоте. Источник: Google

С начала массового строительства центров обработки данных минуло 25 лет, а рынок очень далек от насыщения — ежегодно мировые вложения в строительство дата-центров растут на 15%. При этом ЦОДы становятся всё более мощными и дорогими. Стоимость строительства и эксплуатации напрямую влияет на цену цифровых услуг, например, хостинга, облачных хранилищ и вычислений, поэтому все заинтересованы в повышении эффективности и экономичности дата-центров во всём мире. Какие меры для снижения стоимости услуг ЦОДов можно предпринять?

Высокие технологии с высоким энергопотреблением

По оценкам журнала Nature, в год на снабжение дата-центров во всём мире уходит порядка 200 ТВт·ч, причем 140 ТВт·ч приходится на ЦОДы США. Еще шесть лет назад дата-центры потребляли только 91 ТВт·ч, то есть рост составил внушительные 220% Сейчас ЦОДы потребляют больше, чем вся Украина (122 ТВт·ч), Аргентина (129 ТВт·ч), Швеция (134 ТВт·ч) или Польша (150 ТВт·ч).

Несмотря на то, что дата-центры — это не дымящие трубы и вредные отходы, а облачные вычисления, они тоже оставляют серьезный углеродный след в мировой экологии — примерно 0,3% от общемировых выбросов, что немало. Всё потому, что доля «зеленой» энергетики в главных странах-держателях ЦОДов очень мала (11% в США, 26% в Китае, всё с учетом гидроэлектростанций), поэтому на электроснабжение дата-центров работают газовые и угольные электростанции. В итоге экологи и европейские правительства недовольны ростом выбросов парниковых газов, операторы электросетей недовольны растущей нагрузкой и необходимостью модернизировать сети, владельцы ЦОДов недовольны затратами на обслуживание.

Главная после операционных расходов статья содержания дата-центра — электричество, на которое может прийтись до половины расходов. Для оценки энергоэффективности ЦОДов применяется коэффициент PUE (Power usage effectiveness — «эффективность использования энергии»), выражающий отношение всего потребляемого электричества к потреблению ИТ-оборудования. PUE, равный 1,0, идеален и недостижим, к нему можно только стремиться, так как к серверам непременно прилагаются системы охлаждения и мониторинга, тоже требующие электропитания. На охлаждение может приходится 50–80% от потребления ИТ-оборудования, а то и больше, поэтому средний PUE в мире сейчас составляет 1,67 (1 единица энергии уходит серверам и 0,67 единицы — другому оборудованию). Благодаря комплексному подходу в лучших случаях PUE можно снизить до 1,05–1,10, а это выливается в колоссальную экономию на электроснабжении.

Вот только чтобы добиться такой экономии, придется выполнить почти все рекомендации из нашего чеклиста. Начнем от простого к сложному: сначала опишем меры апгрейда текущего оборудования, потом замахнемся на реорганизацию ЦОДа, а затем помечтаем о переносе или строительстве новых дата-центров с учетом последних тенденций и самых современных технологий.

Согласно опросу владельцев ЦОД, многие хотели бы улучшить энергоэффективность, охлаждение, планировку или местоположение дата-центров. Источник: Solar Thermal Magazine

Обновление ИБП для минимизации потерь

Для обеспечения резервирования электропитания, а также для защиты дорогостоящего оборудования дата-центров от скачков напряжения и других проблем питающей электросети применяются онлайн-ИБП с нулевым временем переключения на батарею. За бессбойную работу серверов приходится платить повышенным энергопотреблением — при двойном преобразовании напряжения в целях повышения его характеристик неизбежны потери, которые тоже приходится оплачивать. КПД ИБП напрямую зависит от нагрузки — чем она выше (в рамках характеристик ИБП), тем больше коэффициент полезного действия. КПД актуальных онлайн-ИБП в режиме двойного преобразовния при высокой нагрузке может составлять 85–95%, а сильно устаревших моделей — пугающие 40–50%. То есть от 15% до 50% электроэнергии исчезают в ходе преобразования, но не исчезают из суммы затрат. Для старых ИБП особенно остро стоит проблема низкого КПД при невысокой загрузке.

Самые современные специализированные онлайн-ИБП могут достигать КПД до 99% при штатной работе. Вот поэтому обновление парка ИБП может круто снизить затраты на обслуживание ЦОДа и заметно повысить PUE. Пример — ИБП от Eaton, недавно попались на глаза. Для маленьких ЦОДов — компактные Eaton 9SX/9PX на 5/6/8/11 кВ·А (серия 9PX оснащена портом DB15 для организации параллельной работы двух ИБП). Эти ИБП имеют КПД до 98% в «высокоэффективном» режиме работы и до 95% при двойном преобразовании. Каждый модуль полностью автономен и может устанавливаться как вертикально, так и в 19-дюймовую стойку. Для снижения затрат на обслуживание батареи в 9SX/9PX используется технология управления зарядом Eaton ABM, которая увеличивает срок службы аккумуляторов на 50%. Вместо постоянной подзарядки малым током ABM следит за уровнем заряда и подзаряжает батареи только тогда, когда это нужно.

А вот для современных больших ЦОД, владельцы которых больше заинтересованы в бесперебойной работе оборудования, чем в экономии каждого рубля, лучше обратить внимание на башенные ИБП Power Xpert 9395P. В режиме сохранения энергии ESS они обладают КПД 99%. Топовая модель серии 9395Pрассчитана на 1200 кВ·А.

Обновляем распределители питания

Такая, казалось бы, банальная вещь, как распределители питания (PDU, или Power distribution unit), тоже могут быть причиной повышенного расхода электроэнергии. Предназначение и функциональность PDU просты — контроль напряжения и его подведение к оборудованию. Хотя на этапе планирования ЦОД велик соблазн отдать предпочтение дешевым розеточным блокам без возможности удаленного управления, возможные перегрузки фазы могут привести к отключению электроснабжения, и тут даже ИБП не помогут.

А еще дешевые PDU имеют невысокий КПД. Современные дорогие интеллектуальные модели поставляются с добротным трансформатором, отвечающим высоким требованиям стандарта энергоэффективности TP-1. Сертификация TP1 подразумевает повышение КПД PDU примерно на 2–3% относительно обычных моделей, что вроде бы немного, но при пересчете на годовые затраты выливается в приятную экономию. Помимо этого, современные PDU упрощают кабель-менеджмент, помогают уменьшить количество проводов и тем самым улучшить обдув компонентов. Да, PDU с сертификатом TP-1 закономерно дороги, но затраты на них отбиваются примерно за 6 лет, тогда как срок службы таких PDU составляет не менее 20 лет.

Заменяем освещение на светодиодное

В сравнении с энергопотреблением серверов или систем охлаждения на освещение ЦОД приходится около 1% от всей необходимой дата-центру электроэнергии. Скромно, но при обновлении освещения экономия будет отражаться не только в счетах за электричество, но и в сметах на замену ламп.

Немало устаревших ЦОД продолжают освещаться энергосберегающими ртутными лампами, которые уступают светодиодам во всём, кроме, разве что, цены. Но ресурс ртутных ламп примерно в 5 раз ниже, чем у светодиодных. Яркость LED-светильника снизится до критических 70% от изначальной за 50 000 часов, после чего его придется менять. Энергосберегающая лампа деградирует до того же уровня всего за 10 000 часов, то есть чуть больше чем за год. Таким образом на одну замену LED-источников придется до пяти замен ртутных ламп!

Ещё яркость светодиодов можно легко менять, снижая энергопотребление в зависимости от времени суток. А для получения того же уровня освещенности при применении LED-ламп требуется на треть меньше, чем нужно энергосберегающих светильников.

Используем free cooling

Лучший ресурс — бесплатный и возобновляемый. В деле охлаждения серверов таким ресурсом являются уличный воздух и грунтовые воды. Вместо того, чтобы тратить огромные средства на работу чиллеров, куда как экономичней будет охлаждать оборудование «забортным» холодом. Подход free cooling, при котором в систему охлаждения поступает холодный отфильтрованный воздух или вода, заслуженно считается одним из лучших способов снизить затраты на содержание дата-центра. За счёт отказа от кондиционеров в пользу free cooling можно гарантированно снизить PUE с 1,8 до 1,1.

В вопросе free cooling вне конкуренции находятся скандинавские страны. В увлеченной экологичностью всего и вся Швеции тепло в дата-центрах используют для нагрева воды в системе отопления жилья. Ирландцы поставили на службу free cooling пронизывающие страну даже летом островные ветра, а датчане пускают в систему охлаждения ледяные грунтовые воды, имеющие одинаково низкую температуру и зимой, и летом.

Google особенно гордится тем, что за счет free cooling в своих европейских дата-центрах компания экономит воду, которая могла пойти на работу электростанций для выработки электричества для чиллеров (если бы они были). Источник: Google

Климат обжитой центральной части России, не говоря уже про северо-западный регион, радует сторонников free cooling (и не радует всех остальных) исключительно малым количеством жарких дней. По статистике Росгидрометцентра, в средней полосе страны только 3,8% времени в году наблюдается температура выше +22 °C, а среднегодовая температура в Санкт-Петербурге — всего +5,6 °C. Для сравнения, в американском штате Аризона, где построен огромный ЦОД Apple, тоже использующий free cooling, даже в январе температура редко опускается ниже +6 °C, ее среднегодовой уровень держится выше +16 °C. Поэтому как минимум четверть времени в году Apple вынуждены использовать прожорливые чиллеры для охлаждения 120 тыс. кв. м площадей своего ЦОДа.

Это не значит, что пришло время осваивать сибирскую целину. Хоть климат России и располагает к самому эффективному использованию free cooling, на этом преимущества севера страны для строительства ЦОДов заканчиваются. Зато недостатков хватает: низкая транспортная доступность, дефицит высококвалифицированных кадров, плохое состояние телекоммуникационных и энергосетей.

Тем не менее, первые шаги по созданию новых ЦОДов на севере уже сделаны: Петрозаводский государственный университет приступил к развертыванию весьма серьезного дата-центра, который претендует на 20% российского рынка облачных хранилищ. При этом карельская погода должна снизить стоимость эксплуатации примерно на 40%. Университетские сотрудники и выпускники, а также близость к Санкт-Петербургу прекрасно решают и проблему кадров, и вопрос подключения к точке обмена трафиком.

Один из дата-центров «Яндекса» расположен в холодной Финляндии. За счет free cooling его коэффициент PUE удалось снизить до 1,1

Призываем на помощь ИИ

Мониторинг охлаждения ЦОДа большой площади и управление им весьма трудоемки, и при этом велик риск что-то переохладить, а где-то недоглядеть. Дело в том, что на эффективность охлаждения влияет множество меняющихся факторов: погода за окном, наличие открытых окон в помещениях, влажность воздуха, состояние градирен, нагрузка на оборудование. Отслеживать сотни и тысячи параметров в реальном времени круглые сутки людям не под силу, поэтому с недавних пор на службу управления охлаждением поставили искусственный интеллект.

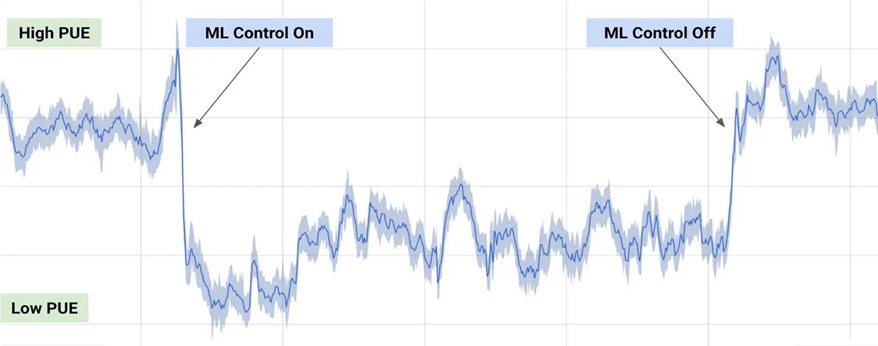

В 2014 году Google приобрела компанию DeepMind, известную своим продуктом AlphaGo, впервые обыгравшим профессионального игрока в го. На основе наработок DeepMind был создан программный комплекс для ЦОД Google, который может не только следить за показаниями датчиков и нагрузкой, но и делать выводы на основании накопленной истории наблюдений и полученных погодных прогнозах. С внедрением ИИ энергозатраты на охлаждение ЦОД Google снизились на впечатляющие 40%, при этом всё оборудование осталось прежним.

Результат работы ИИ DeepMind в ЦОД Google — при включении машинного обучения, система снижала потребление электроэнергии на охлаждение. Источник: DeepMind

Отдельные решения на базе ИИ нашли своё место в ЦОД Сбербанка в Сколково. Так как дата-центр 330 дней в году использует free cooling, система отслеживает внешнюю температуру и прогноз погоды и на основании этого оптимизирует энергозатраты на охлаждение и даже принимает решение о запасе холодного воздуха на случай потепления.

Американская компания LitBit пошла еще дальше, предложив для дата-центров своего ИИ-сотрудника, диагностирующего состояние ЦОД на основании визуальных и акустических данных. ИИ оценивает звук и вибрации, издаваемые оборудованием, и сравнивает с эталонными слепками, помогая обнаружить деградирующие компоненты.

Используем модульные дата-центры

Строительство или расширение ЦОД — процесс не только дорогой, но и долгий — во многом из-за необходимости проектировать капитальное строение и проводить проект по всей цепочке необходимых согласований. От заключения контракта до сдачи в эксплуатацию компактного дата-центра с площадью 200–300 кв. м проходит 9–12 месяцев, и это при условии, что документы не подвиснут ни в одной из инстанций, выдающей своё разрешение на строительство.

Концепция модульных дата-центров, эдаких кирпичиков, из которых, как из конструктора, можно было бы быстро собирать ЦОДы, родилась в середине 2000-х годов. Первопроходцами в этом считается Sun со своим Sun Modular Datacenter — модульным ЦОД внутри стандартного морского грузового контейнера, в котором уместились восемь 40-юнитовых стоек, серверы и сетевое оборудование и система охлаждения. Развертывание модульного Sun Modular Datacenter обходилось примерно в 1% от строительства традиционного дата-центра, его можно было легко перевозить с места на место, а подключение ограничивалось подводом электричества, водоснабжения и сети.

В 2009 году небезызвестный архив интернета archive.org переехал в один Sun Modular Datacenter. Впрочем, хранился он там недолго — за десять лет объем archive.org вырос с 3 до 50 петабайт. Источник: NapoliRoma / Wikimedia Commons

Сейчас рынок предлагает модульные дата-центры в самом различном исполнении, а не только в виде контейнеров. Модули считаются самым эффективным способом быстрого строительства или расширения ЦОД без лишних затрат и долгих согласований. Модули занимают меньше места и эффективнее используют площадь за счет заранее продуманной компоновки, имеют меньшее энергопотребление и зачастую лучшее охлаждение, их легко можно переместить ближе к месту с дешевым электричеством (рядом с крупными электростанциями). Так что прежде чем думать о строительстве или расширении дата-центра, стоит обратить внимание на готовые модули.

Запитываем ЦОД от возобновляемых источников энергии

В сравнении с Европой у России есть важное экономическое преимущество, которое делает размещение ЦОД на ее территории весьма привлекательным, — исключительно низкая стоимость электроэнергии. В некоторых регионах страны она доходит до 3 руб. за кВт·ч, тогда как в Германии около 23 руб. за кВт·ч, а в США в среднем 9 руб. за кВт·ч. Плюс в России власти пока не относятся к экологии так же щепетильно, как в скандинавских странах. Поэтому у нас вопрос перехода ЦОД на автономное электроснабжение из возобновляемых источников энергии пока не стоит.

Однако на Западе владельцы дата-центров вынуждены как минимум декларировать минимизацию углеродного следа, компенсируя выбросы от работы ЦОДа финансированием экологических инициатив. Это, а также высокая цена за электричество, заставляет крупные компании переводить большие дата-центры на автономное электроснабжение. Высокие первичные затраты за рубежом быстро окупаются и идут на пользу имиджа.

Так Apple, один из передовиков по использованию «зеленых» технологий, первой перевела свои ЦОДы на электричество от собственных солнечных и ветровых электростанций. Дошло до того, что в 2016 году компания подала заявку о желании начать продажу излишков выработки со своих американских солнечных электростанций мощностью 90 и 130 МВт.

Автономное электроснабжение будет полезным в областях, далеких от мощный электросетей. Например, исландский ЦОД Verne Global построен рядом геотермальными электростанциями. Хоть они и не принадлежат компании, зато являются экологичными, возобновляемыми и очень стабильными источниками энергии.

В Германии на «зеленую» энергию приходится уже больше половины всей выработки. К сожалению, в России доля возобновляемой энергетики колеблется на уровне 4%, две трети из которых — гидроэнергетика. Но для новых ЦОД в качестве задела на будущее подумать об автономном питании от солнечной или ветряной электростанции не помешает.

Экономия лишней не бывает

Самый крупный и дорогой дата-центр в мире принадлежит телекоммуникационному гиганту China Telecom. Он занимает площадь 994 тыс. кв. м, а строительство обошлось в 3 млрд долларов. Самый большой российский ЦОД построен Сбербанком в Сколково. Он в 30 раз меньше китайского гиганта — всего 33 тыс. кв. м. Но благодаря грамотному внедрению фрикулинга, ИИ и отопления помещений теплом оборудования удалось достичь экономии на обслуживании около 100 млн рублей в год. Учитывая размеры дата-центра China Telecom, можно быть уверенным, что там тоже были применены все возможные способы снижения затрат. Какой бы абсурдной и малозначимой не казалась мера по удешевлению обслуживания ЦОД, в годовом эквиваленте она может принести очень заметную экономию, пропорциональную размеру ЦОД.