Ученые вылечили ИИ от забывчивости

Эта особенность называется «катастрофической забывчивостью» (catastrophic forgetting). Однако ученые из компании DeepMind и Имперского колледжа Лондона разработали алгоритм обучения глубоких нейронных сетей, который способен приобретать новые навыки, сохраняя «память» о предыдущих задачах.

/ фото Dean Hochman CC

/ фото Dean Hochman CC

Нейронная сеть состоит из нескольких связей, для каждой из которых вычисляется её вес. Каждому весу в нейронной сети присваивается параметр F, который определяет его значимость. Чем больше значение F для конкретного нейрона, тем меньше вероятность его замены при дальнейшем обучении. Поэтому нейронная сеть как бы «запоминает» наиболее важные приобретенные навыки.

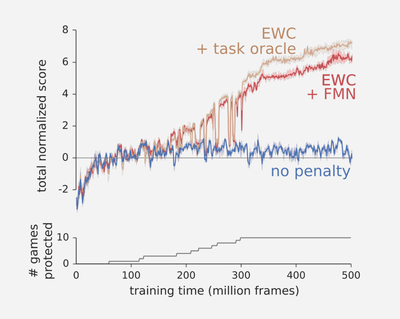

Методика получила название Elastic Weight Consolidation, или «упругое закрепление весов». Работа алгоритма тестировалась на играх Atari. Ученые показали, что без «закрепления весов» программа быстро забывала игры, когда переставала в них играть (синий график). При использовании алгоритма EWC нейросеть «запомнила» веса, необходимые для выполнения всех предыдущих задач. И хотя EWC-сеть проиграла в каждом отдельном случае классическому алгоритму, она продемонстрировала хорошие результаты по сумме всех этапов (красный и коричневый графики).

Авторы исследования рассказывают, что ученое сообщество уже предпринимало попытки создания глубоких нейронных сетей, способных выполнять сразу несколько задач. Однако прошлые решения были или недостаточно мощными, или же требовали больших вычислительных ресурсов, поскольку сети обучались сразу на крупной объединенной выборке (а не на нескольких последовательных). Такой подход не приближал алгоритмы к принципам работы человеческого мозга.

«Умная пыль»: как устроен самый маленький компьютер Michigan Micro Mote

Глубинное обучение: возможности, перспективы и немного истории

«Машинное обучение»: Потенциал и возможности

Еще есть альтернативные архитектуры нейронных сетей для работы с текстом, музыкой и сериями длинных данных. Они носят название рекуррентных и имеют долгосрочную и краткосрочную память, что позволяет переключаться с глобальных проблем на локальные (например, с анализа отдельных слов на правила стилистики языка в целом).

Рекуррентные нейронные сети имеют память, однако уступают глубоким сетям в способности анализировать сложные наборы признаков, которые встречаются, например, при обработке графики. Поэтому новое решение от DeepMind в перспективе позволит создавать умные универсальные алгоритмы, которые найдут применение в программном обеспечении для решения задач, требующих нелинейных преобразований.

P.S. Еще несколько интересных материалов из нашего блога:

- Unboxing all-flash СХД NetApp AFF A300: технические характеристики и взгляд изнутри

- Stretch Deploy для vCloud Connector: функциональные особенности и принцип работы

- Три причины, почему использовать VMware vSphere 6.0 по-прежнему актуально

- Облачные технологии для решения задач в строительном бизнесе

- Технико-экономическое обоснование использования услуги IaaS на примере кейса крупной компании

- X-as-a-services: как не погрязнуть в аббревиатурах облачных услуг