Щупаем китайское железо и выясняем, насколько это дешево и сердито

Не нужно объяснять, как санкции изменили российский ИТ-рынок. Потому что они не так уж его пока изменили. Но, как минимум, изменилось состояние души: именно санкции породили интерес к альтернативным брендам. В первую очередь — к китайским.

Не нужно объяснять, как санкции изменили российский ИТ-рынок. Потому что они не так уж его пока изменили. Но, как минимум, изменилось состояние души: именно санкции породили интерес к альтернативным брендам. В первую очередь — к китайским.

Мы решили поближе посмотреть на достижения китайской народной промышленности и испытать их в условиях типовых вычислительных задач, а заодно проверить, как они будут себя вести в случае техногенных сбоев и других актов вандализма. Ниже история нашего тестирования продуктов компаний Inspur и Huawei.

Все сейчас говорят про вендорозамещение. Это на словах быстро и легко. Однако на практике заменить привычное, милое сердцу оборудование западных производителей на другое, малоизвестное — это шаг непростой и рискованный. Еще недавно клеймо «китайское» свидетельствовало о второсортности. И хотя нынче в Китае собирают многие престижные вещи (где, к примеру, собран ваш iPhone?), от стереотипов избавляться все-таки непросто.

Бренд Huawei на рынке известен давно, и в первую очередь, в сегменте телекоммуникационного оборудования. С конца 80-х годов компания росла, успешно изготавливая недорогих конкурентов западных образцов техники, в первую очередь — Cisco. И не раз была замешана в скандалах, связанных с недобросовестным копированием технологий. В нишу серверных решений Huawei попал примерно 8 лет назад, и за это время успел нарастить богатое портфолио различных аппаратных и программных решений.

Inspur, в свою очередь, за пределами Китая известен не так давно, но в Китае эта компания с государственным участием уже долгое время развивает местный ИТ-рынок. В 60–70 годах она производила транзисторы, которые использовались в том числе в китайских спутниках, в 80–90-х первой в Китае собрала ПК и сервер. В современном виде как производитель серверного оборудования и сопутствующих решений Inspur был основан в 2000 году, сегодня компания занимает 5-ое место в мире по количеству продаж серверов (в большей степени за счет китайского рынка).

Протестировали мы отдельные образцы китайского оборудования частично в своей лаборатории, частично на площадке Huawei. Но прежде чем перейти к описанию железа и того, что мы с ним вытворяли, я хочу заострить внимание еще на одной задаче, которую мы попутно преследовали. Это глобальная задача, которая состоит в том, чтобы постепенно мигрировать информационные системы с проприетарных RISC/UNIX-платформ на добротную и хорошо обжитую платформу x86.

Существует общемировая тенденция снижения доли коммерческих UNIX на серверном рынке. Больше 40 лет RISC/UNIX-системы господствовали в enterprisе-сегменте, потому что надежно работали даже под массивной нагрузкой и почти линейно масштабировались по мере добавления процессоров и памяти. Но прогресс не стоит на месте, и архитектура x86 по своим возможностям стала догонять машины мейнфрейм-класса, а Linux все больше совершенствовался в умении эффективно управлять «большим железом». Конечно, и по сей день есть задачи, где RISC-архитектуре нет равных, когда, скажем, 1500 пользователей базы данных «долбится» в одну точку, что характерно для таких систем, как биллинг или карточный процессинг банка. Тем не менее, уже сейчас различные задачи, включая базы данных, можно успешно переносить на более дешевую и простую x86-архитектуру. Серверы стандартной архитектуры интуитивно понятны всем, кто в армии в детстве на время разбирал и собирал «писюк». И Linux давно уже не экзотика, а набор ПО, который пытливый обыватель легко может развернуть на домашнем компьютере, а особо продвинутые — в виртуальной машине. В противовес этому RISC-серверы в быту не встречаются, и освоить их дома нельзя. Потому подготовка специалиста, способного из командной строки управлять гудящим шкафом весом в тонну, к которому даже привычный монитор подключить некуда — это отдельный и длительный процесс. Еще и не всякому дано. Наряду с изрядной стоимостью самого железа, которое по цене как два подержанных танка и комплект боеукладки, отдельной головной болью является обучение и содержание специалистов. Они к тому же, чуть что, норовят фыркнуть и пойти подороже продать себя вашим «партнерам по рынку». Так что тенденция по вытеснению RISC-серверов вполне закономерна.

Итак, про тестирование. Конечно, никакого открытия мы не сделали, поставив Linux на интеловое железо и погоняв на нем базу. И здесь я не претендую на премию МУЗ-ТВ. Но в целом было интересно посмотреть, как с типовыми задачами будет справляться именно китайское железо, а также софт, который был на нем установлен. Как себя поведет, так сказать, красный дракон в условиях курятника. Применительно к железу мы ставили перед собой задачи оценить:

надежность компонентной базы;

стабильность работы встроенного софта;

удобство настройки и использования.

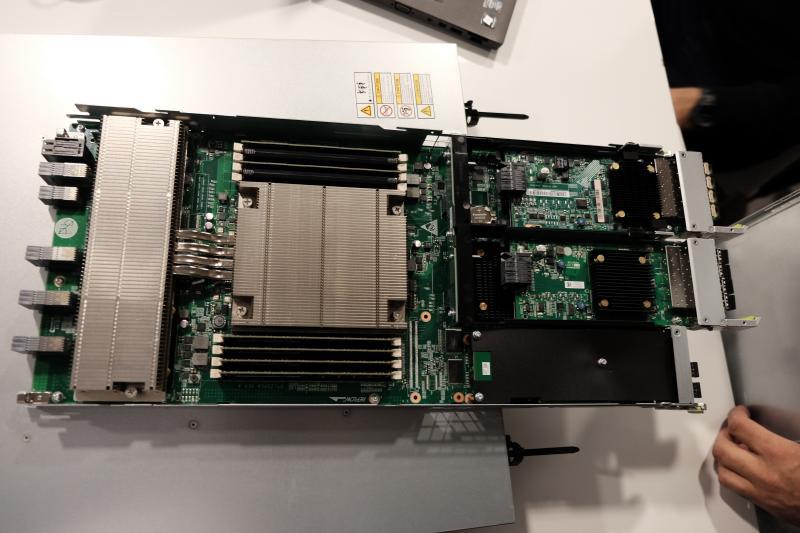

InspurПервый экземпляр производства великой китайской корпорации, который нам попался, был блейд-сервером NX5440. Это самый младший экземпляр из линейки блейдов, бывают еще NX5840 и NX8840. Сервер NX5440 занимает один слот в корзине (half-height), а NX5840 и NX8840 по два каждый. Все три варианта устанавливаются в единственное шасси I8000, как и в нашем случае. Наше шасси было оснащено модулем управления и модулем Ethernet.

Оговорюсь, что Inspur в своей продуктовой линейке x86-серверов предлагает Rack-серверы серии NF, башенные серверы NP, блейд-серверы NX, а также storage-сервер с высокой плотностью размещения дисков. Все типы серверов построены на одном чипсете — Intel C600 — и используют процессоры Xeon E3 V2. Также у Inspur есть первый и пока единственный в Китае свой большой UNIX-сервер на базе процессоров Itanium и архитектуры CC-NUMA — Inspur Tiansuo TSK1, масштабируемый до 128 физических ядер с UNIX-подобной ОС собственной разработки K-UX.

Производитель заявляет небывалую масштабируемость и адаптивность своих творений, но на беспристрастный взгляд творения в плане набивки и особенностей конструкции не сильно отличаются от своих одноклассников, выпущенных другими вендорами. Блоки питания и вентиляторы дублированы, память с коррекцией ошибок, сетевые интерфейсы позволяют создавать отказоустойчивые агрегации. Есть гибкость в компоновке серверов — их правда можно собрать из большого выбора комплектующих.

Опыт работы с этими изделиями, побывавшими в нашей лаборатории, однако показал, что не так уж устарели те самые стереотипы, о которых я писал выше. Наши мытарства начались почти сразу после включения этого хозяйства. Сразу оговорюсь про документацию от производителя. Информация большей частью носит описательный характер: на таком-то экране такие-то кнопочки. Картинки в руководстве пользователя представляют собой скриншоты с китайского интерфейса. В общем, оказалось проще разбираться самим, без руководства.

За ту неделю, пока мы тестировали этот агрегат, у нас трижды пропадала связь с модулем управления шасси (SMC) и с модулем управления самого лезвия (BMC). Эта напасть случалась вне всяких закономерностей. Когда это произошло первый раз, мы вызвали на подмогу инженера из Inspur. К слову сказать, с этим у Inspur все хорошо, если не считать, что все инженеры в российском офисе — китайцы, вероятно, потому что офис открыт совсем недавно. На площадку они выезжают сразу вместе с переводчиком. Казалось бы — круто! Но фокус в том, что выпускник Иркутского языкового института мало что смыслил в технике. В переводе наших технических вопросов его тянуло в лирику, поэтому скоро мы его задвинули в сторону и перешли к прямому общению с инженером через международный язык пантомимы. Китаец жестами объяснил, что он очень любит рис, коммунистическую партию и серверы. Когда мы спросили, есть ли у него допуск к работе с напряжением до 1000В, он предъявил нам какое-то красное удостоверение, выданное, должно быть, Народно-Освободительной Армией Китая, так что мы поняли, что 1000В — это ниже его достоинства, и, если надо, он гордо умрет на этой розетке.

Китаец быстро смекнул, что мы хорошие парни, и радостно починил нам блейд-корзину переусадкой модуля управления. Все последующие случаи пропадания связи мы чинили уже сами — тем же способом: что-то перетыкали или перезагружали. Вот такой вот «плавающий» характер проблемы — когда она проявляется спонтанно и чинится случайными действиями.

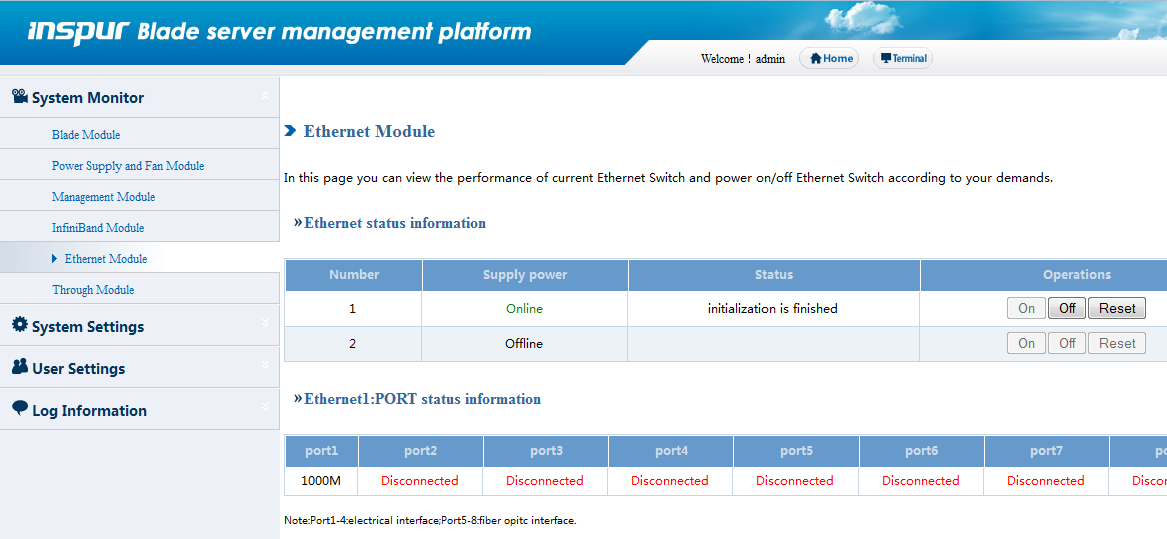

Интерфейс SMC не отличается богатством возможностей. Самое полезное — включить, выключить сервер, перезагрузить его модуль управления. Изменить сетевые настройки BMC-модуля блейда из него нельзя, это вообще можно сделать только из web-интерфейса модуля управления самого блейда, а текущий IP-адрес, если он неизвестен, можно узнать в BIOS«е.

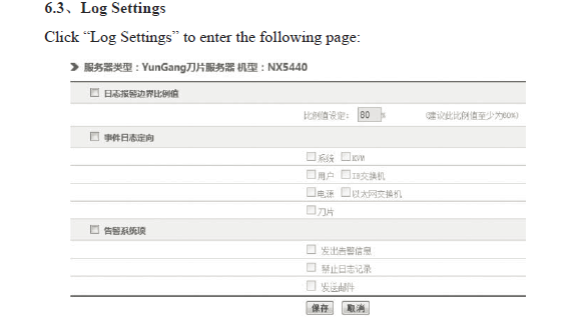

В меню «Ethernet Module» можно посмотреть, установлен ли модуль, включено ли его питание и выключить его при желании. В довершении всего, этот модуль оказался концентратором, а не коммутатором. Правда, сейчас эта модель уже устарела, и Inspur поставляет уже более продвинутые модули.

В меню настройки протоколирования были включены все опции, но при попытке просмотреть логи лишь показывалось сообщение «Empty logs». В меню управления пользователями выяснилось, что нельзя создать дополнительного пользователя с правами администратора, а пользователь типа «Common User» фактически может только переключать меню и рассматривать, но изменять ничего не может. В меню «Power Supply and Fan Module» можно узнать вольтаж и «обороты» и при желании вручную задать последние для каждого Fan Module. При удалённом управлении лезвием через KVM OVER IP у нас достаточно часто возникали разнообразные ошибки, которые разрешались повторным подключением, реже — перезагрузкой BMC. При попытке установить Windows потребовался драйвер для RAID-контроллера, который по идее идет на диске «Inspur driver CD». Однако программа установки с этого диска так не заработала, хотя повреждений CD-носитель не имел.

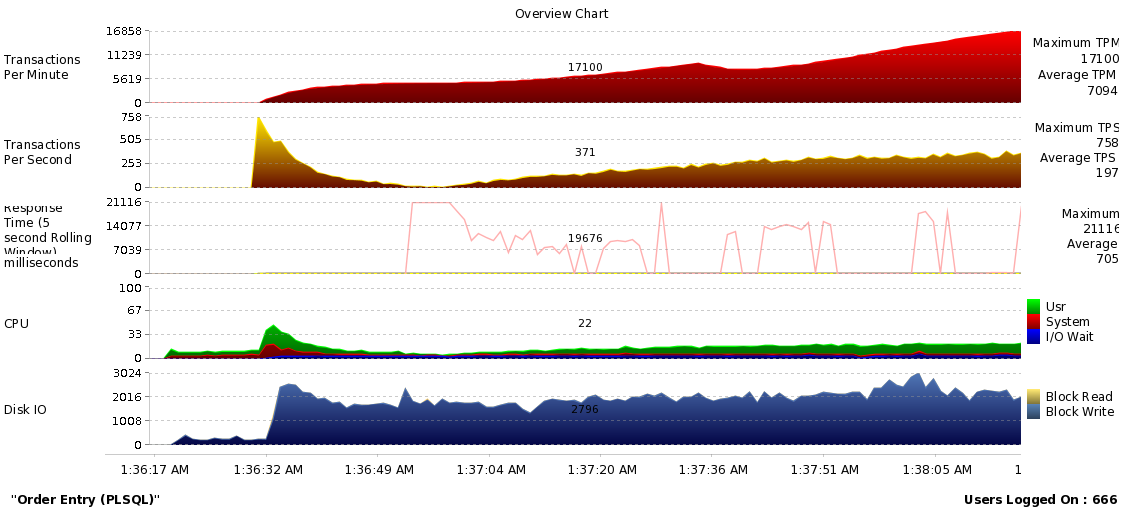

Когда мы научились обращаться с этим изделием и при необходимости его чинить, мы водрузили на сервер ОС RHEL 6.6×86–64 и поверх поставили СУБД Oracle 11.2.0.4. Для тестирования было использовано ПО Swingbench 2.4, а также процедура вычисления квадратного корня на perl для разогрева ЦП. Упомянутый Swingbench (http://dominicgiles.com/swingbench.html) — это небольшое бесплатное приложение, стандартный способ дать синтетическую нагрузку на базу данных, показывающий графики.

Сервер успешно прошёл тестирование в течение суток. Температура ядер процессоров при этом держалась на уровне 55–60 °C при температуре охлаждающего сервер воздуха около 20 °C. На показателях производительности (IOPS, TPS, MB/S) специально заострять внимание не буду, т.к. все они зависят от входных данных, от настроек. Мы не ставили цель выжимать из сервера рекорды производительности, смысл нагрузочного тестирования сводился к проверке способности сервера работать в режиме реальных задач.

В общем и целом мы сделали выводы, что оборудование, которое попало к нам на тесты, выглядело сыроватым. Справедливости ради надо сказать, что пропадание связи с модулями управления, конечно, могло быть особенностью конкретного экземпляра, с которым мы имели дело. В остальном это привычный x86-сервер c двумя Intel Xeon E5–2690 v2 и 128 Gb DDR3. Но вообще китайские производители совершенствуют свои продукты с такой скоростью, что уже через несколько месяцев мы можем столкнуться с новым образцом этой техники, который будет уже избавлен от всех детский болезней. Собственно, по этой причине мы совсем недавно стали официальными партнерами Inspur, наблюдая, как вендор развивает свою линейку и стремится продавать ее в России. Учитывая санкции, еще один альтернативный поставщик в нашем портфеле будет не лишним.

Huawei

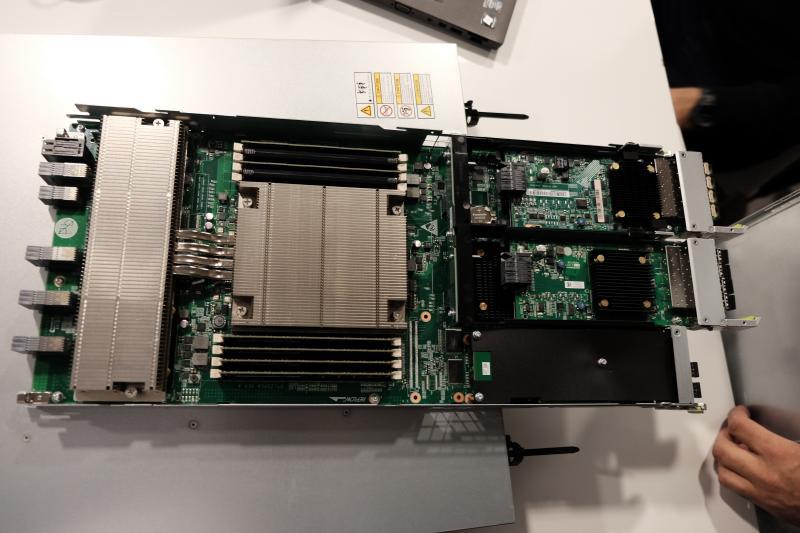

В нашем распоряжении оказалось шасси E6000H с установленными четырьмя лезвиями BH620 V2 (конфигурация: 2x Intel Xeon CPU E5–2407 2.20GHz, 16 Гб RAM, 2 Gigabit Ethernet, 2 Emulex FC3532 HBA). Фото Huawei из нашей лаборатории. Вид сзади — так ракурс удачнее вышел

Фото Huawei из нашей лаборатории. Вид сзади — так ракурс удачнее вышел

Это железо относится к предыдущему поколению, в то время как актуальной линейкой сейчас является v3. Однако это было наше лабораторное оборудование, которое нам было совсем не жалко. Мы ставили на него ОС RHEL и Oracle Linux, поверх ту же СУБД Oracle 11g, создавали в ней нагрузку при помощи Swingbench, а также собственными скриптами, эмулируя различные профили нагрузки: большие объемы записи, большие объемы чтения данных, тяжелые запросы с тяжелыми сортировками. В конце в качестве факультативной информации я привел последовательность наших шагов при нагрузочном тестировании.

Пока системы работали, обрабатывая транзакции, мы, выскакивая неожиданно из-за угла, применяли к ним различные насильственные методы. Мы выдергивали на ходу диски, сеть, вырубали электричество рубильником. Главным образом нас интересовало, сможет ли ОС корректно запуститься, и сможет ли СУБД восстановиться после возобновления работы и доступа к данным. На классических промышленных системах это в подавляющем большинстве случаев происходит. Но как себя вел китайский товар?

Признаться честно, все работало хорошо, и придраться нам в итоге было не к чему. Аппаратная часть работала стабильно, никаких дерзких фокусов не демонстрировала. ОС и база вели себя штатно, отрабатывая все положенные меры по восстановлению после издевательств. Создать в базе коррапт данных нам так и не удалось.

Новое поколение железа мы тоже пощупали. Такая возможность нам была любезно предоставлена компанией Huawei на их демо-площадке, которая выглядит местами даже футуристично.

Вот она — демо-площадка Huawei

Вот она — демо-площадка Huawei

Надо сказать, что в портфеле продуктов Huawei присутствуют весь спектр решений: от серверов и СХД до программных решений по виртуализации. Однако сотрудники Huawei, несмотря на наше горячее желание познакомиться с FusionCompute — средой виртуализации собственной разработки, созданной на базе технологии Xen — за время нашего пребывания у них так и не смогли ее запустить. Она позиционируется, как замена продуктам VMware, однако, как видите, вежливо не работает. Однако железо Huawei делать точно научились, и поэтому оставшееся время я расскажу о наших впечатлениях о нем.

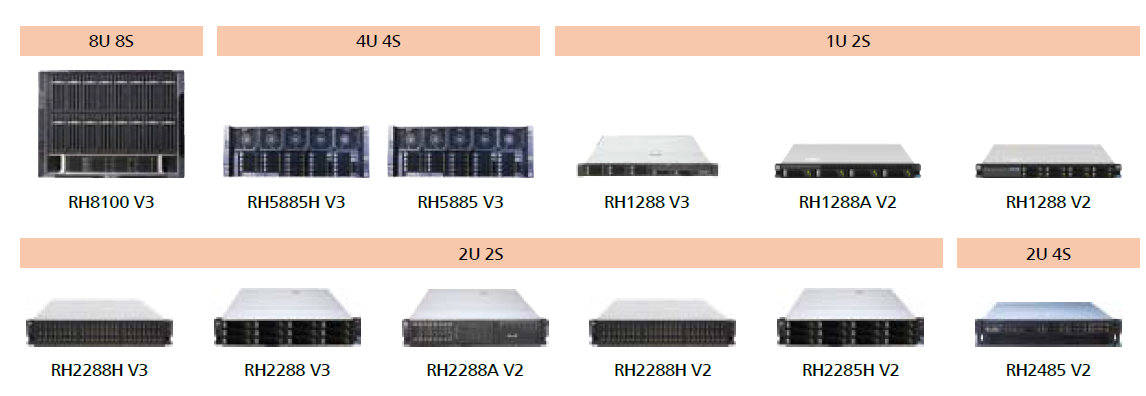

Линейки серверов третьего поколения содержат как Rack-серверы, так и Blade- и High-Density варианты, предоставляя, таким образом, большое количество конкурирующих решений для среднего и крупного бизнеса, привыкшего строить инфраструктуру на таких машинах как HP DL360e и 360p, HP DL380 Gen9, IBM x3650 и x3850, Dell R730 и R930, и т.п. Используются обкатанные технологические решения и обычное современное железо.

Линейка Rack-серверов Huawei Процессоров от Intel начального уровня Е3 нет, как нет и процессоров AMD. В новом поколении v3 поддерживается DDR4, а также заявлена поддержка планок памяти объемом 64 Гб, естественно, когда они появятся. Сетевые интерфейсы у серверов заменяемые, LOM-карточка также включает и менеджмент-порт. SAS RAID контроллеры у поколения V2 — 6 Gb/s, у V3 — 12 Gb/s. И в том, и другом случае используются контроллеры LSI с родной прошивкой производителя, а не модифицированной от Huawei. В качестве батареи кэш-памяти используется суперконденсатор.В целом, набор компонентов в серверах стандартен и дублирован для отказоустойчивости. Блоки питания и вентиляторы поддерживают горячую замену — все как у взрослых.

Серверы от Huawei могут работать в широком диапазоне температур, до 45ºC. У конкурентов отметка редко превышает значение в 35ºC. Данных показателей удалось достичь за счет более продуманного дизайна системной платы и расположения модулей памяти. К сборке серверов нареканий нет, вся конструкция и установка элементов надежная, без люфтов, замена компонентов не вызывает сложностей.

Blade-серверы Huawei устанавливаются в новую корзину Е9000 размером 12U, то есть в стандартную стойку уместится всего три штуки. Количество Blade-серверов в корзине — 16 штук, все устанавливаются горизонтально. Blade-серверы ничем, кроме форм-фактора, не отличаются от Rack-серверов.

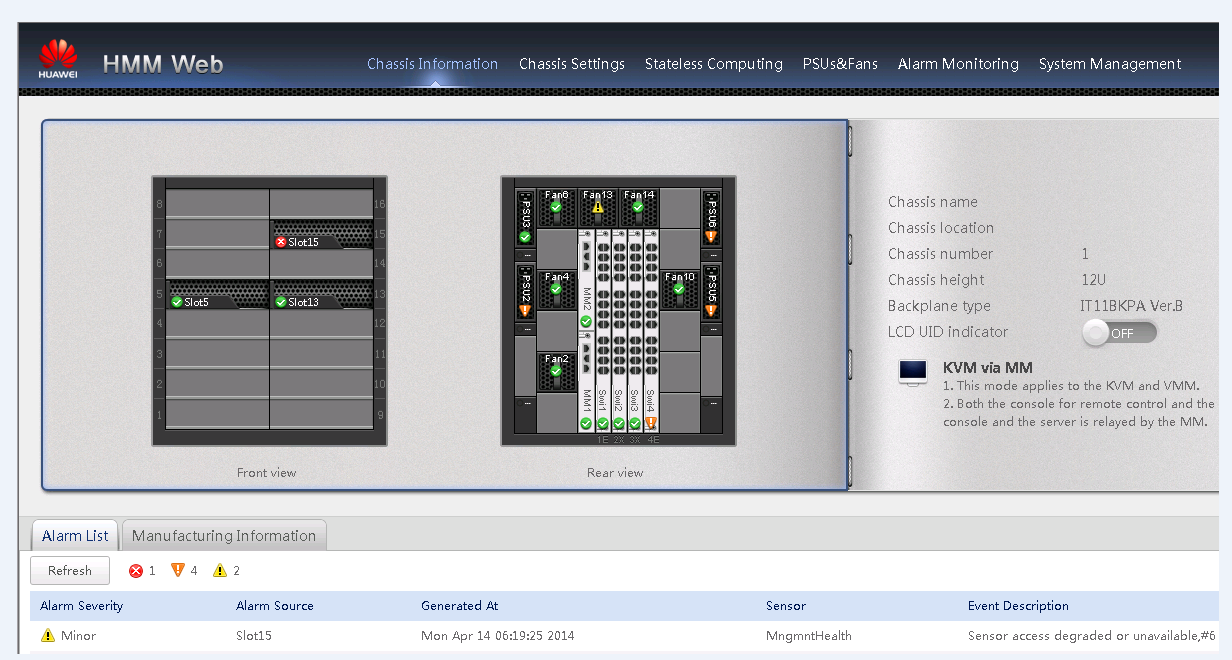

Линейка Blade-серверов Huawei Есть конфигурации с 4 сокетами в полноразмерном блейде, занимающем 2 слота корзины, а также стандартные 2-сокетные конфигурации, отличающиеся размером в зависимости от количества дисков. Блейды могут подключаются к LAN и SAN посредством большого количества свитчей, представленных в линейке. Общая идея Huawei — сделать все конвергентным.Все серверы Huawei, начиная с V2, поддерживают официально следующие ОС: Windows Server, RHEL, SLES, Solaris, CentOS, Citrix XenServer, VMware ESXi, FusionSphere. Чтобы избежать проблем с драйверами, необходимо устанавливать ОС, используя «FusionServer Tools Service CD». Решение представляет собой загрузочный образ, который предварительно скопирует на диск все необходимые драйверы. Также Service CD позволяет сконфигурировать RAID-массив на дисках в сервере и создать логический том нужного размера. В общем, все работало четко и без нареканий. Драйверы для всех официально поддерживаемых ОС постоянно обновляются и доступны для загрузки через портал. Средство управления корзиной Е9000 называется HMM. Со времен первой версии НММ изменился только графический интерфейс. В остальном функционал, конечно, еще далек от идеала. Так и остались не доработанными информативность алертов, читабельность логов с корзины, встроенная документация, информация по серверу и его компонентам, информация по маппингу интерфейсов сервера в коммутаторы, некорректно работающая авторизация LDAP.

iMana и iBMC — управляющий веб-интерфейс серверов, соответственно, второго и третьего поколений. iBMC является продолжением iMana, также с редизайном оставшихся недоработок.

Мы провели в демо-центре несколько дней, и кроме серверов изучали еще системы хранения данных и софт. Также дергали на ходу провода и диски, правда, целиком повторить бесчеловечные эксперименты с чужим оборудованием нам никто не дал. На четвертый день, например, мы еще хотели испытать оборудование на влагостойкость, но почему-то сотрудники вендора не давали нам размотать пожарный рукав.

Уже без шуток скажу, что в целом продукция Huawei оставила о себе благоприятное впечатление, даже несмотря на мелкие шероховатости. Остаются какие-то недочеты в интерфейсах управления, по-прежнему оставляет желать лучшего англоязычная документация, и, очевидно, пока не так много информации можно подчерпнуть из форумов. В остальном это работоспособные образцы, построенные по всем современным правилам серверного железа.

Хроники лаборатории Приведу методы пыток, которые мы применяли к серверам с работающей на них базой Oracle 11g. Вот последовательность шагов при нагрузочном тестировании: Swingbench с «тяжелыми» настройками. Цель — проверить работу системы под разноплановой нагрузкой, отдаленно напоминающей работу пользователей в сферическом приложении в вакууме. Мы установили и настроили Swingbench, задали параметры посложнее и запустили. Если не падало, то постепенно увеличивали нагрузку — и так до полного исчерпания производительности/ресурсов. Большие объемы записи в БД. Цель — убедиться, что связка сервер-ОС-БД остаются в работоспособном состоянии при зашкаливающих объемах записи. Для этого мы написали скрипт, который делает вставку большого количества данных в таблицу (что-то в духе insert into test_table01 as select * from dba_objects a;). Этот скрипт мы запускали одновременно большим количеством потоков, каждый из которых неистово писал в свою таблицу. Большие объемы чтений с диска. Цель — убедиться, что связка сервер-ОС-БД остаются в работоспособном состоянии при зашкаливающих объемах чтения с диска (без кэша). Для этого мы выставили маленькое значение для параметра buffer_cache, создали огромную таблицу без индексов. И затем начали селектить оттуда по случайному значению ключа и так много раз во много потоков. Тяжелые запросы с тяжелыми сортировками. Пишем максимально кривые запросы по огромным таблицам (с использованием полных join, например, или просто сложных и неиндексированных). Запускаем много и параллельно. Это само по себе серьезная нагрузка, было интересно, как справится. Concurency, latch, mutex. Нашей целью было посмотреть, как база будет работать при высокой конкуренции за неразделяемые ресурсы. Для этого мы во много потоков изменяли а) одну строку данных, б) большой, но всегда один, набор данных. Вместо выводов Из множества вариантов, чем инженер может быть озадачен на работе, тестирование нового оборудования представляется чуть ли не самым увлекательным занятием. Но в данном случае мы имели дело не просто с новой моделью известного бренда, а с принципиально новыми представителями рынка, которые, возможно, в недалеком будущем займут свое место в парке вычислительного оборудования. Платформа x86 кажется привычной, но, выражаясь образно, в китайском исполнении ее надо есть с острым соусом и палочками. А для этого нужен навык. Мы сделали первый шаг в знакомстве с серверами Inspur и Huawei, но на этом мы не собираемся останавливаться. И с рядом компаний, которые к нам уже обратились по теме вендорозамещения, мы начинаем серию пилотных внедрений, где на китайское железо будут перенесены не синтетические, а реальные задачи. В общем, если заинтересовались, обращайтесь.