Решение Therascale OCS

В предыдущем материале про Open Compute Project мы рассказали о инициативе Facebook по распространению открытой платформы для построения гипер-ЦОД. Идея проста — существующие решения для эксплуатации пригодны мало, нужно создать то, что подойдет именно тебе.В своем блоге Microsoft много рассказывает, как использовать облачный сервис Azure, построенный на их инфраструктуре. Инфраструктура, как оказалось, тоже разработана «с нуля» под видение Microsoft.

Процесс публикации своей платформы оказался заразным, к инициативе присоединилась компания Microsoft и поделилась своим видением оптимальной инфраструктуры, а мы расскажем об этом подробно.

Основные особенности

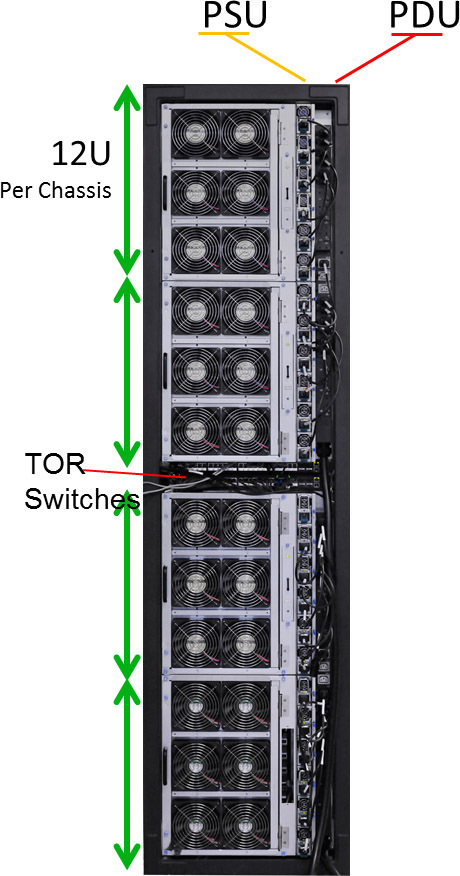

Ширина стандартная, 19 дюймов. Шасси высотой 12U.

Единая система охлаждения и питания.

Единая система управления серверами.

Все обслуживание не затрагивает кабельное хозяйство (если только проблема не в коммутаторе).

Используются стандартные PDU.

Блоки питания совпадают с нашей стоечной линейкой по форм-фактору.

Вид полной стойки

Вид полной стойки

Подробно про архитектуру

Структура

Структура

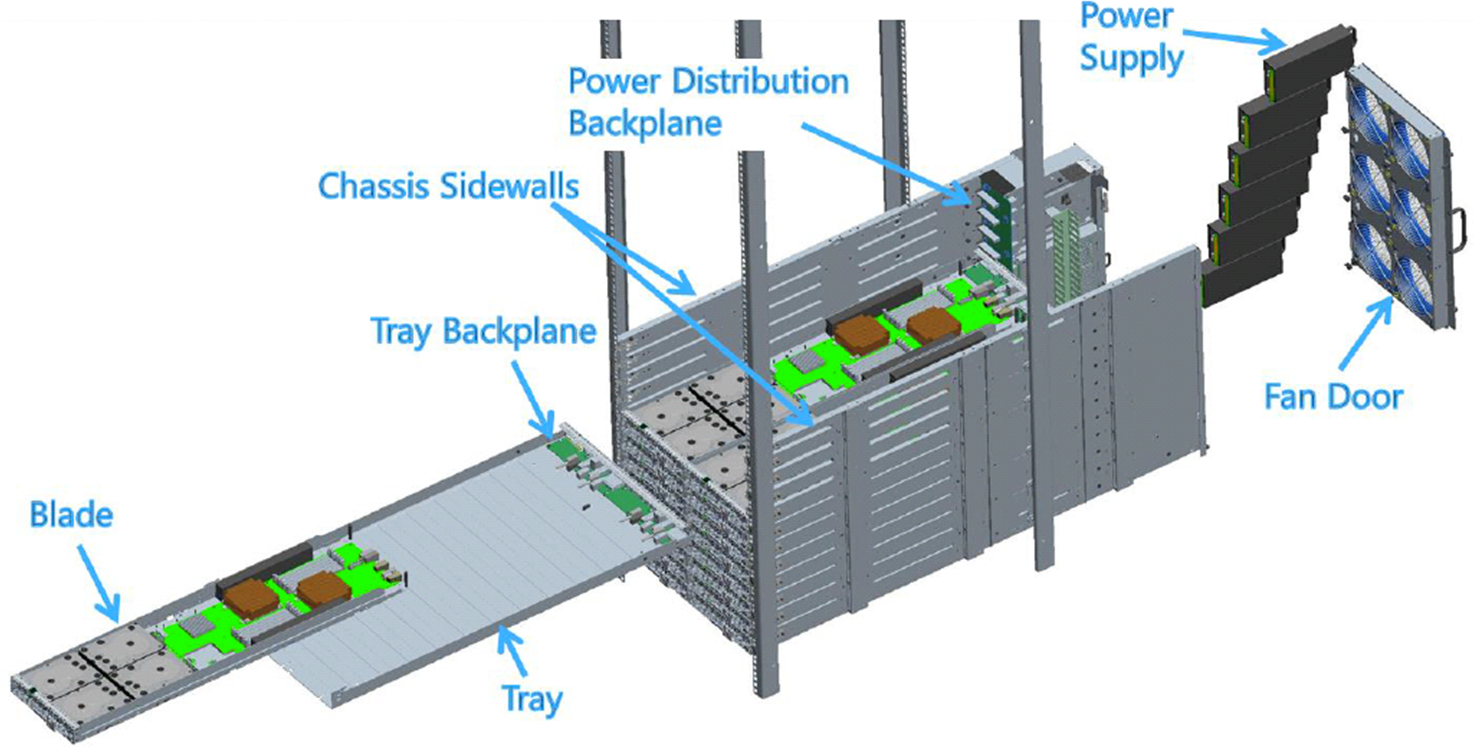

Шасси — корыто сложной формы, в которое устанавливаются корзины с универсальными объединительными платами для серверов и дисковых полок, плата распределения питания, блоки питания, контроллер удаленного управления и стена текста вентиляторов.

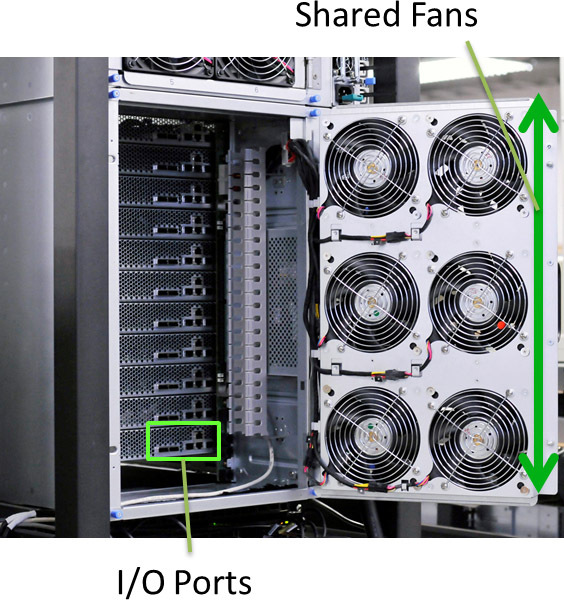

Вид сзади

Вид сзади

Шесть больших вентиляторов (140×140*38) объединены в единый блок на откидной дверце, управление идет с контроллера шасси. Дверца закрывает порты ввода-вывода и пространство для кабелей, где проложены специальные каналы для аккуратной разводки и монтажа.

Microsoft использует стандартные 19» стойки высотой 50U, из которых 48U заняты непосредственно серверами, а еще 2U выделены для коммутаторов. Блоки питания и PDU расположены с одной стороны стойки и не занимают, в отличие от OCP, места.

В каждом шасси встроен сервисный модуль (о нем подробней позже) и расположены 6 блоков питания (точно таких же, как в наших моделях RS130 G4, RS230 G4) по схеме 5+1.

Вид корзины сзади

Вид корзины сзади

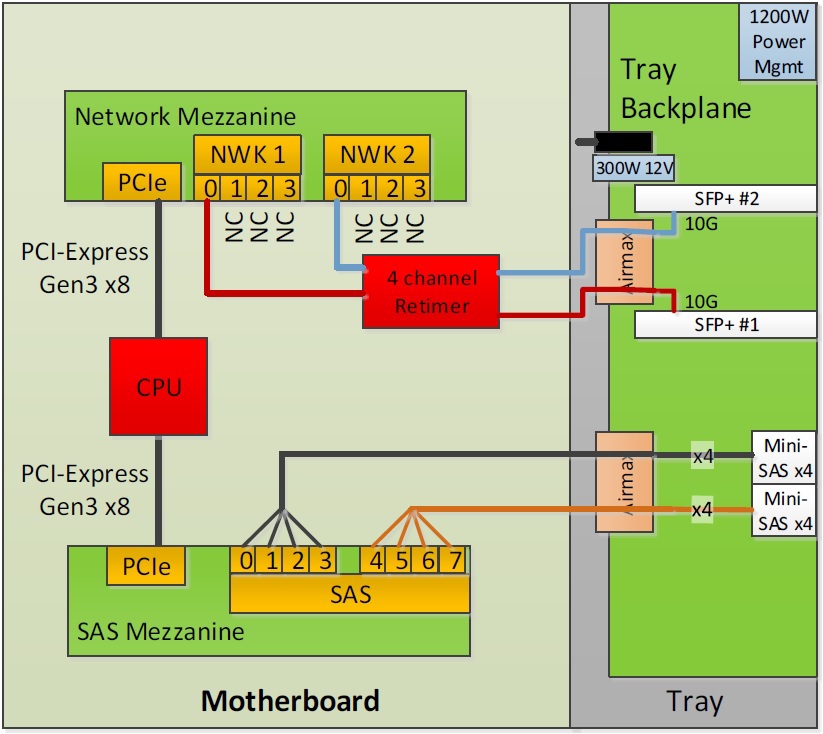

Хорошая идея — вне зависимости от используемых модулей, набор портов на корзине одинаков. Всегда выведены два SAS порта, два порта SFP+ и два порта RJ45, а что к ним будет подключено со второй стороны — определяется на месте.

Сравнение форматов

Open Rack Open CloudServer Обычная стойка 19» Внутренняя ширина 21» 19» 19» Высота стойки 2100 мм (41 OU) 48–52U, 12U/Chassis 42–48U OU/RU OU (48 мм) RU (44.45 мм) RU (44.45 мм) Охлаждение В системе (HS/Fixed) Стена вентиляторов (6 штук) В системе Размер вентилятора 60 мм 140 мм Варьируется Силовая шина 3 пары — — Силовые зоны/бюджет 3, бюджет до 36 кВт 4, бюджет до 28 кВт — Силовая полка Спереди Сзади — Размер силовой полки 3 OU 0 U 0 U Встроенный ИБП Да Да (скоро будет) Нет (но поставить любой никто не мешает) Управление стойкой Да, RMC (но не стойкой целиком) Да, CM — Идентицификация лезвия (Sled ID) Нет Да (в шасси) Нет Кабели Спереди Сзади Спереди или сзади Эффективность системы охлаждения

Полное потребление системы 7200 Вт (24 лезвия x 300 Вт) Внешняя температура (°C) Скорость вентиляторов (%) Потребление вентилятора (Вт) Потребление вентиляторов (Вт) Процент потребления от стойки (%) 25 66 19,2 115,2 1,6 35 93 40,2 241,2 3,35 Система управления

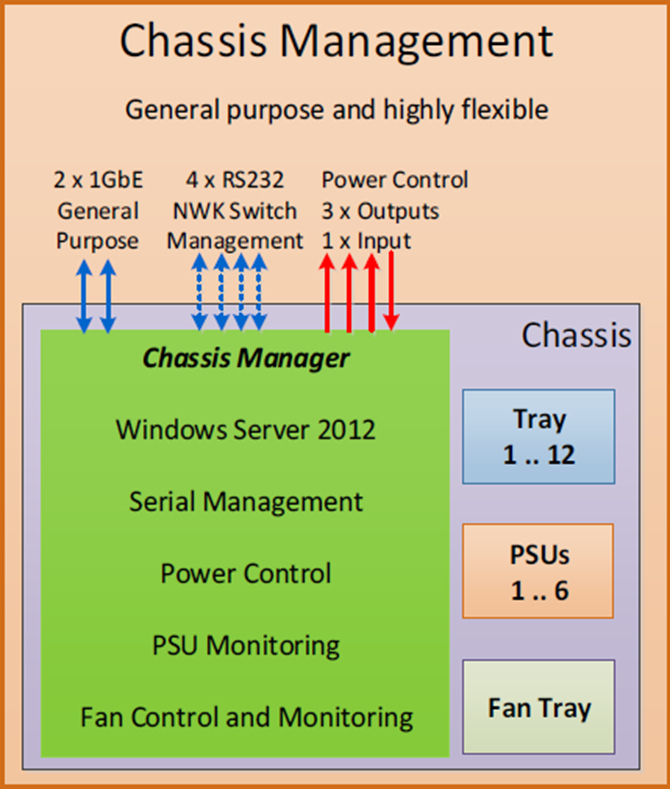

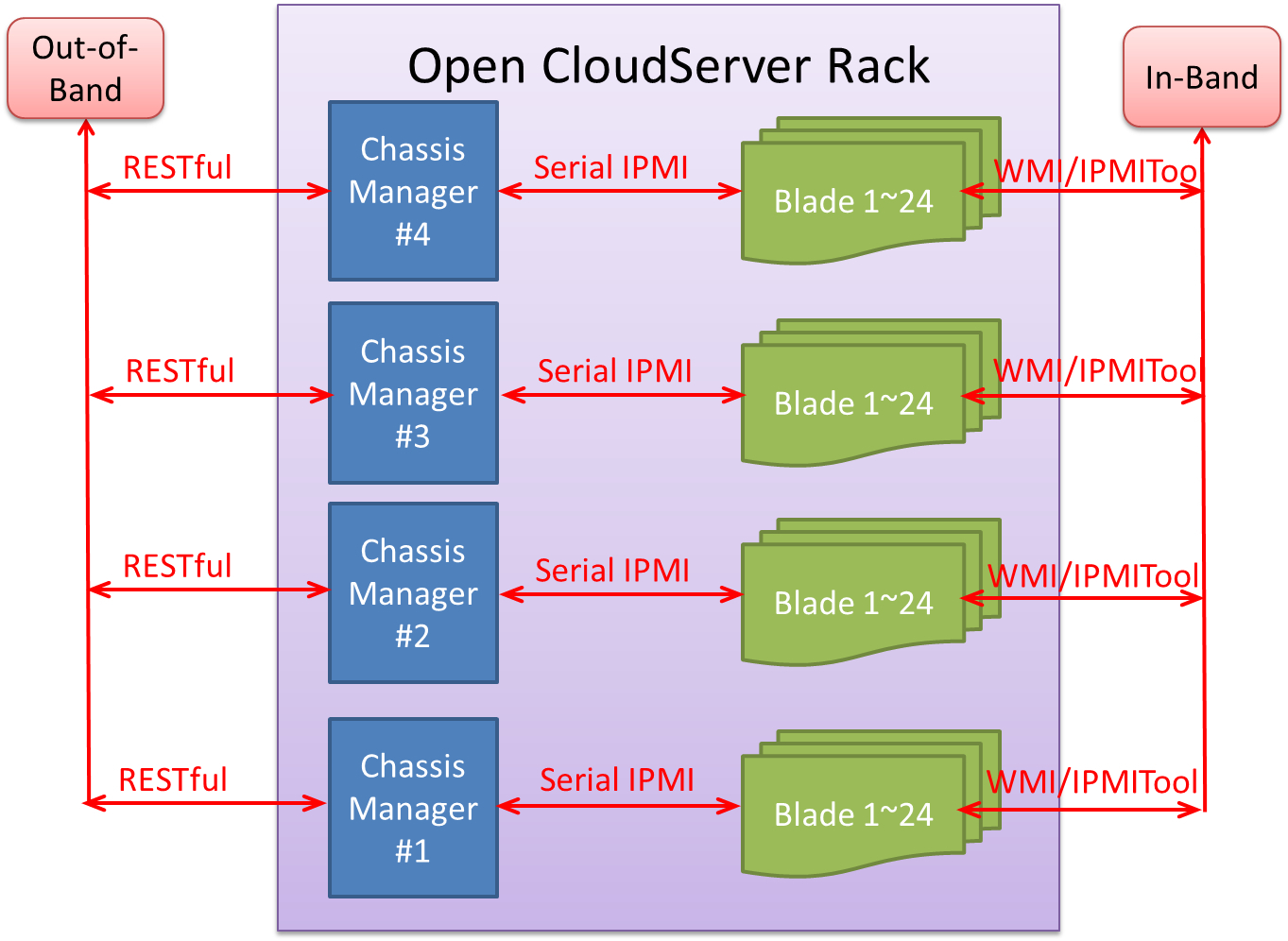

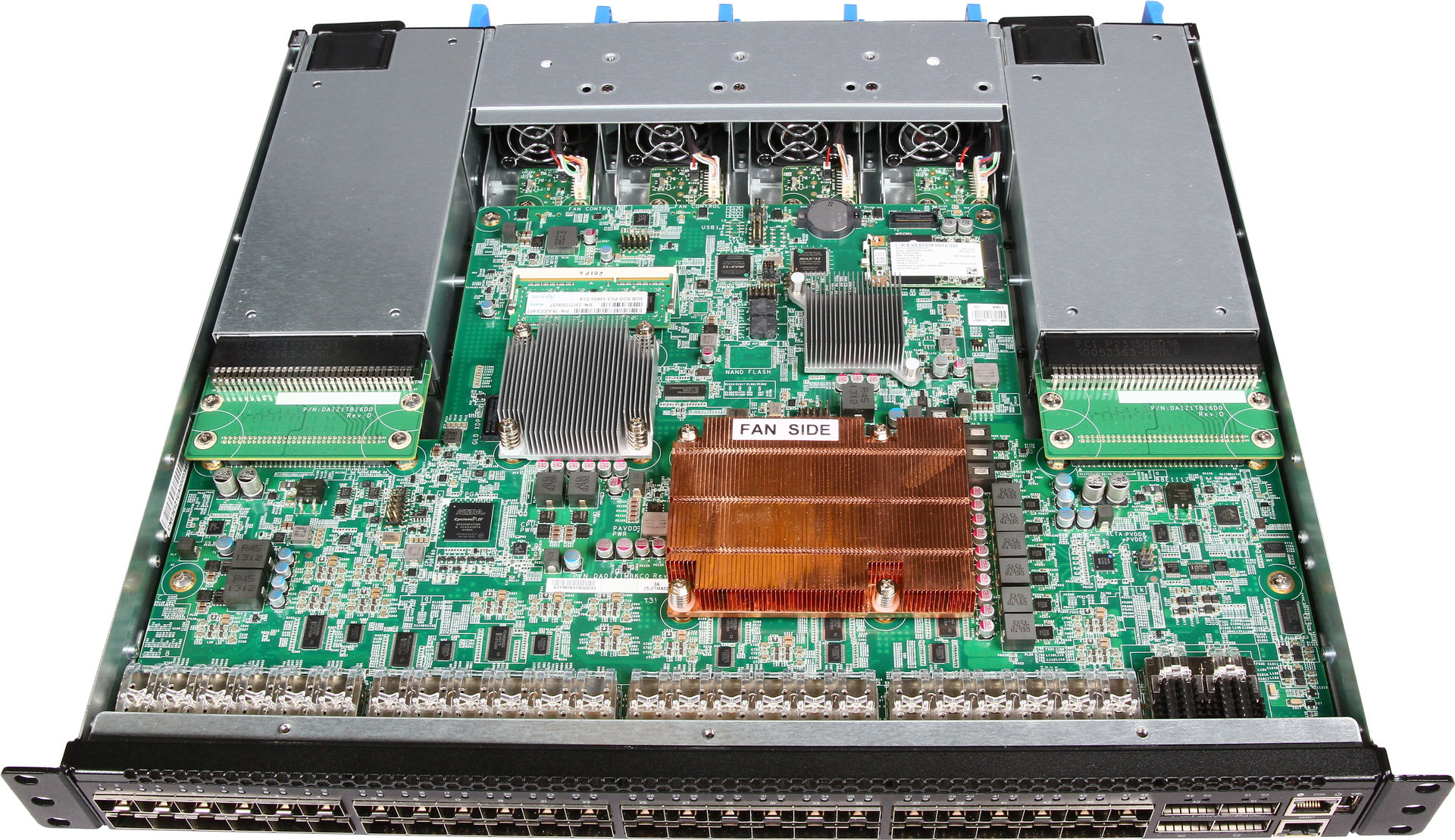

Chassis manager

Chassis manager

Сервер управления вставляется и извлекается «на горячую», программная часть построена (что не удивительно) на Windows Server 2012. Исходный код доступен для широкой публики и каждый может внести свои правки (инструментарий используется бесплатный).

общая идея

общая идея

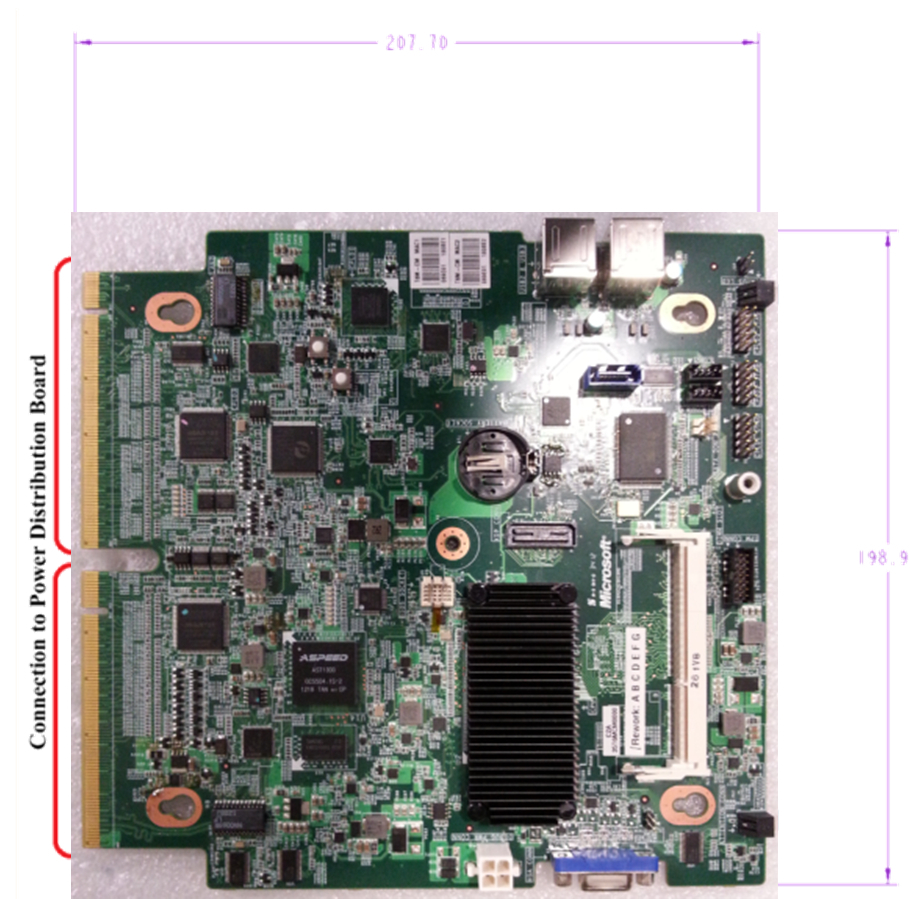

Непосредственно плата

Непосредственно плата

Функционал:

Input/Output (I/O): — 2×1GbE Ethernet (для доступа к сети или управления коммутаторами ToR)— 4 x RS-232 (Подключение к коммутаторам для управления их загрузкой)— Управление питанием (один вход, три выхода для подключения PDU или другого CMM)

Windows Server 2012

Горячая замена модуля

Железо: — Встроенный процессор Atom S1200— 4GB памяти с ECC— 64GB SSD

TPM модуль как опция

Встроенные мультиплексоры для коммуникаций с лезвиями

Управление питанием лезвий выведено отдельно (так надежней)

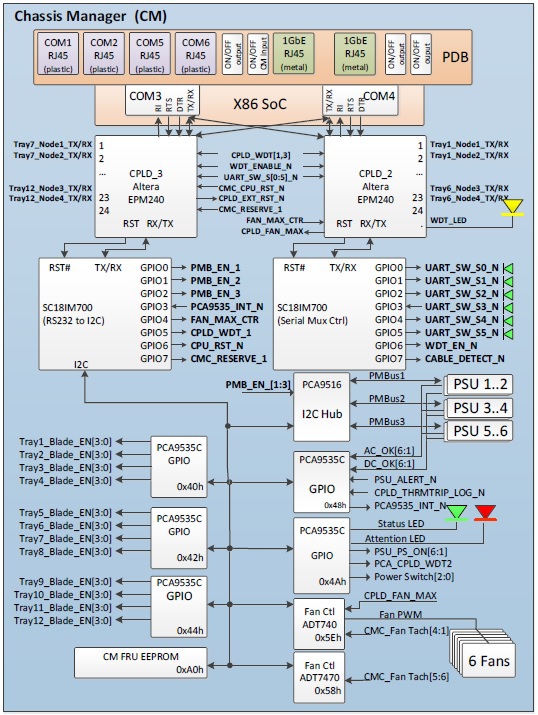

Разводка шин

Разводка шин

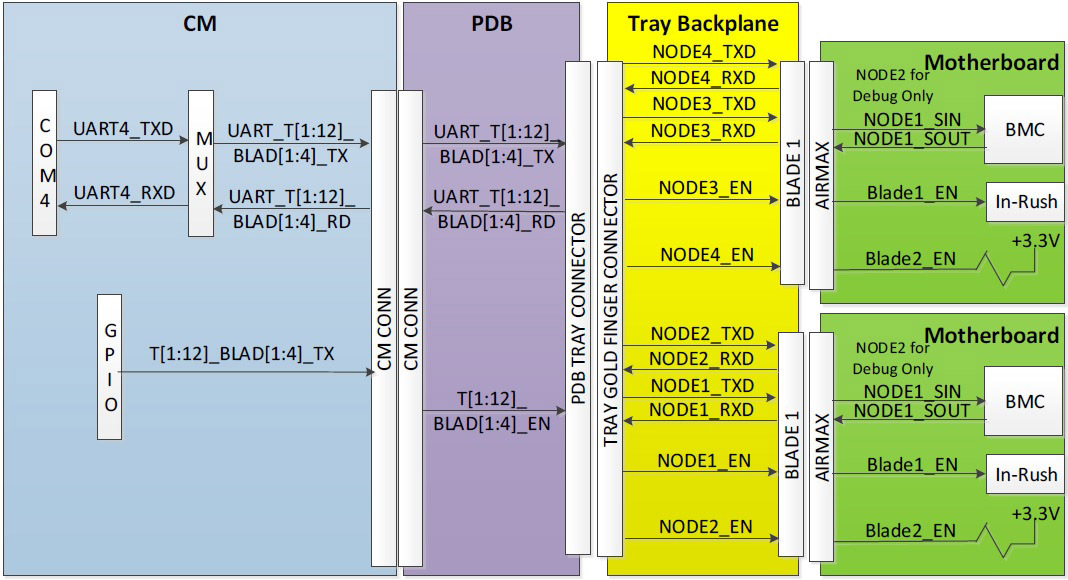

Как это проходит через разъемы

Как это проходит через разъемы

Не забыта и программная часть:

Логическая схема

Логическая схема

Out-of-Band часть

CM имеет REST-подобное API и командную строку CLI для масштабирования системы управления Fan Control/Monitor PSU Control/Monitor Chassis Power Management ON/OFF/Reset Serial Console Redirect Blade Identify LED TOR Power Control ON/OFF/Reset Power Capping In-Band часть

BMC лезвия работает со стандартным IPMI over KCS интерфейсом Windows — WMI-IPMI Linux — IPMItool Идентификация, Chassis Power, Event Logging, Temperature Monitor, Power Management, Power Capping, мониторинг HDD и SSD. Facebook полагается на возможности Intel ME, Microsoft пользуется ставшим уже привычнымIPMI с помощью BMC.

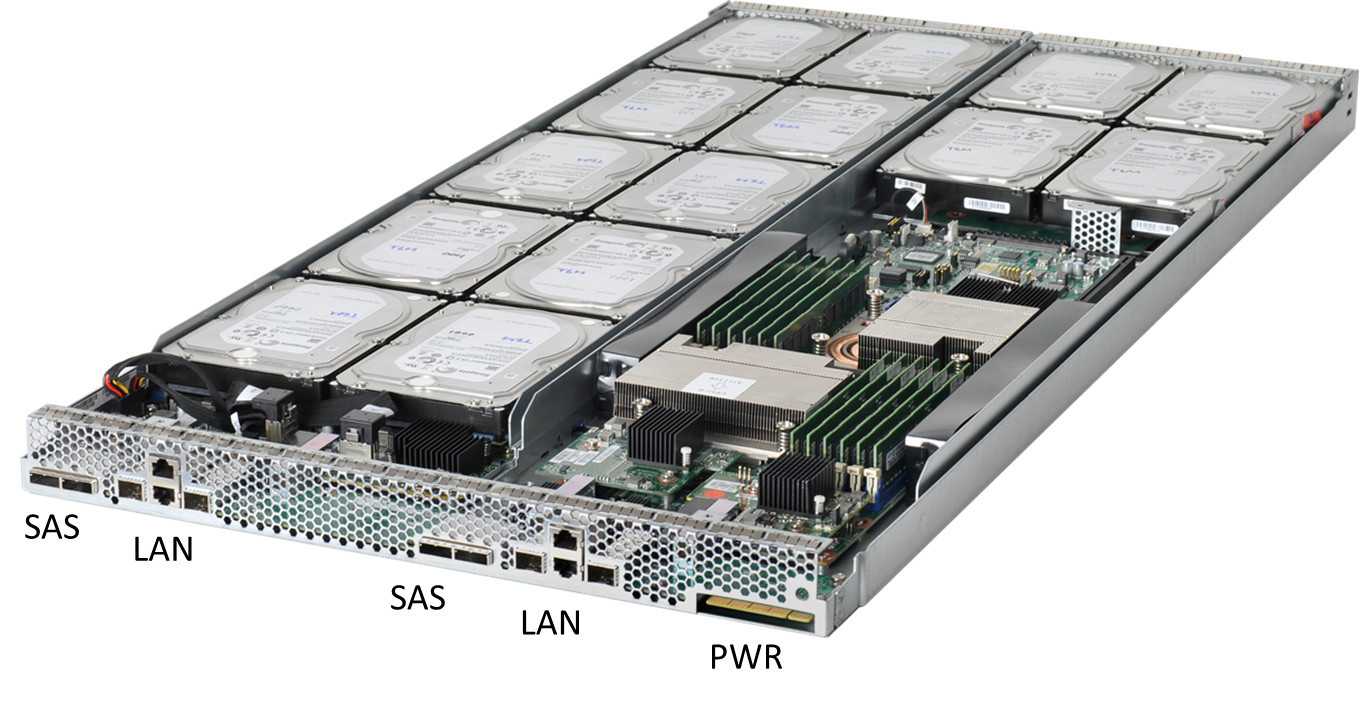

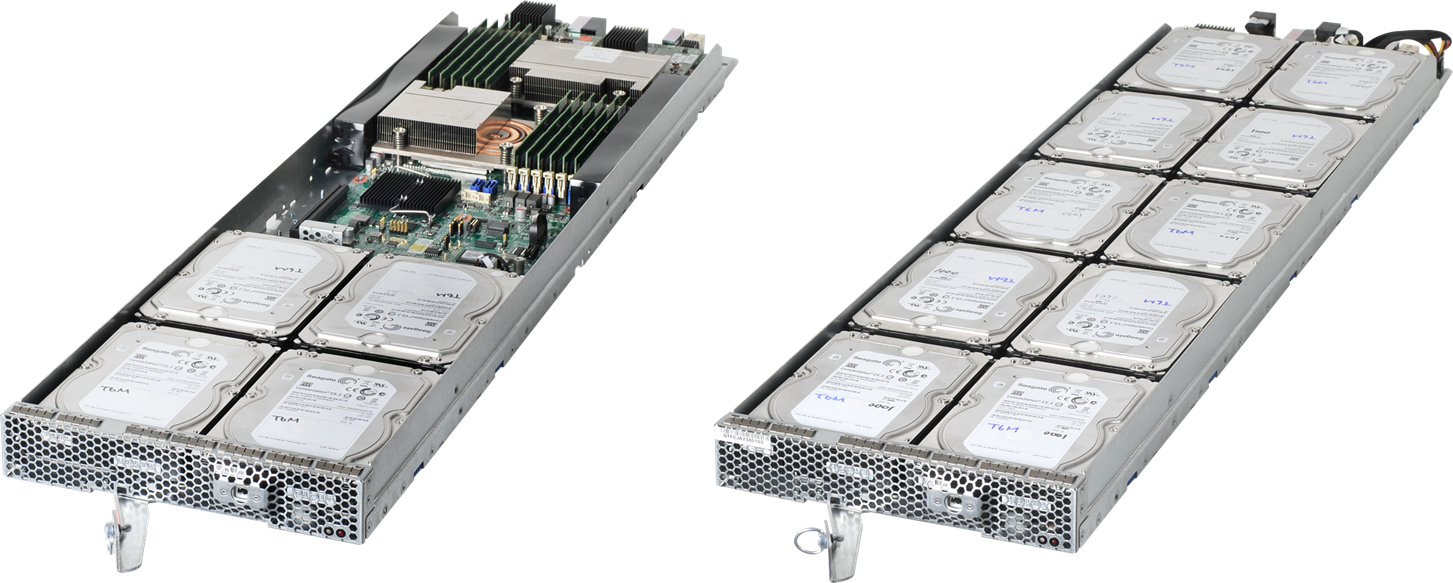

Лезвия

Разработаны два типа лезвий, одно с сервером, другое JBOD на 10 дисков.

Возможные комбинации

Возможные комбинации

Комбинировать, само собой, можно как угодно — хоть два сервера, хоть оба JBOD’ы.

Кабели остаются на месте

Кабели остаются на месте

Кабели подключаются к бэкплейну, поэтому для замены лезвия достаточно просто извлечь корзину (существенное отличие от OCP). Такой подход снижает время на обслуживание и устраняет возможную ошибку при переподключении кабелей.

Спецификация

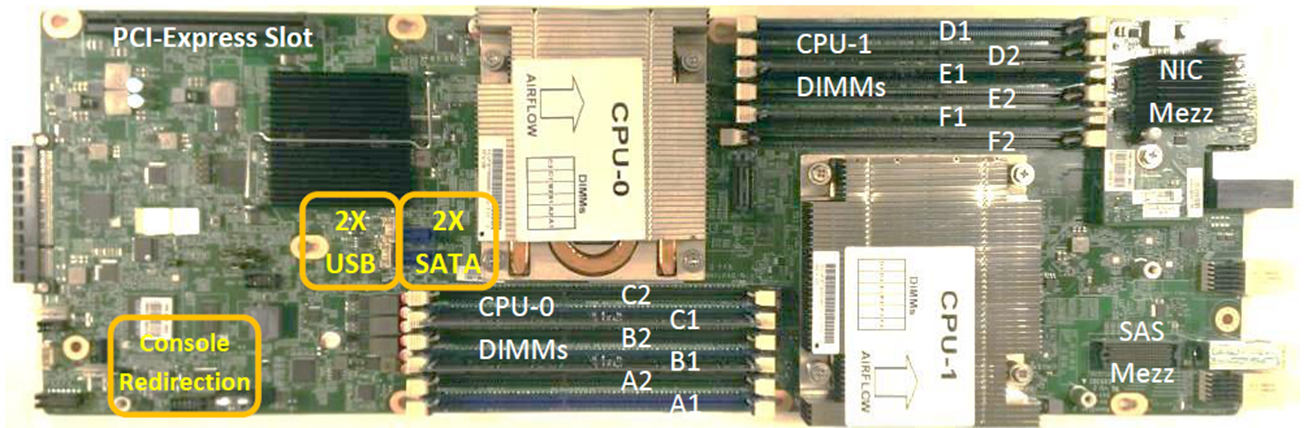

OCS сервер

Процессор

2x Intel Xeon E5–2400 v2 на узел, до 115 Вт

Набор микросхем

Intel C602

Память

12 DDR3 800/1066/1333/1600 ECC UDIMM/ RDIMM/ LRDIMM слотов на сервер

Диски

4 3.5» SATA на сервер

Слоты расширения

[options=«compact»] * 1 PCIe x16 G3 * SAS mezz * 10G mezz

Управление

BMC-lite, подключенный к Chassis Manager с помощью шины I2C

Слот PCIe предназначен для вполне определенной цели — использование PCIe Flash карт.

Так разведены mezzanine платы

Так разведены mezzanine платы

Спецификация

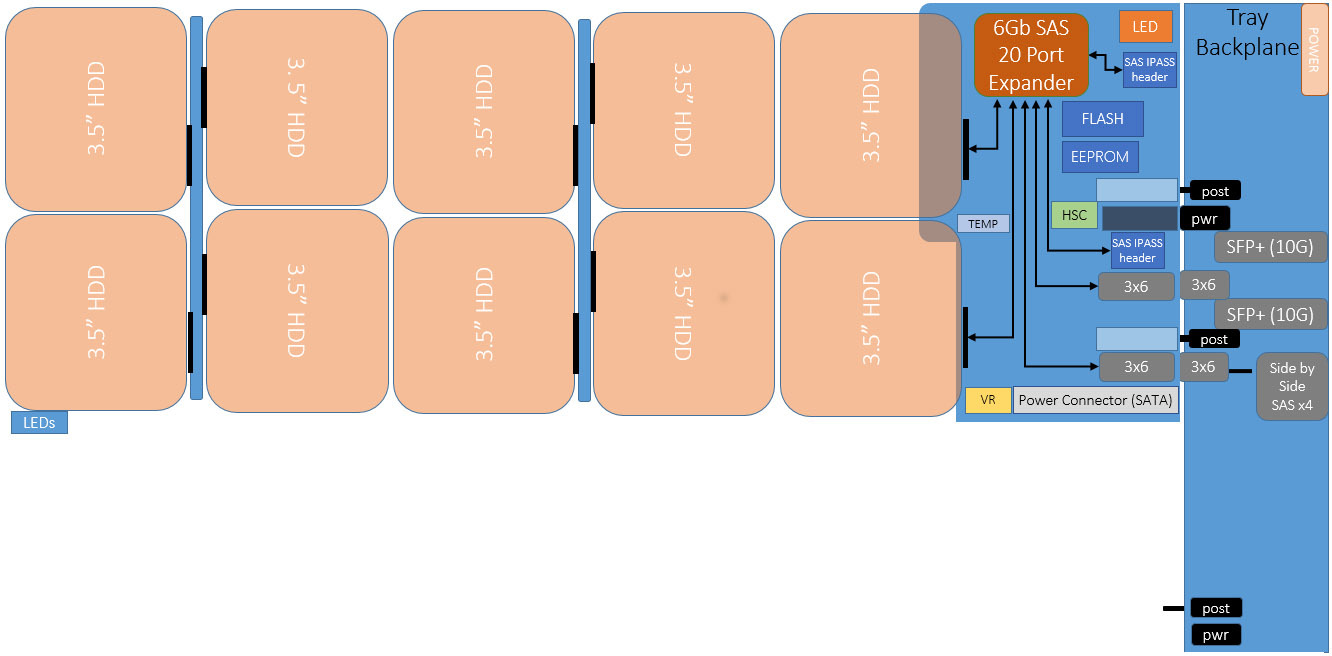

OCS JBOD

Контроллеры

1 SAS Interface Module (SIM)

Внешние порты

2 6Gb/s mini-SAS порта

Диски

10 3.5» SAS/SATA с горячей заменой всей корзины

Управление

SCSI Enclosure Service (SES-2)

Дисковая полка

Дисковая полка

Сетевая инфраструктура

Все сетевые подключения — 10G, гигабит используется только для управления и то не везде. Важный момент — Microsoft крайне активно работает над популяризацией Software Defined Networking (SDN) технологий, их собственные сервисы основаны на программно- конфигурируемых сетях.

Не зря на прошлом Ethernet Summit их продукт для мониторинга SDN сетей, DEMon, получил шесть наград из шести возможных, а компания числится в списке платиновых спонсоров OpenDaylight.

Заодно напоминаем, что у нас давно объявлен продукт для гибридных сетей с поддержкой SDN — коммутатор Eos 410i со стоимостью порта ниже $100:)

Итого

Крупнейшие компании индустрии полагаются на Software Defined Datacenter и Microsoft не исключение. Развитие Ethernet технологий привело к тому, что 10G и RDMA (используется RDMA over Converged Ethernet, RoCE) позволяют обойтись без отдельной FC сети (о приросте от RDMA говорилось здесь: habrahabr.ru/company/etegro/blog/213911/) без потери в производительности. Возможности Windows Storage Spaces таковы, что аппаратные СХД постепенно заменяются решениями на Shared DAS/SAS сетях (подробно писалось тут habrahabr.ru/company/etegro/blog/215333/ и тут habrahabr.ru/company/ etegro/blog/220613/).

Преимущества по версии MS: Дизайн на основе шасси снижает стоимость и энергопотребление

Стандартная стойка EIA 19» Модульный дизайн упрощает развертывание: монтируемые боковины, 1U корзины, блоки питания высокой эффективности, большие вентиляторы для эффективного управления, плата управления с горячей заменой До 24 серверов в шасси, опционально JBOD полки Оптимизировано для контрактного производства Снижение расходов до 40% и на 15% лучшая энергоэффективность по сравнению с традиционными enterprise серверами Ожидаемая экономия 10,000 тонн металла на каждый миллион серверов (тут явно загнули, 10 Кг на один сервер многовато) Все сигнальные и силовые линии передаются через фиксированные разъемыРазделение сервера и шасси упрощает развертывание и восстановление Дизайн «без кабелей» уменьшает возможность человеческой ошибки при обслуживании Снижение числа инцидентов, вызванных неплотно закрепленными кабелями Снижение времени развертывания и обслуживания достигает 50% Сетевые и SAS кабели на едином бэкплейнеПассивная печатная плата упрощает дизайн и снижает риск потери целостности сигнала Поддерживаются различные типы сети и кабелей, 10/40G Ethernet и медные/оптические кабели Кабели разводятся по шасси один раз, при сборке Кабели не трогаются при работе и обслуживании Экономятся сотни километров кабелей на каждом миллионе серверов Безопасная и масштабируемая система управленияСервер в каждом шасси Несколько уровней защиты: TPM при загрузке, SSL транспорт для команд, аутентификация на основе ролей из AD REST API и CLI для масштабирования системы управления На 75% удобней в работе по сравнению с обычными серверами Вывод

Состоялось изобретение очередной инкарнации блейдов. Ключевое отличие от остальных— полностью открытые спецификации платформы и использование стандартных сетевых коммутаторов. В традиционных блейдах от известного круга компаний выбор сетевой части ограничен фантазией разработчиков, в открытом решении можно использовать любой из существующих продуктов, от б/у Джунипера до SDN коммутаторов собственной разработки.

Ну, а мы представили решение на базе Open CloudServer в линейке продукции.