Проблема Интернета — в низкой пропускной способности

Специалисты всего мира трудятся день и ночь, чтобы поддержать каналы передачи данных в рабочем состоянии и расширить их, чтобы не дать информационной революции завянуть на корню.

19 июня вышла новая серия «Игры престолов». Сотни тысяч зрителей с территории США тут же запустили просмотр — и стрим-сервис канала HBO не справился с нагрузкой. Около 15 тысяч зрителей не могли получить доступ к серии в течение часа.

Администрация канала извинилась за непредвиденные неполадки и пообещала, что подобное больше не повторится. Однако дело в том, что этот случай — лишь одно из самых заметных проявлений надвигающейся проблемы. Объем трафика в Интернете растет на 22% каждый год, и такой спрос грозит превзойти возможности интернет-провайдеров.

Хотя мы уже давно не пользуемся модемами, не стоит забывать, что Интернет был создан на основе телефонной сети. И хотя вместо медных проводов мы видим оптоволоконные кабели, которые соединяют между собой огромные центры обработки данных и обеспечивают передачу триллионов бит в секунду, уровень обслуживания в масштабе локальных сегментов сети и отдельных пользователей оставляет желать лучшего.

Эта проблема грозит затормозить развитие информационных технологий. Уже сейчас пользователи ощущают на себе влияние «заторов» в сети: мобильные звонки прерываются при значительной загрузке, беспроводные соединения замедляются в местах большого скопления людей (вроде выставочных центров), качество видеотрансляций страдает при значительном наплыве зрителей. Казалось бы, обещанное высокотехнологичное будущее — с мобильным доступом к видео высокого разрешения, автомобилями-роботами, проведением хирургических операций на расстоянии, конференциями с телеприсутствием, интерактивными 3D-развлечениями в виртуальной реальности — должно вот-вот наступить, но сетевая инфраструктура к нему не готова.

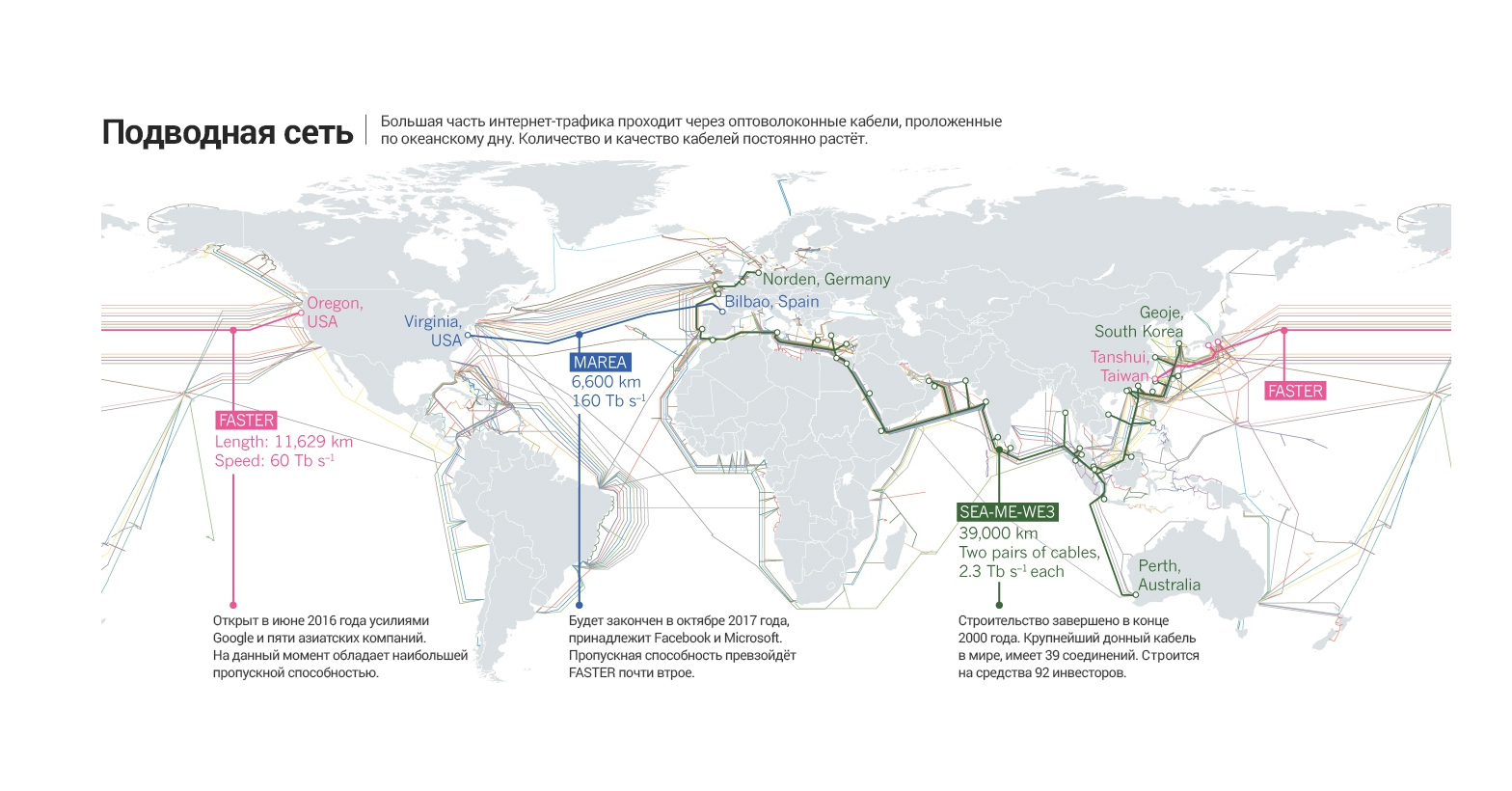

Сейчас компании-провайдеры вкладывают миллиарды долларов в перестройку инфраструктуры Интернета и ликвидацию «заторов». Значимость этого процесса для развития информационных технологий можно сравнить с увеличением вычислительной мощности процессоров. Например, компания Google совместно с пятью азиатскими телекоммуникационными компаниями организовала прокладку оптоволоконной магистрали стоимостью в 300 миллионов долларов и длиной в 11 600 километров по дну Тихого океана, соединив штат Орегон с Японией и Тайванем. Эрик Крейфельдт (Erik Kreifeldt), специалист по прокладке подводных кабелей из вашингтонской компании TeleGeography, называет этот проект «необходимым вложением, нужным для развития отрасли».

Прокладка новых высокоскоростных магистралей — лишь часть комплекса мер, предпринимаемых для оптимизации инфраструктуры Интернета. Ведутся и другие изыскания в разных областях: от ускорения беспроводных сетей до увеличения мощности передающих серверов.

Пятое поколение

Одна из задач, связанных с проблемой расширения сетевой инфраструктуры, решается довольно просто. В Европе и Северной Америке сохранилось довольно много неиспользуемых оптоволоконных магистралей, проложенных на средства оптимистичных инвесторов еще до того, как пузырь доткомов лопнул в 2000 году. С их помощью провайдеры смогут временно решить проблему чрезмерного спроса на трафик в проводных сетях.

Однако это не поможет решить проблемы, которые возникают из-за бума беспроводных устройств. Мобильный трафик в основном обрабатывается сотовыми базовыми станциями, и его объем в среднем растет на 53% каждый год — при том, что площадь покрытия станций не оптимальна, и каждая башня обслуживает тысячи пользователей.

Сети сотовой связи первого поколения 1980-х годов, которые использовали исключительно аналоговый сигнал, остались в прошлом. Сети второго поколения появились в начале 1990-х годов и отличались наличием цифровых услуг (например, SMS-сообщений). Лишь недавно началась замена сетей 2G на более совершенные технологии. Они все еще составляют 75% всех сетей в Африке и на Ближнем Востоке. Сети третьего поколения поддерживают использование мобильного Интернета и существуют с конца 1990-х годов; сейчас их поддерживает большинство мобильных устройств Западной Европы.

Сети четвертого поколения пока остаются наиболее совершенными, они позволяют владельцам смартфонов пользоваться мобильным интернетом со скоростью до 100 Мбит в секунду. Эта технология стала доступна в конце 2000-х годов и ее популярность быстро растет. Однако для того, чтобы удовлетворить уровень спроса на мобильный интернет, который ожидается к 2020-м годам, понадобится пятое поколение беспроводных сетей (5G). И такие сети должны будут обеспечивать скорость подключения, превосходящую 4G в сотни раз — десятки Гбит в секунду.

Глава Института систем связи Университета Сюррея в Гилфорде (Великобритания) Рахим Тафазолли (Rahim Tafazolli) считает, что сигнал 5G должен будет распространяться гораздо шире, чем это возможно сейчас, и охватывать до миллиона устройств на квадратный километр. Это будет необходимо для создания «Интернета вещей» — сети, в которую войдут все виды устройств, от бытовых приборов до систем управления электросетью, медицинских устройств и автономных автомобилей.

Объединение независимых телекоммуникационных компаний Third Generation Partnership Project координировало переход на сети 3G и 4G, а сейчас работает над переходом на 5G. Тафазолли участвует в этой работе и проводит испытания технологии множественного ввода-вывода (Multiply Input Multiply Output, MIMO). Она должна позволить одновременную передачу нескольких потоков данных на одной радиочастоте. При этом передатчик и приемник оборудуются несколькими антеннами, и сигнал передается и принимается различными путями. После приема потоки данных снова разделяются с помощью сложного алгоритма.

Технология MIMO уже применяется в сетях 4G и Wi-Fi. Однако небольшой размер смартфона позволяет установить всего лишь четыре антенны, и столько же применяется на базовых станциях. Эту проблему нужно решить в процессе внедрения 5G.

Установки MIMO с большим количеством антенн уже были испытаны. Компания Ericsson представила многопользовательскую систему с антенной из 512 элементов на выставке Mobile World Congress, которая состоялась в феврале этого года в Барселоне (Испания). Скорость передачи данных между стационарным и подвижным терминалом достигла 25 Гбит в секунду. Передача велась на частоте 15 ГГц, которая входит в диапазон высоких частот для сетей 5G. Японский сотовый оператор NTT DoCoMo испытывает систему совместно с Ericsson, а Korea Telecom планирует масштабную демонстрацию возможностей 5G во время зимней Олимпиады 2018 года.

Другой подход предполагает повышение адаптивности: вместо того, чтобы использовать жестко заданный диапазон частот, мобильное устройство должно работать по принципу «когнитивного радио». При этом происходит программный переход беспроводного соединения на радиоканал, который в данный момент открыт. Такой метод не только позволит автоматически передавать данные по самому быстрому из возможных маршрутов, но и увеличит устойчивость системы. Кроме того, он потребует замены не аппаратного, а программного обеспечения, что гораздо проще.

Еще одна задача на пути к развертыванию 5G — резервирование диапазона радиочастот для достижения требуемого покрытия и пропускной способности. Большинство доступных частот уже зарезервировано существующими международными соглашениями и применяется для телевещания, навигации, в радиотелескопах и т.д. Этот вопрос будет рассматриваться на Всемирной конференции радиосвязи в 2019 году. Федеральная комиссия по связи США в данный момент распродает частоты ниже 1 ГГц телекоммуникационным компаниям. Эти частоты ранее были зарезервированы для телевещания, так как они лучше проникают через препятствия, чем более высокие, но они перестали использоваться после перехода на цифровое ТВ. По мнению Тафазолли, использование этих частот оптимально для малонаселенной местности и позволит обеспечить дома и дороги доступом к 5G с помощью небольшого числа базовых станций.

(кликнуть для увеличения)

Кроме того, возможно использование диапазонов из интервала 1–6 ГГц по мере замены сетей 2G и 3G на 5G. Оптимальными же для густонаселенной городской местности считаются частоты выше 6 ГГц; они мало используются в настоящий момент, так как дают небольшую дальность прохождения сигнала. Планируется устанавливать базовые станции 5G с интервалом в 200 метров. Для сравнения, станции 4G обычно устанавливаются с интервалом в 1 км; однако Федеральная комиссия по связи уже разрешила использование этих частот для высокоскоростной связи начиная с 14 июля. Британская комиссия Ofcom, которая выполняет те же функции, что и ФКС США, собирается вскоре принять аналогичное решение.

Использование высоких частот особенно интересно для компаний, занятых в отрасли связи, так как они открывают новые возможности применения технологии 5G. Недавно компания Verizon испытала в Нью-Джерси, Массачусетсе и Техасе передачу сигнала на частоте 28 Ггц при скорости 1 Гбит в секунду. В экспериментах использовалось оборудование 5G компаний Ericsson, Cisco, Intel, Nokia и Samsung. Verizon планирует предлагать фиксированные беспроводные соединения в качестве альтернативы проводным, при этом стоимость установки подключения будет заметно снижена.

Широкие каналы

Нил Бергано (Neal Bergano), технический руководитель TE SubCom — компании-производителя подводных кабелей из Итонтауна, Нью-Джерси — говорит, что, несмотря на то, что мобильная связь не использует проводов и ее пользователи мобильны, сама по себе сеть мобильной не является. Когда пользователь подключается к сети с помощью телефона, базовая станция превращает радиосигнал в оптический сигнал, который затем передается через стационарный оптоволоконный кабель.

Уже четверть века глобальная сеть телекоммуникаций строится на каналах из оптоволокна. Его пропускная способность не сравнима ни с чем: единственный кабель толщиной в волос способен передавать по 10 Тбитданных — емкость 25 двухслойных Blu-Ray — каждую секунду, и при этом передатчик и приемник могут стоять на разных берегах Атлантического океана. Для сравнения — самый первый трансатлантический кабель, проведенный в 1988 году, имел пропускную способность в 30 тыс. раз меньше. Современные технологии позволяют передавать по одному волокну одновременно до 100 отдельных сигналов, каждый из которых имеет собственную длину волны. Однако даже у «оптики» есть пределы: по мере того, как сигнал проходит тысячи километров стекла, в нем накапливаются шумы и искажения. Верхним пределом для одного сигнала считается скорость в 100 Гбит в секунду.

Стандартное оптическое волокно имеет ядро из сверхчистого стекла толщиной в 9 микрометров. Разработано новое волокно с более широким ядром, которое меньше «загрязняет» сигнал шумами, хотя при этом оно гораздо более чувствительно к растяжению и сгибанию. Таким образом, «широкое» волокно оптимально для длинных и прямых магистралей — например, подводных кабелей, которые находятся в стабильном окружении и не подвергаются внешним воздействиям.

В прошлом году компания Infinera провела опыт в Саннивейле (Калифорния): по оптоволокну с широким ядром пропустили сигнал со скоростью 150 Гбит в секунду. Сигнал прошел 7400 километров, что достаточно для трансатлантического кабеля; также в ходе испытаний был использован сигнал со скоростью 200 Гбит в секунду, который прошел меньшее расстояние.

Самая высокоскоростная система передачи данных на данный момент — это подводный кабель FASTER, который соединяет Японию и штат Орегон. Он состоит из 6 пар «широких» волокон, через каждую из которых проходит 100 сигналов по 100 Гбит в секунду. Однако скоро этот рекорд будет побит: согласно заявлению, сделанному Microsoft и Facebook в мае этого года, в октябре 2017 года будет построена магистраль MAREA. Она протянется на 6400 километров и соединит центры обработки данных этих компаний, расположенные в Испании и в штате Вирджиния. Общая скорость передачи данных составит 160 Тбит в секунду.

Существует еще один способ защиты сигнала от шумов. Его продемонстрировали в Университете Калифорнии (Сан-Диего). Обычно оптоволоконные системы используют несколько лазерных излучателей для генерации сигналов с различной длиной волны. Вместо них предложили использовать один излучатель, созданный с применением технологии «частотной гребенки». Он генерирует серию сигналов с различными длинами волн, отстоящих друг от друга на одинаковый промежуток. Такой подход мог бы удвоить пропускную способность оптоволоконных систем.

Подлетное время

Ширина канала крайне важна, но имеет значение и быстродействие системы. Человеческая речь настолько чувствительна к прерыванию, что неожиданная пауза в четверть секунды способна нарушить разговор по телефону или видеосвязи. Для видео также важна постоянная частота кадров. ФКС США разрешила использование специальных кодов для повышения приоритета передачи пакетов, которые несут кадры видеосвязи и звуковые фрагменты, чтобы трафик, связанный с видео- и аудиосвязью, передавался быстро и равномерно.

Время, которое требуется сигналу для перехода от одного терминала к другому, зависит от расстояния. Хотя скорость сигнала в оптическом кабеле составляет 200 000 км/сек — две трети скорости света в воздухе — задержка между вводом команды, например, в Лондоне, и получением ответа из дата-центра в Сан-Франциско, остается существенной; в данном случае она составит 86 миллисекунд. Это ограничивает возможности облачных вычислений. При этом существует множество других новых сервисов — таких как дистанционно управляемые роботы и хирургические операции — которые крайне чувствительны к задержкам. Не стоит забывать и об играх.

Новые приложения мобильной связи требуют как быстрого отклика системы, так и значительной ширины канала. К примеру, для того, чтобы гарантировать безопасную езду автономного автомобиля, необходимо постоянно получать данные о местности в реальном времени. «Обычным» автомобилям тоже потребуется связь с быстрым откликом для систем голосового управления.

Также не стоит забывать о трехмерных системах виртуальной реальности. Для оптимальной работы таких систем нужна скорость передачи данных 1 Гбит в секунду, что в 20 раз превышает обычную скорость считывания Blu-Ray. Это необходимо потому, что изображение приходится перерисовывать как минимум 90 раз в секунду, чтобы успевать за поворотами головы пользователя; если этого не происходит, пользователь может испытывать дискомфорт. В лаборатории виртуальной реальности Дэвида Уиттингхилла в Университете Пердью в Вест-Лафайетте (Индиана) используется оптоволоконная линия на 10 Гбит.

Крупные компании — такие, как Google, Microsoft, Facebook и Amazon — хранят копии своих данных в центрах обработки данных, распределенных по всему миру. Каждый запрос к данным передается в ближайший центр. По словам Джеоффа Беннета (Geoff Bennett), технического директора компании Infinera, такой подход позволяет зрителям прокручивать видеоролики так, как будто они хранятся на их собственных компьютерах. Широкое распространение центров обработки данных стимулирует повышение пропускной способности оптоволоконных магистралей, так как трафик, который генерируется во время синхронизации копий данных в различных дата-центрах, уже сейчас превышает общий трафик частных пользователей Интернета. Кабель MAREA строится именно с целью синхронизации.

В настоящий момент большинство центров обработки данных расположено в местах наибольшей концентрации пользователей и магистралей: в Северной Америке, Европе и в Юго-Восточной Азии. По словам Крейфельдта, пользователи во многих частях света до сих пор не имеют доступа к центрам обработки данных, и вынуждены мириться с долгим откликом системы. В Южной Америке мало собственных центров, и большая часть контента загружается из Майами (Флорида); пакеты, которые следуют из Бразилии в Чили, также проходят через Майами, что увеличивает время отклика. Такая же проблема и у стран Ближнего Востока. 85% интернационального трафика проходит через европейские центры обработки данных. Ситуация меняется к лучшему, но это происходит достаточно медленно. В прошлом году был запущен первый центр облачного хранения данных Amazon Web Service в Мумбаи (Индия); центр в Сан-Паулу (Бразилия) работает с 2011 года.

Внутренние связи

Пропускная способность важна не только на уровне магистралей, но и на уровне коммуникаций между процессорами внутри каждого из серверов центра обработки данных. Ускорение оборота данных внутри центра приведет и к общему ускорению отклика системы. Однако рост тактовой частоты самих процессоров застопорился несколько лет назад из-за проблем с тепловыделением, и не превышает нескольких гигагерц. Наиболее практичный способ ускорения обработки данных процессором — разделение операций между несколькими ядрами с высокоскоростным соединением между ними. Оптическое соединение в этом случае было бы более практично, так как скорость света превышает скорость электронов, однако интеграция кремниевых микросхем с оптикой затруднена.

Исследования в области кремниевой фотоники идут уже давно, однако способ эффективной генерации света кремниевой микросхемой пока не найден. Существуют хорошие полупроводниковые источники света — например, фосфид индия —, но их почти невозможно вырастить прямо на кристалле кремния из-за различий в структуре атомных решеток. Поэтому интеграция индиевых оптических и электронных компонентов пока крайне ограничена.

Американский Институт производства интегрированной фотоники в Рочестере (Нью-Йорк) был открыт в прошлом году. В него уже вложено 110 млн долларов от федеральных агентств и 502 млн от частных инвесторов и компаний. Этот институт будет заниматься разработкой интегрированной фотоники для вычислительной техники и средств связи.

Кроме того, ранее в этом году уже продемонстрировали интегрированную фотонную схему с 21 активным компонентом, способную выполнять три различные логические функции. Ее разработала команда инженеров из Канады. Это важный шаг в развитии фотонных микропроцессоров: схема сравнима по сложности с первыми программируемыми электронными схемам, с которых началось развитие микрокомпьютеров. Яньпинь Яо (Jianping Yao), инженер из Университета Оттавы и участник разработки, заявил, что схема «проста по сравнению с электронными схемами, но гораздо сложнее, чем другие интегрированные фотонные схемы в настоящее время».

Дальнейшее развитие этой схемы может открыть самые широкие возможности. Например, она могла бы превращать сигнал, который получает башня 5G от смартфона, в аналоговый оптический сигнал, который затем можно передать по оптоволокну в центр обработки данных и оцифровать.

Как и многие другие задачи, которые необходимо решить для оптимизации Интернета, поиск более быстрых процессоров — сложная задача. Однако это не останавливает специалистов, которые заняты поиском решений. Многие из них — например, Бергано — работают в отрасли уже не первый десяток лет, но при этом сохраняют оптимизм и видят потенциал для множества улучшений.

Комментарии (4)

11 октября 2016 в 12:56

+3↑

↓

ИМХО с интернетом все нормально, главная проблема в мусорном трафике, это и неуемное отслеживание всего подряд как софтом так и ОСями с откровенно шпионскими повадками, и огромное количество гнилого спама — рекламой называть то, что весит в несколько раз больше чем запрашивая страница сайта язык не поворачивается, и безумные архитектурные решения вроде «ИОТ ломится наружу локалки».

А еще проблема что забивание трафика не то что не ограничивают так даже поощряют, выдумывают новые еще более тяжелые виды анимированной-видео рекламы, чуть ли не ежесекундно грабят скриншоты экрана пользователя, заваливают в сеть метры излишней телеметрии вместо краткого «жив цел орел» раз в минуту, а что, скорость света стерпит, даешь кабель толщиной с ногу в каждый дом.11 октября 2016 в 14:25

0↑

↓

Вам огнетушитель дать?

11 октября 2016 в 12:59

+3↑

↓

Имхо, проблема не в интернетах, а в головах. Использовали бы p2p для распространения — и никаких проблем бы не испытывали. Структура интернета как такового — это p2p. А что на него натягивают прямое вещание, и он не справляется, удивляться не надо.11 октября 2016 в 13:31

0↑

↓

multicast еще хорошая технология была, для телевещания в локальных сетях. К сожалению, на западе ее сейчас хоронят: постепенно убирают поддержку из устройств (smartTV современные уже не умеют)