Первое десятилетие дополненной реальности

Каждая по-настоящему революционная технология проходит четыре стадии развития: идея, демо, успешных проект, массовый продукт. Это хорошо заметно на примере мультитач-устройств. Давайте оглянемся на предыдущие годы и посмотрим, какова ситуация с технологией дополненной реальности, и пофантазируем, какой она может стать в качестве действительно массового продукта.

В феврале 2006-го Джефф Хан (Jeff Han) на своём выступлении в TED talks показал демку экспериментального «мультитач»-интерфейса (видео ниже). Сегодня многие вещи из презентации кажутся банальными, их умеет делать каждый Android-смартфон за $50. А тогда аудитория, в большинстве своём — искушённые технари, изумлялись и аплодировали. То, что сегодня банально, было тогда удивительным. Год спустя появился первый iPhone, и идея мультитача «обнулилась».

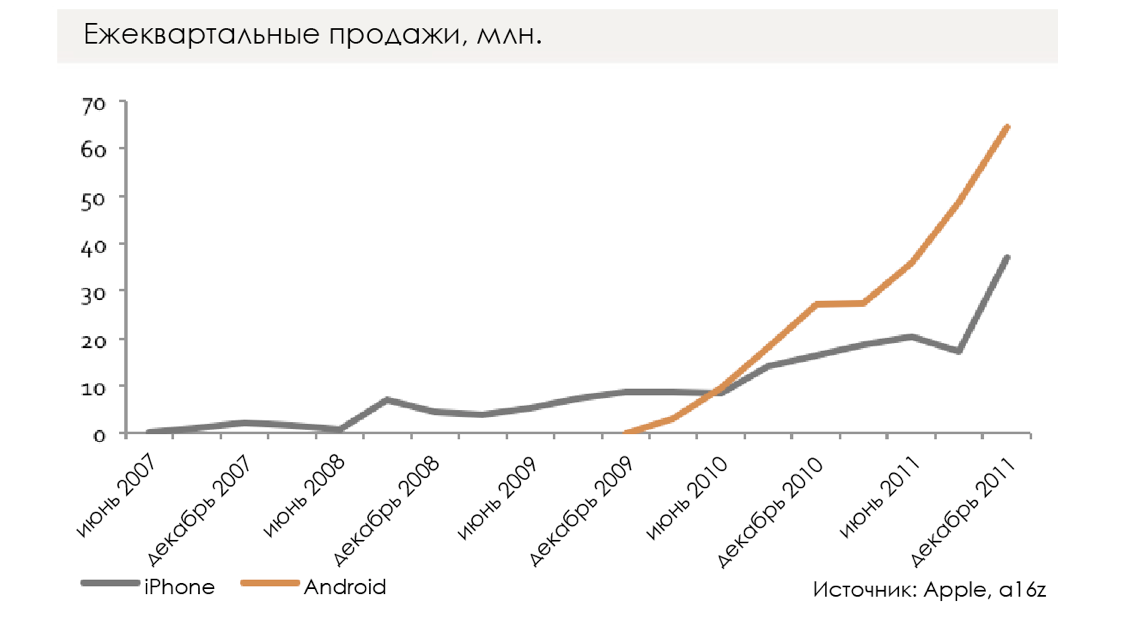

Если посмотреть на события предыдущего десятилетия, то окажется что было четыре стадии запуска мультитача. Сначала он был интересной идеей исследовательских лабораторий. Затем появились первые публичные демки. Третья стадия — первый действительно полезный мультитач реализованный в iPhone. И наконец, через несколько лет, с развитием iPhone и Android-смартфонов начались массовые продажи мультитач-устройств. Эта задержка отражена на графике ниже — после 2007-го прошло несколько лет, даже несмотря на удешевление iPhone, прежде чем смартфоны стали по-настоящему массовым товаром. Подобные стадии развития характерны для многих революционных технологий. Редко, когда что-то сразу получается в законченном виде. Одновременно развивались и тупиковые ветви технологий: Symbian на Западе и iMode в Японии.

Думаю, сегодня дополненная реальность находится где-то между второй и третьей стадиями. Мы уже видели замечательные демки и первые прототипы. Пока не получили массовые коммерческие продукты, но мы уже близки к этому.

Microsoft отгружает Hololens. Это устройство хорошо отслеживает своё положение в пространстве, обладает своим вычислительным процессором. Однако довольно громоздко, имеет очень узкое поле зрения (гораздо меньше, чем в распространяемых Microsoft видео) и стоит $3000. Вероятно, вторую версию устройства можно ожидать в 2019. Очень похоже на то, что Apple тоже работает над чем-то подобным, учитывая информацию об их вакансиях и приобретениях, а также комментарии CEO (подозреваю, что всё это имеет отношение и к миниатюризации, улучшению энергопотребления, радиосвязи и так далее применительно к Apple Watch и AirPod). Вероятно, Google тоже что-то выпустит, или Facebook, или Amazon. Интересные проекты пилят ряд более мелких компаний и стартапов.

Тем временем Magic Leap (в который инвестировала a16z) работает над собственной носимой технологией. Выпущен ряд видео, демонстрирующих возможности прототипов. Но одно дело — посмотреть видео про гаджет, и совсем другое — использовать его. Существует огромная разница между AR-видео и повседневным ношением таких устройств, когда несуществующие объекты возникают перед твоими глазами. Я пробовал — весьма недурно.

Всё это означает, что если мы сегодня на стадии «Джеффа Хана», то скоро можно ожидать появления аналога iPhone 1 в сфере дополненной реальности. А затем, лет через 10 или около того, мы сможем получить действительно массовый продукт. Какой она может быть, дополненная реальность для миллиардов людей?

Первым шагом на пути к AR были Google Glass. Экран «подвешивает» изображение в пространстве перед тобой, но оно никак не взаимодействует с реальным миром. По сути, Google Glass концептуально были очень близки к умным часам, просто смотреть приходилось вверх и вправо, а не вниз и влево. Очки предоставляли экран для вывода данных, но они не имели представления об окружающей среде. Наверное, более продвинутая технология позволит реализовать отображение информации на виртуальном сферическом экране вокруг пользователя, куда можно будет выводить окна, 3D-объекты или ещё что-то.

С появлением «настоящей дополненной реальности», или «гибридной реальности» (mixed reality), устройства смогут предупреждать об окружающих объекта, смогут помещать вместо них виртуальные объекты, так что мы не сможем быть уверены, реально ли то, что мы видим перед собой. В отличие от Google Glass, будущие AR-очки смогут создавать трёхмерные карты окружающего пространства и постоянно отслеживать положение головы. Это позволит поместить на стену «виртуальный телевизор», который будет там «висеть», пока вы находитесь в комнате. Или вообще превратить в дисплей всю стену. Или можно будет поместить на журнальный столик Minecraft (или Populous), и руками строить мир, создавать горы и реки, словно лепя из глины. Если уж на то пошло, то любой, кто наденет такие же очки, сможет увидеть всё то же самое. Можно будет превратить стену или стол в переговорной в дисплей для всей команды, или для семьи. Или можете взять вон того маленького робота и спрятать его за диван, и пусть ваши дети его ищут. Конечно, всё это имеет пересечения с виртуальной реальностью, особенно когда речь заходит о добавлении внешних камер. Гибридная реальность позволит превратить в экран весь мир.

До этого речь шла только о SLAM, то есть о создании трёхмерной карты помещения, но не о распознавании. Можно пойти ещё дальше. Допустим, я встретил вас на митапе и вижу над вашей головой карточку профиля ВКонтакте. Или заметку из CRM-системы, говорящую, что вы ключевой клиент. Или заметку из базы данных Truecaller, согласно которой вы собираетесь впарить мне какую-нибудь страховку и распрощаться. Или, как в сериале «Чёрное зеркало», можно просто «блокировать» конкретных людей, помещая вместо них плоские чёрные изображения. То есть очки не просто сканируют объекты, но и распознают их. Вот это уже будет настоящее дополнение реальности. Вы не просто накладываете изображения на реальные объекты, но делаете это осмысленно, превращаете их в часть настоящего мира. С одной стороны, вы сможете обогатить — или замусорить, это как посмотреть.

А с другой стороны, вы сможете создавать очень ненавязчивые подсказки и изменения окружающего мира. Например, в путешествиях не просто переводить каждую надпись на свой родной язык, но и выбирать определённую стилистику. Если сегодня в браузер можно поставить плагин, который заменяет «millennial» на «snake people», то на что будет способна будущая технология гибридной реальности?

Если очки будут достаточно компактными, вы будете носить их целый день? Если нет, то с ними вы лишитесь и множества применений. Например, вы можете использовать комбинацию из смартфона или часов, выступающих в роли «всегда включённого» устройства, и очков, которые вы надеваете для того, чтобы «правильно» просмотреть контент. Это помогло бы решить некоторые социальные вопросы, которые возникли у владельцев Google Glass: достать телефон, посмотреть на часы или надеть обычные очки — это ясный и понятный сигнал окружающим, а когда носишь Google Glass в баре, то людям совершенно не очевидно, что ты не пялишься в стену, а что-то читаешь.

Всё это приводит к логичному вопросу — происходит ли слияние дополненной и виртуальной реальностей? Это определённо возможно. Обе технологии позволяют выполнять взаимосвязанные вещи, и подразумевают необходимость решить взаимосвязанные инженерные задачи. Одна из них — как перенести пользователя в другой мир с помощью гаджета, являющегося VR-устройством. По идее, вы должны смотреть только сквозь стёкла-дисплеи, то есть очки должны быть закрыты по краям. Но для AR это не нужно. В то же время, трудность с AR заключается в том, чтобы отображать окружающий мир, но при этом отсекать «ненужное» (отдельный вопрос — как быть в случае с ярким солнечным светом). AR-очки прозрачны, то есть окружающие смогут видеть глаза пользователя. Наверное, лет через 10–20 большинство задач по совмещению AR и VR будут решены, но сегодня обе технологии выглядят отдельно развивающимися направлениями. В конце 1990-х мы спорили, будет ли у устройств «мобильного интернета» отдельный радиомодуль и дисплей, плюс наушники плюс клавиатура, или это будет «раскладушка» с экраном и клавиатурой. Индустрия искала нужный форм-фактор, и пришлось ждать до 2007 (и даже дольше), прежде чем мы пришли к устройству с дисплеем, отображающим и клавиатуру. Возможно, идеальный форм-фактор объединения VR и AR тоже ещё не найден.

Другой вопрос: как вы будете управлять и взаимодействовать с виртуальными объектами. Достаточно ли для этого физических контроллеров для VR? Подходит ли просто отслеживание рук (без моделирования движения пальцев)? Мультитач в смартфонах подразумевает физическое взаимодействие: мы касаемся интересующих нас объектов. Но сможем ли мы смоделировать «прикосновение» к AR-объектам? Это действительно хорошая модель взаимодействия для повседневного интерфейса? Magic Leap позволяет создать ощущение глубины пространства, так что ты веришь, что можешь коснуться виртуальных предметов. Но вы хотите пользоваться интерфейсом, в котором ваши руки проходят сквозь то, что должно быть монолитным? Нужно ли использовать управление голосом, и какие ограничения оно будет накладывать (представьте себе полностью голосовое управление телефоном или компьютером, даже при условии идеального распознавания голоса)? Или решение проблемы заключается в отслеживании движения глаз? Например, посмотреть на объект и два раза моргнуть, чтобы выбрать его? Подобного рода вопросы решались при разработке персональных компьютеров и смартфонов, вместе с поиском подходящих форм-факторов. Ответы неочевидны, и вопросов пока остаётся больше.

Чем больше размышляешь над задачей встраивания AR-объектов и данных в окружающий мир, тем больше кажется, что это нужно решать комбинацией ИИ и физического интерфейса. Например, подходя к вам, что я должен увидеть — карточку из ВКонтакта или Facebook? Когда я должен посмотреть новое входящее сообщение — сразу же или позднее? Стоя перед рестораном, должен ли я сказать: «Эй, Foursquare, это хорошее заведение?», или операционная система должна сделать это за меня автоматически? И кем будет управляться это поведение — ОС, добавленными мной сервисами или единым «Google Мозгом» в облаке? У Google, Apple, Microsoft и Magic Leap могут быть разные точки зрения на это, но я считаю, что многие вещи нужно автоматизировать (с помощью ИИ). Если вспомнить слова Эрика Рэймонда о том, что компьютер никогда не должен спрашивать вас о чём-то, что он может вычислить сам, тогда можно сказать, что если компьютер видит всё, что видите вы, то он должен понимать, на что именно вы смотрите. И спустя 10 лет развития ИИ, возможно, мы сможем решить многие стоящие сейчас проблемы, которые пока предполагается решать вручную. Когда мы от оконно-клавиатурно-мышевой модели интерфейса настольных компьютеров перешли к управлению касаниями и прямому взаимодействию с объектами в смартфонах, был снят целый ряд вопросов. Просто изменился уровень абстракции. Смартфоны не спрашивают нас, куда сохранить фотографии, или где вы находитесь, когда заказываете такси, или какое приложение использовать для отправки письма, или какой у вас пароль (если смартфон оснащён сканером отпечатков пальцев). Вопросов больше нет (как и выбора). AR вполне может сделать шаг в том же направлении, ведь это будет нечто большее, чем возникающие перед вами в воздухе приложения в маленьких окнах. Как Snapchat работает совсем не так, как «настольный» сайт Facebook, так и неосязаемый AR-интерфейс, управляемый ИИ, может снова поменять наши представления.

Чем больше AR-очки будут пытаться понять окружающий мир (и вас самих), тем больше они будут наблюдать и отправлять информацию об увиденном на мириады разных облачных устройств, в зависимости от контекста, способов применения и модели приложений. Это лицо человека, и вы с ним разговариваете? Отправим его (или его сжатую абстракцию — да, на это будет сильно влиять пропускная способность сети) в Salesforce, LinkedIn, TrueCaller, Facebook и Tinder. Это пара обуви? Pinterest, «Озон» и Net a Porter. Или вообще всё отправляем в Google. Эти и многие другие ситуации поднимают вопросы, связанные с приватностью и безопасностью. Это как с беспилотными автомобилями, которые когда-нибудь заполонят наши улицы: они постоянно снимают окружающее пространство вокруг себя, и это просто рай для осуществления наблюдения. А что будет, когда все начнут носить AR-очки — можно ли будет вообще от этого убежать? А если ваши очки хакнут? Если хакнут ваш умный дом, то у вас заведутся «полтергейсты», а если хакнут очки, у вас появятся визуальные галлюцинации.

Наконец, ещё один важный вопрос: сколько людей будут носить AR-очки? Будут ли они дополнительным аксессуаром для мобильных телефонов (например, как умные часы)? Или даже в каждом бразильском или индонезийском захолустье можно будет купить десяток моделей китайских AR-очков по $50, как сегодня Android-смартфоны? (И что произойдёт с мобильным интернетом?) Пока ещё рано предсказывать. В конце 1990-х—начале 2000-х мы гадали, будут ли у всех мобильные устройства одного типа, или у некоторых будет то, что мы сегодня называем смартфонами, а у большинства будут традиционные кнопочные мобильники, вплоть до примитивных устройств без камеры или цветного экрана? Оглядываясь назад, понимаешь, что это были споры наподобие «будут ли у всех персональные компьютеры, или кто-то будет пользоваться печатными машинками (word processors)». Логика масштабирования и вычислений общего назначения привела к тому, что сначала РС, а потом и смартфон стали едиными универсальными устройствами. Сегодня на земле примерно 5 млрд владельцев мобильных смартфонов, из них 2,5–3 млрд владеют смартфонами — и очевидно, что за ними последуют остальные. Так что вопрос стоит так: будет ли большинство пользоваться смартфонами, а некоторые (100 млн? 500 млн? 1 млрд?) перейдут на AR-очки в виде аксессуара, или появится новый универсальный продукт? Любой ответ на этот вопрос — это полёт фантазии, а не продукт анализа. Но тогда, в 1995-м, говорили, что у всех будут обычные телефоны.