Откуда берут фотографии для тестирования систем распознавания лиц

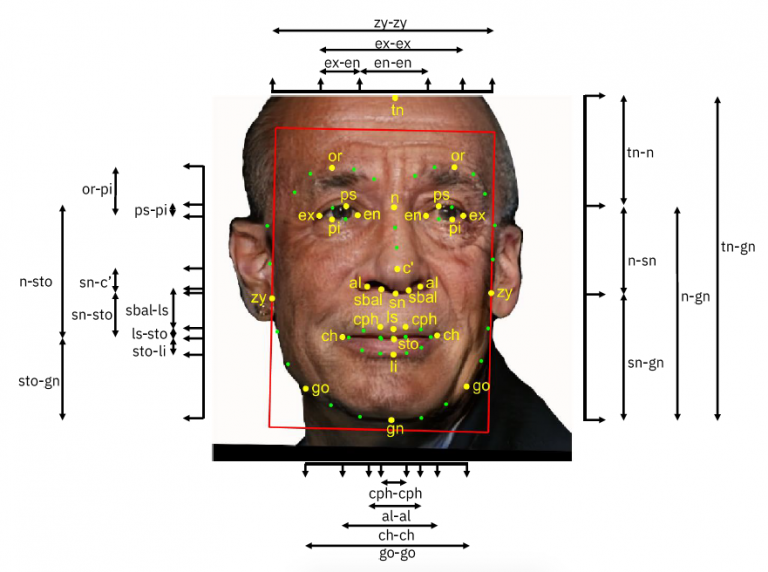

Аннотированная фотография из набора данных Diversity in Faces от IBM

Недавно компания IBM подверглась критике за то, что для обучения нейросетей без разрешения взяла общедоступные фотографии с фотохостинга Flickr и других сайтов, куда пользователи выкладывают свои снимки. Формально всё по закону — все фотографии опубликованы под лицензией Creative Commons —, но люди чувствуют дискомфорт из-за того, что ИИ обучается на их лицах. Некоторые даже не знали, что их сфотографировали. Как известно, для съёмки человека в общественном месте не нужно спрашивать у него разрешения.

Как сообщалось в СМИ, компания IBM использовала примерно 1 миллион частных фотографий с Flickr для обучения своей системы распознавания лиц. Но потом выяснилось, что на самом деле IBM не копировала фотографии с Flickr, эти снимки являются частью набора данных YFCC100M из 99,2 млн фотографий, доступных для обучения нейросетей. Эту базу составила ещё Yahoo, бывший владелец Flickr.

Оказывается, что история с IBM — только вершина айсберга. Здесь компания совершенно случайно попала под раздачу, а на самом деле фотографии пользователей давно используются для обучения самых разных систем, это уже стало общепринятой практикой: «Наше исследование показало, что правительство США, исследователи и корпорации использовали изображения иммигрантов, детей, подвергшихся насилию, и мёртвых людей для тестирования своих систем распознавания лиц», — пишет издание Slate. Оно особо подчёркивает, что подобную деятельность практикуют даже правительственные агентства, такие как Национальный институт стандартов и технологий (National Institute of Standards and Technology, NIST).

В частности, в рамках NIST действует программа Facial Recognition Verification Testing (FRVT) для стандартизированного тестирования систем распознавания лиц, разработанных сторонними компаниями. Эта программа позволяет оценивать все системы одинаковым образом, объективно сравнивая их друг с другом. В некоторых случаях за победу в конкурсе присуждаются денежные призы до $25 тыс. Но и без денежного вознаграждения высокая оценка в тесте NIST — мощный стимул для коммерческого успеха компании-разработчика, потому что на эту систему сразу обратят внимание потенциальные клиенты, а оценку A+ можно упоминать в пресс-релизах и рекламных материалах.

Для оценки NIST используются большие наборы данных с фотографиями лиц, снятых под разными углами и в различных условиях освещения.

Расследование Slate показало, что набор данных NIST включает следующие фотографии:

Многие снимки сделаны сотрудниками Министерства внутренней безопасности (DHS) в общественных местах, при этом в процессе фотосъёмки прохожих сотрудники DHS выдавали себя за туристов, которые фотографируют окрестности.

Наборы данных NIST содержат миллионы изображений людей. Поскольку сбор данных происходил в общественных местах, то буквально любой человек может оказаться в этой базе. NIST активно распространяет свои наборы данных, позволяя всем желающим загружать, хранить и использовать эти фотографии для разработки систем распознавания лиц (изображения эксплуатации детей не публикуются). Невозможно сказать, сколько коммерческих систем используют эти данные, но многочисленные научные проекты точно делают это, пишет Slate.

В комментарии для издания представитель NIST сказал, что базу FRVT, собирают другие правительственные организации в соответствии с их задачами, это касается и базы с фотографиями детей. NIST использует эти данные в строгом соответствии с законодательством и существующими правилами. Он подтвердил, что база с детским порно действительно используется для тестирования коммерческих продуктов, но дети в этой базе анонимизированы, то есть не указаны их имена и место жительства. Сотрудники NIST не просматривают данные фотографии, они хранятся на серверах DHS.

Набор данных с фотографиями детей используется, по крайней мере, с 2016 года. Согласно документации для разработчиков, он включает в себя «фотографии детей в возрасте от младенца до подростка», где большинство снимков демонстрируют «принуждение, насилие и сексуальную активность». Эти изображения считаются особенно сложными для распознавания из-за большей изменчивости положения, контекста и т. д.

Вероятно, этот набор данных используется для обучения и тестирования систем автоматической фильтрации непотребного контента.

Журналисты также обращают внимание на «предвзятость» набора данных с преступниками Multiple Encounter Dataset. Хотя чернокожие составляют всего 12,6% населения США, в базе фотографий преступников их 47,5%, из-за чего ИИ тоже может обучиться предвзятости и стать расистом.