Обзор программы SmartData 2021

Совсем скоро в онлайне стартует SmartData 2021. По названию конференции уже понятно, что она посвящена работе с данными, но не все так просто. Это достаточно обширная тема, в которой можно заниматься совершенно разными вещами. SmartData затрагивает конкретную часть домена «Работа с данными» — дата-инжиниринг. Тут можно услышать про СУБД, архитектуру DWH, MLOps и многое другое, с чем сталкиваются дата-инженеры.

Среди наших спикеров есть и люди из академической среды (Энди Павло), и те, кто имеет дело с огромным количеством данным (Теджас Чопра из Netflix), и топовый контрибьютор популярнейшего оркестратора Airflow (Эш Берлин-Тейлор) и многие другие профессиональные дата-инженеры и архитекторы.

Темы докладов будут самые разнообразные: как заниматься йогой со Spark, какие бывают инженеры данных, как масштабировать аналитику, совладать с ClickHouse без ущерба для здоровья, оптимизировать повседневные задачи с помощью ML и так далее.

Но не докладами едиными: будет ещё и два воркшопа, где зрители не внимают теоретическим знаниям со слайдов, а перенимают у спикера практические навыки работы с чем-то. А в финале конференции будет круглый стол об альтернативах Hadoop.

Под катом — детальный обзор программы, для вашего удобства поделённый на тематические блоки (инструменты, процессы, архитектура и т.д.).

Воркшопы

Воркшоп. Создание эффективной модели данных для высоконагруженных приложений с Apache Cassandra

Александр Волочнев

Александр ВолочневDatastax

Моделирование данных — один из важных компонентов, влияющих на перформанс в мире OLAP. А моделирование данных в распределенных NoSQL — это еще более сложная задача: большая часть проблем с Cassandra вызваны неправильной моделью данных. Это влечет уменьшение производительности, снижение возможностей расширения и т.д.

Александр — профессиональный архитектор облачных решений и Developer Advocate для Apache Cassandra в Datastax, он всегда рад поделиться опытом в проектировании высокопроизводительных и отказоустойчивых систем.

Поэтому если вы дата-инженер, дата-архитектор и работаете с Apache Cassandra, приходите на этот воркшоп, где в live-режиме архитектор DataStax разберет типичные ошибки и покажет, как из БД выжать максимум.

Воркшоп. Делаем жизнь инженеров проще с Big Data Tools

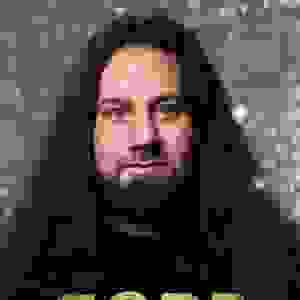

Паша Финкельштейн

Паша ФинкельштейнJetBrains

Паша хорошо знаком зрителям наших конференций. Он спикер и член программного комитета SmartData. Сейчас работает в компании JetBrains над разработкой Big Data Tools — инструментов, которые делают жизнь дата-инженеров проще.

На этом воркшопе вы узнаете, как упростить себе жизнь и не использовать кучу инструментов под каждую задачу.

Паша Финкельштейн на конференции JPoint 2019

Паша Финкельштейн на конференции JPoint 2019

Инструменты

Как прикрутить SQL к чему угодно при помощи Apache Calcite

Роман Кондаков

Роман КондаковQuerify Labs

Роман — делал распределенный SQL-движок для Apache Ignite в компании Gridgain. Специалист по Calcite, профессионально консультирующий по созданию баз данных с его применением. Любит базы данных и знает про них много всего интересного, о чем и расскажет.

Если вы не хотите впутываться в риски создания совершенно новых движков, или просто интересуетесь работой баз данных (как реляционных, так и нереляционных), то этот доклад должен быть полезен. Роман как никто другой знает, как использовать SQL-движки в системе, и расскажет о том, как в его компании исправляли проблемы со старым SQL-движком в Apache Ignite.

Delta Lake data layout optimization

Sabir Akhadov

Sabir AkhadovDatabricks Inc

Физическое расположение данных в системах хранения — сложная и интересная тема, о которой, по сути, не может рассказать никто, кроме разработчиков. А Сабир — разработчик! Раньше он работал в команде разработчиков производительности и тестирования производительности Databricks, накопил богатую экспертизу в оптимизации. Сейчас он инженер-программист и работает над оптимизацией физического хранения.

Сабир расскажет, как можно оптимизировать хранение данных и как жить дальше, когда вы уже дошли до предела оптимизации.

Apache Airflow 2.3 and beyond: what comes next?

Ash Berlin-Taylor

Ash Berlin-TaylorAstronomer.io

Airflow — популярнейший оркестратор, которые используют часто и много, и периодически страдают от этого.

Эш Берлин-Тейлор — один из топовых контрибьюторов Airflow, он лично переписал самую сложную и запутанную часть и разбирается в нем как никто другой.

В докладе Эш расскажет, какие новые фичи появились в Apache Airflow 2.2, и что вероятно всего будет включено в версию 2.3. Расскажет он и о долгосрочном направлении развития проекта (и о том, куда он не движется).

В докладе пойдет речь об интересных фичах, которые планируется реализовать и которые сделают DAG в Apache Airflow гораздо более мощными, что позволит устранить многие прежние болевые точки и откроет новые варианты использования Airflow.

Airflow 2.х SaaS

Михаил Солодягин

Михаил СолодягинTele2

Сергей Юнк

Сергей ЮнкTele2

Вадим Суханов

Вадим СухановTele2

Парные доклады с двумя спикерами — не редкость, а вот тройные случаются не так часто. Здесь все трое докладчиков вместе работают в Tele2: Михаил и Сергей разрабатывают Hadoop-дистрибутив, Вадим делает пайплайны, развивает внутренние фреймворки, контрибьютит в Airflow.

Вместе ребята реализовали работающий Airflow SaaS в частном облаке Kubernetes и в докладе расскажут, как им пользоваться, когда команда растет.

Поэтому если у вас есть Airflow и вы задумываетесь о том, как сделать так, чтобы с ним работало как можно больше людей, которые при этом не хотят разбираться в том, как он устроен, то доклад будет вам полезен. В конце пройдет небольшая демонстрация проекта.

Create a git-like experience for Data Lake analytics

Itai Admi

Itai AdmiTreeverse

Версионирование данных является сложным и комплексным, им трудно управлять, а lakeFS решает эту проблему.

Итаи Адми — руководитель группы исследований и разработок в Treeverse, компании, стоящей за lakeFS. Он расскажет, как с помощью lakeFS над файлами в хранилище объектов можно делать операции на манер Git. Из доклада вы узнаете, как упрощаются общие процессы, как модель данных graveler, которая используется в lakeFS, делает эти операции не только возможными, но и эффективными в любом масштабе.

Выступление будет интересно инженерам и архитекторам данных.

NiFi on a large scale: Архитектура, мониторинг, лучшие практики

Дмитрий Ибрагимов

Дмитрий ИбрагимовLeroy Merlin

Дмитрий вот уже 8 лет занимается построением и поддержкой хранилищ и озер данных в компаниях и стартапах на технологическом стеке Apache.

В докладе Дмитрий рассмотрит ETL-инструмент NiFi — его плюсы и минусы, инструменты и способы мониторинга, поговорит о процессе разработки для большого числа команд. NiFi — достаточно популярный инструмент, с ростом количества людей, которые им пользуются, приходится сталкиваться с вопросами разведения окружений, масштабирования, мониторинга и CI/CD пайплайнов.

Доклад будет интересен инженерам, которые уже работают с NiFi или только выбирают ETL-инструмент для своих задач.

Spark

Apache Spark as an in-memory-only data processing engine?

Jacek Laskowski

Jacek LaskowskiIndependent Consultant

Яцек — автор книг и один из звездных спикеров всех конференций по дата-инжинирингу. Специализируется на Apache Spark, Delta Lake, Apache Kafka и Kafka Streams. В докладе Яцек погрузит вас во внутреннее устройство Spark.

Невероятно, но факт: Spark хранит блоки данных в памяти, хотя все обычно считают иначе.

Тогда можно ли настроить Spark так, чтобы он никогда не касался жестких дисков и, следовательно, работал с быстрой памятью? Какие могут возникнуть проблемы? Что в Spark предназначено только для работы с памятью? На все эти вопросы вы получите ответы в докладе.

Кстати, Яцек совсем недавно написал на эту тему главу книги и считает, что выступление по ней может стать одним из лучших.

«Функциональный» Spark

Дмитрий Зуев

Дмитрий ЗуевOzon

Дмитрий пишет на Scala с 2014 года, и успел поработать над разработкой почти всего: от банальных CRUD API до распределенных stateful-сервисов. Последнее время занимается дата-инжинирингом в различных его ипостасях.

На Spark пишут многие, но далеко не все уделяют внимание качеству Scala-кода. В докладе Дмитрий расскажет, как сделать код более стабильным, эффективным, структурированным и расширяемым. Дмитрий и его коллеги на собственном опыте «выстрадали» те подходы и советы, о которых пойдет речь в докладе. Поэтому если вы хотите забрать себе нетривиальные, но очень полезные трюки, которые улучшат код и сэкономят время на его разработку и поддержку, то не пропустите это выступление.

Доклад будет полезен всем, кто пишет код на Spark, но не так глубоко знает и использует Scala, как хотелось бы.

Spark Yoga — saving time & money with lean data pipelines

Vishnu Chanderraju

Vishnu Chanderrajueyeota.com

Вишну был одним из тех, кто стоял у истоков создания Flipkart — главного индийского маркетплейса, сейчас он сеньор-инженер по данным на eyeota.com.

Автор столкнулся с ситуацией, когда нужно было разрабатывать дата-пайплайны с фиксированными SLA при минимальных денежных затратах, поэтому он придумал много интересных трюков для разработки на Spark, которые позволят сэкономить много денег, разработал свою собственную систему «бережливого» дата-пайплайна.

Эта тема будет интересна разработчикам Spark, пользователям Spark в облаке, особенно в AWS, а также не-spark разработчикам дата-пайплайнов в облаке.

Процессы

Два типа инженеров данных

Дмитрий Аношин

Дмитрий АношинMicrosoft

В аналитике и инжиниринге данных Дмитрий уже более 10 лет. Ведет популярный телеграм-канал по современным аналитическим решениям: @rockyourdata, преподаватель, автор книг.

Итак, чем же все-таки занимается дата-инженер? Такой вопрос, наряду с «Как мне справиться с синдромом самозванца?» задает себе любой в профессии, когда доходит до осознания, где в компании нужен дата-инженер. Давайте признаем, что «дата-инженер» все-таки понятие размытое, и в нем стоит разобраться.

Дмитрий разработал интересную дихотомию, которая позволит ответить на этот вопрос, и выделил два типа инженера данных — Gentle и Hardcore.

Доклад будет интересен всем, кто сталкивается с дата-инженерами или является им сам.

DWH как продукт

Евгений Николаев

Евгений НиколаевАвито

Евгений — руководитель юнита DWH в «Авито». Имплементировать продуктовый подход для построения DWH — большая редкость, но еще большая редкость — хорошо об этом рассказать. Евгений возьмет на себя такую задачу.

Индустрия уже давно и эффективно применяет продуктовый подход к разработке внешних сервисов, но для разработки инструментов для внутреннего использования (платформы, библиотеки, данные) по старинке используют проектный подход. Но оказывается, можно свой инструмент воспринимать как продукт. В докладе посмотрим, насколько это эффективно.

Доклад адресован лидам, владельцам продуктов и менеджерам команд, которые создают внутренние инструменты, а также инженерам, которые интересуются этой темой.

Рабочее место D-people — опыт СБЕР

Дмитрий Бугайченко

Дмитрий БугайченкоСБЕР

У Дмитрия большой профессиональный и педагогический опыт. Он занимался анализом больших данных в «Одноклассниках», а с 2019 года работает в Сбере.

Опыт больших компаний по организации работы с данными для специалистов разного профиля — инженеров, аналитиков, дата сайентистов — это всегда интересно. Задача дата-инженеров не только в том, чтобы перелить данные из точки А в точку Б, но и в том, чтобы сделать инфраструктуру работы с данными удобной.

Дмитрий расскажет, как эволюционировали подходы к выделению вычислительных ресурсов и организации доступа, как менялся набор инструментов и подходов к моделированию, как развивались подходы к выводу результатов в промышленную эксплуатацию.

Доклад будет интересен дата-инженерам, архитекторам и руководителям команд — они узнают, как можно организовать работу с ресурсами в области данных.

Хранение

How an analytical database stopped me smoking: A practical story with Exasol

Christian Langmayr

Christian Langmayr Exasol

Valerie Wiedemann

Valerie WiedemannExasol

В наше время на нейронные сети и роботов возлагаются большие надежды. Люди хотят заменить ими рутинные операции, и все это применимо и для инженерии данных. Некоторые функции администратора БД стандартны и могут быть определены. Например, администратор должен следить за запросами пользователей, анализировать использование полей и скорость запросов и удалять показатели, если они не очень популярны, а также создавать новые. Автоматизация части работы администратора БД — одна из важных составляющих Exasol в улучшении скорости запросов.

СУБД Exasol пока еще не так известна в России, хотя очень популярна за рубежом. Так что доклад, где рассказывается о ее внутреннем устройстве, будет интересен российской аудитории. А расскажут о ней Валери Видеманн — практикующий инженер по решениям в Exasol, и Кристиан Лангмайр, умеющий делать увлекательные презентации.

Поэтому если вы ищете что-то новое для своих аналитических баз данных, хотите быть в курсе последних тенденций в области дата-инжиниринга, ищете бэкенд для своих BI-инструментов, то не проходите мимо.

Trino (Presto) DB: Zero copy lakehouse

Артем Алиев

Артем АлиевHuawei

Артем — эксперт в области технологий больших данных и графических баз данных. А еще он крайне харизматичен, поэтому слушать его будет интересно даже тем, кто ничего не знает о Trino.

Запрос на интерактивную обработку данных растет, и способов организовать такую возможность много. Есть ряд малоизвестных инструментов, позволяющих упростить организацию этого процесса. В докладе поговорим о Trino и его конкурентах (Dremio, Drill), о работе с данными из первоисточников, объединении и обогащении их и т.д. Обо всем этом Артем расскажет не с позиции пользователя систем, а с позиции человека, который умеет находить в них недостатки и знает, как их исправить.

Доклад нацелен на дата-инженеров и архитекторов облачных систем, и предлагает интересный вариант интеграции источников данных.

Dremio SQL Lakehouse: быстрые данные для всех

Виктор Кесслер

Виктор КесслерDremio

Запрос на скорость поставки данных на рынке очень большой, поэтому всегда интересно, каким образом эту поставку можно ускорить, а особенно, если часть работы можно убрать.

С помощью концепции Data Lakehouse + Data Virtualization этой скорости можно добиться и сейчас — именно в то время, когда на рынок выходят инструменты, позволяющие эту концепцию реализовать на практике.

Виктор расскажет, что такое Data Lakehouse, какие преимущества и недостатки появляются при использовании этой технологии, как они позволяют контролировать изменения в данных и ускорять time-to-market.

До прихода в Dremio, Виктор работал в MongoDB, ERGO, PwC и SAP в качестве архитектора в проектах на темы больших данных, DWH и цифровой трансформации. Архитектор с большим опытом и широким кругозором.

Lessons learned from using machine learning to optimize database configurations

Andy Pavlo

Andy PavloCarnegie Mellon University

Энди Павло — доцент кафедры баз данных факультета компьютерных наук Университета Карнеги-Меллон. Соучредитель компании OtterTune. Видит ситуацию в инжиниринге данных как и с академической стороны, так и со стороны индустрии. Потрясающий спикер, увлеченный темой БД.

Настройка перформанса с помощью машинного обучения — давняя мечта инженеров. На эту тему проводится множество исследований, а вот результатов пока не так много. Этот доклад основан на сугубо практическом опыте внедрения ML в сервисе OtterTune.

Машинное обучение может генерировать лучшие конфигурации СУБД быстрее, чем это делает специалист. А поскольку алгоритмы МО не требуют, чтобы люди принимали решения, они также могут масштабироваться для поддержки одновременной настройки тысяч баз данных.

Доклад будет полезен всем тем, кто интересуется перспективами использования МО для решения повседневных задач и занимается оптимизацией БД.

Архитектура высокопроизводительных распределенных SQL-движков

Vladimir Ozerov

Vladimir OzerovQuerify Labs

Владимир — основатель Querify Labs, компании, которая помогает другим компаниям проектировать и реализовывать распределенные движки БД и оптимизаторы запросов. У него много примеров и практики из реальных боевых систем, он хорошо знает не только теоретическую часть, но и реальные проблемы инженеров.

А практически каждый дата-инженер сталкивается с темой оптимизации распределенных запросов в SQL-движках. Часто сложно найти материал и разобраться, как это всё работает. Владимир расскажет про принципы работы оптимизатора распределенных запросов и даст множество ссылок на первоисточники для дальнейшего подробного изучения этой темы.

Доклад будет полезен всем, кто сталкивался с медленным выполнением распределенных запросов в своих системах.

Круглый стол: что, если не Hadoop

Николай Марков

Николай МарковAligned Research Group

Максим Стаценко

Максим СтаценкоЯндекс

Наталья Хапаева

Наталья ХапаеваМТС

Николай Трошнев

Николай ТрошневЧастный консультант

Валдис Пукис

Валдис ПукисEvolution

На этом круглом столе соберутся уже знакомые нашим зрителям Максим Стаценко, Николай Марков, а также Наталья Хапаева из МТС, Николай Трошнев, имеющий десятилетний опыт в аналитике данных, и Валдис Пукис — руководитель группы обработки данных в Evolution.

Мир меняется. То, что раньше казалось незыблемым и не вызывающим сомнений, сейчас требует пересмотра. Участники круглого стол поднимут вопрос: можно ли уже отказаться от экосистемы Hadoop и отправить ее на свалку истории, или же без нее по-прежнему никуда?

Разговор обещает быть жарким: участники поговорят и о том, насколько удобно хранить сырые данные НЕ в HDFS, как делать Kappa-архитектуру в реальной жизни и можно ли просто всех пересадить на SQL-движок.

Дискуссия позволит по-новому взглянуть на привычные вещи, переосмыслить проблемы Data Governance и вдохновиться на решение новых задач. А в конце вы сможете присоединиться к обсуждению в дискуссионной зоне и задать свои вопросы.

Архитектура

Этапы построения платформы аналитических данных в облаках

Николай Голов

Николай ГоловManyChat

Николай — глава департамента дата-инжиниринга в ManyChat, отвечает за все пайплайны и платформу данных для аналитики (хранилище, BI, ETL, интеграционные сервисы). Преподает в НИУ ВШЭ, где занимается научными исследованиями в области современных методологий построения хранилищ данных (Data Vault и Anchor Modeling), и изучает блокчейн.

В своем докладе Николай расскажет об опыте построения аналитической платформы, включающей сбор данных с сервисов, доставку до слоев хранения (Data Lake, детализированные данные, витрины), выполнение расчетов (batching, streaming) и интеграцию с BI-инструментами (отчетность, ML). Какой выбор делала команда на каждом этапе и к чему это приводило, какие возникали риски и что вышло в итоге.

Доклад будет интересен дата-архитекторам и дата-инженерам.

Сказ про то, как мы DWH строим: от реплик MySQL до Exasol + ClickHouse

Екатерина Колпакова

Екатерина КолпаковаСитимобил

Екатерина — опытный спикер и дата-инженер, она разрабатывала DWH в Tinkoff и Mail.Ru Group, а сейчас руководит направлением DWH в Ситимобиле. Преподаватель открытого курса «Проектирование хранилищ больших объемов данных» в Технопарке Mail.Ru.

Ее доклад затрагивает две большие темы: эволюцию хранилища и собственно систему с автоматической генерацией ETL, которая была построена в Ситимобил.

Разработка — процесс творческий, но от рутинных и шаблонных задач никуда не деться. Они важны для продукта, но при этом отвлекают от совершенствование инфраструктуры BigData. Екатерина расскажет историю, как удалось снять скучные задачи с дата-инженеров и переложить все на автоматику. Это подняло дух разработчиков данных и позволило им заниматься интересными задачками.

Доклад будет интересен и разработчикам, и инженерам, и руководителям — многие идеи из него можно переиспользовать.

An experience report on strategies for working with Cloud Storage

Tejas Chopra

Tejas ChopraNetflix

Теджас Чопра — старший инженер-программист, работающий в команде платформы хранения данных в Netflix. Отвечает за разработку решений для хранения данных для поддержки Netflix Studios и Netflix StreamingPlatform. Опытный спикер, проводит воркшопы и читает лекции.

Послушать сеньора из «Нетфликса» — это уже достаточный повод не пропустить это выступление!

Сегодня многие компании выбирают облачные решения и отказываются от локальных систем. Но вопросы безопасности и законы о персональных данных создают ограничения для абсолютной миграции в облако. Теджас расскажет, как в «Нетфликсе» сочетают облачные и локальные решения и используют преимущества обеих систем вместе. Почему в некоторых случаях облако является ведущим, а OnPremise ведомым, а почему в других случаях все наоборот.

Если у вас есть некоторый опыт работы с облаком или большое желание получить такой опыт, то доклад точно будет интересен.

How to bring advanced analytics to hybrid data storage with Vertica

Gianluigi Vigano

Gianluigi ViganoVertica

Maurizio Felici

Maurizio FeliciVertica

Marco Gessner

Marco GessnerVertica

Vertica — платформа для анализа больших данных (Big data) в реальном времени.

Разработчики этой платформы Джанлуиджи Вигано, Маурицио Феличи, Марко Гесснер расскажут о внутреннем устройстве и реализации новых фич на платформе. У спикеров большой опыт в разработке и участии в конференциях.

Какое-то время назад по всему миру начала распространяться микросервисная архитектура, и во многих компаниях каждый сервис имеет свою команду, свой бэкенд и свою базу данных. Такое распространение дошло и до инженерии данных и создало т.н. Data Mash. Не так важно, есть ли оно у вас или нет, но если у вас различные типы источников данных, то ваши пользователи могут захотеть писать запросы, обращаясь к некоторым из них одновременно. В докладе спикеры расскажут, как они реализовали подобное решение в Vertica.

Доклад будет интересен опытным дата-инженерам и архитекторам, всем тем, кто работает с Vertica или выбирает базу данных для своей DWH.

Как мы строим Feature store

Сергей Ярымов

Сергей ЯрымовМТС

Сергей — дата-инженер в МТС Big Data, до этого строил дата-пайплайны, а потом ETL-платформу в крупной IT-компании, в последнее время руководит созданием feature store — решений для управления фичами ML-моделей (ведение базы признаков, их хранение, мониторинг и аналитика). Хорошо понимает всё многообразие требований, он не только ориентируется в существующих доступных решениях, но и может на опыте собственной реализации давать им оценку.

Популярность feature store растет. Кажется, эффективным будет использовать «стандартное» решение. Но какое? Существует несколько как опенсорсных, так и платных реализаций, каждая со своими особенностями. И, как обычно, нет такой, которая точно подходит всем.

В докладе будут затронуты все нюансы, которые помогут либо сделать правильный выбор, либо как минимум лучше понять, чего вам не хватает, а что вы уже делаете правильно.

Будет полезно всем, у кого используются и эволюционируют ML-модели, и кто хочет навести порядок в зоопарке признаков.

Optimizing test data coverage in functional testing

Ton Badal

Ton BadalSynthesized

Тон — инженер, увлеченный машинным обучением и искусственным интеллектом. До прихода в Synthesized работал в одном из банков Великобритании, где оптимизировал процесс принятия решений за счет использования данных.

Данные являются важным элементом для разработки и тестирования любого дата-ориентированного приложения, но доступ к ним может быть ограничен. Тон расскажет, как получить более быстрый и безопасный доступ к данным для тестирования путем создания частных данных, которые имитируют состояние набора данных и увеличивают охват тестированием.

Это достаточно редкая тема, так как про оптимизацию покрытия данными мало кто говорит. Тон расскажет, какое решение было разработано им в Synthesized. Так что если вы заинтересованы в том, чтобы улучшить качество покрытия своих пайплайнов тестами, то этот доклад для вас.

Как устроена поставка данных в Яндексе и почему мы больше не боимся перекладывать JSON’ы

Андрей Терехов

Андрей ТереховЯндекс

Андрей — инженер с более чем десятилетним стажем в IT. Последние 4 года занимается распределенными системами, в частности системами поставки данных. Он постепенно объединил разрозненные системы поставки данных в единый сервис кросс-системной поставки данных — Yandex DataTransfer. Этим сервисом уже пользуются сотни команд, постоянно перекачивая десятки гигабайт данных в секунду. Некоторое время назад он стал доступен и пользователям Яндекс.Облака.

Есть вам интересна работа распределенных систем поставки больших данных и подробности работы востребованного инструмента, то не пропустите этот доклад.

Сценарии использования

Цикл жизни ML-моделей в Cherry Labs

Кирилл Рыбачук

Кирилл РыбачукCherry Labs

Кирилл в индустрии машинного обучения восемь лет, четыре из них — в разработке систем компьютерного зрения в Cherry Labs. Интересуется созданием пайплайнов ML, оптимизацией моделей, автоматизацией и гибкостью инструментов для нужд разработки и исследований. А еще он умеет увлеченно и занимательно рассказывать о том, что ему интересно —, а своим делом он очень горит и хочет поделиться со слушателями лучшими практиками.

Кирилл расскажет о специфике MLOps в области компьютерного зрения, о роли системы human-in-the-loop в мониторинге и выявлении проблем в продакшене, о построении процесса разметки данных, об автоматизации всех шагов — от подготовки данных до сервинга модели с помощью ClearML и S3.

В докладе вы услышите захватывающую историю про подход к моделям машинного обучения.

Каталог и озеро данных на базе MongoDB, собираем технологический стек по кусочкам

Иван Бегтин

Иван БегтинОДСС/Инфокультура

Николай создавал государственные, частные и общественные информационные системы и IT-продукты, занимается популяризацией открытости данных, с целью чего основал НКО «Инфокультура», развивает стартап APICrafter/DataCrafter по созданию каталогов и озер данных, в первую очередь на открытых данных.

Иметь дело с неструктурированными данными приходится довольно часто, поэтому всегда полезно узнать, как подобные задачи решают другие. Иван разработал собственное решение и регулярно использовал MongoDB для похожих задач много раз, и в докладе он поделится своим опытом.

Доклад будет полезен дата-инженерам, дата-аналитикам, разработчикам решений на данных, архитекторам решений на данных. Всем тем, кто работает с MongoDB и хочет получить преимущества хранилища как центрального инфраструктурного компонента, но не хочет вводить новую технологию.

Greenplum и Anchor modeling: Как мечты разбиваются о реальность

Николай Гребенщиков

Николай ГребенщиковЯндекс Go

Евгений Ермаков

Евгений ЕрмаковЯндекс Go

Евгений — архитектор хранилищ данных и систем анализа в Mail.ru Group и Яндекс.Go. Кандидат технических наук, автор более 10 работ в области анализа данных, соавтор монографии по теории и практике анализа параллельных баз данных.

Николай — развивает хранилище данных в Яндекс Go и специализируется непосредственно на MPP СУБД Greenplum.

Ребята выступали на SmartData 2020 и вернулись, чтобы рассказать, чем закончилась история с акторным моделированием в их DWH. Удалось ли (или нет?) натянуть его на Greenplum.

Истории успеха любят все, а вот истории неуспеха любят еще больше. Зрители SmartData 2021 увидят доклад про Anchor+GP первыми и узнают, как архитектуры встраиваются в реальность.

Вставить в ClickHouse и не умереть

Артем Шутак

Артем ШутакMailRu Group / OK.RU

Перфоманс вставки в хранилище — тема для дата-инженеров животрепещущая. Казалось бы, что может быть проще, чем вставить данные в БД? В Mail.ru это делают 2 года и ClickHouse не перестает удивлять.

Артем — ведущий разработчик в Mail.ru Group/OK.RU, специализируется на обработке и анализе больших данных. В формате Tips & Tricks он расскажет — и достаточно глубоко разберет тему! — какие проблемы возникали в процессе реализации решения и как команда справлялась с ними. Артем full-time контрибьютер в Apache Ignite, поэтому как никто другой хорошо знает, как распределенные системы работают изнутри.

Этот доклад для инженеров и архитекторов, как планирующих интегрировать ClickHouse в свою экосистему, так и тех, кто уже работает с ним, но не полностью доволен текущим положением дел.

Self-service BI: практика построения модели данных

Николай Валиотти

Николай ВалиоттиValiotti Analytics (valiotti.com)

Николай Валиотти — глава компании Valiotti Analytics, где осуществляет аналитический консалтинг для мобильных и digital-старапов. До этого строил аналитику в сети «Лента», отвечал за аналитические процессы в Yota, занимался прогнозированием в «Балтике», руководил отделом аналитики, а затем департаментом маркетинга в Юлмарте. В индустрии анализа более 10 лет.

В докладе будут рассмотрены ключевые решения self-service BI, которые на сегодняшний день известны и доступны на рынке, разобран прикладной кейс построения модели данных для Self-service на примере датасета магазина электронной коммерции.

А в финале доклада ждет самое интересное — презентация инструмента для self-service. Николай — разработчик SaaS на базе Looker, это редкий инструмент, и он нем обычно говорят очень мало.

Hadoop 3: Erasure coding catastrophe

Денис Ефаров

Денис ЕфаровMail.ru Group

Денис — ведущий разработчик в Mail.ru Group, а с Hadoop работает с 2013 года. С 2018 года занимается проектированием и разработкой платформы для хранения и обработки статистических данных для «Одноклассников».

Вас ждет интересная и занимательная история, как баг в реализации erasure coding в Hadoop смог пережить все этапы тестирования в крупной компании и вылезти через полгода использования. Тогда данные превратились в тыкву. А что такое исчезновение 100 Pb данных? Это очень и очень больно! Как команда выкрутилась из этой ситуации, а главное, как вам не повторить таких ошибок? Обо всем это расскажет Денис.

Если у вас на стеке есть Hadoop, и вы любите интересные, а главное поучительные истории, то приходите.

От одной большой ETL-джобы до процес