Nvidia создала нейросеть, которая преобразует двухмерные объекты в трехмерные

Nvidia создала AI-систему DIB-R (differentiable interpolation-based renderer), которая построена на основе ML-фреймворка PyTorch. Система способна преобразовывать двухмерные изображения в трехмерные объекты.

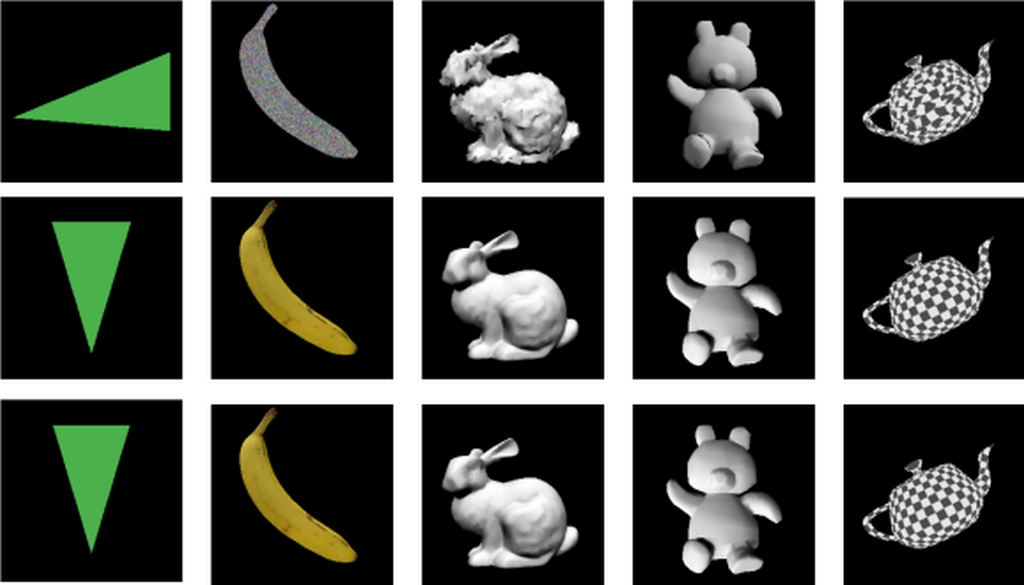

DIB-R обрабатывает картинку, а затем преобразует ее в высокоточную 3D-модель. Учитываются формы, текстура, цвета и освещение объекта. При этом задействована архитектура кодера-декодера, типа нейронной сети, которая преобразует входные данные в вектор, используемый для прогнозирования конкретной информации.

Вся работа занимает менее чем 100 миллисекунд.

Однако на тренировку самой системы уходит двое суток на одном GPU Nvidia V100.По мнению разработчиков, при использовании GPU этот процесс может растянуться на недели.

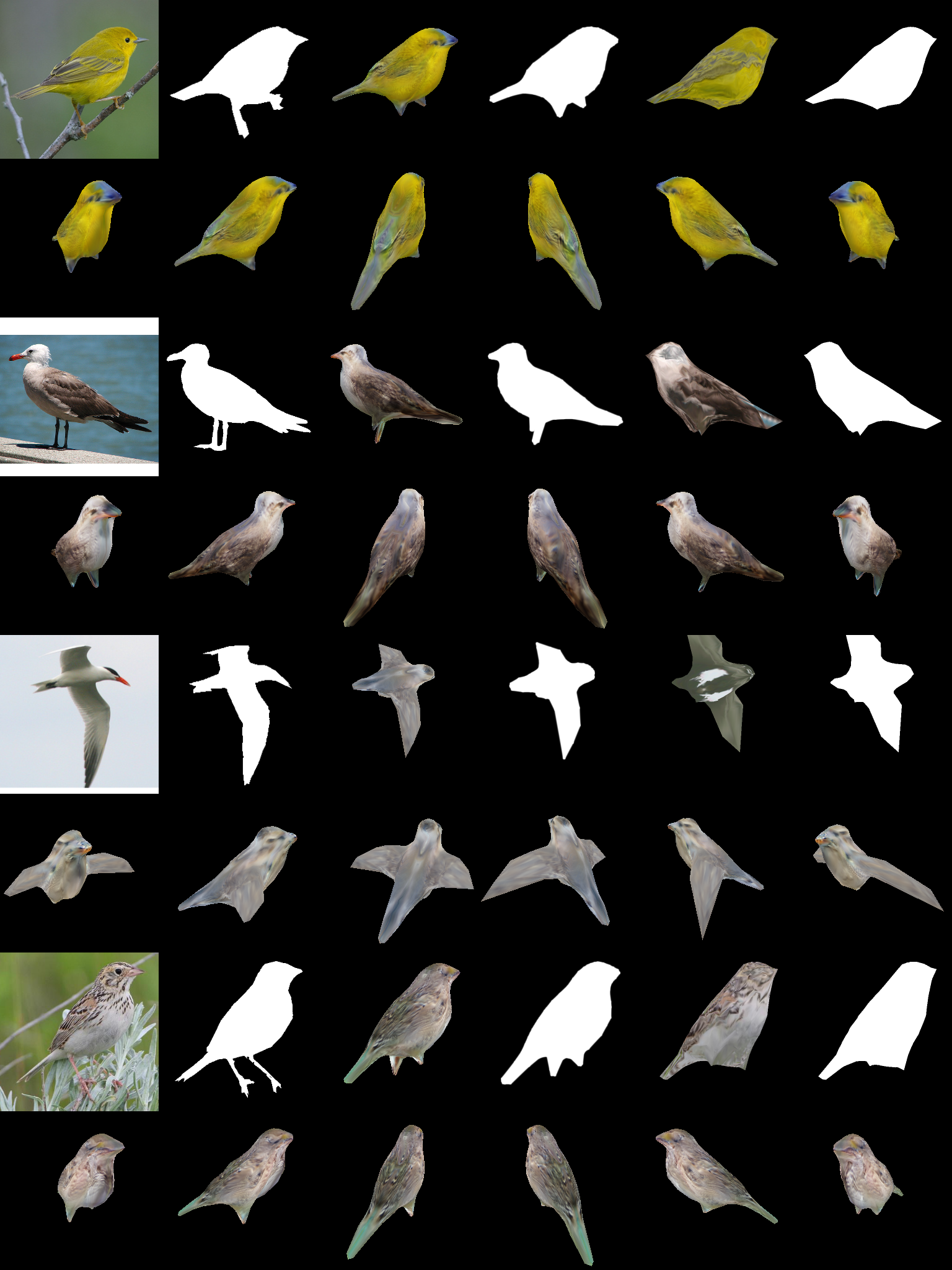

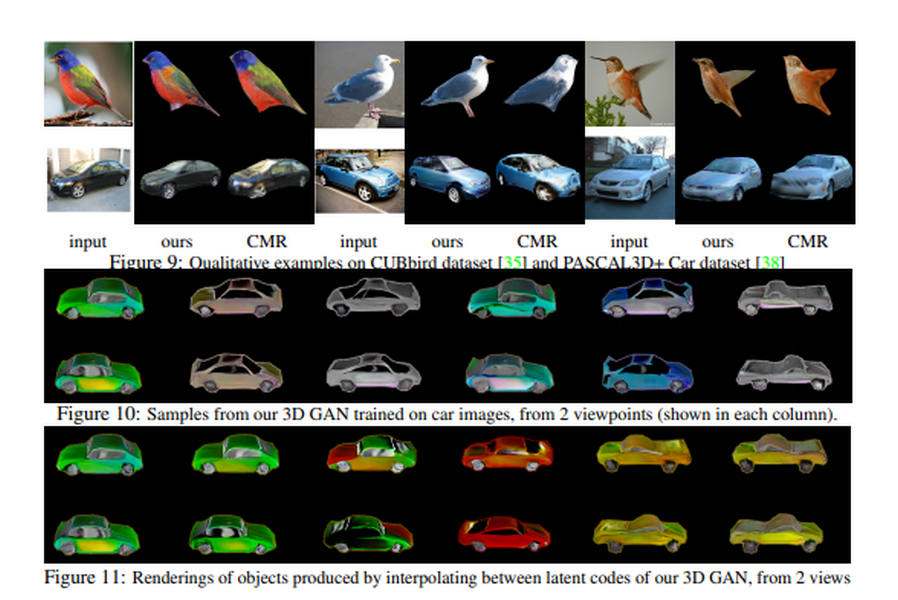

AI-системе показали несколько датасетов с изображениями птиц. DIB-R смогла создать качественные модели по одной 2D-картинке.

Система «видит» двухмерное изображение и делает выводы на основе трехмерного «понимания» мира. Это похоже на то, как люди переводят двухмерный видимый объект в трехмерный мысленный образ.

В Nvidia полагают, что система поможет автономным роботам с восприятием глубины и повысит их точность и безопасность. Также она улучшит ориентацию на местности и умение манипулировать предметами. Фреймворк DIB-R интегрирован в разработанную Nvidia PyTorch-библиотеку Kaolin.

Санья Фидлер, директор AI в Nvidia, заявила: «Представьте, что вы можете просто сделать фотографию, и у вас появится 3D-модель, а это значит, что вы можете теперь смотреть на ту сцену, где сделали снимок со всех видов точек обзора… Такие инструменты, как Google Maps, могут стать более захватывающими, чем когда-либо. И, возможно, креативщики, более опытные в фотографии или живописи, чем в кодировании и разработке, могут оставить всю тяжелую разработку для машин».

Ранее Google презентовала «объяснимый» ИИ (Explainable AI). Его алгоритм расширен для улучшения интерпретируемости пользователями с помощью специальных модулей-пояснений. Пояснения количественно определяют вклад каждого элемента данных в выходные данные модели машинного обучения. Используя эти модули можно понять, почему модель приняла определенные решения, также эту информацию можно использовать для дальнейшей адаптации моделей машинного обучения.

Теперь компания ведет исследование в рамках разработки объяснимого ИИ. Оно касается изучения функций, которые позволяют AI сделать тот или иной прогноз. Разработка видит одной из проблем то, что по мере разрастания системы становится все труднее увидеть точные причины конкретных прогнозов. Таким образом, одной из задач разработки объяснимого ИИ Google считает представление работы этой системы в форме, которая будет понятна.