Nvidia представила решение для ChatGPT — ускоритель Hopper H100 NVL с 188 ГБ памяти на базе двух H100

Источник: Nvidia

Nvidia представила новое решение, разработанное под ChatGPT и аналогичные массивные языковые модели — ускоритель Hopper H100 NVL. Он представляет собой пару ускорителей H100, объединённых интерфейсом NVLink. Как указывает Nvidia, ускоритель идеально подходит для масштабного развёртывания массивных языковых моделей по типу ChatGPT, обеспечивая производительность при работе с GPT-3 в 12 раз по сравнению с предыдущим поколением A100.

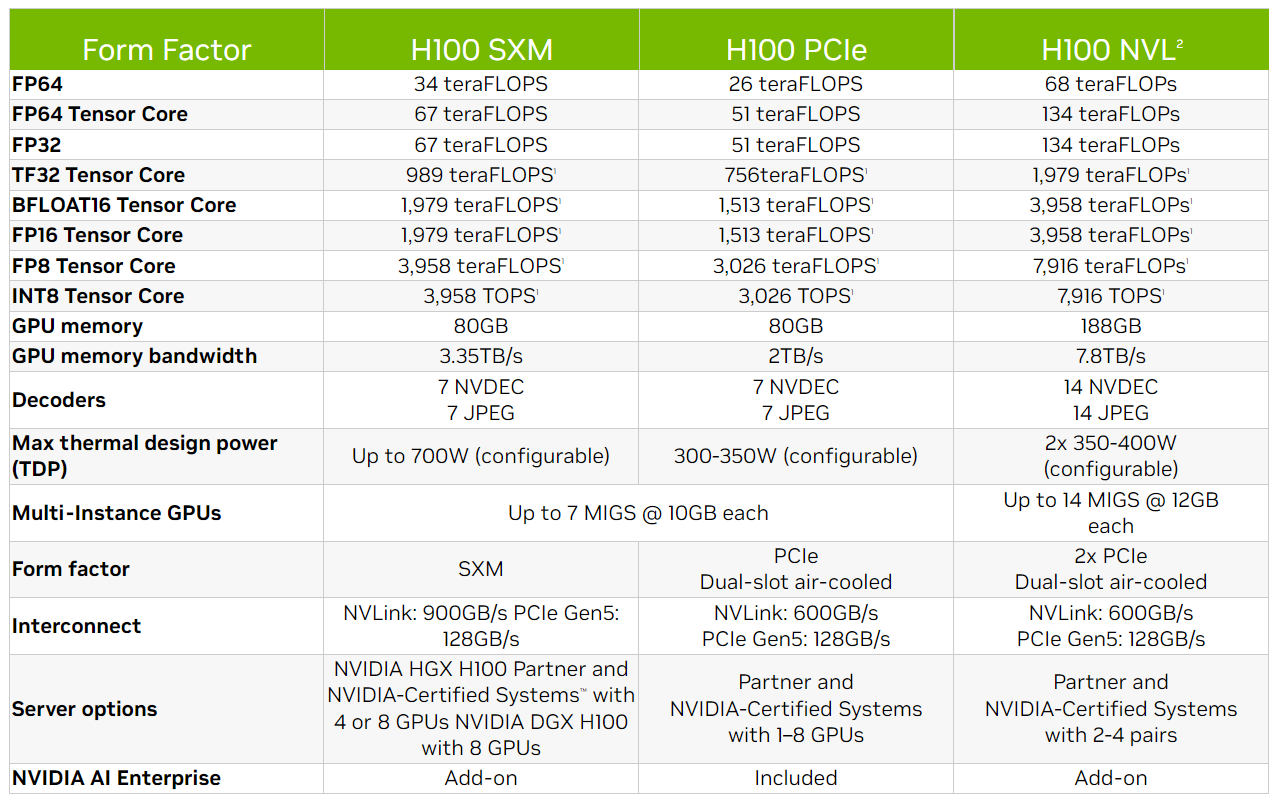

H100 NVL использует все шесть стеков памяти HBM3, обеспечивая в общей сложности 188 ГБ памяти против 80 ГБ у предшественника. Также Nvidia заявила о пропускной способности до 7,8 Тб/сек и производительности 68 TFLOPS (FP64), 134 TFLOPS (Tensor Core FP64) и 7916 TOPS (IN8). Ниже приведена сравнительная таблица H100 NVL и H100 (в SXM и PCIe).

Nvidia не предоставила дополнительных подробностей об ускорителе. Компания планирует запустить его во второй половине 2023 года.