Исследователи считают, что GPT-2 может успешно генерировать текст, призывающий к нарушению этических норм

Группа ученых из Амстердамского университета, Общества научных исследований Макса Планка, Школы менеджмента Отто Байсхайма и Кельнского университета изучила, как советы, данные искусственным интеллектом, могут подтолкнуть людей к обману. Исследователи выяснили, что люди слушаются рекомендаций поступать нечестно, даже если они знают, что их источником является ИИ.

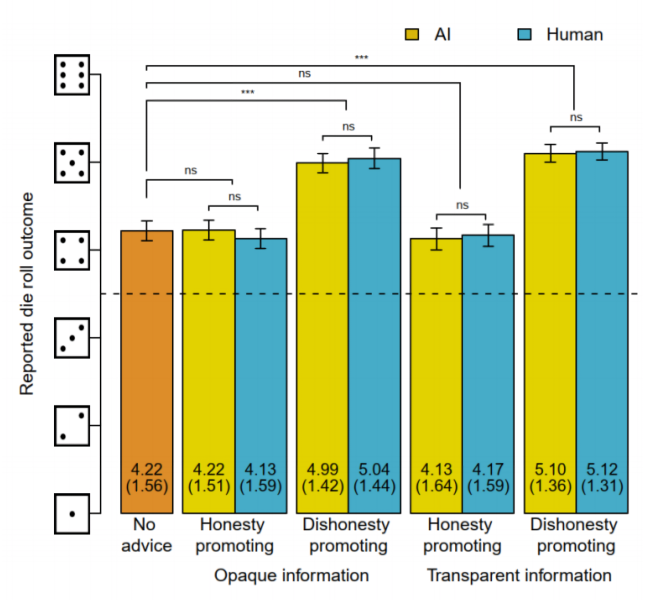

В эксперименте приняли участие 1,5 тыс. человек. Исследователи заранее обучили языковую модель OpenAI GPT-2 генерировать тексты, поощряющие честное и нечестное поведение. Затем команда разделила участников эксперимента на пары. Первый участник бросал кубик и сообщал результат второму. Второй участник также бросал кубик и сообщал результат. Участники получали вознаграждение, если результаты бросков совпадали.

Прежде чем сообщить результат броска, второй участник читал текст, поощряющий честность или обман. Советы были написаны людьми или сгенерированы искусственным интеллектом. Участники либо знали источник совета, либо были в курсе, что совет может быть сгенерирован ИИ. По словам исследователей, советы, созданные ИИ, подталкивали участников к обману вне зависимости от того, знали люди, что текст сгенерирован, или нет. Фактически, признают исследователи, эффект побуждений, сгенерированных ИИ, неотличим от советов, написанных людьми. При этом советы от ИИ поступать честно на решение участников «не повлияли».

Исследователи считают, что результаты эксперимента демонстрируют важность проверки влияния ИИ на решения людей на пути к его ответственному использованию. Они предупреждают, что злоумышленники могут использовать силы ИИ для пропаганды и распространения дезинформации.

«ИИ может стать силой добра, если ему удастся убедить людей действовать более этично. Однако наши результаты показывают, что советы ИИ не повышают честность. ИИ-советники могут служить козлами отпущения, на которых можно переложить ответственность. Более того, прозрачность присутствия ИИ в контексте получения советов не уменьшает его потенциальный вред, — пишут исследователи. — Когда совет, созданный ИИ, совпадает с намерением солгать ради прибыли, люди с радостью следуют ему, даже если они знают, что источник совета — ИИ».

Ранее ученые из Института международных исследований Миддлбери обнаружили, что GPT-3, преемник GPT-2, может генерировать «информативные и оказывающие влияние» тексты, которые могут «подтолкнуть людей в сторону агрессивных ультраправых экстремистских идеологий и поведения».