Hey, Google: умные устройства будут активироваться без команд

Photo by Cristian Cristian on Unsplash

В ближайшем будущем активировать голосовую колонку Amazon Echo или Nest Audio, поиск в Google или Siri на устройствах от Apple можно будет без приветствия вроде «Hello, Google!» При помощи ИИ ученые из США разработали алгоритм, благодаря которому умные голосовые помощники понимают, что человек обращается к ним.

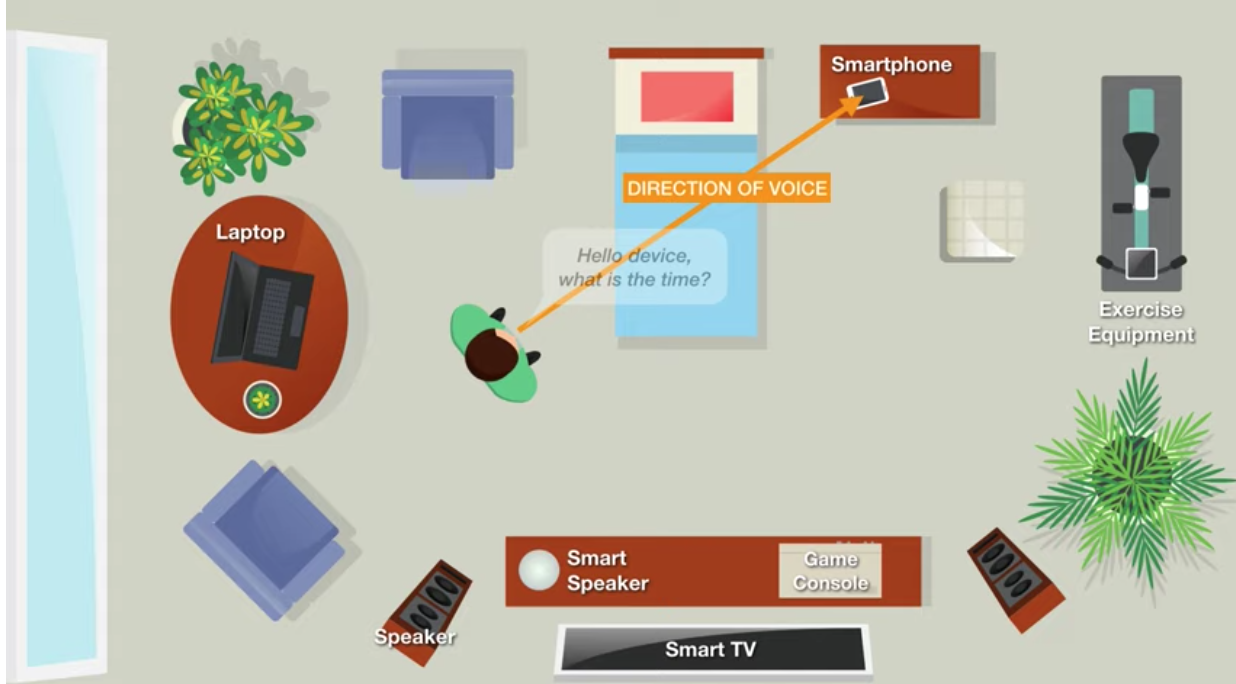

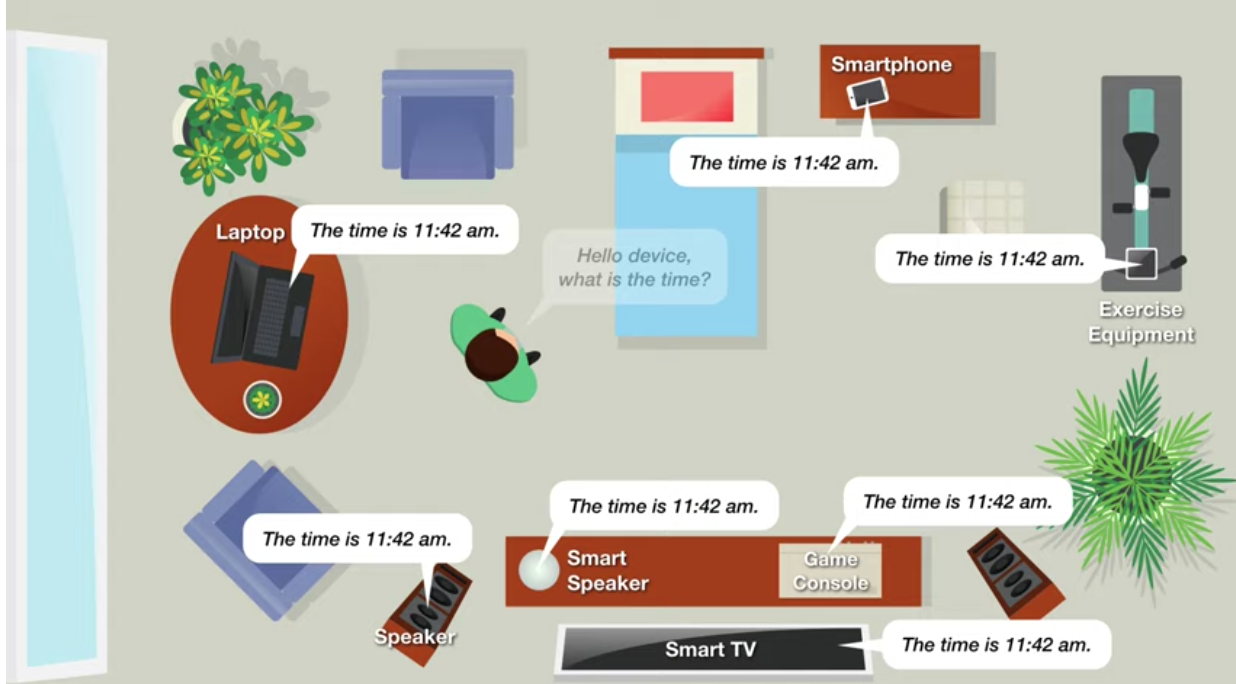

В обычной беседе люди обозначают адресата сообщения, просто посмотрев на него. А вот большинство голосовых устройств заточены под активацию ключевыми фразами, которые в реальном общении никто не произносит. Понимание голосовыми помощниками невербальных сигналов упростило бы коммуникацию и сделало более интуитивной. Особенно, если таких устройств в доме несколько.

Ученые из Университета Карнеги — Меллона отмечают, что разработанный алгоритм определяет направление речи (direction of voice, DoV) с помощью микрофона.

DoV отличается от выявления направления, откуда исходит голос (direction of arrival, DoA).

По мнению исследователей, применение DoV делает возможным адресные команды, что напоминает зрительный контакт собеседников при начале разговора. Однако камеры устройств при этом не задействованы. Таким образом, выходит естественное взаимодействие с разными типами устройств без путаницыи.

Помимо прочего, технология уменьшит количество случайных активаций голосовых помощников, которые все время находятся в режиме ожидания.

В основе новой аудиотехнологии — особенности распространения звука речи. Если голос направлен в микрофон, то в нем преобладают низкие и высокие частоты. Если голос отражен, то есть изначально направлен на другое устройство, то будет заметно снижение высоких частот по сравнению с низкими.

Алгоритм также анализирует распространение звука в первые 10 миллисекунд. Здесь возможны два сценария:

Пользователь повернут к микрофону. Сигнал, который первым придет к микрофону, будет четким по сравнению с возможными другими, отраженными от иных устройств в доме.

Пользователь отвернут от микрофона. Все колебания звука будут дублироваться и искажаться.

Алгоритм замеряет форму сигнала, вычисляет пик его интенсивности, сравнивает со средним значением и определяет, был направлен голос к микрофону или нет.

Измеряя распространение голоса, ученые смогли с точностью до 93,1% определить, находится ли спикер перед конкретным микрофоном или нет. Они отметили, что на сегодня это лучший подобный результат и важный шаг на пути к внедрению решения в существующие устройства. При попытке определения одного из восьми углов, под которым человек смотрит на девайс, достигнута точность в 65,4%. Этого пока недостаточно для приложения, суть которого в активном взаимодействии с пользователями.

Для сбора информации инженеры использовали Python, сигналы обрабатывались на основе алгоритма-классификатора Extra-Trees.

Собранные во время разработки данные и алгоритм открыты в GitHub. Их можно применить при создании собственного голосового помощника.