Google разрабатывает функции, которые объяснят прогнозы ИИ

Google представила исследование в рамках разработки объяснимого ИИ для своей облачной платформы. Оно касается изучения функций, которые позволяют AI сделать тот или иной прогноз.

Отмечается, что искусственные нейронные сети, которые используются многими современными системами машинного обучения и искусственного интеллекта, в некоторой степени моделируются биологическим мозгом. Одна из их проблем заключается в том, что по мере разрастания системы становится все труднее увидеть точные причины конкретных прогнозов. В Google расценили это явление как «потерю отладки и прозрачности».

Проблема может приводить к серьезным последствиям, так как она помогает скрывать ложные корреляции, когда система выбирает неактуальную или непреднамеренную функцию в данных обучения. Это также затрудняет исправление предвзятости ИИ, когда прогнозы делаются на основе этически неприемлемых особенностей.

Одной из задач разработки объяснимого ИИ Google видит в том, чтобы представить работу этой системы в форме, которая будет понятна.

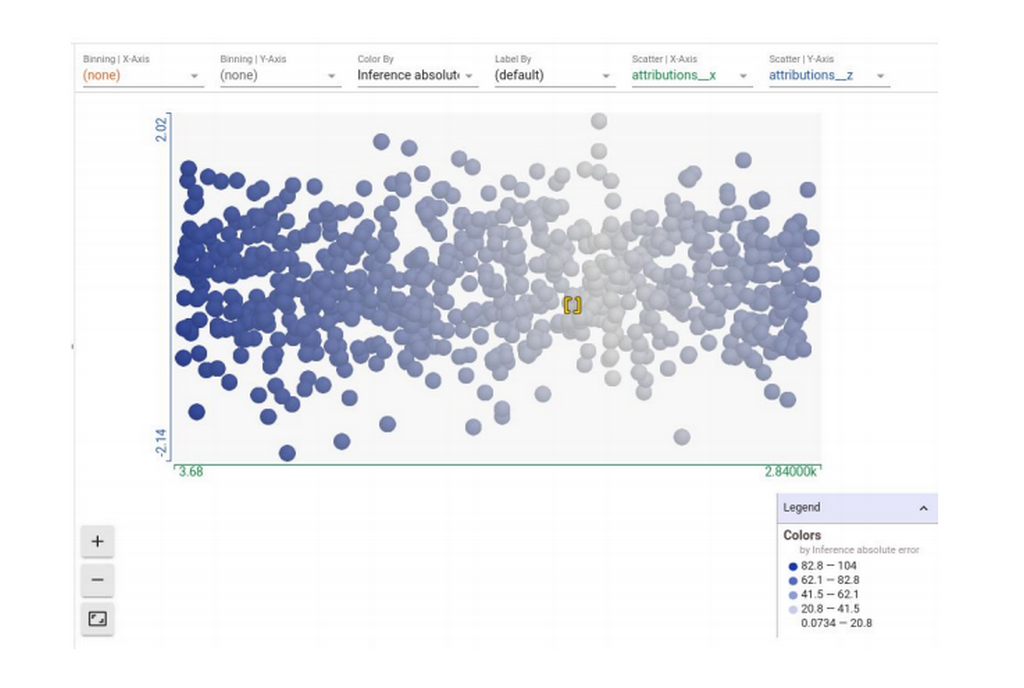

Компания разработала набор из трех инструментов под названием «Объяснение ИИ». Первый предлагает объяснения ИИ, в которых перечислены функции, обнаруженные им, а также показатель атрибуции, демонстрирующий, насколько каждая функция влияла на прогноз. Так, в одном из примеров нейронная сеть предсказывает продолжительность поездки на велосипеде на основе данных о погоде и информации о предыдущей поездке. Инструмент уже показывает такие факторы, как температура, день недели и время начала пути и рассчитывает их влияние на прогноз. На рисунке показано, какие элементы стали основными факторами при прогнозе.

Второй инструмент «Что, если» позволяет тестировать производительность модели, если происходит манипуляция с отдельными атрибутами. Третий инструмент непрерывной оценки передает результаты выборки рецензентам по расписанию, чтобы помочь контролировать результаты.

Главный исследователь Google по искусственному интеллекту и машинному обучению доктор Эндрю Мур заявил на мероприятии в Лондоне, что «около пяти или шести лет назад академическое сообщество начало беспокоиться о непредвиденных последствиях работы ИИ».

Мур подчеркнул, что компания проявляет осторожность в отношении систем распознавания лиц: «Мы приняли взвешенное решение, поскольку у нас есть мощная технология распознавания лиц, чтобы не запускать общее распознавание лиц в качестве API, а вместо этого упаковывать его в продукты, где мы можем быть уверены, что оно будет использовано по назначению».

По мнению Мура, успешный ИИ должен быть объяснимым: «Если у вас есть система безопасности или важная для общества вещь, которая может иметь непредвиденные последствия, если вы считаете, что ваша модель допустила ошибку, вы должны быть в состоянии ее диагностировать».

Специалист привел в пример работу по классификации рентгеновских снимков грудной клетки. Когда модель ИИ, диагностирующую рак легких, спросили, почему именно этот прогноз верный, выяснилось, что в обучающем наборе на положительных примерах врач оставил на слайде пометку, означающую, по его мнению, опухоль. В итоге алгоритм использовал эту отметку в качестве основной функции прогнозирования. В итоге запуск данной системы решили откатить.

По мнению Мура, инструменты, помогающие обеспечить ответственный ИИ — это еще более сложная задача, чем применение ответственного ИИ.

В конце ноября на мероприятии в Лондоне подразделение облачных вычислений Google представило «объяснимый» ИИ (Explainable AI).

Алгоритм ИИ от Google расширили для улучшения его объяснимости для пользователей. Это реализовано с помощью специальных модулей-пояснений. Пояснения количественно определяют вклад каждого элемента данных в выходные данные модели машинного обучения. Используя эти модули, можно понять, почему модель приняла определенные решения.

См. также: «Новый подход к пониманию мышления машин»

Однако модули-пояснения раскрывают принцип работы моделей машинного обучения, полученных на основе исходных данных, но с их помощью нельзя понять о существовании каких-либо фундаментальных связей в конечной выборке данных.