Эксперты из Китая и США научились манипулировать автопилотом Tesla

Работу автопилота и сенсоров можно намеренно нарушить при помощи специального оборудования

В США еще идет разбирательство по делу аварии Tesla Model S со смертельным исходом в мае этого года. Тогда идущий с превышением скорости электромобиль врезался в прицеп грузовика. Ни водитель, ни автопилот не увидели препятствие на фоне яркого неба. У экспертов по информационной безопасности возник вопрос —, а что, если попробовать воспроизвести схожие условия искусственно? Получится ли обмануть сенсоры машины и саму компьютерную систему?

Объединенная команда исследователей Университета Южной Каролины (США), Чжэцзянского университета (Китай) и китайской компании Qihoo 360, работающей в сфере компьютерной безопасности, смогла научиться манипулировать автопилотом Tesla Model S. Для этого исследователи работали с оборудованием разного типа: излучающего радиоволны, звуковые сигналы и свет. В некоторых случаях автопилот Tesla начинал «верить», что впереди препятствий нет, хотя они были, и наоборот — что впереди есть объект, с которым можно столкнуться, хотя перед автомобилем ничего не было.

Как оказалось, для того, чтобы обмануть компьютерную систему управления Tesla Model S, нужно приложить значительные усилия. Целью команды ученых было доказать, что условия, которые привели к аварии в мае, можно воспроизвести намеренно. «Худший вариант развития событий для автомобиля, едущего под управлением Autopilot — это неработающий радар. В этом случае машина не сможет определять наличие препятствий впереди», — говорит один из представителей команды ученых, проводивших исследования.

Autopilot, работающий в электромобилях Tesla, определяет наличие препятствий при помощи трех основных способов: радара, ультразвуковых сенсоров и камер. Исследователи атаковали все три типа систем. В результате удалось определить, что лучше всего поддается «обману» именно радар. Для искажения его показаний исследователи использовали две системы. Первая — это генератор сигналов от Keysight Technologies стоимостью в $90 000. Вторая — VDI умножитель частоты, цена которого еще выше. Обе системы использовались для глушения сигнала, излучаемого радарной системой электромобиля. Когда специалисты глушили сигнал, автомобиль, находившийся спереди Tesla Model S, пропадал для автопилота и более не отображался на дисплее.

Как только включался «антирадар», помеха спереди исчезала. По мнению авторов работы, такой метод может применяться на трассе злоумышленниками, которые по той либо иной причине могут захотеть устроить аварию с участием электромобиля Tesla. Ученые говорят, что для удачной атаки на радарную систему Tesla необходимо правильно установить глушитель, что на дороге не так-то просто сделать.

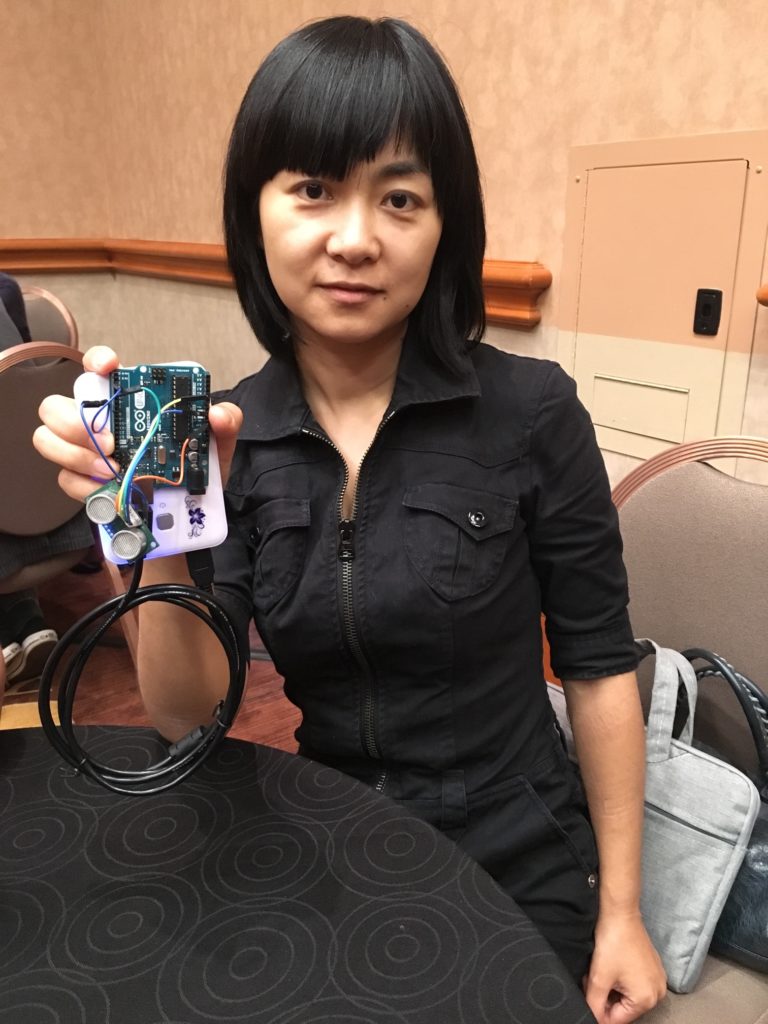

Более простой и дешевой атакой является ультразвуковая система, при помощи которой специалисты решили воздействовать на ультразвуковые сенсоры машины. Они обычно используются для автоматической парковки и «призыва» машины к водителю. В этом режиме она может самостоятельно выехать из парковки и приблизиться к владельцу. Для обмана ультразвуковых сенсоров исследователи использовали ультразвуковой преобразователь и генератор сигналов на основе Arduino для создания электрических сигналов с определенными характеристиками. Такая система стоит существенно меньше — всего $40. В этом случае удалось обмануть систему автоматической парковки, и автомобиль не хотел парковаться, считая, что спереди есть препятствие. При помощи той же системы удалось «убедить» систему парковки в том, что спереди нет препятствия, хотя оно было.

Профессор компьютерных наук Веньянь Сюй (Wenyuan Xu) демонстрирует ультразвуковой девайс на основе Arduino Uno (Источник: Andy Greenberg)

Самый простой способ воздействовать на компьютерную систему управления Tesla — это нанести на сенсоры специальную звукопоглощающую пену.

На камеры ученые тоже пробовали воздействовать, но эта система оказалась наиболее надежной. Единственное, что удалось сделать — это ослепить систему направленным светодиодным лучом или лучом лазера. Но разработчики Tesla предусмотрели такой вариант, и Autopilot просто отключался, передавая управление водителю. Как выяснили эксперты, автопилот может быть ослеплен и ярким солнечным светом при определенном стечении обстоятельств. Возможно, именно такая ситуация возникла в мае.

В руководстве по эксплуатации электромобиля говорится, что Autopilot может не определить некоторые объекты. Говорится и о том, что технология «создана для удобства во время движения, но это не система ухода от препятствий или предупреждения столкновений».

По мнению некоторых сторонних специалистов, изучивших результаты описанной выше работы, следующим этапом исследования должна быть ситуация на дороге, а не в стационарных условиях. Для подтверждения эффективности способов воздействия на Autopilot и сенсоры электромобиля необходимо опробовать сделать то же самое в полевых условиях. «Они должны сделать немного больше, чтобы узнать, действительно ли автопилот позволит машине врезаться в препятствие. Вы мне можете сказать до этого момента, работает автопилот или нет», — говорит Джонатан Петит, представитель Университета Корка (Jonathan Petit).

Авторы исследования считают, что Autopilot и сенсоры подвержены воздействию извне и уязвимы, хотя использовать эту уязвимость не так и просто. По мнению ученых, компания Tesla должна защитить свои электромобили от злоумышленников, которые могут попытаться нарушить нормальную работу компьютерной системы машины. «Если уровень шума очень высокий, или обнаружены какие-то отклонения, радар должен уведомить управляющую систему о возможном сбое», — говорит один из исследователей.

Пока что, признают ученые, методы, использованные ими не слишком практичны — их использовать и сложно, и дорого. Но с течением времени оборудование дешевеет, а методы работы злоумышленников усложняются и совершенствуются. И через некоторое время может оказаться, что кто-то научился обманывать компьютерную систему Tesla без использования систем ценой в $100 000.