Экскурсия по шведскому дата-центру Facebook недалеко от Полярного круга

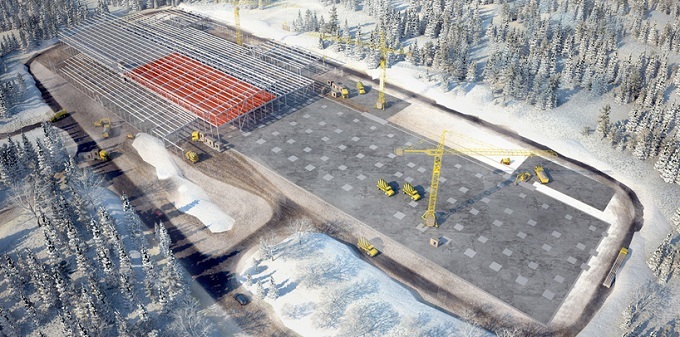

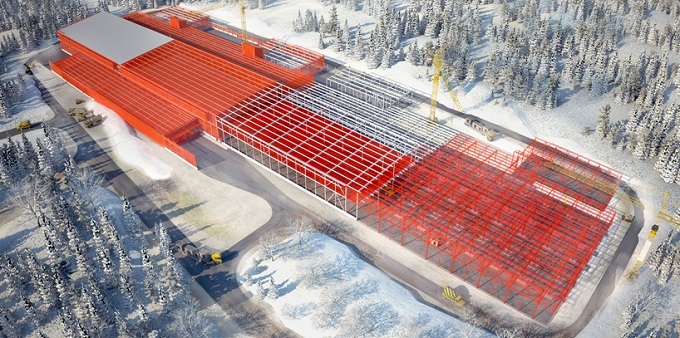

Чуть южнее Полярного круга, посреди леса на окраине шведского городка Лулео, находится серверная ферма — гипермаштабный дата-центр компании Facebook. Фасад гигантского здания обрамляют тысячи прямоугольных металлических панелей, при этом само оно выглядит как заправский космический корабль. Серверная ферма компании в Лулео огромна. Она имеет 300 метров в ширину и 100 метров в длину, что примерно соответствует размеру четырех футбольных полей.

Интересно, что проект Facebook по строительству кампуса ЦОД в Швеции в один момент оказался крайне близок к провалу. Один местный эколог заявил, что новый дата-центр может навредить птицам, включая редкого трехпалого шведского дятла, который гнездится рядом с кампусом. Но чиновники из муниципалитета Лулео отклонили возражение. Слишком уж привлекательным выглядел проект Facebook, предполагавший инвестирование сотен миллионов долларов в строительство и создание множества рабочих мест.

Серверная ферма Facebook является одной из самых энергоэффективных вычислительных объектов в человеческой истории. Около столетия назад Швеция начала строительство многочисленных гидроэлектростанций для организации электроснабжения своей сталелитейной и целлюлозно-бумажной промышленности. Такие ГЭС появились и в Лулео. Теперь они используются для запитки дата-центра Facebook, который, к слову, потребляет примерно столько же электроэнергии, как сталелитейный завод. По словам инженеров Facebook, целью компании является обеспечение электроснабжения своих дата-центров на 50% за счет экологически чистых и возобновляемых источников энергии к 2018 году. И шведский кампус существенно приблизил Facebook к этому уровню. На кампусе также расположились три мощных дизельных генератора квадратной формы, которые понадобятся в случае маловероятных перебоев в работе центральной электросети.

«К региональной электросети подключено так много ГЭС, что генераторы попросту не нужны», сказал Джей Парк, директор Facebook по развитию инфраструктуры. По словам Парка, при подключении подстанций к новому ЦОД инженеры Facebook использовали схему резервирования »2N», то есть электричество поступает из независимых сетей, используя различные маршруты. В первом случае используются подземные кабели, в то время как во втором — воздушные ЛЭП.

Серверная ферма помогает Facebook обрабатывать около 350 миллионов фотографий, 4,5 млрд. «лайков» и 10 млрд. сообщений в день. Строительство шведского дата-центра компания начала с целью повышения качества обслуживания европейских пользователей, которые генерируют все больше электронных данных. При этом сейчас есть высокая вероятность того, что если вы загрузите селфи в Лондоне или опубликуете обновление статуса в Париже, ваши данные будут храниться в Лулео. В обычном дата-центре на каждый ватт IT-нагрузки приходятся полтора-два ватта электромеханического оборудования и систем охлаждения, ЦОД Лулео работает в разы эффективнее: его коэффициент PUE равен 1.04.

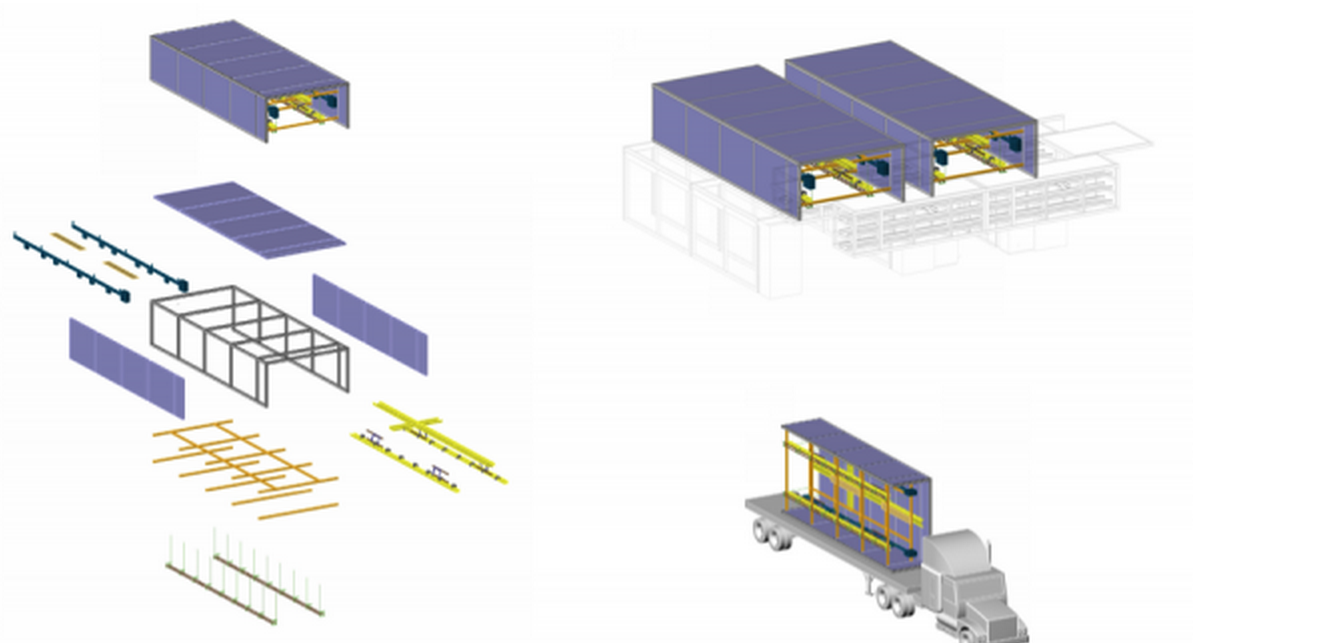

Концепция «Шасси»

Facebook возводил серверную ферму, повторяя концепцию «шасси». Воспользовавшись подсказками из разных индустрий, где широко применяется автоматизация и стандартизация производства, удалось сформировать виденье идеи и реализовать «шасси» — основу (в данном случае это стальная рама с ориентировочными габаритами 3.6 м на 12.2 м) и использовать сборочную линию для доставленных на место осуществления работ элементов.

Марко Магарелли инженер-дизайнер проекта возведения ЦОД для Facebook:

К элементам создания ДЦ также относят всю ту инфраструктуру, которая сопутствует серверным стойкам: кабельные лотки, прокладка силовых линий, устройство контрольно-измерительных узлов и освещение. Наше «шасси» уже поддерживает всю инфраструктуру, которая сопутствует серверным стойкам. В контейнерных решениях помимо самого оборудования приходится транспортировать также «воздух», находящийся в контейнере. В данной же идее транспортируется исключительно базовая конструкция, которая размещается над серверными стойками и уже готова к подключению коммуникаций.

После сборки шасси загружают в кузов и транспортируют непосредственно к самой серверной ферме. В самом же сооружении доставленную сборку монтируют на подготовленные бетонные столбы.

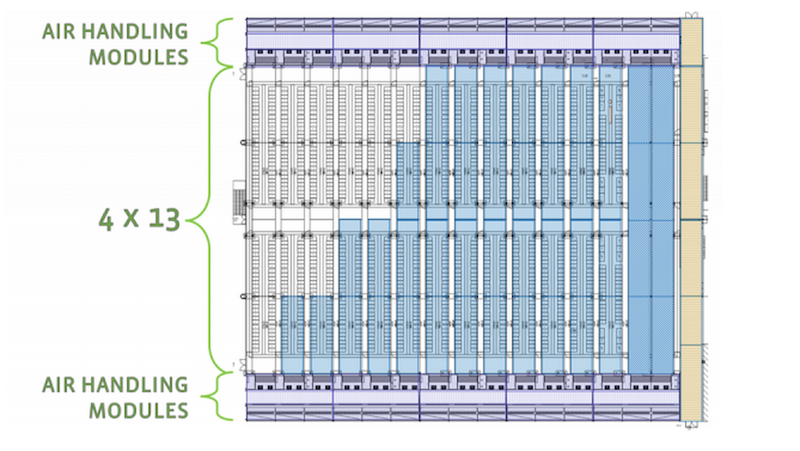

Два соединенных шасси образуют 18-метровый проход. Обычный машинный зал ЦОД будет вмещать в себя 52 шасси, образуя тем самым 13 коридоров, предназначенных в том числе и для охлаждения серверных сборок.

Высокие показатели эффективности и экологичности ЦОД обусловлены его расположением. В распоряжении шведских операторов дешевая электроэнергия, генерируемая надежными гидроэлектростанциями, а также холодный климат, который IT-специалисты могут обернуть в свою пользу. Это обусловлено среди прочего и низкими температурами в регионе (в зимнее время столбик термометра держится в среднем около отметки в -20 C). Инженеры Facebook вместо того, чтобы затрачивать средства на огромные энергозатратные кондиционеры для охлаждения десятков тысяч серверов в Лулео, используют наружный воздух, запуская его в машзалы ЦОД, после того как воздух проходит процес фильтрации, а также оптимизации температуры и влажности и этим охлаждают серверные системы. Новый дата-центр функционирует как один большой механизм.

Внутри длинные коридоры, многочисленные серверы с мигающими индикаторами и гул гигантских вентиляторов.

Удачное географическое место позволит восемь месяцев в году охлаждать этот северный ЦОД исключительно за счет наружного воздуха, что делает его дешевле в обслуживании в среднем на 40% по сравнению с аналогичным дата-центром в США. Немаловажным фактором для инвестиций Facebook также стало то, что для строительства своего дата-центра американская компания получила субсидии от Евросоюза в размере 10 миллионов фунтов, кроме того, именно здесь были предложены наименьшие цены на электричество среди всей Европы.

Инженеры Facebook упростили конструкцию серверов за счет отказа от использования ряда стандартных компонентов, таких как дополнительные слоты памяти, кабели и защитные пластиковые корпуса. Эти серверы, с ни чем не защищенными материнскими платами, размещаются внутри стандартной монтажной стойки размером с холодильник.

Специалисты уверенны, что подобная конструкция позволяет интенсифицировать воздушные потоки, проходящие через каждый сервер. Для эффективной работы подобных вычислительных систем требуется меньшая холодопроизводительность, ведь благодаря сократившемуся количеству компонентов они выделяют меньше тепловой энергии, чем стандартные аналоги. И кроме того, машины Facebook способны функционировать при повышенных температурах.

Когда инженеры Facebook начали выносить свои идеи на «публику», большинство экспертов в области ЦОД все же были настроены скептически, особенно касательно эксплуатации серверных систем при повышенных температурах. Но, как говорится, время расставило все на свои места. При этом дальнейшее улучшение инфраструктурных систем участниками инициативы Open Compute Project (помимо Facebook проект развивают многие производители аппаратного обеспечения и микрочипов, хостинг- и колокейшн-провайдеры, а также далекие от IT-сегмента банковские организации) позволило использовать их и вдалеке от заполярья. Следующий крупный дата-центр Facebook было решено построить в штате Айова (США), где умеренный климат. Как и в Швеции там более чем достаточно дешевой электроэнергии из возобновляемых источников (в Айове роль гидроэлектростанций выполняют ветряные фермы). Компания также начала разработку своих собственных систем хранения данных и сетевого оборудования.

HP оперативно отреагировала на инициативу соцсети, начав продажи микросервера под названием Moonshot, который лишен всего лишнего, комплектуется маломощными чипами и характеризуется высокой энергоэффективностью. Релиз Moonshot стал наиболее радикальным изменением линейки продуктов для серверных ферм, предпринятых американской компанией за последние годы. HP также работает над механизмами повышения энергоэффективности серверов за счет водяного охлаждения.

По мнению руководства сетевого гиганта, лишь немногие компании захотят иметь дело со столь специализированными системами, которые были разработаны в первую очередь для удовлетворения потребностей крупных интернет-компаний, владеющих гипермасштабными ЦОД. По словам пресс-секретаря Cisco Дэвида Маккалока, сетевой гигант не рассматривает новый тренд как угрозу для своего бизнеса. Шесть лет назад еще один крупный американский вендор Dell создал специальную команду инженеров, чтобы те разрабатывали вычислительные системы без «излишеств», которые приобретались интернет-компаниями. С тех пор доход Dell значительно вырос. Это говорит о том, что вендор избрал правильно направление развития своего бизнеса.

Если специализированное аппаратное обеспечение, разработанное в стенах веб-гигантов Google и Amazon, доступно лишь операторам ЦОД этих компаний, то открытость Facebook и желание соцсети делиться своими наработками стали причинами роста интереса в адрес ее дата-центров не только со стороны других интернет-компаний — наработками соцсети в области повышения эффективности ЦОД активно интересуются даже субъекты малого и среднего бизнеса. Facebook было создано пошаговую инструкцию по созданию гипермасштабной серверной фермы, воспользоваться которой может любая компания, обладающая достаточным количеством человеко-часов и денег.

топ-менеджер Facebook Фрэнком Франковскии

В состав совета директоров некоммерческой организации Open Compute Project Foundation, возглавляемого топ-менеджер Facebook Фрэнком Франковскии, вошли руководители таких грандов от мира высоких технологий и финансов как Intel и Goldman Sachs, соответственно. При этом многие крупные азиатские производители аппаратного обеспечения вроде Quanta Computer и Tyan Computer уже начали продавать серверные системы на основе спецификаций, созданных участниками Open Compute Project. Инициатива соцсети оказалась действительно популярной.

Кампус серверной фермы

По периметру кампуса ЦОД проложен длинный забор, который на самом деле возведен для того, чтобы помешать местным лосям попадать внутрь кампуса.

Внутри здания культура Швеции смешивается с американской. На входе можно увидеть красочные картины оленей, соседствующих с логотипом Facebook и часами, которые показывают время на других кампусах компании в американских штатах Северная Каролина, Айова и Орегон.

Большинство из полутора сотен сотрудников шведского кампуса являются местными жителями. Сотрудники добираются на работу на снегоходах и велосипедах, украшенных логотипом Facebook. Они также часто проводят время вместе, к примеру, устраивая, рыбалку на льду.