DeepMind создал систему ИИ, которая способна выполнять более 600 задач

DeepMind выпустила систему искусственного интеллекта «общего назначения», которую можно научить выполнять множество различных типов задач. Исследователи обучили систему под названием Gato выполнять 604 задания, в том числе добавлять подписи к изображениям, участвовать в диалогах, складывать блоки с помощью роборуки и играть в игры Atari.

Достижением в индустрии искусственного интеллекта является создание системы с искусственным общим интеллектом (AGI) или способностью понимать и изучать любую задачу, которую может выполнить человек. Предполагалось, что ОИИ создаст системы, способные рассуждать, планировать, учиться, представлять знания и общаться на естественном языке.

При развертывании Gato подсказка, такая как демонстрация, токенизируется, образуя начальную последовательность. Затем среда выдает первое наблюдение, которое также токенизируется и добавляется к последовательности. Система авторегрессивно выбирает вектор действия, по одному токену за раз.

При развертывании Gato подсказка, такая как демонстрация, токенизируется, образуя начальную последовательность. Затем среда выдает первое наблюдение, которое также токенизируется и добавляется к последовательности. Система авторегрессивно выбирает вектор действия, по одному токену за раз.

Джек Хессель, научный сотрудник Института искусственного интеллекта Аллена, отмечает, что единая система искусственного интеллекта, способная решать множество задач, не нова. Например, Google недавно начал использовать в своём поисковике многозадачную унифицированную модель или MUM, которая может обрабатывать текст, изображения и видео для выполнения разных задач — от поиска межъязыковых вариаций в написании слова и до соотнесения поискового запроса с изображением.

После того, как все маркеры, составляющие вектор действия, выбраны, действие декодируется и отправляется в среду, которая выполняет шаги и дает новое наблюдение. Затем процедура повторяется. Модель всегда видит все предыдущие наблюдения и действия в своем контекстном окне из 1024 токенов.

После того, как все маркеры, составляющие вектор действия, выбраны, действие декодируется и отправляется в среду, которая выполняет шаги и дает новое наблюдение. Затем процедура повторяется. Модель всегда видит все предыдущие наблюдения и действия в своем контекстном окне из 1024 токенов.

Однако Хессель отмечает разнообразие решаемых задач и методов обучения Gato. «Ранее мы видели доказательства того, что отдельные модели могут обрабатывать удивительно разнообразные наборы входных данных», — сказал он. — «На мой взгляд, основной вопрос, когда речь идет о многозадачном обучении, заключается в том, дополняют ли задачи друг друга или нет. Вы можете представить себе более скучный случай, если модель неявно разделяет задачи перед их решением, например: «Если я обнаружу задачу A в качестве входных данных, я буду использовать подсеть A. Если вместо этого я обнаружу задачу B, я буду использовать другую подсеть B». Аналогичные результаты можно было бы получить, тренируя A и B по отдельности, что не впечатляет. Напротив, если совместная тренировка А и В приводит к улучшению одного из них (или обоих!), тогда всё становится более захватывающим».

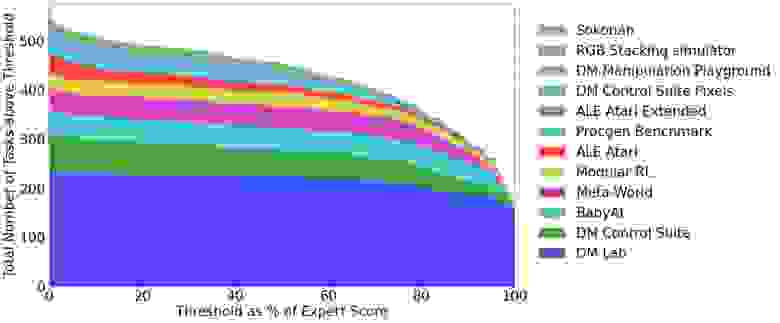

Gato обучается на большом количестве наборов данных, включающих опыт агентов как в смоделированных, так и в реальных средах. Здесь показано количество задач, в которых производительность предварительно обученной модели Гато превышает процент экспертной оценки.

Gato обучается на большом количестве наборов данных, включающих опыт агентов как в смоделированных, так и в реальных средах. Здесь показано количество задач, в которых производительность предварительно обученной модели Гато превышает процент экспертной оценки.

Gato учили на примерах миллиардов слов, изображений из реального мира и смоделированных сред. Система не всегда хорошо справляется с задачами. Например, при общении с человеком она часто отвечает поверхностно или даже неверно (например, называет Марсель столицей Франции). Подписывая фотографии, Gato неверно определяет пол людей. Система правильно укладывает блоки с помощью реального робота только в 60% случаев.

Предварительно обученная модель Gato подписывает изображения.

Предварительно обученная модель Gato подписывает изображения.

Но DeepMind утверждает, что в 450 из 604 вышеупомянутых задач Gato работает лучше, чем человек-эксперт, более чем в половине случаев.

«Если вы считаете, что нам нужны общие системы, а это много людей в области ИИ и машинного обучения, то Gato имеет большое значение», — Мэтью Гуздиал, доцент компьютерных наук в Университет Альберты. — «Я думаю, что люди, говорящие, что это важный шаг к ОИИ, несколько преувеличивают его, поскольку мы всё ещё не достигли уровня человеческого интеллекта и, вероятно, нескоро к этому придём. Однако у этих общих моделей определенно есть преимущества с точки зрения их производительности в задачах, выходящих за рамки их обучающих данных».

Любопытно, что с архитектурной точки зрения Gato не сильно отличается от многих современных систем искусственного интеллекта. Она имеет общие характеристики с GPT-3 OpenAI в том смысле, что это «трансформер». Начиная с 2017 года, трансформер стал предпочтительной архитектурой для сложных логических задач, демонстрируя способность суммировать документы, генерировать музыку, классифицировать объекты на изображениях и анализировать последовательности белков. Возможно, что еще более примечательно, Gato на несколько порядков меньше, чем отдельные системы. У Gato всего 1,2 млрд параметров, тогда как у GPT-3 — более 170 млрд.

Исследователи DeepMind намеренно сделали Gato маленькой системой, чтобы она могла управлять манипулятором робота в режиме реального времени. Но они предполагают, что при масштабировании система сможет справиться с любой «задачей, поведением и воплощением интереса».

Однако предстоит преодолеть несколько препятствий, чтобы сделать Gato лучше передовых однозадачных систем в конкретных задачах. Как и большинство систем на базе Transformer, знания Gato о мире основаны на обучающих данных и остаются неизменными. Таким образом, система не способна постоянно учиться. Также Gato имеет ограничение в своем «контекстном окне» или объеме информации, которую система может «запомнить» в контексте данной задачи. Даже самые лучшие языковые модели на основе Transformer не могут написать длинное эссе, а тем более книгу, не забывая при этом ключевые детали и, таким образом, не теряя из виду сюжет. Забывание происходит в любой задаче, будь то написание поэмы или управление роботом, и некоторые эксперты называют его «ахиллесовой пятой» машинного обучения.

Майк Кук, член исследовательского коллектива Knives & Paintbrushes, предостерегает от предположения, что Gato — это путь к действительно универсальному ИИ: «Звучит захватывающе, что ИИ может выполнять все эти задачи… Но на самом деле это не слишком отличается от понимания GPT-3 разницы между обычным английским текстом и кодом Python. Gato получает специальные обучающие данные об этих задачах, как и любой другой ИИ такого типа, и изучает, как закономерности в данных соотносятся друг с другом, в том числе учится связывать определенные виды входных данных с определенными выходными данными. Это нелегко, но и не означает, что ИИ также может заварить чашку чая или легко выучить еще десять или пятьдесят других задач. Мы знаем, что современные подходы к крупномасштабному моделированию позволяют одновременно изучать несколько задач. Я думаю, что это хорошая работа, но она не кажется мне важной ступенькой на пути к чему-либо».

В ноябре 2021 года DeepMind показала, как её система искусственного интеллекта помогает математикам в поиске информации для разработки теорем. Совместная работа исследователей и ИИ уже привела к прорыву в гипотезе в области топологии и теории представлений, а также к доказанной теореме о структуре узлов.

В декабре DeepMind представила систему искусственного интеллекта Player of Games, которая может играть в покер, шахматы, Go и другие игры.

В феврале компания заявила, что её система AlphaCode пишет компьютерные программы «не хуже среднего программиста».