[Перевод] Сколько людей ходят по ссылкам и проверяют источники?

Очень часто можно встретить заявления, что утверждения, сделанные каким-нибудь мемом, подкреплены «исследованиями» или «наукой». Но когда я начинаю читать сами исследования, обычно оказывается, что данные противоречат заявлениям. Вот несколько свежих примеров, которые мне попадались.

Эффект Даннинга-Крюгера

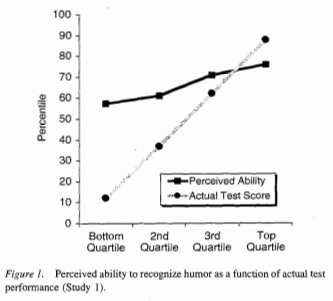

Научно-популярная версия эффекта Даннинга-Крюгера звучит так, что чем меньше кто-либо знает что-то по выбранной теме, тем больше ему кажутся его знания. На самом деле заявление Даннинга и Крюгера не настолько сильное. Оригинальная научная работа не длиннее большей части её неправильных научно-популярных интерпретаций, и можно составить представление о заявлениях учёных, изучив четыре рисунка из статьи. На этих графиках perceived ability, или воспринимаемая способность, обозначает субъективный рейтинг, а actual ability, или реальная способность, является результатом проверки.

В двух случаях из четырёх очевидна положительная корреляция между воспринимаемыми навыками и реальными, что противоречит научно-популярной концепции эффекта Даннинга-Крюгера. Правдоподобным объяснением того, почему воспринимаемые навыки оказываются сжатыми, особенно в нижней части графика, будет то, что мало кто из людей хочет оценивать свои навыки как ниже среднего или как наилучшие. В двух других случаях корреляция почти нулевая. Возможно, что этот эффект работает по-разному для разных задач, или что выборка слишком маленькая и что разница между разными задачами находится в пределах шума. Также этот эффект можно возникать из-за специфики выборки испытуемых (студенты из Корнелла, которые, вероятно, демонстрируют навыки выше среднего во многих областях). Если поискать описание эффекта на Википедии, там будет написано, что воспроизведение этого опыта в восточной Азии дало противоположный результат (воспринимаемые навыки ниже реальных, и чем больше навык, тем больше разница), и что этот эффект, скорее всего, является артефактом американской культуры —, но при этом ссылка ведёт на статью, упоминающую мета-анализ уверенности в себе восточных азиатов, поэтому это может оказаться ещё одним примером неправильного цитирования. Или это просто неправильная ссылка. В любом случае, этот эффект вовсе не говорит о том, что чем больше люди знают, тем меньше, по их мнению, их знания.

Доход и счастье

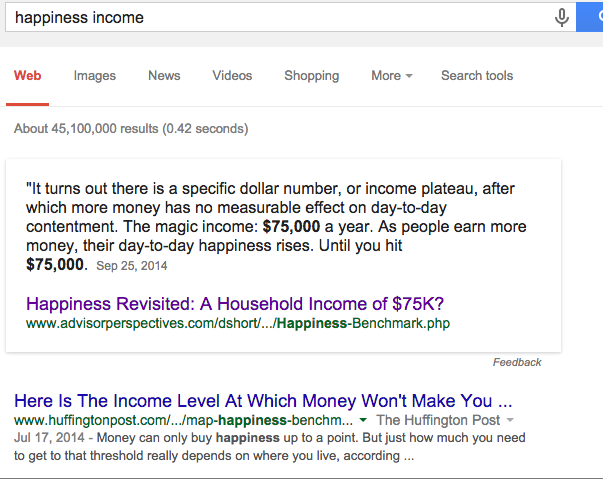

Считается общепризнанным фактом, что деньги не делают людей счастливыми. Сколько денег должно быть достаточно — зависит от того, кого спрашиваете, но обычно говорят о доходах $10, $30, $40 и $75 тысяч в год. На данный момент поиск в Google выдаёт, что сумма, после которой увеличение дохода уже не влияет на счастье, составляет $75 000 в год.

Прим. перев.: довольно сложно переводить их доходы на наши реалии. Можно оценить покупательскую способность по такому достаточно популярному методу, как индекс Биг-Мака, и тогда приближённые подсчёты будут следующие. Если верить онлайн-калькулятору, то на руки в случае дохода в $75 000 за год человек получит в среднем $53 500. В бигмаках это будет примерно соответствовать ежемесячному (как мы больше привыкли считать) доходу в 130 000 рублей «чистыми».

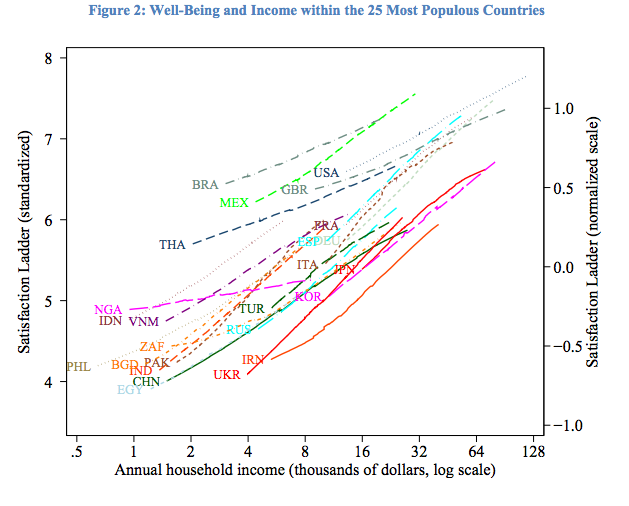

Но это не только неправильно — эта некорректность сохраняется для всех исследованных стран.

Корреляция счастья и доходов существует, и это не результат какого-то одного специально подобранного исследования. Результаты сохраняются после пяти последовательных Опросов мировых ценностей (World Values Survey), проводимых за периоды 1981–1984, 1989–1993, 1994–1999, 2000–2004 и 2005–2009, трёх повторов опросов исследовательского центра Пью (Pew Global Attitudes Survey) за 2002, 2007, 2010 года, пяти повторов Международных социальных опросов (International Social Survey Program) за 1991, 1998, 2001, 2007, 2008 и большого исследования компании Гэллап.

На графике выше доход отображается по логарифмической шкале. Если вы выберете страну и построите линейный график, то получите что-то вроде следующего:

Как и со всеми логарифмическими графиками, создаётся впечатление, что кривая должна вот-вот выровняться и прийти к чему-то такому:

Это реальная картинка из статьи, в которой утверждается, что доходы не делают людей счастливыми. Подобные, похожие на логарифмические, графики, которые со временем выравниваются, встречаются довольно часто. Попробуйте погуглить словосочетание «happiness income». Моя любимая статья та, в которой люди, зарабатывающие достаточно денег, находятся в самом верху шкалы. Судя по всему, существует такое количество денег, которое не только делает вас счастливым, но и делает вас настолько счастливым, насколько это вообще возможно для человека.

Как и в случае с Даннингом-Крюгером, можно взглянуть на графики в научных работах и увидеть, что к чему. В данном случае проще понять, почему люди распространяют неверную информацию, поскольку довольно легко неправильно понять данные, построенные на линейной шкале.

Гедоническая адаптация и счастье

Идея о том, что люди отходят от неприятностей (и от положительных эмоций) и возвращаются к фиксированному уровню счастья вошла в популярное сознание после того, как Дэниел Гилберт описал её в популярной книге.

Но даже не изучая литературу по адаптации к неблагоприятным событиям, предыдущий раздел статьи уже может вызвать определённые вопросы к этой идее. Если люди отходят от неприятных и приятных событий, каким образом увеличение дохода увеличивает счастье человека?

Оказывается, что идея адаптации к неприятным событиям и возвращению к предыдущему уровню счастья — это миф. Хотя конкретные эффекты варьируются в зависимости от природы события, инвалидность, развод, потеря партнёра, потеря работы оказывают долговременное влияние на уровень счастья. Потерю работы легко исправить, но влияние этого события сохраняется даже после того, как люди заново находят себе работу. Тут я процитировал всего четыре исследования, но мета-анализ литературы показывает, что результаты подтверждаются во всех известных исследованиях.

То же верно и для приятных событий. Хотя принято считать, что выигрыш в лотерею не делает людей счастливее, оказывается, что и это не так.

В обоих случаях ранние перекрёстные результаты исследований показывали правдоподобность того, что экстремальные случаи, вроде выигрыша в лотерею или приобретения инвалидности, не оказывают на счастье долгосрочного влияния. Но более длительные исследования, изучающие определённых личностей и измеряющие счастье одного человека, в то время, как с ним происходят разные события, показывают обратный результат — происходящие события влияют на счастье. Эти результаты по большей части не новые (некоторые из них появились ещё до выхода книги Дэниела Гилберта), но более старые результаты основаны на менее строгих исследованиях, продолжают распространяться быстрее, чем исправляющие их новые.

Системы типов

К несчастью, ложные заявления по поводу исследований и свидетельств не ограничиваются научно-популярными мемами. Они встречаются и в разработке ПО и оборудования.

I think programmers who doubt that type systems help are basically the tech equivalent of an anti-vaxxer.

— P. Oscar Boykin (@posco) February 13, 2015

Программисты, сомневающиеся в ценности систем типов, представляют собой технологический эквивалент противников вакцинации

Подобные вещи я наблюдаю не реже раза в неделю. Этот пример я выбрал не потому, что он особо вопиющий, но потому, что он типичный. Если читать твиттер некоторых ярых сторонников функционального программирования, можно периодически натыкаться на заявления о существовании серьёзных эмпирических свидетельств и всеобъемлющих исследований, поддерживающих эффективность систем типов.

Однако обзор эмпирических свидетельств показывает, что эти свидетельства по большей части неполны, а в других случаях — двусмысленны. Из всех ложных мемов этот, по-моему, понять труднее всего. В других случаях я могу представить себе правдоподобный механизм того, как можно неправильно интерпретировать эти результаты. «Связь слабее ожидаемого» может превратиться в «связь оказалось противоположной ожидаемой», логарифм может быть похожим на асимптотическую функцию, а предварительные результаты, полученные сомнительными методами, могут распространяться быстрее, чем последовавшие за ними и лучше выполненные исследования. Но я не уверен, какова связь между свидетельствами и мнениями в данном случае.

Можно ли этого избежать?

Можно понять, почему ложные мемы распространяются так быстро, даже несмотря на то, что они прямо противоречат надёжным источником. Чтение научных работ может показаться сложным занятием. Иногда так и есть. Но часто это не так. Чтение чисто математической работы — занятие обычно утомительное. Чтение эмпирической работы, определяющей надёжность методологии, может быть сложным. К примеру, биостатистика и эконометрика применяют совершенно разные методы, и довольно трудно начать хорошо разбираться с набором методов, используемых в какой-то определённой области, чтобы точно понимать, где их можно применять и какие у них есть недостатки. Но читать эмпирические работы просто чтобы понять, что они заявляют, обычно довольно легко.

Если прочесть выдержку и заключение, а затем пролистать работу в поисках интересных моментов (графиков, таблиц, недостатков методологии, и т.п.), в большинстве случаев этого будет достаточно для того, чтобы понять, совпадают ли популярные заявления с тем, что написано в работе. В моём идеальном мире это можно было бы понять, прочитав только выдержку, но часто работы указывают в выдержках гораздо более сильные заявления, чем те, что приводятся в теле работы, поэтому работу нужно хотя бы пролистать.

Может, я и наивен, но я думаю, что основная причина появления ложных мемов в том, что проверка источников кажется более сложной и пугающей, чем это есть на самом деле. Яркий пример тому — статья в журнале Quartz об отсутствии гендерных различий в зарплатах в технологических областях, в которой было процитировано множество источников, заявлявших прямо противоположное. Твиттер гудел от заявлений людей, рассказывавших, что гендерная разница исчезла. Когда я опубликовал пост, в котором просто процитировал те самые работы, на которые были ссылки, многие из этих людей заявили, что их изначальное заявление было ошибочным. Хорошо, что они готовы написать исправление своим словам, но, насколько я могу судить, никто из них не пошёл и не прочёл сами данные, хотя из графиков и таблиц было совершенно очевидно, как автор оригинальной статьи на Quartz продвигает своё мнение, даже не заботясь о подборе подходящих под него статей.