[Перевод] Эти странные, тревожные фото говорят о том, что ИИ умнеет

ИИ учится генерировать изображения из подписей и начинает лучше понимать наш мир

Из всех моделей искусственного интеллекта именно GPT-3 разработки OpenAI сильнее всего поразила воображение публики. Она без особых подсказок может извергать стихотворения, короткие рассказы и песни, заставляя думать, что это работы человека. Но красноречие — всего лишь уловка, которую не стоит путать с реальным интеллектом.

Тем не менее, исследователи верят, что те же приемы, которые использовались для создания GPT-3, скрывают секрет для создания более продвинутого ИИ. GPT-3 тренировали на огромном объеме текстовой информации. Что если те же методы тренировать одновременно на тексте и изображениях?

Новое исследование под названием AI2, проведенное в Институте искусственного интеллекта Пола Аллена, вывело эту идею на следующий уровень. Исследователи создали особую, визуально-лингвистическую модель. Она работает с текстом и изображениями и может генерировать последние из подписей. Картинки выглядят тревожно и странно, совершенно не как гиперреалистичные «дипфейки», созданные генеративно-состязательными сетями (GAN). Но они могут показать новое направление для более практичного интеллекта, и, возможно, сделают роботов умнее.

Заполнить пробел

GPT-3 входит в группу моделей, известных как «трансформеры». Они впервые обрели популярность благодаря успеху BERT, алгоритма Google. До BERT языковые модели были довольно плохи. Их прогностических способностей хватало для автозаполнения, но не для составления длинных предложений, где соблюдены правила грамматики и присутствует здравый смысл.

BERT изменил ситуацию, представив новую методику под названием «маскинг» (прим. — оригинальное название masking). Она подразумевает, что в предложении прячутся разные слова, и модель должна заполнить пропуск. Примеры:

- Женщина пошла в ___, чтобы потренироваться.

- Они купили___ хлеба, чтобы сделать сэндвичи.

Идея состоит в том, что если заставить модель выполнять эти упражнения, часто по миллиону раз, то она начнет обнаруживать закономерность в том, как слова собираются в предложение, а предложения — в параграфы. В результате алгоритм лучше генерирует и интерпретирует текст, приближаясь к пониманию смысла языка. (Google сейчас использует BERT, чтобы выдавать более релевантные результаты поиска.) После того как маскинг оказался крайне эффективным методом, исследователи попытались применить его к визуально-языковым моделям и стали прятать слова в подписях. Вот таким образом:

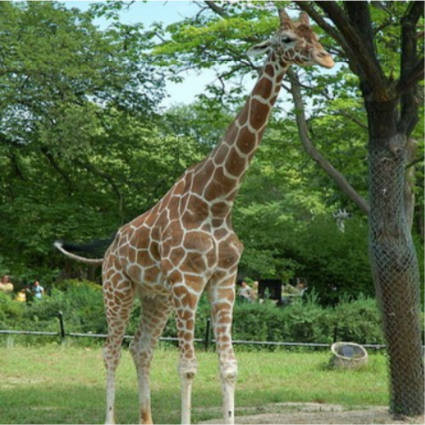

____ стоит на земле рядом с деревом. Источник: AI2

В этот раз модель могла рассматривать окружающие слова и содержимое изображения, чтобы заполнить пробел. После миллиона повторений она училась обнаруживать не только паттерны слов, но и связь слов с элементами каждого изображения.

В результате модели могут связывать текстовые отношения с визуальными примерами, как младенцы устанавливают связи между выученными словами и увиденными вещами. Модели могут взять фотографию ниже и составить осмысленную подпись, например, «Женщины играют в хоккей на траве». Или могут ответить на вопрос вроде «Какого цвета мяч», связывая слово «мяч» с круглым объектом на фотографии.

Визуально-языковая модель может составить осмысленную подпись этой фотографии: «Женщины играют в хоккей на траве». Источник: JOHN TORCASIO / UNSPLASH

Лучше один раз увидеть картинку

Исследователи хотели узнать, развивают ли эти модели концептуальное понимание визуального мира. Ребенок, который выучил слово для объекта, может не только назвать его, но и нарисовать объект по подсказке, даже если сам по себе объект отсутствует. Так что команда проекта AI2 предложила модели делать то же самое: генерировать изображения по подписям. Все модели выдали бессмысленный пиксельный мусор.

Это птица? Это самолет? Нет, это абракадабра, сгенерированная искусственным интеллектом. Источник: AI2

В этом есть смысл: преобразовать текст в изображение сложнее, чем сделать обратное. «Подпись не определяет все, что находится на картинке», — говорит Ани Кембхави, руководитель группы компьютерного зрения в AI2. Таким образом, модель должна опираться на большое количество знаний о нашем мире, чтобы добавить недостающие детали.

Например, если модель просят нарисовать «жирафа, который идет по дороге», то ей необходимо сделать вывод, что дорога скорее будет серой, чем ярко-розовой, и проходить будет рядом с полем, а не с морем. Хотя вся эта информация не является явной.

Поэтому Кембхави и его коллеги Джемин Чо, Джиасен Лу и Ханнане Хаджиширзи решили посмотреть, могут ли они обучить модель всем этим скрытым визуальным знаниям, подправив подход к маскингу. Вместо того чтобы обучать алгоритм просто предсказывать «замаскированные» слова в подписях соответствующих фотографий, они также тренировали его предсказывать «замаскированные» пиксели в фотографиях на основе соответствующих подписей.

Финальные изображения, созданные моделью, не вполне реалистичны. Но это не важно. Они содержат правильные высокоуровневые визуальные концепции. ИИ поступает как ребенок, который рисует фигурку из черточек, чтобы изобразить человека. (Вы можете испытать модель самостоятельно здесь).

Примеры изображений, сгенерированные моделью AI2 по подписям. Источник: AI2

Способность визуально-языковых моделей генерировать подобного рода изображения представляет собой важный шаг вперед в исследованиях искусственного интеллекта. Это говорит о том, что модель на деле способна к определенному уровню абстракции — фундаментальному навыку для понимания мира.

В долгосрочной перспективе навык может иметь важные последствия для робототехники. Чем лучше робот понимает обстановку и использует язык, чтобы сообщать о ней, тем более сложные задачи сможет выполнять. В краткосрочной перспективе, отмечает Хаджиширзи, визуализация поможет исследователям лучше понимать, что именно изучает модель, которая сейчас работает как «черный ящик».

В дальнейшем команда планирует больше экспериментировать, улучшать качество генерации изображений и расширять визуальный и словарный запас модели: включить больше тем, объектов и прилагательных.

«Создание изображений действительно было недостающей деталью головоломки, — говорит Лу. — Добавив его, мы можем научить модель лучше понимать наш мир».