[Перевод] Есть ли будущее у InfiniBand на Hadoop?

Hadoop был создан для запуска на чипах компьютеров широкого употребления с сетевым подключением с низкой скоростью. Но Hadoop кластеры стали больше и организации превысили лимит мощности. Для решения проблемы были найдены специализированные решения такие как твердотельные накопители и сети InfiniBand, у которых есть запас роста.

InfiniBand был представлен миру в 2000 году как сетевой протокол, который был быстрее чем TCP/IP — первоначальный сетевой протокол в сетях Ethernet. Благодаря использованию прямого удаленного доступа к памяти (Remote Direct Memory Access (RDMA) InfiniBand позволяет напрямую записывать/копировать данные из памяти удаленного компьютера, обходя операционную систему и возможные задержки.

Вы можете получить 40 гигабит/сек пропускной способности на порте InfiniBand QDR (Quad Data Rate), который сейчас наиболее широко используется. Это в 4 раза больше стандартной ширины канала в 10Gigabit Ethernet (10GbE). Вы получаете возрастание в скорости при агрегировании портов (в том числе и Ethernet).

Протокол Ethernet изначально занимал доминирующую позицию при выборе для подавляющего большинства энтерпрайз-сетей. В это время InfiniBand постепенно внедрялся на рынке высокопроизводительных компьютерных систем, суперскорость InfiniBand и отсутствие задержек давали преимущество этому протоколу в больших массивах параллельных кластеров. Больше чем 50% суперкомпьютеров из ТОП 500 прошлого года используют InfiniBand. Этот протокол любят высокоскоростные биржи, разные финансовые сервисы и другие большие пользователи портов InfiniBand, чаще всего используется оборудование InfiniBand производителей Mellanox и Intel.

Но когда протокол InfiniBand был внедрен на Hadoop, он показал меньшую производительность, по сравнению с показателями InfiniBand в среде суперкомпьютеров. Этому есть несколько причин. Многие решения были спозиционированы в сторону Ethernet на большинстве энтерпрайз-рынков. Также сыграло свою роль восприятие InfiniBand как чего-то экзотического и очень дорогого (что не всегда правда).

Это не новость, что InfiniBand на Hadoop далеко не мейнстрим. У всех распространителей платформы Hadoop есть поддержка Hewlett-Packard, IBM и Dell. Эти вендоры также поддерживают InfiniBand в соответствующих внедрениях. Если вы посмотрите на чем построены внедрения, которые используют около 20% интеграторов Hadoop, вы узнаете, что и Oracle и Teradata поддерживают InfiniBand

Почему выбирают InfiniBandНесколько интересных моментов, на что стоит обратить внимание при использовании InfiniBand через 10GbE. Есть один человек, кто может видеть изнутри многие моменты использования InfiniBand-on-Hadoop. Это Панда Дабалесвор, профессор Школы компьютерных наук и инжиниринга Университета Огайо и глава исследовательской группы Network-Based Computing Research Group.

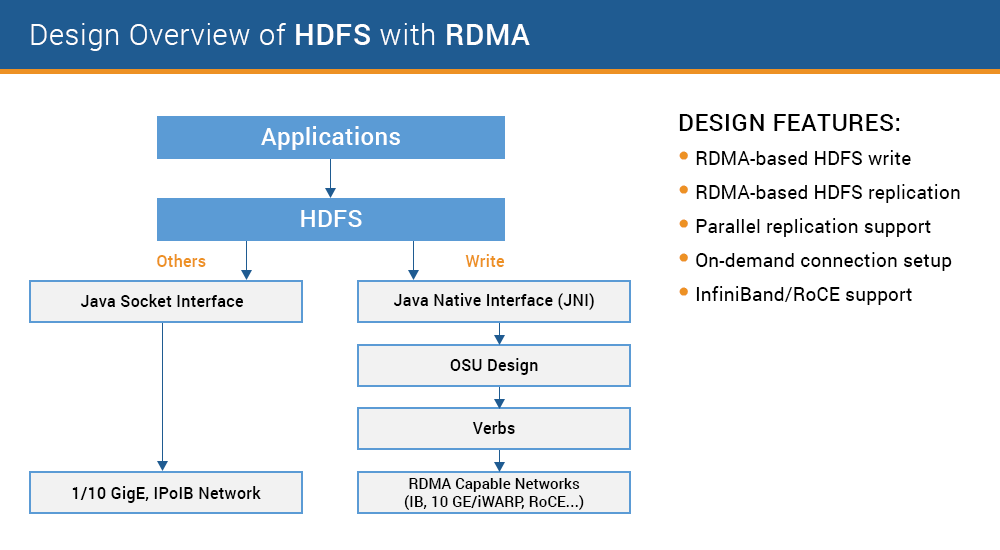

Архитектура высокопроизводительных систем обработки данных (HiBD) для библиотек InfiniBand для распределённой файловой структуры Hadoop (HDFS)

Панда руководит проектом HiBD в университете Огайо, где разрабатывает, развивает и поддерживает проект библиотек для Hadoop версии 1 и 2 (HDFS и MapReduce). Они поддерживают нативный RDMA, который используются для обмена данными в InfiniBand. Apache Hadoop и Hortonworks сейчас поддерживаются в плагине для Cloudera. Исследователи также написали код для поддержки InfiniBand в БД с поддержкой кеширования оперативной памяти. Этот код также работает в библиотеках, поддерживающих Apache Spark и HBase.

Панда проводивший исследования в среде коммутируемых суперкомпьютеров на протяжении 25 лет и работавший с InfiniBand с тех пор, как он появился, подтверждает, что InfiniBand не сильно распространён в среде платформы Hadoop, но он ожидает, что это изменится в скором будущем.

«В среде суперкомпьютеров произошел технологический прорыв. Но в среде enterprise у них есть некоторые недостатки» — сказал Панда порталу Datanami. «С т.з. энтерпрайза они его догнали. Так что нам нужно подождать 1–2 года, чтобы увидеть более широкое использование InfiniBand так сказать «в народе».

С тех пор как архитектура HiBD интегрировала первую библиотеку InfiniBand несколько лет назад, пакет был скачан более чем 11 000 раз. По данным сайта группы, его используют более чем 120 организаций по всему миру.

Также он отметил то, что общая тенденция во всех внедрениях InfiniBand — это желание добиться максимальной масштабируемости и производительности избегая узких горлышек во вводе-выводе. «Традиционно [Hadoop] разрабатывался в Ethernet, но даже если у вас будет 10GbE, особенно в больших массивах данных, вы будете шокированы. Это именно та инфраструктура, где выгоды нашего проектирования стали явны, так что вы действительно можете максимально гибко масштабировать ваши приложения и получить максимум производительности и скалируемости от них» — сказал исследователь.

«Общее заблуждение в сообществе Hadoop в отношении InfiniBand, что он слишком дорогой и слишком «хорош» для кластеров в недорогих, наиболее распространённых устройствах. Это так, если у вас маленькие сборки. Но для кластеров побольше InfiniBand экономически гораздо выгоднее чем Ethernet

«Если вы идете в совсем большие кластерные системы, InfiniBand FDR гораздо более эффективнее и выгоднее чем 10GbE» — сказал профессор. — «Если у вас кластер из 4 или 16 нод, вы не увидите разницы, но если у вас 1000 нод, 2000 или 4000 нод, вы увидите существенную разницу в стоимости».

«Как и в гонке машин, где общую скорость замедляют самые медленные машины, в Hadoop, кластеры могут работать не быстро из-за медленных частей структур» — сказал Панда. «У вас может быть очень хорошее оборудование, но если у вас слабые шины, вы не получите всех выгод технологии. Мы видим, что ввод/вывод и сеть должны быть сбалансированы для получения самой лучшей производительности».

Предостережение насчет HadoopДо сих пор переменная скорость в сети играет главную роль для производительности Hadoop, есть и другие не совсем очевидные факторы. Как обычно, дьявол кроется в деталях.

В июле этого года Microsoft и Barcelona Supercomputing Centre запустили проект Aloja для того, чтобы установить спецификацию для производительности платформы Hadoop. Этот проект определил более чем 80 настраиваемых параметров Hadoop, которые влияют на производительность. Включая факторы, связанные с физическим оборудованием: таким как размер памяти, тип хранилища и скорость сети, так софтверные факторы: количество менеджеров памяти и преобразователей данных, размер блока HDFS и размер виртуальных машин.

Исследователи проекта увидели, что простое добавление InfiniBand в структуру никак не влияет на производительность Apache Hadoop, которую измеряют в бенчмарк-тестах. Однако, добавление InfiniBand в диски SSD в той же сети показывает прирост производительности в 3,5 раза по сравнению с SATA и Gigabit Ethernet. В тоже время, простое добавление дисков SSD в гигабитной сети Ethernet, увеличивает продуктивность только в 2 раза.

Это перекликается с мнением профессора Панды: — «Что получится если вы будете использовать диски SSD? Ваша скорость ввода-вывода увеличится, но это также означает, что у вас должна быть высокопроизводительная сеть. При использовании Ethernet от 1 до 10 гигабит выгоды очевидны, но у с InfiniBand вы получаете больше преимуществ, так как в самой основе этой технологии есть возможность больше нагружать вашу сеть. Это значит, что вы получите лучшие решения, такие же как, например, RDMA, которые будут лучше работать на сетях такого типа».

Не все поддаются «очарованию» InfiniBand. Эрик Самер, нынешний CTO и сооснователь Rocana, в своем посте на сайте Quora приводит аргументы в пользу 10GbE.

Эрик считает, что InfiniBand сильно превышает требования обычных пользователей — «Факт в том, что как только мы переходим к большинству всех совместимых уровней ИТ-инфраструктуры, появляется перерасход мощности. По ряду многих причин я даю не утешительные прогнозы, актуальная ширина полосы пропускания закончится в районе 25Gb на один IP адрес, через порт 4X QDR 40Gb». (Честно говоря, те библиотеки, которые развивает Панда в среде HiBD, уже изначально поддерживают InfiniBand, что исключает служебный поток данных).

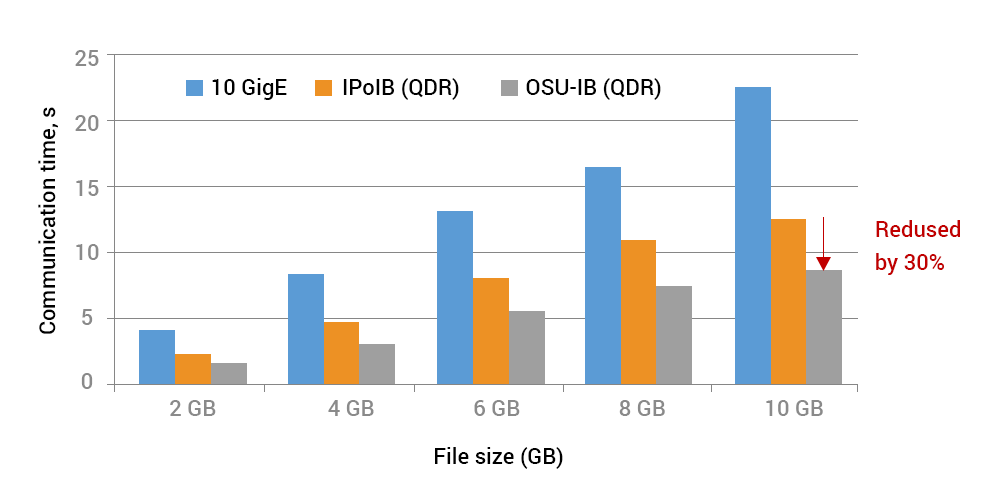

Сравнение производительности Hadoop на 10GbE, и InfiniBand через IP и библиотеку HiBD для нативного InfiniBand QDR.

Саммер говорит о своем развернутом Hadoop 10GbE (возможно через витую пару). «Повсеместность Ethernet — это факт, от которого не отмахнуться, и с такими платформами как Hadoop, я склонен говорить о том, что лучше делать ставку на те технологии, которые развивают сетевые технологии и упрощают передачу данных (Cloudera Impala, происходящие изменения Tez в Apache Hive и т.д.). Я также твердо уверен в том, что те же самые данные из кеша можно использовать при передаче в большем количестве пакетов, и это оптимизирует передачу моих данных из датацентра к получателю на той стороне».

Заявка RoCEТакже InfiniBand конкурирует с новой технологией, которая претендует дать те же выгоды что и InfiniBand, но через Ethernet. Называется это RDMA через конвергентную сеть Ethernet (RDMA over Converged Ethernet — RoCE) и показывает более быструю пропускную способность и меньшие задержки чем традиционный Ethernet.

Группа исследователей профессора Панды также развивает библиотеки RoCE для свичей и сетевых Hadoop устройств и для ПО решений, которые поддерживают кеширование памяти. Mellanox поддерживает и протокол RoCE и протокол InfiniBand в своих устройствах.

Какую бы технологию для соединения не выбрали пользователи, профессор Панда советует хорошо подумать и взвесить все за и против разных вариантов — «Вопрос в том, какое необходимо качество маршрутизации и управления. Если организация чувствует себя комфортно с хорошим сисадмином, который разбирается в Ethernet, вариант с RoCE для них предпочтительнее. Но если некоторые организации имеют хорошую компетенцию в InfiniBand, то тут не может быть мук выбора между InfiniBand или RoCE».

Растет объем данных, и у компаний возникает необходимость в более быстром анализе этих данных. Это вынуждает их строить новые кластеры — большие и быстрые — с дисками SSD и многоядерными процессорами. Становится очевидным, что подход RDMA — или InfiniBand или RoCE — должен быть адаптирован организациями, занимающими большими данными с высокой степенью нагрузки.

Ссылки по теме:

Unravelling Hadoop Performance Mysteries (EnterpriseTech)

Why Big Data Needs InfiniBand to Continue Evolving

Hadoop: что, где и зачем

Самая популярная сеть для суперкомпьютеров или Почему мы выбрали InfiniBand?

SIM-Networks — отказоустойчивое облако (InfiniBand) в Германии, SSD хостинг и VPS.

Комментарии (1)

14 ноября 2016 в 13:32

0↑

↓

Но когда протокол InfiniBand был внедрен на Hadoop, он показал меньшую производительность, по сравнению с показателями InfiniBand в среде суперкомпьютеров.

Так логично, если поверх него гонять IP пакеты. IPoIB имеет в раз 8 больше задержки на типичных сценариях использования хадупа.Вот куда все java программы на InfiniBand будут двигаться